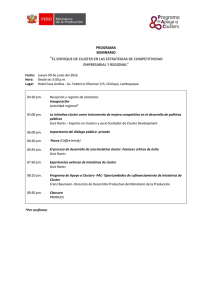

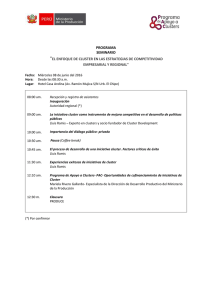

Desarrollo de una supercomputadora basada en un “cluster

Anuncio