- Ninguna Categoria

El impulso hacia la centralización: el péndulo vuelve a cambiar

Anuncio

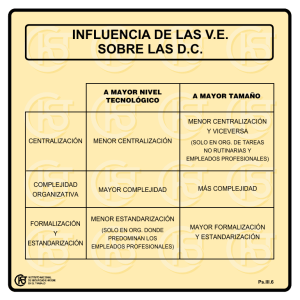

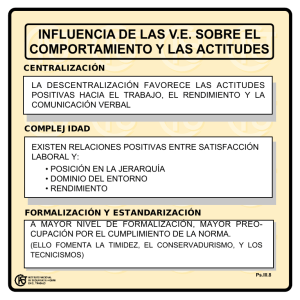

El impulso hacia la centralización: el péndulo vuelve a cambiar L J. Roberto Evaristo, Kevin C. Desouza y Kevin Hollister ¿Qué organizaciones pueden lograr los mayores beneficios de la recentralización (y descentralización) de sus arquitecturas TI de hardware? l debate sobre si la arquitectura TI debería ser centralizada o descentralizada es tan antiguo como la propia tecnología. A pesar de las diversas perspectivas que se han aportado al debate, lo que hasta ahora se ha pasado por alto es el fenómeno de vaivén relacionado no sólo con aspectos centrados en las tecnologías de la información (TI), sino también con los eventos actuales que se extienden a otras áreas de la organización. E Un aspecto clave es la forma en la que los directivos han modificado su interés por las TI: su enfoque ha pasado de basarse en la inversión, “para no ser menos que los demás”, a basarse en el valor, “dónde están los beneficios”, que hace hincapié de forma pragmática en la importancia de la información y sus usos. Otras consideraciones son las necesidades del negocio para un entorno tecnológico fiable, disponible, tolerante a los fallos, respaldado y seguro, incluso ante situaciones catastróficas. Los directivos no pueden permitirse no saber por qué se ha producido el renovado interés en la centralización de la arquitectura TI y cómo puede afectar a sus organizaciones. En 1983, un acreditado análisis sobre el tema sugería que había tres aspectos que diferenciaban la centralización de la descentralización, todos ellos relacionados con el control: la localización física de las instalaciones 1 El impulso hacia la centralización: el péndulo vuelve a cambiar de los servicios de información, la actividad o responsabilidad dentro de la estructura de la organización y la toma de decisiones. Autores posteriores llegaron a la conclusión de que el control era el factor clave determinante en las decisiones de centralización frente a descentralización. En este artículo adoptamos una perspectiva más restringida de la arquitectura TI, centrada sólo en la arquitectura real del hardware, es decir, la topología empleada para conectar todos y cada uno de los diversos componentes de hardware en una determinada organización. Algunos autores llegaron a la conclusión de que el control era el factor clave determinante en las decisiones de centralización frente a descentralización Impulsores del cambio Muchos de los factores que afectan a las decisiones sobre arquitectura TI han estado presentes desde que las TI se utilizaron por primera vez en las organizaciones. No obstante, su importancia frente a otras preocupaciones que han tenido mayor relevancia en el tiempo ha cambiado, lo que ha dado como resultado la doble tendencia de oscilación que se describe en el cuadro 1. Una observación importante es que ha habido más de un cambio en las tendencias, algo que por lo general los escritos no reconocen. Este artículo se centra en cuáles han sido los desencadenantes o el punto de inflexión que han dado lugar a cambios en las tendencias. Además, se analiza la importancia relativa de aspectos ineludibles frente a acontecimientos localizados en el tiempo y se analiza su papel en los dos cambios más significativos. El punto de inflexión se define como el momento en el que aparece un factor lo suficientemente importante como para iniciar una tendencia o una idea que propugna un cambio radical. A principios de los años sesenta, la arquitectura del hardware era básicamente centralizada. El coste era el factor determinante; la elevada cuantía tanto de las telecomunicaciones como del hardware, unida a una capacidad informática relativamente limitada, convirtió la centralización en un imperativo. El estado de la tecnología no permitía arquitecturas alternativas. La arquitectura estaba limitada a grandes sistemas de mainframe que ejecutaban procesos por lotes. Debido a aspectos puramente económicos, esos sistemas estaban bien protegidos y proporcionaban sólo una accesibilidad limitada. La necesidad de mejorar el nivel de respuesta y la flexibilidad, unida a los avances tecnológicos, permitió la aparición de equipos descentralizados cada vez más baratos y sofisticados. A mediados de los años setenta era habitual cierto grado de descentralización, por lo general mediante terminales sin capacidad de procesamiento conectados a líneas alquiladas o nodos de acceso telefónico. Éste fue un salto gigantesco, ya que dejó de 2 El impulso hacia la centralización: el péndulo vuelve a cambiar CUADRO 1 Centralización frente a descentralización de las TI Descentralización/centralización Coste A • Redundancia de datos • Reingeniería • Sistemas dispares Percepción del usuario Servicio C B • Descentralización Internet • Sistemas operativos dispares Período de capacidad de respuesta-costes Período de uso intensivo 1960 • Menor coste de un aspecto • Acceso y fiabilidad de los datos • Seguridad de los datos • Instalaciones redundantes • ERP (anteriormente) 1987 E D Conscientes del valor Período de grandes volúmenes de datos 1992 1997 Fechas (no a escala) 2003 ser necesario desplazarse físicamente hasta el equipo de TI para ejecutar un trabajo o un programa. Las personas podían enviar la tarea al mainframe a través de este tipo de terminales. Los miembros de un departamento, equipo u organización local compartían terminales y enviaban sus trabajos a los mainframes electrónicamente, en lugar de hacerlo mediante entradas físicas de tarjetas perforadas. El primer punto de inflexión La introducción del microordenador en 1981 dio lugar al fenómeno del usuario final. Ahora, el procesamiento se podía realizar tanto localmente como de forma repartida. A mediados de los años ochenta, el software había evolucionado hasta tal extremo que era accesible para las personas que no poseían conocimientos técnicos de programación, para lo cual se contaba con que los usuarios finales fueran capaces de desarrollar y ejecutar una serie de aplicaciones relativamente sencillas. Los servidores fueron el siguiente avance tecnológico y de costes. La consecuencia directa fue que la función de TI pasó poco a poco a ser descentralizada y los departamentos gestionaban su propio software y hardware. Debido a la falta de estándares y controles de calidad comunes a toda la empresa, esta tendencia generó una enorme cantidad de hardware diferente y no siempre compatible, así como aplicaciones de Un factor importante que influyó en la tendencia hacia la descentralización fue el hecho de que grandes organizaciones, como Siemens y General Motors, comenzaron a utilizar el comercio electrónico con sus proveedores 3 El impulso hacia la centralización: el péndulo vuelve a cambiar La recentralización del ‘hardware’ no invalida el empuje de Internet hacia la descentralización de la arquitectura TI software no integradas y dispares. La amplia variedad de hardware y software llevó, a su vez, a la redundancia de la información y la consiguiente incongruencia de los datos. La línea A-B del cuadro 1 describe esta primera época. La apremiante necesidad de lograr la integración de los datos y la simplificación del paisaje de la arquitectura TI dio lugar al primer punto de inflexión (B) en la anteriormente sistemática tendencia hacia la descentralización. En el año 1987 se publicó el artículo “Wither the IT organization”, el cual debatía las virtudes de la centralización o “recentralización”. Sus autores defendían la gestión centralizada de diversas funciones: telecomunicaciones (“para garantizar la rentabilidad y la coordinación del negocio”); metodologías estándar de hardware y software operativo (“compatibilidad de los sistemas en todas las unidades de negocio”); políticas de información (“para gestionar la propiedad corporativa y el intercambio de datos”); gestión compartida del riesgo y los servicios (“para lograr economías de escala”); utilidades compartidas; recursos humanos compartidos (incluyendo las trayectorias profesionales de los expertos en TI); y la centralización del hardware y el software. Es posible que otro factor que haya influido en el trayecto hacia la centralización haya sido el deseo de iniciar nuevos esfuerzos de reingeniería, algo que es más sencillo cuando los sistemas son compatibles. Este factor comenzó a desempeñar un papel importante a principios de los años noventa, casi al final del ciclo (véase la línea B-C del cuadro 1). Apoyos y excepciones Otras razones que han impulsado la evolución hacia la centralización son los elevados costes de los centros de procesamiento de datos independientes (y la duplicación de las licencias de software), los cambios en la demografía de los profesionales de los servicios informáticos y, el más importante, el énfasis por integrar las funciones empresariales con los servicios informáticos y apoyar las nuevas oportunidades de negocio. Se estableció un grupo central con extensos conocimientos a lo largo de toda una organización para promover la integración de una manera más efectiva. Algunos autores defienden la existencia de excepciones como, por ejemplo, la que se produce al gestionar de forma descentralizada el desarrollo de aplicaciones informáticas, lo que da lugar a una estructura híbrida. Esta tendencia hacia la centralización también fue reconocida por los medios de comunicación; entre las razones aducidas, se aludía a restaurar el orden dentro del caos existente, la presión del presupuesto, el crecimiento de las redes y la necesidad de mayor seguridad. 4 El impulso hacia la centralización: el péndulo vuelve a cambiar En 1992, el inicio del siguiente cambio hacia la descentralización (véase el punto C del cuadro 1) estaba en marcha, creado no sólo a través de la renovada percepción de una mayor calidad de servicio proporcionada por la descentralización, sino también por los límites de la comunicación entre multitud de sistemas operativos disponibles en aquel momento y por un incipiente impulso hacia las soluciones web. Aunque limitada a mediados de los años noventa, la iniciativa “punto-com” estaba en pleno apogeo en 1997. Otro factor importante que influyó en la tendencia hacia la descentralización fue el hecho de que grandes organizaciones, como Siemens y General Motors, comenzaron a utilizar el comercio electrónico con sus proveedores. Al mismo tiempo, las empresas orientadas a los consumidores (como Amazon.com) estaban instalando sus servidores por todo el mundo con el fin de mejorar el tiempo de respuesta y utilizando soluciones (como las de Akamai). En 1997, Thomas Malone analizaba la descentralización de la toma de decisiones y de qué forma la decisión de centralización afectaba a los siguientes tres factores: disponibilidad de información, confianza y motivación. A pesar de que Malone llegó a la conclusión de que era muy probable que el control organizacional futuro fuera incluso más descentralizado, no fue capaz de explicar de qué forma la arquitectura TI física subyacente que apoyaba esta tendencia sería implementada. A finales de los años noventa, se hizo evidente el siguiente punto de inflexión (véase el punto D del cuadro 1), que conducía a la recentralización del hardware. Cabe señalar que la tendencia hacia la recentralización del hardware no invalida el empuje de Internet hacia la descentralización de la arquitectura TI, lo que pone de manifiesto que hay diferentes factores que pueden influir simultáneamente en la decisión centralización-descentralización en direcciones opuestas. ¿Por qué la recentralización? La tendencia hacia la recentralización que había comenzado a finales de los años noventa tenía diversas motivaciones (como el coste) más allá de los culpables tradicionales. La clave era la necesidad de acceso instantáneo a los datos a través de una multitud de entornos de toma de decisiones geográficamente dispersos, junto con la necesidad de fiabilidad y seguridad en tales intercambios. El coste de las telecomunicaciones y de la capacidad informática ha disminuido en gran medida en los últimos treinta años, con lo que se ha convertido en un factor mucho menos importante de lo que era antes. Se podría caer en la tentación de afirmar que el coste ya no es una variable en la ecuación. A menos que los costes de adquisición y de operación de El coste de las telecomunicaciones y de la capacidad informática ha disminuido en gran medida en los últimos treinta años, con lo que se ha convertido en un factor mucho menos importante de lo que era antes 5 El impulso hacia la centralización: el péndulo vuelve a cambiar las TI lleguen a ser insignificantes, el aspecto económico de las nuevas instalaciones tecnológicas no cambiará. Además, al correspondiente descenso en los costes le siguen otras necesidades nuevas. En la actualidad es más probable que las corporaciones adquieran soluciones flexibles más baratas con una arquitectura abierta, en especial desde el pinchazo de la burbuja de las “punto-com” En la actualidad es más probable que las corporaciones adquieran soluciones flexibles más baratas con una arquitectura abierta, especialmente desde el pinchazo de la burbuja de las “punto-com” y el aumento de los gastos de TI. La revista The Economist señaló un incremento del 16% en los gastos de TI en 2000, seguido de un descenso del 6% en 2001. En resumen, los costes siguen siendo una parte importante de las razones para la recentralización, pero su papel es diferente al que desempeñaban en las primeras fases. Otra diferencia entre los puntos B y D es una perspectiva de gestión radicalmente diferente entre un punto y otro. A pesar de que ambos puntos marcan un aumento en la centralización del hardware, en el primer caso, la variedad tanto de software como de hardware fue la principal motivación, mientras que, en el segundo, el problema era más de seguridad y acceso fiable a los datos en un entorno distribuido. En ambos casos, los costes fueron relevantes, pero de una manera ligeramente diferente. Algunas de las consideraciones sobre los costes en el primer caso implicaban cómo se podían reducir directamente costes (externos), como, por ejemplo, facilitar la reingeniería y probablemente la reducción del número de trabajadores, mientras que el objetivo en el segundo caso era mejorar el acceso y la seguridad de los datos, mejorando de este modo el rendimiento y, hasta cierto punto, disminuyendo también los costes (internos). Por ejemplo, es mucho más costoso crear centros de respaldo alternativos (de crisis) para cada una de las piezas del entorno distribuido que crear un conjunto de centros de crisis para una arquitectura TI centralizada. Además, la capacidad para acceder de forma rápida y fiable a los datos en servidores geográficamente distantes en un entorno descentralizado puede verse comprometida. A medida que aumenta el número de servidores, también aumenta la probabilidad de que al menos uno no funcione o de que haya dificultades en la conexión. Una consecuencia de ello es que la preparación de los estados financieros y operativos puede no ser posible dentro del marco temporal que pretendían las significativas inversiones en tecnologías realizadas en los últimos años. El debate continúa Es probable que en los años ochenta un problema fuera cómo garantizar que los sistemas de correo electrónico pudieran comunicarse en 6 El impulso hacia la centralización: el péndulo vuelve a cambiar un formato que no fuera simplemente texto. Hoy día, sin embargo, no hay duda con respecto a la capacidad de conexión, a pesar de que es posible que características tales como las libretas de direcciones no se comuniquen perfectamente entre, digamos, el Outlook de Microsoft y Lotus Notes. Por tanto, el problema es más una cuestión de ajuste en este último impulso hacia la recentralización. Además, en el contexto de los servidores descentralizados, no sólo es más difícil la aplicación de estándares, sino que también se ve afectada la seguridad de la información. Es mucho más fácil aplicar estrictos controles de acceso de seguridad cuando hay pocas entradas o cuando los puntos de entrada están centralizados. La centralización, según Malone, reduce “la complejidad de entornos con múltiples servidores y las numerosas solicitudes de cambio de red”. A pesar de que se ha defendido una arquitectura TI descentralizada como una forma de lograr que un sistema TI sea más tolerante a los fallos en caso de que tenga lugar la eliminación de un nodo (por ejemplo, en el caso de un devastador ataque terrorista), nosotros opinamos exactamente lo contrario. La eliminación de un nodo podría inutilizar o comprometer la parte en concreto de las operaciones o contenido que era responsabilidad de ese nodo, a menos que el nodo haya sido duplicado totalmente en otro lugar. La probabilidad de duplicar todos los nodos imaginables está limitada por el coste. Por tanto, una instalación centralizada con múltiples puntos de respaldo y de duplicación es la plataforma de arquitectura TI con mayores probabilidades no sólo de sobrevivir a un desastre, sino también de hacerlo a un coste razonable. Esto se ve agravado por las dificultades inherentes a la hora de gestionar múltiples aplicaciones de software que realizan operaciones de respaldo en diferentes ubicaciones. Además, la centralización tiende a reducir la redundancia de los datos y las actualizaciones incongruentes. Algunos ejemplos Algunas razones van más allá de los aspectos técnicos. Por ejemplo, Valeo, un fabricante de piezas para automóviles francés, con una estructura compleja y tradicionalmente muy descentralizada de 180 plantas de producción en todo el mundo y más de 100 divisiones operativas independientes, descubrió que, debido a cuentas de explotación independientes, los directivos de las divisiones tenían pocos incentivos para trabajar juntos con el fin de optimizar los beneficios globalmente. La solución de la empresa consistió en aumentar el uso de Internet para que los grupos estuvieran más interconectados y pudieran Es mucho más fácil aplicar estrictos controles de acceso de seguridad cuando hay pocas entradas o cuando los puntos de entrada están centralizados 7 El impulso hacia la centralización: el péndulo vuelve a cambiar beneficiarse mutuamente –un importante movimiento hacia la centralización–. Entre otras soluciones, la compañía también creó catálogos web, mejoró las adquisiciones entre las unidades creando economías de escala y abordó los problemas de calidad. Cemex, un importante productor de cemento mexicano, se encontró compitiendo con gran éxito con fabricantes de renombre mundial. La clave fue la automatización de la producción mediante una gran variedad de aplicaciones TI específicas. Además de reducir el número de trabajadores, la integración de los datos resultante mejoró el control de calidad y la gestión de las ventas. A pesar de que seguía siendo necesario hardware TI en una forma distribuida, la información se transmitía a una localización centralizada para su análisis y gestión en tiempo real. Cemex ha crecido a través de fusiones y adquisiciones. Curiosamente, inmediatamente después de una determinada adquisición, la empresa impulsa la armonización de sus sistemas técnicos y de gestión con los de las empresas del holding. En la actualidad, los planes exigen la utilización de un solo portal personalizado, con las operaciones centralizadas a través de Internet. Otro ejemplo es Siemens, un conglomerado de empresas con más de 24 unidades de negocio que operan en 190 países y emplean a 470.000 personas. Hasta hace poco, era muy poco probable que sus unidades intercambiaran información como consecuencia de sus sistemas tecnológicos y su estilo de gestión altamente descentralizados. Sin embargo, el consejero delegado creó un plan con cuatro principios, tres de los cuales requieren una fuerte centralización de TI, aun cuando también incluyen una serie de piezas descentralizadas; entre ellas, la gestión del conocimiento, las compras on-line y las relaciones con los clientes. Desde más de veinte países, el cliente puede hacer clic en “Comprar en Siemens” y realizar un pedido. El cuarto principio consiste en modificar la cadena de valor de la empresa, incluyendo las solicitudes de empleo. Con el fin de lograr estos objetivos, es necesario unir el fragmentado conjunto de sistemas, creando un enfoque corporativo estandarizado. La centralización tiende a reducir la redundancia de los datos y las actualizaciones incongruentes 8 Por último, es mucho más fácil iniciar cualquier proyecto de externalización partiendo de una arquitectura TI centralizada; por consiguiente, esta arquitectura ofrece a los directivos una mejor selección de alternativas. Implicaciones ¿Cuáles son las consecuencias de este argumento? La respuesta varía según el sector, el tipo de organización (grande o pequeña), el tipo de El impulso hacia la centralización: el péndulo vuelve a cambiar vinculación (orientada a otras empresas o a los consumidores), el ancho de banda, las necesidades de conexiones en tiempo real y la cantidad de información que es necesario intercambiar a la hora de realizar informes o generar transferencias que requieren la toma de decisiones. Por tanto, es posible que nuestras conclusiones tengan importantes implicaciones para una organización en un extremo al tiempo que sirven de recordatorio para una organización en el otro extremo. Una organización debe considerar dos aspectos para comprender su posición con respecto a la recentralización de la arquitectura TI de hardware. El primer aspecto es la estructura de toma de decisiones. A pesar de que un pormenorizado debate sobre este tema va más allá del tema de este artículo, sus implicaciones son críticas para el desarrollo de las mejores soluciones posibles de arquitectura TI de hardware. En otras palabras, ¿qué herramientas precisan las personas que toman las decisiones, especialmente aquéllas cuyas responsabilidades abarcan todo el planeta? ¿Y qué grado de centralización de su arquitectura TI de hardware podría satisfacer mejor sus necesidades? La decisión con respecto al grado de centralización varía probablemente según el tamaño y los vínculos de la organización con otras organizaciones J. Roberto Evaristo El segundo aspecto es el estado de los indicadores clave del negocio para la centralización de la arquitectura TI. La decisión con respecto al grado de centralización varía probablemente según el tamaño y los vínculos de la organización con otras organizaciones. Cuanto mayores sean el grado de conexión y dispersión de una gran organización (en especial, si algunas partes se encuentran en áreas con una infraestructura menos adecuada o en áreas menos estables políticamente), la dependencia de la información en tiempo real para tomar las decisiones, el interés en reunir datos en tiempo real o la vulnerabilidad ante una catástrofe en parte de su red, mayor es su necesidad de centralización de las TI de hardware. I Profesor auxiliar del Departamento de Ciencias de la Información y Decisión de la University of Illinois. © ACM. Kevin Hollister Kevin C. Desouza Doctorando del Departamento de Ciencias de la Información y Decisión de la University of Illinois. Director de sistemas de la información de Vivendi Water Systems en Madrid. 9

Anuncio

Documentos relacionados

Descargar

Anuncio

Añadir este documento a la recogida (s)

Puede agregar este documento a su colección de estudio (s)

Iniciar sesión Disponible sólo para usuarios autorizadosAñadir a este documento guardado

Puede agregar este documento a su lista guardada

Iniciar sesión Disponible sólo para usuarios autorizados