PRCTICA 9: PROPIEDADES DESEABLES DE LOS ESTIMADORES

Anuncio

1

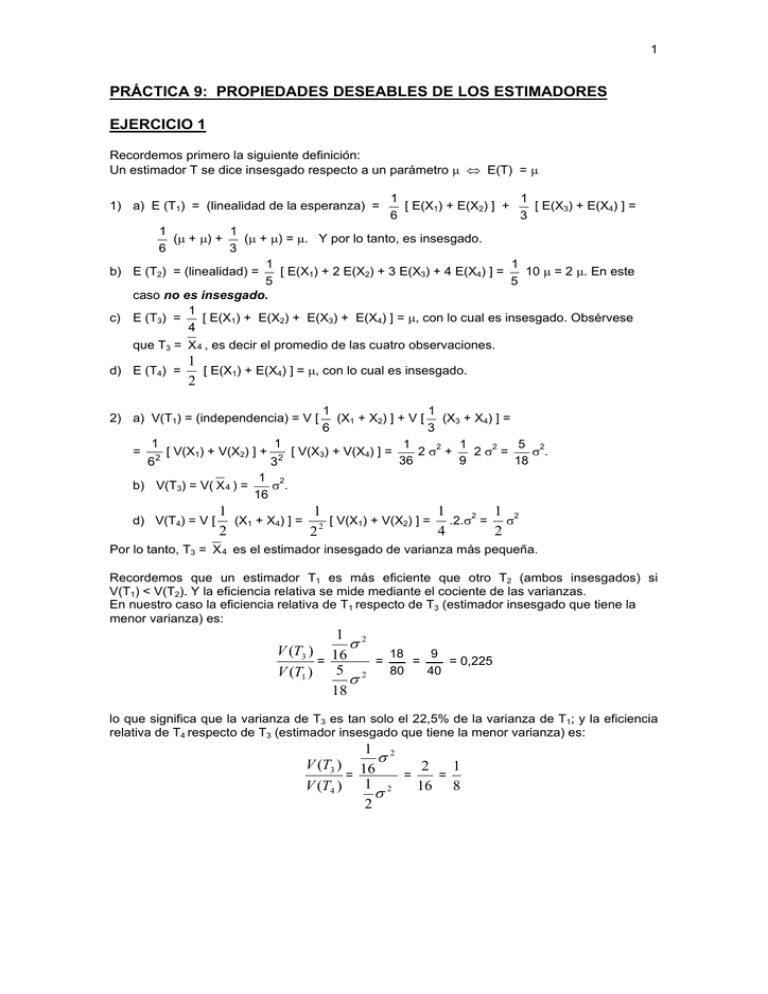

PRÁCTICA 9: PROPIEDADES DESEABLES DE LOS ESTIMADORES

EJERCICIO 1

Recordemos primero la siguiente definición:

Un estimador T se dice insesgado respecto a un parámetro μ ⇔ E(T) = μ

1) a) E (T1) = (linealidad de la esperanza) =

1

1

[ E(X1) + E(X2) ] +

[ E(X3) + E(X4) ] =

6

3

1

1

(μ + μ) +

(μ + μ) = μ. Y por lo tanto, es insesgado.

6

3

1

1

[ E(X1) + 2 E(X2) + 3 E(X3) + 4 E(X4) ] =

10 μ = 2 μ. En este

b) E (T2) = (linealidad) =

5

5

caso no es insesgado.

1

[ E(X1) + E(X2) + E(X3) + E(X4) ] = μ, con lo cual es insesgado. Obsérvese

c) E (T3) =

4

que T3 = X 4 , es decir el promedio de las cuatro observaciones.

d) E (T4) =

1

[ E(X1) + E(X4) ] = μ, con lo cual es insesgado.

2

1

1

(X1 + X2) ] + V [ (X3 + X4) ] =

6

3

1

1

1

1

5 2

2 σ2 +

2 σ2 =

σ.

= 2 [ V(X1) + V(X2) ] + 2 [ V(X3) + V(X4) ] =

36

9

18

6

3

1 2

σ.

b) V(T3) = V( X 4 ) =

16

2) a) V(T1) = (independencia) = V [

d) V(T4) = V [

1

1

1

1

(X1 + X4) ] = 2 [ V(X1) + V(X2) ] = .2.σ2 = σ2

2

4

2

2

Por lo tanto, T3 = X 4 es el estimador insesgado de varianza más pequeña.

Recordemos que un estimador T1 es más eficiente que otro T2 (ambos insesgados) si

V(T1) < V(T2). Y la eficiencia relativa se mide mediante el cociente de las varianzas.

En nuestro caso la eficiencia relativa de T1 respecto de T3 (estimador insesgado que tiene la

menor varianza) es:

1 2

σ

V (T3 ) 16

18

9

=

=

=

= 0,225

80

40

V (T1 ) 5 2

σ

18

lo que significa que la varianza de T3 es tan solo el 22,5% de la varianza de T1; y la eficiencia

relativa de T4 respecto de T3 (estimador insesgado que tiene la menor varianza) es:

1 2

σ

V (T3 ) 16

2

1

=

=

=

V (T4 ) 1 2

16 8

σ

2

2

EJERCICIO 2

n

1) E(T) = E (

∑

n

n

ai Xi ) = (linealidad de la esperanza) =

i =1

∑

∑

ai E ( Xi ) =

i =1

n

ai μ = μ

i =1

∑a = μ

i

i =1

si la suma de los ai es igual a la unidad.

n

2) V(T) = V (

∑

n

ai Xi ) = (independencia) =

i =1

∑

n

n

V (a i X i ) =

i =1

∑

∑a

ai2 V ( Xi ) =

i =1

2

i

σ2 =

i =1

⎡

1⎞

1⎤

1

⎛

⎢

ya que la expresión de la sumatoria

⎜ ai − ⎟ + ⎥ σ 2 , que es mínimo cuando ai =

n

n

n

⎢⎣ i =1 ⎝

⎥⎦

⎠

es positiva o cero y por ello su mínimo se alcanza cuando ella es nula.

2

n

∑

n

Observación: Nótese que lo demostrado implica que T es

∑n X = X

1

i

n

.

i =1

3) El Error Cuadrático Medio de un estimador T respecto a un parámetro θ se define como

E [ (T – θ)2 ]. Se puede demostrar fácilmente además que:

ECM (T) = V(T) + [ Sesgo(T) ]2 donde Sesgo(T) = E(T) – θ

Observación: si T es insesgado, entonces ECM(T) = V(T)

E(T) = μ, que se deduce de 1) pues: (0,2 + 0,1 + 0,4 + 0,3) = 1

ECM(T) es entonces V(T):

V(T) = (independencia) = 0,22 V(X1) + 0,12 V(X2) + 0,42 V(X3) + 0,32 V(X4) = 0,30 σ2

4) si E(X2) = 2 μ2, entonces V(X) = E(X2) – E2(X) = 2 μ2 – μ2 = μ2 = σ2

Por lo tanto: ECM(T) = V(T) = 0,3 μ2

Por otra parte el ECM(T*) = V(T*) + [ Sesgo(T*) ]2 = 0 + [ Sesgo(T*) ]2 = (2 – μ)2

ECM(T) < ECM(T*) ⇔

0,3 μ2 < (2 – μ)2 ⇔ 0,7 μ2 – 4 μ + 4 > 0 ⇔ μ < 1,29 ó

μ > 4,42. En otras palabras, cuando μ está relativamente cerca de 2 (entre 1,29 y 4,42), T*

es más eficiente que T.

EJERCICIO 3

1) Para que sea una densidad es necesario que

∫

+∞

θ

k e θ − x dx = 1 ⇔ – k eθ – x

+∞

θ

=1 ⇔

k = 1.

2) E(X) =

∫

+∞

θ

x e θ − x dx = – x eθ – x

+∞

θ

–

∫

+∞

θ

–

+∞

− e θ − x dx = (T. De ódenes) = θ +

θ

∫

+∞

θ

e θ − x dx

= θ + 1.

E(X2) =

∫

+∞

θ

x 2 e θ − x dx = – x2 eθ – x

∫

+∞

θ

− 2x e θ − x dx = θ2 + 2 E(X) = θ2 + 2 (θ + 1).

V(X) = E(X2) – E2(X) = θ2 + 2 (θ + 1) – (θ + 1)2 = 1.

3) Como Z = mín ⎨X1, ..., Xn ⎬, por el Ejercicio 28, Práctica 4 sabíamos que:

fZ(z) = n [ 1 – FX(z) ]n-1 fX(z)

Calculemos pues FX:

FX(z) = 0 si z < θ

3

∫

FX(z) =

z

θ

e θ − x dx = – eθ – x

z

θ

= 1 – eθ – z, si z ≥ θ

Por lo tanto:

fZ(z) = 0, si z < θ

fZ(z) = n [eθ – z] n-1 eθ – z = n [eθ – z] n = n en(θ – z), si z ≥ θ

4) E(Z) =

∫

+∞

θ

x n en ( θ − x ) dx = – x en (θ – x)

+∞

θ

–

∫

+∞

θ

− en ( θ − x ) dx = θ –

1 n (θ – x)

e

n

+∞

θ

=θ+

1

n

1

1

1

1

5) E(θ*) = E(Z − ) = E(Z) − = θ +

− = θ. Por tanto, θ* es insesgado de θ.

n

n

n

n

6) E(θ*) = θ y E(θ**) = E( Xn – 1) = E( Xn ) – 1 = E(X) – 1 = θ + 1 – 1 = θ. Por lo tanto ambos

estimadores son insesgados. En cuanto a la varianza:

1

V( X)

1

1

V(θ*) = V(Z − ) = V(Z) = 2 y V(θ**) = V( Xn – 1) = V( Xn ) =

= .

n

n

n

n

Concluimos, entonces, que θ* es más eficiente que θ**, ya que ambos son insesgados

pero V(θ*) < V(θ**) ( la varianza de θ* tiende más rápidamente a cero que θ**, pues es un

infinitésimo orden es 2, mientras que el orden de θ* es 1).

EJERCICIO 4

1) ECM(T1) = ECM( 2 Xn ) = V(2 Xn ) + [ Sesgo(2 Xn ) ]2. Pero:

b+0

E( Xn ) = E(X) =

⇒ E(2 Xn ) = b ⇒ Sesgo(2 Xn ) = 0

2

2

2

b

b2

V( X)

⎛b −0⎞ 1

= ⎜

⇒ V(2 Xn ) = 4×

⇒ ECM(T1) =

⎟

n

3n

12. n

⎝ 12 ⎠ n

Para calcular ECM(T2) es necesario resolver la parte 2).

V( Xn ) =

2) Por el Ejercicio 28, Práctica 4 deducimos que:

⎛t⎞

f T2 (t ) = n FXn −1(t ) fX (t ) = n ⎜ ⎟

n −1

⎝b⎠

1

, para 0 ≤ t ≤ b

b

= 0, en otro caso

E(T2) =

E( T22 )

=

∫

b

0

∫

⎛t⎞

tn⎜ ⎟

⎝b⎠

b

0

n −1

⎛t⎞

t n⎜ ⎟

⎝b⎠

2

n

1

dt = n

b

b

n −1

∫

b

t n dt =

0

n

1

dt = n

b

b

∫

b

0

n

bn

t n +1 dt =

t n +1

n +1

n

bn

b

0

=

tn + 2

n+2

n

bn

b

0

=

b n +1

n

=

b

n +1 n +1

n

bn

bn + 2

n

=

b2

n+2

n+2

2

n

n

⎛ n

⎞

b2 – ⎜

b2

b⎟ =

n+2

(n + 2) (n + 1)2

⎝n +1 ⎠

Por lo tanto:

V(T2) =

ECM(T2) =

n

(n + 2) (n + 1)2

b2 + (

2 b2

n b2

b2

n

b – b)2 =

+

=

(n + 2) (n + 1)

n +1

(n + 2) (n + 1)2

(n + 1)2

Concluimos, entonces que si bien T1 es insesgado, T2 es asintóticamente insesgado, esto

n

b . Además, la V(T1) y el ECM(T1) son infinitésimos de orden uno, y como

es, E(T2) ⎯⎯→

V(T2) y el ECM(T2) lo son de orden 2, resulta más conveniente, para un tamaño de muestra

suficientemente grande, el estimador T2. Si se calcula el cociente de los errores cuadráticos

medios, se encuentra que para n = 1 y n = 2 ambos estimadores son igualmente eficientes,

mientras que para n ≥ 3 es más eficiente T2.

4

b2

. Y como X cumple las

3n

hipótesis del Teorema del Límite Central, es decir, E(X) y V(X) son ambas finitas, podemos

concluir que:

b2

d

N (b,

)

T1 ⎯⎯→

n→+∞

3n

4) Hacer una representación gráfica de la distribución exacta obtenida en 2) y la

distribución aproximada obtenida en 3). A mayor n, ambas densidades se “concentran”

cada vez más en b. Reflexionar sobre la velocidad de convergencia.

3) Vimos anteriormente que: E(T1) = E(2 Xn ) = b y V(T1) =

EJERCICIO 5 (CANAVOS 8.7)

1. La Desigualdad de Cramer-Rao nos plantea una cota para la varianza de los estimadores

insesgados siempre que su función de probabilidad (continua, discreta o mixta) sea “regular”.

Si θ̂n es un estimador insesgado, entonces:

V (θˆn ) ≥

1

⎛ ∂ L f ( X ,θ ) ⎞

⎟⎟

n E ⎜⎜

∂θ

⎝

⎠

2

Además, si existe un estimador θ̂n que alcanza la cota, éste se dice eficiente.

En nuestro caso:

f (X, θ) =

1 −

e

θ

E(

X

θ

X

∂ L [ f ( X, θ) ]

X

1

⇒

=– + 2 ⇒

θ

∂θ

θ

θ

⇒ L [f (X, θ) ] = – L θ –

X−θ

V( X)

1

∂ L [ f ( X, θ) ] 2

E ( X − θ )2

) = E ( 2 )2 =

=

= 2

4

4

∂θ

θ

θ

θ

θ

Por lo tanto:

V (θˆ n ) ≥

1

n×

1

=

θ2

n

θ2

2. Recordemos que:

σ2

θ2

=

n

n

es insesgado y alcanza la cota de Cramer-Rao y por ello es eficiente para

E( Xn ) = μ = θ (en este caso) y V( Xn ) =

Entonces Xn

estimar θ.

EJERCICIO 6

1) Obsérvese en primer lugar que el vector (Y1, Y2, …, Yn) es una transformación del vector

(X1, X2, …, Xn) donde cada Yi depende exclusivamente del correspondiente Xi. Por lo visto

en el curso teórico, la independencia de las Xi implica también la independencia de las Yi.

Calculemos entonces la esperanza y varianza de Yi, para los i tales que 1 ≤ i ≤ n:

E(Yi) = 1.P(Xi = 0) + 0.P(Xi ≠ 0) = 1.θ + 0 = θ

E( Yi2 ) = 12.P(Xi = 0) + 02.P(Xi ≠ 0) = 12.θ + 0 = θ

V(Yi) = E( Yi2 ) – E2 (Yi) = θ – θ2 = θ (1 – θ)

Observemos que las variables Yi tienen, entonces, distribución Bernoulli(θ) para i = 1, 2,..,n.

5

Por lo tanto:

E(θ*) = E (

1

n

2) V(θ*) = V (

n

∑

Yi ) =

i =1

1

n

n

∑

1

n

i =1

n

∑

1

n

E ( Yi ) = (igual distrib.) =

Yi ) =

i =1

1

n2

n

∑ θ = θ.

i =1

n

∑

V(

1

Yi )) = (indep.) =

n2

i =1

n

∑V(Y )

i

= (igual distrib.) =

i =1

θ (1 − θ)

n

n

Encontremos ahora la Cota de Cramer-Rao para los estimadores insesgados de θ. Para

ello utilizaremos las Yi, dado que si X1, ..., Xn son independientes e idénticamente

distribuidas, también los son Y1, ..., Yn. Incluso, por lo visto en 1) observamos que cada Yi

se distribuye Bernoulli(θ) y por lo tanto:

p (Y, θ) = θY (1 – θ)1 – Y ⇒ L [p (Y, θ) ] = Y L θ + (1 – Y) L (1 – θ) ⇒

∂ L [ p ( Y, θ) ]

Y−θ

∂ L [ p( Y, θ) ] 2 E ( Y − θ)2

V( Y )

1− Y

Y

=

=

⇒ E(

) = 2

= 2

⇒

+

2

∂θ

1− θ

θ (1 − θ)

∂θ

θ

θ (1 − θ)

θ (1 − θ)2

1

2

=

n θ (1 − θ) =

θ (1 − θ)

θ (1 − θ)

2

2

=

1

θ (1 − θ)

⇒ V (θˆ n ) ≥

, por lo que θ* es de mínima varianza.

θ (1 − θ)

n

3) Como θ* es de mínima varianza, entonces es eficiente y, por lo tanto, asintóticamente

eficiente. Además, aplicando el Teorema del Límite Central, como {Yi } 1 ≤ i ≤n es una M.A.S.

c/r, donde cada Yi ∼ Bernoulli(θ) se tiene que:

Y n = θ* → N (θ,

θ (1 − θ)

)

n

EJERCICIO 7 (NOVALES 9.8)

Un estadístico U se dice suficiente para estimar un parámetro θ (Teorema de Factorización), si

dada una muestra X1, ..., Xn, la función de probabilidad conjunta muestral L puede

descomponerse como el producto de una función φ del estadístico por otra función h,

independiente del parámetro θ. Esto es:

L(x1, ..., xn; θ) = φ [ u(x1, ..., xn); θ) ] h(x1, ..., xn)

Si tenemos una M.A.S. c/r entonces:

−

n

L(x1, ..., xn; θ) =

∏

i =1

1 −

e

θ

xi

θ

=

1

θn

e

n

∑ xi

i =1

θ

=

1

θn

− n xn

e

θ

La demostración se completa observando que:

φ [ u(x1, ..., xn); θ) ] =

1

θn

− n Xn

e

θ

y h(x1, ..., xn) ≡ 1; donde u(x1, ..., xn) =

xn

EJERCICIO 8 (NOVALES 9.10)

En este caso:

n

n

L(x1, ..., xn; λ) =

∏

i =1

Entonces tomando:

e− λ

∑ xi

λ

= e − n λ λ i =1

xi !

xi

n

∏

i =1

1

= e − n λ λ n Xn

xi !

n

∏

i =1

1

xi !

6

φ [ u(x1, ..., xn); λ) ] = e − n λ λ n X n y h(x1, ..., xn) =

n

∏

1

xi !

i =1

queda demostrado el ejercicio.

EJERCICIO 9 (NOVALES 9.10)

La información de Fisher es el inverso de la Cota de Cramer-Rao para las funciones de

probabilidad que satisfacen algunas condiciones de regularidad y se denota I(θ). En nuestro

caso:

−

1

f (X, μ) =

e

2π σ

1

2

⎛ x −μ ⎞

⎜⎜

⎟⎟

⎝ σ ⎠

2

2

⇒ L [f (X, μ) ] = – L

1⎛ X −μ⎞

⎜

⎟ ⇒

2⎝ σ ⎠

2π σ –

V( X)

1

∂ L [ f ( X, μ) ]

∂ L [ f ( X, μ) ] 2 E ( X − μ )2

1

⎛X−μ⎞

=– ⎜

) =

=

= 2

⎟ (− ) ⇒ E (

4

4

∂μ

σ

∂

μ

σ

σ

σ

σ

⎝

⎠

Y por lo tanto:

I(μ) = n

1

σ

2

=

n

σ2

EJERCICIO 10

1) Estudiemos

la

eficiencia

1

Si f (X, μ) =

−

1

2π σ

e

estimador

meditante

la

Cota

de

Cramer-Rao:

.

2

⎛ ∂ L f ( X ,θ ) ⎞

⎟⎟

n E ⎜⎜

∂θ

⎝

⎠

del

⎛ x −μ ⎞

⎜⎜

⎟⎟

⎝ σ ⎠

1

2

2

2

1⎛ X −μ⎞

2π σ –

⎜

⎟ ⇒

2⎝ σ ⎠

⇒ L [f (X, μ) ] = – L

V( X)

1

∂ L [ f ( X, μ) ]

∂ L [ f ( X, μ) ] 2 E ( X − μ )2

1

⎛X−μ⎞

=– ⎜

) =

=

= 2

⎟ (− ) ⇒ E (

4

4

∂μ

σ

∂μ

σ

σ

σ

⎝ σ ⎠

Entonces, la Cota de Cramer Rao es σ2/n. Por otra parte, ya habíamos visto que Xn es

σ2

, con lo que deducimos que Xn es un estimador de mínima

n

varianza para μ, y por lo tanto es eficiente.

insesgado y que V ( Xn ) =

n

n

2) L(x1, ..., xn; μ) =

∏ f ( x , μ) = ∏

−

e

n

1

2

i =1

2π1

i =1

n

∑ ( xi − x + x − μ )2

i =1

∑ (x − x) = 0 ) = (

i

1

i

i =1

−

1

=

(

−

1

2π )

n

e

2 π )n

e

1

2

−

1

2

e

1

2

⎛ xi −μ ⎞

⎜⎜

⎟⎟

⎝ 1 ⎠

2

−

1

=

2π )

n

(

n

∑ ( x i − μ )2

i =1

=

1

(

2 π )n

n

∑ ( x i − x )2 − 2 ( xi − x ) ( x − μ ) + ( x − μ )2

i =1

= (observar que

n

∑ ( x i − x )2 + ( x − μ )2

i =1

e

1

2

=

−

1

(

2π )

n

e

1

2

n

∑ ( x i − x )2

i =1

−

e

1

2

n

∑ ( x − μ )2

i =1

7

Ahora si tomamos:

−

φ [ u(x1, ..., xn); μ) ] = e

n

∑ ( x − μ )2

1

2

i =1

; h(x1, ..., xn) =

1

e

2 π )n

(

n

∑ ( x i − x )2

1

2

−

i =1

,

x queda completa la demostración.

con u(x1, ..., xn) =

3) Para el caso de ( X )3 la factorización es la misma, la función h también y sólo varía φ

mínimamente:

−

φ [ u(x1, ..., xn); μ) ] = e

1

2

n

∑ (3

( x )3 − μ ) 2

i =1

; con u(x1, ..., xn) = ( x )3

Cuando tomamos como estadístico ( X )2 y llevamos a cabo el mismo procedimiento que

para ( X )3 el problema surge con las dos raíces (una positiva y otra negativa) de ( X )2.

4) Observamos que:

n

n

∏ f (x ,σ

L(x1, ..., xn; σ2) =

2

i

) =

i =1

1

1

(

(

−

1

1

σ

2π )

n

e

2 π )n σn

n

2 σ2

n

−

e

n

2σ

∏

−

1

2π σ

i =1

e

1

2

⎛ xi

⎜⎜

⎝σ

⎞

⎟⎟

⎠

2

=

n ( x − x + x )2

i

2 ∑

n

i =1

=

1

1

(

−

σ

2π )

n

e

n

−

1

e

2 π σ )n

(

1

2

n

⎛x ⎞

∑ ⎜⎜⎝ σi ⎟⎟⎠

2

i =1

=

n ( x − x )2 + x 2

i

n

2σ

2 ∑

n

i =1

=

2

(S 2 + x )

, con lo cual no se puede factorizar como en la definición.

Se concluye que S2 no es suficiente para estimar σ2. Sin embargo, si definimos un nuevo

n

estimador S*2 =

L(x1, ..., xn; σ ) =

∑X

2

i

i =1

, entonces siguiendo el mismo razonamiento que arriba obtenemos que:

n

1

2

(

2 π σ )n

−

e

1

2

n

⎛x ⎞

∑ ⎜⎜⎝ σi ⎟⎟⎠

i =1

2

=

1

(

1

2 π )n σn

−

e

n

2 σ2

n ( x )2

i

∑

i =1

n

=

(

−

1

1

2 π )n σn

e

n

2 σ2

S*2

Por lo que tomando:

φ [ u(x1, ..., xn); σ ) ] =

2

−

1

σ

n

e

n

2 σ2

S*2

; h(x1, ..., xn) =

(

queda demostrado que este sí es un estimador suficiente.

1

2 π )n

, con u(x1, ..., xn) = S*2

EJERCICIO 10 (NOVALES 9.31)

Recordemos, previamente,

que un estimador Xn de θ es consistente

⇔

p

Xn ⎯⎯→

θ.

n → +∞

Asimismo la Desigualdad de Chebychev dice que dada una v.a. X, con E(X) = μ < ∞ y V(X) <

∞, entonces se cumple que:

V( X )

P ( X − μ ≥ ε) ≤ 2

ε

n

Sea, luego, un estimador Xn de θ, asintóticamente insesgado, esto es: E(Xn) ⎯⎯→

θ y con

p

p

n

0 . Debemos probar que Xn ⎯⎯→

θ , es decir que: P ( Xn − θ ≥ ε ) ⎯⎯→ 0 .

V(Xn) ⎯⎯→

n → +∞

n → +∞

8

n

n

0 , ya que V(Xn) ⎯⎯→

0 y Xn es asintóticamente

ECM(Xn) = V(Xn) + [Sesgo(Xn)]2 ⎯⎯→

n

0.

insesgado respecto de θ y por lo tanto Sesgo(Xn) ⎯⎯→

2

2

2

Pero como ECM(Xn) = E [(Xn – θ) ] = E [(Xn – θ) 1⎧

2 ⎫ ] + E [(Xn – θ) 1⎧ ( X − θ )2 < ε 2 ⎫ ]

2

⎨ ( Xn − θ ) ≥ ε ⎬

⎨

⎬

n

⎩

⎭

≥ (ambas expresiones son positivas) ≥ E [(Xn – θ) 1⎧

⎩

2

2⎫

2

⎨ ( Xn − θ ) ≥ ε ⎬

⎩

⎭

ε2 P [(Xn – θ)2 ≥ ε2 ] = ε2 P (

⎭

] ≥ ε E [ 1⎧

2

2⎫

2

⎨ ( Xn − θ ) ≥ ε ⎬

⎩

⎭

]=

n

n

Xn − θ ≥ ε ) ⎯⎯→

0 , pues ECM(Xn) ⎯⎯→

0 . Por lo tanto

concluimos que:

p

n

P ( Xn − θ ≥ ε ) ⎯⎯→

0 y que P ( Xn − θ ≥ ε ) ⎯⎯→ 0

n → +∞

EJERCICIO 11

a) Observemos que X ∼ Bernoulli(p) es un caso particular de X ∼ FX(x) con μ y σ2 finitas.

Notemos ahora que cumple las condiciones del ejercicio anterior:

σ2

n

⎯⎯→

0 . Finalmente, si Xn es insesgado

b) Ya sabemos que E( Xn ) = μ y V( Xn ) =

n

respecto de μ, también es asintóticamente insesgado y por lo tanto es consistente como

estimador de μ.

EJERCICIO 12

1) Fn*(a) es un estadístico pues es una variable aleatoria que sólo depende de la muestra, si

“a” es una constante conocida, y el tamaño de la muestra fijo. Fn*(a) se llama “función de

distribución empírica de la muestra” pues proporciona la frecuencia acumulada hasta “a”.

2) E (Fn*(a)) = E (

distribución) =

V (Fn*(a)) =

1

n2

1

n

n

∑

i =1

1{ X i

≤ a} ) = (linealidad) =

1

n

n

∑

i =1

E (1{ X i

≤ a} ) =

1

n

n

∑P(X ≤ a )

i

= (igual

i =1

1

n P ( X ≤ a ) = P ( X ≤ a ) = p.

n

n

V(

∑

i =1

Pero V ( 1{ Xi ≤ a } ) = E

1{ X i

[

≤ a} ) ) = (independencia) =

( 1{ X i ≤ a } )2

] – E2 [

( 1{ X i ≤ a } )

1

n2

n

∑ V (1{

i =1

]=E[

X i ≤ a} ) )

( 1{ Xi ≤ a } )

.

] – E2 [

( 1{ X i ≤ a } )

= P ( Xi ≤ a ) – P ( Xi ≤ a ) = (igual distribución) = p (1 – p)

Finalmente:

2

V (Fn*(a)) =

1

n

2

n

∑ V (1{

i =1

X i ≤ a} )

=

1

n

2

n p (1 − p ) =

p (1 − p)

n

3) Fn*(a) es consistente por el Ej. 11, ya que E (Fn*(a)) = p y V (Fn*(a)) =

p (1 − p)

n

⎯⎯→

0.

n

]