Infesta Domínguez, G. (1996). “Diseños experimentales

Anuncio

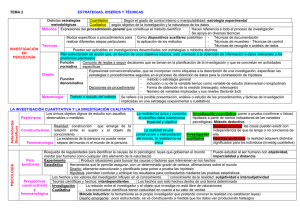

DISEÑOS EXPERIMENTALES: SU UTILIDAD EN LA FORMACION METODOLOGICA EN SOCIOLOGIA Graciela Infesta Domínguez Trabajo presentado a las Segundas Jornadas de Sociología de la Universidad de Buenos Aires, tituladas "1976-1986. Veinte años después: las huellas del pasado reciente en la Argentina de hoy", Buenos Aires, 11 al 13 de noviembre de 1996. RESUMEN El presente trabajo constituye una propuesta sobre cómo encarar la enseñanza de los diseños experimentales: qué aspectos conceptuales deberían abordarse en la clase y en qué secuencia, qué ejemplos podrían utilizarse y con qué finalidad y qué tipo de ejercicios podrían proponerse a los alumnos para que apliquen los temas discutidos en clase. En tanto los estudios experimentales constituyen estudios explicativos que responden a un modelo lógico de inferencia causal, en la primer parte de este trabajo nos referimos a las nociones de "explicación" y "causalidad". A continuación, nos referimos las características de los diseños experimentales en términos de su estructura y sus componentes básicos, poniendo énfasis en los factores que afectan la validez interna y externa de estos diseños. Luego, presentamos los distintos tipos de diseños experimentales más comúnmente utilizados en las ciencias sociales, señalando las ventajas y desventajas de cada uno de ellos. Por último, proponemos algunos ejemplos de investigaciones, así como ejercicios para los alumnos que podrían resultar herramientas pedagógicas útiles en la enseñanza de la temática en cuestión. 1 DISEÑOS EXPERIMENTALES: SU UTILIDAD EN LA FORMACION METODOLOGICA EN SOCIOLOGIA 1 2 Graciela Infesta Domínguez I. INTRODUCCION Una vez que el problema de investigación ha sido formulado en una forma suficientemente clara para especificar los tipos de información necesitada, el investigador debe decidir el diseño de investigación que se adecue más al mismo. El diseño de investigación "... es el programa que guía al investigador en el proceso de recoger, analizar e interpretar observaciones" (Nachmias y Nachmias, 1992). Los diseños de investigación serán distintos según sean los objetivos de la misma. Haciendo una síntesis, podemos decir que "cada estudio tiene sus propios objetivos pero es posible clasificar los objetivos de investigación en los siguientes grandes grupos: 1. avance en el conocimiento de un fenómeno o alcanzar nuevos aspectos del mismo, con frecuencia con el propósito de formular un problema de investigación con mayor precisión o para poder explicitar otras hipótesis; 2. descripción, con mayor precisión, de las características de un determinado individuo, situación o grupo (con o sin específicas hipótesis iniciales acerca de la naturaleza de tales características); 3. determinación de la frecuencia con la que algo ocurre o con la que algo se halla asociado relacionado con otro factor (generalmente, pero no siempre, con una hipótesis inicial específica) 4. comprobación de una hipótesis causal entre variables" (Selltiz et al., 1965). Los estudios que se encuadran en el primero de los grupos enunciados se denominan exploratorios. En estos estudios "... el énfasis mayor recae en el descubrimiento de ideas y aspectos profundos... Muchos estudios exploratorios tienen como objeto la formulación de un problema para posibilitar una investigación más precisa o el desarrollo de una hipótesis. Un 1 Este trabajo fue elaborado en ocasión del Concurso para el Cargo de Profesor Adjunto de la Cátedra de Metodología de la Investigación, Carrera de Sociología, Facultad de Ciencias Sociales, Universidad de Buenos Aires, realizado el 25 de septiembre de 1996. 2 Esta clase será dada a alumnos que cursan Metodología de la Investigación I. Uno de los principales objetivos de esta materia es que los alumnos conozcan distintos tipos diseños de investigación. De acuerdo con el actual programa de la materia, los diseños experimentales se incluyen en la Unidad III en la que se analiza en particular la relación entre objetivos y diseños de investigación. 2 estudio exploratorio puede tener, sin embargo, otras funciones: aumentar la familiaridad del investigador con el fenómeno que desea investigar por medio de un estudio... mejor estructurado..., aclarar conceptos; establecer preferencias para posteriores investigaciones..." (Selltiz, et al., 1965), etc. Así, el mayor énfasis está puesto en el descubrimiento de aspectos profundos del objeto de estudio. Consecuentemente, estos estudios requieren diseños de investigación lo suficientemente flexibles como para permitir la consideración de numerosos aspectos distintos de un fenómeno. Los estudios a los que se refieren los grupos segundo y tercero los agrupamos bajo el epígrafe de estudios descriptivos. Los hemos considerado conjuntamente porque, desde el punto de vista de los procedimientos de investigación, comparten determinadas características importantes. "Las demandas de una investigación presupone mucho conocimiento anterior del problema que va a ser investigado... El investigador debe estar capacitado para definir claramente qué desea someter a medida y debe hallar los métodos adecuados para su medida. Además, debe ser capaz de determinar a quién debe incluirse en la definición de una `determinada comunidad' o `población dada'. En la recogida de pruebas para un estudio de estas características, lo que se necesita no es tanto una gran flexibilidad como una clara formulación de qué y quién van a ser medidos y las técnicas para medidas válidas y de confianza. Por estos motivo, los procedimientos a ser utilizados en los estudios descriptivos deben ser cuidadosamente planificados tomando todas las medidas para evitar los errores de sesgo" (Selltiz et al., 1965). Los estudios del grupo cuarto (estudios de comprobación de hipótesis causales) suelen denominarse estudios explicativos. Estos requieren procedimientos que no solamente disminuyan los riesgos de errores de sesgo y aumenten el grado de la confianza (como los descriptivos), sino que permitan inferir acerca de la causalidad. No es nuestra intención simplificar la cuestión pero sintéticamente podríamos decir (en una primera aproximación al tema) que describir es responder a la pregunta del cómo es algo, en tanto que explicar es responder a la pregunta por qué algo es o se presenta de determinada manera. En este sentido, los procedimientos más frecuentes para lograr dicha condición adquieren la forma de trabajo experimental. No obstante, es necesario aclarar que existen estudios referidos a la comprobación de hipótesis de relaciones causales que no constituyen diseños experimentales. En tanto que describir implica señalar aspectos reconocibles o signos característicos de las cosas, "al describir nos mantenemos en el mismo nivel proposicional de lo que estamos describiendo, no hay un cambio de plano. En cambio explicar (al menos en un sentido fuerte) sí implica un cambio de plano. Para decirlo rápidamente... explicar es subsumir, incorporar un hecho bajo un enunciado general" (Schuster, 1982). De hecho, estos diferentes tipos de estudio no son apenas susceptibles de distinción. Cualquier investigación dada puede contener en sí elementos de dos o más de las funciones descriptas como caracterizadoras de los distintos tipos de estudio. Sin embargo, es frecuente que en una investigación se ponga el énfasis en una sola de estas funciones y el estudio puede ser considerado como clasificado en la categoría correspondiente a su función primordial. En esta oportunidad, nos referiremos a los estudios explicativos, específicamente a los 3 estudios experimentales en tanto éstos constituyen un modelo lógico de inferencia causal. En este sentido, el presente trabajo constituye una propuesta sobre cómo abordar la enseñanza de los diseños experimentales: qué aspectos conceptuales deberían abordarse en la clase y en qué secuencia, qué ejemplos podrían utilizarse y con qué finalidad y qué tipo de ejercicios podrían proponerse a los alumnos para que apliquen los temas discutidos en clase. En relación a los aspectos conceptuales, en esta ocasión pondremos el énfasis en la estructura y los componentes de los diseños experimentales y en los distintos tipos de diseños experimentales más comúnmente utilizados en las ciencias sociales. Dejaremos para otra oportunidad la presentación de los procedimientos estadísticos de análisis e interpretación de los resultados producidos en los estudios experimentales, así como otros estudios explicativos que realicen inferencias causales a través de otros procedimientos que no sean el experimental. II. LA UTILIDAD DE LOS DISEÑOS EXPERIMENTALES EN SOCIOLOGIA El diseño experimental clásico es usualmente asociado con la investigación en las ciencias biológica y física. Las causas por las cuales los diseños experimentales son útiles en las ciencias sociales son dos: 1. el diseño experimental clásico nos ayuda a comprender la lógica de todos los diseños de investigación. Es un modelo contra el cual nosotros podemos analizar otros modelos. Así, cuando nosotros comprendemos la estructura y la lógica del diseño experimental clásico, podemos comprender las limitaciones de otros diseños (Nachmias y Nachmias, 1992), así como sus ventajas; 2. la significancia del experimento estriba en que permite al investigador hacer inferencias causales y observar, con relativamente pocas dificultades, si la variable independiente causa o no cambios en la variable dependiente (Nachmias y Nachmias, 1992). El experimento es menos usado en las ciencias sociales, en primer lugar, porque es una estructura rígida que a menudo no puede ser adaptado a la investigación social. Así, los científicos sociales frecuentemente usan diseños que son más débiles para realizar inferencias causales pero que resultan más apropiados para el tipo de problemas que tienen que analizar, tales como, por ejemplo, los diseños denominados cuasiexperimentales. No obstante, los experimentos ciertamente son usados en las ciencias sociales. Incluso, en algunos campos de las ciencias sociales, como ocurre en la psicología social, los diseños predominantemente utilizados son los experimentales. Por otra parte, el uso de experimentos ha llegado a difundirse más en los análisis de políticas y evaluación de proyectos. Tal como dijimos anteriormente, los estudios experimentales son estudios explicativos que constituyen un modelo lógico de inferencia causal. En este sentido, es necesario aclarar que hay diferentes tipos de explicación. Así, podemos interesarnos en la explicación de una ley o de sucesos, estados de cosas o hechos singulares. "Típicamente la explicación de una ley se realiza a partir de otras leyes, deduciéndola de otras más generales, de un nivel más teórico. Es decir, explicar una ley es algo relativo que consiste en situarla en el contexto de otras leyes... También 4 podemos explicar los hechos singulares haciendo referencia a aspectos más generales. Y esto nos lleva a formular el modelo de explicación más riguroso y exigente, el nomológicodeductivo. Por supuesto, este modelo, desarrollado por Popper, Hempel, Nagel, se puede aplicar tanto a hechos singulares como generales" (Schuster, 1986). Por ejemplo, "ante el hecho... de que un trozo de hierro, en un instante dado, se dilata con el calor, podemos preguntarnos por qué ocurre este fenómeno. Para responder adecuadamente, buscamos enunciados generales (leyes) dentro de las cuales el hecho en cuestión (el enunciado que lo describe) queda incluido. Para evitar confusiones, no se trata de obtener el enunciado general a partir del hecho singular (mediante una inferencia inductiva), sino encontrar una ley o leyes que ya han sido formuladas previamente en el contexto de que se trate y de la que, como veremos, el hecho en cuestión puede deducirse. En nuestro simple caso, encontraríamos la ley general `Todos los metales se dilatan con el calor'. Pero la explicación no está así terminada, pues, incluso, no se puede hacer propiamente la deducción si no conocemos ciertos datos, condiciones iniciales o circunstancias particulares; en nuestro ejemplo, que el hierro es un metal" (Schuster, 1986). Existen otro tipo de explicaciones que guardan relación con la estructura lógica anteriormente expuesta y que son las que nos interesan en esta oportunidad. Nos referimos a las explicaciones causales, las cuales, según Hempel, "... tienen la estructura indicada, sólo que se usan leyes causales. Popper introduce una variación del modelo anterior en su modelo hipotético-deductivo de explicación, en el que permite que las leyes, en lugar de ser verdaderas (o de que nos basemos en esto), sean hipótesis de teorías suficientemente corroboradas" (Schuster, 1986). En este sentido, "... uno explica cuando coloca el hecho a explicar en el contexto de una teoría (entendida como conjunto de hipótesis); la explicación es así hipotética" (Schuster, 1986). De lo dicho hasta aquí, no debe inferirse que toda explicación ha de ser causal ya que puede darse por correlaciones, como ocurre muchas veces en las ciencias sociales (Schuster, 1986). De ahí que sea necesario detenernos un poco en la noción de causalidad, la cual abordamos en el próximo apartado. III. EL EXPERIMENTO COMO TECNICA DE ANALISIS CAUSAL El experimento puede calificarse como el más prominente de todos los métodos de investigación en cuanto es el único que permite constatar relaciones causales. El concepto de causalidad es complejo y el análisis exhaustivo del mismo nos llevaría más allá del propósito de esta clase. En esta oportunidad nos limitaremos a aquellos puntos que parecen esenciales para el entendimiento de los requerimientos de los procedimientos de investigación en aquellos estudios destinados a la comprobación de hipótesis causales. El sentido común aplicado a la causalidad tiende a considerar que un acontecimiento singular (la causa) siempre lleva a otro acontecimiento singular (el efecto). En la ciencia moderna, el énfasis se carga más bien sobre una multiplicidad de "condiciones determinantes", las cuales, en conjunto, hacen probable la ocurrencia de un determinado acontecimiento. Tanto el sentido común como el pensamiento científico se ocupan del descubrimiento de las condiciones necesarias y suficientes para un fenómeno. 5 Una condición necesaria es la que debe ocurrir si el fenómeno del que es "causa", se da en efecto. Si X es una condición necesaria de Y, entonces Y nunca se dará a menos que ocurra la condición X. Por ejemplo, para ser un adicto a las drogas es condición necesaria una previa experiencia con las mismas, puesto que es imposible una adicción a las drogas si la persona nunca las ha usado. Una condición suficiente es la que siempre es seguida por el fenómeno del que es causa. Si X es una condición suficiente de Y, siempre que se dé X, ocurrirá Y. Por ejemplo, la destrucción del nervio óptico es una condición suficiente de ceguera, puesto que ninguna persona cuyo nervio óptico ha sido destruido puede ver. Una condición puede ser a la vez necesaria y suficiente para la ocurrencia de un fenómeno. En tal caso, Y nunca se dará a menos que X ocurra y siempre que X ocurra, también se dará Y. En otras palabras, no habrá ningún caso en que X o Y aparezcan solos. Ninguno de los ejemplos anteriores se ajusta a este modelo. En tanto el sentido común nos lleva a confiar que un factor proporcione una completa explicación, el científico raramente confía -por no decir nunca- en que un factor único o condición sea causa suficiente y necesaria de un fenómeno. Más bien está interesado en las condiciones contribuyentes, condiciones contingentes y condiciones alternativas o alternantes, todas las cuales el científico espera que se hallen trabajando para hacer probable pero no segura la ocurrencia del acontecimiento o fenómeno (Selltiz et al., 1965). Una condición contribuyente es la que aumenta las probabilidades de que ocurra un determinado fenómeno pero no lo hace seguro, lo cual se debe a que éste es solamente uno del número de factores que, conjuntamente, determina la ocurrencia del fenómeno. Así, la investigación sobre la adicción a las drogas no termina con la aceptación de que la experiencia previa con las drogas es condición necesaria para aquélla, sino que continúa con la consideración de qué factores personales, familiares y de vecindad han llevado a tal experiencia y cuál de los factores influye más para que una persona que ha tenido la experiencia primera se convierta en adicto (Selltiz et al., 1965). Pero el comportamiento con que la ciencia social trata es complejo en extremo; la interacción de factores debe ser tenida en cuenta. Un factor que actúa como condición contribuyente de un fenómeno bajo una serie de circunstancias puede no hacerlo bajo otras. Las condiciones bajo las cuales una determinada variable es causa contribuyente de un fenómeno dado son llamadas condiciones contingentes. Una considerable parte de la investigación que se realiza en el campo de las ciencias sociales se refiere a la identificación de tales condiciones. Por ejemplo: en las vecindades donde el uso de las drogas está generalizado (condición contingente), la ausencia del padre del adolescente (condición contribuyente) contribuye a la probabilidad de que el muchacho sea un adicto a aquéllas (Selltiz et al., 1965). El conocimiento de la multiplicidad de causas contribuyentes lleva también a un interés por las condiciones alternativas que pueden hacer más verosímil la ocurrencia de un fenómeno. Por ejemplo, puede descubrirse que tanto la ausencia de la figura paterna como la ocurrencia de 6 trato hostil o indiferente por parte del padre, contribuyen a la probabilidad del uso de drogas en aquellas vecindades donde su uso es común. El científico social puede entonces buscar una hipótesis que incluya un factor común a ambas causas -la alternativa y la contribuyente- y así formular, por ejemplo, que en las vecindades donde las drogas son fáciles de adquirir, la falta de identificación con la figura paterna durante la niñez hace más probable la adicción a las drogas durante la adolescencia (Selltiz et al., 1965). Muchas hipótesis en ciencias sociales se ocupan de las condiciones contribuyentes o alternativas y las contingencias bajo las cuales actúan. Sin embargo, es imposible demostrar directamente que una característica u ocurrencia determinada (X) determina otra característica u ocurrencia (Y), ya se por sí misma o en combinación con otras características u ocurrencias (A, B, C, etc.). Más bien lo que ocurre es que estamos siempre en posición de inferir, a partir de datos observados que la hipótesis de que X es una condición para la ocurrencia de Y es o no sostenible con cierto grado específico de confianza. La ciencia, como otros procesos cognitivos, comprende la formulación de teorías, hipótesis, modelos, etc., así como la aceptación o el rechazo de ellos en virtud de algún conjunto de criterios externos. La experimentación pertenece a esa segunda fase, la del desbrozamiento, el rechazo y la revisión. Podemos suponer para nuestra ciencia una ecología en la cual el número de hipótesis positivas exceda en mucho al de hipótesis que a la larga demostrarán ser compatibles con nuestras observaciones. La característica predominante de la tarea de compilación de datos para la prueba de teorías es, pues, el rechazo de hipótesis inadecuadas (Campbell y Stanley, 1970). Para conseguirlo resulta provechoso cualquier ordenamiento de observaciones en virtud del cual se desautorice la teoría correspondiente, incluyendo diseños cuasiexperimentales de menor eficacia que los verdaderos experimentos. En un sentido muy fundamental, los resultados experimentales nunca "confirman" ni "demuestran" una teoría; más bien la teoría triunfante está probada y escapa a la refutación. En otras palabras, "los resultados de un experimento `ponen a prueba' pero no `prueban' una teoría. Una hipótesis bien fundada es aquella que ha sobrevivido en reiteradas ocasiones a esos exámenes pero que siempre puede ser desplazada por otra nueva investigación" (Campbell y Stanley, 1970). ¿Qué evidencia es necesaria para justificar inferir la existencia de relaciones causales entre dos variables? En la práctica, la demostración de la causalidad conlleva tres diferentes operaciones: 1. Demostrar covariación (o variación concomitante) Covariación simplemente significa que dos o más fenómenos varían conjuntamente. Por ejemplo, si un cambio en el nivel de educación es acompañado por un cambio en el nivel del ingreso, se puede decir que la educación covaría con el ingreso. Esto significa que los individuos con más alto nivel de educación también tienen más altos ingresos que los de menor nivel de educación. Recíprocamente, si un cambio en el nivel de educación no es acompañado por un 7 cambio en el nivel de ingreso, la educación no varía concomitantemente con el ingreso. En la investigación científica, la noción de covariación es expresada a través de medidas de relaciones comúnmente indicadas por correlaciones y asociaciones. De este modo, una correlación entre fenómenos es una evidencia necesaria para una interpretación causal. Por ejemplo, si el autoritarismo no está correlacionado (no varía concomitantemente) con la violencia, aquel no puede ser la causa de ésta. 2. Eliminar las relaciones espúreas La segunda operación requiere que el investigador demuestre que la covariación observada no es espúrea. Existe una relación no espúrea entre dos variables cuando dicha relación no es explicada en el análisis por una tercer variable. En otras palabras, si los efectos de todas las variables relevantes son controlados y la relación entre las dos variables originales se mantiene, la relación entre estas no es espúrea. Que una relación no es espúrea implica que hay nexo causal inherente entre las variables y que la covariación observada no está basada en una conexión accidental con algún fenómeno asociado. 3. Establecer el orden temporal de la ocurrencia de variables La tercera operación requiere que el investigador demuestre que la variable que se asume como causa ocurre primero o cambia primero que la que se asume como efecto. El supuesto implícito aquí es que un fenómeno en el futuro no puede determinar un fenómeno en el presente o en el pasado. En muchos casos, existen algunas dificultades para determinar el orden temporal de los fenómenos. Así, el status de los padres influye en las expectativas educativas de sus hijos y no viceversa. Pero, podemos decir que el logro ("achievement") sigue a la motivación o que un cambio en el nivel de motivación sigue al logro. Nosotros discutiremos más adelante, los métodos empleados para determinar el orden temporal de los eventos, pero en este punto sólo queremos señalar la significancia del criterio de orden temporal cuando formulamos explicaciones causales. IV. EL DISEÑO EXPERIMENTAL CLASICO El diseño clásico de investigación experimental consiste de dos grupos comparables: un grupo experimental y un grupo de control. Estos dos grupos son equivalentes excepto en el hecho de que el grupo experimental es expuesto a la variable independiente (también denominada estímulo -"treatment"-) y el grupo de control, no. La asignación de los casos al grupo experimental o de control está basada en el azar. Esto tiene por objetivo el garantizar la igualdad y, por ende, la comparabilidad de ambos grupos. Para evaluar el efecto de la variable independiente, los investigadores realizan dos mediciones sobre la variable dependiente para cada grupo. La primera medición -el pretest- es realizada antes de introducir la variable independiente en el grupo experimental. La segunda medición -el postest- es realizada luego que la exposición al estímulo ha tenido lugar. Las diferencias entre el pretest y el postest son comparadas en cada grupo. Si la diferencia en el grupo experimental es significativamente mayor que en el grupo de control, se infiere que la variable independiente está 8 causalmente relacionada con la variable dependiente. ¿Cómo interpretar los resultados? Si resulta que la diferencia entre las mediciones de la variable dependiente (realizadas en los grupos experimental y de control) es "auténtica" con un determinado grado de significación, por ejemplo, con 95 % de seguridad, cabe afirmar un nexo causal. Ahora podría hacerse la siguiente interpretación: con un 95 % de seguridad vale para todas las personas de la clase "I" (universo sobre el que se ha de generalizar) que la variable X determina a la variable Y (o, de otra manera: X es una causa de Y). Se precisará al máximo en cada caso concreto la naturaleza del nexo: si Y aumenta o decrece con X, si se transforma proporcional o exponencialmente, etc. La medida en que estos enunciados sean posibles es algo que depende de la naturaleza de las variables. Importante de retener es que a través del experimento sólo se demostró que Y es determinado, entre otros factores, por X, pero no sólo por X. Es posible que también otros factores ejercieran su influencia sobre Y. A fin de descubrir el mayor numero posible de factores causales relevantes para Y, se deberían organizar muchos experimentos en cada uno de los cuales se manipularía como estímulo uno u otro de los supuestos factores causales, mientras que los restantes factores —también aquellos cuyo carácter causal se puso de manifiesto en los anteriores experimentos— se controlarían mediante la equiparación de Gl y G2. Es posible reducir todo este trabajo cuando se realizan experimentos con varios factores causales simultáneamente, como veremos más adelante. El diseño experimental clásico posee tres componentes: la comparación, la manipulación y el control. Los tres son necesarios para establecer que la variable independiente y la dependiente están causalmente relacionadas. La comparación nos permite demostrar la covariación, la manipulación ayuda a establecer el orden temporal de los eventos y el control nos permite determinar que la covariación observada no es espúrea. Discutiremos cada uno de estos componentes separadamente. 1. Comparación El proceso de comparación subyace al concepto de covariación o correlación. La comparación es una operación requerida para demostrar que dos variables están correlacionadas. Digamos, por ejemplo, que deseamos demostrar una correlación entre fumar cigarrillos y el cáncer de pulmón: el fumar cigarrillos está asociado a un mayor riesgo de contraer cáncer de pulmón. Para examinar esto, el investigador debe comparar la frecuencia de casos de cáncer entre fumadores y no fumadores o, alternativamente, comparar el número de casos de cáncer en una población de fumadores antes y después de haber comenzado a fumar. Supongamos que creemos que el mirar televisión contribuye a fomentar imágenes tradicionales sobre los roles de hombres y mujeres entre los adolescentes. Nosotros esperamos encontrar una covariación entre el mirar televisión y las imágenes tradicionales de género. Esto es, los adolescentes que pasan más tiempo mirando televisión exhibirán estereotipos tradicionales de roles de género. Para estimar esta covariación podríamos comparar grupos de adolescentes que miren poca televisión con grupos que miren mucha televisión; o bien comparar las concepciones sobre los roles de género de un grupo antes y después de ver un programa de televisión que privilegia las imágenes tradicionales sobre los roles de género. En otras palabras, para determinar la covariación debemos evaluar los resultados de los adolescentes sobre la variable dependiente antes y después 9 de introducir la variable independiente, o bien comparar un grupo que está expuesto a la variable independiente con otro que no lo está. En el primer caso, un grupo es comparado con sí mismo; en el segundo caso, un grupo experimental es comparado con un grupo de control. 2. Manipulación La noción de causalidad implica, como ya dijimos, que Y es causada por X, entonces un cambio inducido en X acarreará un cambio en Y. Esta relación empírica es asimétrica no reversible, lo cual implica que X produce Y pero no a la inversa. Para que esto se produzca, el cambio de X debería ocurrir ante que el cambio de Y, de lo cual se sigue que ésta no puede ser la variable determinante. Por ejemplo, si se sostiene que la participación en grupos de tratamiento de alcohólicos aumenta la negación de los problemas del alcoholismo, debe demostrarse que el aumento de la negación tiene lugar luego de la participación en el grupo de tratamiento. Esto puede estar acompañado por alguna forma de control -manipulación- de la asignación al grupo de tratamiento de tal forma que el investigador pueda medir el nivel de negación a los problemas del alcoholismo antes y después de la participación en el grupo. En los escenarios ("settings") experimentales, especialmente en experimentos de laboratorio, los investigadores pueden introducir ellos mismos el estímulo experimental y manipularlo. Esto sucede cuando el investigador puede decidir libremente que el estímulo sea introducido en uno u otro grupo. Sólo así puede hablarse de experimento en sentido estricto pues sólo entonces existe la certeza de que la modificación de Y (variable dependiente) fue producida por X (estímulo introducido). Sin embargo, en los escenarios naturales (experimentos de campo) los investigadores no siempre pueden introducir el estímulo experimental y manipularlo libremente. En ambos casos, la principal evidencia requerida para determinar el orden temporal de los eventos, esto es que la variable independiente preceda a la variable dependiente, es que se produzca un cambio solamente después de la activación de la variable independiente. 3. Control El tercer criterio de causalidad requiere que otros factores sean desechados como explicaciones opuestas de la asociación observada entre las variables investigadas. Tales factores podrían invalidar la inferencia de que las variables están causalmente relacionadas. Esto ha sido denominado por Donald Campbell y Julian Stanley (1970) como problema de validez interna. Así, "llamamos validez interna a la mínima imprescindible sin la cual es imposible interpretar el modelo. Por su parte, la validez externa plantea el interrogante de la posibilidad de generalización: ¿a qué poblaciones, situaciones, variables de tratamiento y variables de medición puede generalizarse este efecto? Ambos criterios son sin duda importantes, aunque con frecuencia se contrapongan, en el sentido de que ciertos factores que favorecen a uno de ellos perjudican al otro. Si bien la validez interna es el sine qua non y a la cuestión de validez externa, como a la de la inferencia inductiva, nunca se puede responder plenamente, es obvio que nuestro ideal lo constituye la selección de diseños ricos en una y otra validez. 10 3.1. La validez interna de los diseños experimentales Con relación a la validez interna Campbell y Stanley (1970) presentan ocho clases distintas de variables externas que, de no controlárselas en el diseño experimental, podrían generar efectos que se confundieran con el estímulo experimental. Los factores que pueden afectar la validez interna pueden ser clasificados entre aquellos que son extrínsecos a la operación de investigación y aquellos que son intrínsecos y que infringen los resultados durante el período de estudio. A. Factores extrínsecos Son factores que dan cuenta de sesgos resultantes de una selección diferencial en el reclutamiento de los participantes de la investigación para los grupos experimental y de control. Estos factores de selección producen diferencias entre el grupo experimental y de control que son anteriores a la operación de investigación. Los efectos de selección son especialmente problemáticos en casos en los cuales los individuos deciden si participan en un experimento. En tales casos, el investigador no puede decir si la variable independiente causa las diferencias observadas entre el grupo experimental y de control o si otros factores relacionados con los procesos de selección son los responsables de tales efectos observados. Procedimientos de control Para que las mediciones de la variable dependiente realizadas en los grupos experimental y de control puedan ser comparadas entre sí con pleno sentido, ambos grupos han de ser iguales en todas las variables que (junto a X) hayan podido influir en la variable dependiente. Esto se denomina control de los factores desconocidos. Están controlados cuando existe la certeza de que su repercusión en la variable dependiente es la misma en ambos grupos. Para la igualación de los grupos se emplean habitualmente dos métodos: la aleatorización ("randomization") y el pareo ("matching"). a) Pareo Cuando deba experimentarse con una totalidad pequeña, la igualdad de los dos grupos puede realizarse mediante la aplicación del método del pareo o "matching". Es decir, se divide la población en dos grupos según el principio del pareo. De esta manera están en vigencia las leyes de la teoría probabiIística, y se puede suponer que ambos grupos, siempre que no sean demasiado pequeños, son iguales en sus atributos (Mayntz, 1988). Si, por ejemplo, se sospecha que junto al factor X también el sexo y la edad de los estudiantes son determinantes de la intensidad del prejuicio, se los podría subdividir de la manera que se expone en la siguiente tabla (Mayntz, 1988): Menos de 20 años 20-25 años Más de 25 años 11 Varones 20 40 20 Mujeres 15 30 18 Cada uno de los seis subgrupos es luego dividido en dos, al azar. La mitad se incluye en el grupo Gl, y la otra mitad, en el grupo G2 (en caso de números impares una de las mitades será mayor que la otra en una unidad. El error resultante es despreciable cuando el número de los ocupantes del cuadro es suficientemente grande. Naturalmente, se puede extraer al azar a una persona, con lo que el cuadro presenta un número par). De esta manera se consigue que cada miembro de un grupo tenga un "gemelo" (en los factores causales codeterminantes escogidos) en el otro grupo. Por ello se habla de pareo. Mediante la bipartición aleatoria de los subgrupos se procura que ambas mitades sean iguales en todos los restantes factores causales no considerados. Ahora bien, los subgrupos no deberían ser demasiado pequeños. Naturalmente, así es posible igualar más de dos factores. Pero si los subgrupos son demasiado pequeños, su bipartición aleatoria conduce a una "igualdad" muy distorsionada. El "matching" puede ser también aplicado a una muestra extraída a partir de un universo muy amplio (Mayntz, 1988). b) Aleatorización ("randomization") Se obtienen ambos grupos como muestras aleatorias del mismo universo (por ejemplo, estudiantes de la Universidad de Buenos Aires). Según la teoría matemático-estadística de la probabilidad, estas muestras (dentro de determinados límites de error) son iguales en todas sus características (medias, distribuciones de frecuencias). Con esto están "controlados" todos los factores causales desconocidos (Mayntz, 1988). A veces se indica un tercer método para la igualación de ambos grupos: la igualación de los parámetros de las distribuciones de frecuencia relevantes. Las personas sometidas al experimento son distribuidas entre los dos grupos en base a los factores causales codeterminantes supuestos de manera que las medias (y, eventualmente, las dispersiones) sean iguales. Si se sospecha, pongamos por caso, que la edad es un factor codeterminante, habría que repartir a los individuos entre los dos grupos de tal forma que su edad media y, eventualmente, la dispersión de edad, fueran iguales en ambos grupos. Se trata de una forma primitiva del "matching". Los restantes factores causales codeterminantes, a diferencia de lo que ocurre en el "matching", no resultan controlados, puesto que el principio aleatorio no es puesto en práctica a la hora de la asignación de los individuos al grupo Gl o al G2. B. Factores intrínsecos Estos factores dan cuenta de cambios en los individuos o unidades estudiadas que ocurren durante el período de estudio, cambios en el instrumento de medición o el efecto reactivo de la propia observación. Los siguientes son los principales factores que pueden invalidar la interpretación causal resultante de los resultados de la investigación: 12 1) Historia Se refiere a todos los acontecimientos ocurridos entre la primera y la segunda medición que -además de la variable independiente- pueden afectar a los individuos estudiados y proveer una explicación opuesta para el cambio de la variable dependiente. 2) Maduración Incluye procesos biológicos, psicológicos o sociales que producen cambios en los participantes que operan como resultado del mero paso del tiempo (no son peculiares de los acontecimientos en cuestión). Estos cambios podrían influenciar posiblemente a la variable dependiente y llevarnos a realizar inferencias erróneas. La maduración al igual que la historia son amenazas serias para la validez de la inferencia causal. 3) Administración de tests La posible reacción a la medición es uno de los principales problemas de la investigación en las ciencias sociales. El proceso de administrar tests puede cambiar el fenómeno que está siendo medido. El efecto de ser sometido a un pretest puede sensibilizar a los individuos y afectar sus resultados en el postest. Así, la diferencia entre los resultados del postest y el pretest podrían deberse no a la variable independiente sino más bien a la experiencia ganada por los individuos en el pretest. Similarmente, a través del pretest, los individuos pueden aprender las respuestas socialmente aceptadas ya sea formulando las preguntas o discutiendo los resultados con amigos. Así, ellos pueden responder en la dirección esperada en el postest. 4) Instrumentación Designa los cambios en los instrumentos de medición o en los observadores o calificadores participantes entre el pretest y el postest que pueden producir variaciones en las mediciones que se obtengan. Para asociar las diferencias entre los resultados del postest y el pretest con la variable independiente, el investigador tiene que mostrar que mediciones repetidas con el mismo instrumento de medición bajo condiciones estables conducirán al mismo resultado. Si esto no puede ser mostrado, las diferencias observadas podrían atribuirse a cambios en el instrumento de medición y no necesariamente a la variable independiente. La estabilidad de la medición es un problema de confiabilidad y su ausencia puede ser una amenaza para la validez de los instrumentos. 5) Regresión estadística Opera cuando los individuos han sido asignados a los grupos experimental y de control sobre la base de sus puntajes extremos sobre la variable dependiente. Cuando esto ocurre y las mediciones no son confiables, individuos que han tenido resultados por debajo del promedio en el pretest podrán aparecer como que han aumentado su resultado en el postest. Inversamente, los individuos que han tenido resultados superiores al promedio en el pretest aparecerán con resultados no tan buenos en el postest. Por ejemplo, cuando nosotros damos un examen, algunas veces podemos tener una actuación por debajo de nuestras expectativas en relación al test debido a factores que escapan a nuestro control y que nada tiene que ver con nuestra capacidad académica (por ej., haber tenido una noche de insomnio antes del test o haber tenido un problema personal). Estos factores que no reflejan la verdadera capacidad son definidos como errores. Es muy probable que la próxima vez que el test fuera tomado nuestro rendimiento aumentara sin 13 estudiar adicionalmente. En una visión más general, la regresión estadística puede llegar a ser una amenaza para la validez de un estudio si se espera que el tratamiento produzca un cambio en los individuos cuyos resultados sobre la variable dependiente son extremos al comenzar. 6) Mortalidad experimental Se refiere a los problemas que la pérdida de participantes de los grupos de comparación le generan al investigador ya que le impiden obtener información completa en todos los casos. Cuando los individuos desaparecen selectivamente del grupo experimental y de control, la muestra final sobre la cual se dispone información completa puede estar sesgada. 7) Interacción con selecciones Muchos de los factores que constituyen una amenaza para la validez interna de los experimentos pueden interactuar con selección y representar una amenaza adicional para la validez del estudio. Los factores que más comúnmente interactúan son la selección-historia y la selección-maduración. La interacción selección-historia resulta cuando el grupo experimental y el de control seleccionados provienen de distintos escenarios ("settings") los cuales pueden afectar las respuestas de los individuos al tratamiento. La interacción selección-maduración ocurre cuando el grupo experimental y el de control maduran a un ritmo diferente (por ejemplo, si se compara el desarrollo cognitivo de hombres y mujeres entre el pretest y el postest). 3.2. Generalización de los resultados: el problema de validez externa de los diseños experimentales La validez interna es sin duda un aspecto crucial de la investigación social. Una pregunta significativa adicional tiene que ver con la posibilidad de generalizar los resultados de la investigación a poblaciones mayores y aplicarlos a contextos sociales y políticos diferentes. Este punto es denominado validez externa de los diseños experimentales. Los dos principales factores que amenazan la validez externa o representatividad son los siguientes: 1) La representatividad de la muestra La aleatorización contribuye a la validez interna de un estudio. Sin embargo, no asegura necesariamente la representatividad de la población de interés. Resultados que prueban ser internamente válidos pueden ser específicos para el grupo seleccionado para los estudios en particular. Esta situación es altamente probable en situaciones en las que el reclutamiento de los casos del estudio es difícil. Para que sea posible hacer generalizaciones a partir de los resultados limitados del estudio específico, el investigador debería tener cuidado en la selección de la muestra utilizando métodos de muestreo que aseguren la representatividad. En teoría, los grupos experimental y de control deberían constituir muestras probabilísticas de la población bajo estudio. Sin embargo, en la práctica, obtener una muestra probabilística para un experimento a menudo implica problemas como el alto costo y la alta tasa de rechazo de los sujetos a cooperar con la investigación. 2) Efectos reactivos de los dispositivos experimentales Los resultados de un estudio aspiran a ser generalizados no sólo a una población mayor sino también escenarios o contextos de la vida real. Sin embargo, esto no siempre puede ser 14 concretado, especialmente cuando un estudio es realizado en una situación altamente artificial y preparada -tal como sucede en un laboratorio- que impediría hacer extensivo el efecto de la variable experimental a las personas expuestas a ella en una situación no experimental. Varias características de los escenarios pueden tener efectos reactivos y afectar la validez externa del estudio. Por ejemplo, un pretest podría aumentar o disminuir la sensibilidad o la calidad de la reacción del participante a la variable experimental, haciendo que los resultados obtenidos para una población con pretest no fueran representativos de los efectos de la variable experimental para el conjunto sin pretest del cual se seleccionaron los participantes experimentales. Otro ejemplo estaría dado por las interferencias de los tratamientos múltiples, que pueden producirse cuando se apliquen tratamientos múltiples a los mismos participantes, pues suelen persistir los efectos de tratamientos anteriores. Este es un problema particular de los diseños experimentales de un solo grupo. V. TIPOS DE DISEÑOS EXPERIMENTALES Los diseños experimentales pueden ser clasificados en relación a los criterios que nosotros hemos discutido hasta aquí. Así, algunos diseños permiten la manipulación pero fallan al emplear métodos de control al proveer un adecuado plan de muestreo; otros pueden incluir grupos de control pero no tienen control sobre la manipulación de la variable independiente. De acuerdo con esto, los principales tipos de diseño que podemos distinguir son los siguientes: 1. Experimentales 2. Cuasi-experimentales 3. Correlacionales 4. Pre-experimentales En los diseños experimentales los individuos o unidades de análisis son asignados al azar ("randomly") a los grupos experimental y de control y la variable independiente es introducida solamente al grupo experimental. Este tipo de diseños permiten por la comparación, control, manipulación y, usualmente, la generalización. Los diseños cuasi-experimentales y los correlacionales habitualmente incluyen combinaciones de algunos de estos elementos pero no todos ellos. Típicamente, estos diseños carecen de posibilidades de manipulación y asignación al azar a los grupos experimental y de control. Los diseños pre-experimentales incluyen menos resguardos aún que los diseños cuasiexperimentales y los correlacionales y, en este sentido, ellos proveen menos credibilidad sobre si dos variables están relacionadas causalmente. En esta oportunidad nos centraremos en algunos de los diseños experimentales propiamente dichos más comúnmente utilizados. Dejaremos para otra oportunidad la discusión sobre los diseños cuasiexperimentales, correlacionales y pre-experimentales. 1. Diseño de grupo de control pretest-postest o de experimentación controlada 15 El diseño experimental clásico, al que nos referimos anteriormente, es uno de los modelos lógicos más fuertes para inferir relaciones causales. Este diseño permite: a) comparaciones entre los grupos experimental y de control para el pretest y el postest; b) la manipulación de la variable independiente y además la determinación de la secuencia temporal de las variables; y, la más significativa, c) la asignación al azar ("randomly") de los sujetos a los grupos experimental y de control, que controla la mayoría de los factores que garantizan la validez interna. Grupo Pretest Estímulo Experimental R 01 Control 03 R X Postest 02 04 Sin embargo, este diseño es débil en lo que hace a la validez externa y no permite realizar generalizaciones a la población no testeada. Las dos variaciones de este diseño que veremos a continuación son más fuertes en este último aspecto (validez externa). 2. Diseño de cuatro grupos de Solomon El pretest en un contexto experimental tiene ventajas y desventajas. Aunque provee las bases para establecer la secuencia temporal tanto como la comparación, el pretest puede tener efectos reactivos severos. Debido a la sensibilización de la población muestreada, el pretest puede afectar los resultados del postest. Por otro lado, hay circunstancias bajo las cuales no es posible en la práctica realizar un pretest. El diseño de cuatro grupos de Solomon tiene las mismas características que el diseño clásico pero, además, incluye un set de grupos experimentales y de control que no son sometidos a un pretest. Así, el efecto reactivo del pretest puede ser medido directamente a través de la comparación de los dos grupos experimentales y los dos grupos de control. Estas comparaciones indicarán si X tiene un efecto independiente sobre los grupos que no fueron sensibilizados por el pretest. Si puede mostrarse que la variable independiente tuvo un efecto aún con la ausencia del pretest, los resultados pueden ser generalizados a poblaciones que no fueron medidas con anterioridad a la exposición de X. Campbell y Stanley (1970) señalan que "... no solo se aumenta la posibilidad de generalizar, sino que además se repite el efecto de X en cuatro formas diferentes... Las inestabilidades concretas de la experimentación son tales que, si esas comparaciones concuerdan, el vigor de la inferencia queda muy incrementado". Grupo Pretest Estímulo Postest 16 R 01 R 03 R X 02 04 X R 05 06 Sin embargo, en algunos estudios con diseños de este tipo que se llevaron a cabo en USA (Nachmias y Nachmias, 1992) resultó que los grupos experimental y de control que no fueron pretesteados fueron mucho menos proclives a participar más tarde (en el postest) que aquellos que habían participado del pretest. De este modo, la tasa de rechazo de aquellos dos grupos fue tan alta que el investigador tuvo que atenerse solamente al grupo pretesteado para el análisis de los resultados (Nachmias y Nachmias, 1992). 3. Diseño de grupo de control con postest únicamente Aunque el diseño de cuatro grupos de Solomon es un diseño experimental robusto, a menudo es impracticable para implementar ya sea por su costo o porque los pretests pueden ser seriamente reactivos. El diseño de grupo de control con postest únicamente es una variación del diseño experimental clásico y del diseño de Solomon ya que en el mismo se trabaja sólo con dos grupos: uno experimental y otro de control y en ambos se omite el pretest. Los individuos son asignados al azar a los grupos experimental y de control y son medidos durante o después de la introducción de la variable independiente. Grupo Estímulo Postest R X 01 R 02 El diseño de grupo de control con postest únicamente controla todas las causas de invalidez interna. Con la omisión del pretest, la administración de test y la instrumentación llegan a ser fuentes irrelevantes de invalidez. Puede también asumirse que los restantes factores intrínsecos de validez son controlados, si ambos grupos están expuestos a los mismos acontecimientos externos y sujetos al mismo proceso de maduración. Adicionalmente, el factor extrínseco de selección está controlado por la asignación al azar de los sujetos a los grupos experimental y de control, lo cual elimina un sesgo inicial en cada grupo. 4. Diseño experimental para estudiar efectos extendidos en el tiempo 17 En todos los diseños experimentales descriptos hasta aquí se asumió que el efecto de la variable independiente sobre la variable dependiente puede ser observado inmediatamente o dentro de un período corto de tiempo. Pero, algunas veces, nosotros podemos esperar que efectos de largo plazo tengan lugar con el transcurso del tiempo. Esto es particularmente evidente en estudios de políticas y en investigaciones en las cuales la variable dependiente es un una actitud. Una solución para los estudios de efectos retrasados consiste en introducir períodos de postest adicionales, por ejemplo, seis meses o un año más tarde. Esta es una solución convencional cuando la investigación tiene lugar en escuelas, por ejemplo, donde mediciones postest en los grados serían recogidas de cualquier modo. Sin embargo, Campbell y Stanley (1970) indican que "... cuando mediciones postest son introducidas por el investigador, la repetición de las mediciones sobre los mismos sujetos podrían tener el mismo efecto de invalidez que tendría el pretest. Entonces, una mejor solución sería establecer separadamente los grupos experimental y de control para cada postest planificado" (ver tabla). Grupo Pretest Estímulo R O1 R 03 R 05 R O7 X Postest Postest O2 O4 X O6 O8 La misma duplicación del grupo experimental puede ser incorporada en otros diseños. 5. Diseños factoriales En todos los diseños discutidos hasta ahora había solamente una variable independiente que se introducía en el grupo experimental y se evitaba en el grupo de control. Examinar el efecto de más de una variable independiente requiere un amplio número de grupos experimentales y un diseño factorial. Supongamos que en nuestro estudio tenemos dos variables independientes dicotómicas (como el programa educativo y el tipo de institución escolar) y una dependiente, será necesario 18 trabajar con cuatro grupos experimentales para estudiar todas las combinaciones de valores de esas dos variables. Los cuatro grupos experimentales tienen cuatro diferentes "tratamientos" representando todas las posibles combinaciones de valores de las dos variables independientes (en este ejemplo, dichas combinaciones quedarían reflejadas en un cuadro de 2x2). Grupo Estímulo Postest R X1 O1 R X2 O2 R X3 03 R X4 04 En cuanto a la validez externa de los diseños factoriales, podemos decir que la principal ventaja de los diseños factoriales es que ellos pueden ampliar el rango de generalización. En lugar de "controlar para cualquier cosa", como en los experimentos con una única variable, se introducen variables relevantes adicionales, cada una a dos o más diferentes niveles. Consecuentemente, el investigador no está constreñido o limitado por el nivel constante de cada una de estas variables relevantes cuando realiza generalizaciones sobre el efecto de una variable independiente. Además, el investigador está en posición de inferir que el efecto ocurre similarmente a través de varios niveles de las variables o, alternativamente, que el efecto es diferente a diferentes niveles de una u otra de esas variables. Entonces, los diseños factoriales aumentan la validez externa de los experimentos. Efectos interactuantes en los diseños factoriales: Otra ventaja de los diseños factoriales es que ellos permiten establecer sistemáticamente cómo dos (o más) variables independientes interactúan. La interacción está presente cuando el efecto de una variable independiente sobre la variable dependiente depende del valor de la segunda variable independiente. El test de la interacción de las variables independientes hace posible expandir ampliamente nuestro conocimiento sobre el efecto de las variables independientes sobre la variable dependiente. Dicho test nos permite calificar la conclusión sobre sus efectos en un sentido muy importante ya que nosotros estudiamos la operación simultánea de dos variables independientes. VI. CIERRE DE LA CLASE Se presenta a los alumnos dos investigaciones como ejemplos de distintos diseños a fin de que los comparen y saquen conclusiones: 1. Wainerman, C. H. y M. Moreno (1990). "Hacia el reconocimiento censal de las mujeres trabajadoras", en Estudios INDEC, Nº 8, Los censos del 90. Características económicas de la 19 población, Buenos Aires, CELADE/CENEP/INDEC. 2. Infesta Domínguez, G. (1996). Education for Life: A Time for Reflection about Sexuality, Reproductive Health and Gender Inequalities, Research Proposal. La primera de estas investigaciones es un diseño experimental (del tipo factorial) en tanto la segunda es cuasi-experimental. La comparación de estas investigaciones permitirá a los alumnos comprender mejor las especificidades de los diseños experimentales, así como descubrir situaciones en las que los diseños cuasi-experimentales resulten más adecuados. Finalmente, se entrega a los alumnos un trabajo domiciliario (que figura en el anexo) como otra instancia más del aprendizaje, la cual le permitirá al docente evaluar el grado de asimilación por parte de los alumnos de los conceptos discutidos durante la clase. BIBLIOGRAFIA Blalock, H. (1982). Introducción a la investigación social, Buenos Aires, Amorrortu, cap. 2. Campbell, D. y J. Stanley (1970). Diseños experimentales y cuasiexperimentales en la investigación social, Buenos Aires, Amorrortu editores. Festinger, L. (1992). "Experimentos de laboratorio", en Festinger, L. y D. Katz (comps.), Los métodos de investigación en ciencias sociales, Barcelona, Paidós. Frech, J. (h.). (1992). "Experimentos en contexto de campo", en Festinger, L. y D. Katz (comps.), Los métodos de investigación en ciencias sociales, Barcelona, Paidós. Hage, J. y B. F. Meeker (1988). Social Causality, Boston, Unwin Hyman, chapter 1. Hyman, H. (1968). "El modelo del experimento y el control de las variables", en Mora y Arujo, M. et al., El análisis de datos en la investigación social, Buenos Aires, Ediciones Nueva Visión. Lieberson, S. (1985). Making It Count. The Improvement of Social Research and Theory, Berkley, University of California Press, cap. 9. Mayntz, R. (1988). Introducción a los métodos de la sociología empírica, Madrid, Alianza Universidad, cap. 9. Nachmias, C. F. y D. Nachmias (1992). Research Methods in the Social Sciences, New York, St. Martin's Press, chapters 5 y 6. Rex, J. (1977). Problemas fundamentales de la teoría sociológica, Buenos Aires, Amorrortu editores, cap. 1. 20 Rodrigues, A. e I. Pérez de Maldonado (1995). La investigación experimental en ciencias sociales, México D.F., Trillas. Rosenberg, M. (1968). Publishers; chapter 1. The Logic of Survey Analysis, New York; Basic Books, Inc., Schuster, F. (1982). Explicación y predicción. La validez del conocimiento en ciencias sociales, Buenos Aires, CLACSO. Selltiz, C., M. Jahoda, M. Deutsch y S.W. Cook (1965). Metodos de investigación en las relaciones sociales, Madrid, Ediciones Rialp, cap. 3 y 4. Smith, H. (1991). Strategies of Social Research, Orlando; Holt, Rinehart and Winston, Inc., chapter 6. 21 ANEXO Ejercicio 1: Lea la investigación de Chapin, S.F. (s.f.). Efectos sociales de los Planes Oficiales de Viviendas en Minneapolis, mimeo. Luego, resuelva la siguiente guía de trabajos prácticos: 1) ¿Cuál es el problema que plantea el autor? 2) ¿Qué tipo de diseño se aplica para resolver dicho problema? 3) ¿Cuál es la hipótesis o red de hipótesis? (Indicar las variables con sus categorías y su status) 4) ¿Cuál es la población bajo estudio? ¿Qué tipo de muestra se utilizó? 5) ¿Cómo se intenta igualar los grupos experimental y de control? 6) ¿Cómo se intentó medir cada una de las variables de la hipótesis? 7) ¿Cómo se resolvió el problema de confiabilidad y validez en la medición de las variables? 8) ¿Cuáles fueron los instrumentos de recolección de datos utilizados? 9) ¿Cuáles son las conclusiones a que arriba el estudio? ¿Se confirma o se rechaza la hipótesis del autor? 10) En relación al alcance de los resultados del estudio, ¿cuál es el grado de generalidad de las conclusiones? 11) ¿Qué opinión metodológica le merece esta investigación? (En su respuesta tome en cuenta las características del tipo de diseño utilizado por el investigador) Ejercicio 2 1) Formule un problema y objetivos de investigación que requieran ser abordados a partir de un diseño experimental. Indique el tipo de diseño experimental que más se adecua a sus objetivos. (Justifique su respuesta). 2) ¿Cuál es la hipótesis que pondría a prueba? Indique cuál es la variable dependiente y cuál/es la/s independiente/s y cómo las operacionalizaría? 3) Indique los procedimientos que utilizaría para conformar los grupos que requiera su diseño y 22 el/los "tratamiento/s" que realizaría y cómo implementaría los mismos. 4) Construya un gráfico o figura que ilustre el tipo de diseño elegido. 23