Apunte 1. El enfoque conexionista 1.1 Breve historia del enfoque

Anuncio

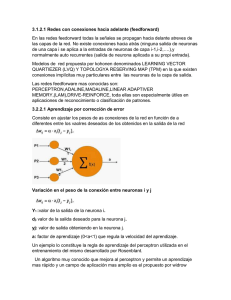

Universidad de Valparaíso Escuela de Psicología Fundamentos Filosóficos y epistemológicos de los sistemas teóricos en Psicología II Errol Dennis y Eduardo Jeria Garay Apunte 1. El enfoque conexionista 1.1 Breve historia del enfoque conexionista Es posible rastrear el conexionismo en el trabajo de algunos teóricos precursores. En primer lugar, el trabajo de Ramón y Cajal, quien enunció por primera vez la idea que el sistema nervioso humano estaba compuesta por millones de unidades discretas llamadas neuronas. Otros neurobiólogos, como Sherrington, descubrieron que, no obstante lo anterior, las unidades no eran independientes, sino que estaban conectadas entre sí por medio de transmisores químicos que se descargaban en el espacio interneuronal o espacio sináptico. Gracias a estos aportes de la neurobiología se pudo saber más acerca del sistema nervioso y con ello se abrieron numerosas especulaciones acerca de cómo podría funcionar la compleja estructura del cerebro a partir de unidades tan pequeñas. Un segundo elemento teórico fue propuesto por Donald Hebb. Este psicólogo propuso que la unión entre dos neuronas podía fortalecerse en la medida que las actividades entre estas dos neuronas tendían a coincidir. Así, las unidades podían establecer recurrencias entre unidades, de manera que se formen redes y subredes. En tercer lugar, la investigación de McCulloch y Pitts publicada en un influyente artículo de 1956, sobre el uso de unidades conectadas entre sí –similares a las neuronas- que podían demostrar teoremas lógicos produjo un gran asombro y abrió un insospechado campo para la Psicología, la Lógica y otras ciencias cognitivas. Estas primeras investigaciones produjeron una gran expectativa de lo que las redes podrían hacer y la tecnología que serían capaces de generar. Sin embargo se comprobó matemáticamente serias limitaciones para lo que las redes podían hacer y con ello la investigación quedó estancada por varios años. En los años 60 se declaraban oficialmente muertas las redes neuronales. Sin embargo, nuevos descubrimientos en la matemática permitieron liberar a las redes de su entrampamiento inicial y darle nuevos bríos a la investigación. En los últimos 20 años (principalmente desde 1986) ha resurgido el interés inicial por el tema de las redes neuronales y vemos como día a día ganas espacios en ciencia básica y aplicada. Dado lo anterior han surgido muchos programas que aplican los principios del conexionismo exitosamente y abarcan un amplio espectro que va desde la percepción visual a la predicción en la bolsa de valores. Como resumen general, podemos decir que el conexionismo concibe la cognición como una emergencia de la actividad de una red de unidades, conocidas como neuronas artificiales, que están interconectadas masivamente y que computan en paralelo los mensajes de activación o inhibición provenientes de otras neuronas. Las neuronas reciben inputs de muchas otras neuronas y responde con un output que es función de la activación de la que fueron objeto. La respuesta depende de si se supera un umbral, es decir, un límite numérico que indica de modo “todo o nada” si la neurona disparará, es decir, enviará un output. Las conexiones entre neuronas tienen un “peso”, es decir, algunas conexiones tienen mayor impacto sobre la respuesta de la neurona target que otras. 1.2 Los elementos básicos de una arquitectura conexionista 1.2.1 Las unidades de una red conexionista Los elementos básicos de una arquitectura conexionista son una serie de microprocesadores simples que por sus características son asemejadas a neuronas, puesto que son unidades que reciben y envían señales y que funcionan como estaciones locales de procesamiento y computación. Las neuronas artificiales reciben información de muchas otras unidades con las cuales están conectadas, de manera de procesar o Por Eduardo Jeria Garay Santiago, primer semestre 2005 Universidad de Valparaíso Escuela de Psicología Fundamentos Filosóficos y epistemológicos de los sistemas teóricos en Psicología II Errol Dennis y Eduardo Jeria Garay transformar la información recibida y emitir una señal de salida hacia otras neuronas. Existen tres tipos de unidades en una red neuronal, que se organizan en tres capas, una por cada tipo de unidad1: - Unidades de entradas Las unidades de entrada reciben información desde fuentes externas a la red. La información puede provenir del mundo físico en el caso que la red posea algún tipo de sensores. Por otra parte la información también puede provenir de bases de datos, de otras redes o de información que un usuario introduce en el computador - Unidades de salida Las unidades de salida envían información o señales al exterior del sistema; constituyen las unidades de respuesta de la red. Si la red dispone de conexiones con sistemas motores su respuesta será la intervención en el exterior. Si en cambio la red no los posee, la salida puede ser utilizada como sistema de alimentación de datos para otras redes o sólo entregan datos de par ser interpretados por el usuario. - Unidades ocultas (hidden units). Las unidades ocultas no están en contacto directo con el exterior de la red. Las unidades ocultas no reciben input directamente del ambiente ni envían output al ambiente externo. Su función es procesar información la información en niveles complejos y favorecer cómputos más eficaces. El sistema de tres capas con unidades ocultas permite una potencia computacional mucho mayor que una red neuronal de dos capas 1.2.2 Las conexiones entre las unidades En una red neuronal, las unidades se conectan entre sí por medio de sinapsis. Estas sinapsis son funcionalmente análogas a las conexiones de las neuronas reales, es decir, dos unidades se vinculan entre sí de manera tal que una de las neuronas cumple la función de entrega de señal (presináptica) y otra la de recepción de dicho mensaje. Cada unidad tiene habitualmente una gran cantidad de unidades que se conectan con ella. El abanico de entrada es el número de elementos que excitan o inhiben una unidad dada. El abanico de salida de una unidad es el número de unidades que son afectadas directamente por dicha unidad. La información que puede recibir, almacenar y emitir una red, está determinada por lo que se llama el abanico de entrada y el abanico de salida. Hay dos tipos de sinapsis: 1 - Sinapsis inhibidora: En este tipo de conexión el impulso que una neurona recibe, inhibe su actividad. Si la neurona j transmite a la neurona i un impulso que inhibe a ésta, el nivel de activación de la neurona I decrecerá y decrecerá en función del peso establecido para dicha conexión y de la cantidad de información que se transmite por dicha sinapsis. - Sinapsis excitatoria: En este tipo de conexión el impulso que una neurona recibe excita o aumenta su actividad. Si la neurona J está conectada mediante una sinapsis excitadora con la neurona I, el nivel de activación de la unidad I aumentará si le llega información por dicha conexión desde la neurona J, y lo hará en función del peso de la conexión y de la magnitud de la señal que se le envía. Se les llama capa, estrato o nivel al conjunto de neuronas que reciben información de la misma fuente y ofrecen información al mismo destino. Por Eduardo Jeria Garay Santiago, primer semestre 2005 Universidad de Valparaíso Escuela de Psicología Fundamentos Filosóficos y epistemológicos de los sistemas teóricos en Psicología II Errol Dennis y Eduardo Jeria Garay Cada uno de estas sinapsis tiene un peso sináptico o peso de conexión. Las conexiones entre dos unidades están jerarquizadas en orden de importancia o impacto en la unidad target. Esto se logra por medio de la introducción de una constante numérica que interviene en el algoritmo de activación-inhibición que supone la sinapsis y, por lo tanto, que gradúa la intensidad de la señal entrante, amplificándola o minimizándola. El concepto de peso de las conexiones permite entender tanto las capacidades computacionales de la red como su flexibilidad para procesar los datos. El concepto de peso puede servir para entender cómo el sistema almacena la información a medida que aprende. Una sinapsis frecuente o Conexiones sinápticas (pesos diversos) Salida axonal UNIDADES OCULTAS Conexiones sinápticas (pesos diversos) UNIDADES DE ENTRADA Salida axonal Figura 5. Esquema de una red conexionista importante en la red se presentará por medio de un valor de peso de conexión elevado y contribuirá de manera importante en el estado de respuesta de la neurona receptora. En el caso opuesto, un valor de peso menor impactará menos en la respuesta de la neurona. Los pesos sináptico se expresan por medio de valores numéricos sencillos, como números enteros o fracciones con los que se ponderan las señales que reciben de las diferentes neuronas involucradas en la sinapsis. Por otra parte, en los modelos conexionistas también es muy relevante la vinculación que se establece entre las diferentes unidades, lo que podemos denominar “patrón de conexiones”. El conocimiento que la red alcanza a partir del aprendizaje no sólo se representa mediante los pesos de las conexiones sino también por medio de este patrón de conexión, que determinará, por lo tanto, el modo de procesamiento de las señales y la respuesta del sistema ante cualquier entrada. Como señalamos, las conexiones de la red se ordenan según una jerarquía son entre las capas adyacentes, estrictamente jerarquizadas. Todas provienen de la capa input y van avanzando, desde las capas input a las capas output y, por lo tanto, son conexiones del tipo prospectivas (feedfoward conections). Así, el conocimiento en una red neuronal habitualmente se relaciona especialmente con la conectividad que se produce en torno a la capa oculta, puesto que esta capa permite el procesamiento de las señales de entrada, su combinación, reacomodación y posterior transformación en señal de salida. Por Eduardo Jeria Garay Santiago, primer semestre 2005 Flujo de Información UNIDADES DE SALIDA Universidad de Valparaíso Escuela de Psicología Fundamentos Filosóficos y epistemológicos de los sistemas teóricos en Psicología II Errol Dennis y Eduardo Jeria Garay 1.2.3 La red en funcionamiento Cada neurona posee un “estado de activación”, que es el estado numérico dependiente de las entradas recibidas. Ese estado sirve de dato fundamental para calcular la “función de salida”, que calcula la señal de salida a partir del estado de activación que en ese momento tiene la neurona. La señal de salida se transmite a las demás neuronas conectadas con la unidad. La unidad receptora pondera la señal de las unidades con las que está conectada tomando en consideración tanto el peso asociado a cada una de las conexiones como la intensidad del mensaje recibido. El estado de activación cambia en función de cuatro factores: el estado de activación anterior, las entradas que la neurona recibe, los pesos de las conexiones por las que recibe las señales y el algoritmo utilizado para calcular la activación a partir de dichas entradas. Una vez establecida la red neuronal se inicia el proceso de entrenamiento o aprendizaje de la red. Una red neuronal aprende cuando es capaz de ofrecer ante un determinado patrón de entrada el correspondiente patrón de salida. El procedimiento consiste en exponer al sistema a los patrones de estímulos que queremos que la red reconozca. Para ello se presentan miles de estímulos al sistema. Mientras ello ocurre, los pesos sinápticos irán variando gracias a la aplicación de diferentes reglas de aprendizaje, como la regla delta generalizada que permite ajustar el valor de los pesos de las conexiones que no cumplen con el valor esperado de salida. Este proceso permitirá que la red pueda enfrentarse exitosamente a nuevos estímulos y que sea capaz de reconocer acertadamente los patrones de estímulos propuestos. En otras palabras, la regla delta permite moldear exitosamente la red como una configuración necesaria de pesos, aunque comience con una configuración aleatoria. Esta regla hace que el sistema aprenda de las pruebas que se le hacen y también de los errores que produce. Este proceso se denomina aprendizaje automatizado por la retropropagación del error. Esta regla permite encontrar el orden y la estructura ante estímulos que desestructurados y en caos. Hay un descenso de gradiente en el porcentaje de error de los pesos sinápticos, lo que lleva a que el sistema presente, al cabo de un cierto tiempo, un error global mínimo, lo que le da al sistema una gran potencia a la hora de reconocer un patrón de estímulos. Existen varios modelos de aprendizaje que muestran cómo se produce el entrenamiento. En el aprendizaje supervisado existe un agente externo (supervisor o maestro) que controla el proceso de aprendizaje de la red. En el aprendizaje no supervisado la red se autoorganiza y en virtud de su propia actividad descubre características, regularidades, correlaciones o categorías en los datos de entrada. Finalmente en el aprendizaje reforzado también existe un supervisor que examina las salidas del sistema, sin embargo, no se dispone de salidas deseadas precisas por lo que no es posible computar el error para cada una de las unidades de salida; el supervisor valora el comportamiento global de la red mediante un criterio y en función de él modifica los pesos mediante un mecanismo de probabilidades. En este aprendizaje, el supervisor se comporta como un crítico, que opina sobre la respuesta de la red. 1.2.4 Las ventajas del conexionismo Los partidarios del conexionismo han argüido que éste presenta claras ventajas sobre las arquitecturas simbólicas computacionales. Dentro de éstas señalan: a) Inspiración biológica: Una de las principales fortalezas del conexionismo es que nos permite entender de manera clara cómo la cognición puede sentarse sobre un órgano biológico. El cerebro. La arquitectura del conexionismo es una modelización y una idealización de la arquitectura del cerebro. El sistema nervioso, tal como un sistema de procesamiento en paralelo está compuesta de unidades discretas masivamente conectadas, formando una red. Las neuronas artificiales, al igual que las biológicas reciben múltiples señales de entrada y se conectan con una única señal de salida con muchas otras unidades, etc. b) Dualismo hardware-software: Derivado de lo anterior, los modelos conexionistas no obedecen al dualismo funcionalista hardware-software. La descripción de la mente no puede hacerse con independencia de las propiedades del “hardware” del que es función. Al menos, no puede Por Eduardo Jeria Garay Santiago, primer semestre 2005 Universidad de Valparaíso Escuela de Psicología Fundamentos Filosóficos y epistemológicos de los sistemas teóricos en Psicología II Errol Dennis y Eduardo Jeria Garay hacerse sin dejarse en el camino características esenciales de los procesos mentales (robustez, flexibilidad, sensibilidad a la experiencia, etc.). c) Robustez: Las redes neuronales biológicas y artificiales comparte la característica de ser robustas ante fallas y daños, puesto que aún perdiendo parte de la información de la red son capaces de funcionar de manera aceptable y acertada. Estas fallas pueden provenir de condiciones de degradación parcial del medio interno (fallas del propio organismo, como cambios de atención, estados de somnolencia, microlesiones del tejido cerebral, etc.) y externo (información con mucho ruido, incompleta o degradada). Esta robustez también es propia de las redes neuronales artificiales, las cuales son hábiles para captar significados globales de las situaciones con información incompleta, completar patrones conceptuales, perceptivos, sin contar con toda la información lógicamente-necesaria para hacerlo, etc. d) Procesamiento en paralelo: Los procesos en una red neuronal artificial son en paralelo: en las redes conexionistas se efectúan numerosos cómputos simultáneamente y en cada momento de procesamiento múltiples capas de microprocesadores están activadas. No realizan una secuencia de cómputos colocados en una fila temporal a lo largo de un camino en que sólo cabe un proceso después de otro. Este paralelismo sin duda parece mas realista que la serialidad en relación con el funcionamiento nervioso. Este rasgo explica por qué las redes pueden dar cuenta de demandas múltiples y simultáneas, lo que las hace más rápidas y más ajustadas al procesamiento tal y cómo se da en el cerebro. e) Simplicidad: Los términos de la explicación conexionista son bastante simples y lo supuestos son prácticamente elementales: unidades, conexiones, reglas de aprendizaje, etc. Este conjunto de mecanismos sencillos puede explicar el accionar cognitivo y dar cuenta de acciones cognitivas de nivel superior. f) Subsimbólico: el conexionismo rechaza la doctrina de las representaciones mentales y de los símbolos y asume que la actividad cognitiva puede basarse en un sistema subsimbólico, donde las representaciones estén distribuidas en la red. Los cómputos no consisten en transformaciones de representaciones simbólicas, sino en cambios que tienen lugar en los estados de activación y los patrones de conectividad de la red en su totalidad. No se puede decir, en rigor, que correspondan a reglas de una sintaxis. Mas bien corresponden a reglas de activación, propagación y aprendizaje que son inherentes al funcionamiento del sistema. g) Leyes estadísticas: El paradigma simbólico tiene constricciones rígidas, inferencia lógica proceso en serie. En el paradigma subsimbólico en cambio, las decisiones se basan en parámetros estadísticos, lo que concuerda con las investigaciones de categorización más influyentes, como el trabajo de Rosch con prototipos. Las categorías del pensamiento humano, entonces responden más bien a leyes probabilísticas que lógicas. h) Sistemas motores y perceptuales: El modelo clásico se centra en procesos cognitivos centrales (como la planificación, la memoria, la atención, la categorización, etc.) y habitualmente no incluyen modelos detallados de las operaciones perceptuales y del sistema motor. En cambio, el conexionismo, por su manera de manejar los input y output paralelamente, considera de manera natural estas áreas. i) Incorporación del ambiente y del aprendizaje: Una de las ventajas del conexionismo es que explica claramente el papel que juegan el ambiente y el aprendizaje en la conducta inteligente. La capacidad de las redes de modificarse adaptativamente en función de las experiencias previas, la plasticidad y flexibilidad de sus conexiones explican cómo un dispositivo puede Por Eduardo Jeria Garay Santiago, primer semestre 2005 Universidad de Valparaíso Escuela de Psicología Fundamentos Filosóficos y epistemológicos de los sistemas teóricos en Psicología II Errol Dennis y Eduardo Jeria Garay aprender de los inestables estímulos ambientales. De esta manera evitan una de las características más criticadas de la arquitectura simbólica: una tendencia al innatismo. j) Rapidez: los sistemas conexionistas asignan significados rápidos, sin necesidad de reducir a algoritmos exhaustivos su proceder. Esta característica se relaciona estrechamente con el hecho que el procesamiento es en paralelo k) Flexibles: Las redes logran ser, a la vez, estructuradas y flexibles. Son estructuradas en cuanto el diseño de la red permite que se responda de la misma manera a estímulos similares, presentan discriminación y generalización y son capaces de tener adquirir conocimiento. Son flexibles en la medida que su estructura puede variar si la red es expuesta a clases de estímulos muy diferentes de los que ésta conocía. Además, los constreñimientos que la red tiene en su procesamiento son mínimos, existiendo muchas maneras de procesar la misma información. Así, desde una red, se puede acceder a los conocimientos por vías diversas, lo que explica la capacidad de los agentes inteligentes de ser flexibles ante las demandas de un ambiente cambiante. l) Control ejecutivo: Por otra parte, en los modelos conexionistas de la mente no hay un procesador central con misiones de control. El “control” es también distribuido e implícito, y no localizable ni explicito. Se deriva de las propiedades de los propios sistemas. Las memorias no se definen por localizaciones y nos hay sistemas de acceso a ellas, sino por patrones de conectividad diversos que pueden producirse en un mismo subconjunto de la red. Para finalizar podemos señalar algunas deficiencias de los modelos de procesamiento distribuido en paralelo. a) Aún no se han desarrollado modelos lo suficientemente potentes como para desplazar a otro tipo de programas más efectivos. b) Las redes neuronales no producen resultados exactos, sino que en general únicamente aproximados. c) Son fuertemente dependientes del estímulo, por lo que actúan bien en simulaciones de procesos perceptivos, pero menos bien con relación a otras áreas de la cognición. d) Mientras que las representaciones de los modelos clásicos son “semánticamente trasparentes”, las de los conexionistas no lo son. Referencias Bechtel et al. (1998) A companion to the cognitive science Oxford: Blackwell McCulloch y Pitts (1965) Un cálculo lógico de las ideas inmanentes en la actividad nerviosa. En Boden (1990) Filosofía de la inteligencia artificial México DF: Fondo de cultura económica Stillings, N. et al. (2002) Cognitive Science: an introduction. Por Eduardo Jeria Garay Santiago, primer semestre 2005