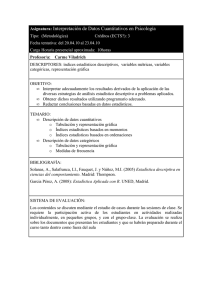

Proceso de Datos en Psicología

Anuncio