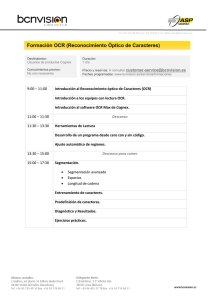

Software de adquisición de imágenes y reconocimiento óptico de

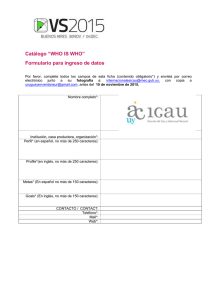

Anuncio