5. Otros temas

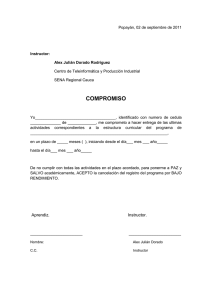

Anuncio

INSTRUCTOR: LUIS E. NIETO BARAJAS

5. Otros temas

5.1 Modelos jerárquicos

¾ Los modelos jerárquicos Bayesianos simplifican la estimación simultánea

de varios parámetros θi del mismo tipo con dos fines principales: (1)

combinar la fuerza de los datos para mejorar la precisión de las

estimaciones de los parámetros y (2) permitir incorporar incertidumbre en

las estimaciones.

¾ Una ventaja de los métodos de simulación Bayesianos, como el MCMC, es

que permiten realizar inferencias relativamente fáciles para modelos

jerárquicos complejos.

¾ La idea de combinar fuerzas está basada en un supuesto de

intercambiabilidad (simetría) entre los parámetros θi del modelo.

¾ INTECAMBIABILIDAD: La idea de intercambiabilidad se puede explicar de la

siguiente manera: Consideremos un conjunto de k poblaciones, donde

cada población está determinada por un parámetro θi, i=1,...,k. Sea Yi una

observación de la i‐ésima población, i.e., cada población se puede

representar mediante la función de densidad f (y i θi ) . Si no se cuenta con

información que nos permita distinguir las θi’s unas de otras (además de

la información de los datos Y1,...,Yk) y si no es razonable establecer algún

orden o agrupación de los parámetros, entonces debemos suponer una

99

Curso: Métodos Bayesianos

INSTRUCTOR: LUIS E. NIETO BARAJAS

especie de simetría entre los parámetros y ésta debe reflejarse en su

distribución inicial. Dicha simetría se representa a través del concepto de

intercambiabilidad.

¿CÓMO representamos intercambiabilidad en las θi’s?.

La intercambiabilidad entre el conjunto (θ1 ,Kθk ) se logra suponiendo

que las θi’s son condicionalmente independientes dado el valor de un

hiper‐parámetro, digamos ϕ, i.e.,

k

f (θ1 ,Kθk ) = ∫ f (θ1 ,Kθk ϕ)f (ϕ)dϕ = ∫ ∏ f (θi ϕ)f (ϕ)dϕ ,

i=1

donde f(ϕ) es la distribución inicial del hiperparámetro.

MODELO: El modelo jerárquico general toma la siguiente forma:

1) Condicional en ϕ y (θ1 ,Kθk ) , los datos Yi son independientes, con

densidades f (y i θi ) , i.e.,

k

f (y 1 ,Ky k θ1 ,Kθk ) = ∏ f (y i θi )

i=1

2) Condicional en ϕ, los parámetros θi son observaciones de la misma

densidad f (θ ϕ) , i.e.,

k

f (θ1 ,Kθk ϕ) = ∏ f (θi ϕ)

i=1

3) El hiperparámetro ϕ tiene función de densidad f (ϕ) .

La parte (1) representa el modelo paramétrico de los datos y las partes (2)

y (3) representan la distribución inicial de los parámetros del modelo.

100

Curso: Métodos Bayesianos

INSTRUCTOR: LUIS E. NIETO BARAJAS

Representación gráfica del modelo jerárquico. El modelo jerárquico se

ϕ

hiperparámetro

θ1

θ2

θk

parámetros

Y1

Y2

Yk

observaciones

puede representar mediante el siguiente esquema:

APLICACIONES / EXPLICACIONES.

o Este tipo de modelos se utilizan para realizar inferencias dentro de un

conjunto de unidades, por ejemplo, en estudios comparativos entre

instituciones, como universidades, hospitales, bancos etc., los

parámetros de interés podían ser la calificación promedio en un

examen por universidad, tasas de mortalidad por hospital, tasas de

aceptación de créditos, etc.

o Por lo general en este tipo de estudios comparativos se tienen varias

unidades (universidades, hospitales, bancos, etc.) pero pocos datos de

cada uno de ellos por separado. La idea de los modelos jerárquicos es

combinar la información de distintas fuentes de datos (universidades,

hospitales, bancos etc.), explotando la similaridad entre los parámetros

en términos de su génesis.

101

Curso: Métodos Bayesianos

INSTRUCTOR: LUIS E. NIETO BARAJAS

ANÁLISIS DEL MODELO. Las componentes del modelo son:

k

Verosimilitud: f (y 1 ,Ky k θ1 ,Kθk ) = ∏ f (y i θi )

i=1

Inicial: f (θ1 ,Kθk , ϕ) = f (θ1 ,Kθk ϕ)f (ϕ) ,

k

donde, f (θ1 ,Kθk ϕ) = ∏ f (θi ϕ)

i=1

La idea es hacer inferencias sobre los parámetros individuales (θ1 ,Kθk ) y

el parámetro común ϕ. Entonces,

Final: f (θ1 ,Kθk , ϕ y ) = f (θ1 ,Kθk ϕ, y )f (ϕ y ) ,

donde, f (θ1 ,Kθk ϕ, y ) ∝ f (y 1 ,K y k θ1 ,Kθk )f (θ1 ,Kθk ϕ) , y

f (ϕ y ) ∝ f (y ϕ)f (ϕ) con f (y ϕ) = ∫ f (y θ1 ,K , θk )f (θ1 ,K , θk ϕ)dθ

CASOS

PARTICULARES:

Dependiendo de la selección de la distribución que

genera los datos, se pueden construir distintos modelos jerárquicos. Una

clase de modelos jerárquicos general se obtiene al considerar f (y i θi )

como un miembro de la familia exponencial y las distribuciones iniciales

f (θi ϕ) y f (ϕ) miembros de la familia conjugada correspondiente.

Ejemplos:

o Normal:

1) Yi µi ∼ N(µi , τi ) , con τi conocida

2) µ i ϕ ∼ N(ϕ, λ ) , con λ conocida

3) ϕ ∼ N(ϕ0 , λ 0 ) , con ϕ0 y λ0 conocidas

Nota: Es posible que en la primera etapa del modelo se incluyan

102

Curso: Métodos Bayesianos

INSTRUCTOR: LUIS E. NIETO BARAJAS

covariables o variables explicativas.

o Poisson:

1) Yi µi ∼ Po(µi )

2) µ i β ∼ Ga(α ,β) , con α conocida

3) β ∼ Ga(α 0 , β 0 ) , con α0 y β0 conocidas

Alternativamente,

2a) ηi = log (µi ) , ηi ϕ ∼ N(ϕ, λ ) , con λ conocida

3a) ϕ ∼ N(ϕ0 , λ 0 ) , con ϕ0 y λ0 conocidas

o Bernoulli:

1) Yi πi ∼ Bin(ni , πi )

2) πi , α , β ∼ Beta(α , β)

3) α ∼ Ga(a0 ,b 0 ) , β ∼ Ga(c 0 , d0 ) , con a0, b0, c0 y d0 conocidos

Alternativamente,

2a) ηi = logit(πi ) , ηi ϕ ∼ N(ϕ, λ ) , con λ conocida

3a) ϕ ∼ N(ϕ0 , λ 0 ) , con ϕ0 y λ0 conocidas

¾ EJERCICIO 13. Incidencia y tasas de mortalidad (Congdon, 2001). Considera

un caso de estudio de niños con leucemia. Se cuenta con la información

del número de muertes en dos regiones del Reino Unido en el año de

1950. Las tasas de muerte están clasificadas por edad (1‐0:5, 2‐6:14), el

tipo de residencia del niño (1‐rural, 2‐urbano) y el tipo de cancer (1‐

Lymphoblastic, 2‐Myeloblastic). Sea Oi el número de muertes observadas,

103

Curso: Métodos Bayesianos

INSTRUCTOR: LUIS E. NIETO BARAJAS

Pi es el número total de niños (en millones) y θi la tasa de mortalidad en la

clase i. Se proponen dos modelos para estos datos:

a) Modelo de efectos independientes:

Yi θi ∼ Po(θiPi ) , θi ∼ Ga(0.001,0.001)

b) Modelo de efectos intercambiables:

Yi θi ∼ Po(θiPi ) , θi α , β ∼ Ga(α , β) , α ∼ Ga(1,1) , β ∼ Ga(0.1,1)

¾ EJERCICIO 14. Probabilidades de reclamación. Considera una compañía de

seguros que cuenta con 10 tipos de seguros. Por el momento la compañía

tiene un total de ni asegurados en cada categoría y únicamente ri de ellos

le han hecho una reclamación, i=1,...,10. Sea πi la probabilidad de que un

asegurado en la categoría i le haga una reclamación. Se proponen dos

modelos:

a) Modelo con efectos independientes:

Yi πi ∼ Bin(ni , πi ) , πi ∼ Beta(1,1)

b) Modelo con efectos intercambiables:

Yi πi ∼ Bin(ni , πi ) , πi α , β ∼ Beta(α , β) , α ∼ Ga(1,1) , β ∼ Ga(1,1)

104

Curso: Métodos Bayesianos

INSTRUCTOR: LUIS E. NIETO BARAJAS

5.2 Análisis Bayesiano empírico

¾ En términos generales, el análisis Bayesiano empírico consiste en hacer

uso de la información muestral para estimar los hiperparámetros de las

distribuciones iniciales.

¾ Para concretar ideas considera el siguiente modelo. Sea f (y θ) la función

de densidad conjunta de las variables observables Y condicional en un

vector de parámetros θ (i.e., la función de verosimilitud), y sea f (θ η) la

distribución inicial para θ que depende de un vector de hiperparámetros

η.

Si η es conocido, entonces la inferencia sobre θ se hace a través de su

distribución final, la cuál está dada por el Teorema de Bayes,

f (θ y , η) =

f (y θ)f (θ η)

,

f (y η)

donde f (y η) denota la distribución marginal de los datos y, dada por

f (y η) = ∫ f (y θ)f (θ η)dθ

Si η es desconocido, el análisis Bayesiano completo consistiría en asignar

una distribución inicial para η, digamos f (η) y obtener la distribución final

para θ como

f (θ y ) =

∫ f (y θ)f (θ η)f (η)dη = f (θ y , η)f (η y )dη

~ )f (θ

~ η)f (η)dηdθ

~ ∫

(

θ

f

y

∫∫

105

Curso: Métodos Bayesianos

INSTRUCTOR: LUIS E. NIETO BARAJAS

Esta segunda expresión representa una mezcla de la distribución final de θ

condicional en η con respecto a la distribución final marginal de η.

En el análisis Bayesiano empírico se usa la distribución marginal f (y η)

para estimar η mediante su correspondiente estimador máximo verosímil

ˆ =η

ˆ (y ) . Entonces, la inferencia sobre θ se realiza a través de f (θ y , η

ˆ ).

η

¾ EJEMPLO 14: Considera un modelo jerárquico de 2 niveles,

(

)

), i=1,….,k independientes.

Yi θi ∼ N θi , σ −2 , i=1,…,k independientes, y

(

θi µ ∼ N µ , τ −2

Supongamos que σ2 y τ2 son conocidos, por lo que el único parámetro

desconocido es µ, (i.e., η=µ). No es difícil demostrar que la distribución

(

(

marginal de las Yi’s condicional en µ es Yi µ ∼ N µ , σ2 + τ2

)

−1

). Entonces la

verosimilitud para µ está dada por,

(

k

f (y µ ) = ∏ N y i µ , σ2 + τ2

i=1

)

−1

.

Por lo tanto el EMV de µ es µˆ = y . Finalmente, la distribución posterior

(estimada) de θi es

(

)

f (θi y , µˆ ) = N Bµˆ + (1 − B )y i , (1 − B )−1 σ −2 ,

(

)

con B = σ2 σ2 + τ2 .

En este caso el estimador Bayesiano empírico de θi es

θˆ iEB = By + (1 − B )y i = y + (1 − B )(y i − y )

106

Curso: Métodos Bayesianos

INSTRUCTOR: LUIS E. NIETO BARAJAS

¾ EJEMPLO 15: Considera el mismo modelo jerárquico del Ejemplo 14. Un

análisis Bayesiano completo consistiría en tomar una distribución inicial

para µ. Supongamos que la distribución inicial es

(

)

µ ∼ N µ 0 , λ−02 .

En este caso, la distribución final para θi es una mezcla de la forma

(

)(

)

f (θi y ) = ∫ N θi Bµ + (1 − B )y i , (1 − B )−1 σ −2 N µ Cy + (1 − C )µ 0 , (1 − C )−1 λ−02 dµ

(

)

con C = nλ2o σ2 + τ2 + nλ20 .

En este caso, el estimador completamente Bayesiano de θi es

θˆ iFB = BCy + B(1 − C )µ 0 + (1 − B )y i

o Nota 1: Si C=1 entonces θˆ iFB = θˆ iEB .

o Nota 2. C→1 si n→∞ ó λ20 →∞.

5.3 Modelos Bayesianos no paramétricos

¾ Los métodos Bayesianos no paramétricos combinan la robustez de la

estadística no paramétrica con la versatilidad de la estadística Bayesiana

mediante el uso de procesos estocásticos.

107

Curso: Métodos Bayesianos

INSTRUCTOR: LUIS E. NIETO BARAJAS

¾ Para poder entender las ideas generales en las que se basan los modelos

Bayesianos no paramétricos comencemos por describir las diferencias

entre los supuestos paramétricos y no paramétricos.

PARAMÉTRICO: X∼F, F ∈ ℑΘ

ℑΘ = {F : F = Fθ , θ ∈ Θ}

NO PARAMÉTRICO: X∼F, F ∈ ℑ

ℑ = {F : F es una función de distribución}

⇔ dim(Θ) = ∞

¾ Recordemos que la teoría Bayesiana requiere que el tomador de

decisiones exprese su conocimiento inicial sobre todos los parámetros

desconocidos del modelo. Para cada uno de los supuestos paramétricos y

no paramétricos anteriores tenemos:

INFERENCIA BAYESIANA PARAMÉTRICA:

θ ∼ f(θ) con θ∈Θ ⇒ ℑΘ ∼ P

INFERENCIA BAYESIANA NO PARAMÉTRICA:

ℑ∼P

¾ El planteamiento de la inferencia Bayesiana no paramétrica se puede

resumir mediante:

X1,X2,…,Xn m.a. tal que

X i F ∼ F definida en (ℜ,B)

F ∼ P definida en (ℑ,A)

108

Curso: Métodos Bayesianos

INSTRUCTOR: LUIS E. NIETO BARAJAS

donde P es una “distribución” inicial sobre el espacio de funciones ℑ, i.e.,

P es un proceso estocástico cuyas trayectorias son funciones de

distribución.

¾ La idea de una distribución inicial no paramétrica es que considere

eventualidades no captadas por las familias paramétricas. En notación

matemática esto se puede ver como:

o Sea G la función de distribución real de los datos. Entonces al suponer

que X|F ∼ F y F ∼ P, para cualquier partición medible (B1 ,KBk ) de ℜ y

ε > 0 quisiéramos que

P (F : F(Bi ) − G(Bi ) < ε , para i = 1,K ,k ) > 0 .

¾ Las distribuciones iniciales no paramétricas más comunes son el Proceso

de Dirichlet y el Árbol de Polya.

¾ PROCESO DIRICHLET (Ferguson, 1973): Sea F0 una función definida en (ℜ,B) y

c>0 un escalar. Sea F un proceso estocástico indexado por elementos de

B. Entonces,

F ∼ DP (c,F0 )

si para toda partición finita de medible (B1 ,KBk ) de ℜ se tiene que

(F(B1 ),KF(Bk )) ∼ Dir(cF0 (B1 ),K, cF0 (Bk ))

o El proceso de Dirichlet asigna probabilidad 1 al espacio de funciones de

distribución discretas.

109

Curso: Métodos Bayesianos

INSTRUCTOR: LUIS E. NIETO BARAJAS

o F0 es llamada medida de centralidad del proceso

o c es el parámetro de precisión

o Para cada B∈B,

F(B ) ∼ Be(cF0 (B ), c{1 − F0 (B )}) , con

E {F(B )} = F0 (B )

VAR {F(B )} =

F0 (B ){1 − F0 (B )}

c +1

Distribución final del proceso: dada una muestra X1,…,Xn de observaciones

de F se tiene

(

F X ∼ DP c* ,F0*

)

donde c* = c + n y

F0* =

cF0 + nFn

c +n

con Fn la función de distribución empírica. F0* es la nueva medida de

centralidad del proceso posterior y puede ser usado como estimador

puntual de F.

¾ Definiciones alternativas del proceso de Dirichlet:

1) Sethuraman (1994): Sea F ∼ DP(c,F0) entonces,

∞

F = ∑ Vjδ Yj

j=1

donde, Vj = Wj ∏ (1 − Wj ), Wj ∼ Be(1, c ) , y Yj ∼ F0

iid

iid

i< j

110

Curso: Métodos Bayesianos

INSTRUCTOR: LUIS E. NIETO BARAJAS

iid

2) Blackwell y MacQueen (1973): Sean X i F ∼ F y F∼DP(c,F0). Entonces, al

marginalizar el proceso F, la sucesión de v.a.’s (X 1 , X 2 ,K) es un

conjunto de v.a.’s intercambiables generadas como,

X 1 ∼ F0 ,

X2 X1 ∼

cF0 + δ X1

c +1

,…,

n−1

X n X 1 ,K , X n−1 ∼

¾ ÁRBOL

DE

cF0 + ∑i=1 δ Xi

c +n−1

.

POLYA (Lavine, 1992). Sea A = (α 0 , α 1 , α 00 ,K) números no

negativos, Y = (Y0 , Y1 , Y00 ,K) v.a.’s, y Π = {B ε } un árbol de particiones

binarias de (ℜ,B). Entonces,

F ∼ PT (Π , A ) si

a) Todas las v.a.’s en Y son independientes,

b) Para todo ε, Yε 0 ∼ Be(α ε 0 , α ε1 ) , y

c) Para todo m=1,2,… y ε = ε1ε 2 Lεm con ε j ∈ {0,1} se tiene que

(

F B ε1Lεm

)

m

m

= ∏ Yε1Lε j−1 0 ∏ 1 − Yε1Lε j−1 0

j=1,ε =1

j=1,ε =0

j

j

(

) .

o Árbol de particiones binarias Π = {B ε }. Para un nivel m, ε = ε1ε 2 Lεm ,

ε j ∈ {0,1} , j=1,…,m se tiene el siguiente diagrama:

111

Curso: Métodos Bayesianos

INSTRUCTOR: LUIS E. NIETO BARAJAS

o La distribución (predictiva) de cualquier observación se puede obtener

como el producto de las Yε por donde pasa una canica si se deja caer de la

parte superior del árbol, i.e.,

o Si tomamos α ε = cm2 con c>0 entonces el árbol de Polya asigna

probabilidad 1 al espacio de funciones de distribución continuas.

Distribución final del proceso: dada una muestra X1,…,Xn de observaciones

de F se tiene

(

F X ∼ PT Π , A *

)

112

Curso: Métodos Bayesianos

INSTRUCTOR: LUIS E. NIETO BARAJAS

{ }

donde A * = α *ε con

α *ε = α ε + nε , y

n

nε = ∑ I(X i ∈ B ε )

i=1

El número de observaciones en Bε.

¾ EJERCICIOS con el proceso Dirichlet y árbol de Polya se encuentran en la

librería de R llamada “DPpackage”.

113

Curso: Métodos Bayesianos