implementación de una arquitectura de almacenamiento masivo de

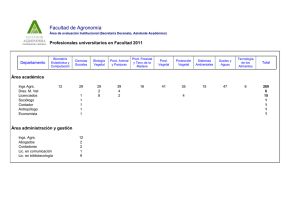

Anuncio