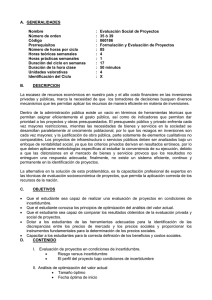

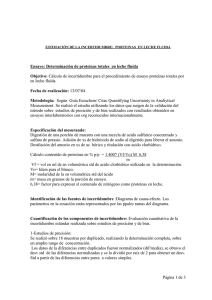

incertidumbre en métodos analíticos de rutina

Anuncio