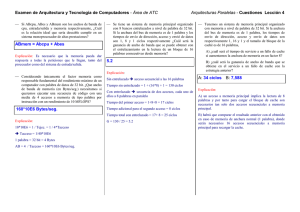

Utilización de Memorias Cache con Bloqueo en Sistemas de

Anuncio