Modelos teóricos y numéricos en los estudios de predecibilidad

Anuncio

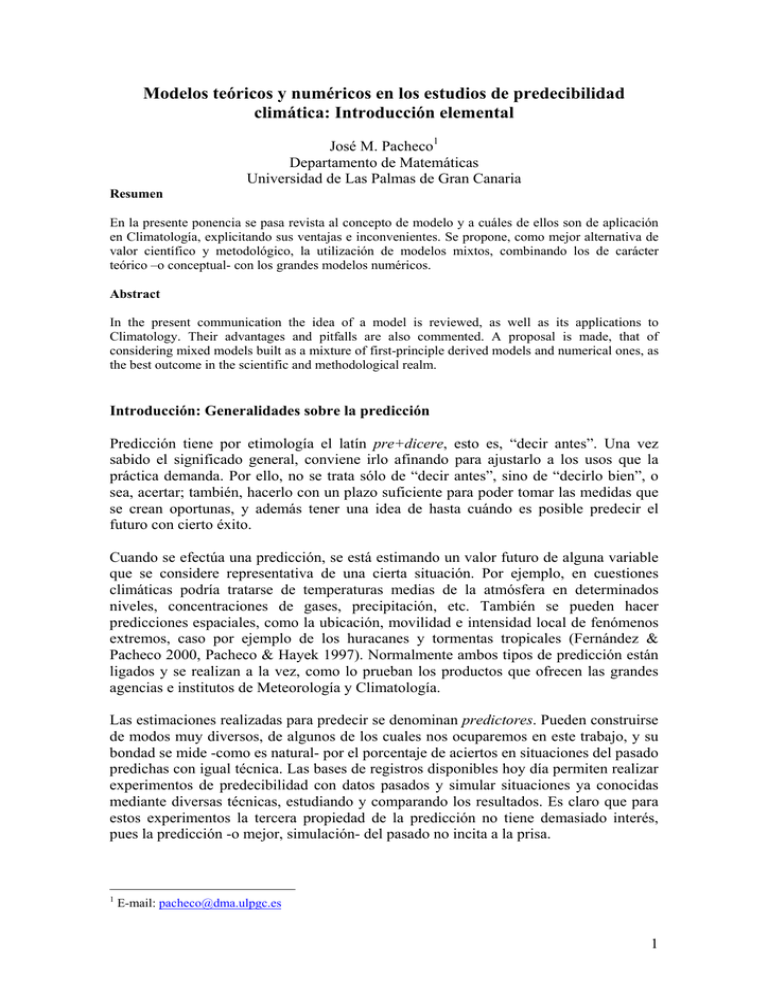

Modelos teóricos y numéricos en los estudios de predecibilidad climática: Introducción elemental José M. Pacheco1 Departamento de Matemáticas Universidad de Las Palmas de Gran Canaria Resumen En la presente ponencia se pasa revista al concepto de modelo y a cuáles de ellos son de aplicación en Climatología, explicitando sus ventajas e inconvenientes. Se propone, como mejor alternativa de valor científico y metodológico, la utilización de modelos mixtos, combinando los de carácter teórico –o conceptual- con los grandes modelos numéricos. Abstract In the present communication the idea of a model is reviewed, as well as its applications to Climatology. Their advantages and pitfalls are also commented. A proposal is made, that of considering mixed models built as a mixture of first-principle derived models and numerical ones, as the best outcome in the scientific and methodological realm. Introducción: Generalidades sobre la predicción Predicción tiene por etimología el latín pre+dicere, esto es, “decir antes”. Una vez sabido el significado general, conviene irlo afinando para ajustarlo a los usos que la práctica demanda. Por ello, no se trata sólo de “decir antes”, sino de “decirlo bien”, o sea, acertar; también, hacerlo con un plazo suficiente para poder tomar las medidas que se crean oportunas, y además tener una idea de hasta cuándo es posible predecir el futuro con cierto éxito. Cuando se efectúa una predicción, se está estimando un valor futuro de alguna variable que se considere representativa de una cierta situación. Por ejemplo, en cuestiones climáticas podría tratarse de temperaturas medias de la atmósfera en determinados niveles, concentraciones de gases, precipitación, etc. También se pueden hacer predicciones espaciales, como la ubicación, movilidad e intensidad local de fenómenos extremos, caso por ejemplo de los huracanes y tormentas tropicales (Fernández & Pacheco 2000, Pacheco & Hayek 1997). Normalmente ambos tipos de predicción están ligados y se realizan a la vez, como lo prueban los productos que ofrecen las grandes agencias e institutos de Meteorología y Climatología. Las estimaciones realizadas para predecir se denominan predictores. Pueden construirse de modos muy diversos, de algunos de los cuales nos ocuparemos en este trabajo, y su bondad se mide -como es natural- por el porcentaje de aciertos en situaciones del pasado predichas con igual técnica. Las bases de registros disponibles hoy día permiten realizar experimentos de predecibilidad con datos pasados y simular situaciones ya conocidas mediante diversas técnicas, estudiando y comparando los resultados. Es claro que para estos experimentos la tercera propiedad de la predicción no tiene demasiado interés, pues la predicción -o mejor, simulación- del pasado no incita a la prisa. 1 E-mail: [email protected] 1 Sin embargo, en las predicciones día a día para fenómenos meteorológicos, o anualmente para situaciones climáticas, es conveniente que la predicción pueda llevarse a cabo con antelación suficiente. Por supuesto, hay predictores que se pueden formular de inmediato: por ejemplo tomemos la permanencia y el paseo aleatorio. El primero consiste en suponer que la situación actual se prolongará hasta el momento para el que se quiere predecir; el segundo supone que la predicción es una mera cuestión de suerte. Ambos son predictores válidos y utilizados con frecuencia como “enemigos a batir” por cualquier otro diseño de predicción. Pero no todos los métodos son tan rápidos, y lleva siempre cierto tiempo efectuar la predicción. Así, una predicción a 24 horas vista necesitará siempre, para ser de alguna utilidad, que se haga en menos de 24 horas, y si es en cuatro o cinco, mejor aún. Hasta hace unos cuarenta años no se consiguió que esta importante propiedad se cumpla con regularidad, y estamos tan acostumbrados a ella que al parecer todo el mundo la da por descontada, pero no siempre es cierto, sobre todo en relación con fenómenos extremos. Para finalizar esta introducción presentaremos el problema de “hasta cuándo” es posible predecir con confianza. Ese límite, a partir del cual la predicción no es fiable, se llama “horizonte de la predicción”, es calculable y debe ofrecerse entre los resultados que se presenten (Gimeno et al. 2001). La pérdida de valor de la predicción con el tiempo, o lo que es igual, la dificultad de predecir más allá de cierto lapso temporal, se debe a la incapacidad de contar para construir el predictor con la información generada entre el instante de su formulación y aquél al cual se refiere. Por eso nunca vemos predicciones meteorológicas para más de siete u ocho días: En esa semana pueden generarse fenómenos atmosféricos que invaliden, debido a las nuevas informaciones que transportan, una predicción que no pudo tenerlas en cuenta. Series temporales Prácticamente todos los registros interesantes en Meteorología y Climatología se presentan en forma de series temporales, esto es, los datos están ordenados de forma correlativa respecto del tiempo. En fórmulas, se trata de trabajar con conjuntos de valores de la forma {X t t = 1,2,..., N }. En esencia, el análisis de datos temporales se reduce a encontrar pautas o patrones que se repiten más o menos exactamente a lo largo de ellas. Para las series meteorológicas, por ejemplo, existe una pauta periódica de un año que se corresponde con el periodo de traslación de la Tierra alrededor del Sol. Para datos tomados a intervalos muy cortos de tiempo es posible distinguir la pauta diaria de día/noche asociada a la rotación de la Tierra, y varias más. Todas estas pautas pueden ser sustraídas de la señal original dejando un resto o residuo como resultado de este primer análisis: X t = Pt + Rt Sobre la señal residual se aplican las técnicas de la Estadística para extraer aquellas informaciones que no fueron captadas en la primera fase del estudio. Una primera investigación es investigar si el residuo es algún tipo de ruido, en cuyo caso la señal básica se interpretaría como un comportamiento periódico modulado por fenómenos asociados al azar. 2 Ahora bien, no todos los ruidos son iguales. Un ruido es simplemente una sucesión de valores muestreados en una distribución estadística, por tanto son números alrededor de un valor medio y distribuidos alrededor de él con un grado de agrupamiento que viene dado por la varianza de la distribución. Así se puede hablar de ruidos Gaussianos, uniformes, etc. Pero existe otra manera de clasificar los ruidos, atendiendo a si existe correlación entre un valor y los anteriores, esto es, se calcula la función de autocorrelación g ( s ) =< Rt Rt −s > que nos indica si para cada intervalo o distancia temporal s existe correlación entre los ruidos correspondientes. Si es nula, esto es, no existe correlación para ningún valor de s exceptuando el caso obvio en que s = 0 , donde no puede ser nula, se dice que el ruido es blanco, lo cual es una forma abreviada de decir que carece de estructura de memoria y en la predicción ésta se reducirá a la parte periódica de la señal básica más un complemento puramente aleatorio que nos podrá informar, como mucho de unas fluctuaciones medias y poco más. Para datos climáticos el objetivo habitual es el da hallar periodicidades en la escala decadal (decenas de años) o incluso superior. En este caso, la existencia de correlaciones a largo plazo con valores previos se indica diciendo que el ruido es rojo, lo cual indica la presencia de una memoria en el fenómeno estudiado, que puede ser utilizada en la predicción. Hay métodos cuantitativos para apreciar el grado de rojez de un ruido y poder establecer el horizonte de la predicción y demás cuestiones de interés sobre el fenómeno estudiado (Caldeira et al. 2006). El principal inconveniente de los estudios de series temporales es que obvian la fenomenología subyacente, a menos de llevarse a cabo un estudio muy detallado de la interpretación de las informaciones obtenidas (Fernández et al. 2003). Un ejemplo lo aclarará mejor: Supongamos que se ha obtenido que determinada señal presenta una pauta periódica de cuatro semanas detectada con el análisis de un ruido rojo. En ese momento hay que preguntarse si verdaderamente existe alguna causa para esa característica o, por el contrario, se trata de un artificio del aparato matemático. Por ello es conveniente también combinar los estudios de series temporales con los modelos teóricos procedentes de la aplicación de primeros principios. Modelos teóricos Un modelo es una representación simplificada de alguna parcela del mundo real. Por ejemplo, las series temporales del apartado anterior son representaciones del mundo real donde sólo se considera como descripción el dato de la variable que se haya elegido, como podría ser la temperatura del aire. Sin embargo, la Ciencia avanza sobre la construcción de Teorías (o “visiones”) que por regla general se componen de partes o “modelos”. En este caso, un modelo es una formulación de alguna parte de la teoría. Si nos hallamos en el mundo de la Física utilizaremos casi sin dudar las Matemáticas para escribir un modelo, y por tanto recibirá el nombre de “modelo matemático”. La inmensa ventaja del modelo matemático es que permite aplicar a las ecuaciones o expresiones que lo conforman todo el aparato deductivo de las Matemáticas y obtener resultados interpretables en términos físicos, 3 resultados que con toda seguridad no habrían sido previstos por la fase inductiva de recopilación y clasificación de datos. Para ver en acción esta forma de entender la Física, supongamos que deseamos estudiar la dinámica atmosférica siguiendo a una partícula en el aire. La primera observación es que se halla sometida a diferentes fuerzas, como la del viento, la presión atmosférica, etc. Usando la segunda ley de Newton, escribiremos: → → ma = F para indicar la proporcionalidad entre la aceleración y la fuerza total a que se halla sometida la partícula. Ahora bien, la fuerza total puede desmenuzarse en otras según el grado de finura de nuestro análisis, de modo que → F = gradP +Coriolis + ... Si además descomponemos las magnitudes vectoriales en sus tres componentes respecto a algún sistema de referencia, tendremos las expresiones habitualmente denominadas ecuaciones primitivas o de Euler. Dado que al introducir las diversas fuerzas aparecieron otras magnitudes como la presión, la temperatura y alguna más, se han de añadir a las ecuaciones derivadas de la ley de Newton las correspondientes a las nuevas magnitudes, generando un modelo teórico al que se le pueden aplicar las técnicas habituales de las Matemáticas. Para este caso se pueden establecer resultados de existencia de soluciones, desarrollar aproximaciones cualitativas para conocer aspectos de las soluciones, pero por desgracia no hay técnicas de resolución –integración de ecuaciones diferenciales- que permitan obtener de forma explícita soluciones del sistema planteado. Este comportamiento es muy frecuente cuando se construyen modelos para hechos físicos. Salvo que se haya seleccionado una versión muy simplificada a base de despreciar diferentes relaciones y magnitudes, lo más corriente será encontrarse con expresiones de las que sólo se pueden obtener soluciones de modo aproximado, que pueden calcularse mediante métodos numéricos. Pero antes de pasar a los modelos numéricos conviene insistir en la necesidad de formular modelos teóricos. Tales modelos están basados en la experiencia acumulada por especialistas y suelen descansar sobre una comprensión profunda de la fenomenología de lo que se desea estudiar, al contrario de lo que pasaba, por ejemplo, con los análisis de series temporales, donde la interpretación es siempre a posteriori. Por tanto, si se han formulado con las necesarias dosis de simplificación y sabiduría en la elección de las magnitudes y relaciones fundamentales, los modelos teóricos son la base más sólida para un estudio provechoso de cualquier fenómeno físico. Modelos Numéricos Los modelos numéricos son hijos del desarrollo tecnológico, aunque no debe pensarse que lo sean sólo desde que existen ordenadores. Las técnicas de cálculo numérico para hallar soluciones de ecuaciones algebraicas, de integrales definidas, para la integración de ecuaciones diferenciales ordinarias y de algunas en derivadas parciales, aparecieron 4 de forma gradual a lo largo del Siglo XVIII y del XIX y fueron implementadas en grandes hojas de cálculo manual, luego suplementadas por calculadoras básicas manejadas por verdaderos ejércitos de calculistas –por regla general eran mujeres- que alimentaban sus máquinas con las operaciones elementales a que se reducen en última instancia los cálculos numéricos. Mucho antes de la existencia de máquinas electrónicas ya se conocían resultados teóricos y prácticos acerca de las condiciones bajo las que las soluciones de las aproximaciones numéricas se podían considerar razonablemente aproximadas a las soluciones –por otra parte no conocidas explícitamente- de las ecuaciones de los modelos teóricos. Entre estos resultados teóricos se encuentra, para las ecuaciones en derivadas parciales, el cálculo del número de condición o de CourantFriedrichs y Levy (CFL) que relaciona el tamaño de los pasos espacial y temporal de la integración. Si no respeta la condición dada por el número CFL, el cálculo se inestabiliza y resulta inútil a efectos prácticos. Sin embargo, la popularización de las máquinas electrónicas y su imparable velocidad de crecimiento en complejidad, capacidad de memoria, rapidez en los cálculos, etc., han conseguido que los esquemas numéricos utilizados para la resolución de las aproximaciones de las ecuaciones de los modelos teóricos conformen por sí mismos una nueva categoría de modelos, en especial cuando se trata de situaciones de gran complicación por el elevado número de variables, o lo extenso de los dominios espaciotemporales que deben discretizarse y controlar por tanto el crecimiento de las fuentes de error en los cálculos aproximados. Para hacernos una idea del volumen de los cálculos que pueden intervenir en un modelo numérico, pensemos en un programa de ordenador ideado para evaluar velocidad de viento, concentración de varios gases de efecto invernadero y temperatura a nivel hemisférico con una malla espacial de unos100 km de lado y dividiendo la atmósfera en veinte capas. Para una extensión de 4000 por 3000 km, más o menos la parte continental de los Estados Unidos, se requerirían 40 × 30 × 20 = 24000 nodos donde efectuar el cálculo. Si el número de variables que se van a determinar es de 10, habrá que resolver sistemas numéricos de 240000 ecuaciones, y dado que cada ecuación requiere un número de operaciones elementales, que podríamos fijar en 10000 (estimación muy conservadora), una determinación de las 10 variables necesitará como mínimo 2400 millones de operaciones. Pero en la predicción hay que llevar a cabo esa determinación muchísimas veces, una tras otra, utilizando la anterior como punto de partida de la siguiente. El número de veces que hay que repetir el cálculo depende de varios factores, entre ellos del número CFL, pero no es arriesgado decir que una predicción meteorológica razonable necesite calcular una determinación para cada cinco minutos. Eso indica que en una predicción a un día harían falta 24 × 12 = 288 repeticiones de los 2400 millones de cálculos elementales, esto es, unas 7 × 1011 operaciones que han de realizarse, con todo su proceso de control de ejecución y generación de resultados en formatos comprensibles en bastante menos de las 24 horas de la predicción. Lo anterior nos muestra de nuevo que es razonable pensar en que por sí solos los modelos numéricos bien merecen ser considerados una categoría nueva, separada de las otras clases de modelos predictivos. Dado que el análisis interno de los modelos numéricos se lleva a cabo de nuevo con técnicas matemáticas, existen matemáticos y expertos en computación cuya tarea es el estudio de esta clase de modelos como si fuesen una nueva clase de fenómenos físicos (o tecnológicos). 5 Los resultados o output de los modelos numéricos se analizan de nuevo con ayuda de los métodos estadísticos tradicionales para comparar su desempeño en situaciones conocidas (simulación) y así ser utilizados después, ya de modo efectivo, en la realización de predicciones. Los Modelos de la Climatología Las características esenciales de los modelos utilizados por los grandes institutos y agencias dedicados a la Climatología son las siguientes: • En principio, utilizan las mismas ecuaciones dinámicas que los modelos meteorológicos, pero para variables promediadas espacial y temporalmente. • Suelen extenderse espacialmente al menos a un hemisferio terrestre. • Están estructurados en submodelos, uno para cada característica que se estime conveniente incluir: 1. Submodelo atmosférico 2. Submodelo oceánico 3. Submodelo de casquetes polares 4. Submodelo de asimilación de datos 5. Otros… • En función de cómo se consideren las partes atmosférica y oceánica, las dos grandes divisiones son 1. Modelo combinado de circulación general atmosférica (AGCM) con un modelo más sencillo de océano, por lo general de orden cero (sin derivadas). Sobre este punto volveremos algo más adelante. 2. Modelo de doble circulación general, tanto atmosférica como oceánica (AGCM + OGCM). 3. También existe el punto de vista de que la Climatología es una cuestión puramente oceánica, siendo la atmósfera un simple sistema esclavo del océano, lo cual llevaría a contemplar modelos del tipo OGCM acoplados a modelos muy sencillos de atmósfera, como el tipo 1 pero al revés. Aquí no entraremos en los detalles de los diversos modelos. Baste saber que prácticamente cada servicio meteorológico y climático posee el suyo, o un conjunto de ellos. Pero sí presentaremos algunas ideas acerca de cómo se trabaja con ellos. La técnica de trabajo presenta las siguientes etapas típicas: • • • Establecido el modelo, se plantea un escenario inicial, esto es, el conjunto de condiciones iniciales para lanzarlo. Algunas de las características del escenario inicial pueden ser variables de carácter exógeno, con variaciones en principio independientes de las de las variables típicamente climáticas. Tal es el caso de los gases de efecto invernadero: Para ellos se puede considerar que evolucionan según el protocolo de Kioto, o no. Esta evolución es incorporada a lo largo de la simulación, con lo cual el modelo correrá de diferente manera y ofrecerá diferentes proyecciones o escenarios futuros como resultado. Con los mismos escenarios iniciales, se cambia un modelo por otro y se comparan los resultados de ambos. Existen estudios de comparación de hasta 15 ó veinte modelos simulando a partir de las mismas condiciones iniciales, y no siempre generan los mismos escenarios para el futuro. 6 • • Se utiliza el submodelo o módulo de asimilación de datos para ir variando las entradas al modelo general según éste va corriendo, con lo cual se puede ir alargando el horizonte de predicción. Como producto final se suele ofrecer un abanico de posibles futuros promediados obtenidos a partir de una selección de modelos y de escenarios iniciales. La utilidad que se le pueda dar a estos productos finales dependerá de los gestores ambientales, que son quienes tienen el poder de tomar decisiones en cuestiones de tanta importancia como la limitación de emisiones de gases de efecto invernadero, su cuantificación en términos de externalidades económicas, o el establecimiento de mercados de derechos de emisión, etc. Algo más sobre modelos mixtos GCM+conceptual Abandonando el campo de la política y restringiendo nuestro estudio a algunos aspectos puramente científicos, existen en la actualidad dos tendencias en la profundización de la comprensión del clima y sus variaciones: • • Usar modelos numéricos, cuanto más sofisticados y potentes, mejor…, pero plantean el problema de que la imprecisión de las condiciones suplementarias dificulta o impide la predicción. Como ya hemos dicho antes, el proceso de asimilación de datos ayuda a paliar este problema. Por ello se tiende, al menos en una primera etapa, y a modo de guía preliminar, a combinar modelos numéricos con modelos conceptuales. Esta filosofía se utiliza esencialmente, para hacer más cómoda la predicción. Por ejemplo, un modelo global del tipo AGCM+OCGM es mucho más complicado de controlar, matemáticamente hablando, que un modelo mixto AGCM+conceptual u OGCM+conceptual, y puede ocurrir que las predicciones sean de igual calidad con un coste, tanto computacional como económico, mucho menor. Vamos a comentar un modelo conceptual que puede transformarse en diferentes modelos mixtos: El modelo de Bretherton y Battisti para la NAO (North Atlantic Oscillation, Oscilación del Atlántico Norte), presentado el año 2000 (Modelo BB2000). Véase Bretherton & Battisti 2000. Las ecuaciones del modelo son las siguientes, a las que hay que añadir condiciones iniciales (SST: Sea Surface Temperatura, temperatura superficial del mar), donde ε es un parámetro pequeño para indicar que la variación de la SST es lenta con relación a las variaciones atmosféricas: dNAO = − aNAO + bSST + R (0,1) dt dSST = ε [cNAO − dSST ] dt Un breve análisis de este modelo nos dice lo siguiente: • BB2000 no presenta, a priori, capacidades predictivas a plazo superior a unos pocos meses, debido a que la SST está determinada por el ruido atmosférico 7 • • • Sin embargo, los experimentos muestran que reproduce bastante bien las características básicas descritas por modelos más complejos. Sin el término de ruido R (0,1) el sistema es lineal, sus elementos básicos son la b ⎤ ⎡− a traza y el determinante de la matriz ⎢ ⎥ . Para valores adecuados de los ⎣ εc − εd ⎦ parámetros se consigue que el origen sea estable, bajo las condiciones: Det = ε ( ad − bc ) > 0 y Traza = −( a + εd ) < 0 . Pero la introducción del término ruidoso cambia la estabilidad del origen, originando oscilaciones. En términos matemáticos, se ha producido una bifurcación de Hopf estocástica (Banerjee et al. 2000) Vemos aquí la NAO (azul, más abrupta) y la SST (roja, más lisa) asociada a ella según el modelo BB2000 1: NAO 1: 2: 2: SST 3 0 2 1 1: 2: 2 1 0 2 1 1 1 2 1: 2: -2 -0 0.00 45.00 Page 1 90.00 Time 135.00 180.00 NAO (azul) y SST Figura 1: NAO y SST según BB2000 (realizada con STELLA). donde hemos utilizado la siguiente realización de ruido blanco Gaussiano N (0,1) : 1: Ruido 1: 4 1 1: 1 1 1 1 1: Page 1 -3 0.00 45.00 90.00 Time 135.00 180.00 Realización del ruido blanco Figura 2: Realización de ruido utilizada en la obtención de la Figura 1 (realizada con STELLA). 8 Se observa la pauta general de que una de las señales sigue a la otra con un ligero retardo. Ello indica que si se conoce una de ellas, obtenida por ejemplo a partir de un modelo AGCM u OGCM, se podrá utilizar para predecir la otra. Como siempre, quedará abierto el problema de cuál es la causa y cuál es el efecto. Por tanto, los experimentos realizados a partir del modelo BB2000 han sido: • • • • Experimentos sólo con BB2000 Acoplar la parte SST con un AGCM Acoplar la parte NAO con un OGCM Aplicar las técnicas de análisis de datos a los outputs de estas combinaciones Por ejemplo, los experimentos sólo con BB2000 llevan la siguiente pauta: 1. 2. 3. 4. Generar una solución y guardar la SST resultante. Resolver la parte NAO de BB2000 varias veces con la SST anterior fijada Promediar los resultados obtenidos Calcular la correlación entre esta NAO media y la SST Los experimentos mixtos serán, pues, de dos tipos: El primero, utilizar la señal generada de SST por BB2000 como si fuera un dato observacional y alimentar con ella el modelo AGCM para calcular la NAO; el segundo, usar la señal NAO generada por BB2000 como entrada al modelo OGCM que nos dará la SST. Pueden verse resultados de estos experimentos en Eden & Greatbatch 2003. Conclusiones Las conclusiones científicas de esta ponencia son tres, muy simples: • • • La predicción climática es inseparable de la formulación de modelos. No siempre los modelos más complicados son los mejores, si no se someten a comparación con modelos simples que todavía conservan las ideas físicas primitivas. Queda un inmenso esfuerzo por hacer en la comprensión de la complejidad del sistema climático, de las fuerzas que lo impulsan y de las posibles perturbaciones a que se halla sometido y que pueden modificar drásticamente su comportamiento futuro. Referencias Banerjee S, Bhattacharya R, Chakrabarti C (2000) Shift of bifurcation point due to noise induced parameter, Int. J. Math.& Math. Sci. 23(6), pp.435-439. Bretherton C, Battisti D (2000) An interpretation of the results from atmospheric general circulation models forced by the time history of the observed SST distribution, Geophys. Res. Letters 27(6), pp. 767-770. Caldeira R, Fernández I & Pacheco J (2006) On NAO's predictability through the DFA method. Meteorology and Atmospheric Physics. Online: 15 Nov 2006. 9 Eden C, Greatbatch R (2003) A damped decadal oscillation in the North Atlantic Climate System, J. Climate 16, pp.4043-4060. Fernández I, Hernández C, Pacheco J (2003) Is the NAO just a pink noise? , Physica A 323, pp.705-716. Fernández I, Pacheco J (2000) Bases para la predicción de ENSO, In E. Hernández and R. García, (eds) El Niño, climatología, efectos y predicción, (93-131), Universidad Complutense and Fundación MAPFRE. Gimeno L, García R, Pacheco J, Hernández E, Ribera P (2001) Predictability of global surface temperature by means of nonlinear analysis, Earth & Planetary Science Letters 184, pp. 561-565. Pacheco J, Hayek N (1997) Climate, Mathematics, and the Canary Islands. In Díaz, J.I. (ed) The Mathematics of Models for Climatology and Environment (411-418), Springer Verlag (NATO ASI Series I, Nº 48). 10