Maestría en Bioinformática Probabilidad y Estadística: Clase 10

Anuncio

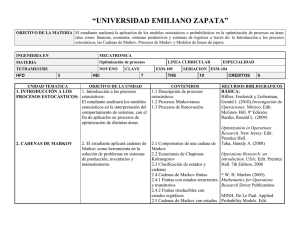

Procesos aleatorios en tiempo continuo Cadenas de Markov en tiempo continuo Maestrı́a en Bioinformática Probabilidad y Estadı́stica: Clase 10 Gustavo Guerberoff [email protected] Facultad de Ingenierı́a Universidad de la República Mayo de 2010 Procesos aleatorios en tiempo continuo Cadenas de Markov en tiempo continuo Contenidos 1 Procesos aleatorios en tiempo continuo Procesos puntuales Proceso de Poisson homogéneo 1 Cadenas de Markov en tiempo continuo Matrices de transición Propiedades del semigrupo de transiciones Matriz de tasas de cambio Procesos aleatorios en tiempo continuo Cadenas de Markov en tiempo continuo Procesos aleatorios en tiempo continuo Consideraremos en estas clases procesos aleatorios en tiempo continuo. Recordemos que, en general, un proceso aleatorio en tiempo continuo, con espacio de estados E, es una familia de variables aleatorias, {X (t) : t ≥ 0}, donde X (t) ∈ E para cada t ≥ 0. Antes de introducir las cadenas de Markov en tiempo continuo veamos algunos conceptos previos. Procesos aleatorios en tiempo continuo Cadenas de Markov en tiempo continuo Definición Un proceso puntual aleatorio es una sucesión de variables aleatorias no negativas, T0 , T1 , T2 , . . . , Tn , . . ., tales que (con probabilidad 1) se cumple: i) T0 = 0, ii) 0 < T1 < T2 < T3 < . . ., iii) lı́mn→∞ Tn = ∞. A partir de un proceso puntual se construyen las siguientes cantidades de interés: Para cada n ≥ 1 se define: Sn = Tn − Tn−1 ; estas son las distancias inter-arribos. Procesos aleatorios en tiempo continuo Cadenas de Markov en tiempo continuo Para cada intervalo (a, b] se define la variable: N(a, b] = cantidad de puntos en el intervalo (a, b]. Para cada t ≥ 0 se define: N(t) = N(0, t]. Observación: Notar que N(0) = 0 y que N(a, b] = N(b) − N(a). El proceso de tiempo continuo {N(t) : t ≥ 0} es el proceso de conteo asociado al proceso puntual. De todos los procesos puntuales hay uno que se destaca por su importancia. Procesos aleatorios en tiempo continuo Cadenas de Markov en tiempo continuo Proceso de Poisson homogéneo Definición Un proceso puntual es un proceso de Poisson homogéneo de tasa λ si: i) Las variables aleatorias N(ti , ti+1 ] son independientes, para cualquier conjunto de tiempos 0 ≤ t1 ≤ t2 < . . . ≤ tk . ii) Para cada intervalo (a, b] la variable N(a, b] es una variable de Poisson de parámetro λ(b − a). Por lo tanto: P(N(a, b] = k) = [λ(b − a)]k −λ(b−a) e , k! para cada k ≥ 0. Procesos aleatorios en tiempo continuo Cadenas de Markov en tiempo continuo Además: E(N(a, b]) = λ(b − a); de manera que el parámetro λ representa el número medio de puntos del proceso por unidad de tiempo. Procesos aleatorios en tiempo continuo Cadenas de Markov en tiempo continuo Cadenas de Markov en tiempo continuo En lo que sigue consideramos un espacio de estados E finito o numerable. Un proceso en tiempo continuo queda caracterizado por la familia de probabilidades: P(X (t1 ) = i1 , X (t2 ) = i2 , . . . , X (tk ) = ik ), para cada conjunto de tiempos t1 , t2 , . . . , tk ≥ 0 y estados i1 , i2 , . . . , ik ∈ E. Una clase muy importante de procesos son aquellos que cumplen la siguiente condición: Procesos aleatorios en tiempo continuo Cadenas de Markov en tiempo continuo Condición de Markov P(X (t + s) = j | X (s) = i, X (sk ) = ik , . . . , X (s1 ) = i1 ) = P(X (t + s) = j|X (s) = i), para todos los valores de i, j, i1 , . . . , ik ∈ E, t, s ≥ 0, 0 ≤ s1 ≤ s2 . . . ≤ sk ≤ s. Los procesos que cumplen esta condición se llaman cadenas de Markov en tiempo continuo. Si las probabilidades de transición P(X (t + s) = j|X (s) = i) no dependen de s decimos que la cadena es homogénea. En tal caso denotamos, para cada t ≥ 0: pij (t) = P(X (t + s) = j|X (s) = i) = P(X (t) = j|X (0) = i). Procesos aleatorios en tiempo continuo Cadenas de Markov en tiempo continuo Matrices de transición Supongamos, para simplificar, que el espacio de estados es E = {1, 2, . . . , r }. Agrupando las cantidades {pij (t)} en una matriz obtenemos, para cada t ≥ 0, la matriz de transición de la cadena de Markov: Matrices de transición Para cada t ≥ 0: P(t) = p11 (t) p12 (t) ... p1r (t) p21 (t) p22 (t) ... p2r (t) . . . . . . . . pr 1 (t) pr 2 (t) ... prr (t) La familia de matrices {P(t) : t ≥ 0} se llama el semigrupo de transiciones. Procesos aleatorios en tiempo continuo Cadenas de Markov en tiempo continuo Observación: A diferencia de lo que ocurre con las cadenas de Markov en tiempo discreto, en las que se especifican para cada problema las matrices de transición, en el contexto de cadenas de Markov en tiempo continuo hay que calcular, para cada proceso, P(t) como función de t. Ejemplo: Proceso Flip-Flop Consideremos un proceso de Poisson de tasa λ. A partir del proceso de conteo introducido anteriormente se define el proceso flip-flop, {X (t) : t ≥ 0}, con espacio de estados E = {1, −1}, de la siguiente manera: X (t) = X (0)(−1)N(t) , donde X (0) es una variable aleatoria que representa el estado inicial. Procesos aleatorios en tiempo continuo Cadenas de Markov en tiempo continuo Para calcular la matriz P(t) en este ejemplo observemos que el estado X (t + s) se obtiene a partir de X (s) y de N(s, s + t]. Se tiene: P(X (t + s) = 1|X (s) = −1) = P(X (t + s) = −1|X (s) = 1) = P(N(s, s + t] sea impar ) 1 (1 − e−2λt ), = 2 y, de manera análoga: P(X (t + s) = 1|X (s) = 1) = P(X (t + s) = −1|X (s) = −1) = P(N(s, s + t] sea par ) 1 = (1 + e−2λt ). 2 Procesos aleatorios en tiempo continuo Cadenas de Markov en tiempo continuo De manera que, para cada t ≥ 0: 1 −2λt ) 2 (1 + e P(t) = 1 −2λt ) 2 (1 − e 1 2 (1 1 2 (1 − e−2λt ) + e−2λt ) . Propiedades La familia de matrices {P(t) : t ≥ 0} cumple las siguientes propiedades: Para cada t ≥ 0, P(t) es una matriz estocástica. P(0) = I. Para cada t, s ≥ 0 se cumple: P(t + s) = P(t)P(s). Procesos aleatorios en tiempo continuo Cadenas de Markov en tiempo continuo Condición de continuidad: En nuestro curso consideraremos procesos continuos, esto es, que cumplen la condición: lı́m P(h) = P(0) = I. h→0 Puede probarse que esta condición implica la siguiente: lı́m pij (t + h) = pij (t), h→0 para cada t ≥ 0 y para cada i, j ∈ E. Veremos más adelante cómo calcular {P(t) : t ≥ 0} para cada proceso. Observación: Una vez que se conoce la familia de matrices {P(t) : t ≥ 0} y un estado inicial π(0), el proceso queda completamente especificado. Procesos aleatorios en tiempo continuo Cadenas de Markov en tiempo continuo Si π(t) = (P(X (t) = 1), P(X (t) = 2), . . . , P(X (t) = r )) denota el estado del proceso al tiempo t, entonces: π(t) = π(0)P(t). Para calcular la probabilidad de cualquier trayectoria se procede de la siguiente manera: P(X (t0 ) = i0 , X (t1 ) = i1 , X (t2 ) = i2 ) = πi0 (t0 ) pi0 i1 (t1 −t0 ) pi1 i2 (t2 −t1 ). Procesos aleatorios en tiempo continuo Cadenas de Markov en tiempo continuo A partir de las propiedades de {P(t) : t ≥ 0} se prueba el siguiente resultado válido para procesos continuos: Teorema i) Para cada par de estados i 6= j existe: qij = dpij pij (h) (0) = lı́m , dt h h→0 y además qij ≥ 0. ii) Para cada estado i ∈ E existe: qii = y además qii ≤ 0. dpii p (h) − 1 (0) = lı́m ii , dt h h→0 Procesos aleatorios en tiempo continuo Cadenas de Markov en tiempo continuo Notación: Para cada estado i ∈ E denotamos: qi = −qii . De manera que qi ≥ 0. Observación: Supongamos que el espacio de estados E es finito. Para cada t ≥ 0 se cumple: X pij (t) = 1. j∈E Derivando a ambos lados de esa igualdad y evaluando la derivada en t = 0 se obtiene: X qij = 0. j∈E Esto es, para cada i ∈ E: qi = X j∈E:j6=i qij . Procesos aleatorios en tiempo continuo Cadenas de Markov en tiempo continuo Observación: Notar que para i 6= j y h ' 0 se tiene: P(X (t + h) = j|X (t) = i) = qij h + o(h); de manera que el parámetro qij puede interpretarse como la tasa (o la velocidad) de cambio del estado i al j. Estos parámetros se agrupan en una matriz formando la matriz de tasas de cambio o generador infinitesimal del proceso. Matriz de tasas de cambio Consideremos E = {1, 2, . . . , r }. La matriz de tasas de cambio se define de la siguiente manera: q11 q12 ... q1r q21 q22 ... q2r . . . . A= . . . . qr 1 qr 2 ... qrr Procesos aleatorios en tiempo continuo Cadenas de Markov en tiempo continuo Observemos que las filas de esta matriz suman 0. Cada proceso queda caracterizado por la matriz de tasas de cambio. Más adelante veremos cómo calcular P(t) a partir de A. Ejemplo: Usando la igualdad A = P 0 (0) se obtiene la matriz de tasas de cambio para el proceso Flip-Flop: −λ λ A= . λ −λ