- Ninguna Categoria

Processat del senyal

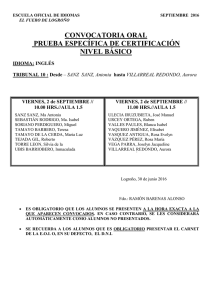

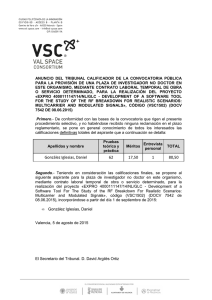

Anuncio

Processat del senyal

Jesús Sanz Marcos Introducció

Temari

Introducció

Introducció

Objectius

Notació matricial

Processos estocà stics

Estimació de paràmetres

Objectius

Estimació espectral

Densitat espectral de potència

Estimació de la densitat espectral de potència

Estimació espectral paramètrica (model autoregressiu)

Estimació lineal i predicció

Estimació lineal quadrà tic-mitjana

Filtre de Wiener. Aplicacions

Predicció lineal. Tècnica estimació paràmetres

Compressió de la parla: tècniques paramètriques

Filtres adaptatius

Mètode del gradient. Propietats

Estimació adaptativa. Algorisme LMS

Codificació diferencial adaptativa

Processat d’arrays de sensors

Processament i compressió de senyals 2D

Sistemes i senyals en 2D

Compressió d’imatge: tècniques predictives.

Mètodes transformats

Compressió d’imatges fixes.

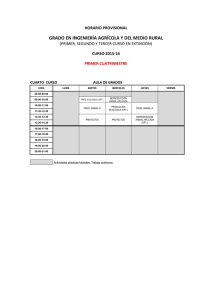

Professorat i avaluació

Professor:

Albert Oliveras D5213 Dill: 09:30-12:00 Dij: 16:00-19:00

1r control:

2n control:

Ex. Final:

Nota:

7/10 Abril

19/22 Maig

26 de Juny

max{E.F, 0.6E.F.+0.2P1+0.2P2}

“Estudi de les tècniques i algorismes de processat digital del senyal, enfocat a

aplicacions en comunicacions i tractament d’imatge i veu”

Aplicacions

§

§

§

§

Anà lisi espectral

Caracterització paramètrica del senyal

Filtrat adaptatiu

Codificació i compressió de la imatge

Notació matricial

x(n) : seqüència

x(0)

x : vector =

M

x( N − 1)

x = x (0) L x( N − 1)

T

hH x =

N −1

∑ h * (n ) x ( n )

n= 0

|| x || 2 =

N −1

∑ | x( n ) | = x

2

n =0

x : matriu

desigualtat de Schwartz

| h H x |2 ≤|| h || 2 || x || 2

Coherència

| h H x |2

| γ |2 =

≤1

|| h ||2 || x || 2

Run-time vector

sii h(n) = αx (n) ⇒ igualtat

sii h(n) = αx(n) ⇒ γ = 1

X n T = [x (n), x(n − 1),..., x(n − Q + 1)]

H

x

1

Processat del senyal

Jesús Sanz Marcos Introducció

Autocorrelació

Distància entre senyals

Dxy =

N −1

∑ | x(n) − y(n) | = (x − y)

2

H

( x − y ) =|| x || 2 + || y || 2 − x H y − y H x

n= 0

Autocorrelació de x(n)

1

1

r (m) =

x * (n − m) x (n) =

M n

M

∑

∑ x * (n) x(n + m)

n

∑

Q −1

y ( n) =

∑ h ( q ) x( n − q ) = h

H

L x(Q − 1)

L x(Q − 2)

O

M

L

x(0)

L x ( N − 1)

0

L x ( N − 2)

x ( N − 1)

O

M

M

L x( N − Q ) x ( N − Q + 1)

y = hH X

Matriu de correlació a partir de X n

r (1)

r (0)

r (−1)

r

(0)

1

R=

X n X n* ≅

M n

M

M

r (−Q + 1) r (−Q + 2)

Filtrat

*

x (0) x(1)

0

x (0)

X =

M

M

0

0

· x n = h(0)

q =0

*

L r (Q − 1)

L r (Q − 2)

O

M

L

r (0)

x (0)

L h (Q − 1)

M

x (Q − 1)

*

Sinus en soroll i el lema de la inversa

s (n) = A0 e j ( 2πf 0 n +θ ) = Ae j 2πf 0 n

1

− j 2πf 0

e

= Ae j 2πf 0 n S 0

S n = Ae j 2πf 0 n

M

− j 2πf 0 (Q −1)

e

1

H

2

R0 =

S n S n =| A | S o S oH

M n

∑

y (n) = s (n) + w(n)

| y (n) | = h X n X h

1

ry (0) =

| y (n) |2 =h H R h

M n

Si existeixen M<Q sinus ortogonals, existiran M termes iguals.

ry (0) ≤ 0

R=

2

H

H

n

H

R =| A | 2 S 0 S 0 + σ 2 I

∑

M

∑| A

m

|2 S m S m H + σ 2 I = R S + σ 2 I

m ) =1

Transitori

x(n), N mostres h(n), Q mostres (filtre FIR)

y T (n) = y (0), y (1),K, y (Q − 1), y (Q), , K, y ( N − 1), y ( N ),K, y ( N + Q − 1)

42444

3 144424443

144424443 144

règim transitor i N-Q mostres

post − transitori Q mostres

pre - transitori Q mostres

E y = y H y = yT y*

Py =

1 H

1

y y = hH

XXHh

M

M

Lema de la inversa

si R = GG H + R a ⇒

R −1 = R a −1 − R −a1 G ( I + G H R −a1 G ) −1 G H R −a1

L

0

L

0

O

0

L x( N − 1)

2

Processat del senyal

Minimització amb restriccions

Disseny de filtres o sistemes pot formular-se sempre com a minimització d’una funció

objectius, subjecta a restriccions. Per processos gaussians i sistemes lineals, aquesta

funció és l’error quadrà tic mig (MSE).

MSE = ξ = a H C a

restriccions: Φ a = f

Jesús Sanz Marcos Introducció

Valors singulars

dim{R} = QxQ

R=XXH

dim{X } = QxN

Q

X=

∑φ u

q

q vq

H

=[u1

q =1

MSEmin = f H (ΦC −1 Φ H ) −1 f amb a = C −1 Φ H (ΦC −1 Φ H ) −1 f

Autovalors i autovectors

R e q = λq e q

e q : autovector

λq : autovalor

Per ser R hermítica (dim QxQ) existeixen Q autovectors diferents que permeten fer la

descomposició següent:

λ1 L 0 e1 H

Q

R=

λq e q e q H =[e1 L e Q ] M O M M = E D E H

q =1

0 L λq e Q H

∑

I = EH E = EEH

Propietats

• Si la matriu és definida positiva, tots els seus autovalors ho són.

• Si la matriu R és de rang M<Q, el número d’autovalors zero és Q-M

• El determinant de la matriu R és el producte dels seus autovalors, i la seva traça

és la suma dels autovalors.

•

ln{R} = E ln{D}E H

•

e{R} = Ee{D} E H

•

Rm = EDm E H

•

R −1 = E D −1 E H

φ1

M

0

L u Q ]

0

M

0

L

O

L

L

O

L

0

M H

v1

φq

M = U ΦV H

0 H

vN

M

0

I = QH Q = V H V

( X X H )u q = φ q2 u q , q = 1..Q

R = U Φ 2 U H = U DU H

φ 2 v

( X H X )v q = q q

0

q = 1..Q

q = Q + 1...N

3

Processat del senyal

Jesús Sanz Marcos Introducció

Sistemas adaptativos

H

H

H

H

ξ = ξ min + a~ n ( E Λ E )a~ n = ξ min + z n Λ z n = ξ min + ∑ λi | zn (i ) |2

Introducción

z n = E (a n − a opt )

Q

i =1

H

Los diseños óptimos dan lugar a degradación de las prestaciones

cuando las condiciones del escenario cambian.

Diseño y convergencia de algoritmos del gradiente

De este modo, cuando un sistema de tratamiento de señal es capaz

de adaptarse automáticamente al entorno de señal, se dice que es

adaptativo.

Amplificador : d (n) = g (n) x(n)

En el sistema de apredizaje, se dispone de la señal de

referencia r(n), o simplemente de su potencia Pr, basta pues

calcular la potencia de la señal de salida según:

a n+1 = a n − µ ∇ξ n = a n − µ ( R a n − P)

µ<

2

2

<

Traza{R} λmax

µ=

2α

Px (n)

2,30

2,30

2,30 λmax

=

≈

− ln(1 − µλmin ) − ln(1 − 2 λmin )

2α λmin

α

λmax

ε (n) = Pr − Pd (n)

g (n + 1) = g (n) + µε (n)

Nc =

MSE y métodos del gradiente

TN c =

X n : vector de datos

H

Usualmente se establece un umbral mínimo Pxo .

Pd (n) = βPd (n − 1) + (1 − β )d 2 (n)

d (n) : señal de referecia

a n : respuesta impulsional el filtro FIR

Px (n + 1) = βPx (n) + (1 − β ) X n X n

1

: número de muestras de la memoria

1− β

2

H

MSE = ξ (a n ) = E d (n) − a n X n

2,30 Ps 2,30

Q

=

QSNR

2α

Pw

2α

El algoritmo LMS (Least Mean Square algorithm)

y (n) = a H X n

ξ (a n ) = Pd + a n R a n − a n P − P a n

ε (n) = d ∗ (n) − y ∗ (n)

∂ξ (a n )

= ∇ξ = R a opt − P = 0 ⇒ a opt = R −1 P

∂ a Hn

a n+1 = a n + µ X nε ∗ (n)

H

H

H

ξ (a n ) = ξ min + (a n − a opt ) H R (a n − a opt )

ξ min = Pd − P R P

H

∇ξ (a~ n ) = R a~ n

H

ξ (a~ n ) = ξ min + a~ n R a~ n

2

X nH X n

E{a n } = a opt

a~ n = a n − a opt : error de coeficientes

a~ = a~ − µε ∗ (n) X

n +1

a n+1 = a n − µ∇ξ (a n )

µ<

n

n

d (n) = w(n) + a opt X n

ε (n) = w(n) − a~ H X

H

opt

n

4

Processat del senyal

µ

H

Σ a = E{a~ opt a~ opt

} ≅ ξ min I : covarianza delos coeficientes

2

ξ (n) = ξ + a~ H R a~

min

n

n

µ

E{a~ nH R a~ n } = ξ minTraza{R}

2

E{ξ (n)} − ξ min

100% : exceso de error

ℵ≡

ξ min

µ

Traza{R}

2

2α

µ=

Px (n)

ℵ=

α : ruido de desajuste (i.e. α = 0.1 ⇒ ℵ = 10%)

Jesús Sanz Marcos Introducció

δ2

2

δ2

ξ n (q,+δ ) = ξ n + ξ n' δ + ξ n''

2

'' 2

2

ξδ

δ rxx (0)

γ = n =

ξ min

ξ min

ξ n (q,−δ ) = ξ n − ξ n' δ + ξ n''

2

3 µQξ min δ Traza{R}

+

4 Mδ 2

Qξ min

2α

µ=

Traza{R}

ℵtotal =

2

=

δ opt

Conclusiones:

•

•

•

•

Probar convergencia al óptimo

Analizar la velocidad de convergencia

En la fase de seguimiento, se ha de determinar el ruido de

desajuste o lo que es lo mismo, su velocidad de seguimiento o

capacidad de reacción a cambios.

A altas velocidades de convergencia (o aprendizaje rápido)

implican desajustes elevados.

Hay un compromiso entre desajuste y velocidad de

convergencia.

2

3 Q 2αξ min

2 MTraza 2 {R}

ℵtotal optimo

6α

=

M

γ =

5

δ 2Traza{R}

Qξ min

ξ n (q, δ ) =

1

M

n+ M −1

∑ | e( n ) |

2

n

Ventajas

•

Desajuste disminuye con la

raiz cuadrada del número

de términos empleados en

la estimación del MSE.

•

No es necesario el vector

de datos

Desventaja:

• Se requieren 2MQ vectores

por cada iteración.

Algoritmo LRS (Linear Random Search)

Para cada instance n,

•

Generar un vector aleatorio con distribución uniforme en sus

componentes δ n .

•

Actualizar los pesos como: a n+1 = a n +

•

Calcular el nuevo error usando M vectores de datos ξ n+1

•

a ξ n +1 > ξ n

a n+1 = n

a n+1 otherwise

∇ n (q) =

•

n++;

a n+1

ℵ=

µQσ δ2

2M

•

DSD y métodos de búsqueda aleatoria

DSD (Differential Steepest Descent), calcula el gradiente

independientemente para cada coeficiente del filtro.

ξ n (q, δ ) + ξ n (q − δ )

2δ

µ

= a n − ∇n

2

Algoritmo GRS (Guided Random Search)

µ

δ

2 n

Processat del senyal

Jesús Sanz Marcos Introducció

Igual que LRS pero se diferencia en que cuando se encuentra una

perturbación que hace disminuir el error, se avanza en esa

dirección incrementado la µ hasta que el error empeora y

entonces µ = µ básico y se busca un vector de perturbaciones

aleatorio ortogonal al presente.

Algoritmo RLS (Recursive Least Squares)

MSE (n) = βMSE(n − 1) + (1 − β ) | ε (n) |2

R n+1 = β R n + (1 − β ) X n X n

H

P n+1 = β P + (1 − β ) X n d ∗ (n)

a n+1 = R −n1+1 P n+1

M =

1

: número de datos de la señal de entrada

1− β

−1

instante n: datos a n , d (n), X n , R n

•

y (n) = a nH X n

ε (n) = d (n) − y (n)

•

φ = α X n R n X n ,α =

•

Kn =

•

a n+1 = a n + K n ε ∗ (n)

1 −1

−1

H 1+ φ

Rn = Rn − K n K n

β

1− β

n + +;

•

•

•

(

H

−1

−1

α Rn X n

1+φ

)

1− β

β

: vectr ganancia

6

Processat del senyal

Jesús Sanz Marcos Introducció

Introduction

Disecrete-Time Sinusoidal

x(n) = a cos(ωn + θ ),−∞ < n < +∞

ω = 2πf

x(n) periodic ⇔ x (n) = x( N + n) ⇔ f ∈ Q

2πf 0 n = 2kπ

k

f0 =

N

cos(ωn + θ ) = cos(( 2πk + ω )n + θ ) = cos(ω k n + θ ),ω k = ω + 2πk

1

maximum oscillation ⇒ ω = ±π , f = ± ⇒ x(n) = {+1,−1,+1,−1,+1,...}

2

Sampling of analog signals

x(n) = xa (nT )

t = nT =

n

Fm

F

: normalized frequency

f =

Fm

ω = ΩT

Continious-time signals

Ω radians / sec = 2πFHz

−∞ < Ω < +∞

− ∞ < F < +∞

Discrete-time signals

ω radians/ sample = 2πf cycles / sample

−π ≤ ω ≤ +π

1

1

− ≤ f ≤+

2

2

Fmax = B and the signal is sampled at a rate Fs > 2 Fmax ≡ 2 B , then

xa (t ) can be exactly recovered from its sample values.

Quantization

eq (n) = xq (n) − x(n)

∆

2

xmax − xmin

∆=

L −1

Discrete-Time Signals and Systems

Elementary signals

1 n = 0

δ (n) ≡

0 n ≠ 0

1

u (n) ≡

0

n

u r (n) ≡

0

unit sample sequence, unit impulse

n≥0

n<0

unit step signal

n≥0

unit ramp signal

n<0

x(n) = a n = (re jθ ) n = r n (cos θn + j sinθn )

Sampling Theorem

If the highest frequency contained in an analog signal xa (t ) is

xq (n) = Q{x(n)}

∆2

2

12 P = A / 3 ⇒ SNQR = 3 2 2b , SNQR = 1.76 + 6.02b

q

dB

2 2b

2

2A

∆= b

2

Pq =

Classification of signals

•

E≡

+∞

∑ | x( n ) |

2

0 < E < ∞ ⇒ x(n) is an energy signal

n= −∞

+N

1

| x ( n) | 2

∑

N →+∞ 2 N + 1

n =− N

•

P ≡ lim

•

periodic signal ⇒ power signal

•

x(n) = x (−n) ⇒ even signal

x(n) = − x (−n) ⇒ odd signal

| eq (n) |≤

Quantization of sinusoidal signals

exponential signal

Discrete-time systems

0 < P < ∞ ⇒ x(n) is a power signal

1

( x(n) + x(−n))

2

1

xo (n) = ( x (n) − x(−n))

2

xe (n) =

Γ

x(n)

→

y (n)

•

static: y (n) = f {x(n)}

•

dynamic: y (n) = f {x(n), x (n − 1),...} with memory

memoryless

7

Processat del senyal

•

Jesús Sanz Marcos Introducció

Γ

x( n )

→

y (n)

time variant:

Γ

x( n − k )

→

y (n − k )

linear: Γ{a1 x1 (n) + a2 x2 (n)} = a1Γ{x1 (n)} + a2 Γ{x2 (n)}

•

•

•

causal: output only depends on past and present.

Stable: every bounded input produces a bounded output.

Analysys of Discrete-time systems Linear Time-Invariant

N

M

y (n) = −∑ ak y (n − k ) + ∑ bk x (n − k )

k =1

k =0

y ( n) = x ( n ) ∗ h ( n) =

+∞

+∞

k =−∞

k = −∞

∑ h(k ) x(n − k ) = ∑ x(k )h(n − k )

ρ xx (m) =

ρ xy (m) =

rxx (m)

: normalized autocorrelation

rxx (0)

rxy (m)

rxx (0)ryy (0)

Correlation of periodic signals

M

1

1

x (n) y (n − m) =

∑

M →∞ 2 M + 1

N

n =− M

rxy (m) = lim

•

Associative law:

rxy (m) = x(m) ∗ y (−m)

•

Distributive

rxx (m) = x(m) ∗ x (−m)

•

Causal: h(n) = 0∀n < 0

•

Stable:

•

FIR: h(n) = 0∀n < 0 and n ≥ M

+∞

Input-Output correlation sequences

k =−∞

y (n) = x(n) ∗ y (n)

Correlation of signals

+∞

+∞

∑ x(n) y(n − m) = ∑ x(n + m) y(n) = r

yx

n =−∞

∑ | αx(n) + βy (n − m) | = a r

2

xx

(0) + b 2 ryy (0) + 2abrxy (l )

n= −∞

| rxy (m) |≤ E x E y

( − m)

n= −∞

+∞

2

ryx (m) = rxx (m) ∗ h(l )

rxy (m) = rxx (m) ∗ h(−l )

yreceived (n) = αx(n − D) + w(n)

rxy (m) =

n

Convolution realisation of correlation

Commutative law: x(n) ∗ h(n) = h(n) ∗ x (n)

∑ | h(n) |< ∞

N

∑ x ( n) y ( n − m )

y (n) = x(n) + w(n) ⇒ ryy (m) = rxx (m) + rxw (m) + rwx (m) + rww (m)

•

[x(n) ∗ h1 (n)]∗ h2 (n) = x(n) ∗ [h1 (n) ∗ h2 (n)]

law: x(n) ∗ [h1 (n) + h2 (n)] = x(n) ∗ h1 (n) + x (n) * h2 (n)

: normalized crosscorrelation

| rxx (m) |≤ E x

ryy (m) = rxx (m) ∗ rhh (m) = rxx (m) ∗ h(m) ∗ h(−m)

8

Processat del senyal

Jesús Sanz Marcos Introducció

+∞

+∞

−∞

−∞

Frequency Analysis of signals and

systems

S xx ( f ) =| X ( f ) |

Continious-Time signals

Relationship between periodic and aperiodic transform

Jean Baptiste Joseph Fourier (1768-1830)

ck =

E xx =

2

9

2

∫ S xx ( f )df = ∫ | x(t ) | dt

k

1

1

X (kF0 ) =

X( )

Tp

Tp

Tp

Periodic-Signals

+∞

∑c e

x (t ) =

Discrete-Time signals

j 2πkF0t

k

Periodic-Signals

k =−∞

N −1

+∞

Synthesis equations

x(t ) = c0 + 2∑ | ck | cos (2πkF0t + ∠ck )

Synthesis equations

Analysis equations

ck =

1

ck =

Analysis equations

1

Tp

∫ x (t ) e

− j 2πkF0t

Px =

dt

Tp

Px =

+∞

∑ | ck |2 = a02 +

Aperiodic-Signals

bk = 2 | ck | sin ∠ck

Synthesis equations

k = −∞

(

1 +∞ 2

ak + bk2

2∑

k =1

)

G xx ( f ) =

k =−∞

Analysis equations

x (t ) =

j 2πft

∫ X ( f )e df

−∞

+∞

Analysis equations

N −1

N −1

n =0

n =0

E x = ∑ | x( n ) | 2 = N ∑ | ck | 2

1

2π

X (ω ) =

∫ X (ω )e

jωn

dω

2π

+∞

∑ x ( n) e

− jωn

Ex =

π

∑ | x(n) | = 2π ∫ S

2

1

xx

(ω )dω

−π

S (ω ) = S xx (−ω )

S xx (ω ) =| X (ω ) |2 ⇒ xx

∠X (ω ) = −∠X (−ω )

Relationship with Z-transform:

+∞

Synthesis equation

ck = ck + N

n= −∞

+∞

k = −∞

Aperiodic-Signals

2π

x( n ) =

+∞

∑ | ck |2 δ ( f − F0 k )

2π

kn

N

− j kn

1 N −1

x ( n )e N

∑

N n =0

N −1

1 N −1

2

|

x

(

n

)

|

=

| c k |2

∑

N∑

n =0

n= 0

a0 = c0

ak = 2 | ck | cos ∠ck

Power Density Spectrum of Periodic Signals

j

k =0

1

+∞

x(t ) = a0 + ∑ (ak cos (2πkF0t ) + bk sin(2π

x( n ) = ∑ ck e

X (t ) =

− j 2πft

∫ x(t )e dt

X (ω ) = Z {x(n)} | z = e jω

Basic rectangular pulse tranform:

F {u (n) − u (n − L)} = Ae − j (ω / 2 )( L−1)

sin(ωL / 2)

sin(ω / 2)

−∞

Properties of the Fourier Transform for Discrete-Time signals

Power Density Spectrum of aperiodic Signals

Processat del senyal

Jesús Sanz Marcos Introducció

10

F

a1 x1 (n) + a2 x2 (n) ←→

a1 X 1 (ω ) + a2 X 2 (ω )

x(n − k ) ←→ e

F

− jωk

X (ω )

Y (ω ) = X (ω ) H (ω )

| Y (ω ) |=| X (ω ) || H (ω ) |

∠Y (ω ) = ∠X (ω ) + ∠H (ω )

x(−n) ←→ X (−ω )

F

x * (n) ←→ X * (ω *)

dX (ω )

F

nx(n) ←→

j

dω

F

x1 (n) * x2 (n) ←→

X 1 (ω ) X 2 (ω )

F

F

x1 (n) x2 (n) ←→

1

2π

1

2

k = −∞

B (ω )

H (ω ) =

=

A(ω )

∑ bk e − jωk

M

k =0

N

1 + ∑ ak e − jωk

(ω − λ )dλ

= b0

k =1

F

rx1x2 (m) = x1 (m) ∗ x2 (− m) ←→

X 1 (ω ) X 2 (−ω )

F

rxx (m) ←→

S xx (ω )

ryy (m) = rxx (m) ∗ rhh (m)

S yy (ω ) = S xx (ω ) | H (ω ) |2

ryx (m) = rxx (m) ∗ h(m)

S yx (ω ) = S xx (ω ) H (ω )

Random Input signals

F

e jω 0n x(n) ←→

X (ω − ω 0 )

y (n) = x (n) ∗ h(n)

1

( X (ω − ω 0 ) + X (ω + ω 0 ) )

2

1

F

( X (ω − ω 0 ) − X (ω + ω 0 ))

sin (ω 0 n) x(n) ←→

2j

F

cos(ω 0 n) x (n) ←→

+∞

m y ≡ E{ y (n)} = m x

∗

2

n= −∞

+π

1

1

∗

2

+∞

+∞

∑ ∑ h(k )h( j)γ

(ω )dω

xx

( k − j + m)

+∞

γ xx (m) = σ x2δ (m) ⇒ γ yy (m) = σ x2 ∑ h(k )h(k + m)

−π

k = −∞

(AWGN)

+∞

γ yy (0) = Py = σ x2 ∑ | h(k ) |2 = σ x2

F

δ (n) ←→

1

Frequency-Domain LTI Systems

x

k =−∞ j =−∞

Some useful Fourier Transform Pairs

1

sin L + )ω

1 | n |≤ L F

2

x( n ) =

←→

ω

0

|

|

n

>

L

sin

2

ωc

n=0

ω

F

x( n ) = π

←→

∏

sinω c n

2ω c

n≠0

πn

∑ h(k ) = m H (0)

k = −∞

∑ x (n) x (n) = 2π ∫ X (ω ) X

1

+∞

γ yy (m) = E{ y * (n) y (n + m)} =

F

x(n) = u (n)a n ←→

1

1 − ae − jω

k = −∞

Γyy (ω ) =

+∞

∑γ

yy

1/ 2

−1/ 2

(m)e − jωm = Γxx (ω ) | H (ω ) |2

m =−∞

Γyx (ω ) = Γxx (ω ) H (ω )

Frequency-Selective Filters

∫| H( f ) |

2

df

∏ (1 − z e

− jωk

k

| H (ω ) |2 = H (ω ) H (ω )

−π

Parseval’s relation:

− jωn

M

S yy (ω ) = S xx (ω ) | H (ω ) |2

+π

∫ X (λ ) X

+∞

∑ h(n)e

H (ω ) = H ( z ) | z =e jω =

k =1

N

∏ (1 − p e

k

k =1

− jωk

)

)

Processat del senyal

hlp (n) =

sinω cπn

πn

Jesús Sanz Marcos Introducció

H hp (ω ) = H lp (ω − π )

( )

hhp (ω ) = (−1) n hlp (ω ) = e jπ hlp (ω )

n

Notch filters: z1, 2 = e

± jω 0

y (0)

h(0) =

x (0)

, r near ≤ 1

± jω o

All-Pass filters: | H (ω ) |= 1∀ω

Inverse Systems

hI (n) = 0∀n < 0 ⇒ hI (0) =

n

hINV (n) = −∑

k =1

1

h(0)

h(k )hI (n − k )

n ≥1

h(0)

•

| z k |< 1 ∀k ⇒ ∠H (π ) = ∠H (0) minimum phase system

| z k |> 1 ∀k ⇒ ∠H (π ) − ∠H (0) = Mπ maximum phase system

•

otherwise: mixed-phase system

H ( z ) minimum phase ⇒ H −1 ( z ) stable

H ( z ) stable ⇒ H −1 ( z ) minimum phase

H ( z ) non minimum phase = H min ( z ) H all − pass ( z )

B ( z ) B2 ( z −1 )

H min ( z ) = 1

A( z )

A( z )

⇒

, B ( z ) = B1 ( z ) B2 ( z )

H ( z) =

B( z)

H all − pass ( z ) = B2 ( z−1)

B2 ( z )

Deconvolution

(system identification)

h(n) =

S yx (ω ) = H (ω ) S xx (ω )

H (ω ) =

n−1

Comb filters: nulls occur periodically across the frequency band.

•

∑ h(k ) x(n − k )

k =0

Digital resonators: p1, 2 = re

y (n) = x(n) ∗ h(n)

δ (n) = h(n) ∗ hINV (n)

casual n

y (n) = x(n) ∗ h(n) =

y ( n ) − ∑ h ( k ) x( n − k )

k =0

x(0)

,n > 0

S yy (ω )

S xx (ω )

=

S yx (ω )

| X (ω ) |2

11

Processat del senyal

Jesús Sanz Marcos Introducció

Z-Transform

X (z) =

+∞

∑ x( n ) z

M

X (z) =

−n

Region of Convergence(ROC)

N ( z)

=

D( z )

∑b z

−k

∑a z

−k

k

k =0

N

M

=

b0 − M + N ( z − z1 )L ( z − z M )

= Gz N − M

z

a0

(z − p1 )L (z − p N )

k

Finite-Duration Signals

Causal:

z ∈ C − {0}

Infinite-Duration Signals

Causal:

| z |> r2

Anticausal: z ∈ C − {∞}

Anticausal: | z |< r1

z ∈ C − {0, ∞}

Two-sided:

r2 <| z |< r1

Two-sided:

Z

a1 x1 (n) + a2 x2 (n) ←→

a1 X 1 ( z ) + a2 X 2 ( z )

Z

y (n) = x(n) ∗ h(n) ←→

Y ( z) = X ( z )H ( z)

H ( z) =

+∞

Y ( z)

= ∑ h ( n) z − n

X ( z ) n= −∞

M

N

M

k =1

k =0

−k

x(n − k ) ←→ z X ( z )

Z

x(−n) ←→ X ( z )

x1 (n) * x2 (n) ←→ X 1 ( z ) X 2 ( z )

x * (n) ←→ X * ( z*)

1

Z

Re{ x(n)} ←→

( X ( z) + X * ( z*) )

2

1

Z

Im{x (n)} ←→

( X ( z ) − X * ( z*) )

2

dX ( z )

Z

−z

nx(n) ←→

dz

z

1

X 1 (v ) X 2 ( )v −1dv

v

2πj ∫C

if x (n) causal ⇒ x (0) = lim X ( z )

Z

x1 (n) x2 (n) ↔

z →∞

Any H(z)

causality: ⇔ ROC | z |> z1

stability: ⇔ ROC ∈| z |= 1

Rational H(Z)

ROC | z |>| pk |

order{num} ≤ order{denom}

causality ⇔ pk most far away pole

stability: ⇔| pk |< 1∀k

+∞

1

z

x1 (n) x2∗ (n) =

X 1 (v ) X 2∗ ( )v −1dv

∑

∫

C

2πj

v

n= −∞

Basic Z-Transform Pairs

Unilateral Z-Transform

+∞

X( z ) = ∑ x(n) z − n

Z

δ (n) ←→

1

Rational Z-Transforms

1 + ∑ ak z −k

Z

Z

1

Z

u (n) ←→

1 − z −1

1

Z

a n u(n) ←→

1 − az −1

−k

k

k =0

N

Analysis of LTI systems in the Z-domain

−1

Parseval’s relation:

∑b z

k =1

Z

a n x(n) ←→

X (a −1 z )

Z

∑ (z − p )

k =0

y (n) = −∑ ak y (n − k ) + ∑ bk x (n − k ) ⇒ H ( z )

Properties

k

k =0

N

k

k =0

n =−∞

∑ (z − z )

n =0

na n u (n) =

az −1

(1 − az )

−1 2

12

Anuncio

Documentos relacionados

Descargar

Anuncio

Añadir este documento a la recogida (s)

Puede agregar este documento a su colección de estudio (s)

Iniciar sesión Disponible sólo para usuarios autorizadosAñadir a este documento guardado

Puede agregar este documento a su lista guardada

Iniciar sesión Disponible sólo para usuarios autorizados