condiciones de kuhn y tucker aplicaciones a la economia y al

Anuncio

CONDICIONES DE KUHN Y TUCKER

APLICACIONES

A LA ECONOMIA

Y AL MERCADO DE CAPITALES

Bernardello, Alicia Blanca y Vicario, Aldo Omar

Departamento de Matemática

Facultad de Ciencias Económicas de la Universidad de Buenos Aires

Octubre de 2000

1

CONSIDERACIONES PREVIAS

Combinación convexa de vectores

Sea V = { Rn; ⊕; R; • } un espacio vectorial

de n-ésima

dimensión sobre R, siendo ⊕ la suma usual de vectores y • el

producto de un vector por un escalar real.

Y sea S ={ v(1); v(2); v(3);......; v(m)} ⊂ V, se dice que el vector w ∈

V es combinación lineal de los vectores de S ⇔ ∃ ki ∈ R con 1 ≤

m

i ≤ m ∧ i ∈ N / w = ∑ k i v (i )

i =1

Cuando ki ∈ [0; 1]

y

m

∑k

i =1

i

= 1 dicha combinación lineal se

llama combinación convexa.

Conjunto convexo

Un conjunto X ⊂ Rn se llama convexo, si para cualquier par de

elementos x(1); x(2) ∈ X la combinación convexa definida por

ellos está incluida en X:

λ x(1) + ( 1 -λ) x(2) ⊂ X siendo λ ∈ [0; 1]

2

Función convexa

Sea f : X → R con X ⊂ Rn convexo, f es una función convexa

⇔ ∀ x(1); x(2) ∈ X ∧ λ ∈ [0; 1]:

f[λ x(1) + ( 1 - λ) x(2) ] ≤ λ f(x(1)) + ( 1 - λ) f(x(2))

f es estrictamente convexa ⇔ ∀ x(1); x(2) ∈ X ∧ λ ∈ [0; 1]:

f[λ x(1) + ( 1 - λ) x(2) ] < λ f(x(1)) + ( 1 - λ) f(x(2))

Función cóncava

Sea f : X → R con X ⊂ Rn convexo, f es una función cóncava

⇔ ∀ x(1); x(2) ∈ X ∧ λ ∈ [0; 1]:

f[λ x(1) + ( 1 - λ) x(2) ] ≥ λ f(x(1)) + ( 1 - λ) f(x(2))

f es estrictamente cóncava ⇔ ∀ x(1); x(2) ∈ X ∧ λ ∈ [0; 1]:

f[λ x(1) + ( 1 - λ) x(2) ] > λ f(x(1)) + ( 1 - λ) f(x(2))

Como consecuencia de las definiciones se puede probar que:

1) Teorema: a) (función lineal) Si f(x) con x ∈ Rn es una

función lineal, entonces es una función cóncava así como

una función convexa, pero no estrictamente.

3

2) Teorema: b) (función opuesta) Si f(x) con x ∈ Rn es una

función cóncava, entonces –f(x)es una función convexa, y

viceversa.

Análogamente: Si f(x) con x ∈ Rn es una función

estrictamente cóncava, entonces

–f(x)es una función estrictamente convexa, y viceversa.

3) Teorema: c) (suma de funciones). Si f(x) y g(x) son ambas

cóncavas (convexas), entonces f(x) + g(x) es también una

función cóncava (convexa). Si f(x) y g(x) son ambas

cóncavas (convexas), y además una de ellas o las dos son

estrictamente cóncavas (estrictamente convexas) entonces

f(x) + g(x) es también una función estrictamente cóncava

(estrictamente convexa).

Las definiciones anteriores sobre concavidad y convexidad no

utilizan

las

derivadas,

y

por

tanto,

no

requieren

la

diferenciabilidad.

Si la función es diferenciable, la concavidad y la convexidad

pueden también definirse en términos de sus derivadas

primeras:

4

Una función f(x) con x ∈ Rn es una función cóncava

(convexa), si, para cualquier punto dado x(1) = ( x1(1); x2(1);

x3(1);....... xn(1)) y para cualquier otro punto .

x(2) = ( x1(2); x2(2); x3(2);....... xn(2)) del dominio de la función

n

≤

∂f

( 2)

(1)

f ( x ( 2 ) ) f ( x (1) ) + ∑

( xi − xi )

i =1 ∂x i x (1)

≥

Una función dos veces continuamente diferenciable z = f(x) con

x ∈ Rn es cóncava (convexa) ⇔ d2z es en todo punto

semidefinida negativa (positiva)1.

Dicha

función

es

estrictamente

cóncava

(convexa)

si

(condición suficiente) d2z es en todo punto definida negativa

(positiva).

1

Sentido amplio – Ver “Condición de segundo orden en la optimización libre y sujeta a

restricciones de igualdad”(Bernardello,A;Vicario, Aldo O.,septiembre de 1999)

5

Funciones cuasicóncavas- cuasiconvexas

Una función f es cuasicóncava (cuasiconvexa) si, ∀ x(1) ≠ x(2) ∈

X dominio convexo de f ∧ λ ∈ [0; 1]:

≥ f ( x (1) )

f ( x ( 2 ) ) ≥ f ( x (1) ) ⇒ f λx (1) + (1 − λ )) x ( 2 )

( 2)

≤ f ( x )

[

]

Y lo será de manera estricta si las dos desigualdades débiles

de la derecha se sustituyen por desigualdades estrictas

> f (x(1))

< f (x(2))

Se pueden probar los siguientes teoremas:

a) función opuesta : Si f(x) es cuasicóncava (estrictamente

cuasicóncava) entonces

– f(x) es cuasiconvexa ( estrictamente cuasiconvexa).

b) Cualquier función cóncava (convexa) es cuasicóncava

(cuasiconvexa),

pero

el

recíproco

no

es

cierto.

Análogamente: Cualquier función estrictamente cóncava

(estrictamente convexa) es estrictamente cuasicóncava

(estrictamente cuasiconvexa), pero el recíproco no es

cierto.

6

c) Si f(x) es una función lineal, entonces es cuasicóncava así

como cuasiconvexa.

Observación

En el caso de funciones cóncavas y convexas las únicas que

pertenecen a ambas clases son las lineales.

En el caso de funciones cuasicóncavas y cuasiconvexas,

aparte de las lineales, existen otras, como por ejemplo y = x2

para x ≥ 0 que es cuasicóncava y cuasiconvexa a la vez.

Funciones diferenciables:

Una función diferenciable f(x) con x ∈ Rn es cuasicóncava

(cuasiconvexa)

si ∀ x(1) ≠ x(2) ∈ X dominio de f

n ∂f

( 2)

(1)

∑

( xi − x i )

i =1 ∂xi x (1)

f ( x ( 2 ) ) ≥ f ( x (1) ) ⇒ n

≥0

∂f ( x ( 2) − x (1) )

i

i

∑

i =1 ∂xi x ( 2 )

Para la cuasiconcavidad y cuasiconvexidad estrictas la

desigualdad de la derecha tendrá que ser sustituída por la

desigualdad estricta > 0

7

Si la función es dos veces continuamente diferenciable, la

cuasiconcavidad y cuasiconvexidad , en el ortante no

negativo, pueden verificarse estudiando el signo de los

siguientes menores principales de la matriz hessiana :

0 f1 f2 .....fn

f1 f11 f12 ..... f1n

f2 f21 f22 ..... f2n

........................

fn fn1 fn2 ..... fnn

∆2 = 0 f1

f1 f11

∆3 =

0 f1 f2

f1 f11 f12

f2 f21 f22

......... ∆n =

0 f1 f2 .....fn

f1 f11 f12 ..... f1n

f2 f21 f22 ..... f2n

.........................

fn fn1 fn2 ..... fnn

Mientras la concavidad (convexidad) de una función sobre un

dominio convexo puede extenderse siempre a la concavidad

(convexidad) sobre el espacio total, con la cuasiconcavidad y

la cuasiconvexidad esto no es posible. Las condiciones que se

dan a continuación son las que exponen Kenneth J.Arrow y

8

Alain

C.

Enthoven

en

su

trabajo

Programación

Cuasicóncava, y son válidas en el ortante no negativo.

Condición necesaria de

Condición suficiente de

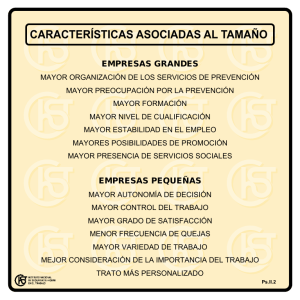

cuasiconcavidad cuasiconvexidad cuasiconcavidad cuasiconvexidad

∆2

≤0

≤0

<0

<0

∆3

≥0

≤0

>0

<0

∆4

≤0

≤0

<0

<0

∆5

≥0

≤0

>0

<0

∆i

≤ 0 si i es par

< 0 si i es par

≥ 0 si i es impar

> 0 si i es impar

∆n

≤0

<0

CONDICIONES DE KUHN-TUCKER

Un problema de programación no lineal suficientemente

general es el siguiente:

max. f(x1; x2;.......xn) s.a. g(1) (x1; x2;.......xn) ≤ c1

g(m) (x1; x2;.......xn) ≤ cm

(I)

9

El conjunto de vectores x ∈ Rn que verifican todas las

restricciones se llama conjunto admisible o factible

Cabe señalar que:

Minimizar f(x) es equivalente a maximizar -f(x)

La desigualdad de la forma gj(x) ≥ cj se

puede escribir

como -gj(x) ≤-cj

Una igualdad gj(x) = cj es equivalente a dos desigualdades

de la forma

g j ( x) ≤ c j

j

g ( x) ≥ c j

ó

g j ( x) ≤ c j

j

− g ( x) ≤ −c j

Así los problemas de optimización restringida se pueden

expresar, en general, de la forma (I).

Suponiendo que x* = (x*1; x*2;.....x*n) resuelve el problema (I),

entonces o bien gj(x*) < cj en cuyo caso se dice que la

restricción gj(x*) ≤ cj está inactiva o no saturada, o bien gj(x*) =

cj en cuyo caso se dice que la restricción gj(x*) ≤ cj está activa

o saturada en x*.

10

Cualificación de restricciones (C.R.)

Tienen como cometido eliminar situaciones anómalas que

provocan contraejemplos a las condiciones de Kuhn- Tucker.

Kuhn y Tucker plantearon para la demostración del teorema

condiciones que no son

sencillas de verificar.

2Pero

imponiendo algunas hipótesis adicionales a las funciones gj(x)

con 1 ≤ j ≤ m, se puede detectar rápidamente su vigencia por

conducto de criterios operativos, a saber:

Si todas las restricciones son funciones lineales, i.e

si cada gj(x)

con 1 ≤ j ≤ m

es lineal, se cumple la

cualificación de restricciones.

Si cada restricción es una función de clase C1 (función

diferenciable) y convexa, y existe un punto x*perteneciente

al conjunto factible en el cual todas las restricciones son

inactivas, i.e

gj(x*) < 0

con 1 ≤ j ≤ m

se cumple la cualificación de restricciones (condición de

Slater).

Para su enunciación ver, por ejemplo, Alpha Chiang; Fernandez Pol, Jorge

Eduardo; Uribe, Diego Escobar

2

11

Si

cada

función

de

restricción

es

diferenciable,

cuasiconvexa, existe un punto x* perteneciente al conjunto

factible tal que

gj(x*) < 0

con 1 ≤ j ≤ m

y si además para cada j

-

o bien gj(x) es convexa

-

o bien para cada x* perteneciente al conjunto

factible

→

∇ gj(x*) ≠ 0

3

entonces se cumple la cualificación de restricciones.

Las funciones gj(x)

con 1 ≤ j ≤ m correspondientes a las

restricciones que están activas en x* tienen gradiente en x*

que son linealmente independientes.

Es de destacar que esta condición es semejante a la condición

exigida al problema de optimización sujeta a condiciones de

igualdad4.

3 Sea f(x) con x ∈ Rn se llama gradiente de f al vector en el que las componentes

son las derivadas parciales de f , y evaluado en

x0

∂f ∂f

∂f

;.........

...

∇f ( x 0 ) = ;

∂x n x 0

∂x1 x 0 ∂x 2 x 0

ver condición de primer orden en optimización restringida en: “Condición de

segundo orden en la optimización libre y sujeto a restricciones de igualdad (Pag.21

y 22) presentado en las XIV Jornadas- Bernardello, Alicia y Vicario, Aldo.

Septiembre de 1999

4

12

La cualificación de restricciones es una restricción

impuesta a las restricciones aún cuando no es una limitación

concerniente al conjunto factible.

Es decir que dadas dos restricciones distintas entre sí, puede

ocurrir que a pesar de que ambas generan el mismo conjunto

factible, una satisface la cualificación y la otra no. Como por

ejemplo:

x1 ≥ 0

y

x1 ≥ 0

x2 ≥ 0

1-x1-x2 ≥ 0

x2 ≥ 0

g(1-x1-x2)3 ≥ 0

(1)

(2)

definen el mismo conjunto factible.

(1) satisface la C.R. (cualificación de restricciones) por ser las

restricciones lineales, pero

(2) por ejemplo en el punto x1 = ½ y x2 =1/2

− 3(1 − x1 − x 2 ) 2

0

= (linealmente dependiente)

∇g =

2

− 3(1 − x1 − x 2 ) (1 / 2;1 / 2) 0

no la satisface.

La función objetivo no tiene nada que ver con esta hipótesis

de regularidad denominada C.R.

13

No es necesario que se cumplan todas las condiciones arriba

expuestas, solo basta con una de ellas. Además estas no son

equivalentes entre sí.

Condiciones necesarias de Kuhn-Tucker

Suponiendo que x ( 0) = ( x1( 0) ; x 2( 0 ) ;........x n( 0 ) ) resuelve el problema

max. f ( x)

s. a. g j (x) ≤ c j con 1 ≤ j ≤ m ∧ x ∈ R n

no

estando

acotada la cantidad de restricciones y donde f(x) y gj(x) con

1 ≤ j ≤ m son funciones continuamente diferenciables.

Suponiendo

que

se

verifica

la

cualificación

de

las

restricciones. Entonces,existen unos únicos números λ1;

λ2;.........λm tales que

a)

∂f ( x ( 0 ) ) m

∂g j

− ∑λj

= 0 con 1 ≤ i ≤ n

∂xi

∂xi

j =1

b)

g j ( x ( 0) ) ≤ 0 ∧

λ j ≥ 0 ∧ λ j g j ( x ( 0) ) = 0 con 1 ≤ j ≤ m

Si se escribe la función de Lagrange

m

[

L( x; λ ) = f ( x) + ∑ λ j c j − g j ( x)

]

j =1

Las condiciones de Kuhn y Tucker se pueden expresar:

14

a)

b)

∂L

= 0 1≤ i ≤ n

∂xi

∂L

≥0

∂λ j

λj ≥ 0

λj

∂L

=0

∂λ j

1≤ j≤ m

(II)

Condiciones de no negatividad para las variables

Es frecuente que las variables que aparecen en los problemas

económicos de optimización sean no negativas por su propia

naturaleza.

Para introducir estas restricciones a la formulación (I), xi ≥ 0

se puede representar por gm+1(x) = -xi ≤ 0 y se introduce un

multiplicador de Lagrange adicional para ella.

Sin

embargo

para

no

tener

que

manejar

demasiados

multiplicadores de Lagrange, se formulan las condiciones

necesarias de solución de los problemas de programación no

lineal con restricciones de no negatividad de las variables de

una manera ligeramente distinta.

15

En efecto, considerando por ejemplo el siguiente problema:

max. f ( x, y ) s.a. g (1) ( x; y ) ≤ c ∧

x≥0

∧

y≥0

condiciones de no negatividad

introduciendo las funciones g(2)(x;y) = -x

y

g(3)(x,y) = -y

con lo que las restricciones quedarán:

g(1)(x;y) ≤ 0

g(2)(x;y) ≤ 0

g(3)(x;y) ≤ 0

entonces:

L(x; y; λ1; λ2; λ3) = f(x;y) + λ1 [c - g(1)(x;y)] + λ2 (0 + x) + λ3 (0 + y)

Las condiciones de Kuhn-Tucker son:

∂L ∂f

∂g (1)

=

− λ1

+ λ2 = 0

∂x ∂x

∂x

(a)

∂L ∂f

∂g (1)

=

− λ1

+ λ3 = 0

∂y ∂y

∂y

(b)

∂L

= c - g(1)(x;y) ≥ 0

∂λ1

16

λ1 ≥ 0

λ1 [c - g(1)(x;y)] = 0

(c)

∂L

=x ≥ 0

∂λ 2

λ2 ≥ 0

x λ2 = 0

(d)

λ3 ≥ 0

y λ3 = 0

(e)

∂L

=y ≥ 0

∂λ3

de (a) se obtiene

∂f

∂g (1)

− λ1

- λ2 =

∂x

∂x

(a1)

de (d)

λ2 ≥ 0

x λ2 = 0

(d1)

es decir que (a) y (d) equivalen conjuntamente a

∂f

∂g (1)

− λ1

≤0

∂x

∂x

y,

x ≥ 0 por condición de no negatividad

∂f

∂g (1)

− λ1

∂x

∂x

x = 0

por (a1) y (d1)

de (b)

- λ3 =

∂g (1)

∂f

− λ1

∂y

∂y

(b1)

17

de (e)

λ3 ≥ 0

y λ3 = 0

(e1)

es decir que (b) y (e) equivalen conjuntamente a

∂f

∂g (1)

≤0

− λ1

∂y

∂y

y,

y ≥ 0 por condición de no negatividad

∂f

∂g (1)

− λ1

∂y

∂y

y = 0

por (b1) y (e1)

Es decir que si se incluyen las condiciones de no negatividad

de las variables, las condiciones necesarias de Kuhn y Tucker

utilizando el Lagrangeano según (II) para el problema

max . f ( x)

→

s. a. g j (x) ≤ c j con 1 ≤ j ≤ m ∧ x ≥ 0 ∧ x ∈ R n

m

[

L = f ( x) + ∑ λ j c j − g j ( x)

]

j =1

serán:

suponiendo que x(0) ∈ Rn resuelve el problema siendo la

función

objetivo

continuamente

y

las

diferenciables

restricciones

y

suponiendo

funciones

que

se

verifica la cualificación de restricciones entonces existen

unos únicos números λ1; λ2;.........λm tales que

18

∂L

≤0

∂xi x ( 0 )

a)

∂L

∂λ j

b)

≥0

x

xi ≥ 0

xi

λj ≥ 0

λj

(0)

∂L

=0

∂xi x ( 0 )

∂L

∂λ j

=0

x

1≤ i ≤ n

con 1 ≤ j ≤ m

(0)

Condiciones suficientes de Kuhn-Tucker

Considerando el problema de programación no lineal

max. f (x)

→

s.a. g j (x) ≤ c j con1 ≤ j ≤ m ∧ x ≥ 0 ∧ x∈R n m > = ó <

n

donde la función objetivo y las restricciones son

continuamente diferenciables, f es cóncava

y las

restricciones son convexas. Suponiendo que existen λ j

con 1 ≤ j ≤ m

y un vector factible x(0) tales que:

a)

∂L

=0

∂xi x ( 0 )

b)

∂L

∂λ j

≥0

x(0)

1≤ i ≤ n

λj ≥ 0

λj

∂L

∂λ j

=0

con 1 ≤ j ≤ m

x(0)

19

Si se agregan las condiciones de no negatividad de las

variables a) sería:

∂L

≤0

∂xi x ( 0 )

xi ≥ 0

xi

∂L

=0

∂xi x ( 0 )

1≤ i ≤ n

Entonces x(0) resuelve el problema.

Si además se verifica la cualificación de restricciones las

condiciones son necesarias y suficientes, y si la función

objetivo es estrictamente cóncava se puede asegurar que el

máximo global es único

Observación:

Para minimizar basta utilizar lo indicado en consideraciones

previas es decir

min. f ( x)

→

s. a. g j (x) ≥ c j con 1 ≤ j ≤ m ∧ x ≥ 0 ∧ x ∈ R n

equivale a

max. - f ( x)

20

→

s. a. - g j (x) ≤ −c j con 1 ≤ j ≤ m ∧ x ≥ 0 ∧ x ∈ R n

Condiciones necesarias y suficientes en programación

cuasicóncava (Arrow- Enthoven)

Sea el problema

→

s. a. g j (x) ≤ c j con 1 ≤ j ≤ m ∧ x ≥ 0 ∧ x ∈ R n

max. f ( x)

donde

la

función

objetivo

y

las

restricciones

son

continuamente diferenciables. Suponiendo que existen

números λ j con 1 ≤ j ≤ m y un vector x(0) ∈ Rn tales que:

a) x(0) es factible y se verifican:

∂L

≤0

∂xi x ( 0 )

b)

∂L

∂λ j

c)

d)

≥0

x

xi ≥ 0

λj ≥ 0

xi

∂L

=0

∂xi x (0)

λ j ∂L

(0)

∂λ j

con 1 ≤ i ≤ n

=0

x

con 1 ≤ j ≤ m

(0)

f(x) es cuasicóncava y gj(x) es cuasiconvexa para 1 ≤ j

≤ m en el ortante no negativo

e) Se satisface una cualquiera de las siguientes:

e-i

∂f

< 0 para al menos una variable xi

∂xi x ( 0 )

e-ii ∂f

∂x

i

x(0 )

> 0 para alguna variable xi que pueda tomar

21

un valor positivo sin violar las restricciones (xi en este

caso es llamada en la literatura del tema como variable

relevante)5

→

e-iii ∇f ( x (0) ) ≠ 0 , y la función es dos veces diferenciable en

un entorno de x(0)

e-iv f(x) es cóncava

Entonces en x(0) la función se maximiza.

Es decir si además de verificarse a, b, c, d y e se satisface la

cualificación de restricciones, entonces las condiciones de

Kuhn y Tucker son necesarias y suficientes.

La cuasiconcavidad no implica que las condiciones de KuhnTucker sean suficientes para tener un máximo global. ArrowEnthoven dieron el siguiente ejemplo:

Max. f(x) = (x – 1)3

s.a. 2 – x ≥ 0 ∧

x≥0

Analizando f(x) = (x – 1)3 en el cuadrante positivo

5

dado el conjunto de restricciones C = {

g j (x) ≥ 0 con 1 ≤ j ≤ m ∧ x ∈ Ω n }

( Ω es el ortante no negativo de Rn) se dice que la variable xi es variable relevante si

n

existe un x en C tal que xi > 0

22

f’(x) = 3 (x – 1)2; f”(x) = 6 (x – 1) B =

0

3( x − 1) 2

3( x − 1) 2

6( x − 1)

= -9(x-

1)4 < 0

⇒ condición suficiente de cuasiconcavidad y la restricción es

lineal (cóncava entonces cuasicóncava)

L = (x – 1)3+ λ (2 – 2 x)

a)

∂L

= 3 (x – 1)2 – 2 λ ≤ 0

∂x

b)

∂L

= 2 – 2x ≥ 0

∂λ

x ≥0

λ≥0

x.[ 3 (x – 1)2 – 2 λ] = 0

λ (2 – 2x) = 0

En x = 1 y λ = 0 se cumple a) y b) y se cumple la cualificación

de restricciones ( la restricción es lineal) pero no se satisface

ninguna de las condiciones e. En efecto, al ser f’(1) = 0, no se

cumple ni e-i, ni e-ii, ni eiii, y como la función f no es cóncava

tampoco e-iv. El óptimo se encuentra en x = 2 y λ = 3 donde

se satisface a), b) y c) y e-ii o e-iii, es decir que las condiciones

de Kuhn y Tucker son necesarias y suficientes

23

Procedimiento para hallar todos los candidatos a óptimo

1- Hallar todos los puntos factibles donde se satisface la

cualificación de restricciones y las condiciones de Kuhn y

Tucker

2- Hallar todos los puntos factibles en los que la cualificación

de restricciones falla

Si se sabe que el problema tiene solución los pasos 1 y 2

darán todos los posibles candidatos a solución.

Después de evaluar f en todos esos candidatos, se pueden

tomar el (o los) que maximizan f

El paso 2 se debe realizar ya que para que las condiciones de

Kuhn

y

Tucker

sean

necesarias

se

debe

verificar

la

cualificación de restricciones, entonces x(0) puede ser una

solución del problema sin verificar las condiciones de Kuhn y

Tucker.

Es necesario evitar el error de que al encontrar un único

candidato a solución x(0) a partir de las condiciones de Kuhn y

Tucker

en

el

que

se

comprueba

la

cualificación

restricciones suponer que se alcanzó la solución ya que el

24

de

óptimo puede encontrarse en otros puntos factibles donde

falla la cualificación de restricciones.

Observación:

En

los

modelos

funciones

económicos

dependientes

de

aparecen

variables

frecuentemente

discretas

y,

en

consecuencia, no diferenciables.

Si un problema de programación no lineal resulta ser no

diferenciable, las técnicas expuestas hasta ahora no son

aplicables. Así, es necesario encontrar otros métodos que

faciliten la solución de este tipo de problemas, métodos que

también, por otra parte, son válidos para resolver problemas

diferenciables.

Para ello es necesario definir el punto silla del Lagrangeano y

ver su relación con la solución, tema que no trataremos en

este trabajo.

Caso en que las condiciones de Kuhn y Tucker son

necesarias pero un punto que las satisface no es el óptimo

Sea max. z = x2 + y2 – 8

s. a.

x ≤ 1 ; -y ≤ 0; x2 + y2 ≤ 4

L = x2 + y2 – 8 + λ1(1 – x) + λ2 y + λ3 (4- x2 – y2)

25

∂L

= 2 x - λ1 – 2 λ3 x = 0

∂x

∂L

= 2 y + λ2 – 2 λ3 y = 0

∂y

∂L

=1–x≥0

∂λ1

∂L

=y≥0

∂λ 2

λ1 ≥ 0

λ2 ≥ 0

∂L

= 4 – x2 – y2 ≥ 0

∂λ3

λ1 (1 – x) = 0

λ2 y = 0

λ3 ≥ 0

λ3 (4 – x2 – y2 ) = 0

El punto x = 1 y = 0 es regular ya que satura la 1° y la 2°

restricción y los gradientes ∇g(1)(1;0) = ( 1;0)

y

∇g(2)(1;0) =

(0; -1) son linealmente independientes, (verificala cualificación

de restricciones).

Además x = 1; y = 0; λ1 = 0; λ2 = 0; λ3 = 0 verifica las

condiciones de Kuhn y Tucker, pero si se toman puntos

próximos a éste por ejemplo (1; h) con h > 0 y pequeño, que

satisface las condiciones de Kuhn y Tucker, resulta que f(1;h)

= 1 + h2 – 8 = h2 – 7 pero f(1;0) = -7 por lo tanto f (1;h) ≥ f(1;0)

por lo que (1;0) no es máximo local.

26

Obsérvese que la función objetivo es convexa y no cóncava

como se exige para que las condiciones de Kuhn y Tucker

sean suficientes.

Caso

en

que

no

se

satisface

la

cualificación

de

restricciones por lo que las condiciones de Kuhn y Tucker

no son necesarias

Max. z = x y

s. a.

g(x;y) = (x + y – 2)2 ≤ 0

Como (x + y – 2)2 es no negativa, la restricción es equivalente

a x + y – 2 = 0. Entonces puede plantearse como un problema

de optimización sujeta a condiciones de igualdad. Es decir:

L = x y + λ (2 – x – y)

∂L

= y-λ=0

∂x

∂L

= x-λ=0

∂y

∂L

=2–x–y=0

∂λ

la solución de este sistema es x = 1; y = 1; λ = 1

27

Planteando las condiciones de Kuhn y Tucker para el

problema con la restricción original

L = x y + λ [-( x + y - 2)2]

∂L

= y – 2 λ (x + y - 2) = 0

∂x

∂L

= x – 2 λ (x + y - 2) = 0

∂y

∂L

= -(x + y - 2)2 ≥ 0

∂λ

λ≥0

En el óptimo del problema x = 1

- λ (x + y - 2)2 = 0

y = 1 se obtiene la

contradicción 1 = 0 en cada caso.

Nótese que el ∇g(1)(1;1) = (0;0) que no es un vector linealmente

independiente, es decir que (1;1) no es un punto regular. La

cualificación de restricciones falla en (1;1). Las condiciones de

Kuhn y Tucker fallan en (1;1) no obstante ser este punto el

máximo que resuelve el problema.

Por otro lado la función objetivo es cuasicóncava. En efecto

analizando

28

z = x y en el ortante positivo:

0

B = y

x

x

0 1 ;

1 0

y

0

y

y

= −y2 < 0

0

∀y > 0; |B| = 2 x y > 0

∀x,y > 0

la restricción g = ( x + y – 2)2 es convexa (cuasiconvexa)

En efecto su matriz hessiana

2 2

H =

2 2

2 > 0 y |H| = 0

es semidefinida positiva

Podría pensarse en utilizar el Teorema de Arrow- Enthoven

pero no se cumplen las condiciones de Kuhn y Tucker por lo

que no se puede emplear las condiciones suficientes.

Ejemplo de condiciones necesarias y suficientes

Max. f(x;y) = - 8 x2 – 10 y2 + 12 x y – 50 x + 80 y

s. a. g(1)(x;y) = x + y ≤ 1

g(2)(x;y) = 8 x + y2 ≤ 2

x ≥0;

y≥0

L = - 8 x2 – 10 y2 + 12 x y – 50 x + 80 y + λ1(1 – x - y) +

+ λ2 (2- 8 x2 – y2)

29

∂L

= - 16 x + 12 y – 50 - λ1 – 16 λ2 x ≤ 0

∂x

∂L

= -20 y + 12 x + 80 - λ1 – 2 λ2 y ≤ 0

∂y

x ≥0

x

∂L

=0

∂x

y≥0

y

∂L

=0

∂y

∂L

=1–x–y≥0

∂λ1

λ1 ≥ 0

λ1 (1 – x - y) = 0

∂L

= 2 – 8 x2 – y2 ≥ 0

∂λ 2

λ2 ≥ 0

λ2 (2 – 8 x2 – y2 ) = 0

La función objetivo es cóncava ya que la matriz hessiana

− 16 12

H =

12 − 20

-16 < 0

y

|H| > 0 es definida negativa

entonces la función es cóncava en sentido estricto

Las restricciones:

g(1) es lineal cóncava-convexa

g(2) es convexa (suma de funciones convexas)

se cumple la cualificación de restricciones ya que existe ( x ; y )

= (0,1 ; 0,1) admisible en el que:

30

g(1) (0,1 ; 0,1) < 0

(condición de Slater)

g(2) (0,1 ; 0,1) < 0

entonces las condiciones de Kuhn y Tucker son necesarias y

suficientes.

El punto que las satisface es x = 0; y = 1; λ1 = 60; λ2 = 0

En efecto

∂L

(0;1) = -98

∂x

x ≥0

x

∂L

=0

∂x

∂L

(0;1) = 0

∂y

y≥0

y

∂L

=0

∂y

z(0;1) = 70

Aplicación de las condiciones de Kuhn y Tucker al

problema

estandar

en

teoría

de

la

demanda

del

consumidor

Max. U(x)

s. a. p1x1 + p2x2 + p3x3 +.............+pnxn ≤ I

donde U es la función utilidad

31

x ∈ Xn espacio de bienes definido en Ωn ⊂ Rn

pi es el precio del bien xi

1≤i≤n

pi > 0

I es el ingreso del consumidor

Suponiendo

que

U

es

continuamente

diferenciable

y

cuasicóncava. Las condiciones de Kuhn y Tucker son:

L = U(x) + λ ( I - p1x1 - p2x2 - p3x3 -.............-pnxn)

a)

∂L ∂U

=

− λpi ≤ 0

∂xi ∂xi

b)

n

∂L

= I − ∑ pi xi ≥ 0

∂λ

i =1

xi ≥ 0

λ≥0

∂U

xi

− λpi = 0 con 1 ≤ i ≤ n

∂xi

n

i =1

λ I − ∑ p i xi = 0

Suponiendo que x(0) ∈ Xn verifica a) y b) y suponiendo que no

todas las

∂U

son cero, o sea que se supone que para algún

∂xi x ( 0 )

bien no existe saciedad, (condición e-iv de Arrow-Enthoven), y

teniendo en cuenta que la función objetivo es cuasicóncava y

la restricción es lineal, se dan las condiciones suficientes de

óptimo.

32

n

Entonces a) implica que λ > 0 y así ∑ pi xi = I por b). Por lo

i =1

tanto, se gasta todo el presupuesto y x(0) ∈ Xn resuelve el

problema

Utilización en programación lineal

Suponiendo el problema:

w;x ∈ Rn

Min. wTx

s.a. A x ≥ b

x ≥ 0 A ∈ Rmxn b ∈ Rm

que se convierte en el problema:

Max. - wTx

Rmxn

w;x ∈ Rn

s.a.

-Ax≤-b

x≥0

A∈

b ∈ Rm

L = - wTx + λT (- b + A x )

En este problema se dan las condiciones necesarias y

suficientes de Kuhn y Tucker pues la función objetivo es

lineal y las restricciones también:

a)

∂L

= - wT + λT A ≤ 0

∂x

→

x ≥ 0

ó

b)

∂L

=-b+Ax ≥0

∂λ

→

λ ≥ 0

- wTx + λT A x = 0

wTx = xT AT λ

(1)

λT (- b + A x) = 0

ó bT λ = xT AT λ

(2)

33

Suponiendo que existe un vector y ∈ Ωn tal que:

ATy ≤ w (3)

⇒ xT AT y ≤ xT w (4)

bT y - bT λ = bT y - xT AT λ

de (2)

bT y - bT λ ≤ xT AT y - xT AT λ ≤ 0

ya que de (1) xT AT λ = wTx = xT w

y de (4) xT AT y ≤ xT w

Es decir

xT (AT y - AT λ) ≤ 0

Por lo tanto bTy toma su máximo bajo (3) en y = λ

Y además vale

bT y = bT λ = xT AT λ = wTx

Se concluye entonces que si Min. wTx s.a. A x ≥ b x ≥ 0

tiene solución, entonces Max. bT y s.a. A y ≤ w tiene solución

y los valores mínimo y máximo de las funciones objetivos

coinciden (Teorema débil de la dualidad)

34

Programación cuadrática

Consideremos el caso de maximizar una forma cuadrática

(como función objetivo) sujeta a restricciones lineales:

Máx. f(x) = cT x – ½ xT Q x s.a. g(j)(x) ≤ bj que equivale a A x ≤

b (por ser

restricciones

lineales) ∧ x ≥ 0

donde:

c1

x1

b1

a11.............a1n

q11.........q1n

c2

x2

b2

a21.............a2n

q21.........q2n

c=

x=

cn

b=

xn

A=

bm

Q=

am1............amn

qn1.........qnn

la matriz Q es simétrica semidefinida positiva, lo que asegura

que la función objetivo sea una función cóncava6.

Las condiciones de Kuhn y Tucker son necesarias y

suficientes

cuando

en

el

problema

de

programación

matemática se maximiza una función cóncava y la región de

factibilidad es un conjunto convexo, como en este caso.

6

ver Anexo II

35

Algoritmo de Wolfe

Consiste en aplicar las condiciones de Kuhn y Tucker al

problema

de

programación

cuadrática,

reduciendo

el

problema a otro de programación lineal.

∇ (cT x – ½ xT Q x) -

m

∑ ∇g

j =1

( j)

λ j + β = 0 (1)

→

→

β≥0

xi ≥ 0

b- A x ≥ 0

(2)

βx = 0

→

λ (b - Ax) = 0

λj ≥ 0

(2’)

siendo

β1

0

β =

#

0

0

β2

#

0

0

..... 0

..... #

..... β n

λ1

0

λ=

#

0

.....

y

como ∇ (cT x – ½ xT Q x) = c – Q x

y

0

..... 0

..... #

..... λ n

0

.....

λ2

#

0

m

∑ ∇g

j =1

( j)

λ j = ATλ

sustituyendo en (1)

c – Q x – AT λ + β = 0

de (2) A x ≤ b

⇒ Q x + AT λ - β = c

que puede ser expresada como igualdad

utilizando un conjunto de variables de holgura (slacks)

36

s1

s

s= 2

#

sm

Ax+s=b

→

siendo λ s = 0

por (2’)

Analizando esta última relación:

λ>0

⇒

s=0 ⇒ Ax=b

λ =0

⇒

s≥0 ⇒ Ax≥b

Entonces las condiciones quedan:

Q x + AT λ - β = c (5)

xi ≥ 0

Ax+s=b

El

sistema

→

→

β≥0

βx = 0

λj ≥ 0

λ s=0

anterior

→

puede

ser

resuelto

(3)

s≥0

(4)

utilizando

programación lineal, lo que es básicamente el algoritmo de

Wolfe

Destaquemos que por (3) xi y βj no deben formar parte de la

solución factible básica al mismo tiempo, y que por (4) λj y sj

37

tampoco deben formar parte de la solución factible básica al

mismo tiempo.

La solución factible básica inicial no se obtiene fácilmente.

Sin

embargo,

si

definimos

un

conjunto

de

variables

artificiales zi con 1 ≤ i ≤ n y si definimos una matriz.

c1

0

C=

#

0

0

c2

#

0

0

..... 0

..... #

..... c n

.....

podemos reestructurar la ecuación (5) de la siguiente forma:

Q x + AT λ - β + C z = c

Destaquemos que la solución factible básica inicial será

entonces zi = 1.

Como las variables zi son variables artificiales podemos crear

una función objetivo que las incluya y como las queremos

eliminar de nuestra solución factible básica inicial, entonces

minimizaremos dicha función.

Entonces nuestro problema quedará definido de la siguiente

manera:

38

Min

W =

n

∑z

i =1

xi ≥ 0

→

→

βx = 0

β≥0

A

λj ≥ 0

Q x + AT λ - β + C z = c

s.a.

i

→

λ s=0

x

+

s

=

b

s.a.

8

s≥0

Ejemplo:

Max. f(x) = 10 x1 + 20 x2 + x1 x2 – 2 x12 – 2 x22

– x2 ≥ 0

0 –

x1 – x2 ≥ 0

x1 ≥ 0

x2 ≥ 0

en forma matricial:

x

max. f(x) = [10 20] 1 x2

½ [x1

4 − 1 x1

0 1 x1 8

x2 ]

s.a.

≤

− 1 4 x 2

1 1 x 2 10

x1 ≥ 0

x2 ≥ 0

Aplicando el algoritmo de Wolfe se reduce a resolver:

39

z

Min. W = [1 1] 1

z2

4 − 1 x1

− 1 4 x +

2

s.a.:

0 1 λ1 β 1

10 0

1 1 λ - β + 0 20

2 2

z1

10

z = 20

2

0 1 x1 s1 8

1 1 x + s = 10

2 2

s

[λ1

λ2 ] 1 = 0

s

[β 1

β2 ] 1 = 0

x

2

x

2

Que se puede resolver mediante el método simplex teniendo

en cuenta durante la resolución que λi y si no pueden formar

parte simultáneamente de la base y que βi

y

xi tampoco

pueden formar parte simultáneamente de la base.

Problema de selección de la cartera de valores

Bajo ciertos supuestos sobre el comportamiento del inversor

Markowitz7 supuso que la función de utilidad del individuo es

U=f[E(RP);σ(RP)]

con

7

∂U

>0

∂E (RP )

y

∂U

>0

∂σ (RP )

Markowitz, Portfolio Selection, marzo de 1952 reproducido en Teoría de la Financiación

de la Empresa recopilación de J. Fred Weston y Donald H. Woods, editorial Gustavo Gilli

S.A., Barcelona, 1970

40

donde:

E(RP) es el valor esperado de la rentabilidad del portafolio

σ( RP) es el desvío estandar de la rentabilidad del portafolio

Y suponiendo que cuenta con P unidades monetarias para

invertir en un conjunto de n acciones desea saber cuánto le

conviene invertir en cada acción (wi = proporción de P

invertida en la acción i)

Entonces se plantea el problema:

min V(R P )

n

s.a. E(R P ) = ∑ wi Ri

i =1

con wi ≥ 0

Donde V(RP) = [w1

n

∧ ∑ wi = 1

i =1

1≤i≤n ∧ i∈N

w2 " wn ]

σ 11 σ 12 " σ 1n w1

σ

21 σ 22 " σ 2 n w2

#

#

# #

σ n1 σ n 2 " σ nn wn

Donde σ ij es la covarianza del rendimiento de la acción i con

la j ( si i = j σ ii es la varianza de la acción i).

41

Se puede demostrar que la función V(RP) es semidefinida

positiva (concepto amplio) y al ser las restricciones lineales se

puede resolver por programación cuadrática.

Haciendo depender el valor de la función objetivo de E*(RP) y

aplicando lo demostrado en Anexo I y considerando que al ser

V(RP) convexa8 y la restricción E(RP)

cóncava (por ser una

función lineal),

v[E(R p )] = MinV ( R p ) tal que∑ wi Ri = E * ( RP ), con

con wi ≥ 0

n

∑w

i =1

i

= 1

1≤i≤n ∧ i∈N

E ∗ ( RP )

*

el valor óptimo v[E (RP)] de

1

que asigna a cada vector

V(RP), será convexa.

Obteniéndose la frontera eficiente en el espacio E(RP); σ( RP),

donde:

σ( RP) =

8

V ( RP )

9

ver Anexo II

v[E(RP)] es no decreciente en la variable E(RP), ya que si ésta crece (baja) y la otra

restricción permanece fija, la exigencia de una mayor rentabilidad del portafolio, hará que

el riesgo medido por v[E(RP)] aumente (disminuya)

42

9

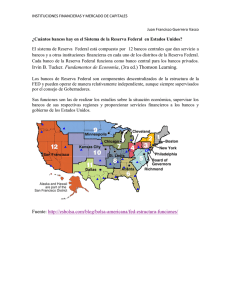

Gráficamente:

σ( RP)

E(RP)

o como más frecuentemente se presenta

E(RP)

σ( RP)

Observación:

El problema de selección de la cartera de valores, si se levanta

el supuesto de que las ponderaciones sean no negativas (wi ≥

0) lo que implica desde el punto de vista financiero aceptar

“venta descubierta” (en inglés: “short sale”)10, se puede

10

significa venta de un título del cual no se es propietario

43

resolver por optimización clásica (Maximización sujeta a

restricciones de igualdad)11

ANEXO I

Propiedades de la función valor:

El valor de la función objetivo f(x) depende de c = (c1; c2;

c3;.....;cm)

La función definida por: v(c) = max { f(x) sujeta a gj(x) ≤ cj con

1 ≤ j ≤ m ∧ j ∈ N ∧ x ∈ Rn}

asigna a cada vector c el valor óptimo v(c) de f y se llama

función valor para el problema.

Si f(x) es cóncava y g(1)(x); g(2)(x);.......... g(m)(x) son todas

convexas entonces v(c) es cóncava.

En efecto, designemos con x(c) a una solución óptima del

problema cuando el vector de los miembros de la derecha

de las desigualdades es c = (c1; c2; c3;.....;cm).

11

Para un tratamiento del tema ver “Selección de Inversiones” Messuti y otros cap 5 y 12

44

Sean c(1) y c(2) dos vectores arbitrarios de miembros de la

derecha, entonces:

v(c(1)) = f[x(c(1))]

con gj[x(c(1))] ≤ cj y

y

v(c(2)) = f[x(c(2))],

gj[x(c(2))] ≤ cj

con 1 ≤ j ≤ m ∧ j ∈ N

y sea λ ∈ [0; 1] correspondiente al vector ( 1 -λ) c(1) + λ c(2) hay

una solución óptima x[( 1 -λ) c(1) + λ c(2)] para la cual

v[( 1 -λ) c(1) + λ c(2)] = f { x[( 1 -λ) c(1) + λ c(2)]}

Anotando x = ( 1 -λ) x(c(1)) + λ x(c(1))

La convexidad de gj implica que para 1 ≤ j ≤ m ∧ j ∈ N

gj(x) ≤ ( 1 -λ) gj [x(c(1))] + λ gj [x(c(2))] ≤ ( 1 -λ) cj(1) + λ cj(2)

donde la última desigualdad se deduce del hecho de que los

dos vectores x(c(1)) y x(c(2)) sean factibles.

Así x es factible para el problema cuyo miembro de la derecha

es el vector

( 1 -λ) c(1) + λ c(2) .

45

x = [( 1 -λ) c(1) + λ c(2)]

Por definición

es óptimo de este

problema. Por lo tanto:

f(x) ≤ f{x[( 1 -λ) c(1) + λ c(2)]} = v[( 1 -λ) c(1) + λ c(2)]

(a)

además la concavidad de f implica que

f(x) ≥ ( 1 -λ) f [x(c(1))] + λ f [x(c(2))] = ( 1 -λ) v(c(1)) + λ v(c(2))

(b)

de (a) y (b) se deduce que:

v[( 1 -λ) c(1) + λ c(2)] ≥ ( 1 -λ) v(c(1)) + λ v(c(2))

que responde a la definición de concavidad de v.

Para

v(c)

=

min

{

f(x)

sujeta

a

gj(x)

≤

cj

con 1 ≤ j ≤ m ∧ j ∈ N ∧ x ∈ Rn}

con f(x) convexa y g1(x); g2(x);..........gm(x) todas cóncavas, de

forma similar, se puede demostrar que la función valor v(c) es

convexa.

•

v(c) es no decreciente en cada variable cj con 1 ≤ j ≤ m ya

que si cj crece y todas las otras variables están fijas, el

conjunto factible se agranda. Por lo tanto v(c) no puede

decrecer

46

ANEXO II

Una forma cuadrática semidefinida positiva (negativa), es una

función convexa (cóncava) sobre Rn.

Se demostrará esta propiedad para una forma cuadrática

semidefinida positiva.

Sea f(x) = xT A x ≥ 0 para todo x distinto del vector nulo con

x∈ Rn y nAn simétrica.

Tomando dos puntos cualesquiera x(1) y x(2) y sea z = [( 1 -λ)

x(1) + λ x(2)]

con λ ∈ [0; 1] .

Por definición de función convexa hay que demostrar que:

zT A z ≤ ( 1 -λ) x(1)T A x(1) + λ x(2)TA x(2)

por definición de z

zT A z = [( 1 -λ) x(1) + λ x(2)]T A [( 1 -λ) x(1) + λ x(2)]

zT A z = [( 1 -λ) x(1) A + λ x(2) A]T [( 1 -λ) x(1) + λ x(2)]

zT A z = λ2 x(2)TA x(2)+ (1 -λ) λ x(1)TA x(2) + λ x(2)TA (1 -λ) x(1) +

+ (1 -λ)2 x(1)T A x(1)

47

zT A z = λ2 x(2)TA x(2) + λ x(1)TA x(2) - λ2 x(1)TA x(2) + λ x(2)TA x(1) - λ2 x(2)TA x(1) + x(1)TA x(1) - 2λ x(1)T A x(1) + λ2 x(1)TA x(1)

aplicando x(1)TA x(2) = [x(1)TA x(2)]T = x(2)TA x(1) en

el 4° término (♣)

zT A z = λ2 x(2)TA x(2) + λ x(1)TA x(2) - λ2 x(1)TA x(2) + λ x(1)TA x(2) - λ2 x(2)TA x(1) + x(1)T A x(1) - 2λ x(1)T A x(1) + λ2 x(1)TA x(1)

sumando el 2° y el 4° término

zT A z = λ2 x(2)TA x(2) + 2 λ x(1)TA x(2) - λ2 x(1)TA x(2) - λ2 x(2)TA x(1)

+ x(1)T A x(1)- 2λ x(1)T A x(1) + λ2 x(1)TA x(1)

zT A z = λ2 (x(2)TA x(2) - x(1)TA x(2) - x(2)TA x(1) + x(1)TA x(1)) +

+ 2 λ (x(1)TA x(2) - x(1)T A x(1)) + x(1)T A x(1)

zT A z = λ2 (x(2) - x(1))TA x(2) – (x(2) - x(1))TA x(1)) +

+ 2 λ x(1)TA (x(2)- x(1)) + x(1)T A x(1)

zT A z = λ2 (x(2) - x(1))TA (x(2) – x(1)) + 2 λ x(1)TA (x(2) - x(1)) +

+ x(1)T A x(1)

48

aplicando la propiedad (♣) en el 2° término

zT A z = λ2 (x(2) - x(1))TA (x(2) – x(1)) + 2 λ (x(2) - x(1))T A x(1) +

+ x(1)T A x(1)

como λ ∈ [0; 1] y xT A x ≥ 0 se deduce que

λ (x(2) - x(1))TA (x(2) – x(1)) ≥ λ2 (x(2) - x(1))TA (x(2) – x(1))

Entonces :

zT A z ≤ λ (x(2) - x(1))TA (x(2) – x(1)) + 2 λ (x(2) - x(1))T A x(1) +

+ x(1)T A x(1)

zT A z ≤ (λ x(2)T A - λ x(1)TA) (x(2) – x(1))+ 2 λ x(2)T A x(1)- 2λx(1)T A x(1) + x(1)T A x(1)

zT A z ≤ λ x(2)T A x(2) - λ x(2)T A x(1) - λ x(1)TA x(2) + λ x(1)TA x(1)+

+2λ x(2)T A x(1)

-

2 λ x(1)T A x(1) + x(1)T A x(1)

aplicando la propiedad (♣) en el 3° término:

zT A z ≤ λ x(2)T A x(2) - λ x(2)T A x(1) - λ x(2)TA x(1) + λ x(1)TA x(1) +

+ 2 λ x(2)T A x(1) - 2 λ x(1)T A x(1) + x(1)T A x(1)

49

cancelando 2°, 3° y 5° términos y sumando 4° y 6° términos

zT A z ≤ λ x(2)T A x(2) - λ x(1)T A x(1) + x(1)T A x(1)

zT A z ≤ λ x(2)T A x(2) + (1- λ) x(1)T A x(1)

que es lo que se quería demostrar.

El razonamiento para una forma cuadrática semidefinida

negativa es análogo.

50

Función convexa

Sea f : X → R con X ⊂ Rn convexo, f es una función convexa

⇔ ∀ x(1); x(2) ∈ X ∧ λ ∈ [0; 1]:

f[λx(1)+(1 - λ)x(2)] ≤ λ f(x(1)) + (1 - λ) f(x(2))

f es estrictamente convexa ⇔ ∀ x(1); x(2) ∈ X ∧ λ ∈ [0; 1]

f[λx(1)+(1 - λ)x(2)] < λ f(x(1)) + (1 - λ) f(x(2))

Función cóncava

Sea f : X → R con X ⊂ Rn convexo, f es una función cóncava

⇔ ∀ x(1); x(2) ∈ X ∧ λ ∈ [0; 1]:

f[λ x(1)+(1 - λ)x(2) ] ≥ λ f(x(1))+(1 - λ) f(x(2))

f es estrictamente cóncava ⇔ ∀ x(1); x(2) ∈ X ∧ λ ∈ [0; 1]:

f[λx(1)+(1 - λ) x(2) ] > λ f(x(1))+(1 - λ) f(x(2))

Funciones cuasicóncavas- cuasiconvexas

Una función f es cuasicóncava (cuasiconvexa) si, ∀ x(1) ≠ x(2) ∈

X dominio convexo de f ∧ λ ∈ [0; 1]:

≥ f (x(1) )

f (x ) ≥ f (x ) ⇒ f λ.x + (1− λ)).x

(2)

≤ f (x )

(2)

(1)

[

(1)

(2)

]

Y lo será de manera estricta si las dos desigualdades débiles

de la derecha se sustituyen por desigualdades estrictas

> f (x(1))

< f (x(2))

51

Una función diferenciable f(x) con x ∈ Rn es cuasicóncava

(cuasiconvexa)

si ∀ x(1) ≠ x(2) ∈ X dominio de f:

n ∂f

( 2)

(1)

(

)

x

x

−

∑

i

i

i =1 ∂xi x (1)

( 2)

(1)

f (x ) ≥ f (x ) ⇒ n

≥0

f

∂

(

2

)

(

1

)

( xi − xi )

∑

x

∂

i =1 i x ( 2 )

Para la cuasiconcavidad y cuasiconvexidad estrictas la

desigualdad de la derecha tendrá que ser sustituída por la

desigualdad estricta “ > 0 ”

Si la función es dos veces continuamente diferenciable, la

cuasiconcavidad y cuasiconvexidad, en el ortante no negativo,

pueden verificarse estudiando el signo de los siguientes

menores principales de la matriz hessiana :

0 f1 f2 .....fn

f1 f11 f12 ..... f1n

f2 f21 f22 ..... f2n

........................

fn fn1 fn2 ..... fnn

52

∆2 = 0 f1

∆3= 0 f1 f2

f1 f11

f1 f11 f12

f1 f11 f12 ..f1n

f2 f21 f22

f2 f21 f22..f2n

...

∆n =

0 f1 f2 ...fn

....................

fn fn1 fn2.. fnn

Condiciones de Arrow-Enthoven

Son válidas en el ortante no negativo.

Condición necesaria

cuasiconcavidad

cuasiconvexidad

Condición suficiente

cuasiconca-

cuasicon-

vidad

vexidad

∆2

≤0

≤0

∆3

≥0

≤0

>0

<0

∆4

≤0

≤0

<0

<0

∆5

≥0

≤0

>0

<0

∆i

≤0

<0

<0

si i es par

si i es par

≥0

>0

si i es impar

∆n

<0

si i es impar

≤0

<0

53

Cualificación de restricciones (C.R.)

La C.R. se cumple:

Si todas las restricciones son funciones lineales

Si cada restricción es una función diferenciable y convexa,

y existe un punto x* perteneciente al conjunto factible en el

cual todas las restricciones son inactivas:

gj(x*) < 0 con 1 ≤ j ≤ m

Si

cada

función

(condición de Slater)

de

restricción

es

diferenciable,

cuasiconvexa, existe un punto x* perteneciente al conjunto

factible tal que

gj(x*) < 0

con 1 ≤ j ≤ m

y si además para cada j

-

o bien gj(x) es convexa

-

o bien para cada x*

→

∇ gj(x*) ≠ 0

entonces se cumple la C.R.

Las funciones gj(x) correspondientes a las restricciones que

están activas en x* tienen gradientes en x* que son

linealmente independientes.

La cualificación de restricciones es una restricción impuesta a

las

restricciones

aún

cuando

concerniente al conjunto factible.

54

no

es

una

limitación

Condiciones necesarias de Kuhn-Tucker

Suponiendo

x ( 0 ) = ( x 1( 0 ) ; x 2( 0 ) ;........ x n( 0 ) )

que

resuelve

el

problema:

max. f (x)

s.a. g j (x)≤ cj con1 ≤ j ≤ m ∧ x∈Rn

no estando acotada la cantidad de restricciones y donde f(x) y

gj(x) son funciones continuamente diferenciables. Suponiendo

que se verifica la C.R. Entonces,existen unos únicos números

λ1; λ2; ......... λm tales que:

a)

∂f ( x ( 0 ) ) m

∂g j

− ∑λj

= 0 con 1 ≤ i ≤ n

∂xi

∂xi

j =1

b)

gj (x(0)) ≤0 ∧ λj ≥0 ∧ λj gj (x(0)) =0 con1≤ j ≤m

Si se incluyen las condiciones de no negatividad

max. f (x)

→

s.a. gj(x)≤ cj con 1≤ j ≤ m ∧ x≥ 0 ∧ x∈Rn

m

[

L = f ( x) + ∑ λ j c j − g j ( x)

]

j =1

Serán:

Suponiendo que x(0) ∈ Rn resuelve el problema siendo la función

objetivo

y

las

restricciones

funciones

continuamente

diferenciables y suponiendo que se verifica la cualificación de

restricciones

entonces

existen

unos

únicos

números

λ1;

λ2;.........λm tales que

55

a)

∂L

≤0

∂xi x ( 0 )

xi ≥ 0

b)

∂L

≥0

∂λ j ( 0 )

x

λj ≥ 0

xi

∂L

=0

∂xi x ( 0 )

λj

∂L

=0

∂λ j ( 0 )

x

Condiciones suficientes de Kuhn y Tucker

Considerando el problema de programación no lineal

max. f (x)

Donde

la

s.a. g j (x) ≤ c j

función

→

con 1 ≤ j ≤ m ∧ x ≥ 0 ∧ x∈Rn

objetivo

y

las

restricciones

son

continuamente diferenciables, f es cóncava y las restricciones

son convexas. Suponiendo que existen

λj

Y un vector factible x(0) tales que:

a)

∂L

=0

∂xi x ( 0 )

b)

∂L

∂λ j

56

≥0

x

(0)

1≤ i ≤ n

λj ≥ 0

λj

∂L

∂λ j

=0

x

(0)

con 1 ≤ j ≤ m

Si se agregan las condiciones de no negatividad

a)

∂L

≤0

∂xi x ( 0 )

xi ≥ 0

xi

∂L

=0

∂xi x ( 0 )

Entonces x(0) resuelve el problema.

Si además se verifica la C.R. las condiciones son necesarias y

suficientes,

y si la función objetivo es estrictamente cóncava se puede

asegurar que el máximo global es único.

Condiciones necesarias y suficientes en programación

cuasicóncava (Arrow- Enthoven)

Sea el problema

max. f ( x)

Donde

la

→

s. a. g j (x) ≤ c j con 1 ≤ j ≤ m ∧ x ≥ 0 ∧ x ∈ R n

función

continuamente

objetivo

diferenciables.

y

las

restricciones

Suponiendo

que

son

existen

números λ j y un vector x(0) ∈ Rn tales que:

57

a)

x(0) es factible y se verifican:

b)

∂L

≤0

∂xi x ( 0 )

∂L

∂λ j

c)

d)

xi ≥ 0

λj ≥ 0

≥0

x( 0)

xi

∂L

=0

∂xi x (0)

λj

∂L

=0

∂λ j ( 0 )

x

f(x) es cuasicóncava y gj(x) es cuasiconvexa en el ortante

no negativo

e) Se satisface una cualquiera de las siguientes:

e-i

∂f

< 0 para al menos una variable xi

∂xi x ( 0 )

e-ii

∂f

> 0 para alguna variable xi que pueda tomar un

∂xi x ( 0 )

valor positivo sin violar las restricciones (xi en este caso es

llamada en la literatura del tema como variable relevante).

e-iii ∇f ( x

(0)

→

) ≠ 0 , y la función es dos veces diferenciable en

un entorno de x(0)

e-iv f(x) es cóncava

Entonces en x(0) la función se maximiza.

58

Es decir si además de verificarse a, b, c, d y e se satisface la

C.R., entonces las condiciones de Kuhn y Tucker son

necesarias y suficientes.

Problema

estandar

en

teoría

de

la

demanda

del

consumidor

Max.U(x) s. a. p1x1 + p2x2 + p3x3 +......+pnxn ≤ I

Suponiendo

que

U

es

continuamente

diferenciable

y

cuasicóncava. Las condiciones de Kuhn y Tucker son:

L = U(x) + λ ( I - p1x1 - p2x2 - p3x3 -.............-pnxn)

a)

∂L ∂U

=

− λp i ≤ 0

∂xi ∂xi

b)

n

∂L

= I − ∑ p i xi ≥ 0

∂λ

i =1

xi ≥ 0

λ≥0

xi ∂U − λpi = 0

∂xi

n

i =1

λ I − ∑ p i xi = 0

Suponiendo que x(0) ∈ Xn verifica a) y b) y suponiendo que no

todas las

∂U

son cero, o sea que se supone que para algún

∂xi x ( 0 )

bien no existe saciedad, (condición e-iv de Arrow-Enthoven), y

teniendo en cuenta que la función objetivo es cuasicóncava y

59

la restricción es lineal, se dan las condiciones suficientes de

óptimo.

n

Entonces a) implica que λ > 0 y así

∑px

i

i =1

i

= I por b).

Por lo tanto, se gasta todo el presupuesto y x(0) ∈ Xn resuelve

el problema.

Programación cuadrática:

Máx. f(x) = cT x – ½ xT Q x

s.a. g(j)(x) ≤ bj

que equivale a A x ≤ b (por ser restricciones lineales) ∧ x ≥ 0

donde:

c1

x1

b1

a11.............a1n

q11.........q1n

c2

x2

b2

a21.............a2n

q21........q2n

c=

x=

cn

b=

xn

A=

bm

Q=

am1............amn

qn1........qnn

la matriz Q es simétrica semidefinida positiva, lo que asegura

que la función objetivo sea una función cóncava

Las condiciones de Kuhn y Tucker son necesarias y

suficientes

60

cuando

en

el

problema

de

programación

matemática se maximiza una función cóncava y la región

de factibilidad es un conjunto convexo, como en este caso.

Algoritmo de Wolfe

Consiste en aplicar las condiciones de Kuhn y Tucker al

problema

de

programación

cuadrática,

reduciendo

el

problema a otro de programación lineal.

En el proceso

Ax+s=b

→

siendo λ s = 0

Analizando esta última relación:

λ>0

⇒

s=0 ⇒ Ax=b

λ =0

⇒

s≥0 ⇒ Ax≥b

Entonces nuestro problema quedará definido de la siguiente

manera:

n

Min W =

∑z

i =1

s.a. Q x + AT λ - β + C z = c xi ≥ 0

→

λj ≥ 0 λ s = 0

i

→

βx = 0

→

β≥0

A x + s =b

s≥0

61

Destaquemos que por (3) xi y βj no deben formar parte de la

solución factible básica al mismo tiempo, y que por (4) λj y sj

tampoco deben formar parte de la solución factible básica al

mismo tiempo.

Problema de selección de la cartera de valores

Bajo ciertos supuestos sobre el comportamiento del inversor

Markowitz supuso que la función de utilidad del individuo es

U = f [E(RP);σ( RP)]

con

∂U

>0

∂E (R P )

∂U

>0

∂σ (RP )

y

Entonces se plantea el problema

n

min V(R P )

con wi ≥ 0

s.a. E(R P ) = ∑ wi Ri

i =1

n

∧ ∑ wi = 1

i =1

1≤i≤n ∧ i∈N

Donde

V(RP) = [w1

62

w2 " wn ]

σ 11 σ 12 " σ 1n w1

σ

21 σ 22 " σ 2 n w2

#

#

# #

σ n1 σ n 2 " σ nn wn

Se puede demostrar que la función V(RP) es semidefinida

positiva (concepto amplio) y al ser las restricciones lineales se

puede resolver por programación cuadrática.

y se obtienen los wi que se reemplazan en la función objetivo

para calcular V ( RP ) min

y también σ(RP)min =

V ( RP ) min (riesgo mínimo)

n

y en E(R P ) min = ∑ wi Ri

(el valor esperado del rendimiento

i =1

cuando el riesgo es mínimo)

Esto proporciona el punto [σ(RP)min; E(RP)min] en el gráfico

E(RP)

E(RP)min

σ(RP)min

σ(RP)

Ahora planteamos el problema de hallar

Min. V(RP)

63

n

s.a.

∑w R

i =1

i

n

i

= E*(RP) ∧ ∑ wi = 1

con wi ≥ 0

i =1

Con el parámetro E*(RP) > E(RP)min

Obteniéndose los wi correspondientes a cada valor de E*(RP),

que se reemplazan en la función objetivo para calcular los

respectivos V ( R P ) y también los respectivos σ(RP) =

V ( RP ) .

Esto proporciona otros puntos [σ(RP); E(RP)] en el gráfico que

conforman la frontera eficiente

E(RP)

E(RP)5

E(RP)4

E(RP)3

E(RP)2

E(RP)1

E(RP)min

σ(RP)

σ(RP)min σ1(RP) σ2(RP) σ3(RP) σ4(RP) σ5(RP)

64

Bibliografía

ARMITANO O., EDELMAN J. y PALOMARES GARCÍA U.(

1985), “Programación no Lineal.”, México, Limusa

BALBÁS A. y

GIL J. A.(1987), “Programación Matemática” ,

España, Editorial AC,

BENAVIE Arthur ,(1972), “Técnicas Matemáticas del análisis

Económico”, España, Prentice Hall,

BERCK Peter y SYDSAETER Knut , 1994, “Formulario para

Economistas”, España, Bosch

BERNARDELLO, Alicia; VICARIO, Aldo ,(1999), “Condición de

segundo orden en la optimización libre y sujeta a restricciones

de igualdad”,(1999), XIV Jornadas

CARBONELL Lorenzo y PERIS Josep E.(1986), “Problemas de

Matemáticas para Economistas”, España, Ariel, S.A

CHIANG

Alpha

C.(1987),

“Métodos

Fundamentales

de

Economía Matemática”, España, McGraw-Hill

65

EPPEN, G. D,(2000), “Investigación de Operaciones en la

Ciencia Administrativa”, México, Prentice Hall

ESCOBAR URIBE Diego,(1998), “Introducción a la Economía

Matemática”,

Colombia, Grupo Editorial

Iberoamericana

FERNÁNDEZ-POL

Jorge

Eduardo,(1980),

“Lecciones

de

Programación no Lineal”, Argentina, Macchi

GUERRERO CASAS Flor M..(1994), “Curso de optización:

Programación Matemática”, España, Ariel

INTRILIGATOR Michael D, (1973), “Optimización Matemática y

Teoría Económica” España,

Prentice Hall.

LANCASTER Kelvin ,(1972), “Economía Matemática”, España,

Bosch.

LUENBERGER D. G.,(1989), “Programación Lineal y no

Lineal”, México, Addison- Wesley

66

MADDEN Paul ,(1987), “Concavidad y optimización en

Microeconomía”, España, Alianza

MESSUTI D. J., ALVAREZ V. A. y GRAFFI H. R.,(1992),

“Selección de

inversiones”, Argentina, Macchi MITAL K.

V.,(1984), “Métodos de optimización”,México, Limusa

SYDSAETER Knut y HAMMOND Peter ,(1996), “Matemáticas

para el análisis Económico”.España, Prentice Hall.

TAKAYAMA Akira, (1985. Reprinted 1997.), “Mathematical

economics”, Estados Unidos, Cambridge University Press

WESTON, Fred J. y WOODS, Donald H.,(1970), “Teoría de la

financiación de la empresa”,Barcelona, Gustavo Gilli S. A.

WINSTON Wayne L.,(1994), “Operations Research-Applications

and Algoritms”, third edition, Estados Unidos,. PWS-Kent.

67