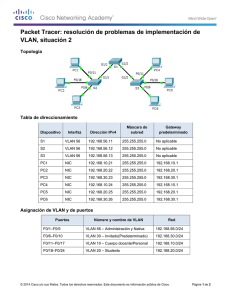

Redes Convergentes

Anuncio