tratamiento digital previo de las imágenes

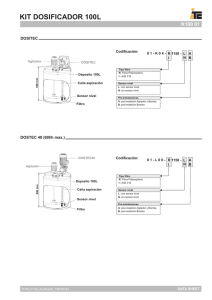

Anuncio

Master en Ingeniería Medioambiental y Gestión del Agua 2007/2008 Módulo VII: Sistemas de Información Geográfica y Teledetección TRATAMIENTO DIGITAL PREVIO DE LAS IMÁGENES AUTOR: JUAN GREGORIO REJAS AYUGA ©: Quedan reservados todos los derechos. (Ley de Propiedad Intelectual del 17 de noviembre de 1987 y Reales Decretos). Master en Ingeniería Medioambiental y Gestión del Agua 2007/2008 Índice INTRODUCCIÓN - Datos e información - Proceso en Teledetección - Tipos de sensores 1. FUENTES DE ERROR EN LA IMAGEN Fuentes de error en la imagen: instrumentales atmosféricas terreno Distinción: calibración-corrección 2. DISTORSIONES RADIOMÉTRICAS. CORRECCIÓN 2.1 DISTORSIONES - Efecto atmosférico - Distorsiones provocadas por el instrumento (offset y ganancia) 2.2 CORRECCIONES - Bandeado (sensores de barrido, desajustes calibrado) - Líneas o píxeles “perdidos” (fallos sensor o transmisión) - Normalización radiométrica horaria (teledetección aeroportada) - Corrección del efecto por columnas (sensores de barrido lineal) - Correcciones atmosféricas y conversión a reflectividad - Métodos basados en la imagen (Chávez, multialturas) - Método empírico, REF=F(ND) - Métodos basados en modelos de transferencia radiativa (6s, Modtran) 3. DISTORSIONES GEOMÉTRICAS. CORRECCIÓN 3.1 DISTORSIONES - Rotación de la tierra - Ancho del campo de visión - Curvatura de la Tierra - Variaciones de altitud, actitud y velocidad - Distorsión panorámica - Efecto del relieve CORRECCIONES SISTEMAS DE REFERENCIA. TRANSFORMACIÓN DE COORDENADAS - Sistema de referencia imagen - Sistemas de referencia espaciales 3.2 CORRECCIONES GEOMÉTRICAS - Corrección del efecto de rotación de la tierra - Corrección panorámica - Corrección del efecto de la curvatura terrestre Página 2 de 34 ©: Quedan reservados todos los derechos. (Ley de Propiedad Intelectual del 17 de noviembre de 1987 y Reales Decretos). Documentación elaborada por el autor/a para EOI. Prohibida la reproducción total o parcial sin autorización escrita de EOI. Master en Ingeniería Medioambiental y Gestión del Agua 2007/2008 3.3 CORRECCIÓN GEOMÉTRICA Y GEOREFERENCIACIÓN Métodos No Paramétricos - Métodos polinómicos - Funciones racionales Métodos Paramétricos - Modelización o corrección orbital - Ecuaciones de colinealidad - Georeferenciación Directa de imágenes 3.4 REMUESTREO DE LA IMAGEN - Vecino más próximo - Interpolación bi-lineal - Convolución cúbica 3.5 FUSIÓN DE IMÁGENES - Métodos y ejemplo 4. REALCES Y MEJORAS DE LA IMAGEN 4.1 REALCES VISUALES - Ajuste del contraste - Función brillo, contraste - Compresión del contraste - Expansión del contraste - Lineal - Cuadrático - Ecualización del histograma 4.2 FILTROS - Filtros de paso bajo - filtros de media - filtros de mediana - Filtros de paso alto - filtro de Sobel - filtro Edge Sharpening - filtro Direccional DIRECCIONES DE INTERNET BIBLIOGRAFÍA Y REFERENCIAS Página 3 de 34 ©: Quedan reservados todos los derechos. (Ley de Propiedad Intelectual del 17 de noviembre de 1987 y Reales Decretos). Documentación elaborada por el autor/a para EOI. Prohibida la reproducción total o parcial sin autorización escrita de EOI. Master en Ingeniería Medioambiental y Gestión del Agua 2007/2008 1. Fuentes de error El propósito de este capítulo es la discusión de la naturaleza de los errores geométricos y radiométricos en imágenes de teledetección que nos permita encontrar procedimientos de desarrollo computacional para usarlos en su compensación. Se pueden considerar las siguientes fuentes de error en la imagen: - Los producidos por los intrumentos Los producidos por la atmósfera Los producidos por el terreno Los errores se pueden clasificar de una manera genérica como: errores geométricos y radiométricos. Cuando los datos de las imágenes son registrados por sensores embarcados en satélites o en plataformas aeroportados estos pueden contener errores en geometría y en la medida de los valores de brillo (ND) de los píxeles. Este último efecto provoca los denominados errores radiométricos y pueden ser consecuencia de la instrumentación usada en registrar los datos, de la dependencia de la longitud de onda en la radiación solar y del efecto atmosférico. Los errores geométricos en la imagen se pueden deber a diversas causas. Errores sistemáticos y no sistemáticos, la curvatura de la tierra y variaciones incontroladas en posición y actitud de la plataforma del sensor pueden generar errores geométricos severos. Hay una serie de condicionantes externos a los sensores que afectan en las medidas de las superficies que adquieren los distintos sistemas. El grado de influencia puede ser mayor o menor dependiendo de la plataforma de la que procedan los datos. 2. Distorsiones radiométricas. Corrección Los mecanismos que afectan e intervienen en la medida de los valores de brillo de los píxeles pueden ser fuentes de distorsión radiométrica. En primer lugar, la distribución del brillo en la imagen para cada una de las bandas dadas puede ser diferente en la escena y en el terreno. En segundo lugar el ND relativo de un píxel singular de una banda a otra puede estar distorsionado comparado con la reflectividad espectral correspondiente a la región en el terreno. Ambos tipos de errores pueden ser el resultado conjunto de la presencia de la atmósfera y de la transmisión del medio en relación con la radiación que llega al sensor, y puede ser el resultado también de efectos en la instrumentación. 2.1 Fuentes de distorsión radiométrica 2.1.1 Efecto atmosférico en la radiación Las interacciones de la radiación solar directa y de la radiación reflejada por la superficie con los componentes atmosféricos interfieren con el proceso de transmisión de información por teledetección originando lo que se ha dado en llamar "efecto de la atmósfera". Los gases atmosféricos y los aerosoles, así como las nubes, dispersan y absorben la radiación solar y pueden, por tanto, modular la radiación reflejada por el objeto atenuándola, cambiando su distribución espacial e introduciendo 4 Master en Ingeniería Medioambiental y Gestión del Agua 2007/2008 en el campo de visión radiación de fondo procedente de la dispersión atmosférica. Como resultado la atmósfera puede afectar a la imagen aparente del objeto (la imagen observada por el sensor) de diferentes modos, dependiendo de varios factores: (a) la longitud de onda (b) la reflectividad de la superficie y su variabilidad espacial (c) las características del sensor (d) la aplicación de teledetección La atmósfera cambia de una fecha a otra y es necesario corregir los valores de las radiancias registrados por el sensor. DIFERENTES CONTRIBUCIONES A LA SEÑAL DETECTADA POR EL SENSOR En el caso ideal de ausencia de atmósfera, la señal medida por el sensor será una función simplemente del nivel de energía de la radiación incidente sobre el píxel y de las propiedades reflectivas de éste. Sin embargo, la presencia de la atmósfera puede modificar la situación de un modo significativo. En el supuesto de que no hubiera Atmósfera, la irradiancia solar espectral en el límite de la atmósfera será E(λ). Si el ángulo solar cenital es θs, entonces la irradiancia espectral sobre la superficie de la tierra será E(λ) cosθs. Esto dará una irradiancia disponible para la banda comprendida entre las longitudes de onda λ1 y λ2 que será E(λ) =λ2∫ λ1 E(λ) cosθs dλ (2.1.1) En teledetección, la anchura de la banda utilizada (Δλ = λ2 - λ1) es lo suficientemente estrecha como para suponer E(λ) ≈ E(Δλ) cosθs Δλ (2.1.2) E(Δλ) representa la irradiancia espectral media en la banda Δλ. Supongamos ahora que la superficie tiene una reflectividad ρ. Esta nos dice qué proporción de la energía incidente es reflejada. La radiancia dispersada en el hemisferio superior que será la que pueda ser observada por el sensor, será L = 1/π . E(Δλ) cosθs Δλ ρ (2.1.3) EL factor 1/π tiene en cuenta precisamente el ángulo sólido del hemisferio superior. Conociendo L es posible determinar la potencia detectada por el sensor y, por supuesto, el valor en ND que se proporciona en el producto digital de una imagen, y que está relacionado directamente con la radiancia de la escena. Así pues, la radiancia de una píxel determinado puede también expresarse como L = ND . k + Lmin 5 (2.1.4) Master en Ingeniería Medioambiental y Gestión del Agua 2007/2008 siendo Lmax y Lmin las radiancias máxima y mínima detectables por el sensor y función de la ganancia de éste. k = (Lmax - Lmin) / ND max (2.1.5) Consideramos ahora la situación real de atmósfera presente. Hay una serie de mecanismos, resultado de la absorción y dispersión de partículas de la atmósfera, que deben tenerse en cuenta. La Absorción por moléculas de la atmósfera es un proceso selectivo que convierte la radiación incidente en calor. En particular, las moléculas de oxígeno, dióxido de carbono, ozono, y agua atenúan la radiación intensamente en ciertas bandas. Los sensores que normalmente se utilizan para la observación de la tierra y del mar, se diseñan para operar fuera de estas bandas y así los efectos serán pequeños. La Dispersión es el mecanismo dominante y se presenta bajo dos formas distintas: la dispersión de RAYLEIGH, producida por las moléculas de los mismos gases, es una función de λ-4. La dispersión de MIE o dispersión por los aerosoles, se produce por partículas más grandes (de tamaño entre λ/10 y 10λ). Esta dispersión también depende de λ, pero no tan intensamente como la de Rayleigh. La dependencia con λ desaparece cuando las partículas son mucho más grandes, tales como la niebla, las de las nubes o las del polvo. Ahora se puede apreciar mejor el efecto que produce la atmósfera sobre la radiación que al final llega al sensor. Estos efectos son : (a) Transmisisvidad En ausencia de atmósfera la transmisividad es del 100%. Sin embargo, debido a la absorción y a la dispersión, no toda la irradiancia solar llega al suelo. La cantidad que llega, con relación a la que llegaría en situación de ausencia de atmósfera es, precisamente el coeficiente de transmisividad, TθS, que depende del ángulo cenital. Del mismo modo, también hay una transmisividad atmosférica, TθV, que debe considerarse entre el punto de reflexión y el sensor puesto que no toda la radiancia reflejada por la superficie, de hecho, llega al sensor. (b) Radiación difusa Puesto que la radiación es dispersada en su camino hacia abajo a través de la atmósfera, un píxel particular podrá ser irradiado no sólo por la radiación directa, sino también por la radiación procedente de los píxeles vecinos. Ésta última es la radiación difusa, Ed. Un píxel puede también recibir energía que ha sido reflejada por los píxeles de alrededor y entonces, por dispersión atmosférica, de nuevo ser dirigida hacia abajo originando un efecto de reflexión múltiple (albedo esférico) que no debe ser confundido con la dispersión múltiple. 6 Master en Ingeniería Medioambiental y Gestión del Agua 2007/2008 (c) Radiancia atmosférica De nuevo y debido también sólo al efecto de dispersión, la radiación procedente de las partículas atmosféricas puede alcanzar al sensor antes de llegar al suelo y contaminar la medida. Este término se denota por Lp. Habiendo analizado estos efectos, podemos ahora determinar de qué modo resulta afectada por la atmósfera la radiancia medida en el sensor. En primer lugar, la irradiancia que ahora llega a la superficie de la tierra es EG = E (Δλ) . TθS↓ . cosθs Δλ + Ed (2.1.6) Por simplicidad, se ha supuesto que la radiación difusa no es función de λ (en la banda que se considera). La radiancia, por tanto, que refleja el píxel será ahora LS = 1/π . ρ (E (Δλ) . TθS↓ . cosθs Δλ + Ed) (2.1.7) Finalmente, en el límite de la atmósfera, la radiancia total que medirá el sensor será LSEN = 1/π . ρ. TθV ↑. (E (Δλ) . TθS↓ . cosθs Δλ + Ed) + LP (2.1.8) Esta es la cantidad que debe entonces introducirse como radiancia registrada en el sensor en la ecuación del calibrado para relacionar la radiancia observada con el valor en niveles digitales que se proporciona. En el caso de superficie Lambertiana en el suelo, la señal detectada por el instrumento puede calcularse a partir de las estimaciones separadas de la transmisión gaseosa y de las funciones atmosféricas (reflectividad atmosférica intrínseca, transmisividad directa y difusa y albedo esférico). La heterogeneidad en la reflectividad de la superficie puede tenerse en cuenta de un modo aproximado estimando el efecto circundante por medio de una función de peso convenientemente establecida (Tanré, 1981). Las consecuencias directas más evidentes del efecto atmosférico en teledetección son: las imágenes aparecen oscuras, el ángulo de visión (FOV) tiene diferente camino atmosférico, y la dispersiones Rayleigh y Mie son diferentes para cada banda de imagen. 2.1.2 Distorsiones radiométricas provocadas por instrumento Errores radiométricos por banda de imagen y entre bandas pueden ser debidos a un fallo en el diseño del sistema sensor. Normalmente suelen ser errores sistemáticos, de corrección controlada. El más significativo de estos errores se debe al sistema detector. Estos errores se corrigen por calibración del instrumento, midiendo dos parámetros fundamentales que se utilizan para determinar parámetros físicos a partir del ND de la imagen, son el sesgo u “offset”, en terminología anglosajona, y la ganancia. Los sistemas de teledetección proporcionan estos parámetros para cada imagen. 7 Master en Ingeniería Medioambiental y Gestión del Agua 2007/2008 ganancia Canal NDBB1 1 2 3 NDmedio NDBB2 . . sesgo u “offset” Fig. 2.1. Características de transferencia de radiación de un detector y procedimiento de calibración de un instrumento (BB1 y BB2, cuerpos negros del sensor) 2.2 Correcciones radiométricas En contraste con la corrección geométrica, en donde todas las fuentes de error suelen ser son rectificadas conjuntamente, los procesos de corrección radiométrica tienen que ser específicos para la naturaleza de la distorsión. Las técnicas más habituales de corrección radiométrica son: 2.2.1 2.2.2 2.2.3 2.2.4 2.2.5 2.2.1 Corrección radiométrica del bandeado, en sensores de barrido producido por desajustes en el calibrado de los detectores. Corrección radiométrica de líneas o píxeles perdidos, producido por fallos del sensor o de transmisión de los datos Corrección o Normalización radiométrica horaria Corrección radiométrica del efecto por columnas Correcciones atmosféricas (i) Métodos basados en la imagen (método de Chávez, método multialturas) (ii) Método empírico: ref=F(ND) (iii) Método basado en modelos de transferencia radiativa (6s, Modtran) (iv) Conversión de nivel digital a reflectividad CORRECCIÓN RADIOMÉTRICA DEL BANDEADO Se consigue eliminar este efecto desplazando los histogramas parciales de la imagen, de tal manera que obtengamos el mismo valor promedio y misma desviación típica que para toda la banda (k). La función que se aplica es ND’i,j = akNDi,j + bk 8 (2.2.1) Master en Ingeniería Medioambiental y Gestión del Agua 2007/2008 donde ND’i,j es el nivel digital corregido, NDi,j es el nivel digital que presenta el efecto de bandeado, ak y bk son los coeficientes para la banda k del ajuste de histogramas parciales (de la parte de imagen defectuosa) respecto al histograma general. Fig. 2.2 Imagen térmica ATM con bandeado (izqª) y corregida de este efecto (dchª). 2.2.2 CORRECCIÓN DE PÍXELES Y LÍNEAS PERDIDAS Usualmente existen tres formas de corregir o predecir el ND de esos píxeles o líneas perdidas. Son : - 2.2.3 Se asigna el ND del píxel vecino de la línea inmediatamente anterior o de la siguiente. Otra forma es asignar, en lugar del valor directo, el valor promedio entre línea anterior y posterior a la defectuosa. Quizás la forma más refinada, aunque siga siendo una predicción, sea la de asignar el ND de otra banda altamente correlacionada con la defectuosa y que no presente esos píxeles o líneas perdidas. CORRECCIÓN O NORMALIZACIÓN HORARIA Esta corrección se aplica en trabajos con imágenes adquiridas en el mismo día a diferentes horas. Los ND deben cumplir unas condiciones para que dos superficies con la misma reflectividad den el mismo ND: • • • • misma ganancia y sesgo misma iluminación solar (misma hora) mismo ángulo de incidencia solar, que implica misma hora y/o misma topografía del terreno mismo efecto atmosférico La normalización horaria consiste en corregir el ND de una escena con un factor que considera la variación del flujo solar incidente en esa escena respecto a una escena de referencia. Es una corrección destinada a homogeneizar el ND cuando la zona de estudio. La corrección se basa en la hipótesis de que el ND es linealmente dependiente del flujo solar incidente, lo cual es cierto en primera aproximación. 9 Master en Ingeniería Medioambiental y Gestión del Agua 2007/2008 La normalización horaria, corrección por distinta hora de adquisición, es inmediata: el flujo recibido por una superficie horizontal se incrementa según el coseno del ángulo cenital. El modelo que relaciona el flujo recibido en la superficie con el ND registrado, ND = m (Τ*ρ*Eo cosθ + La) + n (2.2.2) siendo m y n coeficientes de calibración del sensor, permite despreciando n y suponiendo que La es igualmente proporcional al cosθ, suponer que el ND también es finalmente proporcional al coseno del ángulo cenital (De Miguel, 1999). Por tanto podemos aplicar la siguiente corrección: NDn = NDh (cosθn / cosθh) (2.2.3) Es decir, el ND a una hora normalizada “n” es igual al obtenido en la hora “h” corregido con el cociente entre el ángulo cenital a la hora de referencia y el de la hora "h". 2.2.3 CORRECCIÓN RADIOMÉTRICA POR COLUMNAS Esta corrección es aplicable a equipos de barrido lineal. Las hipótesis de partida que se adoptan para realizar esta corrección son: (1) No existe iluminación diferencial en los píxeles de la misma imagen (2) La distribución de la respuesta espectral de la superficie de la tierra es aleatoria. Existe, por lo tanto, diversidad en esa respuesta y no se sigue ningún patrón definido. La corrección por columna se realiza tras comprobarse empíricamente que existe una atenuación de la señal recibida en los píxeles más lejanos al nadir. La comprobación se puede realizar de dos maneras: (a) observando el ND medio para cada columna de imagen para el conjunto de los datos obtenidos. (b) observando el ND registrado sobre superficies que aparecen en dos pasadas. Ha de considerarse que hay otros factores, como la diferente hora de adquisición y los efectos de la BDRF, que determinan un diferente ND para un mismo objeto. El procedimiento se basa en la hipótesis de que en el nadir el escáner está registrando la energía de una forma correcta. El factor de corrección para cada banda por columnas se obtendrá dividiendo ese valor de ND supuesto si la medida hubiese sido nadiral (ND') por el ND medio por columnas. factorc_i = ND' / NDcolumna 10 (2.2.4) Master en Ingeniería Medioambiental y Gestión del Agua 2007/2008 Fig. 2.3 Canal 1 ATM, con efecto de columnas (izqª) y corregido (dchª) 2.2.4 (i) Corrección atmosférica Métodos basados en la imagen El método ideado por Chávez, se trata de una operación sencilla, que actúa aminorando el efecto atmosférico. No obstante, seguiremos hablando de reflectancias aparentes ya que, si bien se trata de una aproximación a la corrección atmosférica, ésta no se realiza con la intervención de datos de verdad terreno, y seguimos asumiendo un terreno plano y una observación vertical, lo cual supone una simplificación grosera de la realidad. efecto atmosférico El método está basado en el hecho de que áreas cubiertas con materiales de fuerte absortividad (agua, zonas de sombra) deberían presentar una radiancia espectral muy próxima a cero. Esto no se suele producir, debido precisamente a la dispersión atmosférica y se presentan valores superiores a cero, más grandes cuanto más corta sea la banda (por la dispersión de Rayleigh y Mie). Por lo tanto, y siguiendo estas premisas, restaremos los ND mínimos a todos los ND de cada banda, según se indica en esta expresión: NDi,j,k´= NDi,j,k - NDmin,k Fig. 2.4 Efecto atmosférico en bandas de TM 11 (2.2.5) Master en Ingeniería Medioambiental y Gestión del Agua 2007/2008 El método multialturas responde a una técnica habitual en teledetección aerportada, dónde es técnicamente posible la adquisición de imágenes de la misma zona a diferentes alturas, con diferente camino atmosférico por lo tanto. La operación para eliminar el aporte atmosférico de la imagen alta respecto a la baja también es directa. El ND corregido será la diferencia para cada banda del ND alto menos el ND bajo, imagen esta última en donde se desprecia la aportación de la atmósfera. (ii) Método empírico Esta corrección se realizaría a partir de datos de reflectancia medidos en el terreno con correspondencia en la imagen, y tomados en el momento de su adquisición. Los datos terreno se pueden obtener a partir de medidas con radiómetros o espectro-radiómetros de campo, en los que también se tomarán medidas de posicionamiento para su geo-referenciación en la imagen y su localización si se pretende realizar un seguimiento temporal en esas cubiertas. Para desarrollar este segundo procedimiento necesitaríamos, por tanto, los siguientes datos: - reflectancia medida sobre el terreno reflectancia aparente ( o sin corrección atmosférica) obtenida a partir de lo ND de la imagen. Una hipótesis necesaria es que puntos del terreno con idéntica reflectancia deben tener valores muy similares de ND. Una vez se han depurado ambos datos, imagen-terreno, el procedimeinto es realizar una regresión a partir de los pares de puntos de que se dispone. Esta regresión determina una relación r = F(r aparente), que es aplicada a cada pixel de la imagen. También puede optarse por la relación r = F(exp(r aparente), aunque el resultado será muy similar al de la regresión simple. Se puede establecer un modelo empírico, a partir de los datos de reflectividad medidos en el terreno con correspondencia en la imagen (Kollewe, 1996). El planteamiento general es: ! Se dispone de una lista de pares de puntos (ρ terreno, ND), para cada banda. Esta lista se podría completar con superficies de la que se asumiera su reflectividad con suficiente exactitud, como embalses u otros. ! Los puntos se representan en un diagrama para visualizar la posible relación entre ambos. Usualmente hay que buscar una relación lineal o cuasi-lineal. ! Efectuamos la regresión para cada canal aplicando distintos modelos. 12 Master en Ingeniería Medioambiental y Gestión del Agua 2007/2008 Plot of Fitted Model 0.2 REF_2 0.16 0.12 0.08 0.04 0 1.9 2.9 3.9 4.9 5.9 6.9 exp(P8_ND2/100) Fig. 2.5 Ejemplo de modelo exponencial: REFch = a + b *EXP(ND ch /100) Evaluamos su error y depuramos iterando lo necesario quedándonos con el mejor modelo de regresión que aplicaremos a las imágenes. (iii) Mediante un modelo de transferencia radiativa Gracias a él podremos deducir la reflectancia en el terreno a partir de la señal medida y de un caracterización de la atmósfera. Para este caso se puede disponer de un modelo desarrollado por uno mismo o de un modelo implementado en software comercial, como es el caso del conocido 6S (Vermote et al., 1995) o del Modtran. Para desarrollar este modelo necesitaremos conocer varios parámetros: - radiancia registrada en el sensor datos de iluminación para esa fecha concreta datos atmosféricos para esa fecha también A partir de estos datos nuestro modelo determina una transformación que permite obtener la reflectancia corregida atmosféricamente. Estos modelos nos permiten simular: – – señal que recibe un sensor a bordo de satélite/avión reflectividad en el terreno para la radiancia registrada por dicho sensor. En principio no necesita de medidas tomadas en campo, y se basa en una modelización de la atmósfera, empleando usualmente modelos de atmósfera y aerosoles para amplias regiones de la Tierra. Este método está encaminado a corregir el aporte atmosférico en la señal registrada por el sensor, según la expresión que hemos visto ya (2.1.8) Es natural esperar que la corrección del efecto atmosférico pueda ser útil para mejorar la calidad de los datos de teledetección y producir señales que estarán mejor relacionadas con las características de las superficies. En general, los algoritmos de corrección atmosférica básicamente desarrollan dos etapas. En primer lugar, deben estimarse las características ópticas de la atmósfera, las cuales 13 Master en Ingeniería Medioambiental y Gestión del Agua 2007/2008 pueden medirse o modelizarse por medio de algoritmos de transferencia radiativa. En segundo lugar, pueden aplicarse métodos de inversión que permitan deducir las características ópticas de la superficie, por ejemplo la reflectividad, a partir de la radiancia medida. Los efectos de dispersión molecular y de absorción pueden ser tenidos en cuenta de un modo satisfactorio ya que son prácticamente invariables en el espacio y en el tiempo. La dispersión por los aerosoles es la componente variable principal del efecto atmosférico para superficies oscuras, mientras que la absorción es importante para superficies más claras (Fraser y Kaufman, 1985). Para realizar la corrección atmosférica de datos de teledetección, es necesario conocer las características ópticas de la atmósfera. Atmósferas estándar Precisamente por la dificultad de conocer características reales de la atmósfera y para poder realizar cálculos de transferencia radiativa, se han definido por los investigadores un pequeño número de modelos de atmósferas medias y extremas que, sin reflejar condiciones reales, pueden sin embargo ser suficientes para la intercomparación de diferentes esquemas ya que reflejan ciertas condiciones medias seleccionadas (McClatchey et al., 1986). Desde ese punto de vista, estos mode- los pueden utilizarse como primera aproximación cuando se trate de atmósferas claras, sin nubes. Modelos de Aerosoles Estas atmósferas tipo utilizan a su vez modelos de aerosoles que cubren una gran variedad de condiciones desde el nivel del mar hasta la mesosfera. Fig. 2.6 Albedo atmosférico resultado del modelo de transferencia radiativa 6S Los coeficientes de transformación que proporcionan estos modelos de transferencia radiativa dependen no sólo de las condiciones atmosféricas, sino también de la reflectancia de la superficie observada y de su entorno. En rigor, por tanto, deberían calcularse para cada pixel de la imagen. Sin 14 Master en Ingeniería Medioambiental y Gestión del Agua 2007/2008 embargo esto no es operativo, y además la caracterización de la reflectancia del pixel y de su entorno debería ser necesarimente muy aproximada, por lo que una estimación general no es muy diferente. (iv) Conversión de ND a reflectividad Vamos a tratar esta conversión que no puede ser considerada en rigor como una corrección. En primer lugar debemos obtener la radiancia espectral medida por el sensor como consecuencia de la reflexión de la radiación electromagnética en las cubiertas (junto con la influencia de la atmósfera). A partir de los coeficientes de calibración específicos para cada sensor, podremos obtener la radiancia espectral sirviéndonos de los ND promedio para cada cubierta de estudio . Para ello utilizaremos la siguiente expresión: L sen,k = n 0,k + m l,k NDk (2.2.6) donde: L sen,k , corresponde a la radiancia espectral recibida por el sensor en la banda k n 0,k y m l,k son los coeficientes de calibración para esa banda NDk corresponde al nivel digital de la imagen en la misma banda. Por otro lado, la radiancia que llega al sensor (asumiendo que las superficies tienen un comportamiento lambertiano), es una función de la irradiación solar, la reflectividad de la cubierta y las condiciones de adquisición: L sen,k = (E 0,k cos θ i ρ *k) / (K ∏) (2.2.7) donde: E 0,k es la irradiancia solar en el techo de la atmósfera, ρ *k es la reflectividad aparente de la cubierta en esa banda k θ i es el ángulo cenital del flujo incidente (formado por la vertical y los rayos solares) K es el factor corrector de la distancia Tierra-Sol, calculado como: K = (1 + 0.0167 (sen (2 ∏ (D - 93.5) / 365))2 (2.2.8) donde: D indica el día en el calendario juliano y el seno se asume en radianes. Despejando la reflectividad aparente, obtenemos la siguiente fórmula: ρ *k = (K ∏ L sen,k) / (E 0,k cos θ i) (2.2.9) Finalmente, obtenemos los valores (%) de reflectancia aparente de las superficies, parámetro primario en estudios habituales de teledetección. 15 Master en Ingeniería Medioambiental y Gestión del Agua 2007/2008 3. Distorsiones geométricas. Corrección Con el nombre de Corrección Geométrica se engloban las técnicas de corrección de las distorsiones que producen las principales fuentes de error en el momento de la adquisición de la imagen, como son el cabeceo (pitch), alabeo (roll), giro lateral (yaw) y las provocadas por la trayectoria, altura y velocidad de la plataforma que sustenta al sensor. A estas hay que añadir los efectos del relieve y de la esfericidad terrestre. Así mismo, se incluyen en estas técnicas las de georeferenciación, es decir, las de asignar una posición geográfica a los píxeles de nuestra imagen. 3.1 Fuentes de distorsión geométrica Los principales factores o fuentes de error geométrico en la imagen son: - rotación de la tierra ancho campo de visión de algunos sensores curvatura de la Tierra variaciones de altitud, actitud y velocidad de la plataforma efecto panorámico relieve del terreno Estas fuentes de error van a producir unas distorsiones desde el punto de vista geométrico que pueden ser tratadas en la mayoría de los casos conjuntamente, es decir, aplicando una corrección se pueden minimizar los errores procedentes de distintas fuentes. 3.2 Correcciones geométricas En este punto vamos a tratar los procedimientos más habituales exclusivamente de corrección, es decir, de alteración de la posición del píxel en la imagen sin llevar implícito una georeferenciación, punto que veremos posteriormente. 3.2.1 Corrección geométrica del efecto de rotación de la Tierra Este efecto es más evidente sobre todo en barredores de línea como el MSS y TM de Landsat, AVHRR de NOAA o el HRV de SPOT. Durante el tiempo de adquisición de la escena de imagen la Tierra está rotando de oeste a este, lo que produce que un punto al final de la adquisición presente un importante desplazamiento al este. Para proporcionar la posición relativa correcta de los píxeles en el terreno es necesario desplazar la imagen hacia el oeste siguiendo el movimiento del terreno durante la adquisición de la imagen, desplazando proporcionalmente las líneas. Habrá que contemplar las velocidades del satélite y de rotación de la Tierra. Se deduce, (Richards, 1998) que la expresión de corrección es ΔX = ΔXe cosδ (3.2.1) siendo ΔXe = ve ts, donde ve es la velocidad angular y ts el tiempo de adquisición de la imagen. 16 Master en Ingeniería Medioambiental y Gestión del Agua 2007/2008 3.2.2 Corrección geométrica de la distorsión panorámica Si el IFOV es constante, la visión lateral de la escena induce por lo tanto diversas alteraciones en la geometría de la imagen. • El tamaño de píxel de escena es mayor a medida que nos alejamos de nadir, pero se registra sobre el mismo tamaño de píxel del detector, luego existe una disminución de resolución espacial en estas zonas. • La forma de píxel escena es aproximadamente la de un trapecio isósceles (con sus lados paralelos orientados paralelamente a la trayectoria del avión). • A medida que nos alejamos de nadir aumenta la distancia entre los centros de dos píxeles de escena consecutivos. Estos fenómenos de distorsión panorámica se producen cuando la dirección de apuntamiento del instrumento se aleja de nadir, ya sea por tener un gran campo de visión (entonces sólo afecta a los extremos de la imagen) o bien por una imagen tomada con un importante ángulo de alabeo (dirección de movimiento perpendicular a la de desplazamiento del sensor). El efecto que produce la distorsión panorámica es una alteración de la geometría de la imagen y de los detalles en los bordes de la misma. La contribución de la curvatura terrestre a este fenómeno sólo es apreciable a grandes distancias de la superficie terrestre, y para posiciones alejadas de nadir, por lo que esta contribución no afecta a las imágenes aeroportadas que estamos utilizando. Fig. 3.1 Efecto panorámico Se parte de la imagen original. Se calcula la resolución del nadir. Se calcula el número de píxeles finales y el factor de corrección a aplicar. Se aplica una corrección utilizando la relación (ver Fig.3.1): SN/TN = θ / tanθ 17 (3.2.2) Master en Ingeniería Medioambiental y Gestión del Agua 2007/2008 siendo θ el FOV del instrumento para cada momento, SN la distancia corregida de un píxel al nadir y TN la distancia a corregir del píxel al nadir. La corrección aplicada es proporcional al FOV y distinta para cada píxel de la línea de imagen considerada. Fig. 3.2 Imagen ATM con efecto panorámico (izqª) y corregida de él (dchª) 3.2.3 Corrección geométrica del efecto de la curvatura de la Tierra Los sistemas aeroportados de teledetección no están afectados de una manera sustancial por este efecto. Es en los sistemas espaciales donde las distorsiones que produce son más evidentes. La inclinación de la órbita del satélite o la propia cobertura espacial de las imágenes hacen que la curvatura de la Tierra produzca un efecto parecido al ya visto de distorsión panorámica, es decir, el tamaño del píxel es mayor en los extremos de las imágenes. EL TAMAÑO DEL PIXEL EN LA DIRECCIÓN NORMAL A LA TRAYECTORIA DEL SATÉLITE ES β [h + re (1-cosϕ)] secγ (3.2.3) siendo β el ángulo de visión instantáneo, h la altura del sensor, re el radio de la Tierra, ϕ el ángulo de deriva y γ es el ángulo de barrido. La geometría del píxel efectivo en la superficie inclinada de la Tierra (en los extremos de la imagen) se puede deducir del la figura y es pc = β [h + re (1-cosϕ)] secγ sec(γ +ϕ) (3.2.4) Fig. 3.3 Efecto de la esfericidad terrestre 18 Master en Ingeniería Medioambiental y Gestión del Agua 2007/2008 3.3 Corrección geométrica y geo-referenciación Estos procedimientos implican una alteración de la situación y forma original del píxel en la imagen y una asignación de posición en un sistema de referencia geográfico. 3.3.1 Métodos no paramétricos En estos métodos los parámetros de transformación de los diferentes modelos se deducen a partir de puntos de control, es decir, a partir de puntos con coordenadas conocidas en el sistema de referencia terreno (X,Y) y en el sistema imagen (x,y). (i) Métodos polinómicos El primer modelo geométrico en utilizarse fue el polinómico de tipo 2D, no orbital y sobre un sistema cartesiano de coordenadas determinado por una proyección cartográfica. Asume que no se conocen las fuentes de los errores, pero que éstos pueden modelizarse a partir de ajustar unas ecuaciones a un conjunto de puntos, de los que se conoce tanto las coordenadas imagen a corregir como las de un mapa de referencia. Lo expresamos de la siguiente forma: ci = a0 + a1 Xi + a2 Yi li = b0 + b1 Xi + b2 Yi (3.2.4) donde ci y li son las coordenadas estimadas columna y fila, respectivamente, para unas coordenadas determinadas del mapa Xi e Yi . Este modelo es válido para territorios en los que existe poco rango de variación altimétrica. Si este no es el caso, como ocurre en nuestra imagen, debemos aumentar el rango de los polinomios o introducir en los mismos términos que dependan de las elevaciones. El modelo quedaría de la siguiente forma: ci = a0 + a1 X1 + a2 Yi + a3 Z1 + a4ZiX1 + a5ZiY1 li = b0 + b1 X1 + b2 Yi (3.2.5, Palá y Pons, 1995) Fig. 3.4 Órdenes de los polinomios (izqª), imagen TM original (centro) e imagen corregida (dchª) 19 Master en Ingeniería Medioambiental y Gestión del Agua 2007/2008 (ii) Funciones “Thin plane spline” Se trata de un método relativamente novedoso basado en las siguientes funciones: U(x,y)0 = a1 + a2 * x + ai=N,1 * yi + SUM F * ri * ln(ri ) (3.2.6) donde, ri2 = (x - xi)2 + (y - y i )2. Se trata de un proceso iterativo, en donde x,y son las coordenadas de los puntos de control y xi,yi son las que se van deduciendo en las diferentes iteraciones. Necesita de puntos de control, es un método muy eficaz, ya que hace “pasar” a la función por los puntos de referencia, no como en un ajuste por mínimos cuadrados. Por contra, no nos permite estimar directamente el error que cometemos en el mismo. Para ello habrá que realizar un control de errores independiente del método. 3.3.2 Métodos Paramétricos En estos métodos hay una serie de parámetros que intervienen en los diferentes modelos generados, y que se introducen de forma directa proporcionados por sistemas e instrumentación de posicionamiento y navegación auxiliares. (i) Modelización o Corrección orbital Se trata de realizar transformaciones inversas a las que realiza el sensor en el momento de la adquisición. Para ello se deben conocer con suficiente precisión las características orbitales de la plataforma y las especificaciones del sensor. Podemos resumir los modelos comúnmente más usados para describir órbitas en: Modelo polinómico. Se establecen 3 polinomios función del tiempo o de la línea para las 3 coordenadas geocéntricas de los puntos orbitales. Órbita circular. Con los parámetros de anomalía inicial, el nodo ascendente, la inclinación orbital y el radio orbital respecto al centro de la Tierra podemos modelizar la órbita. Órbita Kepleriana. Se utilizan los seis elementos Eulerianos: semieje mayor de la elipse, excentricidad de la órbita, inclinación orbital, nodo ascendente, argumento del perigeo y tiempo de paso por el perigeo. Además se suele considerar la posición y velocidad de un punto de la órbita. (ii) Ortorectificación Existe otro procedimiento, basado en un modelo ampliamente utilizado en aplicaciones fotogramétricas, que incorpora términos en los que se tiene presente las elevaciones del terreno. Nos referimos a la Ortorectificación. El resultado de este proceso es una imagen en la que se elimina la variación de escala y los desplazamientos debidos al relieve y a la inclinación (tilt). Estas distorsiones son muy evidentes sobre todo en Teledetección aeroportada, en donde es imprescindible tenerlos presentes. 20 Master en Ingeniería Medioambiental y Gestión del Agua 2007/2008 El proceso de ortorectificación está basado en el modelo matemático de las Ecuaciones de Colinealidad, principio que supone que el punto imagen, el punto objeto y el centro óptico del sensor están alineados. De esta condición se deducen las siguientes ecuaciones: → → → Xm = X0m + λ Rpm . xp (Cramer, 1998) donde: → Xm, son las coordenadas (Xi,Yi,Zi) de los puntos objetos en el sistema de referencia terreno → X0m, coordenadas (X0,Y0,Z0) del centro perspectivo del sensor en el sistema de referencia terreno Rpm = Rpm (ω,ϕ,κ), matriz de rotación de la imagen p en el sistema de referencia terreno → p x , coordenadas del punto imagen en el sistema imagen λ, factor de escala Observando las ecuaciones podemos apreciar cómo intervienen en ellas las elevaciones del terreno en forma de esas Zi. Es fácil comprender que si intervienen en el modelo las elevaciones (en forma, por ejemplo, de Modelos Digitales de Elevaciones, MDE), los giros de actitud de la plataforma (proporcionados, por ejemplo, por un sistema de navegación inercial, IMU) y la posición del sensor, será más fácil y efectivo la corrección geométrica de esos efectos. Fig. 3.5 Fotograma en color original de cámara RC-10 (izqª) y fotograma ortorectificado (dchª) 21 Master en Ingeniería Medioambiental y Gestión del Agua 2007/2008 (iii) Georreferenciación Directa Lo que se ha venido en llamar Georreferenciación Directa (GD) es ya una realidad para un gran número de aplicaciones de fotogrametría aérea, y en la mayoría de las de teledetección aeroportada. Se trata de una técnica que utilizando los parámetros de orientación externa, posición y actitud, medidos por un sistema inercial formado por un receptor GPS y una IMU (Inertial Measurement Unit) posibilita la rectificación de las imágenes adquiridas por distintos sensores ópticos (cámaras matriciales, escáneres lineales de empuje y escáneres lineales de espejo giratorio) y no ópticos (Radar, Lídar) en un proceso automatizado. Este método repercute positivamente en los costes y optimiza las campañas de adquisición y el preprocesamiento de los datos. Entre estas tareas de calibración principales que hay que abordar está el alineamiento de la IMU respecto del sistema de referencia espacial del sensor, actividad conocida como calibración de boresight. Una vez que se han resuelto favorablemente los distintos procesos de calibración que intervienen, se puede aplicar directamente a las imágenes los datos de orientación externa medidos por el sistema inercial siguiendo alguna particularización para el tipo de sensor del modelo matemático de colinealidad. ϕ y POI (f,pp,K1..Kn,P1,P2,t) GPS Centro de fase de la antena POE (X0,Y0,Z0,ω,ϕ,κ) Z x H ω κ Pi s R ri rmSensor z Y Y Lever arms Pg IMU X Z SENSOR Y Centro sistema referencia IMU X rmObjeto Dirección de vuelo Z Centro óptico del sensor X Sistema de Referencia Terreno Fig. 3.5.2. Parámetros involucrados en Georreferenciación Directa y subsistemas (GPS,IMU, sensor). 1000 m AHS 20,10,4 res. 3m 05/2004 Parque Nacional de Doñana, El Rocío Fig. 3.5.3 Imagen hiperespectral AHS georreferenciada directamente a partir de GPS/IMU (INTA-IGME). 22 Master en Ingeniería Medioambiental y Gestión del Agua 2007/2008 3.4 Remuestreo de la imagen Una vez que tenemos la imagen en su “situación” corregida, hay que transferir el nivel digital empleando para ello el de la imagen original. Se pude hacer de tres formas: i. ii. iii. Vecino más próximo, en la celda de la imagen corregida el ND corresponde al del píxel más cercano de la imagen original. Interpolación bi-lineal, promedia los ND de los cuatro píxeles más cercanos en el original. Difumina contrastes espaciales de la imagen original Convolución cúbica, considera los ND de los dieciséis píxeles más próximos. Requiere un volumen de cálculo elevado. Fig. 3.4 Remuestreo de la imagen. 23 Master en Ingeniería Medioambiental y Gestión del Agua 2007/2008 3.5 Fusión de imágenes Las técnicas de fusión de datos en teledetección se desarrollan debido al condicionante de diseño de los sensores de adquisición de imágenes, ya que gracias a éste se produce una relación inversa entre la resolución espectral de los mismos y la resolución espacial a que pueden registrar datos. Por este motivo se han desarrollado metodologías cuyo objetivo último es transformar las imágenes multiespectrales incorporando el detalle espacial a partir de canales pancromáticos de alta resolución. Para hacer referencia a este concepto se emplean habitualmente términos "correlación multiresolución", "integración multifuente" o "fusión de datos", entre otros. Nosotros nos referiremos a estas técnicas como fusión de imágenes. 3.5.1 Métodos de fusión de imágenes Las técnicas principales de fusión de imágenes se pueden dividir en los siguientes grupos: - Técnicas HIS y Técnicas PCA Tienen en común la proyección de los datos originales en otro espacio, la sustitución de un vector por otro de una imagen de alta resolución y la proyección inversa en el otro espacio. Entre estos métodos están el de transformaciones IHS, Intensidad, Tono y Saturación, y el método de PCA o de componentes principales. El método IHS consiste en transformaciones RGB a imágenes de I, H, y S. La componente I se sustituye por la imagen pancromática cuyo histograma se ha igualado previamente al de la imagen I. La transformación IHS inversa permite obtener la imagen RGB fusionada, a la que se ha incorporado el detalle espacial de la imagen pancromática. En el método de PCA, la primera componente, habitualmente, es reemplazada por la imagen pancromática, cuyo histograma se ha igualado previamente con el de la primera componente. Finalmente se aplica el análisis de PCA inverso al conjunto de los datos formado por la imagen pancromática modificada y las otras componentes principales y se obtienen las nuevas bandas fusionadas a las que se ha incorporado el detalle de la imagen pancromática. - Técnicas de combinaciones aritméticas Métodos de contribución espacial relativa. La técnica que utiliza estos métodos consiste en combinaciones aritméticas entre bandas. Entre los más habituales está la transformación de Brovey, implementada en los programas de tratamiento de imágenes ERDAS y Geomática (anterior PCI). La transformación de Brovey emplea la suma, división y multiplicación de la fusión de bandas multiespectrales. Básicamente el proceso se realiza en tres fases: (1) añadir las bandas multiespectrales para sumar una única imagen, (2) dividir cada banda multiespectral por la imagen suma y (3) multiplicar cada cociente por la alta resolución del pancromático. Multii Se puede expresar según la ecuación : Fusión i = ⎯⎯⎯ x Pan Multisum 24 (exp.1) Master en Ingeniería Medioambiental y Gestión del Agua 2007/2008 donde i son el número de bandas multiespectrales y Multisum = Multi1+Multi2+...+ Multii - Técnicas basadas en transformaciones wavelet Técnicas basadas en transformaciones en distintos niveles de resolución. Las transformaciones de wavelet son una herramienta matemática desarrollada en el campo del procesamiento de la señal. Se puede descomponer una imagen en un set de de imágenes multiresolución acompañadas de coeficientes de wavelet para cada nivel de resolución. La fusión basada en transformaciones de wavelet consiste básicamente en: (1) descomponer la imagen pancromática en un set de imágenes de baja resolución con coeficientes wavelet para cada nivel, (2) reemplazar una baja resolución pancromática con una banda multiespectral al mismo nivel de resolución, (3) realizar una transformación inversa de wavelet para convertir el set descompuesto y reemplazado al nivel de resolución del pancromático original. El reemplazamiento e inversión de la transformación se realiza en los pasos sucesivos correspondientes al número de bandas multiespectrales. Fig. 3.5 Ejemplo de fusión por método de wavelets de imagen pancromática de cámara digital aMDC (izq.) e imagen ATM de Daelaus 1268 (centro). 25 Master en Ingeniería Medioambiental y Gestión del Agua 2007/2008 4 Realces y mejoras de la imagen Se conoce con este término a un conjunto de técnicas encaminadas a situar o disponer mejor de los datos, con el objetivo de facilitar el análisis visual de la imagen, y hacer que se “presente” toda la variabilidad que se ofrece en la imagen. 4.1 AJUSTE DEL CONTRASTE Son los procesos que tienden a adaptar la resolución radiométrica de la imagen a la capacidad de visualización del monitor. Se presentan dos opciones, que darán lugar a dos técnicas distintas de ajuste. Por un lado, que el rango de ND de la imagen sea menor que el número de visualización (NV) que facilita la memoria gráfica del ordenador y por otro, que esta capacidad de visualización sea menor que el rango de ND de la imagen. 4.1.1 COMPRESIÓN DEL CONTRASTE Viene a solucionar el segundo de los casos que se planteaban, que se puede producir cuando el ordenador no tiene suficiente capacidad gráfica o en casos de imágenes correspondientes a sensores de gran sensibilidad radiométrica. Debido a que es habitual utilizar ordenadores con resolución gráfica en pantalla de 8 bits para cada uno de los colores elementales (rojo, verde y azul), no va a ser necesario utilizar estas técnicas. 4.1.2 Expansión del contraste Se trata de técnicas, como ya hemos dicho, que vienen a solucionar el desajuste entre el rango de ND de la imagen y una mayor capacidad de NV del ordenador. Normalmente los sensores actuales codifican la señal en un rango de 256 niveles que coincide con los NV de los sistemas de visualización. Por tanto, en teoría, no tendría que hacerse ningún ajuste del contraste. Lo que ocurre es que una imagen difícilmente tendrá una variedad de paisaje tal como para tener que utilizar los 256 niveles, variedad por la que fueron pensados y diseñados los sensores, que hace que estos sean útiles tanto para zonas mundiales poco reflectivas (zonas marinas) como para zonas muy reflectivas (como zonas desérticas o esteparias). Por tanto, parte de los niveles de gris que ofrece el monitor quedan inactivos, y la imagen se visualiza poco contrastada. Para solucionarlo, se realiza una expansión del contraste mediante una CLUT (Color Look Up Table) o tabla de referencia de color, matriz numérica que indica el NV con el que se representa en pantalla cada uno de los ND de la imagen. Gracias a estas CLUT hacemos corresponder el rango de ND presente en la imagen con el total de los NV posibles que ofrece el monitor. Existen varios procedimientos encaminados a cumplir este objetivo. (i) Expansión lineal 26 Master en Ingeniería Medioambiental y Gestión del Agua 2007/2008 Se diseña una CLUT en la que al ND mínimo se le asocia un NV de 0, y al ND máximo se le asocia un NV de 255 (se excluye el 2% de los valores en ambos extremos), distribuyendo linealmente el resto entre ambos márgenes. Como resultado del realce la imagen aparece más nítida y mejor contrastada. En el ejemplo hemos aplicado este realce a una imagen TM Landsat 5 del parque de Cabañeros. Las colas del histograma se han fijado en los extremos del rango de ND y los valores intermedios están mejor repartidos ahora. (ii) Expansión cuadrática (raíz) Se trata de modificar la tabla de color de tal manera que al ND mínimo se le asocie un NV de 0, y al ND máximo se le asocie un NV de 255 (se excluye el 2% de los valores en ambos extremos), distribuyendo cuadráticamente el resto entre ambos márgenes. 27 Master en Ingeniería Medioambiental y Gestión del Agua 2007/2008 Se puede observar el resultado de este realce en la misma imagen que la anterior. En general, se trata de una imagen contrastada pero más clara (en este caso), que produce un efecto “cegador” al visualizarla. El histograma toma forma de una distribución también asimétrica (como en la expansión lineal) pero a la izquierda, que provoca que aparezcan esos tonos claros. (iii) Ecualización del Histograma En esta expansión del contraste la asignación del color no se realiza por el valor digital del píxel, sino por el orden que ocupa en la distribución de valores, es decir, se pretende considerar la distribución de frecuencias en los ND originales. El objetivo es generar una CLUT en la cual cada NV tenga, aproximadamente, el mismo número de ND de la imagen. Según este criterio, el NV asignado a cada ND está en proporción no sólo a este valor, sino también a su frecuencia. Se conseguirá un mejor resultado si la imagen original presenta una distribución gausiana. Se observa una imagen contrastada, sin esos niveles de “saturación” del realce cuadrático y con un mejor detalle de la variabilidad presente en la imagen que el lineal. 4.2 Filtros Bajo la denominación de filtros se incluyen a aquellas funciones encaminadas a obtener unas características dadas de la señal eliminando otras que no se desean, aislando componentes de interés. Mediante estas técnicas de filtraje, se pretende suavizar o reforzar contrastes en la imagen, de tal forma que los ND de la imagen se asemejen o diferencien más de los correspondientes a los píxeles que le rodean. Algunas de las aplicaciones de estos filtros son: 28 - El suavizado, su objetivo es corregir el ruido y los errores producidos como consecuencia de la transmisión de las imágenes. - El reforzamiento de bordes, se aplica para obtener imágenes con definiciones más claras en los bordes. Master en Ingeniería Medioambiental y Gestión del Agua 2007/2008 - La extracción de bordes, su objetivo es construir una imagen que contenga exclusivamente información sobre los bordes existentes en la imagen original. Se pueden distinguir dos tipos de filtros en función del objetivo que se esté buscando: por una lado tenemos los filtros de paso bajo, que tienden a subrayar el componente de homogeneidad en la imagen, acentuando la zonas donde la frecuencia de cambio es baja; por otro lado tendríamos los filtros de paso alto, es decir, buscan acentuar las zonas de más contraste de la imagen. 4.2.1 FILTROS DE PASO BAJO Una vez mencionado su objetivo, se puede pensar en estos filtros en su utilización para restaurar los errores en los ND de la imagen debido a defectos en la transmisión de datos. También puede usarse para eliminar un efecto dispersivo en las clasificaciones, reduciendo la variabilidad espacial de algunas categorías. (i) Filtro de media Como su nombre indica, este filtro hace una media aritmética con los ND de los píxeles cercanos definidos en la ventana de filtraje. Si definimos una ventana de 3x3 de este tipo a1 a2 a3 a4 a5 a6 a7 a8 a9 El filtro de media calcula la suma de todos los píxeles de la ventana del filtro y lo divide por el número de píxeles que contiene la ventana: Píxel filtrado: (a1 + a2 + a3 + a4 +a5 + a6 + a7 + a8 + a9) / 9 El resultado es una imagen suavizada (ver Fig. 4.1), en la que los ND extremos se acercan produciendo ese efecto en la imagen y disminuyendo, por tanto, el contraste. También se produce una eliminación del ruido de la imagen. (II) FILTRO DE MEDIANA También como indica su propio nombre, este tipo de filtro asigna el valor estadístico de la mediana de los ND correspondientes a los píxeles vecinos de la ventana de filtraje al píxel central. Un filtro de mediana de, por ejemplo, 3x3 busca el valor mediano entre los valores ordenados de la ventana del filtro y se lo aplica al píxel central. Ejemplo: 129 128 127 29 126 125 133 130 131 134 Master en Ingeniería Medioambiental y Gestión del Agua 2007/2008 El pixel resultado del filtro sería: (125,126,127,128,(129),130,131,133,134) = 129 Los efectos son parecidos a los del filtro de media, pero cabe destacar su mayor robustez, es decir, se ve mucho menos afectado por valores extremos. En las siguientes figuras se muestra la banda 4 de TM del Parque de Cabañeros con realce lineal pero sin aplicarle ningún filtro, y a continuación la misma banda con ese realce a la que se le ha aplicado un filtro de media y otro de mediana. Fig. 4.1 banda 4 sin filtro filtro de media filtro de mediana El filtro de mediana, como corresponde al propio carácter de esta medida estadística, es menos sensible a los valores extremos, es decir, es más robusto y por tanto el valor final no se modifica tanto. Esta característica supone una ventaja, en este caso, respecto el filtro de media, que sí tiene en cuenta esos valores extremos. 4.2.2 FILTROS DE PASO ALTO Con este tipo de filtros se remarcan digitalmente los contrastes espaciales entre píxeles cercanos, acentuando los rasgos lineales presentes en la imagen como pueden ser carreteras, caminos, hidrografía, accidentes geológicos, etc. (I) FILTRO SOBEL El filtro de Sobel realza la variación entre filas y columnas de la matriz de filtraje. Solamente se puede utilizar con ventanas de 3x3. El filtro utiliza dos plantillas para calcular el valor del píxel central. Plantilla X Plantilla Y -1 0 1 1 2 1 -2 0 2 0 0 0 -1 0 1 -1 -2 -1 Aplicando las plantillas a los niveles de gris de la ventana 3x3: 30 Master en Ingeniería Medioambiental y Gestión del Agua 2007/2008 a1 a2 a3 a4 a5 a6 a7 a8 a9 Operando de la siguiente manera: X = -1*a1 + 1*a3 - 2*a4 + 2*a6 - 1*a7 + 1*a9 Y = 1*a1 + 2*a2 + 1*a3 - 1*a7 - 2*a8 - 1*a9 Siendo el píxel filtrado = (X2 + Y2)1/2 (II) FILTRO EDGE SHARPENING Este filtro utiliza un método de suavización sustractivo para remarcar la imagen. Lo primero que hace es aplicar un filtro de mediana a la imagen. La información que retendrá la imagen promediada se atenuará, es decir, los bordes y las líneas se suavizarán. Posteriormente, se sustrae la imagen promediada a la original, resultando una imagen donde se conservan los bordes y las líneas. Una vez que se han determinado las líneas y los bordes, se suma esta última imagen diferencia a la imagen original para conseguir realzar los bordes y las líneas. La imagen resultante realza los contrastes espaciales, pero tiene el problema de que se pueden aumentar los ruidos. (III) FILTRO DIRECCIONAL El objeto es realzar alguna dirección en particular de la imagen. Se muestra un ejemplo en la dirección Noroeste, en concreto buscamos resaltar las líneas de cuerda de las montañas que aparecen en la imagen. Fig. 4.2 filtro Sobel 31 filtro Edge Sharpening filtro direccional NE Master en Ingeniería Medioambiental y Gestión del Agua 2007/2008 DIRECCIONES DE INTERNET (1) HTTP://LISTSERV.REDIRIS.ES/ARCHIVES/TELEDETECCION.HTML, LISTA DE TELEDETECCIÓN DE REDIRIS. (2) HTTP://WWW.REDIRIS.ES/LIST/INFO/TELEDETECCION.HTML, PÁGINA WEB DE TELEDETECCIÓN, QUE SIRVE DE PORTADA A LA ANTERIOR LISTA, CON INFORMACIÓN Y LINKS DE DIFERENTES DIRECCIONES (3) HTTP://LISTSERV.REDIRIS.ES/ARCHIVES/SIG.HTML, LISTA DE SISTEMAS DE INFORMACIÓN GEOGRÁFICA DE REDIRIS (4) http://redgeomatica.rediris.es/, portal web sobre Geomática BIBLIOGRAFÍA Y REFERENCIAS ACKERMANN F. SCHADE H. 1993 “Application of GPS for aerial triangulation” BARET F., CHAMPION I., GUYOT G. & PODAIRE A., 1987. “Monitoring wheat canopies with a high spectral resolution radiometer”. Remote Sensing of Environment, 22. BAUER M.E., DAUGHTRY C., BIEHL L.L., KANEMASU E.T. & HALL F.G., 1986. “Field spectroscopy of agricultural crops” IEEE Transactions on Geoscience and Remote Sensing, GE-24 (1). COLWELL R.N., 1983 “Manual of Remote Sensing, American Society of Photogrammetry”, Virginia CURRAN P.J., 1985 “Principles of Remote Sensing”. Longman Group Limited, Essex (England) CHUVIECO E., 1996 “Fundamentos de Teledetección Espacial”, Rialp, Madrid 3ª Edición Revisada. DE MIGUEL E.; ANTON-PACHECO, C.; GUMIEL, J.C.; GOMEZ, J.A.; GUTIERREZ, O.; REJAS, J. G.; ARRANZ, J.; LÓPEZ, J.E.; BARETTINO, D. Y JIMÉNEZ, M . 1999 “Cartografía del vertido de lodos de la mina de Aznalcóllar mediante Imágenes Daedalus ATM”. Teledetección. Avances Y Aplicaciones. VIII Congreso de Teledetección AET. FRASER R.S. & KAUFMAN Y.J., 1985 "The elative importance of scattering and absorption in remote sensing" IEEE Transactions on Geoscience and Remote Sensing, 23. GILABERT M.A., 1991. “Radiometría de campo”. La Teledetección en el seguimiento de los fenómenos naturales. Recursos renovables: agricultura. Universidad de Valencia. GIRARD M.C. ET GIRARD C.M. 1989 ”Télédétection Appliquée”, Masson, Paris 32 Master en Ingeniería Medioambiental y Gestión del Agua 2007/2008 JOBSON J. D. 1991 “Applied Multivariate Data Analysis”. Volume I: Regression and Experimental Design. Edit. Springer-Verlag. LILLESAND & KIEFER, 1994 “Remote Sensing and Image Interpretation”. Wiley & Sons, Canada MAARTEN HOOIJBERG, 1997 “Practical Geodesy”, Editorial Springer, Berlin. McCLATCHEY R.A., BOLLE H.J. & KONDRATEYEV K.Y., 1986. "A preliminary cloudless standard atmospheric for radiation computation" WCP-112 WMO/TD-NO. 24. International Association for Meteorology and Atmospheric Physics, Radiation Commission. MILTON, E.J., ROLLIN, E.M. & EMERY, D.R., 1995, "Advances in field spectroscopy". Advances in Environmental Remote Sensing, Ed. F.M. Danson y S.E. Plummer. John Wiley & Sons 1995. KRAMER H.J. 1996 “Observation of the Earth and its Environment”. Surveys of Missions and Sensors Third Enlarged Edition. Springer RICHARDS J.A. & XIUPING J. 1999 “Remote Sensing Digital Image Analysis. An Introduction” .Third Revised and Enlarged Edition. Springer ROBERTS, D.A., YAMAGUCHI, Y. & LYON, R.J.P., 1985, "Calibration of airborne imaging spectrometer data to percent reflectance using field spectral measurements". Proceedings 9th International Symposium on Remote Sensing of the Environment, Ann Arbor, Michigan, October. ROY D.PD. DEVEREUX B., GRAINGER B. & WHITE S.J., 1997 “Parametric geometric correction of Airborne Thematic mapper imagery”. Intentional Journal of Remote Sensing, VOL 18, NO9.,1865-1887 SWAIN P.H. & DAVIS, S.M., 1978 “Remote sensing: The Quantitative approach”. McGraw hill, London; New York TANRE D., HERNAN M. & DESCHAMPS P.Y., 1981. “Influence of the background contribution upon space measurements of ground reflectance”. Applied Optics, 20, 36763684. 33 Master en Ingeniería Medioambiental y Gestión del Agua 2007/2008 34