Clasificación de preguntas sin respuesta: la retórica de Twitter

Anuncio

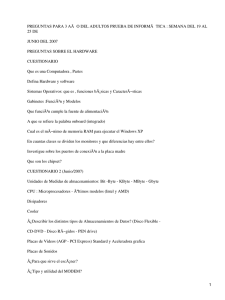

Clasificación de preguntas sin respuesta: la retórica de Twitter David Tomás* Departamento de Lenguajes y Sistemas Informáticos Universidad de Alicante, España [email protected] Resumen Debido a la velocidad con la que se propaga la información en Twitter, son numerosos los usuarios que utilizan esta red social para formular preguntas. Este contexto resulta propicio para plantear un cambio de paradigma en el desarrollo de sistemas de búsqueda de respuestas, haciendo que éstos no sólo sean capaces de responder a las consultas de los usuarios, sino también de detectar cuándo un usuario tiene una necesidad de información para acudir en su ayuda. Detectar ésta necesidad de información en Twitter no es trivial, ya que en numerosas ocasiones la gente emplea en sus mensajes interrogaciones retóricas que no requieren de una respuesta. En este trabajo se ha desarrollado un clasificador basado en aprendizaje automático para discriminar entre preguntas reales y retóricas en Twitter, como un primer paso para la creación de sistemas de búsqueda de respuestas que sean capaces de detectar cuándo un usuario realiza una petición real de información. Keywords: Recuperación de información, búsqueda de respuestas, clasificación de preguntas, preguntas retóricas, redes sociales, Twitter 1. Introducción Las redes sociales han adquirido una relevancia indiscutible en el panorama actual de Internet. Millones de personas se conectan y vinculan a diario en estas redes para verter en ellas contenidos, ideas, noticias y opiniones. Los usuarios de Internet han pasado de ser meros consumidores de información a convertirse en participantes activos y motores de la red. Twitter1 es una de las principales redes sociales, con más de 140 millones de usuarios que generan 340 millones de mensajes diarios [8]. Esta red ofrece un servicio de microblogging que permite a sus miembros enviar y leer mensajes de texto (conocidos como tweets) de un máximo de 140 caracteres. Esta restricción en el tamaño de los mensajes y la facilidad de propagación entre sus usuarios la han convertido en una fuente intestimable de información en tiempo real. * 1 Este trabajo ha sido financiado por el Gobierno Español a través del proyecto TEXTMESS 2.0 (TIN2009-13391-C04-01), por la Universidad de Alicante (GRE10-33) y por la Generalitat Valenciana (GV/2012/110). http://www.twitter.com/. Es precisamente esta inmediatez con la que se propagan los mensajes la que hace que muchos usuarios utilicen Twitter como foro para plantear sus dudas y consultas, en lugar de recurrir a sistemas de recuperación de información en la Web como Google2 o a sitios sociales de búsqueda de respuestas como Yahoo! Answers.3 Este panorama nos ofrece la posibilidad de plantear un nuevo paradigma para el desarrollo de sistemas de búsqueda de respuestas (BR): frente a los sistemas actuales, donde es el usuario el que acude a éstos con una petición de información para obtener una respuesta, en el contexto planteado aquı́ serı́a el propio sistema el que detectarı́a que un usuario tiene una necesidad de información y acudirı́a en su ayuda. La creación de este tipo de sistemas pasarı́a por ser capaces de detectar cuándo un usuario está expresando con su mensaje una petición de información. Detectar esta situación en Twitter no es una tarea trivial, ya que en numerosas ocasiones sus usuarios expresan opiniones y argumentos mediante oraciones interrogativas con fines retóricos: su objetivo no es obtener una respuesta, sino enfatizar los argumentos expuestos. Mensajes como “¿Por qué siempre me toca a mı́?” o “¿Cómo me pude olvidar?” tienen la apariencia de una pregunta, pero no expresan ninguna necesidad de información ya que no esperan una respuesta. Es lo que se conoce como pregunta retórica. En este artı́culo se pretende sentar las bases de este nuevo paradigma de funcionamiento para los sistemas BR, realizando una aproximación a la detección de peticiones de información realizadas por los usuarios de Twitter. Esta tarea se afrontará desde el punto de vista de la clasificación de preguntas [7]. Esta investigación se centra en el desarrollo de un sistema basado en aprendizaje automático capaz de discriminar entre peticiones reales de información y expresiones retóricas que adquieren la forma de oración interrogativa pero que no buscan respuesta alguna. El lenguaje informal que habitualmente se emplea en Twitter y la particular fisonomı́a de sus mensajes hacen que las caracterı́sticas de aprendizaje planteadas en este sistema de clasificación disten notablemente de las empleadas en los sistemas de clasificación de preguntas tradicionales. Este trabajo tiene la siguiente estructura: la sección 2 describe la idiosincrasia de Twitter; en la sección 3 se describe la aproximación seguida para la detección automática de preguntas, incluyendo las caracterı́sticas de aprendizaje y el corpus empleado; en la sección 4 se definen los experimentos realizados y los resultados obtenidos; la sección 5 muestra los trabajos relacionados con la investigación desarrollada en este artı́culo; finalmente, en la sección 6 se presentan las conclusiones y el trabajo futuro que podrı́a derivarse de esta investigación. 2. Anatomı́a de Twitter En este apartado se describen los elementos y conceptos fundamentales de la red social Twitter. El primero de estos conceptos es el de tweet, que es como se denomina a los mensajes de como máximo 140 caracteres que emiten los 2 3 http://www.google.com/. http://answers.yahoo.com/. usuarios de esta red social. Por defecto, los tweets tienen un carácter público, siendo accesibles para cualquier persona. En Twitter existen dos tipos básicos de relaciones entre sus miembros. Dado un usuario, los followers son las personas que siguen a ese usuario, mientras que los friends son las personas a las que sigue ese usuario. Cuando un usuario decide seguir a otro, automáticamente pasa a recibir todos los tweets que éste genere. Debido a la limitación que supone la cuota de 140 caracteres, el lenguaje empleado en los tweets suele ser marcadamente informal, plagado de notaciones taquigráficas y del argot usado habitualmente en los foros de Internet y en los mensajes SMS telefónicos. Además de estos rasgos comunes a otros medios, los mensajes de Twitter poseen sus propios rasgos distintivos: los hashtags, las menciones, los enlaces y los retweets. Un hashtag o etiqueta es una cadena de caracteres formada por una o varias palabras y precedidas por el sı́mbolo almohadilla (#). Son incluidos por los usuarios en sus tweets para representar un tema con el que se quiere identificar el mensaje enviado (por ejemplo, usar #elecciones20n para referirse a las elecciones generales de 2011 en España). Una mención es una alusión a un usuario de Twitter y se representa por el sı́mbolo arroba (@) seguido del identificador del usuario (por ejemplo, “@johnmaeda” o “@d tomas”). También es habitual la inclusión en el texto de los tweets de enlaces a páginas Web, imágenes y vı́deos, complementando la información introducida en el mensaje. Finalmente, cuando un mensaje es un retweet de uno previo (un seguidor retransmite un mensaje recibido a sus propios seguidores), se incluye el término RT en el mensaje para indicar esta situación de forma explı́cita. 3. Clasificación de preguntas Los sistemas de BR tienen como finalidad encontrar respuestas concretas a necesidades precisas de información formuladas por los usuarios mediante lenguaje natural. Sin embargo, no todos los tipos de pregunta que se pueden dar en la comunicación humana son de interés para estos sistemas, sino sólo aquellas oraciones formuladas por los usuario que tienen como objetivo recibir una cierta información como respuesta. Las preguntas se formulan habitualmente mediante oraciones interrogativas, contrastando con aquellas oraciones que hacen una afirmación, una petición o expresan una exclamación. Las preguntas retóricas son un ejemplo de oraciones interrogativas utilizadas por su efecto persuasivo, pero que no esperan una respuesta (“¿Cuántas veces te lo tengo que repetir?”). Estas preguntas son un artefacto usado por el hablante para deleitar, persuadir o conmover al oyente. La clasificación de preguntas es una de las tareas fundamentales en los sistemas de BR. Esta tarea consiste en, dada una pregunta, determinar el tipo de respuesta esperada. Para consultas como “¿Quién es el presidente de Estados Unidos?” y “¿Dónde está la Torre Eiffel?”, un sistema de clasificación de preguntas determinarı́a que se espera como respuesta el nombre de una persona y un lugar respectivamente. Esta clasificación permite filtrar un gran número de respuestas posibles y quedarse sólo con aquellas que pertenecen al tipo de respuesta esperada. El problema aquı́ planteado es el de discriminar entre oraciones interrogativas que tienen una necesidad de información real y las que no. Este problema va a ser abordado como una tarea de clasificación automática de preguntas, donde a cada instancia de entrada (tweet) le será asignada una clase de entre dos posibles, “real” o “retórica”, indicando si la pregunta espera una respuesta o no. El clasificador se va a construir siguiendo el paradigma de aprendizaje automático supervisado. Para desarrollar un sistema de este tipo es necesario definir una serie de componentes. El primero de ellos es la taxonomı́a de tipos de pregunta que queremos asignar a las entradas que lleguen al sistema. En este caso, las clases posibles son únicamente dos (clasificación binaria). El segundo componente del sistema es el conjunto de ejemplos (tweets en nuestro caso) correctamente etiquetados con las posibles clases de la taxonomı́a. Es lo que se conoce como corpus de entrenamiento. El tercer componente es el conjunto de caracterı́sticas que se van a extraer de cada instancia y que identificará la información relevante para la clasificación. El último componente es un algoritmo capaz de aprender a predecir la clase a la que pertenece cada nueva instancia de entrada a partir de las caracterı́sticas de aprendizaje extraı́das del corpus de entrenamiento. En nuestros experimentos utilizaremos algoritmos ya existentes pertenecientes a diferentes familias. En los siguientes puntos se describen las caracterı́sticas de aprendizaje extraı́das y el corpus desarrollado. 3.1. Caracterı́sticas de aprendizaje Uno de los principales retos a la hora de desarrollar sistemas de clasificación basados en aprendizaje automático es definir el conjunto de caracterı́sticas que mejor permita al algoritmo de aprendizaje discriminar entre las distintas clases de la taxonomı́a. En el campo de la clasificación de preguntas, estudios previos han demostrado que el empleo de bolsas de palabras y de información semántica (entidades, listas de palabras semánticamente relacionadas, relaciones de WordNet, etc.) son fundamentales para una correcta clasificación [4]. Sin embargo, en el problema que aquı́ nos planteamos, estas caracterı́sticas se antojan de poca utilidad. Por ejemplo, la aparición de pronombres interrogativos como “quién”, “cuándo” o “dónde” resultan fundamentales para saber si nos están preguntando por una persona, una fecha o un lugar. Sin embargo, a la hora de determinar si una pregunta es real o retórica, esta información puede resultar en la mayorı́a de las ocasiones totalmente irrelevante. Por lo que respecta al uso de diccionarios o bases de datos léxicas tradicionales, el carácter marcadamente informal de gran parte de los mensajes emitidos en Twitter limitan la utilidad de estos recursos. Las caracterı́sticas que vamos a plantear en este apartado contrastan claramente con las empleadas en los sistemas de clasificación de preguntas tradicionales. Tal y como veı́amos en la sección 2, los tweets poseen una idiosincrasia muy particular que intentaremos explotar en este trabajo. Se han definido un total de 19 caracterı́sticas, agrupadas conceptualmente por afinidad hasta obtener 7 Signos de puntuación Número interrogativos Número de signos interrogativos contenidos Número exclamaciones Número de signos de exclamación contenidos Contiene comillas Indica si aparecen o no comillas Lenguaje propio de Twitter Número menciones Número de usuarios nombrados (usando ’@’) Número hashtags Número de etiquetas empleadas (usando ’#’) Contiene enlaces Indica la existencia o no de direcciones Web Número palabras Número total de palabras que contiene Número interjecciones Número de interjecciones que contiene Entidades Número entidades Número de entidades (producto, empresa, lugar, etc.) que aparecen Etiquetado morfológico Número comunes Número de nombres comunes que aparecen Número propios Número de nombres propios que aparecen Número verbos Número de verbos (no auxiliares) que aparecen WordNet Media camino Distancia media en el árbol de WordNet entre los términos del mensaje y el nodo raı́z Porcentaje WordNet Porcentaje de términos del mensaje encontrados en WordNet Encontrados WordNet Número total de términos del mensaje encontrados en WordNet Análisis de sentimientos Polaridad Indica la polaridad del mensaje: positivo, negativo o neutro Relaciones Número friends Número de personas a las que sigue el usuario que lo envió Número followers Número de personas que siguen al usuario que lo envió Relación friends/followers Número de amigos del usuario dividido por su número de seguidores Tabla 1. Caracterı́sticas de aprendizaje utilizadas para representar cada tweet. grupos diferentes. La tabla 1 resume estos conjuntos. Todas estas caracterı́sticas son de tipo numérico (o binario, asignando en esos casos el valor 0 a falso y 1 a verdadero) y sus valores han sido normalizados en el intervalo [0, 1]. Para la obtención de estas caracterı́sticas se utilizaron diversas herramientas de procesamiento del lenguaje natural, algunas de ellas adaptadas al lenguaje propio de Twitter. Para obtener la polaridad de los mensajes se empleó la herramienta Twitter Sentiment,4 capaz de clasificar la polaridad de un tweet en tres tipos diferentes: positivo, negativo y neutro. Para el análisis morfológico y la detección de entidades se empleó el etiquetador UW Twitter NLP Tools [5], especializado en el tratamiento de textos informales. En los experimentos aquı́ realizados se ha trabajado únicamente sobre el idioma inglés, condicionados por la disponibilidad en este idioma de algunas de las herramientas necesarias para la obtención de las caracterı́sticas descritas. No obstante, la mayorı́a de caracterı́sticas planteadas son directamente extraı́bles del tweet y, por tanto, independientes del idioma con el que se trabaje. 3.2. Construcción del corpus Es necesario crear un corpus etiquetado para poder entrenar al algoritmo de clasificación. Para este trabajo se hace necesario un conjunto de preguntas 4 http://twittersentiment.appspot.com/. reales y un conjunto de preguntas retóricas convenientemente etiquetadas. Si bien existen grandes corpus de preguntas reales (como los empleados en las diversas ediciones de las competiciones TREC [9] o los recopilados en sitios sociales de búsqueda de respuestas), hasta donde alcanza nuestro conocimiento no existen corpus especı́ficos de preguntas retóricas que puedan servir para entrenar un clasificador como el aquı́ planteado. Más aún, el lenguaje formal empleado en los recursos antes mencionados contrasta con el lenguaje marcadamente informal que emplean los usuarios de Twitter. Esta diferencia hace que los recursos existentes resulten poco adecuados para el fin perseguido en esta investigación. Por esta razón, como paso previo a la construcción del clasificador se optó por recopilar y etiquetar manualmente un corpus de preguntas reales y retóricas formuladas en Twitter. El primer paso fue la obtención de un conjunto amplio de oraciones interrogativas directas de Twitter,5 es decir, tweets que contuvieran signos de interrogación. Se recopilaron 10.000 mensajes de este tipo para cada uno de los pronombres interrogativos (“what”, “who”, “whom”, “whose”, “which”, “when”, “where”, “why” y “how”) a fin de obtener una muestra variada de oraciones interrogativas. De este conjunto de 90.000 preguntas se seleccionaron de forma aleatoria 100 muestras para cada uno de los pronombres enumerados, generando una muestra de 900 oraciones interrogativas que fueron etiquetadas manualmente como “real” o “retórica”. El criterio que se estableció para el etiquetado fue el de considerar como preguntas reales aquellas que esperaban una respuesta, independientemente de si esa pregunta estaba formulada para un público general o no. Es decir, mensajes como “¿Qué vais a hacer después del partido?” fueron etiquetados como preguntas reales. Como resultado de este etiquetado, 680 preguntas fueron consideradas como retóricas mientras que sólo 220 fueron consideradas preguntas reales. Estas cifras dan una idea de que, efectivamente, la mayorı́a de oraciones interrogativas expresadas en Twitter no son consultas que esperen una respuesta, sino artificios retóricos para dar fuerza o emotividad al discurso de sus usuarios. Con el objetivo de conseguir un corpus equilibrado con respecto al número de muestras de cada tipo, se buscó la forma de obtener más preguntas reales formuladas por usuarios de Twitter. Para ello se recurrió a buscar mensajes que contuvieran el hashtag #lazyweb.6 La presencia de esta etiqueta prácticamente garantiza que el mensaje enviado es una pregunta que formula de manera general un usuario a sus seguidores. De esta manera se obtuvieron 2.803 tweets que contenı́an esta etiqueta y que, por tanto, representan una muestra rica de preguntas reales para entrenar al clasificador. La etiqueta #lazyweb fue eliminada en todos estos mensajes, ya que hubiera supuesto un rasgo definitorio a la hora de discriminar entre preguntas reales y retóricas. Para obtener el corpus equilibrado en los experimentos planteados en la sección 4, se seleccionaron 680 muestras al azar de este conjunto de 2.803. 5 6 El tratamiento de preguntas indirectas queda fuera del ámbito de esta investigación. Lazyweb es un concepto usado para describir el acto de trasladar preguntas a los usuarios de Internet antes de buscar la solución por uno mismo. Clasificador Precisión SVM NB IB1 RF 75,56 70,78 68,56 73,33 real retórica Precisión Cobertura F-score Precisión Cobertura 0,00 0,00 0,00 75,60 100,00 38,40 32,30 35,10 79,20 83,20 34,90 33,20 34,00 78,70 80,00 43,30 29,50 35,10 79,30 87,50 F-score 86,10 81,10 79,40 83,20 Tabla 2. Precisión obtenida por SVM, Naı̈ve Bayes (NB), IB1 y Random Forest (RF) sobre el corpus de 900 preguntas y sobre cada una de las clases (real y retórica). 4. Experimentos y resultados En esta sección se van a exponer los experimentos y resultados obtenidos en la evaluación del sistema propuesto. Se han planteado tres experimentos diferentes. El primero de ellos trata de evaluar el rendimiento del clasificador sobre el corpus de 900 preguntas etiquetado manualmente. El segundo se centra en el corpus aumentado con preguntas obtenidas a través del hashtag #lazyweb. El tercer y último experimento realiza un estudio selectivo donde se evalúa el aporte al rendimiento del sistema de cada uno de los grupos de caracterı́sticas definidos. En todos los experimentos el rendimiento del sistema se ha evaluado en términos de precisión, entendiendo como tal el resultado de dividir el número de preguntas correctamente clasificadas por el total de preguntas. Para evitar dividir el corpus en un conjunto de entrenamiento y en otro de evaluación, se ha realizado una validación cruzada en 10 particiones (10-fold cross-validation). 4.1. Corpus original En este experimento se ha trabajado con el corpus de 900 preguntas etiquetado manualmente, experimentando con todas las caracterı́sticas descritas en la sección 3.1 y empleando cuatro algoritmos de clasificación pertenecientes a diferentes familias: support vector machines (SVM) como representante de los clasificadores lineales, Naı̈ve Bayes de los métodos bayesianos, IB1 de los algoritmos basados en ejemplos y Random Forest de los árboles de decisión. La tabla 2 muestra los resultados obtenidos para el corpus completo (segunda columna) y de forma individualizada para cada una de las clases (real y retórica). Por los resultados obtenidos, podrı́a parecer que SVM es el que mejor rendimiento ofrece al obtener la mejor precisión en este experimento. Sin embargo, un análisis pormenorizado sobre cada una de las clases revela que para real obtiene una precisión y cobertura nula, es decir, todas las preguntas fueron clasificadas como pertenecientes a la clase retórica. El resto de algoritmos, aunque de forma menos marcada, muestra también una clara tendencia a asignar mayoritariamente la clase retórica a las instancias clasificadas. Para ver hasta qué punto está afectando al rendimiento del sistema la falta de equilibrio en el número de muestras de cada tipo en el corpus, se ha realizado un nuevo experimento seleccionando 220 preguntas de la clase retórica de entre Clasificador SVM NB IB1 RF 440 preguntas Precisión 64,73 ± 1,80 56,41 ± 4,55 57,73 ± 1,52 62,34 ± 2,40 1.360 preguntas Precisión Mejora 76,30 ± 0,56 +17,87 73,80 ± 1,43 +30,83 72,84 ± 1,09 +26,17 80,49 ± 1,01 +29,11 Tabla 3. Precisión media y desviación tı́pica obtenida por los cuatro algoritmos sobre el corpus equilibrado de 440 preguntas y sobre el de 1.360 preguntas. En este último caso, se muestra la mejora de precisión obtenida con respecto al anterior. las 680 existentes para equilibrar las 220 de la clase real y obtener un corpus de 440 preguntas. Este proceso de selección de 220 preguntas sobre las 680 totales se repitió 10 veces, evitando ası́ que una única selección al azar pudiera llevarnos a obtener un rendimiento poco realista del sistema. La tabla 3 muestra la media (µ) de la precisión y la desviación tı́pica (σ) calculada para cada uno de los algoritmos sobre las 10 iteraciones mencionadas. Las matrices de confusión obtenidas en estos experimentos (no incluidas aquı́ por motivos de espacio) muestran una mayor igualdad a la hora de asignar una u otra clase a las muestras del corpus, como resultado de haber equilibrado el corpus. Sin embargo, la tabla 3 nos ofrece un rendimiento bastante pobre para todos los clasificadores (SVM es el mejor con 64,73 %) y una desviación elevada en algunos casos (como con Naı̈ve Bayes) que revelan un comportamiento inestable dependiendo del subconjunto de muestras de entrenamiento elegido. Estos resultados revelan que el criterio establecido para decidir cuándo una pregunta es real o retórica (que espere o no una respuesta) durante el etiquetado del corpus ha generado un conjunto demasiado difuso en el cual las caracterı́sticas definidas no son capaces de resultar discriminatorias. Se antoja recomendable, pues, reconsiderar este criterio de etiquetado. Un enfoque más orientado a la aplicación final de este trabajo serı́a etiquetar como preguntas reales sólo aquellas que estén dirigidas a un público general y no a una persona concreta o a un grupo particular, al que apenas es necesario proporcionar información para que entienda plenamente la consulta formulada. Por otra parte, este tipo de preguntas personales carecerı́an de interés para un sistema que busque solventar de forma automática las consultas que plantean los usuarios en Twitter. 4.2. Corpus aumentado Este experimento va a analizar el rendimiento del clasificador empleando el corpus aumentado descrito en la sección 3.2, donde se aprovechó el uso popular de la etiqueta #lazyweb para recopilar un conjunto de preguntas reales formuladas en Twitter. La evaluación en este nuevo contexto consiste en la selección aleatoria de 680 preguntas de las más de 2.800 que se recopilaron. Junto con las 680 preguntas de tipo retórico etiquetadas manualmente se obtiene ası́ un corpus equilibrado de 1.360 preguntas. Este experimento se ha repetido 10 veces para asegurar que el rendimiento no está condicionado por el subconjunto aleatorio de preguntas seleccionado. La tabla 3 muestra la media y desviación tı́pica, ası́ como la mejora obtenida con respecto al corpus de 440 preguntas. Los resultados obtenidos revelan un rendimiento mucho más elevado que en el experimento realizado anteriormente con el corpus de 440 preguntas, obteniendo una precisión superior al 80 % con el algoritmo Random Forest y consiguiendo mejoras superiores al 30 % en el caso de Naı̈ve Bayes. La desviación tı́pica es también notablemente menor, demostrando un comportamiento más estable de los clasificadores frente a la selección del conjunto de muestras del experimento. Esta mejora viene dada por dos aspectos fundamentales. El primero es el tamaño del corpus empleado: 1.360 muestras frente a 440. Es sobradamente conocida la influencia que tiene el número de muestras del corpus de entrenamiento en el rendimiento del clasificador. El segundo aspecto es la calidad de las muestras. En el experimento anterior veı́amos que la frontera entre preguntas reales y retóricas resultaba demasiado difusa para el clasificador, ya que muchas de las preguntas que considerábamos como reales estaban destinadas a un público particular que requiere de muy poca información para su tratamiento. Sin embargo, en este segundo experimento, las preguntas reales obtenidas están claramente dirigidas a un público general y orientadas a la obtención de una respuesta. Poseen una mayor riqueza de información que en el caso anterior que facilita al clasificador la labor de discriminar entre éstas y las preguntas de tipo retórico. 4.3. Estudio selectivo Con el objetivo de evaluar la importancia de cada uno de los grupos de caracterı́sticas definidos en la tabla 1, se ha realizado un estudio selectivo, eliminando en cada iteración una de las caracterı́sticas en el proceso de evaluación y comprobando la influencia producida sobre el rendimiento global del clasificador. Este experimento se ha realizado sobre el corpus de 1.360 preguntas. Vamos a centrar el estudio en el algoritmo Random Forest, que es el que mejor resultado obtuvo en el apartado anterior. La figura 1 muestra los resultados obtenidos. La lı́nea etiquetada como “Todas” muestra la precisión media µ obtenida utilizando todas las caracterı́sticas. Las lı́neas paralelas superior e inferior representan µ + σ y µ − σ respectivamente. En esta gráfica se observa que las caracterı́sticas del lenguaje de Twitter (número menciones, número hashtags, contiene enlaces y número palabras) son las que más afectan al rendimiento del clasificador al ser eliminadas. Los signos de puntuación, la información morfológica y las relaciones establecidas influyen también de manera sustancial en el rendimiento final. Son este tipo de caracterı́sticas superficiales del lenguaje las que más afectan al sistema. Sin embargo, las caracterı́sticas semánticas relativas a entidades, análisis de sentimientos y WorNet apenas afectan al rendimiento del sistema, siendo llamativo el caso de WordNet, en el que su eliminación favorece al rendimiento final del clasificador. Si bien podrı́a concluirse que la información semántica carece de utilidad para la discriminación de preguntas reales y retóricas, hay que tener en cuenta que el tratamiento del lenguaje informal se haya todavı́a en una fase incipiente, Random Forest Todas Seleccion 84 Precisión 82 80 78 76 s ne io ac ad rid la el R Po et dN or W s ca gi ló fo es ad tid or M En je ua ng Le ón ci ua nt Pu Características eliminadas Figura 1. Precisión del clasificador Random Forest sobre el corpus de 1.360 preguntas al eliminar cada uno de los conjuntos de caracterı́sticas definidos. “Todas” muestra la precisión obtenida al emplear todas las caracterı́sticas. y que el rendimiento obtenido por éstas herramientas dista todavı́a del obtenido por sus equivalentes para lenguaje formal, pudiendo ser un motivo fundamental de la escasa efectividad de estas caracterı́sticas. Para completar este estudio sobre la relevancia de cada una de las caracterı́sticas en el rendimiento del clasificador, hemos utilizado information gain (IG) como medida para determinar cuáles son las caracterı́sticas que aportan más información durante el proceso de aprendizaje. El orden de relevancia asignado por IG fue el siguiente (de mayor a menor): Número followers, Número propios, Número menciones, Número interrogativos, Número palabras, Número friends, Relación friends/followers, Media camino, Número verbos, Contiene enlaces, Número exclamaciones, Encontrados WordNet, Polaridad, Número propios, Número entidades, Número interjecciones, Porcentaje Wordnet, Número Hashtags y Contiene Comillas. Esta lista muestra que la caracterı́stica más relevante según IG es el número de seguidores del autor del tweet. Este resultado confirma el estudio realizado por InboxQ [2], donde se indica que un 67 % de los usuarios que formulan preguntas en Twitter tienen más de 100 seguidores. Es decir, existe una correlación entre la formulación de preguntas reales y el número de seguidores. El número de menciones también tiene una relevancia importante. Incluir nombres de personas en oraciones interrogativas puede ser indicativo de que el mensaje va dirigido a una persona particular y que probablemente se trate de un mensaje privado y no de una petición de información. El número de interrogativos también tiene una relevancia notable. Varios interrogativos consecutivos puede denotar un grado alto de informalidad (“¿¿Qué me dices??”). Por otra parte, varias oraciones interrogativas consecutivas pueden ser un claro ejemplo de uso retórico del lenguaje (“¿Dónde están tu valores? ¿Y tu dignidad?”). Por lo que respecta a las caracterı́sticas peor valoradas, el uso de comillas (muy habitual en expresiones literales) o el número de hashtags no parecen ser relevantes para la clasificación, al igual que el porcentaje de términos del mensaje que aparecen en WordNet (y que podrı́an dar una idea del grado de formalidad del lenguaje empleado) o el número de interjecciones (que podrı́a ser también indicativo de la formalidad o informalidad del mensaje). 5. Trabajo relacionado La red social Twitter se ha convertido en los últimos años en foco de estudio preferente para la comunidad investigadora dentro del área de la recuperación de información y la minerı́a de opiniones. El volumen de datos que se genera en Twitter y su particular idiosincrasia han abierto un nuevo panorama de oportunidades y retos para la comunidad investigadora en el área de las tecnologı́as del lenguaje humano. Muchos de los estudios realizados en este campo están relacionados con el análisis de opiniones [3] y la detección de eventos en tiempo real [6]. El lenguaje informal usado habitualmente en Twitter ha llevado a realizar numerosos trabajos para la adaptación de técnicas aplicadas tradicionalmente sobre textos formales, como el etiquetado de entidades [5]. Dentro del campo de la búsqueda de información, la tarea TREC Microblog,7 centrada en el desarrollo y evaluación de sistemas de recuperación de información sobre Twitter, se celebró por primera vez en 2011 con un notable éxito de participación. Son numerosos los estudios centrados en la evaluación de medidas para ponderar la relevancia de los tweets con respecto a una consulta [1]. Por lo que respecta a la búsqueda de respuestas, existen algunos productos comerciales para la detección de preguntas formuladas en Twitter, ofreciendo la posibilidad a los usuarios de esta red social de responder a las preguntas. No se trata de sistemas automáticos de BR, sino de interfaces que facilitan que los usuarios respondan a las preguntas formuladas por otros ususarios, siguiendo la filosofı́a de los sistios sociales de búsqueda de respuestas como Yahoo! Answers. InboxQ8 y TweetQA9 son dos ejemplos de este tipo de aplicaciones. Estos sitios no aplican ningún tipo de análisis para detectar cuándo un usuario a formulado una pregunta, sino que sus mensajes deben emplear unos patrones fijos en su consulta para que sean detectadas por la aplicación. Fuera del contexto de la búsqueda de respuestas, existe un trabajo similar al nuestro en su intención, aunque no en su fondo [10]. En este trabajo se propone un sistema de clasificación para el campo de la biomedicina capaz de determinar cuándo una pregunta puede ser contestada o no por especialistas médicos. Para ello utilizan un corpus de preguntas clasificadas y una ontologı́a médica para determinar sobre qué patologı́as se puede dar respuesta y sobre cuáles no. 7 8 9 http://trec.nist.gov/tracks.html. https://www.inboxq.com/. http://www.tweetqa.com/. 6. Conclusiones y trabajo futuro En este trabajo se ha planteado un sistema para la detección de preguntas reales formuladas por usuarios de Twitter. Este sistema pretende ser un paso previo para un cambio de paradigma en el funcionamiento de los sistemas de BR, haciendo que los propios sistemas sean los que detecten las necesidades de información de los usuarios y acudan en su ayuda. Se ha desarrollado un clasificador capaz de discriminar entre preguntas reales y preguntas retóricas, estudiando el rendimiento de diferentes algoritmos y caracterı́sticas de aprendizaje en el proceso. Los resultados obtenidos son prometedores, alcanzando valores por encima del 80 % de precisión. Como trabajo futuro se plantea la ampliación del corpus de entrenamiento y el estudio de los tipos de pregunta que se dan en Twitter, además de incorporar al sistema el tratamiento de preguntas indirectas. Referencias 1. Duan, Y., Jiang, L., Qin, T., Zhou, M., Shum, H.Y.: An empirical study on learning to rank of tweets. In: Proceedings of the 23rd International Conference on Computational Linguistics. pp. 295–303. COLING ’10, ACL, Stroudsburg, PA, USA (2010) 2. InboxQ: Twitter’s loaded questions: How people ask and answer questions on twitter. http://blog.inboxq.com/?page=7 (2011), [Accedido 14-Diciembre-2011] 3. Joshi, A., Balamurali, A.R., Bhattacharyya, P., Mohanty, R.: C-feel-it: a sentiment analyzer for micro-blogs. In: Proceedings of the 49th Annual Meeting of the Association for Computational Linguistics. pp. 127–132. HLT ’11, ACL, Stroudsburg, PA, USA (2011) 4. Li, X., Roth, D.: Learning question classifiers: the role of semantic information. Natural Language Engineering 12(3), 229–249 (2006) 5. Ritter, A., Clark, S., Mausam, Etzioni, O.: Named entity recognition in tweets: an experimental study. In: Proceedings of the Conference on Empirical Methods in Natural Language Processing. pp. 1524–1534. EMNLP ’11, ACL, Stroudsburg, PA, USA (2011) 6. Sakaki, T., Okazaki, M., Matsuo, Y.: Earthquake shakes twitter users: real-time event detection by social sensors. In: Proceedings of the 19th conference on World Wide Web. pp. 851–860. WWW ’10, ACM, New York, NY, USA (2010) 7. Tomás, D.: Sistemas de clasificación de preguntas basados en corpus para la búsqueda de respuestas. Ph.D. thesis, Departamento de Lenguajes y Sistemas Informáticos, Universidad de Alicante, España (Julio 2009) 8. Twitter: Twitter turns six. http://blog.twitter.com/2012/03/ twitter-turns-six.html (2011), [Accedido 26-Marzo-2012] 9. Voorhees, E.M.: The trec-8 question answering track report. In: Eighth Text REtrieval Conference. NIST Special Publication, vol. 500-246, pp. 77–82. National Institute of Standards and Technology, Gaithersburg, USA (1999) 10. Yu, H., Sable, C.: Being erlang shen: Identifying answerable questions. In: Proceedings of the Workshop on Knowledge and Reasoning for Answering Questions. IJCAI ’05 (2005)