Audio Expresivo e Inteligencia Artificial: SaxEx y JIG

Anuncio

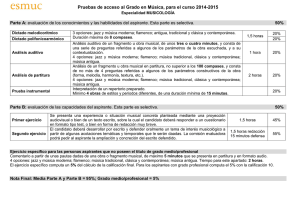

Audio Expresivo e Inteligencia Artificial: SaxEx y JIG Diego Arias Morán Universidad Carlos III de Madrid NIA 100077460 [email protected] SUMARIO SaxEx es un sistema basado en casos diseñado para generar interpretaciones expresivas de melodías basándose en ejemplos de interpretaciones humanas. La resolución mediante CBR es apropiada ya que se pueden conseguir múltiples casos resueltos o precedentes, es decir, grabaciones de interpretaciones humanas. JIG (Jazz Improvistaion Generator) es un sistema capaz de crear improvisaciones ’formulaicas’ monofónicas en clave de jazz usando restricciones en combinación con aleatoriedad para generar los atributos de nota. Palabras clave inteligencia artificial, CBR, case based reasoning, audio, SMS, spectral modelling synthesis, creatividad, expresividad, jazz, SaxEx 1. INTRODUCCIÓN 1.1. La creatividad artificial también puede ser La creatividad es un potencial que se puede entrenar, desarrollar y evolucionar. No se enseña, sino que se desbloquea. Básicamente, la creación artificial – como la natural – se compone de dos procesos computacionales: uno “generador” y otro “evaluador”. Varias técnicas de Inteligencia Artificial ya han demostrado que es factible modelizar actividades creativas en muchos campos: artes (música, literatura), ciencias (física, matemática), tecnologías (ingeniería, arquitectura), juegos (ajedrez, damas), etc. 1.1.1. Creatividad humana Aunque no existe una definición única, se podría decir que la creatividad es la capacidad de unir, asociar, conectar, integrar o combinar diferentes ideas ya existentes – y previamente no relacionadas – de manera no habitual, inesperada, sorpresiva, impredecible e innovadora, a fin de producir nuevas ideas más complejas y potentes adaptadas a los nuevos propósitos. No obstante, es preciso que sean útiles, pertinentes, razonables y/o viables; es decir, se deben descartar todas aquellas ideas descabelladas, inalcanzables o absurdas. De allí que la creatividad es un concepto parcialmente subjetivo y relativo a un contexto sociocultural: lo que en una cultura puede ser valioso, útil o beneficioso en otra puede no serlo. En el caso del ser humano, la creatividad no es algo exclusivo de algunas personas sino que es inherente a toda la especie. Aunque, conviene aclarar, no todos son igualmente creativos: algunos lo son mucho más que otros e incluso unos pocos son extraordinarios. La creatividad no se enseña sino que se desbloquea. Si el entorno local (físico y sociocultural) es capaz de estimular, motivar o alentar, entonces la creatividad florece. 1.1.2. Creatividad, inteligencia e imaginación La creatividad no necesariamente va aparejada con la inteligencia (se puede ser mucho más creativo que inteligente y viceversa), pero depende de ella. También está relacionada con la imaginación: crear es poner de manifiesto aquello que se imagina. Por último, depende también del conocimiento y de la experiencia, aunque si bien es muy útil contar con un bagaje mínimo, el exceso de conocimientos y de experiencias puede restringir la creatividad. Aparentemente para ser creativo son condiciones esenciales la motivación y la colaboración entre las personas; mientras que son aspectos importantes o necesarios el aprendizaje y la interacción con el entorno (físico y social) [1]. En términos generales, las personas creativas no sólo dependen del proceso cognitivo sino que también dan importancia a aspectos afectivos de su personalidad para la solución de los problemas que se les presenta. 1.1.3. El proceso creativo El proceso creativo consta, básicamente, de dos etapas: una generadora y otra evaluadora, que se descomponen, a su vez, en cuatro “momentos” distintos (dos conscientes, separados por dos inconscientes): – Preparación: se selecciona y recolecta la mayor cantidad de información posible y viable sobre el problema en cuestión, incluyendo lecturas, indagaciones, averiguaciones, consultas, etc. – Incubación: se deja “decantar” el tema. Se trata de un período de aparente inactividad, pero se produce un procesamiento subconsciente de la información recolectada. – Iluminación: se produce el “relámpago creativo”, la inspiración propiamente dicha, el momento en que “caen todas las fichas”. La solución surge abrupta y repentinamente en la mente – Verificación: es el trabajo de evaluación –racional y metódica– a fin de determinar la validez objetiva y/o práctica de la solución obtenida en la etapa de iluminación. De este modo, la preparación y la incubación corresponden a la etapa generadora y la iluminación y la verificación a la evaluadora, respectivamente. Otros autores agregan otros dos “momentos” más (al inicio y al final del proceso) – Cuestionamiento: se percibe algo como problema y se inicia una reflexión profunda a fin de delimitarlo con claridad – Comunicación: es la tarea de dar a conocer lo nuevo, de hacer una adecuada difusión de lo creado. 1.1.4. Las características Las características más comúnmente aceptadas de la creatividad, en la gran mayoría de las personas, son: – Fluidez: es la facilidad para generar un elevado número de ideas. Obviamente cuanto mayor es su número, más probable resulta encontrar una alternativa o solución útil y beneficiosa. – Flexibilidad: es la habilidad para modificar, transformar, replantear o reinterpretar –de muy diversas formas– ideas, explorando líneas diferentes. – Originalidad: es lo que define a la idea como algo único, nuevo, inusual, novedoso, diferente o inédito. Significa apartarse de lo obvio, de lo habitual, romper la rutina, dar un salto desde lo conocido. – Elaboración: es el nivel de detalle, desarrollo o complejidad de las ideas creativas. 1.2. Creación artificial Básicamente, la creación artificial –como la natural– se compone de dos procesos computacionales: uno “generador” y otro “evaluador”. En cuanto al primer proceso, es fácil para la máquina generar muchas de las soluciones posibles a un determinado problema. Es así que, en muchas ocasiones y dado que funciona a toda hora (y durante días), encuentra resultados inesperados, soluciones originales, que el ser humano posiblemente habría pasado por alto. Lo que ocurre es que sólo es capaz de combinar “ideas” previamente conocidas, no puede realizar asociaciones inéditas, transgredir, “traspasar los límites” o “romper las reglas” como hacen los grandes creadores. En cuanto al segundo proceso, es difícil evitar que la máquina haga cosas inútiles. Por el momento, no posee la capacidad de evaluar y, por lo tanto, de escoger únicamente la solución más adecuada. No obstante, se puede implementar un “sistema creador”, compuesto por una máquina y por un ser humano, en donde la computadora genere abundante material recombinado y el hombre la guíe por el camino más interesante o la máquina efectuara los procesos inferiores de una obra y el ser humano continuara el trabajo en un nivel superior. 1.2.1. Diferentes técnicas Varias técnicas de Inteligencia Artificial que ya han demostrado su valía para modelizar actividades creativas [2]. Como ya han aparecido en la asignatura, se describen sintéticamente a continuación [3]: – Sistemas Expertos: Emulan artificialmente ciertos aspectos del razonamiento de un especialista humano en un ámbito restringido y limitado de conocimiento. Su característica principal es que se basan en reglas; es decir, contienen un juego predefinido de conocimientos que se utiliza para tomar sus decisiones. – Razonamiento Basado en Casos Aprovecha la experiencia adquirida en el pasado para resolver el problema actual, a través de su gran base de conocimientos con ejemplos de casos ya resueltos (históricos). A la hora de resolver un nuevo caso, el sistema busca en su memoria y recupera aquel que más se le asemeje adaptándolo al problema actual. Al incorporar permanentemente nuevos casos a su memoria, el sistema va adquiriendo más “experiencia” con el tiempo. Se trata, en definitiva, de un aprendizaje por analogía. – Redes Neuronales Artificiales: Inspiradas en el cerebro humano, están compuestas por una multitud de procesadores paralelos interconectados, cada uno de los cuales es capaz de efectuar sólo un pequeño número de operaciones simples y transmitir sus resultados a sus vecinas. A las redes neuronales no se les “inculca” ningún tipo de regla, sino que son capaces de aprender a reconocer patrones, a partir de un proceso de entrenamiento basado en el análisis automático y sistemático de una suficiente cantidad de ejemplos diferentes. Son hábiles para manipular datos imprecisos, incompletos, con ruidos y hasta compuestos de ejemplos contradictorios. – Algoritmos Genéticos Son métodos adaptativos de búsqueda que se basan en los mecanismos de evolución biológica. En ellos se codifica cada una de las posibles soluciones a un problema dado en forma de cadenas de caracteres de longitud fija llamados “genes”. Se genera una “población” inicial de prueba, a la cual se evalúa posteriormente según un criterio de desempeño fijado con anterioridad (la “función de adecuación” o fitness). En cada cada ciclo o generación se eligen las soluciones que más se aproximan al objetivo buscado, descartando el resto de las soluciones. Las más aptas se combinan entre sí para producir una descendencia nuevas soluciones, permitiendo introducir alguna modificación al azar (una “mutación”) durante la reproducción. Este ciclo se itera hasta llegar a aquella considerada aceptable. – Sistemas Multiagentes Se componen de un conjunto de entidades relativamente autónomas e inteligentes que cooperan entre sí para desarrollar una tarea o resolver un problema (agentes). Se trata de comunidades de agentes, cuyas propiedades no pueden derivarse únicamente de las de sus partes constitutivas.. El Razonamiento Basado en Casos (CBR, Case Based Reasoning) cuenta con varias aplicaciones completamente funcionales en el campo del audio, como son: – Estudio de la similitud melódica (diferentes algoritmos compitiendo en el Music Information Retrieval Exchange MIREX [9]) – Transformaciones temporales de grabaciones monofónicas de audio respetando su expresividad: Tempo-Express. – Síntesis de audio expresivo mediante SMS por imitación de un intérprete humano: SaxEx [15]. – Generación de improvisaciones: JIG (Jazz Improvisation Generator [16], incorporado posteriormente como parte de SaxEx) Tempo-Express está desarrollado en la tesis doctoral de M. Grachten, pero por la extensión de esta queda fuera de nuestro ámbito. Sí entraremos a examinar tanto SaxEx como JIG, dos sistemas capaces capaces de generar audio expresivo, cada uno centrando su “creatividad” en un campo: SaxEx en la creación de interpretaciones expresivas y JIG en la composición de nuevas melodías derivadas de temas y estándares de jazz. 2. EXPRESIVIDAD EN LA EJECUCIÓN MUSICAL Cuando un ejecutante interpreta música a partir de una partitura, el resultado nunca es una reproducción literal y mecánica de la partitura (la llamada ejecución nominal). Incluso cuando músicos (expertos) tocan intencionadamente de una manera mecánica, aparecen diferencias notables con respecto a la ejecución nominal. 2.1. Factores La investigación en torno a la ejecución musical data desde al menos el final del siglo XIX. Repp mostró que los estudiantes de piano eran tan capaces como los profesionales de producir repetidamente versiones muy similares de la misma pieza. En 1913, Johnstone observó que en las ejecuciones pianísticas, las notas pertenecientes a la melodía se tocan de forma habitual ligeramente adelantadas con respecto a las notas pertenecientes a acordes en la misma posición métrica. Actualmente se acepta que la interpretación de una pieza musical está determinada o influida por varios factores. En primer lugar, las condiciones físicas del músico y su instrumento, ya que el tipo de instrumento determina en gran medida el carácter de la interpretación. Además, las condiciones fisiológicas del intérprete (como fatiga o estado de salud) pueden jugar un papel. En segundo lugar, las habilidades motoras de cada persona determinarán el grado de desviación no intencionada de la ejecución frente a la partitura. Un músico experimentado controla mejor su velocidad motora y su exactitud. Un tercer factor son los aspectos afectivo-cognitivos del músico. Sloboda muestra que los ejecutantes se desvían sistemáticamente de la partitura cuando tocan variaciones de la pieza consistente en la misma secuencia de notas (con sólo su emplazamiento en el compás cambiado. Este resultado elimina la posibilidad de que las desviaciones sean debidas a limitaciones motoras humanas. Otros estudios muestran desviaciones sistemáticas en interpretaciones dotadas de caracteres o intenciones diferentes. 2.1.1. Recursos interpretativos: Podemos concluir de los estudios y razonamientos anteriores que los ejecutantes enriquecen el sonido usando las siguientes técnicas: – Desviación en tiempo – Articulación – Dinámica – Modulación (vibrato) – Ornamentaciones La señal de audio lleva, por tanto, una gran cantidad de información acerca de la expresividad, que deberíamos ser capaces de sintetizar en un conjunto de descriptores de alto nivel. 2.2. Transformación temporal expresiva Se ha discutido si los aspectos temporales de la interpretación se escalan uniformemente cuando el tempo cambia [6], esto es, si las duraciones de todas las notas producidas mantienen sus proporciones relativas. Esta hipótesis es denominada la invariancia relacional (de la duración bajo cambios de tempo). Se han hallado discrepancias con esta teoría [Desain and Honing, 1994; Friberg and Sundström, 2002; Timmers et al., 2002], y un reciente estudio muestra que los oyentes son capaces de determinar cuando grabaciones de jazz y música clásica han sido uniformemente comprimidas en tempo a partir solamente a partir de aspectos expresivos de las interpretaciones. [Honing, 2006]. De hecho es posible revelar cómo el contenido expresivo de las piezas varía con el tempo. La gráfica muestra la frecuencia de aparición de varios tipos de recursos expresivos, como ornamentación y consolidación, como una función del tempo nominal de las interpretaciones (el tempo anotado en la partitura), entendido como eventos discretos más que como aspectos numéricos continuos como la temporización o las desviaciones dinámicas . Figura 1 Frecuencia relativa de eventos en función del tempo Según la figura, la ornamentación, por ejemplo, muestra un descenso muy acusado con el incremento del tempo. La frecuencia de aparición de cierto tipo de eventos interpretativos, especialmente de la consolidación, crece con el tempo. La siguiente gráfica muestra cómo varían sistemáticamente varios parámetros expresivos comparando diferentes interpretaciones de la misma frase con diferentes tempos (medidos en pulsos o “tiempos” por minuto, BPM). El eje x muestra las diferencias de tempo entre las dos interpretaciones. En la figura superior izquierda, el eje y muestra el valor eficaz (RMS) de la diferencia absoluta en el comienzo (onset) de nota. La figura superior izquierda muestra el valor eficaz de la diferencia de duración entre pares de notas, la inferior izquierda el valor de la diferencia de energía y la inferior derecha muestra la distancia entre interpretaciones, consideradas como dos secuencias de eventos interpretativos. La distancia aumenta en esta última cuando las secuencias contienen diferentes elementos. En las cuatro gráficas las diferencias se incrementan conforme aumenta el tempo al que se interpreta la frase. En algunos parámetros el cambio puede parecer pequeño pero hay que tener en cuenta que el impacto real de las interpretaciones viene dado por la combinación de todos los parámetros. Los efectos en los parámetros individuales son acumulativos. Figura 2 Diferencias entre ejecuciones (de la misma frase) frente a su diferencia de tempo Las anteriores observaciones apoyan la idea de que algunas circunstancias la invariancia relacional puede transmitir ciertos aspectos de la expresividad, en general no se puede asumir que todos los aspectos expresivos se transformen de manera lineal o permanezcan constantes cuando el tempo de la interpretación cambia. En otras palabras, la transformación temporal de música involucra más técnicas que el uniform time stretching (UTS). Este concepto será usado en SaxEx para permitir aplicar ataques, variaciones de dinámica u otros parámetros de expresividad extraídos de la base de casos a otras melodías con diferente tempo. 2.3. Análisis: Descripción de Contenidos Para preparar los casos, así como el problema, se debe llevar a cabo un análisis musical sobre la partitura del tema. Los resultados se usarán en el proceso de solución del problema, por ejemplo para segmentar frases en grupos más pequeños de notas y para llevar a cabo la recuperación de casos. Una descripcióna nivel de nota (como MIDI) no es suficiente, ya que solo permite un modelizado limitado de la expresividad (desviaciones en tiempo, inserción de notas…). Mucha de la expresividad se haya a nivel de intra-nota (vibrato, articulación) y otra se haya colocada por encima, a un nivel de motivo (dinámicas). 2.4. El Modelo de Implicación/Realización Narmour ha propuesto una teoría de la percepción y la cognición de melodías, el Modelo de Implicación/Realización o modelo I/R. De acuerdo con esta teoría, la percepción de una melodía genera continuamente previsiones en los oyentes acerca de cómo continuará la melodía. La fuente de estas previsiones es doble, siendo tanto innatas como adquiridas. Los factores innatos son procesos predefinidos en nuestro cerebro y nuestro sistema periférico, mientras que los aprendidos se debe a la exposición a la música como un fenómeno cultural y la familiaridad con determinados estilos de música. Igual que en la teoría Gestalt de la visión, los elementos individuales se combinan para formar unidades percibidas como un todo (“gestalt”). El agrupamienmto sigue los principios de proximidad (perceptual), similitud y continuación (es decir, los elementos aparecen como una sucesión natural). Narmour, siguiendo con la analogía, indica que esperamos oír, después de cierto intervalos, una determinada nota con más probabilidad que otras. Hay dos principios básico que regulan este comportamiento: – Dirección registral – Diferencia interválica La dirección registral supone que un pequeño intervalo ascendente hace esperar otro intervalo ascendente (análogamente para intervalos descendentes), e intervalos grandes implican cambios en la dirección registral. La diferencia interválica supone que un intervalo menor de 5 semitonos implica un intervalo posterior de tamaño similar (hasta dos semitonos mayor o menor) y un intervalo mayor implica un intervalo subsiguiente menor. perceptual con el sonido original cuando no se realizan transformaciones. Su aproximación particular al análisis espectral es la descomposición del sonido en sinusoides más un residuo espectral [17]. El proceso puede se automático o controlado por el usuario dependiendo de las características del sonido. Basándonos en estos principios, los patrones melódicos pueden respetar o violar las implicaciones. Los patrones son denominados estructuras y se etiquetan de acuerdo a sus características registrales e interválicas. Figura 3 Estructuras básicas del modelo I/R y primeros compases de “All of Me” anotado con estructuras I/R. Se pueden diseñar algoritmos que clasifiquen las estructuras presentes en una melodía según sus análisis I/R, por ejemplo para integrar archivos de audio de interpretaciones reales en nuestra base de casos. Se pueden usar mecanismo estandarizados con el fin de acoplarse a la norma MPEG-7, guardando los datos en formato XML. 3. SaxEx: CBR para la generación interpretaciones musicales expresivas. de El principal obstáculo para generar automáticamente interpretaciones musicales expresivas es que los intérpretes humanos usan conocimientos musicales que no están explícitamente indicados en la partitura. Además, estos conocimientos son difíciles de verbalizar y por tanto las implementaciones con IA basadas en representaciones declarativas de conocimiento tienen serias limitaciones. Una aproximación alternativa es el uso directo de estos conocimientos implícitos en grabaciones de interpretaciones humanas. Trabajos previos habían intentado resolver el problema principalmente por medio de instrumentos MIDI con sus inevitables limitaciones, sobre todo en materia de expresividad. SaxEx es un sistema basado en casos diseñado para generar interpretaciones expresivas de melodías basándose en ejemplos de interpretaciones humanas. La resolución mediante CBR es apropiada ya que se pueden conseguir múltiples casos resueltos o precedentes, es decir, grabaciones de interpretaciones humanas. 3.1. Análisis y resíntesis: SMS Las técnicas de análisis y síntesis basadas en modelos espectrales como SMS (Spectral Modeling Synthesis) son útiles para extraer parámetros de alto nivel de sonidos reales, para transformarlos y para la síntesis de una versión modificada del original. La finalidad de SMS es obtener una representación del sonido general y musicalmente significativa, a partir de la cual podemos manipular parámetros musicales manteniendo la identidad Figura 4 GUI de SMS . La ventana superior muestra la forma de onda del sonido de entrada, la central muestra la evolución en frecuencia de los parciales, y la inferior contiene el residuo espectral. De la representación senoidal y residual podemos extraer parámetros de alto nivel cuando el sonido es una nota o una frase monofónica de un instrumento. SaxEx usa SMS para obtener información básica relacionada con varios parámetros de expresividad como dinámica, rubato, vibrato y articulación a partir de datos de tiempos de ataque y de caída, estructura de formantes o amplitud y altura medias. Todos estos parámetros se pueden modificar y añadir a la representación espectral sin ninguna pérdida de calidad sonora. El análisis SMS se comporta como un preproceso para extraer los parámetros musicales de alto nivel, mientras que la síntesis SMS añade las transformaciones especificadas por el sistema CBR al sonido original, lo que permite a SaxEx generar nuevas interpretaciones expresivas (nuevos archivos de sonido). 3.1.1. Modelado de conocimientos musicales SaxEx incorpora como base conocimientos musicales construidos sobre el modelo de implicación/realización de Narmour y la teoría generativa de la música tonal (GTTM) de Lerdahl y Jackendoff. Estas teorías de percepción y entendimiento musical son las bases del modelo computacional de conocimiento musical del sistema. 3.1.2. Implementación La parte cognitiva está implementada en Noos, un lenguaje de representación reflectivo orientado a objetos, diseñado para soportar el modelado de conocimiento para la resolución de problemas y el aprendizaje. Este lenguaje está implementado en Common Lisp y puede funcionar en diversas plataformas, siendo la Macintosh plataforma principal de desarrollo, a través de un entorno gráfico de ventanas. Modelar un problema en Noos requiere especificar tres tipos diferentes de conocimiento: – de dominio – de resolución de problemas – de metanivel Figura 5 Parte de la partitura de “All of Me” representada en Noos El conocimiento de dominio especifica un conjunto de conceptos, relaciones entre conceptos y datos del problema relevantes para una determinada aplicación, quedando definida la ontología de dominio. En este caso, la ontología de dominio está compuesta por notas, acordes, estructuras de implicación/realización y parámetros expresivos. Los datos de problema definen situaciones específicas que tienen que ser resueltas (por ejemplo frases en concreto que deben ser transformadas). Noos está basado en feature terms (términos característicos), que corresponden a estructuras similares a registros agrupando una colección de características. Esto genera una representación de partitura como la de la figura, a partir de los parámetros usados en el modelado. sistema infiere una serie de posible transformaciones expresivas para una pieza dada. Finalmente, usando la síntesis SMS y el set de transformaciones inferidas, SaxEx genera nuevas interpretaciones expresivas de los mismos estándares de jazz y también de otras melodías de similar carácter no presentes en el grupo de casos (base de conocimientos) original. SaxEx ha sido desarrollado especificando dos tipos diferentes de conocimiento: – modelado de conceptos y estructuras relevantes para representar el conocimiento musical – desarrollo de un método de resolución para hallar la secuencia de transformaciones expresivas necesaria para una frase musical dada. El conocimiento de resolución de problemas especifica el conjunto de tareas a resolver en una aplicación (la secuencia de transformaciones en este caso). Los métodos modelan los modos de resolver las tareas. Éstos a su vez pueden ser elementales o estar divididos en subtareas. Para una sola tarea puede haber múltiples métodos capaces de llevarla a cabo. El conocimiento reflectivo o de metanivel son datos acerca de los dos dominios de conocimiento anteriores. Se puede usar como criterio en la selección de los métodos para una tarea específica. Una vez que un problema (tarea) es resuelto, Noos lo almacena e indexa, siendo esta característica lo que lo hace adecuado para los sistemas de aprendizaje no supervisado y específicamente, para los sistemas de razonamiento basado en casos. 3.1.3. Proceso El estudio de la expresión musical en SaxEx se centra en el contexto de las interpretaciones de saxofón tenor. Basándose en varias grabaciones de un ejecutante de saxo tocando estándares de jazz con diferentes grados de expresividad, incluida una versión (casi) inexpresiva de cada pieza. Estas grabaciones son analizadas usando las técnicas de modelado espectral SMS con el fin de extraer información básica relacionada con los parámetros expresivos. El conjunto de parámetros extraídos junto con las partituras de las piezas constituye el grupo de casos que conforma los sistemas CBR. Con este set de casos y usando criterios de similitud basados en los conocimientos musicales de base, el Figura 6 Diagrama de bloques de SaxEx 3.1.4. El Razonador Basado en Casos El método de resolución desarrollado sigue la descomposición en subtareas de los métodos CBR: recuperar (retrieve), adaptar (reuse/adapt), e incorporar (retain/incorporate): ­ Si se comparan ambas versiones, se podrá comprobar cambios en la distribución temporal de algunas notas, crescendo en las melodías ascendentes y decrescendo en notas largas, uso del vibrato y cambios en la articulación, que pasa a ser más marcada. Retrieve: Elección del conjunto de notas (casos) más similares al problema actual. Esta tarea es descompuesta en tres subtareas: · Identify: construcción de patrones de recuperación usando dos criterios alternativos: estructuras de implicación/realización de Narmour o importancia métrica (dada por GTTM) de las notas. · Search: búsqueda de casos en la memoria de Noos usando sus métodos de recuperación y patrones previamente construidos. · Select: clasificar por rango los casos recuperados usando los métodos preferentes de Noos, que usan criterios como similitud en la duración de las notas, estabilidad armónica o direcciones melódicas. ­ ­ Reuse/Adapt: Elección de transformaciones expresivas a ser aplicadas en el problema actual entre las del conjuntos de casos similares. El criterio usado privilegia las opciones con mayor grado de similitud. Retain/Incorporate: Incorporación del nuevo problema resuelto a la memoria de casos, realizada de forma automática en Noos. Todos los problemas resueltos estarán disponibles para futuros procesos de razonamiento. Figura 8 Autumm Leaves y All of Me 3.2. Conclusiones Existe bastante literatura sobre descripción de la expresividad natural a partir de interfaces similares a MIDI: – Widmer et al., reglas para interpretación expresiva en piano. – Dillon, Camurri et al., reconocimiento de estados anímicos – Bressin et al., reglas y ANN para interpretación automática – Desain & Honing, correspondencia partiturainterpretación – Gómez et al., transformaciones expresivas de tempo en interpretaciones de jazz – Ramirez et al., reglas para la predicción de la expresividad en interpretaciones de jazz También se ha llevado a cabo trabajo sobre el modelado tímbrico de sonidos aislados (Jenssen, K) como factor de expresividad. Sin embargo trabajos anteriores sobre el análisis y síntesis de expresión musical sólo habían abordado el estudio de parámetros como ritmo y vibrato, Figura 7 Descomposición de tareas CBR de SaxEx 3.1.5. Dos (pequeños) ejemplos Como ejemplo, podemos escuchar las transformaciones introducidas en dos fragmentos, uno de “Autumn Leaves” y otro de “All of Me”, obtenidas a partir del análisis de las interpretaciones expresivas de otras piezas y la aplicación a otras piezas distintas. En concreto, se trabajó sobre tres interpretaciones expresivas de piezas conteniendo cerca de cincuenta notas con el fin de generar ejecuciones expresivas de unas veinte notas. El uso en Noos de perspectivas permitió al sistema identificar situaciones como notas largas, melodías ascendentes y descendentes, etc. que también son usadas como referencias (de dinámica por ejemplo) por intérpretes humanos. Los ejemplos sonoros de interpretación inexpresiva y de transformación expresiva se adjuntan con este documento. Widmer es el único que previamente había intentado generar música expresiva basándose en ejemplos, aunque mediante un método basado en descripciones para el aprendizaje de dinámicas y rubato en un contexto MIDI, usando un piano electrónico. En SaxEx se manejan con muchos parámetros expresivos adicionales en el contexto de un instrumento más rico expresivamente. Los resultados obtenidos se asemejan a una interpretación humana en parámetros como rubato, vibrato y dinámicas, aunque las articulaciones requieren un mayor grado de atención. 4. JIG Generador de Improvisaciones Jazz JIG genera improvisaciones ’formulaicas’ monofónicas en clave de jazz usando restricciones en combinación con aleatoriedad (condicionada por probabilidad) para generar los atributos de nota. De esta manera, numerosas improvisaciones se pueden generar a partir de una sola pieza. JIG ha sido incorporado en SaxEx, que se encarga de modificar los atributos expresivos de la nota, como dinámica y articulación. Por tanto, JIG sólo necesita generar los atributos de duración y altura a partir del tema de la pieza y su armonización. Las improvisaciones supuestamente deben cumplir estas tres grandes restricciones: – Tonalidad: la improvisación debe ser tonal respecto al resto de la música y por tanto predominantemente consonante. – Continuidad: el contorno melódico de la improvisación debe ser mayormente suave; los intervalos grandes se usarán ocasionalmente y la dirección de registro no será frecuentemente variada. – Estructura: la improvisación no debería ser meramente una secuencia de notas no relacionadas; de alguna manera, se debería poder identificar grupos interrelacionados de notas Las dos primeras restricciones son relativamente sencillas de satisfacer, usando el contexto local. La estructura requiere una elaboración mas detenida, y la improvisación puede tomar distintas formas en función de la estructura elegida. Un tipo de improvisación reconocida en el jazz es la llamada “formulaica”, es decir la construida mediante el uso de fórmulas (pequeños fragmentos melódicos tambén llamados motivos). Las fórmulas pueden provenir del repertorio personal o del tema. No deben aparecer literalmente, sino que deben ser transformadas para ajustarse al contexto y pueden unirse mediante secuencias de notas de transición, o melódicas. Para derivar la altura final del pitch-type se tienen en cuenta 3 factores: – Altura de la anterior nota – Dirección melódica (deseada) o armónica del siguiente acorde. – Valor medio del intervalo entre las últimas notas Como podemos ver en la figura la altura se elegiría entre una serie de valores: Figura 11 Probabilidad de elección de nota 4.2. Conclusiones 4.1. Proceso El proceso para generar cada tipo de notas será diferente, y se elegirá uno u otro en cada momento según una distribución estadística a flta de desarrollar un métiodo más preciso. Para la generación de motivos, si se dispone de un análisis de la pieza según el modeo de Narmour, será más fácil identificarlos ya que cada una de las secuencias lleva aparejado un carácter conclusivo o no conclusivo que determinan la posible funcionalidad de un grupo de notas como motivo. Las improvisaciones generadas por JIG cumplen el requisito de tonalidad con bastante facilidad, aunque a veces la selección de escala basándose tan sólo en lo acordes usados en ese momento produce elecciones extrañas en los fragmentos entre motivos. La condición de estructura quizás sea la menos evidente, ya que está no está formalmente demasiado clara. A modo de ejemplo, esta es una improvisación generada por JIG sobre “Autumn Leaves”. El uso del principio del tema como motivo es bastante claro. Figura 12 Improvisación sobre “Autumn Leaves” En la presentación se incluye una improvisación corta creada con JIG y SaxEx. Figura 9 Proceso de generación melódico En el proceso melódico, la duración es generada antes que la altura, debido a la relativamente más restringida gama de alturas. Una vez que se ha determinado una duración, el contexto es suficientemente específico como para generar un pitch-type, del que se deriva la altura real del sonido. El proceso de motivos usa fragmentos preexistentes para generar no un solo valor, sino la entonación general del motivo. El proceso es similar al melódico: Figura 10 Proceso de generación de motivos Otros ejemplos interesantes de programas creativos son el sistema informático desarrollado por Roger Dannenberg capaz de generar en tiempo real toda la sección rítmica de acompañamiento de un solista interpretando blues; o NeurSwing de Dennis Baggi que también genera la sección rítmica para un solista improvisando jazz. 5. REFERENCIAS [1] Langen, Pieter van; Wijngaards, Niek y Brazier, Frances (2004): Towards Designing Creative Artificial Systems. AI EDAM (Engineering Design, Analysis and Manufacturing), Special Issue on Learning and Creativity in Design, vol. 18, N° 4, p. 217-225 www.iids.org/publications/AIEDAM04_Creativity.pdf [2] López de Mántaras, Ramón (2000): Inteligencia artificial y creatividad. Mecad, número 3, marzo. Barcelona. http://www.mecad.org/e-journal/archivo/numero3/art1.htm [3] Moriello, Sergio (2005): Inteligencia Natural y Sintética. Buenos Aires, Editorial Nueva Librería. [4] Pease, Alison; Winterstein, Daniel y Colton, Simon (2001): Evaluating machine creativity. Proc. ICCBR 2001 Workshop on Creative Systems: Approaches to Creativity in Artificial Intelligence and Cognitive Science (Bento, C., & Cardoso. A., Eds.). http://homepages.inf.ed.ac.uk/s9904767/papers/iccbr01.pdf [5] Saunders, Rob y Gero, John (2001): Artificial Creativity: Emergent Notions of Creativity in Artificial Societies of Curious Agents. http://www.vf.utwente.nl/%7Ehmiproj6/AL/SaundersGero2 001SecondIteration.pdf [6] Repp, B. H. (1995): Quantitative effects of global tempo on expressive timing in music performance: Some perceptual evidence. Music Perception, 13: p.39–58. [7] Juslin, P. N.; Friberg, A. y Bresin, R. (2002). Toward a computational model of expression in music performance: The GERM model. Musicae Scientiae, Special Issue 20012002, 63-122. http://www.psyk.uu.se/hemsidor/musicpsy/abstracts.html#C omp_mod [8] Dillon, Roberto: Extracting audio cues in real time to understand musical expressiveness. Laboratory of Musical Informatics – University of Genoa. [9] Gómez, Emilia; Grachten, Maarten; Amatriain, Xavier y Arcos, Josep Lluís (2003): Melodic Characterization Of Monophonic Recordings For Expressive Tempo Transformations. Proc. Stockholm Music Acoustics Conference, August 6-9, (SMAC 03), Stockholm, Sweden. [10] Grachten, Maarten; Arcos, Josep Lluís (2004). Music Performance Generation as Time Series Prediction. Proc. ECCBR 2004 Workshops: p. 329-336. UCM, Madrid. http://www.iiia.csic.es/langes/publication_detail.php?pub_id=918i [11] Hazan Amaury; Ramirez Rafael y Grachten, Maarten (2006): Evolving Performance Models by Performance Similarity: Beyond Note-to-note Transformations. Music Technology Group, (UPF) - Artificial Intelligence Research Institute (IIIA - CSIC), Barcelona, Spain. [12] Arcos, Josep Lluís; Cañamero, Dolores y López de Mántaras (1998): Affect-Driven Generation of Expressive Musical Performances. IIIA, Artificial Intelligence Research Institute, Spanish Council for Scientific Research CSIC, UAB, Bellaterra, Spain. [13] Arcos, Josep Lluís; Cañamero, Dolores y López de Mántaras (1998): Combining AI Techniques to Perform Expressive Music by Imitation. Artificial Intelligence Research Institute, IIIA; Spanish Council for Scientific Research, CSIC, Campus UAB, Bellaterra, Spain. [14] Arcos, Josep Lluís(1998): Saxex, A Case-Based Reasoning system for generating expressive performances http://www.iiia.csic.es/Projects/music/Saxex.html [15] Arcos, Josep Lluís; López de Mántaras y Serra, Xavier(1998): SaxEx: a case based reasoning system for generating expressive musical performances. Artificial Intelligence Research Institute, IIIA Spanish Council for Scientific Research, CSIC, Campus UAB, Bellaterra – IUA Audiovisual Institut Pompeu Fabra University, Barcelona, Spain. [16] Grachten, Maarten (2004): JIG: Jazz Improvisation Generator. Artificial Intelligence Research Institute, IIIA Spanish Council for Scientific Research, CSIC, Campus UAB, Bellaterra, Spain. [17] Serra, X. (1997). Musical sound modeling with sinusoids plus noise. In Roads, C., Pope,S. T., Picialli, A., and De Poli, G., editors, Musical Signal Processing, pages 91–122. Swets and Zeitlinger Publishers.