Series de Tiempo Estacionarias (Univariadas)

Anuncio

Econometrı́a de series de tiempo aplicada a

macroeconomı́a y finanzas

Series de Tiempo Estacionarias (Univariadas)

Carlos Capistrán Carmona

ITAM

Serie de tiempo

Una serie de tiempo es una sequencia de valores usualmente

registrados en intervalos de tiempo equidistantes.

xt

t = 1, 2, ..., T.

Ejemplos:

I

I

I

I

I

Número de nacimientos por año en México.

Producción semanal de autos en VW México.

Precios diarios del cierre de alguna acción (e.g., TELMEX).

Producción industrial mensual en México.

Inflación mensual en México.

Serie de tiempo

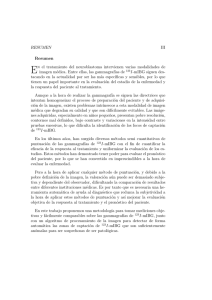

Ejemplo: Inflación anual en México 1925-2010

Inflación Histórica

100

●

●

●

●

●

●

50

●

●

●

●

●

●

●

●●

●

●

●

●

●

●

●

●

●●

●

●

●

●

●

●

●●

●

●●●

●

●●●●●●●●●●●●●

●

●●

●

●

●

0

Cambio % en Deflactor del PIB

150

●

●

●

●

●

●

●

●

●

●●

●

●

●

●

●●●●●●●

●

●

●

●

1940

1960

1980

Años

2000

●

●●

Procesos estocásticos base

Proceso iid (iid)

ε t es un proceso independiente e idénticamente distribuido (iid)

si:

I

ε t , ε s son independientes pero tienen la misma distribución.

Ejemplo: xt = ε t , ε t ∼ N (0, 1), t = 1, ..., 100.

Proceso iid

Ejemplo: xt = ε t ,

ε t ∼ N (0, 1),

t = 1, ..., 100.

3

2.5

2

1.5

1

x

0.5

0

-0.5

-1

-1.5

-2

-2.5

0

20

40

60

80

100

Procesos estocásticos base

Martingala en diferencias (md)

La secuencia M es llamada una martingala si:

E Mt | Mt−j , j = 1, 2, ..., t = Mt−1 .

Una Martingala en diferencias se define como: xt = Mt − Mt−1 .

I

Propiedades:

E x t | Mt − j ,

j≥1

cov (xt , xt−k )

= 0,

= E xt xt−k | Mt−j ,

j ≥ 1 = 0.

Nótese que no es independiente, ya que para eso se necesita:

E (g(ξ t − E [g (ξ t )]) h(ξ t−j ) = 0.

Procesos estocásticos base

Ruido Blanco

ε t es un proceso de ruido blanco si:

I corr ( ε t , ε s ) = 0

∀ t 6= s

I E [ ε t ] es constante para todo t (usualmente 0).

Un proceso de ruido blanco básicamente no tiene estructura

temporal (lineal).

Las principales propiedades de una serie de ruido blanco con

media cero son:

I

I

No hay correlación entre términos

Valores pasados no ayudan a pronosticar valores futuros

Si se utiliza un criterio de mı́nimos cuadrados, se puede mostrar

que el mejor pronóstico de todos los valores futuros de un proceso

de ruido blanco es simplemente la media de la serie.

Nótese que:

ruido

blanco ; Martingala

en

diferencias ; iid.

Estacionariedad y ergodicidad

Primeros dos momentos de una serie de tiempo:

E (xt ) = µt ,

cov(xt , xs ) = λt,s .

¿Cómo se estiman si en cada momento del tiempo sólo tenemos

una realización de cada variable aleatoria?

Inflación Histórica

100

●

●

●

●

●

●

50

●

●

●

●

●

●●

●

●

●

●

●

●

●

●

●

●●

●

●

●

●

●

●

●

●●

●

●●●

●

●●●●●●●●●●●●●

●

●●

●

●

●

0

Cambio % en Deflactor del PIB

150

●

●

●

●

●

●

●

●

●

●●

●

●

●

●

●●●●●●●

●

●

●

●

1940

1960

1980

2000

●

●●

Estacionariedad y ergodicidad

Estacionariedad

Se dice que un proceso estocástico xt es estacionario de segundo

orden (o “estacionario en covarianzas”) si sus primeros dos

momentos no dependen del tiempo:

E [xt ] = µ,

Var [xt ] = σ2 ,

Cov [xt , xt−τ ] = λτ .

Nótese que la covarianzas sólo dependen de la distancia y no del

tiempo.

Se dice que un proceso estocástico xt es estacionario en sentido

estricto si la distribución conjunta de (xt , ..., xt−k ) es independiente

de t para todo k (extremadamente difı́cil de probar).

Estacionariedad y ergodicidad

Ergodicidad

La ergodicidad requiere que valores del proceso suficientemente

separados en el tiempo casi no estén correlacionados.

Una definición, aunque no muy estricta, es: una serie de tiempo

estacionaria es ergódica si cov [xt , xt−τ ] → 0 cuando τ → ∞.

La ergodicidad permite que al promediar una serie en el tiempo,

uno este continuamente añadiendo información nueva y relevante

al promedio.

Desafortunadamente no es posible probar ergodicidad,

simplemente se asume.

Estacionariedad y ergodicidad

Si una serie de tiempo cumple con los supuestos de

estacionariedad y ergodicidad, entonces es posible formar

buenos estimadores de las cantidades de interés promediando a

través del tiempo.

Un estimador consistente de la media es la media muestral:

b=

µ

1

T

T

∑ xt .

t=1

Un estimador consistente de la autocovarianza es la

autocovarianza muestral:

1

b

λτ =

T

T

∑ (xt − µb) (xt−τ − µb) .

t=1

Un estimador consistente de la autocorrelación es la

autocorrelación muestral:

b

λτ

.

ρbτ =

b

λ0

Operadores y filtros

Operador rezago:

Lj xt = xt−j .

Operador diferencia:

∆j xt = 1 − Lj xt = xt − xt−j .

Un filtro cambia las propiedades dinámicas de una serie de

tiempo.

Operadores y filtros

Ejemplos

Ejemplos de filtros:

xt = yt + 3yt−1 + 2yt−2 ,

= (1 + 3L + 2L2 )yt .

xt = yt − yt−1 ,

xt = ( 1 − L ) yt .

Un ejemplo de la aplicación del operador rezago:

xt = axt−1 + ε t ,

(1 − aL)xt = ε t ,

εt

,

(1 − aL)

entonces :

|a| < 1

xt =

si

xt =

∞

∞

j=0

j=0

∑ aj L j ε t = ∑ aj ε t − j .

Modelos Autorregresivos (AR)

AR(p)

Autorregresivo de orden p, AR(p):

p

xt =

∑ φj xt−j + ε t ,

j=1

εt

:

var (ε t ) = σ2

ruido blanco, E [ε t ] = µ,

también puede escribirse como:

φp (L) xt = ε t ,

p

donde φp (L) = 1 − ∑ φj Lj .

j=1

Modelos Autorregresivos (AR)

Condición de estacionariedad

La condición para que un AR(p) sea estacionario es que las raı́ces

de la ecuación caracterı́stica

1 − φ1 z − φ2 z2 − ... ı −φp zp = 0,

estén fuera del cı́rculo unitario (i.e. que el inverso de las raı́ces

estén dentro del cı́rculo unitario, que es lo que usa Eviews).

Lo que esta condición garantiza es que el proceso

φp (L) xt = ε t ,

pueda escribirse como

xt = φp (L)−1 ε t ,

con φp (L)−1 convergiendo a cero, lo que implica que las

autocorrelaciones decaerán conforme aumenta la longitud del

rezago.

Modelos Autorregresivos (AR)

AR(1)

Algunos aspectos importantes de un AR(1):

xt = φxt−1 + ε t

empieza en t = 0,

t

∑ φj ε t−j + x0 φt .

xt =

j=0

asumiendo que x0 = 0, entonces:

i

( h

1 − φ t+1

t

µ

si φ 6= 1

1− φ

E ( xt ) = µ ∑ φ j =

µ (t + 1) si φ = 1

j=0

!2

h

i

t

var (xt ) = E (xt − E (xt ))2 = E ∑ φj ε t−j − µ

j=0

= σ

2

t

∑φ

j=0

(

2j

=

h

1 − φ 2(t+1)

1− φ2

σ2

(t + 1)

σ2

i

si φ 6= 1

si φ = 1

Modelos Autorregresivos (AR)

AR(1)

Un modelo AR(1):

xt = φxt−1 + ε t

es estacionario si |φ| < 1.

¿Porqué?

En este caso, la media y la varianza están dadas por:

E(xt ) =

var(xt ) =

µ

1−φ

σ2

1 − φ2

Modelos Autorregresivos (AR)

AR(1)

La autocovarianza entre xt y xt−1 está dada por:

cov(xt , xt−1 ) = E [(xt − E [xt ]) (xt−1 − E [xt−1 ])]

= E [xt xt−1 ] = E [(φxt−1 + ε t ) xt−1 ]

= φE x2t−1 + E [ε t xt−1 ] = φE x2t−1

= φvar(xt−1 ).

El segundo término desaparece porque xt = ∑tj=0 φj ε t−1−j y por lo

i

h

i

h

−1 j

t−1 j

φ

ε

φ

ε

ε

tanto E ε t ∑tj=

=

E

∑

t t−1−j = 0.

t−1−j

0

j=0

Por lo tanto la autocorrelación está dada por:

ρ1 = corr(xt , xt−1 ) =

cov(xt , xt−1 )

φvar(xt−1 )

=

= φ,

var(xt )

var(xt )

si var(xt ) = var(xt−1 ) que ocurre cuando |φ| < 1.

En general, la función de autocorrelación está dada por:

ρk = corr(xt , xt−k ) = φk .

Modelos Autorregresivos (AR)

Ejemplo: xt = 0.9xt−1 + ε t , con x0 = 0, ε t ∼ N (0, 1), t = 1, ..., 100.

4

3

2

x; AR(1), phi = 0.9

1

0

-1

-2

-3

-4

-5

0

20

40

60

80

100

Modelos Autorregresivos (AR)

Correlograma y correlograma parcial

ACF for x; AR(1), phi = 0.9

1

+- 1.96/T^0.5

0.5

0

-0.5

-1

0

2

4

6

8

10

12

14

lag

PACF for x; AR(1), phi = 0.9

1

+- 1.96/T^0.5

0.5

0

-0.5

-1

0

2

4

6

8

lag

10

12

14

Promedios Móviles (MA)

MA(q)

Promedio móvil de orden q, MA(q):

q

xt =

∑ θ j ε t−j

θ0 = 1.

j=0

también puede escribirse como:

xt = θ q ( L ) ε t ,

q

donde θq (L) = 1 + ∑ θj Lj .

j=1

Promedios Móviles (MA)

MA(1)

Algunos aspectos de un MA(1) :

xt = ε t + θ1 ε t−1 ,

de donde se obtiene:

E [xt ] = 0,

h

i

var(xt ) = E (xt − E [xt ])2

h

i

= E (xt )2

h

i

= E ( ε t + θ 1 ε t−1 )2

= E ε2t + θ1 ε t ε t−1 + θ12 ε2t−1

= 1 + θ12 σ2 .

Promedios Móviles (MA)

MA(1)

La autocovarianza de primer orden está dada por:

cov(xt , xt−1 ) = E [(xt − E [xt ]) (xt−1 − E [xt−1 ])]

= E [xt xt−1 ] = E [(ε t + θ1 ε t−1 ) (ε t−1 + θ1 ε t−2 )]

= E ε t ε t−1 + θ1 ε t ε t−2 + θ1 ε2t−1 + θ12 ε t−1 ε t−2

= E θ1 ε2t−1

= θ1 σ 2 .

Por lo que la autocorrelación de primer orden es:

θ1 σ 2

cov(xt , xt−1 )

θ1

.

corr(xt , xt−1 ) =

=

=

var(xt )

1 + θ12 σ2

1 + θ12

nótese que es posible estimar ρ1 = corr(xt , xt−1 ), pero entonces

obtendrı́amos dos estimadores de θ1 , uno siempre dentro de la region

[−1, 1] , el otro siempre fuera de esa region.

Promedios Móviles (MA)

MA(1)

La autocovarianza de segundo orden es:

cov(xt , xt−2 ) = E [xt xt−2 ]

= E [(ε t + θ1 ε t−1 ) (ε t−2 + θ1 ε t−3 )]

= E ε t ε t−2 + θ1 ε t ε t−3 + θ1 ε t−1 ε t−2 + θ12 ε t−1 ε t−3

= 0.

de donde se observa que todas las autocovarianzas (y por lo tanto

autocorrelaciones) mayores a q (el orden del MA) son cero.

Los procesos MA siempre son estacionarios.

Promedios Móviles (MA)

Ejemplo: xt = ε t + 0.9ε t−1 , con ε t ∼ N (0, 1), t = 1, ..., 100.

3

2

x; MA(1), theta = 0.9

1

0

-1

-2

-3

-4

0

20

40

60

80

100

Promedios Móviles (MA)

Correlograma y correlagrama parcial

ACF for x; MA(1), theta = 0.9

1

+- 1.96/T^0.5

0.5

0

-0.5

-1

0

2

4

6

8

10

12

14

lag

PACF for x; MA(1), theta = 0.9

1

+- 1.96/T^0.5

0.5

0

-0.5

-1

0

2

4

6

8

lag

10

12

14

Modelos Autorregresivos y de Promedios Móviles

(ARMA)

Proceso autorregresivo y de promedios móviles de orden p,q,

ARMA(p, q):

φp (L)xt = θq (L)ε t .

Un ejemplo es el proceso ARMA(1, 1):

xt = φxt−1 + ε t + θ1 ε t−1 .

Modelos Autorregresivos y de Promedios Móviles

(ARMA)

Los procesos mixtos pueden generarse agregando otros modelos.

Por ejemplo:

xt

φ1 (L)xt

φ2 (L)yt

εt

zt

φ1 (L)φ2 (L)zt

∼ AR(m),

yt ∼ AR(n),

xt ⊥ yt

= εt

= ηt

⊥ ηt , con media cero

= xt + yt

ηt

εt

=

+

φ1 (L) φ2 (L)

1

=

[φ2 (L)ε t + φ1 (L)ηt ]

φ1 (L)φ2 (L)

= [φ2 (L)ε t + φ1 (L)ηt ]

⇒ zt ∼ ARMA(m + n, r), r = máx(m, n).

Metodologı́a de Selección de Modelos Box-Jenkins

Los procesos ARMA tienen firmas (ACF y PACF) que permiten

identificarlos, sin embargo dichas firmas son demasiado parecidas

o complejas, lo cual dificulta la selección de la especificación.

Box y Jenkins propusieron una técnica estadı́stica para la selección

de un modelo ARMA que se ajuste a los datos, la cual consiste de

las siguientes etapas

1

2

3

4

Identificación

Estimación

Diagnóstico

Pronóstico

Metodologı́a Box-Jenkins (Identificación)

Selección del orden de un ARMA(p,q)

Para seleccionar el orden del proceso, es decir, p y q, se utilizan los

llamados criterios de información. Los dos más populares son el

Akaike (1974) y el Bayesiano de Schwarz (1978):

2(p + q)

2

,

AIC = ln σ̂p,q

+

T

(p + q) ln(T )

2

+

BIC = ln σ̂p,q

,

T

donde T es el tamaño de la muestra. Se escogen los valores de p y

q que minimizan el criterio de información seleccionado.

En caso de que no sea posible discriminar entre modelos, es

posible quedarnos con los modelos relevantes y tratar de

combinarlos de alguna forma (modelado denso: “Thick

modeling”).

Metodologı́a Box-Jenkins (Estimación)

Estimación de un ARMA(p,q)

Bajo el supuesto de que se conoce el orden p y q del proceso

ARMA, es posible hacer uso distintos de métodos de estimación

de parámetros los cuales son puestos en práctica con la ayuda de

programas computacionales.

Si el orden del proceso ARMA no es conocido, éste puede ser

estimado con la ayuda de los criterios de información. Para dicho

propósito se estiman procesos ARMA de manera recursiva con un

orden creciente tanto en p como en q ( p = 1, . . . , pmax y

q = 1, . . . , qmax ). Finalmente se elige la combinación (p∗ , q∗ ) que

minimiza el criterio seleccionado.

Metodologı́a Box-Jenkins (Estimación)

Estimación de un AR(p)

Se mostrará la estimación para el caso de un proceso AR(p), para

el cual sus parámetros pueden ser estimados mediante tres

métodos:

1

2

3

Máxima Verosimilitud

Método de Momentos (Ecuaciones Yule-Walker)

Mı́nimos Cuadrados

Metodologı́a Box-Jenkins (Estimación)

Estimación de un AR(p)

Máxima Verosimilitud

Si conocemos la distribución del ruido blanco que genera el

proceso AR(p), los parámetros pueden ser estimados usando el

método de máxima verosimilitud

Tomando x1 como dada, la verosimilitud condicional para las

n − 1 observaciones restantes es

L∗ = p (x2 , x3 , . . . , xn |x1 )

= p (x2 |x1 ) p (x3 |x1 , x2 ) (xn |x1 , x2 , . . . , xn−1 )

Para obtener la verosimilitud no condicional habrá que calcular

L = p ( x1 ) L ∗

Metodologı́a Box-Jenkins (Estimación)

Estimación de un AR(1)- Máxima Verosimilitud

Bajo el supuesto de un proceso AR(1) con ruido blanco gaussiano, i.e.

xt = φxt−1 + ε t

E[ε t ] = µ var[ε t ] = σ2

las distribuciones son:

t=1

µ

σ2

,

1 − φ 1 − φ2

x2 |x1 ∼ N µ + φx1 , σ2

x1 ∼ N

t=2

t>1

xt |xt−1 , . . . , x1 ∼ N µ + φxt−1 , σ2

Metodologı́a Box-Jenkins (Estimación)

Estimación de un AR(1)- Máxima Verosimilitud

La función de Verosimilitud es

(

2 )

− 21

1

σ2

1 − φ2

µ

L = √

exp −

y1 −

2σ2

1−φ

2π 1 − φ2

)

(

T

1

(xt − φxt−1 )2

√

exp

∏ 2πσ2

2σ2

t=2

La log-verosimilitud es

T

1

l = − ln(2π ) − ln

2

2

σ2

1 − φ2

1 − φ2

−

2σ2

µ

y1 −

1−φ

2

T

n−1

(xt − φxt−1 )2

2

−

ln σ − ∑

2

2σ2

t=2

la estimación de los parámetros se obtiene de maximizar ya sea

analı́ticamente o mediante una optimización numérica.

Metodologı́a Box-Jenkins (Estimación)

Estimación de un AR(p)

Método de Momentos - Ecuaciones Yule-Walker

Las ecuaciones Yule-Walker son extraı́das de la función de

autocorrelación de un proceso AR(p), la cual tiene la siguiente

forma:

1,

para j=0;

ρj =

φ1 ρj−1 + φ2 ρj−2 + . . . + φp ρj−p , para j=1,2,. . . .

por lo tanto existen p parámetros distintos y hay p ecuaciones

Yule-Walker. Se puede resolver este sistema reemplazando ρj

(correlación teórica) por ρbj (correlación muestral) y obtener

estimadores de los parámetros φi para i = 1, 2, . . . , p.

Metodologı́a Box-Jenkins (Estimación)

Estimación de un AR(p)

Mı́nimos Cuadrados

Se ajusta por MCO la siguiente especificación:

xt = φ1 xt−1 + φ2 xt−2 + · · · + φp xt−p + ut

si la ecuación satisface las condiciones de√

estacionariedad

MCO

b

arroja estimadores consistentes. Además T φi − φi

i = 1, 2, . . . , p se distribuye asintóticamente normal.

El estimador de MCO es equivalente al estimador de MV cuando

el vector de errores sigue una distribución normal multivariada.

Metodologı́a Box-Jenkins (Estimación)

Estimación de un MA(q)

Se presenta la estimación de un proceso MA(q) por el método de

Máxima Verosimilitud, dicho método no es el único disponible

para estimarlo, pero cualquier método que pretenda hacerlo debe

ser capaz de estimar una función no lineal en los parámetros (por

ejemplo, mı́nimos cuadrados no lineales).

Metodologı́a Box-Jenkins (Estimación)

Estimación de un MA(1)

Máxima Verosimilitud

Se calcula la función de verosimilitud, para el caso

et ∼i.i.d. N(0, σ2 )

xt = µ + ε t + θε t−1

las probabilidades condicionales son:

I t = 1 Bajo el supuesto ε = 0

0

x1 |(ε 0 = 0) ∼ N(µ, σ2 )

ε 1 = x1 − µ

I

t=2

x2 |(x1 , ε 0 = 0) ∼ N(µ − θε 1 , σ2 )

ε 2 = x2 − µ − θε 1

Metodologı́a Box-Jenkins (Estimación)

Estimación de un MA(1)

Las probabilidades condicionales son en general de la forma

p(yt |ε t−1 )

I t > 1

xt |(xt−1 , . . . , x1 , ε 0 = 0) ∼ N(µ − θε t−1 , σ2 )

ε t = xt − µ − θε t−1

La función de verosimilitud es

T

L =

∏ p(yt |ε t−1 )

t=1

T

=

∏

t=1

ε2

√

exp − t 2

2σ

2πσ2

1

Metodologı́a Box-Jenkins (Estimación)

Estimación de un MA(1)

La log-verosimilitud es

T

T

1

l = − ln(2π ) − ln(σ2 ) − 2

2

2

2σ

T

∑ ε2t

t=1

el último término de la expresión es una función no lineal de los

parámetros por lo cual es necesario el uso de métodos iterativos

para obtener los estimadores.

La estimación de un proceso ARMA(p, q) comparte el reto de

estimación presente en un proceso MA.

Metodologı́a Box-Jenkins (Diagnóstico)

Pruebas de Diagnóstico

La inferencia estadı́stica que se hace a partir de MCO o MV puede

ser aplicada en el contexto de la estimación de un proceso ARMA

siempre y cuando se cumplan las condiciones de estacionariedad.

Los residuales del modelo proveen información importante, si

éstos no aproximan un ruido blanco el modelo seleccionado no es

satisfactorio y es necesario una nueva especificación.

Metodologı́a Box-Jenkins (Pronóstico)

Pronósticos por pasos

Denotemos por pt+h,t al pronóstico realizado en t para el horizonte

h.

Se define el error de pronóstico como et+h,t = xt+h − pt+h,t . Notese

que pt+h,t es conocido en el tiempo t, mientras que et+h,t y xt+h lo

son hasta el periodo t + h.

El error cuadrático medio (ECM) de un pronóstico es

H

ECM =

∑

h=1

e2t+h,t =

H

∑ (xt+h − pt+h,t )2

h=1

el cual promedia el error de pronóstico de manera simétrica.

Se puede demostrar que el mı́nimo en el ECM se alcanza cuando

el pronóstico de la variable pt+h,t es la esperanza condicional de la

variable xt+h , dada toda la información disponible en el tiempo t.

Metodologı́a Box-Jenkins (Pronóstico)

Pronósticos por pasos para un AR(1)

Consideramos un proceso AR(1) de la forma

xt = φxt−1 + ε t

E[ε t ] = µ var[ε t ] = σ2

Para calcular el pronóstico un paso hacia adelante del proceso

partimos de saber que su verdadero valor es

xt+1 = φxt + ε t+1

El pronóstico, es la esperanza condicional de xt+1 dada la

información disponible en el tiempo t, cuando se minimiza el

ECM esto es

pt+1,t = E[xt+1 |xt ] = φxt + µ

el error asociado es

et+1,t = xt+1 − E[xt+1 |xt ]

= xt+1 − φxt − µ

= ε t+1 − µ

Metodologı́a Box-Jenkins (Pronóstico)

Pronósticos por pasos para un AR(1)

El pronóstico dos pasos hacia adelante es

pt+2,t = E[xt+2 |xt ] = φE[xt+1 |xt ] + µ = φ2 xt + (1 + φ)µ

et+2,t = xt+2 − E[xt+2 |xt ]

= φxt+1 + ε t+2 − φE[xt+1 |xt ] − µ

= φet+1,t + ε t+2 − µ

= ε t+2 + φε t+1 − (1 + φ)µ

El pronóstico h pasos hacia adelante es

pt+h,t = E[xt+h |xt ] = φh xt + µ 1 + φ + φ2 + · · · + φh−1

et+h,t = ε t+h + φε t+h−1 + φ2 ε t+h−2 + · · · + φh−1 ε t+1

− 1 + φ + φ 2 + · · · + φ h−1 µ

Metodologı́a Box-Jenkins (Pronóstico)

Pronósticos por pasos para un AR(1)

Las propiedades del error de pronóstico de horizonte h son

E[et+h,t ] = 0

Var[et+h,t ] =

1 + φ 2 + φ 4 + · · · + φ 2(h−1) σ 2

Conforme el horizonte de pronóstico crece

µ

pt+h,t −→

cuando

1−φ

Var[et+h,t ] −→

σ2

1 − φ2

cuando

h −→ ∞

h −→ ∞

i.e. el valor pronósticado tiende a la media no condicional del

proceso, y la varianza del error de pronóstico se incrementa hacia

la varianza no condiconal del proceso.

Metodologı́a Box-Jenkins (Pronóstico)

Pronósticos por pasos para un AR(1)

Al tener una distribución para el error de pronóstico es posible

construir intervalos de confianza (IC) para los pronósticos h pasos

hacia adelante.

Para el caso de un pronóstico un paso hacia adelante

et+1,t ∼ N 0, (1 + φ)σ2

por lo cual un IC al 95 % está dado por

1

IC : µ + φxt ± 1,96 (1 + φ)σ2 2

Metodologı́a Box-Jenkins (Pronóstico)

Pronósticos por pasos para un MA(1)

Consideremos un proceso MA(1) de la forma

xt = µ + ε t + θε t−1

E[ε t ] = 0 var[ε t ] = σ2

Para calcular el pronóstico un paso hacia adelante del proceso

partimos de saber que su verdadero valor es

xt+1 = µ + ε t+1 + θε t

El pronóstico, cuando se minimiza el ECM, es

pt+1,t = E[xt+1 |xt ] = µ + θε t

El valor de ε t depende de los valores previos de ε, para la

implementación es común fijar ε 0 = 0, está aproximación pierde

importancia conforme el tamaño de muestra crece.

Calculamos el error asociado

et+1,t = xt+1 − E[xt+1 |xt ]

= xt+1 − µ − θε t = ε t+1

Metodologı́a Box-Jenkins (Pronóstico)

Pronósticos por pasos para un MA(1)

El pronóstico dos pasos hacia adelante es

pt+2,t = E[xt+2 |xt ] = µ

et+2,t = xt+2 − E[xt+2 |xt ] = xt+2 − µ = ε t+2 + θε t+1

En un proceso MA(1) el pronóstico por pasos tiene el siguiente

esquema

h≥2

pt+h,t = µ

2

var(et+h,t ) = (1 + θ )σ

2

h≥2

para dos periodos adelante, el pronóstico de un MA(1) es

simplemente la media no condicional de la serie, y la varianza del

error de pronóstico es la varianza de la serie.

Teorema de Wold

xt univariada, estacionaria y con media cero. It consiste del pasado

y del presente de la serie: xt−j , j ≥ 0.

(Representación de Wold) Cualquier proceso estacionario {xt }

puede representarse como:

∞

xt = c(L)ε t + vt =

∑ cj ε t−j + vt ,

j=0

donde c0 = 1 y ∑j∞=0 c2j < ∞. El término ε t es ruido blanco y

representa el error hecho al pronosticar xt basándose en una

función lineal de rezagos de xt :

ε t = x t − P ( x t | It − 1 ) .

vt un proceso linealmente determinı́stico y no está correlacionado

con ε t−j ∀j, mientras que ∑j∞=0 cj ε t−j es llamado el componente

lineálmente no determinı́stico (i.e. estocástico).

Procesos Determinı́sticos

Son aquéllos que pueden ser pronosticados perfectamente, dado

que conocemos la función que los genera.

Por ejemplo, si la función generadora es:

yt = a + bt,

entonces, el valor de yt+1 puede ser pronosticado perfectamente,

al igual que el de yt+k :

yt + 1 = a + b ( t + 1 ) ,

yt+k = a + b(t + k).

Descomposición Tradicional de una Serie de Tiempo

Una serie de tiempo puede pensarse como compuesta de distintos

elementos, algunos de ellos determinı́sticos y otros estocásticos:

yt = tendencia + estacionalidad + resto,

yt = t + s + ε,

los dos primeros han sido considerados tradicionalmente como

determinı́sticos, asi que la parte estocástica es a lo que llamamos

resto.

La tendecia puede ser lineal, o puede ser ajustada por un

polinomio de más alto grado. También puede presentar cambios

estructurales o ser estocástica. En caso de presentar tendencia, las

series son no estacionarias.

Estacionalidad

Existen varios métodos para tratar datos estacionales:

En el caso en que sea verdaderamente repetitiva, podemos utilizar

12

un filtro de promedios moviles: yt∗ = ∑ aj yt−j

j=−12

aj = a − j .

Incluir una variable dicotómica (dummy) para cada “estación” (y

no incluir una constante). Esto asume que la estacionalidad no

cambia en la muestra.

Usar datos “ajustados estacionalmente”. El factor estacional se

estima tı́picamente usando un filtro de dos lados para los datos de

cada “estación” en años contiguos. De esta forma se pueden

extraer una amplia gama de factores estacionales. Algunos filtros

son el X-12 ARIMA o el TRAMO-SEATS. Sin embargo, el ajuste

estacional también altera las auto-correlaciones de las series.

Aplicar una diferencia estacional. Si s es el número de estaciones

(4 para trimestres, 12 para meses), entonces: ∆s yt = yt − yt−s . La

serie ∆s yt está libre de estacionalidad, sin embargo, esto también

elimina la tendencia de largo plazo.

Bibliografı́a

Box, George E.P., Gwilym M. Jenkins y Gregory C. Reinsel. 2008.

Time Series Analysis Forecasting and Control. 4a ed. New

Jersey:Wiley.

Brooks, Chris. 2008. Introductory Econometrics for Finance. 2a ed.

Cambridge:Cambridge University Press.

Enders, Walter. 2010. Applied Econometric Time Series. 3a ed. New

Jersey:Wiley.

Guerrero, Vı́ctor. 2003. Análisis Estadı́stico de Series de Tiempo

Económicas. 2a ed. México:Thomson.

Granger, Clive W.J. y Paul Newbold. 1986. Forecasting Economic

Time Series. 2a ed. San Diego:Academic Press.

Hamilton, James D. 1994. Times Series Analysis. Princeton

University Press.