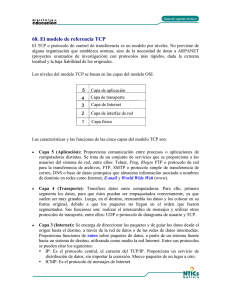

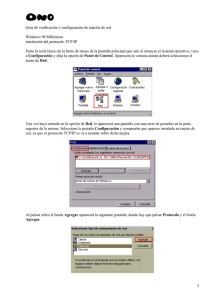

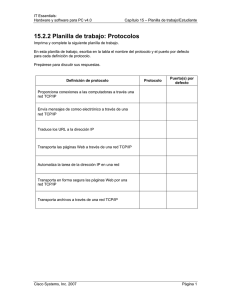

optimización de enlaces en redes ip

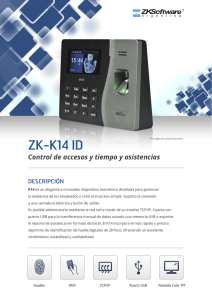

Anuncio