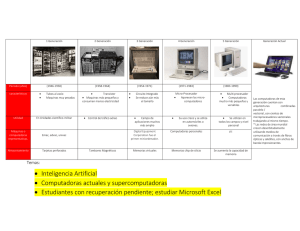

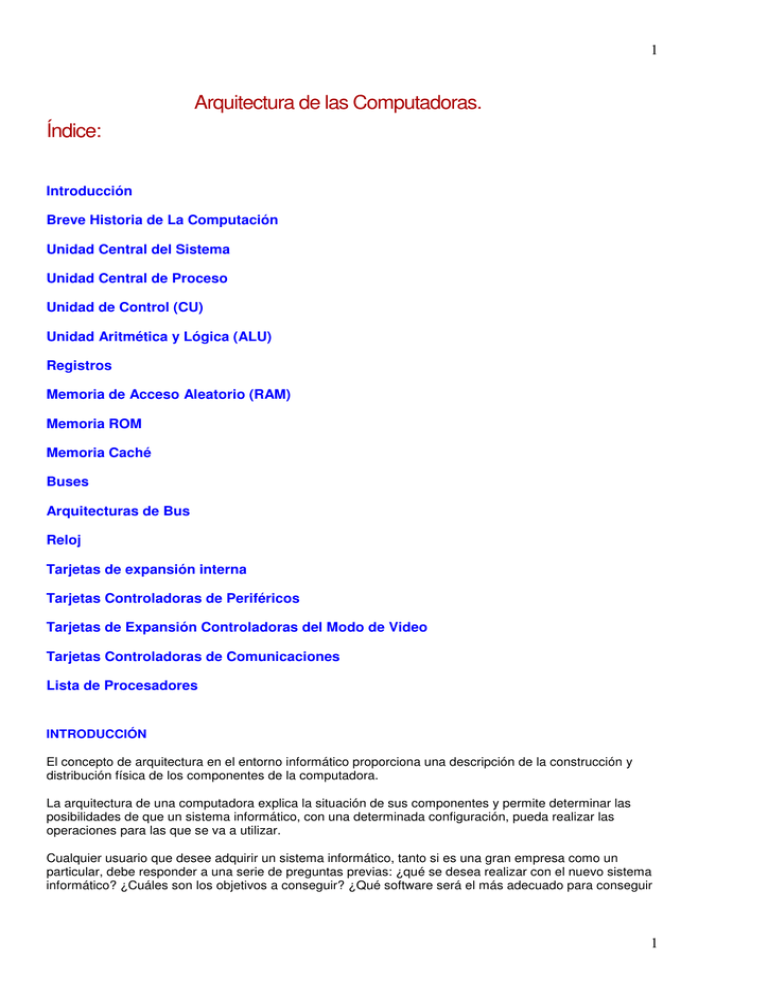

Arquitectura de las Computadoras. Índice:

Anuncio