Fundamentos de Estadística

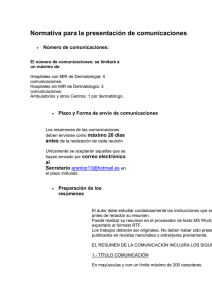

Anuncio

Fundamentos de Estadística:

Resúmenes.

A. Roberto Espejo Mohedano.

Arturo Gallego Segador.

TEMA 1: Introducción a la Estadística.

•

La Estadística y las estadísticas.

•

Definición de Estadística:

o Estadística Descriptiva.

o Estadística Matemática o Inferencial:

Población y muestra.

•

Escalas de medida:

o Categóricas: Ordinales y nominales.

o Numéricas: Por intervalos y por ratios.

•

Herramientas para la Estadística:

o Técnicas de conteo.

o Cálculo de probabilidades.

•

Estadística Multivariante: Modelos probabilísticos.

Fundamentos de Estadística: Resúmenes.

2

Tema 2: Estadística descriptiva univariante.

TEMA 2: Estadística descriptiva univariante.

MEDIDAS

DATOS SIN AGRUPAR

n = impar → me = x n +1

(

2

)

n = par → me = x n

n

+ +1

2 2

Li= Limite inferior del intervalo mediano.

Ni-1= Frecuencia absoluta acumulada del

intervalo anterior al mediano.

Intervalo mediano: Es el primero en el que n= Número total de datos.

la frecuencia absoluta acumulada es mayor ni= Frecuencia absoluta del intervalo

mediano.

que n/2.

ai= amplitud del intervalo mediano.

n

k

MEDIANA (me)

CUARTILES

S2 =

DESVIACION TIPICA (S)

CUASI_VARIANZA ( S 2 )

CUASI_

DESVIACION TIPICA ( S )

MOMENTOS RESPECTO

AL ORIGEN DE ORDEN r

MOMENTOS RESPECTO

A LA MEDIA DE ORDEN r

COEFICIENTE DE

ASIMETRIA (ϕ1 )

COEFICIENTE DE

CURTOSIS (ϕ 2 )

DATOS ANORMALES

RELACION ENTRE

S2 Y S 2

X=

C1= Valor que deja el 25% de los datos a su

izquierda.

C2= Igual que C1 con el 50% de los datos.

C3= Igual que C1 con el 75% de los datos.

VARIANZA (S2)

COEFICIENTE DE

VARIACION (V)

RANGO ( R )

1

∑ xi

n i =1

X =

MEDIA ( X )

ERROR ESTANDAR

DATOS AGRUPADOS

n

− N i −1

me = Li + 2

ai

ni

1

∑ ni xi

n i =1

n

K − N i −1

Ck = Li + 4

ai ; k = 1, 2, 3

ni

2

2

( xi − x ) = ∑xi2 − x 2 S 2 = ∑ ni ( xi − x )

∑

n i=1

n i =1

n i=1

1

1

n

1

n

k

S = S2

1 n

2

S2 =

( xi − x )

∑

n − 1 i =1

S = S2

1 k

2

S2 =

ni ( xi − x )

∑

n − 1 i =1

S = S2

S = S2

1 n r

∑ xi

n i =1

1 n

r

mr = ∑ ( xi − x )

n i =1

ar =

e.s =

1 k

ni xir

∑

n i =1

1 k

r

mr = ∑ ni ( xi − x )

n i =1

ar =

S

S

=

n −1

n

S

X

R=X(n) - X(1)

V =

m3

ϕ1 = 0 ⇒ Distribución simétrica.

S3

ϕ1 < 0 ⇒ D. Asimétrica a la izquierda. ϕ1 > 0 ⇒ D. A. a la derecha.

m

ϕ 2 = 44 − 3 ϕ 2 = 0 ⇒ Mesocurtica.

S

ϕ 2 > 0 ⇒ Leptocurtica. ; ϕ 2 < 0 ⇒ Platicurtica.

ϕ1 =

Xi − X

Sí Z i ∈ [− 2,2]

S

n S 2 = (n − 1) S 2

Zi =

Fundamentos de Estadística: Resúmenes.

datos normales.

3

Tema 2: Estadística descriptiva univariante.

Tabla de frecuencias.

Frec. Absoluta

Frec. Relativa (f.d.d.

empírica)

ni

fi =

ni

Frec. Absoluta

acumulada

Frec. Relativa

aculada (f.d.D.

empírica)

Fi = f i + Fi −1

(F0=0)

N i = ni + N i −1

(N0=0)

n

Medidas gráficas.

0.4

0.3

1

1

0.2

2

3

2

1

3

2

3

0.1

-3

-1.9

-1 -0.3 0.3

1

1.9

3

Histograma

Diagrama de sectores (pastel)

40

30

20

10

0.1

0.3

0.5

0.7

Diagrama de barras

0.9

Diagrama de frec. acumuladas

Fundamentos de Estadística: Resúmenes.

4

Tema 3: Estadística descriptiva bivariante.

TEMA 3: Estadística descriptiva bivariante.

( X , Y ) ( x1 , y1 ),( x 2 , y 2 ),......,( x n , y n )

x i ∈ S X = {x1* , x 2* ,..., x r* } Posibles valores de X (o sus marcas de clase)

y i ∈ S Y = {y1* , y 2* ,..., y k* } Posibles valores de Y (o sus marcas de clase)

Tabla de contingencia

Distribuciones marginales

X|

Y

y

x1*

n11

n12

x 2*

n 21

n 22

*

1

y

*

2

M

x i*

M

M

M

M

M

x r*

M

n r1

M

nr

n

n

n

...

y

*

j

...

...

...

...

O

...

...

y

*

k

n i.

...

...

n1k

n1.

n2k

n 2.

M

M

n ij

...

O

...

Frecuencias absolutas

k

n i. = ∑ n ij ;

i = 1,..., r

(variable X)

j = 1,..., k

(variable Y)

j =1

r

n. j = ∑ nij ;

i =1

M

M

Frecuencias relativas

M

n rk

M

nr .

n

n

f i. =

f. j =

ni .

;

n

n. j

n

;

i = 1,..., r

(variable X)

j = 1,..., k

(variable Y)

Distribuciones condicionadas

YX

fY X =

nij

ni.

j = 1,..., k,

i = 1,..., r

i = 1,..., r,

j = 1,..., k

XY

fX Y =

nij

n. j

Medidas de asociación:

Escala nominal

feij =

ni.n. j

n

, ∀ij

frecuencias absolutas esperadas en caso de ausencia de asociación

r

k

(nij − feij ) 2

i =1

j =1

feij

χ 2 = ∑∑

Coeficiente C de contingencia

C=

χ 2 de Pearson

V de Cramer

V =

χ2

nt

χ 2 ∈ [0, nt]

χ2

χ +n

2

t = min {(r − 1), (k − 1)}

C ∈ [0 , 1)

V ∈[0,1]

Fundamentos de Estadística: Resúmenes.

5

Tema 3: Estadística descriptiva bivariante.

Escala ordinal

r

Coeficientes predictivos λ:

nij − max n. j

∑ jmax

=1...k

j =1..k

i =1

λY / X =

n − max n. j

∈ [0 ,1]

j =1..k

k

λX / Y =

nij − max ni.

∑ imax

=1...r

i =1..r

j =1

n − max ni.

∈ [0 ,1]

i =1..r

Escala numérica

Covarianza

S xy =

1

n

1

( xi − x )( yi − y ) =

n

i =1

n

∑

Coeficiente de correlación rxy =

1

xi yi − x y =

n

i =1

n

∑

S xy

SxS y

r

nij xi yi − x y

j =1

k

∑∑

i =1

∈ [ - 1,1 ]

Fundamentos de Estadística: Resúmenes.

6

Tema 4 y 5: Combinatoria y calculo de probabilidades.

TEMA 4 y 5: Combinatoria y calculo de probabilidades.

Introducción.

• Inferencia.

• ¿Probable o improbable?.

• Fenómenos deterministas.

• Fenómenos aleatorios o estocásticos.

Conceptos básicos.

• Espacio muestral Ω.

Finito.

Infinito numerable.

Infinito no numerable.

• Sucesos A ⊂ Ω.

Suceso simple o elemental.

•

•

•

Suceso compuesto.

Sucesos impropios.

Suceso seguro Ω.

Suceso imposible ∅.

Relación entre sucesos.

Inclusión A ⊂ B.

Igualdad A = B.

Operaciones con sucesos.

Unión A ∪ B.

Intersección A ∩ B.

Sucesos incompatibles.

Complementación. Suceso complementario Ac .

Teoría de conjuntos y sucesos.

Propiedades de la ∪ y la ∩ de sucesos.

Asociativa. Conmutativa. Distributiva. E. neutros.

Leyes de Morgan.

Diferencia entre sucesos A-B = A ∩ B c .

Álgebra de Boole.

• Álgebra de sucesos A: consecuencias.

•

•

Sucesos aleatorios o estocásticos.

Extensión del álgebra: σ-álgebra.

Espacio probabilizable ( Ω,A ).

Fundamentos de Estadística: Resúmenes.

7

Tema 4 y 5: Combinatoria y calculo de probabilidades.

Definición frecuentista de probabilidad.

•

Frecuencia relativa del suceso A.

n

f r (A) = a

n

•

n

P(A) = lim f r (A) = lim a

n→∞

n→∞ n

•

Propiedades

f r (Ω ) = 1

0 ≤ f (A) ≤ 1

r

f (A ∪ B) = f (A) + f (B) si A∩ B =∅.

r

r

r

Definición de Laplace de probabilidad.

Dados A ,A ,...,A tales que A ∩ A = ∅ y

1 2

m

i

j

m

U A = Ω e igualmente

i

i =1

verosímiles:

P(A) =

m

a = casos favorables

m

casos posibles

Definición axiomática de probabilidad.

Sea P: A → [0,1] tal que:

•

P(Ω) = 1

•

P(A) ≥ 0

•

P(A∪ B) = P(A)+P(B) si A∩ B=∅

P → Función de probabilidad.

(Ω,A, P) → Espacio de probabilidad.

Consecuencia de los axiomas:

Si A ⊂ B ⇒ P(A) ≤ P(B)

P(A) ≤ 1

P(Ac ) = 1 − P(A)

Fundamentos de Estadística: Resúmenes.

8

Tema 4 y 5: Combinatoria y calculo de probabilidades.

Ley aditiva de probabilidades.

•

n

n

P( U A ) = ∑ P(A ) si A ∩ B = ∅ ; i ≠ j

i

i

i

j

i =1

i =1

• P(A∪B) = P(A)+P(B)-P(A∩ B)

• P(A∪ B∪ C) = [P(A)+P(B)+P(C)]-[P(A∩ B)+P(A∩ C)+P(B∩ C)]+

+[P(A∩ B∩ C)]

•

Generalización:

• P(A∪ B∪ C∪ D∪ ...) = [P(A)+P(B)+P(C)+P(D)+...]-

- [P(A∩ B)+P(A∩ C)+P(A∩ D)+...]+[P(A∩ B∩ C)+P(A∩ B∩ D)+...] - ...

• P( U A ) ≤ ∑ P(A ) (Bonferroni)

i

i

i

i

-oOo-

Análisis combinatorio.

REPETICIONES

CON

SIN

INFLUYE SI

EL

ORDEN

NO

m!

(m − n )!

Pm = Vm,m = m!

VRm ,n = m n

Vm ,n = Vmn =

C m,n = C mn =

( ) = n!(mm−! n)!

m

n

m!

a!⋅b!⋅... ⋅ k!

(m + n − 1)!

=

n!(m − 1)!

PRm ,a ,b ,...,k =

CRm ,n =

Fundamentos de Estadística: Resúmenes.

(

m + n −1

n

)

9

Tema 6: Probabilidad condicionada.

TEMA 6: Probabilidad condicionada.

Determinación concreta del espacio muestral.

Frecuencia relativa condicionada.

n

f (A ∩ B)

f ( A B ) = A∩ B = r

•

r

n

f (B)

B

r

si

f (B) ≠ 0

r

Probabilidad condicionada.

P(A ∩ B)

P( A B ) =

; P(B) > 0

•

P(B)

P(A ∩ B)

P( B A ) =

; P(A) > 0

•

P(A)

Independencia estocástica (aleatoria)

•

A i B ⇔ P(A)=P(A/B)

•

A i B ⇔ P(A∩B)=P(A) P(B)

•

A i B ⇔ B i A

En general, dados A ∈ A , i = 1,...,n los A son "mutuamente" independientes

i

i

•

si y sólo si:

P(A ∩ A ∩ ... ∩ A ) = P(A )P(A )...P(A )

1

2

n

1

2

n

Teorema de la partición (o de la probabilidad total).

•

Dados A ∈ A , i = 1,...,n tales que:

i

•

n

UA

i

=Ω

i =1

•

•

Ai ∩ A j = ∅ ∀i, j = 1, K , n / i ≠ j

•

P ( Ai ) > 0 , i = 1, K , n

Sea B ∈ A otro suceso, entonces:

n

P(B) = ∑ P(Ai ) P(B/Ai )

i =1

Fundamentos de Estadística: Resúmenes.

10

Tema 6: Probabilidad condicionada.

Demostración: Basta considerar

n

1.

B = U ( Ai ∩ B)

i =1

2.

P ( Ai ∩ B) = P( Ai ) P( B / Ai )

Teorema de Bayes.

•

•

•

Probabilidad a priori.

Probabilidad a posteriori.

Teorema: Dadas las condiciones del teorema de la partición:

P( A j / B) =

P( A j ) P( B / A j )

n

∑ P( A ) P( B / A )

i

i =1

i

Donde: P ( Ai ) → Probabilidad a priori.

P ( A j / B) → Probabilidad a posteriori.

P( B / A j ) →

Verosimilitudes.

Demostración:

P( A j / B) =

P( A j ∩ B)

P( B)

=

P( A j ) P( B / A j )

P( B)

T .P.

=

P( A j ) P( B / A j )

n

∑ P( A ) P( B / A )

i =1

i

Fundamentos de Estadística: Resúmenes.

i

11

Tema 7: Variable aleatoria univariante.

TEMA 7: Variable aleatoria univariante.

Ω

P(A)

A

0

X(A)

1

F(x)

X-1(B)

R

B

Función real de los resultados.

Variable aleatoria univariante (v.a.).

Dado (Ω, A, P), sea X : Ω → R

A ∈ A → X(A) ∈ R

X es v.a. sobre Ω ⇔ ∀ intervalo B ∈ R, se tiene que X -1(B) ∈ A.

Espacio muestral (S) de una v.a.

S = { todas las realizaciones X(w), w ∈ Ω }

Función de distribución (f.d.D.).

En un sentido estrictamente matemático, F: R → [0,1] es una f.d.D. sii:

1.

lim F ( x) = 0

x → −∞

2. lim F ( x) = 1

x →∞

3. F es monótona no decreciente. (si x1< x2 ⇒ F(x1) ≤ F(x2) )

4. F es continua por la derecha. ( lim F ( x + h) = F ( x) )

x →0 , h →0

Fundamentos de Estadística: Resúmenes.

12

Tema 7: Variable aleatoria univariante.

Función de distribución de una v.a. X.

F(x) = P({w ∈ Ω / X (w) ≤ x})

( F(x) = P(X ≤ x) )

" Distribución de una unidad de masa sobre la recta real."

" F(x) es la masa probabilística situada a la izquierda del punto x."

Variable aleatoria discreta.

•

El espacio muestral asociado es finito o numerable.

S = {x1, x2, ..., xn, ... } "Puntos donde se concentra la masa

probabilística."

•

Se entiende por P(X = x) a:

P(X = x) = P(X -1(x)) = P({w ∈ Ω / X(w) = x})

•

Distribución de probabilidad.

X

P(X=x)

•

•

x1

x2

P(X=x1)

P(X=x2)

F ( x) = P(X ≤ x) =

∑ P(X

xi ≤ x

...

...

xn

P(X=xn)

= xi )

Función de densidad (f.d.d.) de una v.a. (o de cuantía)

0 ∀ x∉S

f ( x) =

P(X = x) si x ∈ S

F ( x) =

∑ f (x )

xi ≤ x

i

Variable aleatoria continua.

•

“La v.a. puede tomar un valor cualquiera dentro de un intervalo real”.

S puede ser de la forma: (a, b), (-∞, b), (a, +∞), (-∞, +∞)

•

P (a < X < b) = P( X −1 ((a, b)) = P({w ∈ Ω / a < X ( w) < b})

P(X = xi ) = 0 (“distribuimos la masa probabilística en ∞ valores”)

•

F ( x) = P(X ≤ x)

Fundamentos de Estadística: Resúmenes.

13

Tema 7: Variable aleatoria univariante.

•

La f.d.d. de una v.a. X, f(x) es una función tal que:

∫

1.

+∞

−∞

f ( x) dx = 1

x2

2. P ( x1 < X < x 2 ) = ∫ f ( x) dx

x1

•

Relación entre la f.d.D. y la f.d.d.

x

1. F ( x) = P(X ≤ x) = P (−∞ < X ≤ x) = ∫ f (t ) dt

−∞

f ( x) =

2.

•

dF ( x)

dx

Anotaciones:

b

1. Si S = {( a, b)} ⇒ ∫ f ( x) dx = 1 , y además

a

0

si

x≤a

x

F ( x) = ∫ f ( x) dx si a < x < b

a

1

si

x≥b

2. P (X > xi ) = 1 − P(X ≤ xi ) = 1 − F ( xi ) = ∫

+∞

xi

f ( x) dx

x2

3. P ( x1 < X < x 2 ) = ∫ f ( x) dx = F ( x 2 ) − F ( x1 ) − P(X = x 2 ) = F ( x 2 ) − F ( x1 )

x1

Valor esperado.

Sea X una v.a y sea g: R → R . Se define el valor esperado de la v.a. g(X)

como:

1. E [g (X )] =

∑ g ( x ) f ( x ) = ∑ g ( x ) P(X = x )

xi ∈S

i

i

2. E [g (X )] = ∫ g ( x) f ( x) dx

+∞

−∞

xi ∈S

i

i

(Caso discreto)

(Caso continuo)

Supuestos:

∑ g(x ) f (x )

xi ∈S

+∞

∫

−∞

< +∞

es decir la ∑ y la

g ( x) f ( x) dx < +∞

i

i

∫

son absolutamente convergentes.

Fundamentos de Estadística: Resúmenes.

14

Tema 7: Variable aleatoria univariante.

Esperanza matemática.

•

Si la función g(x) anterior es la identidad (g(x)=x), a E[X] se le

denomina esperanza matemática o simplemente esperanza de la v.a. X,

siendo habitual notarla por µ X .

•

Propiedades:

1. E [k ] = k

2. E [a + bX ] = a + bE [X ]

Momentos.

•

Momento de orden k respecto del parámetro c.

•

M kc = E (X − c) k

Si c = 0. Momentos respecto al origen.

[

]

[ ]

αk = E X k

•

Si c = µ X . Momentos centrales.

[

µ k = E (X − µ X ) k

]

Media de una v.a.

•

µ X = µ = α 1 = E [X ] "Media o valor medio" de la distribución de la v.a. X

µ=

∑x

xi ∈S

•

+∞

i

f ( xi ) ; µ = ∫ x f ( x) dx

−∞

En general, no tiene porque existir la media.

Varianza de una v.a.

•

[

σ X2 = σ 2 = µ 2 = E (X − µ ) 2

σ2 =

∑ (x

xi ∈S

•

]

"Varianza" de la distribución de la v.a. X.

+∞

i

− µ ) 2 f ( xi ) ; σ 2 = ∫ ( x − µ ) 2 f ( x) dx

−∞

Desviación típica de la v.a.

Fundamentos de Estadística: Resúmenes.

15

Tema 7: Variable aleatoria univariante.

σ =+ σ2

•

"Viene expresada en la mismas unidades que la v.a."

Propiedades:

1. σ 2 = α 2 − α 12

"Teorema de Konning"

2. Si Y = a + bX siendo X ∈ D( µ X , σ X2 ) . Entonces: σ Y2 = b 2σ X2 .

Desigualdad de Tchebycheff.

•

P ( µ − kσ < X < µ + kσ ) ≥ 1 −

•

Formulaciones equivalentes:

P ( X − µ < kσ ) ≥ 1 −

P ( X − µ ≥ kσ ) <

1

k2

1

k2

1

k2

Fundamentos de Estadística: Resúmenes.

16

Tema 8: Principales distribuciones discretas.

TEMA 8: Principales distribuciones discretas.

•

Distribución Uniforme.

"La v.a. X toma valores x1, x2, ..., xn con igual probabilidad"

f (x) = f (x, k) =

1

∀ x = x1 , x 2 ,K , x k ∈ U (k)

k

k

µ=

∑ xi

i =1

k

k

;

En el caso de que SX={1,2,...,k} , µ =

f(x)

1/k

σ2 =

x1

·

·

x2 · · ·

xn

i =1

i

− µ)2

.

k

k +1 2 k 2 −1

;σ =

12

2

F(x)

·

∑ (x

1

2/k

1/k

x1 x2

x3 · · ·

xn

En el caso particular de ser SX={x0}, la distribución de X se dice degenerada o

singular.

•

Distribución de Bernouilli o Binaria.

"Experimento aleatorio con dos posibles resultados": SX = {0,1}

A = {"Éxito"} = {1} ; P(A) = p

B = Ac = {"Fracaso"} = {0} ; P(B) = q = 1-p

f ( x) = f ( x, p ) = p x (1 − p )1− x ∈ B ( p )

Proceso de Bernouilli:

1. La probabilidad de éxito permanece constante para cada uno de los intentos.

2. Los intentos repetidos son independientes.

1

E [X ] = ∑ xp x (1 − p)1− x = 0 + p = p

x =0

[ ]

1

V [X ] = E X 2 − (E [X ]) = ∑ x 2 p x (1 − p )1− x − p 2 = p − p 2 = p(1 − p)

2

x =0

Fundamentos de Estadística: Resúmenes.

17

Tema 8: Principales distribuciones discretas.

f(x)

F(x)

p

·

·

q

1=p+q

q

0

1

0

•

1

Distribución binomial.

Dadas n pruebas de Bernouilli repetidas e independientes:

X1 , X2 , L , Xn ∈ B ( p )

La v.a. X "no de éxitos total en las n pruebas" se dice binomial de parámetros n y p.

n

X = ∑ Xi ∈ b (n, p )

i =1

n

f ( x) = f ( x, n, p) = p x (1 − p ) n − x

x

E [X ] = E [X1 + X2 + L + Xn ] = E [X1 ] + E [X2 ] + K + E [Xn ] = n p

V [X ] = V [X1 + X2 + K + Xn ] = 12 V [X1 ] + 12 V [X2 ] + K + 12 V [Xn ] = n p q

"Asociada a la idea de muestreos con reemplazamiento".

•

Distribución hipergeométrica.

"La v.a. X no de éxitos en una prueba muestra aleatoria de tamaño n seleccionada de

entra N resultados posibles, de los cuales a son éxitos y b fracasos (a+b=N), se dice

hipergeométrica".

X ∈ h (n, a, b)

a b

x n − x

f ( x) = f ( x, n, a, b) =

a + b

n

x≤a

n − x ≤ b

n ≤ a + b

Fundamentos de Estadística: Resúmenes.

18

Tema 8: Principales distribuciones discretas.

N−n

a b

n

N −1

N N

E [X ] = n p ; V [X ] =

"Asociada a la idea de muestreos sin reemplazamiento".

•

Distribución de Poisson.

La v.a. X, no de ocurrencias del suceso A (éxito) durante un gran número de pruebas,

se dice de Poisson".

En términos coloquiales: "Una binomial con n grande y p pequeño".

X ∈ P (λ ) ; λ = n p

Matemáticamente, si: n → ∞ y p → 0 y n p = λ = cte :

x

n

n!

λ λ

P (X = x) = p x (1 − p) n − x =

1 −

x!(n − x)! n n

x

n

n− x

−x

=

1 n(n − 1)(n − 2) L (n − x + 1) x λ

λ 1 −

x!

nx

n

=

−n

−x

λ x 1 x − 1 λ λ λ

1 1 − L 1 −

1 − 1 −

x! n

n n n

λ

1 −

n

−λ

1

Por lo tanto: f ( x) = f ( x, λ ) =

•

1

e-λ

→

λ x −λ

e

x!

1

λ x −λ

e

x!

n ≥ 50

b (n, p ) → P (λ ) cuando

o bien n p < 18

p ≤ 0.1

E [X ] = λ ; V [X ] = λ

Asociada con "sucesos raros". Algunos casos típicos pueden ser: no de bacterias en

un cultivo, no de errores mecanográficos por página, no de llamadas telefónicas

recibidas, etc.

Fundamentos de Estadística: Resúmenes.

19

Tema 8: Principales distribuciones discretas.

•

Distribución geométrica.

Dado un fenómeno dicotómico con alternativas A (con P(A)=p) y Ac (P(Ac)=1-p=q)

"la v.a. que cuenta el número de veces que ocurre la alternativa Ac (fracaso) antes de que

aparezca por primera vez A (éxito), se dice geométrica". X ∈ G ( p) .

q

q

f ( x ) = f ( x, p ) = q x p

;

; V [X ] = 2

E [X ] =

p

p

•

Distribución binomial negativa (o de Pascal).

Dado un fenómeno dicotómico con alternativas A (con P(A)=p) y Ac (P(Ac)=1-p=q)

"la v.a. que cuenta el número de veces que ocurre la alternativa Ac (fracasos) antes

de que aparezca por r-esima vez A (éxito), se dice binomial negativa".

X ∈ bn (r , p ) .

x + r − 1 x r − r

x

q p = (− q ) p r

f ( x) = f ( x, r , p ) =

x

x

E [X ] = r

q

p

; V [X ] = r

q

p2

Fundamentos de Estadística: Resúmenes.

20

Tema 9: Principales distribuciones continuas.

TEMA 9: Principales distribuciones continuas.

•

Distribución uniforme o rectangular.

Sea X una v.a. con espacio muestral asociado S={(a,b)}. Si todos los puntos de S

son equiprobables, se dice que X tiene una distribución uniforme (X ∈ U (a, b) ),

cuya f.d.d es:

0

f ( x ) = f ( x, a , b ) = 1

b − a

f(x)

si

x∉S

si

x∈S

F(x)

1

1/b-

a

µ = E [X ] =

•

a

b

b

a+b

(b − a ) 2

; σ 2 = V [X ] =

2

12

Distribución normal.

Es la distribución continua más importante en todos los campos de la Estadística,

sobre todo en la Inferencial.

Describe de forma aproximada muchos fenómenos que ocurren en la naturaleza,

industria e investigación.

Tiene una distribución (f.d.d.) en forma de campana.

NHµ,σ2 L

µ−σ

µ

µ+σ

X ∈ N (µ ,σ )

Fundamentos de Estadística: Resúmenes.

21

Tema 9: Principales distribuciones continuas.

1 x−µ

σ

−

1

f ( x ) = f ( x, µ , σ ) =

e 2

σ 2π

2

Consideraciones:

-

La moda (punto sobre el eje horizontal donde la curva tiene su máximo)

ocurre en x = µ .

La curva es simétrica respecto al eje vertical que pasa por la media.

La curva tiene sus puntos de inflexión en x = µ ± σ .

La curva tiene como asíntota el eje horizontal.

El área bajo la curva y el eje horizontal es igual a 1.

La forma de la función de distribución F(x) es:

1

0

E [X ] = µ ; V [X ] = σ 2

•

Distribución normal estándar.

La distribución de una v.a. X normal de media cero y varianza 1, se denomina

distribución normal estándar. X ∈ N (0,1) .

f ( x) =

1 − 12 x 2

e

2π

NH0,1L

−1

0

1

Fundamentos de Estadística: Resúmenes.

22

Tema 9: Principales distribuciones continuas.

La v.a. X ∈ N (0,1) se encuentra tabulada. En dichas tablas se proporciona la

P (X ≥ zα ) .

NH0,1L

α

0

zα

Tipificación de v.a. normales:

X −µ

∈ N (0,1) . Por tanto se reduce el

σ

calculo de probabilidades asociado a distribuciones normales a la consulta de la

tabla de la N(0,1).

Dada una v.a. X ∈ N ( µ , σ ) , la v.a. Z =

Ejemplo:

NH0,1L

α=0.4013

NH7,16L

α=0.4013

0 z=0.25

•

0

x=8

Distribución gamma.

La distribución de una v.a. X ∈ γ (a, p) , si su f.d.d. es:

a p p −1 − ax

x>0

x e

si

f (x) = Γ(p)

a, p > 0

0 en el resto

+∞

siendo Γ( p ) =

∫x

p −1 − x

e

d x , (integral gamma), convergente ∀ p > 0 .

0

p

E [X ] =

a

; V [X ] =

p

a2

Fundamentos de Estadística: Resúmenes.

23

Tema 9: Principales distribuciones continuas.

•

Distribución exponencial.

Es un caso particular de la distribución gamma para a=a y p=1.

X ∈ γ (a,1) = Ex(a) .

Su f.d.d. es:

•

a e − ax ; x ≥ 0, a > 0

f ( x) =

0 ; resto

Distribución chi-cuadrado.

Es un caso particular de la distribución gamma para a=1/2 y p=n/2.

X ∈ γ ( 1 , n ) = χ (2n )

2 2

( )

Su f.d.d. es:

1 n2

2 x n 2 −1e − 12 x

f ( x) =

Γ( n )

2

0

si

x>0

en el resto

Al parámetro n se le llama “grados de libertad”.

Construcción a partir de la normal:

Sea la v.a. Z ∈ N (0,1) , la distribución de la v.a. X = Z 2 es una χ (21) y se le suele

llamar “distribución cuadrado de la normal”.

Sean las v.a. X1 ∈ χ (21) , X2 ∈ χ (21) , K , Xn ∈ χ (21) , independientes entre si.

La v.a. Y:

n

Y = ∑ Xi ∈ χ (2n )

i =1

χ2 H1L

χ2 H4L

χ2 H6L

Fundamentos de Estadística: Resúmenes.

24

Tema 9: Principales distribuciones continuas.

χ2 HnL

0

La distribución chi-cuadrado es asimétrica y se encuentra tabulada, proporcionando la

P (X ≥ χ α2 )

χ2 HnL

α

χ2 α

0

•

Distribución t de Student.

Una v.a. X cuya f.d.d. es:

n + 1

n +1

Γ

2 − 2

x

2

1 +

f ( x) =

∀ x ∈R

n

n

n π Γ

2

se dice que su distribución pertenece a la familia de distribuciones t de Student

con n grados de libertad. X ∈ t (n ) .

Construcción a partir de la normal:

2

Sean las v.a. Z ∈ N (0,1) e Y ∈ χ (n)

, la distribución de la v.a.:

X=

Z

Y

∈ t (n )

n

Fundamentos de Estadística: Resúmenes.

25

Tema 9: Principales distribuciones continuas.

Esta distribución simétrica respecto del origen y que se encuentra tabulada,

proporcionado la P (X ≥ tα )

tHnL

α

0

tα

Su forma funcional es algo mas achatada que la curva normal al tener una

varianza mayor. Cuando n → ∞ ⇒ t ( n ) → N (0,1) .

NH0,1L

tHnL

−1

•

0

1

Distribución F de Fisher-Snedecor.

Una v.a. cuya f.d.d. es:

2

m m+n

m+ n

Γ

m

−

n 2 2 −1 m 2

f ( x) =

x 1 + x

n

m n

Γ Γ

2 2

∀ x ∈R

se dice que su distribución pertenece a la familia de distribuciones F de FisherSnedecor con n y m grados de libertad. X ∈ F( n ,m ) .

Fundamentos de Estadística: Resúmenes.

26

Tema 9: Principales distribuciones continuas.

Construcción a partir de la normal:

Si la v.a. X1 ∈ χ (2m ) y la v.a. X2 ∈ χ (2n ) y son independientes entre si, la v.a.:

X1

X=

X2

m ∈F

( m,n )

n

Es asimétrica, y su forma es del tipo:

FHn1 ,n2 L

Su distribución se encuentra tabulada, proporcionado la P(X ≥ Fα )

α

FHn1 ,n2 L

Fα

X1

Si X =

X2

Fα ,( m,n ) =

m ∈F

( m ,n )

n

X2

n ∈F

⇒1 =

( n ,m )

X X1

m

1

F(1−α ),( n ,m )

Fundamentos de Estadística: Resúmenes.

27

Tema 9: Principales distribuciones continuas.

•

Teorema central del limite de Lindeberg-Levy.

Sean las v.a. X1, X2, ..., Xn independientes entre si y con la misma distribución

X i ∈ D( µ , σ 2 ) ∀ i . Se verifica que la v.a.:

n

X = ∑ Xi

→ N (nµ , nσ 2 )

i =1

o bien:

X − nµ

nσ 2

→ N (0,1)

Relación de convergencia entre b (n,p), P (λ) y N(0,1):

•

•

X ∈ b (n, p ) → P (λ )

( n ≥ 20, p ≤ 0.05 λ = np < 18 )

X − np

X ∈ b ( n, p ) ⇒

→ N (0,1)

( n ≥ 30, min(p,q) ≥ 0.1 )

npq

X ∈b (n, p ) → N (np, npq )

•

X ∈P (λ ) → N (λ , λ )

( Teorema de D’Moivre)

X −λ

→ N (0,1)

( λ ≥ 18 ) o bien

λ

Corrección de continuidad de Yates:

Si se quiere aproximar una distribución discreta por una continua, hay que

aplicar una corrección de continuidad consistente en considerar un intervalo en

torno al punto que se desea estudiar.

Discreta

Continua

x=a

a<x<b

a≤x≤b

a≤x<b

a<x≤b

a-0.5 ≤ y ≤ a+0.5

a+0.5 ≤ y ≤ b-0.5

a-0.5 ≤ y ≤ b+0.5

a-0.5 ≤ y ≤ b-0.5

a+0.5 ≤ y ≤ b+0.5

Fundamentos de Estadística: Resúmenes.

28

Tema 10: Variable aleatoria bivariante.

TEMA 10: Variable aleatoria bivariante.

V.a. n-variante.

•

Dado un espacio de probabilidad (Ω, A , P) , una función:

r

X : Ω → Rn

w ∈ Ω a (X1 ( w), X2 ( w),L, Xn ( w) )

r

es una v.a. n-variante si ∀ intervalo B ∈ R n se tiene que X -1 (B) ∈ A .

•

r

Espacio muestral S de la v.a. X .

•

V.a. Bivariante:

(X , Y ) : Ω → R 2

w ∈ Ω a (X , Y )( w) = (X(w), Y(w)) ∈ R 2

es v.a. bivariante si ∀ intervalo B ∈ R 2 se tiene que (X, Y ) (B) ∈ A .

-1

•

Clasificación de v.a. bivariantes: Discretas, continuas y mixtas.

Función de Distribución (f.d.D.).

•

Dada una v.a. (X,Y) y F : R 2 → [0,1] tal que:

F ( x, y ) = P(X ≤ x ; Y ≤ y )

se le denomina f.d.D. de la v.a. (X,Y).

•

Propiedades de la f.d.D.

F(x,y) es monótona no decreciente respecto a cada una de las variables.

F(x,y) es continua por la derecha respecto a cada una de las variables.

lim F ( x, y ) = 0 ∀ y ∈ R

x → −∞

lim F ( x, y ) = 0 ∀ x ∈ R

y → −∞

lim F ( x, y ) = 1

x , y →∞

Fundamentos de Estadística: Resúmenes.

29

Tema 10: Variable aleatoria bivariante.

V.a. bidimensional discreta.

•

La v.a. (X,Y) es discreta si X e Y son discretas.

S = {(X, Y )( w) ; ∀ w ∈ Ω} es un conjunto finito o numerable.

(

)

P(X = x; Y = y ) = P X −1 ( x); Y −1 ( w) = P(w ∈ Ω / X ( w) = x; Y ( w) = y )

•

Distribución de probabilidad de la v.a. (X,Y).

X\Y

x1

x2

...

xi

...

xn

y1

p11

p21

...

pi1

...

pn1

y2

p12

p22

...

pi2

...

pn2

...

...

...

...

...

...

...

siendo pij = P (X = xi ;Y = y j ) y

•

yj

p1j

p2j

...

pij

...

pnj

n

m

∑∑ p

i =1 j =1

ym

p1m

p2m

...

pim

...

pnm

=1

f.d.D. de una v.a. (X,Y)

F ( x, y ) = P(X ≤ x; Y ≤ y ) =

∑ ∑ P(X = x ; Y = y )

i

xi ≤ x y j ≤ y

•

ij

...

...

...

...

...

...

...

j

f.d.d de una v.a. (X,Y) o función de cuantia.

f ( x, y ) = P(X = x; Y = y ) ⇒ F ( x, y ) =

∑ ∑ f (x , y

xi ≤ x y j ≤ y

i

j

)

V.a. bivariante continua.

•

•

Una v.a. (X,Y) es continua si X e Y son continuas.

Una v.a. (X,Y) es continua si:

∃ f ( x, y ) ≥ 0 / F ( x, y ) con F ( x, y ) = P(X ≤ x; Y ≤ y ) puede expresarse

como:

x

y

∂ 2 F ( x, y )

F ( x, y ) = ∫ ∫ f (u , v) du dv ⇒ f ( x, y ) =

−∞ + ∞

∂x ∂y

•

Propiedades:

+∞ +∞

o

∫ ∫

o

P( x1 < X ≤ x 2 ; y1 < Y ≤ y 2 ) = ∫

−∞ −∞

f ( x, y ) dx dy = 1

x2

x1

∫

y2

y1

f ( x, y ) dx dy

Fundamentos de Estadística: Resúmenes.

30

Tema 10: Variable aleatoria bivariante.

o

P( x1 ≤ X ≤ x 2 ; y1 ≤ Y ≤ y 2 ) = F ( x 2 , y 2 ) − F ( x1 , y 2 ) − F ( x 2 , y1 ) + F ( x1 , y1 )

Momentos.

•

Esperanza matemática de una v.a. (X,Y)

∑x y

Caso discreto:

xi , yi ∈S

+∞ +∞

∫ ∫

Caso continuo:

•

i

−∞ −∞

[

i

f ( xi , y i )

x y f ( x, y ) dx dy

Momentos: M ku,,hv = E (X − u ) (Y − v )

k

h

]

Para u=v=0 , "momentos respecto al origen" α k ,h

Para u = α 1, 0 ; v = α 0,1 , "momentos centrales respecto de las medias" µ k ,h

•

α 1, 0 "media de X"

α 0,1 "media de Y "

µ 0, 2 "varianza de Y "

•

µ1,1 = α1,1 − α1,0 α 0,1

•

µx

Vector de medias: µ =

µy

•

Coeficiente de correlación: ρ xy =

µ 2, 0 "varianza de X"

µ1,1 "covarianza entre X e Y "

(Teorema de Konning)

σ 2

Matriz de covarianzas: ∑ = x

σ yx

σ xy

σ y2

σ xy

σ xσ y

Fundamentos de Estadística: Resúmenes.

31

Tema 10: Variable aleatoria bivariante.

Distribuciones marginales.

P(X ∈ A) = P((X, Y ) ∈ A × R )

•

P(Y ∈ B ) = P((X, Y ) ∈ R × B )

Caso discreto:

o Probabilidades marginales:

X\Y y1

x1 p11

...

...

xi

pi1

...

...

xn pn1

n

p y j = ∑ p ij

i =1

...

...

...

...

...

...

yj

p1j

...

pij

...

...

...

...

...

...

...

...

ym

p1m

...

...

...

...

1

px1

...

pxi

...

pxn

m

p xi = ∑ pij

j =1

i = 1,2, K , n

j = 1,2, K , m

o Distribuciones marginales:

X

pxi

x1

px1

x2

px2

...

...

xn

pxn

1

Y

pyj

y1

py1

∑p

xi

y2

py2

...

...

ym

pym

1

o f.d.D. marginales:

FX ( x) = F1 ( x) = F ( x, ∞) = P(X ≤ x ; Y < ∞ ) =

xi ≤ x

FY ( y ) = F2 ( y ) = F (∞, y ) = P(X < ∞ ; Y ≤ y ) =

∑p

yj≤y

Fundamentos de Estadística: Resúmenes.

yj

32

Tema 10: Variable aleatoria bivariante.

•

Caso continuo:

o

F1 ( x) = F ( x, ∞) = ∫

x

∫

+∞

−∞ −∞

x

f (t , y ) dt dy = ∫ f 1 (t ) dt

−∞

+∞

donde f1 ( x) = ∫ f ( x, y ) dy

−∞

o

F2 ( y ) = F (∞, y ) = ∫

+∞ y

∫

−∞ −∞

y

f ( x, t ) dx dt = ∫ f 2 (t ) dt

−∞

+∞

donde f 2 ( y ) = ∫ f ( x, y ) dx

−∞

o F1(x) y F2(y) son las f.d.D. marginales

o f1(x) y f2(y) son las f.d.d. marginales.

Distribuciones condicionadas.

•

Caso discreto:

Sea (X,Y) una v.a. con f. de probabilidad pij y distribuciones marginales pxi y pyj:

P (xi / y j ) = P (X = xi / Y = y j ) =

P(X = xi ; Y = y j )

P (Y = y j )

=

pij

pyj

; pyj > 0

( Probabilidad de X=xi condicionada al valor Y=yj )

o Distribuciones de probabilidad condicionada:

x1

x2

X

p(xi/yj) p(x1/yj) p(x2/yj)

...

...

pyj > 0

xn

p(xn/yj)

∑ P(x / y ) = 1

n

i =1

•

i

j

Caso continuo:

o

f ( x / y) =

f ( x, y )

; f 2 ( y) > 0

f 2 ( y)

(f.d.d. de la v.a. X condicionada al

valor Y=y).

o

∫

F ( x / y) =

x

−∞

f (t , y ) dt

f 2 ( y)

; f 2 )( y ) > 0

(f.d.D. de la v.a. X

condicionada al valor Y=y)

Independencia (estocástica) entre v.as.

Fundamentos de Estadística: Resúmenes.

33

Tema 10: Variable aleatoria bivariante.

•

Dada una v.a (X,Y), las variables X e Y se dicen independientes si ∀ intervalo

de R2 de la forma ( (x1,y1),(x2,y2) ) se verifica:

P(( x1 , y1 ) < (X, Y ) ≤ ( x 2 , y 2 )) = P( x1 < X ≤ x 2 ) P( y1 < Y ≤ y 2 ) ⇒

F ( x, y ) = F1 ( x) F2 ( y ) ∀ ( x, y ) ∈ R 2

•

Caracterizaciones equivalentes:

o

pij = P (X = xi ; Y = y j ) = p xi p y j

o

o

o

f ( x, y ) = f1 ( x) f 2 ( y ) ∀ ( x, y ) ∈ R 2 (caso continuo)

f ( y / x) = f 2 ( y )

f ( x / y ) = f1 ( x)

∀ ( x, y ) ∈ R 2 (caso discreto)

Fundamentos de Estadística: Resúmenes.

34

Tema 11: Introducción a la Inferencia Estadística.

TEMA 11: Introducción a la Inferencia Estadística.

Muestreo.

•

Población o colectivo: Censo (costos, destrucción del ente, entes relativos, ...).

•

Muestra. Principio de aleatoriedad (muestra aleatoria simple).

r

Muestra genérica: X = (X1 , X2 ,..., Xn ) v.a. n-dimensional.

•

x1

x'1

x''1

...

X1

x2

x'2

x''2

...

X2

x3

x'3

x''3

...

X3

...

...

...

...

...

xn

x'n

x''n

...

Xn

x

x'

x' '

...

X

Sx

Sx'

Sx''

...

SX

r

Para cada valor de X ⇒ muestra distinta. Realización de la muestra.

r

Conjunto de todas las posibles realizaciones: espacio muestral de X .

•

Tipos de muestreo:

o Según el diseño:

Muestreo aleatorio simple.

Muestreo estratificado.

Muestreo por conglomerados.

Muestreo polietápico.

o Según la forma en que se toman las observaciones:

Muestreo independiente o aleatorio simple.

Muestreo dependiente.

o Según el tamaño de la muestra:

Muestreo en poblaciones finitas (con o sin reemplazamiento).

•

Muestreo en poblaciones infinitas.

r

Función de densidad de X (supuesto el muestreo aleatorio simple):

Fundamentos de Estadística: Resúmenes.

35

Tema 11: Introducción a la Inferencia Estadística.

f(x1 ,x 2 ,K ,x n ) = f(x1 )f(x 2 )L f(x n )

llamada también función de verosimilitud.

•

Función de distribución empírica de la muestra concreta:

0

1

n

2

F*( x ) = n

L

( n − 1 )

n

1

si

x < x( 1 )

si

x( 1 ) ≤ x ≤ x( 2 )

si x( 2 ) ≤ x ≤ x( 3 )

L LLLLL

si x( n −1 ) ≤ x ≤ x( n )

si x( n ) ≤ x

siendo x( 1 ) ≤ x( 2 ) ≤ K ≤ x( n ) la muestra ordenada.

•

Teorema Central de la Estadística o de Glivenko-Cantelli.

“La distribución empírica de la muestra converge en probabilidad a la distribución

de la población cuando el tamaño muestral tiende a ser grande”.

P

F*( x )

→

F( x ) ∀ x ∈R , n → ∞

(

)

es decir que P sup F * ( x ) − F ( x ) → 0 → 1

r

• Estadísticos: Funciones de la v.a. X .

t : (X1, X2, ..., Xn) → R

(x1, x2, ..., xn) → t (x1, x2, ..., xn)

⇒ v.a. (asigna un valor numérico a cada muestra distinta).

•

Inferencia:

o Paramétrica.

Estimación: Por punto y por intervalo.

Contrastes de hipótesis.

o No paramétrica.

Fundamentos de Estadística: Resúmenes.

36

Tema 12: Algunas distribuciones maestrales.

TEMA 12: Algunas distribuciones muestrales.

Distribución de la media muestral.

•

•

r

Sea X = (X ,X ,...,X ) ∈ D( µ , σ 2 ) . El estadístico X ( media muestral )

1 2

n

1 n

σ2

X = ∑ X ∈ D( µ ,

)

n i =1 i

n

Si el tamaño muestral es grande:

σ2

σ2

X ∈ D( µ ,

) → N( µ ,

)

n

n

O lo que es lo mismo:

Z=

•

X −µ

→ N( 0 ,1 )

σ

n

Casos a considerar:

o σ 2 conocida:

Si n ≥ 30 la aproximación es buena.

o σ 2 desconocida:

Se puede calcular mediante la varianza muestral S 2 y la

aproximación es buena si n ≥ 100, es decir:

Z=

X −µ

→ N( 0 ,1 )

S

n

o Si n es pequeño, X seguirá la misma distribución que la población y no

tenderá ( convergerá ) a la distribución Normal.

•

Si la muestra proviene de una población Normal:

o σ 2 conocida:

X i ∈ D( µ , σ 2 ) ⇒ X ∈ N( µ ,

σ2

X −µ

) ⇔

→ N( 0 , 1 )

σ

n

n

Fundamentos de Estadística: Resúmenes.

37

Tema 12: Algunas distribuciones maestrales.

o σ 2 desconocida:

Se calcula mediante S2, la aproximación es buena si n ≥ 20. Caso

contrario se utiliza la aproximación:

T=

•

X −µ

→ t(n-1)

S

n -1

(Apéndice 1)

Distribución de la varianza muestral.

r

Sea X = (X ,X ,...,X ) ∈ D( µ , σ 2 )

1 2

n

1 n

o Si µ es conocida: S 2 = ∑ (xi − µ) 2

n i =1

1 n

o Si µ es desconocida: S 2 = ∑ (xi − x ) 2

n i =1

E( S2 ) = σ 2 −

σ2

n

;

V( S2 ) =

µ4 − σ 4

n

(Apéndice 2)

o Si el muestreo se realiza en una población normal:

S2

σ 2 µ4 − σ 4

→ N( σ −

,

)

n

n

2

o El estadístico usado en el estudio de la varianza es (Teorema de Craig):

nS 2

→ χ 2(n-1)

σ2

•

Distribución de la diferencia de medias en poblaciones normales.

Sean:

r

X ∈ N (µX ,σ X2 )

r

⇒

Y ∈ N (µY ,σ Y2 )

X ∈ N (µX ,

σ X2

)

n

X

σ2

Y ∈ N (µY , Y )

n

<

Y

Fundamentos de Estadística: Resúmenes.

38

Tema 12: Algunas distribuciones maestrales.

Consideremos la nueva v.a. Z = X − Y

E Z = E X − E Y = µX − µY

V Z = V X - Y = 12V (X ) + ( - 1)2V (Y )-2COV (X,Y ) ⇒

(

)

⇒ Z ∈ N (µX − µY ,

σ X2 σ Y2

+

− 2COV (X,Y ))

n

n

X

Y

Y donde ⇒ COV (X,Y ) =

σ XY

n n

X

Y

a) Si las muestras están relacionadas σ XY ≠ 0 , y generalmente se realiza un estudio

r

de la v.a. Z donde por regla general nX = nY

b) Si las muestras son independientes, σ XY = 0

Z ∈ N (µX − µY ,

σ X2 σ Y2

+

)

nX

nY

Casos posibles para σ X2 y σ Y2 :

1) σ X2 y σ Y2 son conocidas:

Z = X − Y ∈ N (µX − µY ,

σ X2 σ Y2

+

)

nX

nY

2) σ X2 = σ Y2 y desconocidas:

1

1

+

Z ∈ N µX − µY , σ 2

n

n

Y

X

⇒U=

X − Y − ( µx − µY )

1

1

σ

+

nX nY

→ N (0,1)

Fundamentos de Estadística: Resúmenes.

39

Tema 12: Algunas distribuciones maestrales.

nX S X2 + nY S Y2

, entonces:

nX + nY − 2

Si calculamos σ 2 mediante S 2 =

U=

X − Y − ( µx − µY )

→ t ( nX + nY − 2 )

1

1

+

S

nX nY

(Apéndice 3)

3) σ X2 ≠ σ Y2 y desconocidas:

U=

X − Y − ( µx − µY )

→ t (n)

SX2 SY2

+

nX nY

donde n ≅ nX + nY − 2 , si nX ≅ nY y relativamente grande, o bien:

n=

•

S X2

S2

n + Yn

X

Y

2

2

S X2

S Y2

n

n

X

Y

+

nX − 1

nY − 1

2

Distribución del cociente de varianzas en poblaciones normales.

r

r

n S2

Sean : X ∈ N ( µ X , σ X2 ) y Y ∈ N ( µ Y , σ Y2 ) . Considerando que: X 2 X ∈ χ (2nX −1) y que

σX

nY S Y2

∈ χ (2nY −1) , entonces:

σ Y2

χ (2nx −1)

nX SX2

σ X2

nX − 1 (nY − 1)nX SX2σ Y2

F=

=

∈ F( nX −1,nY −1)

nY SY2 (nX − 1)nY SY2σ X2

σ Y2

χ (2n −1)

nY − 1

y

Si nX = nY = n , la expresión anterior se reduce a:

F=

S2X σY2

∈ F(n

S2Y σX2

−1,n −1)

Fundamentos de Estadística: Resúmenes.

40

Tema 12: Algunas distribuciones maestrales.

Apéndices.

1. Y =

X −µ

→ t (n-1) ya que:

S

n -1

N(0,1)

X -µ

σ

n

X -µ

σ

X − µ n −1

X − µ n −1

X −µ

n

=

=

=

=

2

S

S

S n

nS

σ

nS

n −1

σ

n σ

σ2

n −1

n −1

t(n-1)

χ 2(n-1)

2. E(

S2 =

S2

(

σ2

)= σ −

n

2

)

(

)

t(n-1)

puesto que:

1 n

1 n 2

1 n

1 n 2

2

2

2

2

x

−

x

=

x

−

x

⇒

E

S

=

E

x

−

x

=

E xi2 − E x 2 = {

(

)

∑

∑

∑

∑

i

i

i

n i =1

n i =1

n i =1

n i =1

}

Por otra parte:

2

E ( xi − µ ) = E xi2 + µ 2 − 2 xi µ = E xi2 + µ 2 − 2 µ E [ xi ] = E xi2 − µ 2 ⇒ E xi2 = σ 2 + µ 2

y también

σ2

σ2

2

E ( x − µ ) = E x 2 + µ 2 − 2 x µ = E x 2 + µ 2 − 2µ E [ x ] = E x 2 − µ 2 =

⇒ E x 2 =

+ µ2

n

n

σ2

X → D µ,

n

Por tanto:

{ }=

3.

σ 2

1

σ2

n (σ 2 + µ 2 ) −

+ µ2 = σ 2 −

n

n

n

U=

X − Y − ( µx − µY )

1

1

S

+

nX nY

→ t ( nX + nY − 2) ya que:

Si suponemos σX2 = σ Y2 = σ 2 , y puesto que χ 2 es reproductiva,

Fundamentos de Estadística: Resúmenes.

41

Tema 12: Algunas distribuciones maestrales.

nx S x2

→ χ (2nx −1)

2

2

2

2

σx

nx S x2 n y S y nx S x + n y S y

→ χ (2n + n − 2)

⇒ 2 + 2 =

2

2

x

y

ny S y

σ

σ

σ

2

χ

→

( n y −1)

σ y2

Por lo tanto:

N (0,1)

X − Y − ( µX − µY )

σ

t ( n + n − 2)

x

y

1

1

+

nx n y

nx S x2 + n y S y2

σ2

nx + n y − 2

realizando X − Y − ( µX − µY )

=

=

1

1

operaciones

S

+

nx n y

χ (2n + n − 2)

x

si S =

nx S x2 + n y S y2

nx + n y − 2

y

Fundamentos de Estadística: Resúmenes.

42

Tema 13: Estimación por punto.

TEMA 13: Estimación por punto.

•

Estimador.

Estimador ⇒ Estadístico.

⇐

•

Propiedades de los estimadores.

o Insesgadez:

θˆ es un estimador insesgado o centrado de θ sí verifica que

r

E( θˆ ) = E[ t( x ) ] = θ

( θ parámetro poblacional desconocido)

Ejemplos:

X estimador insesgado de µ.

S 2 estimador insesgado de σ 2 .

(Apéndice 1)

S 2 estimador sesgado de σ 2 .

o θˆ es un estimador asintóticamente insesgado de θ sí E(θˆ )

→ θ

n→∞

Ejemplo: E( S 2 ) = σ 2 −

o

σ2

n

→ σ2

Consistencia.

Un estimador es consistente si al aumentar n indefinidamente, converge en

probabilidad al parámetro estimado:

P

θˆ(X1 , X2 ,K , Xn )

→θ

n →∞

Si

(

)

r

es decir P θˆ(X ) − θ < δ → 1

θˆ es estimador asintóticamente insesgado de θ

y se verifica que

V(θˆ)

→ 0 , se dice consistente ( de θ ).

n →∞

Ejemplo:

E( S 2 ) → σ 2 ; V ( S 2 ) =

µ4 − σ 4

→0

n

o Eficiencia.

Si dos estimadores θˆ1 y θˆ2 son estimadores insesgados de θ, se dice que θˆ1 es

más eficiente que θˆ2 sí: V(θˆ1 ) < V(θˆ2 ).

Fundamentos de Estadística: Resúmenes.

43

Tema 13: Estimación por punto.

•

Cota de Frechet-Cramer-Rao. (FCR )

r

Sea una muestra a.s. X = (X1 , X2 ,..., Xn ) obtenida de una población con f.d.d.

f ( x) = f ( x,θ ) en las que se cumplen ciertas condiciones de tipo matemático (p.e. el

r

espacio muestral no depende de θ, etc.), y sea θˆ = t ( X ) un estimador insesgado de θ y

r

L(θ ) = L(θ , X ) = f ( x1 ,θ ) f ( x2 ,θ )L f ( xn ,θ )

su función de verosimilitud. Entonces se verifica que la varianza de θˆ está acotada

inferiormente por la cota de FCR(θ ).

V (θ ) ≥

1

≡ FCR (θ )

∂ ln L(θ , Xr ) 2

E

∂θ

Si se cumplen estas condiciones, se dice que θˆ es un estimador eficiente deθ .

•

Mejor estimador insesgado.

Un estimador θˆ que sea insesgado, consistente y eficiente se denomina mejor

estimador insesgado BUE(θ ) para θ.

•

Obtención de estimadores. Método de la máxima verosimilitud.

Consiste en maximizar la función de verosimilitud

r

L(θ ) = L(θ , X ) = f ( x1 ,θ ) f ( x2 ,θ )L f ( xn ,θ )

r

r

siendo f ( X ) la f.d.d. de la v.a. X . Para lo cual basta con obtener la solución de:

r

∂L(θ , X )

=0

∂θ

Pero si una función cualquiera alcanza un máximo en un punto, la función ln de

ésta también alcanza un máximo en el mismo punto, con lo que basta resolver:

r

∂ ln L(θ , X )

=0

∂θ

Fundamentos de Estadística: Resúmenes.

44

Tema 13: Estimación por punto.

Apéndices.

n

n 2 σ2

1. E S 2 =

E S 2 =

σ −

n −1

n −1

n

n 2 1

n

n −1

=σ2

σ 1 − =

σ2

=

n

n − 1 n n − 1

2. La media muestral es el estimador de máxima verosimilitud para la media

poblacional de una variable normalmente distribuida.

r

L ( x ,θ ) = f ( x1 ,θ ) f ( x2 ,θ )L f ( xn ,θ )

r

L ( x, µ ) =

1

σ 2π

e

−

1 ( x1 − µ )

2 σ2

2

1

σ 2π

e

−

1 ( x2 − µ )

2 σ2

2

L

n

x − µ)

1

r

1 ∑( i

−

ln L ( x , µ ) = ln

2 i =1 σ 2

σ 2π

n

r

∂ ln L ( x , µ )

∂µ

n

= + 1 2∑

2 i =1

Es decir µˆ =

( xi − µ )

σ2

1

σ 2π

e

−

1 ( xn − µ )

2 σ2

2

n

n

1

1 − 2∑

i =1

=

e

σ 2π

( xi − µ )2

σ2

2

n

n

i =1

i =1

= 0 ⇔ ∑ ( xi − µ ) = 0 ⇔ ∑ xi − n µ = 0 ⇔ µ =

1 n

∑ xi

n i =1

1 n

∑ xi = x

n i =1

3. La media muestral es el estimador de máxima verosimilitud para el parámetro λ en

una población de tipo Poisson.

r

L ( x ,θ ) = f ( x1 ,θ ) f ( x2 ,θ )L f ( xn ,θ )

n

−λ

−λ

−λ

e λ e λ

e λ

e

r

L ( x, λ ) =

L

=

x1 !

x2 !

xn !

x1

x2

xn

− nλ

∑ xi

λ i =1

n

∏x !

i

i =1

n

n

r

ln L ( x , λ ) = − nλ + ∑ xi ln λ − ∑ ln xi

i =1

r

∂ ln L ( x , λ )

∂λ

= −n +

i =1

n

1 n

1 n

x

=

⇔

x

=

n

λ

⇔

λ

=

0

∑ i

∑

∑ xi

i

λ i =1

n i =1

i =1

1 n

Con lo que λˆ = ∑ xi = x

n i =1

Fundamentos de Estadística: Resúmenes.

45

Tema 13: Estimación por punto.

4. La media muestral es un estimador eficiente para µ en una población normal, y por

tanto BUE.

FCR ( µ ) =

∂ ln L( Xr , µ ) 2

E

∂µ

r

∂ ln L ( x , µ )

∂µ

1

=

1

σ2

n

∑(x

i

i =1

− µ)

2

r

∂ ln L ( x , µ )

1

1

2

= 4 ( xi − µ ) = 4

∂µ

σ

σ

n

n 2

2 2

∑ xi + n µ − 2n µ ∑ xi

i =1

i =1

∂ ln L ( xr , µ ) 2

n

1 n 2

2 2

E

= E 4 ∑ xi + n µ − 2n µ ∑ xi

∂µ

σ i =1

i =1

2

1 n

n

2 2

=

+

−

µ

µ

E

x

n

n

E

2

∑ i

∑ xi

σ 4 i =1

i =1

2

1 n 2

1 n

2 2

2 2

2 2

=

E

x

+

n

µ

−

n

µ

=

E

x

−

n

µ

2

∑

∑

i

i

σ 4 i =1

σ 4 i =1

2

n

x

∑

n 2 i =1 i

n2 σ 2 σ 2

2

=

−

µ

=

=

=

E

{

}

n

σ 4 n

σ4 n

{}

n

n

x

∑ xi

∑ i

i =1

= E i =1

V

n

n

Luego FCR ( µ ) =

1

n

σ2

=

2

n 2

n

x

∑ i

∑ xi

i

1

=

−E

= E i =1

n

n

2

2

− µ2 = σ

n

σ2

, y por tanto µˆ = x es eficiente.

n

Fundamentos de Estadística: Resúmenes.

σ2

X → D µ,

n

46

Tema 14: Estimación por intervalo.

TEMA 14: Estimación por intervalo.

•

Una estimación por intervalo de un parámetro poblacional θ es un intervalo de

la forma:

•

θˆi < θ < θˆs

donde θˆ y θˆ dependen del estadístico θˆ utilizado y de su distribución.

i

s

Muestras distintas proporcionan valores distintos de θˆ ⇒ θˆ y θˆ son valores

i

s

de las variables θˆ y θˆ

I

S

⇒ a partir de la distribución muestral de θˆ es

posible seleccionar θˆ y θˆ tal que:

i

s

P( θˆ < θ < θˆ ) = 1- α ; 0 < α < 1

I

S

⇒ para una muestra seleccionada puedo encontrar un intervalo de confianza:

I1 − α (θˆi ,θˆs ) = θˆi < θ < θˆs

donde:

1 - α = coeficiente de confianza

θˆi y θˆs = límites de confianza

•

Obtención de intervalos: Método de Student.

r

1. Definir un estadístico T = T (X ,θ ) cuya distribución muestral no

dependa de θ .

2. Tomar dos cotas t (α1 ) , t (α 2 ) con α1 + α 2 = α tal que ∀θ ,

r

P t (α 2 ) ≤ T (X,θ ) ≤ t (α1 ) = 1 − α

(

)

α2

α1

1−α

tHα2L

tHα1L

Fundamentos de Estadística: Resúmenes.

47

Tema 14: Estimación por intervalo.

r

r

3. Resolver las ecuaciones t (α1 ) = T (X ,θ ) ; t (α 2 ) = T (X ,θ ) para obtener:

r

r

P θˆ1 (X ,α1 ) ≤ θ ≤ θˆ2 (X , α 2 ) = 1 − α

(

)

Y por tanto:

r

r

I1−α (θ ) = θˆ1 (X ,α1 ) ,θˆ2 (X ,α 2 )

(

)

Fundamentos de Estadística: Resúmenes.

48

Tema 15: Contrastes de hipótesis.

TEMA 15: Contrastes de hipótesis.

•

Un contraste o test consiste en una regla de decisión, basada en información

experimental (una muestra) para aceptar o rechazar una cierta hipótesis

formulada (sobre la naturaleza de la población o alguna forma de sus

propiedades).

•

Hipótesis nula (H0) o hipótesis del contraste: Hipótesis (afirmación) que se

quiere contrastar, y por tanto, la que se acepta o se rechaza como conclusión del

contraste.

•

Hipótesis alternativa (H1): Hipótesis situada frente a H0, de forma que si se

acepta H0, se rechaza H1 y viceversa.

•

Tipos de contraste:

o Paramétrico: La elección entre aceptar o rechazar H0 depende del valor o

valores de un parámetro θ ( y la distribución generadora de la muestra).

o No paramétrico: Se contrasta la forma de la distribución de la población

generadora de la muestra.

•

Espacio paramétrico (Θ ): Conjunto de posibles valores de θ.

•

Espacio paramétrico asociado a H0 (Θ0): Conjunto de posibles valores del

parámetro θ que estamos contrastando bajo la hipótesis nula.

•

Espacio paramétrico asociado a H1 (Θ1): Conjunto de posibles valores del

parámetro θ que estamos contrastando bajo la hipótesis alternativa.

•

Notas:

o La estimación trata de obtener un valor θˆ que en algún sentido

(probabilístico) se pueda considerar próximo al verdadero valor de θ. Sin

embargo, en los test de hipótesis se trata, dado un valor de θ , de ver si

los datos experimentales están o no de acuerdo con esta hipótesis.

o Cada hipótesis está asociada a una parte del espacio paramétrico.

•

Hipótesis simple: El espacio paramétrico (de θ ) está compuesto por un único

valor. En caso contrario, la hipótesis se dice compuesta.

•

Errores en la decisión:

o Error de tipo I: Error que se comete en la decisión del contraste cuando

se rechaza la hipótesis nula (H0) siendo correcta.

o Error de Tipo II: Error que se comete en la decisión del contraste cuando

se acepta la hipótesis nula siendo falsa.

H0 verdadera

H0 falsa

Se acepta H0

Decisión correcta

Error de tipo II

Fundamentos de Estadística: Resúmenes.

Se rechaza H0

Error de tipo I

Decisión correcta

49

Tema 15: Contrastes de hipótesis.

•

Región de aceptación de H0 (C0 ): Conjunto de valores muestrales o una función

de ellos (estadístico) que lleva a la decisión de aceptar la hipótesis nula.

•

Región crítica (C1) o de rechazo: Conjunto de valores muestrales o una función

de ellos (estadístico) que lleva a la decisión de rechazar la hipótesis nula.

•

•

r

Estadístico del contraste: Estadístico t (X ) usado para decidir qué hipótesis

aceptar o rechazar.

Probabilidades de error:

r

o P ( I ) = P t (X ) ∈ C1 / H 0

r

o P ( II ) = P t (X ) ∈ C0 / H1

(

(

)

)

•

Nivel de significación(α): Máxima probabilidad de cometer error de tipo I.

•

Contraste bilateral: El espacio

paramétrico asociado a H1

recubre al espacio paramétrico

asociado a H0, es decir, está

formado por dos conjuntos de

valores disjuntos.

αê2

αê2

1−α

o Ejemplo:

H 0 : µ = µ0

H1 : µ ≠ µ 0

•

NH0,1L

−Zαê 2

Zα ê2

0

C1

C0

C1

Contraste Unilateral: El espacio paramétrico asociado a H1 recubre está formado

por valores superiores o inferiores al espacio paramétrico asociado a H0, es

decir, formado por un solo conjunto de valores.

o Ejemplos:

H 0 : µ = µ0

H 0 : µ = µ0

H1 : µ > µ 0

H1 : µ < µ 0

NH0,1L

α

NH0,1L

α

1−α

0

C0

1−α

zα

−zα

C1

C1

Fundamentos de Estadística: Resúmenes.

0

C0

50

Tema 15: Contrastes de hipótesis.

•

Curva operativo característica (C(θ)): Probabilidad de aceptar la hipótesis nula.

r

r

C (θ ) = P( Aceptar H 0 ) = P t (X ) ∈ C0 , ∀ θ = P t (X ) ∉ C1 , ∀ θ

(

o

o

)

(

)

r

r

P t (X ) ∈ C0 / H 0 = 1 − P t (X ) ∈ C1 / H 0 = 1 − P ( I )

r

P t (X ) ∈ C0 / H1 = P( II )

(

(

)

)

(

1

)

PHIL

α,α∗

P∗ HIL

C∗ HθL

P∗ HIIL

0

PHIIL

a

Θ1

CHθL

b

Θ0

Θ1

•

Potencia de un contraste: Probabilidad de rechazar la hipótesis nula H0 siendo

falsa.

•

Curva de potencia (P(θ)): Probabilidad de rechazar la hipótesis nula H0.

r

r

P (θ ) = P ( Rechazar H 0 ) = P t (X ) ∈ C1 , ∀θ = 1 − P t (X ) ∈ C0 , ∀θ = 1 − C (θ )

(

)

(

)

1

α∗

α

C∗ HθL

β∗

β

CHθL

0

Θ1

a

Θ0

b

Θ1

Donde β es la máxima probabilidad de cometer error de tipo II.

•

Fases para realizar un contraste de hipótesis:

1. Enunciar y determinar las hipótesis H0 y H1 respectivamente.

2. Elegir un nivel de significación α con el que trabajar.

3. Especificar el tamaño muestral y realizar la muestra concreta con la ,que

trabajar.

Fundamentos de Estadística: Resúmenes.

51

Tema 15: Contrastes de hipótesis.

4. Seleccionar el estadístico de trabajo, cuya distribución sea conocida en el

supuesto de ser H0 cierta.

5. Determinar la región de aceptación C0 o la región crítica C1.

6. Determinar el valor del estadístico para la muestra obtenida.

7. Obtener conclusiones de tipo estadístico.

8. Obtener conclusiones de naturaleza no estadística, como pueden ser

biológicas, medicas, económicas, etc.

Fundamentos de Estadística: Resúmenes.

52

Tema 16: Contrastes de ajuste.

TEMA 16: Contrastes de ajuste.

Poblaciones X e Y no numéricas.

Hipótesis:

Y ∈ Sy

*

1

*

c

H : X es independiente de Y

0

H1 : X esta relacionada con Y

(xt,yt)

Muestra:

{

}

= {y ,....., y }

X ∈ Sx = x1* ,....., x*f

nij

tabulada en forma de tabla de contingencia

t=1,2,...n

i=1..f

j=1..c

Estadísticos:

G2 = 2

f

c

∑∑

i =1 j =1

nij ln

f

nij

P=

Eij

c

∑∑

(nij − Eij ) 2

Eij

( nij − Eij − 0.5) 2

i =1 j =1

n (n 11 * n 22 − n 12 * n 21 )

P=

n 1. * n 2. * n .1 * n .2

∑∑

i =1 j =1

f

Pc =

c

2

; Pc =

(

Eij

n n 11 * n 22 − n 12 * n 21 − n

)

2

2

n 1. * n 2. * n .1 * n .2

Distribución muestral (asintótica):

P , G ∈ χ 2 [(r − 1)(k − 1)]

0.25

Regla de decisión de nivel α:

2)

C0 = (0; χα

2

Distribución χ [(f-1)(c-1)]

0.20

0.15

0.10

0.05

|

|

0.00

Decisión:

0

A nivel α: Si P o G ∈ C0 ⇒ se acepta H0

Fundamentos de Estadística: Resúmenes.

χα

2

P, G

2

53

Tema 16: Contrastes de ajuste.

CONTRASTES DE AJUSTE A DISTRIBUCIONES

Hipótesis:

H : X ∈D µ , σ 2

H : X ∈ F(x)

0

0

⇒

H : X ∉ D µ , σ 2

H1 : X ∉ F(x)

1

Estadísticos:

n

G = 2 ∑ n i ln i

Ei

i =1

k

(n i − n p i 0 ) 2

P=∑

n p i0

i =1

k

k

Pc = ∑

(n

− n p i 0 − 0.5)

2

i

n p i0

i =1

Distribución muestral (asintótica):

P , G ∈ χ 2 (k − 1)

Condiciones asintóticas

n p i0 > 5 ∀ i

; admitiendo 1 < n p i 0 < 5 en número inf erior al 20% del valor de K

0.25

Regla de decisión de nivel α:

2)

C0 = (0; χα

2

Distribución χ [(f-1)(c-1)]

0.20

0.15

0.10

0.05

|

|

0.00

Decisión:

0

A nivel α: Si P o G ∈ C0 ⇒ se acepta H0

Fundamentos de Estadística: Resúmenes.

χα

2

P, G

2

54

Tema 16: Contrastes de ajuste.

CONTRASTES DE INCORRELACION

Poblaciones X e Y numéricas.

Hipótesis:

H0 : X está incorrelada con Y

Muestra:

(xi, yi)

H1 : X está correlada con Y

i=1,2,...,n

Estadístico:

T=

r n−2

r = rxy =

1− r 2

Distribución muestral:

0.5

a) Si X,Y ∈ N

T|H0 ∈ t(n-2)

b) Si X,Y ∉ N

T|H0 → t(n-2)

s xy

sx s y

Distribución t(n-2)

0.4

0.3

0.2

Regla de decisión de nivel α:

0.1

0.0

C0 = (-tα/2;+tα/2)

Decisión:

-tα/2

0

tα/2

t

A nivel α: Si t ∈ C0 ⇒ se acepta H0

Fundamentos de Estadística: Resúmenes.

55

Tema 17: Regresión y correlación lineal.

TEMA 17: Regresión y correlación lineal.

Introducción.

•

Correlación: Simple, múltiple, parcial.

•

Regresión o ajuste. Línea de regresión:

Recta: y=a+bx

Parábola: y=a+bx+cx2

Exponencial: y=akbx

Potencial: y=axb

Cúbica: y=a+bx+cx2+dx3

Hipérbola: y=1/(a+bx)

Polinómica: y=a+bx+cx2+...+hxn

..........................

Regresión lineal.

•

Recta de regresión de Y sobre X.

Y

yi

*

.

εi

ŷ i

yˆ = a + bx

(xi,yj)

*

*

*

*

*

*

ŷ i valor estimado de Y

para X=xi

*

εi residuos

X

xi

•

Mínimos cuadrados:

Minimizar la expresión:

n

n

n

H = ∑ ε = ∑ ( y i − yˆ i ) = ∑ ( y i − a − bxi )

i =1

2

i

i =1

2

2

i =1

para ello derivamos parcialmente e igualamos a cero:

n

∂H

= −2∑ ( y i − a − bxi ) = 0

∂a

i =1

Ecuaciones Normales

n

∂H

= −2∑ ( y i − a − bxi )xi = 0

∂b

i =1

Resolviendo el sistema, se obtienen a y b.

Fundamentos de Estadística: Resúmenes.

56

Tema 17: Regresión y correlación lineal.

•

Resultados intermedios:

o

ε =0

o

y = a + b x ⇒ (x, y ) satisface la ecuación de regresión ≅ la recta de

regresión pasa por el centro de gravedad.

a = y − bx

n

o

∑ε x

i =1

i

= 0 ⇒ COV (ε , x) = S εx = 0

i

Los residuos y la variable

independiente están incorrelados.

o

COV (ε , X ) = S xy − bS x2 = 0 ⇒

b=

o

•

yˆ − y =

S xy

S x2

S xy

S x2

(xˆ − x )

Recta de regresión de X sobre Y: Estudio análogo. ( xˆ = a '+b' y )

Y

*

*

.

yi

*

*

*

*

x̂i valor estimado de

X para Y=yi

(xi,yj)

εi

*

x̂i

•

*

xˆ = a'+b' y

εi residuos

xi

X

Relación entre las pendientes:

b b' =

S xy2

S x2 S y2

= ρ xy2

Fundamentos de Estadística: Resúmenes.

57

Tema 17: Regresión y correlación lineal.

Regresión parabólica.

yˆ = a + b1 x + b2 x 2

Usando el método de mínimos cuadrados, minimizamos la expresión:

n

n

n

(

H = ∑ ε = ∑ ( y i − yˆ i ) = ∑ y i − a − b1 xi − b2 xi2

i =1

2

i

2

i =1

)

2

i =1

para ello derivamos parcialmente e igualamos a cero:

n

∂H

= −2∑ y i − a − b1 xi − b2 xi2 = 0

∂a

i =1

n

∂H

2

= −2∑ y i − a − b1 xi − b2 xi xi = 0 Ecuaciones Normales

∂b1

i =1

n

∂H

2

2

= −2∑ y i − a − b1 xi − b2 xi xi = 0

∂b2

i =1

(

)

(

)

(

)

Resolviendo el sistema, se obtienen a, b1 y b2. Podemos simplificar realizando el

cambio Z=X2, con lo que:

yˆ = a + b1 x + b2 z

Y de nuevo aplicando mínimos cuadrados:

n

∂H

= −2∑ ( y i − a − b1 xi − b2 z i ) = 0

∂a

i =1

n

∂H

= −2∑ ( y i − a − b1 xi − b2 z i )xi = 0 Ecuaciones Normales

∂b1

i =1

n

∂H

= −2∑ ( y i − a − b1 xi − b2 z i )z i = 0

∂b2

i =1

Se obtienen los valores de los parámetros desconocidos, resolviendo el sistema

•

Conclusiones:

o

o

o

o

o

ε =0

a = y − b1 x − b2 z

(y = a + b x + b z )

1

2

COV (ε X ) = 0

COV (ε Z ) = 0

A1,i +1

bi = −

para i = 1,2 . Donde A1,1 es el adjunto al elemento a1,1 de la

A1,1

matriz de covarianzas ∑.

Fundamentos de Estadística: Resúmenes.

58

Tema 17: Regresión y correlación lineal.

S y2

∑ = S xy

S

zy

S yz

S xz y A1,i+1 el adjunto al elemento a1,i+1 .

S z2

S yx

S x2

S zx

Al menor complementario del elemento a1,1 de ∑, es decir:

S x2

∑ xr =

S zx

S xz

se le denomina matriz de covarianzas de las xr (v. indep.)

2

Sz

Este proceso se puede generalizar al caso lineal múltiple, dado el hiperplano

de regresión: yˆ = a + b1 x1 + b2 x 2 + L + bn x n .

Regresión exponencial y potencial.

•

Exponencial: yˆ = ak bx , k > 0

Si tomamos logaritmos:

log k yˆ = log k a + bx log k k ⇒

yˆ * = a * + b * x

donde:

yˆ * = log k yˆ

a * = log k a

b * = b log k k = b

con lo que se ha transformado el problema en uno de tipo lineal. Para obtener

finalmente a, basta tomar antilogaritmos.

•

Potencial: yˆ = ax b

Tomando logaritmos:

log yˆ = log a + b log x ⇒

yˆ * = a * + bx *

donde:

yˆ * = log yˆ

a * = log a

x * = log x

de nuevo se ha transformado el problema a uno de tipo lineal.

Correlación simple.

•

ρ xy =

S xy

SxSy

.

Fundamentos de Estadística: Resúmenes.

59

Tema 17: Regresión y correlación lineal.

•

Relación entre ρ xy y los coeficiente de regresión:

S xy

o Dado que b =

S x2

o O bien b = ρ xy

⇒ ρ xy =

bS x2

S

=b x

SxSy

Sy

Sy

Sx

o Por otra parte: ρ xy = bb'

Varianza residual.

•

V (ε ) = Sε2 =

1 n

1 n 2

2

(

)

ε

ε

−

=

∑ i

∑εi

n i =1

n i =1

Por otra parte:

S ε2 =

1 n

1 n

2

(

)

( yi − a − bxi )2 = K Ejercicio

y

−

y

=

ˆ

∑ i i n∑

n i =1

i =1

S xy2

K = S 1 − 2 2 = S y2 1 − ρ 2

S S

x y

(

2

y

)

"La recta de regresión explica el 100ρ2 % de la varianza de la variable Y."

•

ρ2 coeficiente de determinación.

S ε2

ρ = 1− 2

Sy

2

"Tanto por1 (ó % ) de la varianza de Y explicada por el modelo."

Correlación múltiple.

Dado el hiperplano de regresión: yˆ = a + b1 x1 + b2 x 2 + L + bn x n , se definen los

•

coeficientes de correlación simples como:

ρ yxi =

S yxi

S y S xi

∀ i = 1,2, K

Fundamentos de Estadística: Resúmenes.

60

Tema 17: Regresión y correlación lineal.

•

Y la matriz de correlaciones simples como:

ρ yx1

1

1

ρ

Γ = yx1

ρ

yx2

M

•

ρ yx2

ρ x1 x2

1

M

ρ x1x2

M

L

L

L

O

Coeficiente de correlación lineal múltiple:

ρ yx1x2 K = ρ y =

S yyˆ

S y S yˆ

∈ [− 1,1]

Ejercicio: Obtener el coeficiente de correlación lineal simple a partir de

la definición genérica.

2

Se verifica que: ρ y2 ≥ ρ yx

i

•

Al igual que en el caso lineal simple se puede expresar:

ρ y2 = 1 −

•

∀ i = 1,2, K

S ε2

S y2

y

(

S ε2 = S y2 1 − ρ y2

)

La varianza residual puede obtenerse de forma genérica como:

Sε2 =

det ∑

det ∑ xr

Ejercicio: Obtener S ε2 del modelo lineal simple a partir de la definición

genérica.

Correlación parcial.

•

Objetivo: Eliminar los efectos distorcionantes de terceras variables sobre las

relaciones lineales entre variables.

•

Fundamento: Dados los modelos:

x = a + bz + ε x

;

y = a '+b' z + ε y

Fundamentos de Estadística: Resúmenes.

61

Tema 17: Regresión y correlación lineal.

ε x representa la parte de X que no es capaz de explicar Z (luego Z no

interviene), y de forma análoga ε y . Por tanto se define el coeficiente de

correlación entre X e Y, parcial Z como:

ρ xy , z = ρε x ε y

Operativamente se puede obtener como:

ρ xy , z =

•

ρ xy − ρ xz ρ yz

1 − ρ xz2 1 − ρ yz2

=−

A12

A11 A22

Conclusiones:

ρ xy2 , z > ρ xy2

La variable Z oculta o amortigua la

⇒

interdependencia entre X e Y

La interdependencia entre X e Y se debe

ρ xy2 , z ≅ 0 ⇒

casi exclusivamente al efecto de Z

ρ xy2 , z < ρ xy2

La interdependencia entre X e Y se debe

⇒

parcialmente a la influencia de Z

Fundamentos de Estadística: Resúmenes.

62

![Plantilla para resumen de JIMA2008 [pdf]](http://s2.studylib.es/store/data/001614228_1-b16f419ac1229808b31c5bd9885fdf95-300x300.png)