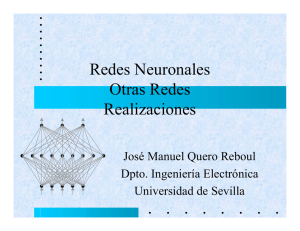

Redes de Hopfield(T)

Anuncio

Osvaldo Comelli

Nicolás Hakim

Rafael Peñalosa

Isis Pulido

Aram Zamora

Daniela Zenteno

REDES DE HOPFIELD

0. Objetivos

En este documento, se pretende dar una visión

general de las Redes de Hopfield, así como lo

fueron las presentaciones de carácter divulgativo.

Este documento y el resumen entregado en clase

constituyen el soporte de las mismas.

No se ahonda en demostraciones ni formalismos,

pero se da la esencia de estas redes.

1.Introducción

Las Redes de Hopfield simulan una memoria

asociativa, es decir, al igual que la mente

humana relaciona acontecimientos con

sensaciones, estas redes asociarán patrones

con variaciones de los mismos.

Para comprender más fácilmente la forma en que

trabajan las redes de Hopfield para asociar

aquellos patrones, haremos una analogía con la

física. Si se tiene una curva cóncava hacia arriba

y se coloca un objeto un la parte más alta, éste

objeto tendrá energía potencial. Al soltarlo y

dejarlo resbalar sobre la curva, irá

perdiendo energía potencial y ganando

energía cinética, y además perderá

energía en forma de calor a causa de la

fricción con el aire y la superficie. Finalmente,

después de un tiempo, llegará a un estado estable

(donde ya no se moverá). Éste estado tendrá la

energía mínima (puesto que estará en la parte más

baja de la curva [energía potencial mínima] y su

energía cinética será cero).

En las redes de Hopfield se definirá una función

de energía que asegure alcanzar el mínimo mediante

algún procedimiento, y se formará la red de tal

forma que el estado estable (donde se alcanza el

mínimo) sea exactamente alguno de los patrones que

se desea recuperar. Estos patrones serán llamados

“memorias fundamentales”.

2. Características de la Red de Hopfield

2.1 Topología de la Red

a) Es un Red Recurrente, todos las neuronas están

conectadas entre sí, pero no con

ellas mismas (conexión

irreflexiva). Es decir, la

conexión es tal que cada neurona

recibe señal de todas las demás y

emite señal hacia todas ellas,

pero no se autoexcita.

b) Los pesos entre neuronas deben ser simétricos y

una neurona no puede estar conectada con ella

misma, es decir

wij=wji ij

wii=0

Así, la matriz de pesos W es simétrica con

ceros en la diagonal.

c) Cada neurona puede tomar los valores de 1.

Al vector N-dimensional X que contiene los

valores de las N neuronas de la red se le llama

estado de la red.

d)La forma en que una neuronaj determina su estado

es haciendo un promedio ponderado vj (al que se le

llama CAMPO LOCAL INDUCIDO) de las entradas que recibe

de otras neuronas (la ponderación se hace de acuerdo

a los pesos sinápticos). Después de acuerdo si

vj > 0 xj=1

vj = 0 xj permanece igual

vj < 0 xj=-1

2.2 Función de Energía

Un requisito para que la Red de Hopfield funcione

como memoria asociativa es que sea un sistema

globalmente estable (i.e. no importando la

trayectoria (sucesión de estados) se termina en un

punto de equilibrio). Esto pasa si existe una

función Lyapunov para el problema (no diremos en

qué consiste esto). Para la Red de Hopfield

existe, y es una función E que tiene como

parámetros los pesos, la resistencia de cada

neurona, y como entrada el estado de la red.

Esta función tiene como propiedad ser

monotónicamente decreciente, lo que asegura que la

evolución en el tiempo de la red represente una

trayectoria en el espacio de estados que busca un

mínimo de la función E.

2.3 Funcionamiento

Se tiene un conjunto de M memorias fundamentales

(vectores de dimensión N con valores 1, que

queremos que la red “recuerde”). Sea {ui}i=1,...,m el

conjunto de estas memorias.

Fase de Almacenamiento:

1) Aprendizaje :

Usualmente a través de la Regla de Hebb:

1 M T

W ( ui ui ) MI

N i 1

se determinan los pesos entre neuronas.

(Nota: La elección de la regla de aprendizaje no

es trivial, depende de la correlación entre los

patrones que se desean almacenar. Existen

variantes de la Regla de Hebb)

Fase de Recuperación (“Recuerdo”)

1) Inicialización:

x(k) representa el estado de la red en la

iteración k-ésima.

Se impone un vector prueba prueba (una versión

distorsionada de una memoria fundamental)como estado

de la red:

x(0) prueba

2)Mientras x(k+1)x(k)

Se calcula el siguiente estado de la red:

2.1) Cálculo de los valores de los CAMPOS LOCALES

INDUCIDOS v.

V = Wx(k)

donde W es la matriz de pesos.

2.2) Se calcula el siguiente estado.

1

si

vj>0

x(k+1)j=

x(k)j

si vj =0

-1

si vj <0

En la versión Asíncrona , esto se hace para sólo

una j elegida al azar elegida de forma

secuencial.

En la versión Síncrona, esto se hace para toda j.

La razón por la que se prefiere Asíncrono a

Síncrono es el siguiente

Teorema:

La Red de Hopfield (con W simétrica y ceros en la

diagonal) es globalmente convergente (es decir, no

importa el punto inicial) si se emplea una

dinámica asíncrona.

2) El resultado es el último x(k) obtenido. (Un

punto estable)

3. Limitaciones

3.1 Capacidad de Almacenamiento

a) No todas las memorias fundamentales no son

siempre puntos estables.

En base a estudios probabilísticos se obtuvo que:

Las memorias fundamentales serán estables si y

sólo si,

N

es grande . Así que mientras el

( M 1)

número de memorias fundamentales sea pequeño

comprado con N , las memorias fundamentales son

estables en un sentido probabilístico.

b) Existen estados espúreos (puntos estables que

no corresponden a memorias fundamentales).

Así que en la segunda fase, podemos no “recordar”

una memoria fundamental, se dice que “recuerda con

errores”.

Se denota la CAPACIDAD DE ALMACENAMIENTO CON ERRORES como

Mc, es decir,el número de estados que pueden ser

recordados con errores, pero antes de que éstos

sean severos.

Hopfield haciendo simulaciones estimo Mc=.15 N y

Amit haciendo consideraciones estadísticas obtuvo

que Mc=.14N.

Se denota la CAPACIDAD DE ALMACENAMITNO CASI SIN ERRORES

como MMax, se define como el número más grande de

memeorias fundamentales que pueden almacenarse en

la red y que la mayoría sea recordada

correctamente.Mc Cliece encontró que

M max

N

2 ln N

3.2 Estados Espurios

Se pueden clasificar de tres formas:

a) Negativos: Si x es un punto fijo de la red

entonces –x también lo es.

b) Estados Mezcla: Si u1,u2,...,uk, con k impar,

son patrones almacenados, entonces

k

sgn( ui ) es un estado espúreo.

i 1

(sgn, denota la función signo, sgn(x)=1 si x>0, -1

si x<0 y x si x=0).

c)Estados “Spin-Glass”: son mínimos locales de

energía que no están relacionados con ninguna de

las memorias fundamentales.

3.3 Eficiencia

Requieren mucho tiempo de procesamiento hasta

converger a una solución estable, lo que limita su

aplicabilidad.

4. Bibliografía

Haykin, Neural Networks a Comprehensive

Foundation,2aedición, Prentice Hall, 1999

http://electronica.com.mx/neural/informacion/hopfi

eld.html

http://www.gc.ssr.upm.es/inves/ann2/unsupmod/fixwe

igh/seqhopmo.htm

http://dns1.mor.itesm.mx/~emorales/Cursos/KDDO1/no

de41.html

http://www.fortunecity.com/skyscraper/chaos/279/ar

ticulos/redesneuronales.htm

http://www.shef.ac.uk/psychology/gurney/notes/15/