Un Ambiente Integrado de Clasificación, Selección y Ponderación

Anuncio

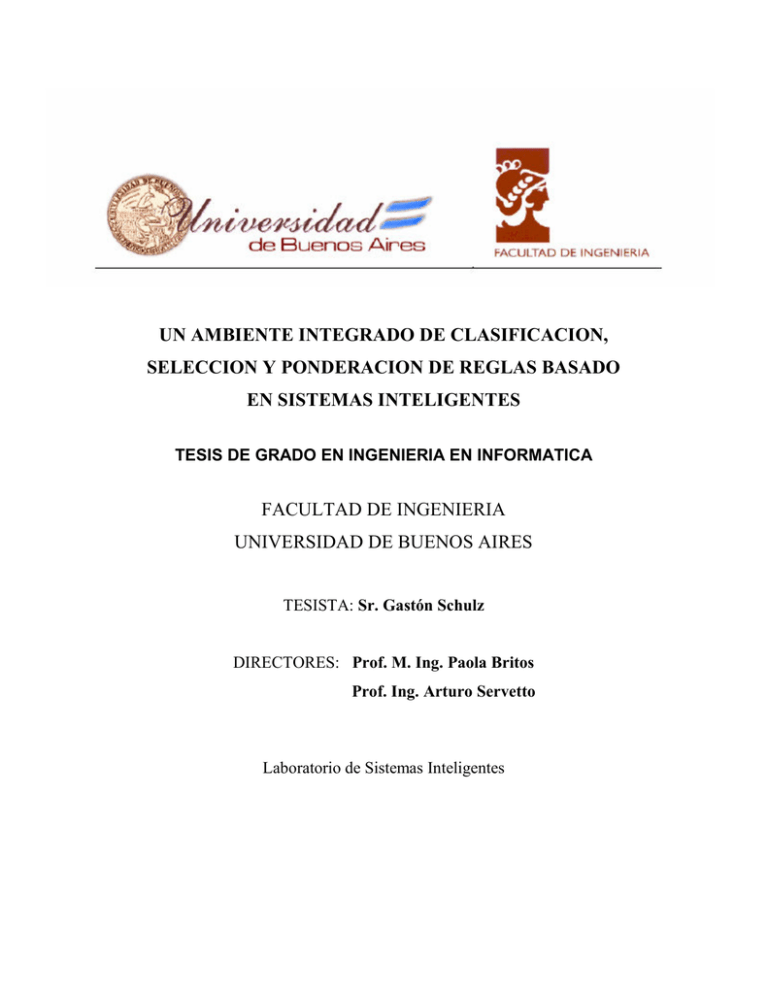

UN AMBIENTE INTEGRADO DE CLASIFICACION,

SELECCION Y PONDERACION DE REGLAS BASADO

EN SISTEMAS INTELIGENTES

TESIS DE GRADO EN INGENIERIA EN INFORMATICA

FACULTAD DE INGENIERIA

UNIVERSIDAD DE BUENOS AIRES

TESISTA: Sr. Gastón Schulz

DIRECTORES: Prof. M. Ing. Paola Britos

Prof. Ing. Arturo Servetto

Laboratorio de Sistemas Inteligentes

2

UN AMBIENTE INTEGRADO DE CLASIFICACION,

SELECCION Y PONDERACION DE REGLAS BASADO

EN SISTEMAS INTELIGENTES

TESIS DE GRADO EN INGENIERIA EN INFORMATICA

Laboratorio de Sistemas Inteligentes

FACULTAD DE INGENIERIA

UNIVERSIDAD DE BUENOS AIRES

3

4

Resumen

Actualmente no existe un ambiente que integre y complemente las funciones de

clasificación de instancias, extracción o inducción de reglas de decisión y ponderación

de estas reglas, para lograr una profunda y completa investigación de las características

de las poblaciones que se desean estudiar. Esta falencia hace que cada vez que se quiera,

por ejemplo, extraer las reglas de producción que dan como consecuencia la

clasificación de una población, se necesite primero clasificar a los individuos de una

población en un ambiente de clasificación, para luego ingresar a estos individuos

clasificados en un ambiente diferente, capaz de inducir y extraer las reglas. Aquí se

propone desarrollar un ambiente capaz de integrar las tres funciones, para que se

complementen unas con otras.

Palabras clave: Data mining, ambiente integrado, clasificación de instancias, reglas de

decisión, ponderación de reglas.

Abstract

Actually there not exists a ambient capable to integrate the mechanisms of

classification of instances, selection and weighting of rules, and that uses each one of

these mechanisms as a complement one of the other, to obtain a complete investigation

of the characteristics of the populations that are desired to study. This does that

whenever it is wanted, for example, to extract the rules that give the classification of a

population, it is needed first to classify the individuals of the population in a

classification ambient, and then to enter these classified individuals in a different

ambient, able to induce and to extract the rules. Here we propose to develop a tool able

to integrate these three mechanisms, to let then complement one with each other.

Key words: Data mining, integrated ambient, clasification of instances, decision rules,

weighting of rules.

5

ÍNDICE

1. INTRODUCCIÓN ______________________________________________ 9

2. ESTADO DEL ARTE __________________________________________ 11

2.1. Ambientes de minería de datos actuales _____________________________________________ 11

2.2. Redes neuronales competitivas en la clasificación de instancias__________________________ 13

2.2.1. Introducción _________________________________________________________________ 13

2.2.2. Redes SOM (Self Organizing Maps) ______________________________________________ 14

2.3. Árboles de decisión e inducción de reglas ____________________________________________

2.3.1. Inducción de árboles de decisión._________________________________________________

2.3.2. La familia TDIDT de sistemas de aprendizaje_______________________________________

2.3.3. Árboles de decisión____________________________________________________________

2.3.4. La tarea de inducir ____________________________________________________________

2.3.5. Tamaño correcto del árbol de decisión. Poda _______________________________________

2.3.6. ID3_________________________________________________________________________

2.3.7. Incorporando valores continuos __________________________________________________

22

22

23

25

27

30

31

40

2.4. Redes Bayesianas y ponderación de reglas ___________________________________________

2.4.1. Teorema de Bayes_____________________________________________________________

2.4.2. Introducción a redes Bayesianas _________________________________________________

2.4.3. Estimación de la estructura de la red Bayesiana _____________________________________

2.4.4. Clasificadores basados en redes Bayesianas ________________________________________

41

41

44

46

48

3. DESCRIPCIÓN DEL PROBLEMA ________________________________ 55

3.1. Generalidades ___________________________________________________________________ 55

3.2. El problema a resolver ____________________________________________________________ 55

4. SOLUCIÓN PROPUESTA ______________________________________ 59

4.1. El ambiente integrado ____________________________________________________________ 59

4.2. Representación de los datos de entrada ______________________________________________ 64

4.2.1. El Standard XML _____________________________________________________________ 65

4.3. Características necesarias de los datos de entrada _____________________________________ 72

5. DISEÑO DEL AMBIENTE. LA METODOLOGÍA UML ________________ 75

5.1. Generalidades ___________________________________________________________________ 75

5.2. Casos de Uso ____________________________________________________________________

5.2.1. Población____________________________________________________________________

5.2.2. Clasificador __________________________________________________________________

5.2.3. Selector _____________________________________________________________________

5.2.4. Ponderador __________________________________________________________________

5.2.5. El menú _____________________________________________________________________

75

76

78

80

82

85

7

5.3. Transición de estados en el ambiente ________________________________________________ 88

5.4. La interfase grafica_______________________________________________________________

5.4.1. Población____________________________________________________________________

5.4.2. Clasificador __________________________________________________________________

5.4.3. Selector _____________________________________________________________________

5.4.4. Ponderador __________________________________________________________________

90

90

91

92

94

5.5. Casos de Prueba _________________________________________________________________ 96

5.5.1. Población____________________________________________________________________ 96

5.5.2. Clasificador __________________________________________________________________ 98

5.5.3. Selector ____________________________________________________________________ 100

5.5.4. Ponderador _________________________________________________________________ 103

5.5.5. El menú ____________________________________________________________________ 105

6. COMPARACIÓN EXPERIMENTAL CON OTROS AMBIENTES _______ 109

6.1. Introducción ___________________________________________________________________ 109

6.2. Clasificador de instancias ________________________________________________________ 110

6.3. Inducción de reglas ______________________________________________________________ 111

6.4. Ponderación de reglas ___________________________________________________________ 116

7. CONCLUSIONES ____________________________________________ 119

BIBLIOGRAFÍA _______________________________________________ 121

8

1. Introducción

Actualmente no existe un ambiente capaz de integrar y complementar las

funciones de clasificación de instancias, inducción o selección de reglas de decisión y

ponderación de estas reglas, para lograr una profunda y completa investigación de las

características de las poblaciones que se desean estudiar. Esta falencia hace que cada

vez que se quiera, por ejemplo, extraer las reglas de producción que dan como

consecuencia la clasificación de una población, se necesite primero clasificar a los

individuos de una población en un ambiente de clasificación, para luego ingresar a estos

individuos clasificados en un ambiente diferente, capaz de inducir y extraer las reglas.

La misma necesidad haría falta si se quieren ponderar luego esas reglas obtenidas.

Aquí se propone desarrollar un ambiente capaz de integrar las tres funciones, y

hacer además que estas funciones logren complementarse.

Esta tesis se encuentra estructurada a lo largo de 7 capítulos.

El capítulo 2 describe el estado actual de los campos de estudio relacionados con

esta tesis. En la sección 2.1 se presenta un listado de las herramientas actuales más

conocidas o utilizadas en el mercado para el estudio de poblaciones con sus

características, la sección 2.2 presenta los conceptos y teorías importantes relativas a las

redes competitivas en general y a las SOM en particular, utilizadas para la clasificación

de individuos. A lo largo de la sección 2.3 se presentan los árboles de decisión, dándole

una especial atención a los ID3. En la sección 2.4 se presentan las redes Bayesianas, y

junto con ellas se da una introducción a la utilización de estas redes como

clasificadoras, describiéndose las características de las redes Naive Bayes y TAN.

En el capítulo 3 se presenta el contexto de nuestro problema de interés.

En el capítulo 4 se presentan todos los aspectos relativos de la solución

propuesta. En la sección 4.1 se describen las características y el flujo de procesos que

conformarán el ambiente integrado propuesto como solución. En la sección 4.2 se

9

describe el estándar XML, utilizado para la representación de los datos de entrada que

serán analizados por el ambiente y ya en la sección 4.3 se describen y especifican las

características que deben cumplir (dentro del estándar XML) los datos de entrada que

serán analizados.

En el capitulo 5 se desarrolla la metodología de diseño y desarrollo de sistemas

denominada UML aplicada al diseño y desarrollo del ambiente a implementar.

Primeramente, en la sección 5.1, se hace una reseña del lenguaje utilizado, ambientes de

desarrollo y demás características del software utilizado para la construcción y

compilado del software. En la sección 5.2 se presentan los casos de uso. Luego, en la

sección 5.3 se presenta la transición de estados en el ambiente, y en la sección 5.4 se

presenta el diseño de las distintas pantallas desarrolladas. A continuación, en la sección

5.5, se describen las pruebas que se realizaron sobre los casos de uso, para evaluar la

efectividad de la solución propuesta.

En el capitulo 6 se realiza una comparación entre los resultados experimentales

obtenidos con el ambiente desarrollado y otros ambientes existentes, respecto a cada

una de las funciones que el ambiente desarrollado provee.

Y por último, en el capitulo 7, se describen las conclusiones obtenidas.

10

2. Estado del arte

Este capítulo presenta el estado actual de los aspectos relacionados con el

estudio de esta tesis. Se comienza dando una reseña respecto a los diferentes ambientes

de minería de datos actualmente disponibles en el mercado (Sección 2.1). Luego, se

presenta el estado actual de las redes competitivas, y en especial a las redes

denominadas mapas autoorganizados, utilizadas como redes clasificadoras de datos

(Sección 2.2).

Se comienza dando una introducción de lo que son las redes

competitivas (Sección 2.2.1) en general, para después detallar a las redes SOM en

particular (Sección 2.2.2). A continuación se presentan los árboles de decisión,

utilizados como solución a la inducción de reglas (Sección 2.3). Primero se explica el

concepto de inducción mediante árboles de decisión (Sección 2.3.1). Después se

presenta a la familia TDDI de árboles de decisión (Sección 2.3.2). Luego se detallan

puntualmente los árboles de decisión (Sección 2.3.3) para después explicar a que se

refiere la tarea de inducir dentro de los árboles (Sección 2.3.4), continuar explicando lo

que es la poda en árboles de decisión (Sección 2.3.5) y finalizar dando una reseña,

dentro de la familia TDDI, al algoritmo ID3 (Sección 2.3.6). Se describe luego un

método probabilístico para lograr la ponderación de las reglas inducidas, como son las

redes Bayesianas (Sección 2.4), presentado también diferentes algoritmos de redes

Bayesianas utilizadas como clasificadoras de datos (Sección 2.4.3), detallando

puntualmente las Naive Bayes y las TAN.

2.1. Ambientes de minería de datos actuales

Existen numerosos ambientes utilizados en forma exitosa tanto para clasificar a

una población de individuos, para inducir reglas inherentes a las características de una

población o para ponderar reglas. Sistemas que utilizan a las redes neuronales son un

ejemplo de eso, ya que dependiendo de la arquitectura de redes que utilicen, se

comportan muy bien como clasificadores de elementos de un dominio; los sistemas que

implementan árboles de decisión tales como ID3 [Quinlan, 1986] o C4.5 [Quinlan,

1993], por otro lado, son también muy comunes en lo que se refiere a la extracción de

11

reglas de dominios; y también están aquellos sistemas que utilizan a las redes

Bayesianas como modelos de ponderación de reglas.

A continuación se detallan varios

ambientes actualmente disponibles en el

mercado, junto con una pequeña reseña de las funciones que proveen y de las técnicas

utilizadas para brindar esas características.

AMBIENTE DESCRIPCION

AC2

AC2 es un ambiente de data mining diseñado para usuarios conocedores

de la materia. AC2 tiene un modelado grafico orientado a objetos y

librerías en C y C++. Soporta la edición interactiva del árbol que se

genera. Se comporta como una librería multiplataforma de funciones de

data mining. Provee como funciones: clusterización, clasificación,

predicción, segmentación. Utiliza como técnica árboles de decisión

[AC2].

AnswerTree

AnswerTree es un ambiente de SPSS utilizado para construir árboles de

decisión. Como ambiente de data mining apunta perfilar a grupos para

la comercialización y las ventas. Utiliza cuatro algoritmos de árboles de

decisión. Incluidos están dos algoritmos CHAID, los cuales SPSS ha

extendido para manejar categorización nominal, ordinal y variables

continuas dependientes. Provee como funciones: Clasificación. Utiliza

como técnicas: Árboles de decisión (CHAID, CHAID Exhaustivo,

C&RT (variación de CART), QUEST). [AnswerTree]

CART

CART es un ambiente de árbol de decisión que utiliza el algoritmo

CART. Para poder manejar la falta de información, los datos son

manejados a través de reglas de backup que no siempre asumen que

todos los datos de un atributo incierto es el mismo. Se utilizan siete

criterios diferentes de splitting (incluyendo el Gini). Debido al uso del

motor de traducción de datos, DBMS/Copy, se pueden utilizar datos de

diferentes tipos de formato (incluyendo Excel, Informix, Lotus, Oracle).

Provee como funciones: Clasificación. Utiliza como técnicas: Árboles

de decisión (CART). [CART], [Breiman L, 1984].

Clementine utiliza iconos descriptivos como interfaz, el usuario crea

descripciones de flujos de datos de las funciones que se realizarán. Cada

icono representa un paso en el proceso total de minería de datos.

Existen incluidos iconos para funciones tales como el acceso a datos,

preparación de datos, visualización y modelado. Para asistir a la

creación de secuencias, Clementine utiliza Capri. Además puede utilizar

grandes conjuntos de datos usando un modelo de cliente/ servidor.

Cuando es posible, el servidor convierte peticiones del acceso a los

datos en las consultas SQL, que pueden entonces tener acceso a una

base de datos emparentada. Provee como funciones: Reglas de

asociación, clasificación, clusterización, análisis de factor, pronostico,

predicción. Utiliza como técnicas: Apriori, BIRCH, CARMA, árboles

Clementine

12

AMBIENTE DESCRIPCION

de decisión (C5.0, C&RT variación de CART), clusterización K-means,

redes neuronales (Kohonen, MLP, RBFN), regresión (lineal, logística)

inducción de reglas (C5.0, GRI). [Clementine]

Elvira

El programa Elvira está destinado a la edición y evaluación de modelos

gráficos probabilistas, concretamente redes Bayesianas y diagramas de

influencia. Elvira cuenta con un formato propio para la codificación de

los modelos, un lector-intérprete para los modelos codificados, una

interfaz gráfica para la construcción de redes, con opciones específicas

para modelos canónicos (puertas OR, AND, MAX, etc.), algoritmos

exactos y aproximados (estocásticos) de razonamiento tanto para

variables discretas como continuas, métodos de explicación del

razonamiento, algoritmos de toma de decisiones, aprendizaje de

modelos a partir de bases de datos, fusión de redes, etc. [Elvira]

Sipina

Sipina está diseñado especialmente para la inducción de árboles de

decisión. Sipina es un software con el cual se puede extraer

conocimiento de los datos. Sipina aprende tanto de datos cualitativos

como cuantitativos, y produce un grafico enrejado. Los algoritmos que

provee Sipina para la generación de árbol de decisión son: SIPINA,

ID3, C4.5, CART, Chi2-link, Elisee, QR_MDL y WDTaiqm. [Sipina]

Weka

Weka contiene y se focaliza en algoritmos de clasificación, regresión, y

clusterización de patrones. Weka es un software gratuito y open-source

bajo la licencia al público en general del GNU (GLP). Las técnicas que

utiliza son: Naïve Bayes, Nearest neighbor, Linear models, OneR,

Decision trees, Covering rules, K-means, EM, Cobweb. [Weka]

2.2. Redes neuronales competitivas en la clasificación de instancias

2.2.1. Introducción

En las redes neuronales con aprendizaje competitivo y cooperativo, las neuronas

compiten y cooperan unas con otras con el fin de llevar a cabo una tarea dada. Con este

tipo de aprendizaje se pretende que cuando se presente a la red cierta información de

entrada, solo una de las neuronas de salida de la red se active o alcance su valor de

respuesta máximo. Es por eso que las neuronas compiten para activarse, quedando

finalmente una como neurona ganadora, mientras que el resto quedan anuladas. Como

se mencionó anteriormente, el objetivo de este aprendizaje es clusterizar los datos que

se introducen en la red. Debido a esto, los individuos con características similares son

clasificados formando parte de la misma categoría y por lo tanto deben activar la misma

13

neurona de salida. Un punto que vale la pena destacar es el hecho de que en este tipo de

redes las clases o categorías que la red clasificará deberán ser creadas por la propia red,

puesto que se trata de un aprendizaje no supervisado a través de las correlaciones entre

los datos de entrada. Las clases o categorías en las que se va a dividir el conjunto de

entrada están directamente relacionadas con la estructura que tenga la red competitiva,

ya que la cantidad de nodos que tenga la red dará lugar a la cantidad máxima de clases

en las que ésta podrá clusterizar a las entradas.

2.2.2. Redes SOM (Self Organizing Maps)

Una de las implementaciones que más se destacan en este tipo de redes son los

mapas autoorganizados (SOM., Self Organizing Maps). Esta implementación permite a

la red clasificar entradas en las cuales las neuronas que estuviesen en un vecindario

cercano a la neurona ganadora, respondieran a entradas similares.

Los mapas autoorganizados están compuestos por un conjunto de nodos

definidos por un vector de pesos, y una topología que indica la vecindad de los nodos

entre sí. Todos los nodos reciben el mismo vector de entradas, y su salida es la distancia

euclídea entre el vector de entradas y el de pesos. De todos los nodos que forman el

mapa, solo uno será el responsable de generar la salida, y será aquel cuyo vector de

pesos sea el más parecido a la entrada actual. Esta red utiliza un aprendizaje no

supervisado de tipo competitivo.

En cuanto a la topología de vecindad entre los nodos, esta puede ser muy

variada:

14

-

lineal,

-

lineal en forma de anillo,

-

plana con retículo rectangular,

-

plana con retículo hexagonal,

-

toroidal

En la Figura 1 se muestran algunos ejemplos de vecindad en los mapas

autoorganizados. Es posible también tener mapas autoorganizados con topologías de

dimensiones más altas, pero la utilización, y sobre todo la representación de los

resultados en dimensiones superiores a dos resulta más incómoda, o impracticable.

Figura 1. Ejemplos de vecindad en los mapas autoorganizado

El aspecto geométrico de la disposición de las neuronas de una red en los mapas

autoorganizados o SOM es la base de un caso particular de aprendizaje competitivo

introducido por Kohonen en 1982 [Kohonen, 1982], el cual es aplicado a una

disposición bidimensional de las neuronas de salida, que permiten obtener mapas

topológicos o topográficos en los que de algún modo estarían representadas las

características principales de las informaciones presentadas a la red. La idea es que si la

red recibe informaciones con características similares, se generarán mapas parecidos,

debido a que serían afectadas neuronas de salidas próximas entre sí, y no solo la

neurona supuestamente ganadora.

15

El modelo presentado por Kohonen se trataba de un modelo de red neuronal con

capacidad para formar mapas de características de manera similar a como ocurre en el

cerebro; el objetivo de Kohonen era demostrar que un estímulo externo o información

de entrada por sí solo, suponiendo una estructura propia y una descripción del

comportamiento de la red, era suficiente para forzar la formación de los mapas. En la

etapa de aprendizaje de este tipo de redes, se distinguen dos etapas: una etapa de

entrenamiento y una etapa de funcionamiento.

En la etapa de entrenamiento se fijan los valores de las conexiones

(feedfordward) entre la capa de entrada y la de salida. Esta red utiliza un aprendizaje no

supervisado de tipo competitivo, las neuronas de la capa de salida compiten por

activarse y sólo una de ellas permanece activa ante una determinada información de

entrada a la red, los pesos de las conexiones se ajustan en función de la neurona que

haya resultado vencedora.

Durante la etapa de entrenamiento, se le presenta a la red un conjunto de

información de entrada para que ésta establezca en función de la semejanza entre los

datos las diferentes categorías, las cuales serán una por neurona de salida, que servirán

durante la etapa de funcionamiento para realizar clasificaciones de nuevos datos que se

le presenten a la red. En el caso de existir más patrones de entrenamiento que neuronas

de salida, es lógico pensar que más de un patrón deberá asociarse con la misma neurona,

o sea pertenecerán a la misma clase.

En este modelo el aprendizaje no concluye después de presentarle una vez todos

los patrones de entrada, sino que habrá que repetir el proceso varias veces para refinar el

mapa topológico de salida, de tal forma que cuantas más veces se presenten los datos,

tanto más se reducirán las zonas de neuronas que se deben activar ante entradas

parecidas, consiguiendo que la red pueda realizar una clasificación más selectiva.

Como se mencionó anteriormente, un concepto muy importante en la red de

Kohonen es la zona de vecindad, o vecindario alrededor de la neurona vencedora i*. Los

pesos de las neuronas que se encuentran en esta zona, a la que se le dará el nombre de

16

X(q), serán actualizados junto con el peso de la neurona ganadora, en un claro ejemplo

de aprendizaje cooperativo.

El algoritmo de aprendizaje utilizado para establecer los valores de los pesos de

las conexiones entre las N neuronas de entrada y las M de salida es el siguiente:

1. En primer lugar se inicializan los pesos wij con valores aleatorios pequeños y

se fija la zona de vecindad entre las neuronas de salida.

2. A continuación se presenta a la red una información de entrada, la cual

deberá aprender, en forma de vector p=(p1,p2,…,pn), cuyas componentes pi

serán valores continuos.

3. Puesto que se trata de un aprendizaje competitivo, se determina la neurona

vencedora de la capa de salida. Ésta será aquella cuyo vector de pesos wi

será el más parecido a la información de entrada p. Para ello se calculan las

distancias o diferencias entre ambos vectores, considerando una por una

todas las neuronas de salida. Suele utilizarse la distancia euclídea o la

siguiente expresión, muy similar:

di = ∑ (pj - wij)2 1 <= i <= M

4. Una vez localizada la neurona ganadora i*, se actualizan los pesos de las

conexiones entre las neuronas de entrada y dicha neurona, así como los de

las conexiones entre las de las entradas y las neuronas vecinas de la

vencedora. En realidad lo que se consigue con este mecanismo es asociar la

información de entrada con una cierta zona de la capa de salida. Esto se

realiza mediante la siguiente ecuación:

w(q) = w(q-1) + a(q)(p(q)-w(q-1)) para i ε X(q)

El tamaño de X(q) se puede reducir en cada iteración del proceso de ajuste

de los pesos, con lo que el conjunto de neuronas que pueden considerarse

vecinas cada vez será menor como se observa en la Figura 2. Sin embargo,

17

en la práctica es habitual considerar una zona fija en todo el proceso de

entrenamiento de la red.

Figura 2. Posible evolución de la vecindad en una red de Kohonen

El termino a(q) es el coeficiente de aprendizaje o parámetro de ganancia, con

un valor entre 0 y 1 y el cual decrece con el numero de iteración q del

proceso de entrenamiento, de tal forma que cuando se ha presentado un gran

numero de veces todo el juego de patrones de aprendizaje, su valor es

prácticamente nulo, con lo que la modificación de los pesos es insignificante.

La forma de la función a(q) si la suponemos continua durante toda la

interacción es como la mostrada en la Figura 3, que proporciona un ajuste

positivo o refuerzo en las proximidades del nodo ganador, que va

decreciendo hasta volverse negativo o inhibidor según se va alejando, para

volver a crecer hasta hacerse cero en los nodos más lejanos.

Figura 3. La función sombrero mejicano para la

interacción lateral en un mapa autoorganizado.

18

5. El proceso deberá repetirse, volviendo a presentar todo el juego de patrones

de aprendizaje p1, p2,…,pn hasta obtener la salida deseada.

En forma simplificada, en la Figura 4 puede observarse las conexiones de una

red de Kohonen.

A modo de ejemplo, y para demostrar como trabaja una red competitiva, se

creará una red que clasifique los siguientes vectores:

p1=(-0.216, 0.993), p2=(0.216, 0.993), p3=(0.993, 0.216),

p4=(0.993, -0.216), p5=(-0.622, -0.873), p6=(-0.873, -0.622)

Supondremos que la red tendrá tres neuronas, por lo tanto los vectores de

entrada serán clasificados en tres clases o grupos. Esta es una de las principales

características de las redes competitivas, ellas pueden agrupar los patrones de entrada en

clases que no se conocen. Los pesos normalizados escogidos aleatoriamente son:

w1=(0.7071, -0.7071), w2=(0.7071, 0.7071), w3=(-1.000, 0.000). W = (w1, w2, w3).

Figura 4. Conexiones de una red de Kohonen

19

Los vectores de datos y los pesos asignados pueden visualizarse en la Figura 5.

Se presenta a la red el vector p2. El vector de la segunda neurona w2 estaba más

cercano a p2, por lo tanto ganó la competición (i*=2) y su salida es 1. Ahora se aplicara

la regla de Kohonen a la neurona ganadora con una rata de aprendizaje de α=0,5.

w2 nuevo = w2 + α (p2 – w2), lo que hace w2 nuevo = (0.9527, 0.5641).

La regla de Kohonen hace que w2 tienda a p2 como puede verse en la Figura 5b,

si continuamos escogiendo vectores de entrada aleatoriamente y presentándoselos a la

red, en cada interacción el vector de pesos se acercará más al vector de entrada.

Cada vector de pesos apuntará hacia una clase diferente del vector de entrada,

convirtiéndose en un prototipo para esa clase. Cuando termine el proceso de

entrenamiento, los pesos finales se verá como aparece en la Figura 5c.

Figura 5. a) Vectores de entrada y vector de pesos. b) Proceso

de entrenamiento. c) Pesos finales

20

Las redes competitivas son bastante eficientes para resolver problemas de

clasificación, sin embargo presentan algunos problemas. El primero de los problemas es

la elección de una rata de aprendizaje que permita hallar un punto de equilibrio entre

velocidad de convergencia y la estabilidad final de los vectores de peso. Una rata de

aprendizaje cercana a cero, torna el aprendizaje muy lento pero garantiza que cuando un

vector haya alcanzado el centro de la clase objetivo, se mantendrá allí indefinidamente.

En contraste, una rata de aprendizaje cercana a uno genera un aprendizaje rápido, pero

los vectores de peso continuarán oscilando aun después de que se haya alcanzado

convergencia. La indecisión que se presenta al escoger la rata de aprendizaje puede ser

empleada como una ventaja si se inicia el entrenamiento con una rata de aprendizaje alta

y se decrementa en el transcurso del proceso de entrenamiento cuando sea necesario.

Desafortunadamente esta técnica no funciona si la red necesita continuamente ser

adaptada a nuevos argumentos de los vectores de entrada, por ejemplo en el caso de que

la red se trabaje On-Line.

Un problema de estabilidad más serio se presenta cuando las clases están muy

juntas; en ciertos casos, un vector de pesos tratando de apuntar hacia una clase

determinada, puede entrar al territorio de otro vector de pesos. En la Figura 6 pueden

observarse con círculos azules, como dos vectores de entrada son presentados repetidas

veces a la red; el resultado es que los vectores de pesos que representan las clases de la

mitad y de la derecha se encuentran a la derecha. Con seguridad, se presentará el caso

en que una de las clases de la derecha será clasificada por el vector de pesos del centro.

Figura 6. Aprendizaje Inestable

Un tercer problema con redes competitivas, es que es posible que el vector de

pesos inicial de una neurona se encuentre muy lejos de cualquiera de los vectores de

21

entrada y por lo tanto nunca gane la competición. La consecuencia será la muerte de la

neurona, lo que por supuesto no es recomendable. En la Figura 7 el vector de pesos w3

nunca ganará la competición, sin importar cuál sea el orden en que se presenten los

vectores de entrada. Una solución a este problema consiste en adicionar una ganancia

negativa a la entrada neta de cada neurona y decrementar así la ganancia total cada vez

que la neurona gane la competición; esto hará que difícilmente una neurona gane varias

veces la competición. A este mecanismo se lo llama conciencia.

Otro problema con el que nos enfrentamos en las redes competitivas, es el hecho

de que una capa competitiva tiene tantas clases como neuronas, lo que podría complicar

algunas implementaciones, ya que el número de clases no se conoce de antemano. En

capas competitivas, cada clase consiste de una región convexa del espacio de entrada,

las capas competitivas no pueden formar clases con regiones no convexas o clases que

sean la unión de regiones no conectadas.

Figura 7. Causa de la muerte de una neurona

2.3. Árboles de decisión e inducción de reglas

2.3.1. Inducción de árboles de decisión.

La investigación sobre el aprendizaje está constituida en diferentes campos. Por

un lado están los sistemas adaptativos que monitorean su propia performance y tienden

a mejorar esa performance ajustando parámetros internos. Esta aproximación,

22

característica de una gran cantidad de los primeros trabajos sobre aprendizaje, produce

sistemas que auto mejoran. Una aproximación diferente ve al aprendizaje como a la

adquisición de conocimiento estructurado en la forma de conceptos.

La importancia práctica del aprendizaje automático en esta última aproximación

ha sido subrayada con la llegada de los sistemas expertos basados en conocimiento.

Como su nombre sugiere, estos sistemas están fundados por conocimiento representado

en forma explícita más que de forma implícita en los algoritmos. El conocimiento

necesario para conducir a los sistemas expertos pioneros estaba codificado a través de

una larga interacción entre un experto en el dominio y el ingeniero en conocimiento.

Mientras el ritmo típico de adquisición de conocimientos por este método es de algunas

reglas por día, un sistema experto para una tarea compleja puede necesitar cientos e

incluso miles de esas reglas. El tiempo necesario para esto resulta muy excesivo.

Feigenbaum [Feigenbaum, 1981] llamó a este problema como “cuello de botella”. Esta

percepción estimuló investigaciones sobre métodos de aprendizaje para explicar el

conocimiento.

2.3.2. La familia TDIDT de sistemas de aprendizaje

Carbonell, Michalski y Mitchell [Carbonell, Michalski y Mitchell 1983]

identifican tres dimensiones principales en las que el aprendizaje automático puede ser

clasificado:

•

las técnicas subyacentes de aprendizaje

•

la representación del conocimiento adquirido por el sistema

•

el dominio de aplicación del sistema

El dominio de aplicación de estos sistemas no se limita a ningún área en

particular, sino que pueden ser aplicados a cualquier área. Y aunque sean sistemas de

propósito general, las aplicaciones a las que son dirigidos conllevan consigo la

clasificación. El resultado del aprendizaje es un procedimiento que puede asignar un

23

objeto desconocido a una de las distintas clases específicas. Ejemplos de clasificación

son:

•

el diagnostico de una condición medica a partir de síntomas, en donde las

diferentes clases específicas pueden ser o bien distintas enfermedades o

posibles terapias.

•

determinar el valor teórico de una determinada posición de ajedrez, cuyas

clases pueden ser blancas ganan, negras gana o tablas.

Puede parecer que la tarea de clasificación es solo una pequeña parte de los

procedimientos, pero hasta actividades de planificación interna de robots pueden ser

reclasificadas como tareas de clasificación.

Los miembros de esta familia están fuertemente caracterizados por representar

el conocimiento adquirido como árboles de decisión. Esto es un formalismo

relativamente simple que carece del poder expresivo de las redes semánticas o de otras

representaciones de primer orden. Como consecuencia de esta simplicidad, las

metodologías usadas en la familia TDIDT son considerablemente menos complejas que

las empleadas por los sistemas que pueden expresar los resultados de su aprendizaje en

un lenguaje más poderoso. Sin embargo, sigue siendo posible generar conocimiento con

la forma de árboles de decisión que es capaz de resolver problemas difíciles de

significado práctico.

La técnica subyacente del aprendizaje es del tipo no incremental a partir de

ejemplos. A los sistemas se les presenta un conjunto de casos relevantes para la tarea de

clasificación y deben desarrollar un árbol de decisión descendente (top-down),

guiándose por la frecuencia de información en los ejemplos pero no por el orden

particular en que esos ejemplos son presentados. Esto contrasta con los métodos

incrementales donde un dialogo es llevado a cabo con un instructor para depurar

conceptos parcialmente correctos o en aquellos métodos donde los ejemplos son

analizados uno a uno, cada uno de ellos produciendo un pequeño cambio en el

desarrollo del concepto; en esos métodos, el orden en el que los ejemplos son

24

presentados es muy importante. Los sistemas descriptos aquí buscan patrones dentro de

los ejemplos presentados, por lo que deben ser capaces de examinar y re-examinar todos

los ejemplos en sus diversas etapas durante el aprendizaje.

En resumen, los sistemas descritos aquí desarrollan árboles de decisión para

tareas de clasificación. Estos árboles están construidos empezando por la raíz del árbol y

descendiendo hacia las hojas. La familia destaca que sus miembros desarrollan

Inducción descendente de los árboles de decisión (Top Down Induccion of Decision

Trees).

2.3.3. Árboles de decisión

Los árboles de decisión son una forma estructurada y secuencial de representar

reglas subyacentes en los datos. Un árbol de decisión puede ser utilizado para la

exploración de datos en una o más de las siguientes formas:

•

Descripción: para reducir el volumen de datos transformándolos en una

forma más compacta la cual preserva las características esenciales y provee

un resumen exacto.

•

Clasificación: descubriendo si los datos contienen clases de objetos bien

diferenciadas, de tal forma que dichas clases puedan ser interpretadas

significativamente en el contexto.

•

Generalización: descubriendo un mapeo de variables independientes a

dependientes que es valioso para predecir el valor de la variable dependiente

en un futuro.

Las ventajas más significativas de los árboles de decisión son respecto a otros

mecanismos son:

25

•

La adquisición del conocimiento a través de ejemplos preclasificados evita

los cuellos de botella de la adquisición de conocimientos mediante un

experto.

•

Los métodos son exploratorios en lugar de inferenciales. También son no

paramétricos. Debido a que solo unas pocas asunciones son hechas en

relación al modelo y a la distribución de los datos, los árboles de decisión

pueden modelar a un gran rango de distribuciones de datos.

•

La descomposición jerárquica implica el mejor uso de las características

disponibles y una eficacia computacional en la clasificación.

•

Los árboles de decisión pueden ser utilizados tanto en problemas

determinísticos como en problemas incompletos.

•

Los árboles de decisión desarrollan la clasificación en una secuencia de tests

simples y fáciles de entender, cuya semántica es claramente intuitiva para los

expertos en el dominio.

Un árbol de decisión es una representación grafica de un procedimiento para

clasificar y evaluar un ítem de interés. Por ejemplo, dados un conjunto de síntomas de

un paciente, un árbol de decisión podría determinar el posible diagnostico o el

tratamiento recomendado para curar dichos síntomas. La Figura 8 muestra un árbol de

decisión para pronosticar si un paciente va a morir o no de hepatitis. Un árbol de

decisión representa una función que mapea cada elemento de su dominio a un elemento

de su rango, la cual es típicamente una clase etiquetada o un valor numérico. En cada

hoja del árbol de decisión se puede encontrar un elemento del rango o clase etiquetada.

En cada nodo interno del árbol, se puede encontrar un test que tiene una pequeña

cantidad de salidas posibles. Eligiendo la ramificación correcta en cada nodo interno, se

llega a la hoja que contiene la clase o el valor numérico que corresponde al ítem

evaluado. En la figura, cada hoja muestra el número de ejemplos de cada clase.

26

Figura 8. Árbol de decisión

Un árbol de decisión con un rango discreto de clases es llamado árbol de

clasificación, mientras que un árbol de decisión con un rango de valores numéricos es

denominado árbol de regresión. Un elemento del dominio es denominado instancia o

ejemplo o caso, dependiendo del contexto. Una instancia es representada por un

conjunto de valores de atributos. Cada atributo tiene su propio dominio de posibles

valores, generalmente discretos o continuos. El espacio de todas las posibles instancias

se define por el conjunto de posibles instancias que se pueden generar utilizando los

atributos y sus posibles valores (producto cartesiano). Los árboles de decisión son

atractivos porque muestran claramente como llegar a una decisión, y porque son fáciles

de construir a partir de instancias o ejemplos. Tres programas conocidos para construir

árboles de decisión son ID3 [Quinlan, 1986], C4.5 [Quinlan, 1993] y CART [Breiman,

Friedman Losen y Stone, 1984].

2.3.4. La tarea de inducir

La base de la tarea de inducir comienza con un universo de objetos, los cuales

son descriptos por una colección de atributos. Cada atributo mide alguna característica

importante del objeto y será limitado a tomar algún valor discreto. Por ejemplo, si el

27

objeto fuera el día Domingo y la tarea clasificatoria envolviese al clima, algunos

atributos podrían ser

Tiempo, con valores (soleado, nublado, lluvioso)

Temperatura, con valores (frío, templado, calor)

Humedad, con valores (alta, normal)

Viento, con valores (Si, No)

Tomados juntos, los atributos proveen un lenguaje para caracterizar objetos

dentro del universo. Un Domingo en particular podría ser descrito como

Tiempo: nublado

Temperatura: caluroso

Humedad: normal

Viento: No

Cada objeto o instancia del universo pertenece a una de un conjunto de clases

mutuamente excluyentes. Para simplificar el posterior tratamiento, asumiremos que solo

existen dos clases llamadas P y N.

El otro punto importante es el conjunto de datos de entrenamiento cuyas clases

son conocidas. La tarea de inducción es la de desarrollar una regla de clasificación que

pueda determinar la clase a la que pertenece cualquier objeto tomando como referencia

los valores de los atributos de dicho objeto. La pregunta inmediata es si los atributos

proveen o no suficiente información para realizar dicha tarea. En particular, si el

conjunto de datos de entrenamiento contiene dos objetos que tienen valores idénticos

para cada atributo y cada uno de ellos pertenece a una clase diferente, es claramente

imposible diferenciar entre esos dos objetos solo por los atributos dados. En este caso

los atributos serán inadecuados para el conjunto de elementos y por ende para la tarea

de inducir.

28

Las reglas de clasificación serán expresadas como un árbol de decisión. La Tabla

1 muestra un pequeño conjunto de entrenamiento que utiliza los atributos del objeto

Domingo. Se muestra además la clase a la que pertenece cada objeto o instancia. Un

árbol de decisión que correctamente clasifica a cada objeto del conjunto se muestra en la

Figura 9.

Nro

1

2

3

4

5

6

7

8

9

10

11

12

13

14

Temperatura

calor

calor

calor

templado

Frío

Frío

Frío

templado

Frío

templado

templado

templado

Calor

templado

Atributos

Humedad

alta

alta

alta

alta

normal

normal

normal

alta

normal

normal

normal

alta

normal

alta

Clase

Viento

No

Si

No

No

No

Si

Si

No

No

No

Si

Si

No

Si

Tiempo

soleado

soleado

nublado

lluvioso

lluvioso

lluvioso

nublado

soleado

soleado

lluvioso

soleado

nublado

nublado

lluvioso

N

N

P

P

P

N

P

N

P

P

P

P

P

N

Tabla 1. Un pequeño conjunto de entrenamiento.

Si los atributos son adecuados, siempre es posible construir un árbol de decisión

que correctamente clasifique a cada objeto del conjunto de datos de entrenamiento, y

generalmente hay más de un árbol correcto. La esencia de la inducción es la de moverse

dentro del conjunto de datos de entrenamiento para construir un árbol de decisión que

no solo clasifique a los objetos del conjunto de datos de entrenamiento sino también

otros objetos de la misma manera. Para poder realizar esto, el árbol debe ser capaz de

capturar relaciones significativas entre los objetos de una clase y los valores de sus

atributos. Teniendo la posibilidad de elegir entre dos árboles de decisión, donde cada

uno clasifique correctamente los elementos de entrenamiento, pareciera correcto decir

que el que se preferiría sería el árbol más simple, ya que es más seguro que dicho árbol

capture la estructura inherente al problema. Se espera que el árbol más simple clasifique

correctamente a más objetos fuera del conjunto de datos de entrenamiento, mientras que

29

del árbol más grande puede esperarse que sea más una explicación de dicho conjunto de

datos de entrenamiento.

Figura 9. Un árbol de decisión simple.

2.3.5. Tamaño correcto del árbol de decisión. Poda

Una de las mayores dificultades de inducir una estructura recursivamente es

saber cuando parar.

Muchas técnicas se han sugerido para obtener el tamaño correcto de un árbol de

decisión. La más popular de estas técnicas es la llamada Poda.

La poda fue propuesta en [Breiman, 1984]. El procedimiento que se sugirió fue

el siguiente: construir el árbol completo y luego eliminar aquellos subárboles que no

contribuyen significativamente a la generalización.

30

La poda de un árbol de decisión se realiza reemplazando un subárbol entero por

un nodo hoja. El reemplazo se lleva a cabo si una regla de decisión establece que el

error esperado en el subárbol es mayor que en la hoja. Por ejemplo, si se obtiene el árbol

de decisión de la Figura 10 con un caso de entrenamiento Rojo Éxito y dos elementos de

entrenamiento Azul Fracaso, y luego en el conjunto de elementos de test encontramos

tres elementos Rojo Fracaso y uno Azul Éxito, podemos considerar reemplazar este

subárbol por un simple nodo Fracaso. Luego del reemplazo tendremos solo dos errores

en lugar de cuatro.

Figura 10. Ejemplo de poda

2.3.6. ID3

Una aproximación a la tarea de inducción podría ser la de generar todos los

posibles árboles de decisión que clasifiquen correctamente al conjunto de datos de

entrenamiento y seleccionar luego el más de simple de ellos. El número de esos árboles

es finito pero muy grande, es por eso que esta aproximación puede ser factible solo para

tareas pequeñas. El algoritmo ID3 fue diseñado justamente para espectros opuestos, o

sea donde el conjunto de entrenamiento contiene una gran cantidad de elementos con un

gran numero de atributos, pero donde un buen y razonable árbol de decisión es

requerido sin mucho esfuerzo computacional. Se ha demostrado que el algoritmo

construye árboles de decisión simples, pero la aproximación que utiliza no garantiza que

el árbol que construye sea el más óptimo.

La estructura básica de ID3 es iterativa. Un subconjunto del conjunto de

entrenamiento llamado ventana (window) es elegido al azar y se construye un árbol de

31

decisión a partir de esa ventana; este árbol de decisión clasifica correctamente a los

elementos de esta ventana. Todos los demás objetos del conjunto de datos de

entrenamiento son luego clasificados utilizando este árbol. Si el árbol correctamente

clasifica a esos objetos, entonces el proceso termina ya que el árbol es correcto para el

conjunto entero de datos de entrenamiento. Caso contrario, una selección de los objetos

incorrectamente clasificados es sumada a la ventana y el proceso continua.

Lo esencial del problema es como desarrollar un árbol de decisión a partir de una

colección de C objetos arbitrarios. Si C es vacío o contiene solo objetos de una clase, el

árbol de decisión más simple es solo una hoja etiquetada con dicha clase. De otro modo,

digamos que T sea cualquier test sobre un objeto con posibles salidas O1 , O2 ,..., Ow .

Cada objeto en C dará alguna de estas salidas para el test T, por lo que T produce una

partición {C1 , C 2 ,..., C w } de C con C i conteniendo aquellos objetos que tengan la salida

Oi . Esto se representa gráficamente por el árbol de la Figura 11. Si cada subconjunto

C i en esta figura pudiera ser reemplazado por un árbol de decisión para C i , el resultado

seria un árbol de decisión para todo C. Es más, mientras dos o más C i sean no vacíos,

cada C i es más pequeño que C. En el peor de los casos, esta estrategia de divide y

conquistarás dará como resultado subconjuntos de un solo objeto que satisface el

requerimiento de una sola clase para la hoja. Teniendo en cuenta que un test T que de

una partición no trivial de cualquier conjunto de objetos siempre se puede encontrar,

este procedimiento siempre producirá un árbol de decisión que correctamente clasifique

a cada objeto de C.

La elección del test T es crucial si lo que se quiere es que el árbol de decisión sea

simple. Por el momento, el test estará limitado a ramificarse en los valores de un

atributo, por lo que elegir el test se convierte en seleccionar un atributo para la raíz del

árbol. ID3 adopto un método que depende de dos asunciones. Si C contiene p objetos de

la clase P y n objetos de la clase N, las asunciones son:

1) Cualquier árbol de decisión correcto para C va a clasificar objetos en la

misma proporción que su representación en C. Un objeto arbitrario será

32

determinado a pertenecer a la clase P con probabilidad p/(p+n) y a la clase N

con probabilidad n/(p+n).

2) Cuando un árbol de decisión es utilizado para clasificar a un objeto, este

retorna una clase. Un árbol de decisión puede entonces ser considerado como

una fuente del mensaje P o N, con la esperada información necesaria para

generar este mensaje, dado por

l (n, p ) = −

p

p

n

n

log 2

−

log 2

p+n

p+n p+n

p+n

Figura 11. Un árbol estructurado de los objetos en C

Si el atributo A con valores { A1 , A2 ,..., Av } es utilizado para la raíz del árbol de

decisión, particionará a C en {C1 , C 2 ,..., C v } donde C i contiene aquellos objetos en C

que tienen el valor Ai para el atributo A. C i contiene pi objetos de la clase P y ni

objetos de la clase N. La información requerida esperada para el subárbol para C i es

l ( p i , ni ) . La información requerida esperada para el árbol can A como raíz es la

obtenida como el promedio de pesos

33

v

E ( A) = ∑

l =1

p i + ni

l ( p i , ni )

p+n

donde el peso para la i-esima ramificación es la proporción de objetos en C que

pertenecen a C i . La ganancia de información obtenida por haber ramificado en A es

gain(A )=l(p,n) – E(A)

Una buena regla será la de elegir aquel atributo para ramificar que tenga la

mayor ganancia de información. Debido a que l(n,p) es constante para todos los

atributos, maximizar la ganancia equivale a minimizar E(A). El algoritmo ID3 examina

todos los atributos candidatos y elige A para maximizar la ganancia gain(A), desarrolla

el árbol y luego utiliza el mismo proceso en forma recursiva hasta formar el árbol de

decisión para los subconjuntos restantes C1 , C 2 , …, C v .

Para ilustrar la idea, digamos que C es el conjunto de objetos en la Tabla 1. De

los 14 objetos, 9 pertenecen a la clase P y 5 a la clase N, por lo que la información

requerida para la clasificación es

l ( n, p ) = −

9

9

5

5

log 2 ( ) − log 2 ( ) = 0.940bits

14

14 14

14

Ahora consideremos al atributo Tiempo con sus valores [soleado, nublado,

lluvioso]. Cinco de los catorce objetos de C tienen su primer valor (soleado), dos de

ellos de la clase P y tres de ellos de la clase N, entonces

p1 = 2

n1 = 3 l ( p1 , n1 ) = 0.971

y en forma similar

34

p2 = 4

n2 = 0

l ( p 2 , n2 ) = 0

p3 = 3

n3 = 2

l ( p 3 , n3 ) = 0.971

La información esperada requerida después de testear este atributo es

E (Tiempo ) =

5

4

5

l ( p1 , n1 ) + l ( p 2 , n2 ) + l ( p 3 , n3 ) = 0.694bits

14

14

14

La ganancia de este atributo es entonces

gain(Tiempo)=0.940 – E(Tiempo) = 0.246 bits

Análisis similares dan

gain(Temperatura) = 0.029 bits

gain(Humedad) = 0.151 bits

gain(Viento) = 0.048 bits

ID3 puede concebirse como un proceso de búsqueda en un espacio de hipótesis,

para encontrar aquella hipótesis que se ajusta mejor a los datos de entrenamiento. El

espacio de hipótesis explorado por ID3 es el espacio de todos los árboles de decisión

posibles. El algoritmo lleva a cabo una búsqueda de lo simple a lo complejo,

comenzando por el árbol vacío, para considerar cada vez hipótesis más complejas. La

medida ganancia de información guía esta búsqueda de ascenso de colina (hillclimbing).

Considerando ID3 en términos de su espacio y estrategias de búsqueda, es

posible analizar sus capacidades y limitaciones:

•

El espacio de hipótesis de ID3 es completo con respecto a las funciones de

valores discretos que pueden definirse a partir de los atributos considerados.

De manera que no existe el riesgo que la función objetivo no se encuentre en

el espacio de hipótesis.

35

•

ID3 mantiene solo una hipótesis mientras explora el espacio de hipótesis

posibles. Esto contrasta, por ejemplo, con el algoritmo eliminación de

candidatos, que mantiene el conjunto de todas las hipótesis consistentes con

el conjunto de entrenamiento. Es por ello que ID3 es incapaz de determinar

cuantos árboles de decisión diferentes son consistentes con los datos.

•

El algoritmo básico ID3 no ejecuta vuelta atrás (backtracking) en su

búsqueda. Una vez que el algoritmo selecciona un atributo, nunca

reconsidera a esta elección. Por lo tanto, es susceptible a los mismos riesgos

que los algoritmos estilo ascenso de colina, por ejemplo, caer máximos o

mínimos locales. La vuelta atrás puede implementarse con alguna técnica de

poda.

•

ID3 utiliza todos los ejemplos de entrenamiento en cada paso de su búsqueda

guiada por el estadístico ganancia de información. Esto contrasta con los

métodos que usan los ejemplos incrementalmente, por ejemplo encuentra-S

o eliminación de candidatos. Una ventaja de usar propiedades estadísticas de

todos los ejemplos es que la búsqueda es menos sensible al ruido en los

datos.

Algunas consideraciones sobre la aplicación práctica del algoritmo básico de ID3,

incluyen mecanismos para:

•

determinar que tanto debe crecer el árbol en profundidad

•

procesar atributos con valores continuos;

•

procesar ejemplos de entrenamiento con valores faltantes;

•

introducir costos diferentes asociados a los atributos; así como para

determinar una buena métrica de selección de los atributos y mejorar la

eficiencia computacional del algoritmo.

36

Muchos de estos aspectos han sido incorporados en el sistema C4.5 [Quinlan,

1993].

El algoritmo básico de ID3 crece cada rama del árbol en profundidad hasta que

logra clasificar perfectamente los ejemplos de entrenamiento. Esta estrategia puede no

ser del todo satisfactoria si los datos de entrenamiento presentan ruido, o cuando el

conjunto de entrenamiento es demasiado pequeño, como para ofrecer un muestreo

significativo del concepto objetivo. En estos casos, ID3 puede producir árboles que se

sobre ajustan a los datos de entrenamiento.

Formalmente definimos el sobre ajuste como:

“Dado un espacio de hipótesis H, se dice que una hipótesis h ∈ H está sobre

ajustada a los ejemplos de entrenamiento, si existe una hipótesis alternativa

h'∈ H , tal que h’ tiene un error de clasificación más pequeño que h sobre la

distribución completa de los ejemplares del problema”.

Es común observar que a medida que el tamaño del árbol crece, en término de

número de nodos, su precisión sobre el conjunto de entrenamiento mejora.

¿Como es esto posible que un árbol h que tiene mayor precisión que h’ sobre el

conjunto de entrenamiento, luego tenga un desempeño menor sobre el conjunto de

prueba?

Una situación en la que esto ocurre es cuando el conjunto de entrenamiento

contiene ruido, por ejemplo, elementos mal clasificados. Considérese agregar el

siguiente ejemplo mal clasificado (clasificado como clase = N) al conjunto de

entrenamiento de la Tabla 1:

Tiempo = soleado, temperatura = calor, Humedad = Normal, Viento = Si

Al ejecutar ID3 sobre el nuevo conjunto de entrenamiento, este construirá un

árbol más complejo. En particular, el ejemplo con ruido seria filtrado junto con los

ejemplos Nro 9 y Nro 11 de la Tabla 1 (tiempo = Soleado y Humedad = normal), que

son ejemplos positivos.

37

Dado que el nuevo ejemplo es negativo, ID3 buscaría refinar el árbol a partir del

nodo humedad, agregando un atributo más al árbol. Este nuevo árbol h’ tiene mayor

precisión sobre los ejemplos de entrenamiento que h, puesto que se ha ajustado al

ejemplo con ruido. Pero h tendría mejor desempeño al clasificar nuevos ejemplares,

tomados de una misma distribución que los ejemplos de entrenamiento.

Existe la posibilidad de sobre ajuste, aún cuando el conjunto de entrenamiento

esté libre de ruido, por ejemplo, si el conjunto de entrenamiento tiene pocos elementos.

En conjuntos de entrenamiento pequeños es fácil encontrar regularidades accidentales

en donde un atributo puede particionar muy bien los ejemplos dados, aunque no esté

relacionado con el concepto objetivo.

Puesto que el sobre ajuste puede reducir la precisión de un árbol inducido por

ID3 entre un 10 a 25 %, diferentes enfoques han sido propuestos para evitar este

fenómeno. Los enfoques pueden agruparse en dos clases:

•

Enfoques que detienen el crecimiento del árbol anticipadamente, antes de

que alcance un punto donde clasifique perfectamente los ejemplos de

entrenamiento.

•

Enfoques en donde se deja crecer el árbol para después podarlo.

Aunque el primer enfoque parezca más directo, la poda posterior del árbol ha

demostrado tener más éxito en la práctica. Esto se debe a la dificultad de estimar en que

momento debe detenerse el crecimiento del árbol. Independientemente del enfoque

usado, una pregunta interesante es: ¿Cual es el tamaño correcto de un árbol? Algunos

enfoques para responder a esta pregunta incluyen:

•

Usar un conjunto de ejemplos, diferentes de los usados en el entrenamiento,

para evaluar la utilidad de eliminar nodos del árbol.

38

•

Usar los ejemplos disponibles para el entrenamiento, pero aplicando una

prueba para estimar cuando agregar o eliminar un nodo, podría producir una

mejora al clasificar nuevos ejemplares

•

Usar explícitamente una medida de complejidad para codificar los ejemplos

de entrenamiento y el árbol de decisión, deteniendo el crecimiento cuando el

tamaño codificado sea minimizado. Por ejemplo, el principio de descripción

mínima (MDL).

¿Cómo podemos usar un conjunto de ejemplos de validación para prevenir el

sobre ajuste?

Un enfoque llamado reduced-error pruning [Quinlan, 1987], consiste en

considerar cada nodo del árbol como candidato a ser podado. La poda consiste en

eliminar todo el subárbol que tiene como raíz el nodo en cuestión, convirtiéndolo así en

una hoja, cuya clase corresponde a valor más común de los ejemplares asociados a ese

nodo. Un nodo solo es eliminado si el árbol podado que resulta de ello, no presenta un

desempeño peor que el árbol original sobre el conjunto de validación. El efecto de esto,

es que los nodos que se han colocado en el árbol por coincidencias fortuitas en los datos

del entrenamiento, generalmente son eliminados debido a que las coincidencias suelen

no estar presentes en el conjunto de validación.

Este método es únicamente efectivo si contamos con suficientes ejemplos, de tal

forma que el conjunto de entrenamiento y el conjunto de validación sean significativos

estadísticamente. De otra forma, tomar ejemplos para el conjunto de validación reduce

aún más el tamaño del conjunto de datos entrenamiento, aumentando así la posibilidad

de sobre ajuste.

En la práctica, un método exitoso para encontrar el árbol de mayor precisión se

conoce como rule post-prunning [Quinlan, 1993] y está incorporado en el sistema C4.5

de Ross Quinlan. El procedimiento es el siguiente:

39

•

Inducir el árbol de decisión permitiendo sobre ajuste, por ejemplo, con

nuestro algoritmo básico ID3.

•

Convertir el árbol aprendido en un conjunto de reglas equivalente, esto es,

una conjunción por cada rama del árbol que va de la raíz a una hoja.

•

Podar (generalizar) cada regla, eliminando las precondiciones que resulten en

una mejora de la precisión estimada.

•

Ordenar las reglas por su precisión estimada, y aplicarlas en ese orden al

clasificar nuevos ejemplares.

Cabe mencionar que el método aplicado por C4.5 no es estadísticamente valido,

aunque ha demostrado ser una heurística útil. En la sesión de evaluación de hipótesis,

estudiamos técnicas estadísticamente robustas para estimar medias e intervalos de

confianza. Lo relevante aquíı es que la conversión del árbol en reglas ayuda a distinguir

los diferentes contextos en los que un atributo participa en la clasificación, es decir,

reglas diferentes; elimina la diferencia entre nodos ubicados cerca de la raíz y aquellos

ubicados cerca de las hojas; y aumenta la facilidad de comprensión por parte del

usuario.

2.3.7. Incorporando valores continuos

En el algoritmo básico de ID3 tanto el concepto objetivo, como los atributos

usados para describir los ejemplares, deben tener valores discretos. La segunda

restricción puede ser eliminada fácilmente, permitiendo el uso de atributos con valores

continuos. Esto se logra definiendo dinámicamente nuevos atributos discretos que

particionan los atributos de valores continuos, en intervalos discretos. Para un atributo

continuo A, el algoritmo puede crear dinámicamente un atributo discreto Ac que es

verdadero si A > c y falso en cualquier otro caso. La única consideración es como

seleccionar el mejor valor para el umbral c. Supongan que el atributo temperatura toma

valores discretos y que su relación con el concepto objetivo es la siguiente:

40

Temperatura 40

48

60

72

80

90

No

No

Si

Si

Si

No

Clase

¿Qué valor booleano basado en un umbral debemos definir para el atributo

temperatura?

Obviamente, necesitamos un umbral c, tal que este produzca la mayor ganancia

de información posible. Es posible generar candidatos a umbral, ordenando los ejemplos

de acuerdo a su valor en el atributo temperatura e identificando ejemplos adyacentes

que difieren en el valor de su atributo objetivo. Se puede demostrar que los umbrales c

que maximiza la ganancia de información, se encuentran en estos sitios.

Para el ejemplo presentado, dos umbrales pueden localizarse en los puntos (48 +

60)/2 y (80 + 90/2). La ganancia de información puede entonces calcularse para los

atributos temperatura>54 y temperatura>85. El atributo con mayor ganancia de

información, en este caso el primero, puede ser usado entonces para competir con otros

atributos en la construcción del árbol de decisión. Por supuesto, es posible también

mantener ambos atributos dinámicamente creados, usando múltiples intervalos.

2.4. Redes Bayesianas y ponderación de reglas

2.4.1. Teorema de Bayes

El Teorema de Bayes, dentro de la teoría probabilística, proporciona la

distribución de probabilidad condicional de un evento "A" dado otro evento "B"

(probabilidad posteriori), en función de la distribución de probabilidad condicional del

evento "B" dado "A" y de la distribución de probabilidad marginal del evento "A"

(probabilidad simple o apriori).

41

La probabilidad a priori es la probabilidad de una variable en ausencia de

evidencia. La probabilidad a posteriori es la probabilidad de una variable condicionada

a la existencia de una determinada evidencia; la probabilidad a posteriori de X cuando se

dispone de la evidencia e se calcula como P(X /e).

Partiendo de las fórmulas de probabilidad condicional, que dice que dadas dos

variables X e Y, la probabilidad de que ocurra A dado que ocurrió el evento B es la

probabilidad condicional de A dado B y se denota como P ( A / B ) .

P( A / B) =

P( A ∩ B)

P( B)

Análogamente, si se intercambia el orden de las variables:

P ( B / A) =

P( A ∩ B)

P ( A)

A partir de las dos fórmulas anteriores se obtiene:

P ( A / B) =

P ( A) P ( B / A)

P( B)

a esta expresión se conoce como el Teorema de Bayes.

Para eventos estadísticamente dependientes se procederá a enunciar el Teorema

de Bayes.

Sean A1 , A2 , …, An eventos mutuamente excluyentes tales que, cualquier evento

“B” en el espacio muestral pertenece a uno y sólo a uno de estos eventos. Entonces la

probabilidad de que ocurra cualquier evento Ak dado que ha ocurrido el evento “B” se

calculará por la siguiente fórmula:

42

P ( Ak / B ) =

P ( Ak ∩ B )

P(B)

Por lo tanto, sustituyendo la fórmula de probabilidad condicional, se obtiene la

fórmula general para el Teorema de Bayes:

P( Ak / B) =

P( Ak ) P( B / Ak )

P ( A1 ) P( B / A1 ) + P( A2 ) P( B / A2 ) + ... + P ( An ) P( B / An )

Donde:

El numerador es la probabilidad conjunta:

P( A ∩ B) = P ( B ) P ( A / B )

El denominador es la probabilidad marginal de que ocurra el evento “B”

P ( B ) = P ( A1 ) P ( B / A1 ) + P ( A2 ) P ( B / A2 ) + ... + P ( An ) P ( B / An )

Como "A" y "B" son eventos estadísticamente dependientes, el Teorema de

Bayes se puede representar también utilizando el diagrama de árbol.

Probabilidad conjunta

Dado un conjunto de variables {X, Y, …, Z}, la probabilidad conjunta especifica

la probabilidad de cada combinación posible de estados de cada variable

P( xi , y j ,..., zk )∀i, j ,..., k de manera que se cumple que:

∑ P( x , y ,..., z ) = 1

i

j

k

i , i ,..., k

43

2.4.2. Introducción a redes Bayesianas

Las redes Bayesianas o probabilísticas se fundamentan en la teoría de la

probabilidad y combinan la potencia del teorema de Bayes con la expresividad

semántica de los grafos dirigidos; las mismas permiten representar un modelo causal por

medio de una representación gráfica de las independencias / dependencias entre las

variables que forman parte del dominio de aplicación [Pearl, 1988].

Una red Bayesiana es un modelo gráfico que permite representar las relaciones

de dependencia entre un conjunto de variables y busca relaciones probabilísticas entre

las distintas variables del sistema. Los componentes básicos que componen una red

bayesiana incluyen:

•

Un conjunto de nodos { X i } que representan cada una de las variables del

modelo. Cada una de ellas tiene un conjunto exhaustivo de estados

{ xi } mutuamente excluyentes.

•

Un conjunto de enlaces o arcos ( X i , X j ) entre aquellos nodos que tienen una

relación causal. De esta manera todas las relaciones están explícitamente

representadas en el grafo.

•

Una tabla de probabilidad condicional asociada a cada nodo X i indicando la

probabilidad de sus estados para cada combinación de los estados de sus

padres. Si un nodo no tiene padres se indican sus probabilidades a priori.

La estructura de una red bayesiana se puede determinar de la siguiente manera:

•

Se asigna un vértice o nodo a cada variable ( X i ) y se indica de qué otros

vértices es una causa directa; a ese conjunto de vértices “causa del nodo X i ” se

lo denota como el conjunto π x i y se lo llamará “padres de X i ”.

•

Se une cada padre con sus hijos con flechas que parten de los padres y llegan a

los hijos.

44

•

A cada variable X i se le asigna una matriz P ( xi / π xi ) que estima la probabilidad

condicional de un evento X i = xi dada una combinación de valores de los π x i .

Una vez que se ha diseñado la estructura de la red y se han especificado todas la

s tablas de probabilidad condicional se está en condiciones de conocer la probabilidad

de una determinada variable dependiendo del estado de cualquier combinación del resto

de variables de la red; para ello se debe calcular la probabilidad a posteriori de cada

variable condicionada a la evidencia; estas probabilidades a posteriori se podrán obtener

de

forma

inmediata

a

partir

de

la

probabilidad

conjunta

de

todas

las

variables P ( x1 , x2 ,..., xi ) .

Cada nodo dentro del grafo dirigido de la red Bayesiana representa una variable

aleatoria que tiene asociada una función de probabilidad condicional. La estructura de la

red Bayesiana provee información sobre las relaciones de dependencia e independencia

condicional existentes entre las variables. Estas relaciones simplifican la representación

de la función de probabilidad conjunta como el producto de las funciones de

probabilidad condicional de cada variable.

Una red Bayesiana para un conjunto de variables aleatorias X = ( X 1 ,..., X n ) es

un par B = (G, P (Θ) ) , donde G es un gráfico acíclico dirigido, cuyos nodos se

encuentran en correspondencia uno a uno con las variables en X, y P es un conjunto de

funciones de probabilidad local definidas por un conjunto de parámetros Θ. Se usa Pa i

y pa i para denotar, respectivamente, a los padres y las configuraciones de los padres

del nodo X i en G. La función de probabilidad conjunta representada por la estructura G

está dada por

n

p ( X ) = p( X 1 ,..., X n ) = ∏ p ( X i / Pai )

i =1

Un arco en una red Bayesiana es la unión entre dos nodos y representa la

dependencia entre dos variables del modelo. Un arco queda definido por un par

45

ordenado de nodos (X, Y). Un Padre Pa i (nodo X) es un padre del nodo Y, si existe un

arco (X, Y) entre los dos nodos. Un nodo hijo Y es un hijo del nodo X, si existe un arco

(X, Y) entre los dos nodos.

Las funciones de probabilidad local P son las funciones de probabilidad

correspondientes a los términos de la ecuación anterior. Un ejemplo de red Bayesiana se

presenta en la Figura 12. La función de probabilidad conjunta representada en esta red

es p ( X 1 ,..., X 5 ) = p ( X 1/ X 2 , X 5 ) p ( X 2 ) p( X 3 / X 5 ) p ( X 4 / X 3 , X 5 ) p ( X 5 )

Figura 12. Red bayesiana.

2.4.3. Estimación de la estructura de la red Bayesiana

Existen dos metodologías para el problema de estimación de la estructura de una

red Bayesiana. La primera, llamada búsqueda y score, utiliza un criterio para medir que

tanto la estructura de la red estima el conocimiento a priori y un método de búsqueda

para encontrar el modelo que mejor estime el conjunto de datos. La segunda

metodología, llamada análisis de dependencia, mide el grado de relación de estas

dependencias usando alguna prueba estadística o la cantidad de información mutua.

Generalmente, la primera metodología tiene menor tiempo de complejidad pero puede

46

no encontrar la mejor solución debido a su naturaleza heurística. La segunda

metodología de algoritmos es generalmente asintóticamente correcta cuando la función

de probabilidad cumple ciertas condiciones. A continuación detallaremos la primera de

las metodologías.

Selección del modelo por búsqueda y store

Esta sección presenta algunos ejemplos de las medidas de calidad usadas para

calcular el score de una estructura de red, y los algoritmos de búsqueda sobre el espacio

posible de estructuras de red.

A) Medidas de calidad

Medidas de calidad Bayesianas. Estas medidas están relacionadas con la estadística

Bayesiana. La idea básica es asignar a cada red un valor en función de su probabilidad

posterior p(B/D). Un criterio frecuente es usar el logaritmo de la función de

probabilidad posterior

log p ( B / D ) = log p ( B ) + log p ( D / B )

El logaritmo es usado por conveniencia numérica. Este criterio tiene dos componentes:

el logaritmo de la a priori y el log de la verosimilitud marginal.

Medidas de mínima longitud de codificación. El score esta basado en el principio LDM

[Rissanen, J. , 1989] y la aplicación a las redes Bayesianas fue desarrollado por

Bouckaert [Bouckaert, 1994], Lam y Bacchus [Lam, 1994] y Suzuki [Suzuki, 1996].

Estos autores argumentan que usando solo la función de probabilidad posterior resulta

en un criterio que refiere redes con gráficos completos, por lo que se debe agregar un

factor que penalize el tamaño de la red.

q ( B, D ) =

log N

|| B || − LL ( B / D)

2

47

Donde ||B|| representa el tamaño de la red y LL el logaritmo de la función de

verosimilitud.

Medidas de información teórica. Otra forma de medir la calidad de una red es usando

las medidas de información. Estas medidas pueden considerarse como una

generalización de la medida LDM. Las más conocidas son

Criterio de información por máxima verosimilitud. La medida es el logaritmo de

la verosimilitud de una red Bayesiana, dado un conjunto de datos de

entrenamiento. A diferencia de otras medidas de información teórica, esta no

contiene penalización debido al tamaño de la red.

q (B,D) = LL(B/D)

Criterio de información de Akaike. [1] Esta medida no es consistente ya que el

mejor modelo no se encuentra entre las que reciben lo mayores scores [Schwarz,

1978].

q (B,D)=LL(B/D)−||B||

Criterio de información Bayesiana. También conocido como criterio de

información de Schwarz [Schwarz, 1978] es fácil de usar y no requiere la

evaluación de la función de probabilidad a priori. Consecuentemente, se trata de

un criterio práctico usado en circunstancias apropiadas. Cuando se aplica a redes

con distribución multinomial para las variables este criterio es parecido al

criterio LDM diferenciándose por un signo negativo.

q ( B, D) = − LL( B / D) −

log N

|| B ||

2

2.4.4. Clasificadores basados en redes Bayesianas

48

Supongamos que X 1 ,..., X n son variables aleatorias que permiten predecir el

valor de una variable C llamada clase. De acuerdo al teorema de Bayes, la probabilidad

de que una observación pertenezca a la clase c es

p (C = c / x1 ,..., x n ) =

P(C = c) p ( x1 ,..., x n / C = c)

p ( x1 ,..., x n )

El proceso de clasificación se realiza asignando la observación en aquella clase

que tenga la mayor probabilidad usando la ecuación anterior. Las redes Bayesianas

pueden ayudarnos a simplificar la representación de la función de probabilidad conjunta

p ( X 1 ,..., X n / C ) considerando las relaciones de dependencia que existen entre las

variables.

Clasificador Naive Bayes

El clasificador Naive Bayes y sus variantes se encuentran entre los algoritmos

más conocidos para construir clasificadores de documentos de texto [Kim S., Seo H. y

Rim H., 2003], filtración de correo electrónico [Sahami, M., Dumais, S., Heckerman, D.

y Horvitz E., 1998], clasificación de galaxias [Bazell D. y Aha D., 2001] y

reconocimiento de emociones [Sebe N., Lew M., Cohen I., Gary A. y Huang T., 2002].

A pesar de su simplicidad es comparable con clasificadores sofisticados como las redes

neuronales y los árboles de decisión, ya que posee alta precisión y velocidad cuando es

aplicada a conjuntos grandes de datos.