Untitled

Anuncio

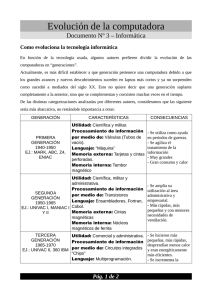

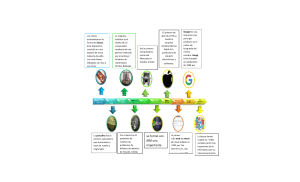

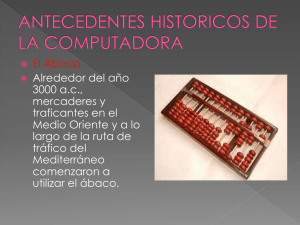

Definición Informática la ciencia que estudia los sistemas inteligentes se información se le denomina informática. En otras palabras, la informática es la ciencia enfocada al estudio de las necesidades de información, de los mecanismos y sistemas requeridos para producirla y aplicarla, de la existencia de insumos y de la integración coherente de los diversos elementos informativos que se necesitan para comprender una situación. La definición del IBI (Oficina Intergubernamental para la Informática) es: "La aplicación racional y sistemática de la información en los problemas económicos, sociales y políticos"; también señala que la informática es la "ciencia de la política de la información". Si buscas el concepto en un diccionario, muy probablemente encuentres una definición según la cual computación e informática son prácticamente lo mismo. Por ejemplo, el diccionario de la Real Academia de la Lengua Española señala que informática es el "conjunto de conocimientos científicos y técnicas que hacen posible el tratamiento automático de la información por medio de ordenadores (computadoras)". Es más, en el mismo diccionario se apunta que "informática" es la palabra que se usa en América para hablar de "computación". Introducción El ser humano siempre ha necesitado encontrar métodos rápidos y efectivos para resolver sus cálculos, y con ayuda de su gran inventiva ha conseguido a través de los siglos desarrollar las computadoras. Hoy en día ya estamos acostumbrados a vivir con ellas, o casi, y no nos percatamos de que su aparición ha tenido una gran influencia en diversos aspectos de nuestra vida diaria, mejorándola y abriendo puertas que antes eran desconocidas para la humanidad. En sus orígenes, bastantes años antes de Cristo, el cálculo tenía bastantes problemas para poder desarrollarse. Uno de ellos era que no existía un mecanismo fácil para escribir el enunciado de los problemas y para anotar los resultados intermedios, dificultando así el trabajo de las personas que buscaban la solución de un cálculo. Dado este problema y la necesidad de obtener resultados rápidos y exactos procedente de los campos del comercio, impuestos, calendarios, organización militar, etc., en la historia de la humanidad se han ido construyendo distintos instrumentos y maquinas que simplificaran notablemente los cálculos humanos. La computadora u ordenador, no es un invento de alguien en particular, sino el resultado evolutivo de ideas y realizaciones de muchas personas relacionadas con áreas tales como la electrónica, la mecánica, los materiales semiconductores, la lógica, el álgebra y la programación. Historia de la Informática El origen de las máquinas de calcular está dado por el ábaco chino. El ábaco no era otra cosa que un rudimentario marco o tablilla de madera dotada de una serie de varillas verticales que dividían la tabla en varias columnas, en las cuales habían una serie de bolas o anillos a modo de cuentas. La columna situada más a la derecha representaba las unidades, la anterior a las decenas y así sucesivamente. En la parte inferior de cada columna existían cinco cuentas elementales y, situadas en la parte superior otras dos de distinto color que representaban cinco unidades. Así, representando un número en el ábaco mediante las cuentas situadas en las columnas correspondientes, las sumas se realizaban añadiendo las cuentas necesarias a cada columna dígito a dígito, de forma que si en este proceso se completaba alguna columna con diez cuentas, éstas eran eliminadas y se sumaba una cuenta en la columna inmediatamente a su izquierda. Desde épocas tempranas se han manipulado piedras sobre el polvo o usado un palo o el propio dedo sobre tablas de polvo (como sustitución del papel y la tinta) para hacer operaciones. Por eso se cree que la palabra semítica abaq (polvo) es la raíz de nuestra palabra moderna ábaco; y que fue adoptada por los griegos que utilizaban la palabra abax para nombrar la superficie plana en la que dibujaban sus líneas de cálculo. Como gran parte de la aritmética se realizaba en el ábaco, llegó un momento en el que ambas palabras se utilizaban indistintamente, considerándose sinónimos. Su origen no está muy claro, y probablemente comenzó simplemente como piedras que se movían en líneas dibujadas sobre polvo. Pero lo que sí es seguro es que por el 1000 a.C. en la civilización china el ábaco era una herramienta indispensable para efectuar todas las transacciones comerciales en las que era necesario realizar operaciones rápidas y eficaces. Otro de los hechos importantes en la evolución de la informática lo situamos en el siglo XVII, donde el científico francés Blas Pascal inventó una máquina calculadora. Ésta sólo servía para hacer sumas y restas, pero este dispositivo sirvió como base para que el alemán Leibnitz, en el siglo XVIII, desarrollara una máquina que, además de realizar operaciones de adición y sustracción, podía efectuar operaciones de producto y cociente. Ya en el siglo XIX se comercializaron las primeras máquinas de calcular. En este siglo el matemático inglés Babbage desarrolló lo que se llamó "Máquina Analítica", la cual podía realizar cualquier operación matemática. Además disponía de una memoria que podía almacenar 1000 números de 50 cifras y hasta podía usar funciones auxiliares, sin embargo seguía teniendo la limitación de ser mecánica. Recién en el primer tercio del siglo XX, con el desarrollo de la electrónica, se empiezan a solucionar los problemas técnicos que acarreaban estas máquinas, reemplazándose los sistemas de engranaje y varillas por impulsos eléctricos, estableciéndose que cuando hay un paso de corriente eléctrica será representado con un *1* y cuando no haya un paso de corriente eléctrica se representaría con un *0*. Con el desarrollo de la segunda guerra mundial se construye el primer ordenador, el cual fue llamado Mark I y su funcionamiento se basaba en interruptores mecánicos. En 1944 se construyó el primer ordenador con fines prácticos que se denominó Eniac. En 1951 son desarrollados el Univac I y el Univac II (se puede decir que es el punto de partida en el surgimiento de los verdaderos ordenadores, que serán de acceso común a la gente). El avance de la tecnología de las computadoras, a partir de los primeros años del siglo XX ha sido sorprendente. El descubrimiento de los nuevos dispositivos electrónicos, los grandes avances de la programación y el acelerado desarrollo de los nuevos sistemas operativos, han marcado fechas que permiten clasificar a las computadoras de acuerdo a sus componentes y a su capacidad de procesamiento, agrupándolas por generaciones. Hay quienes ubican a la primera a partir de 1937, otros desde 1951 que fue cuando apareció la primera computadora comercial la UNIVAC (Universal Automatic Computer), pero no es conveniente tomar partido por alguna de estas teorías, sino considerar a las fechas en que se dieron los grandes cambios, como parámetros para determinar el fin de una etapa y el comienzo de otra. - Primera generación Las computadoras de esta generación se caracterizaron por estar constituidas de relevadores (relés) electromecánicos como la MARK I, o de tubos de vacío como la ENIAC. Eran de un tamaño tan grande que ocupaban espaciosos salones en las universidades donde fueron desarrolladas. - Segunda generación En la segunda generación de computadoras la característica principal en cuanto a los equipos (hardware) es la inclusión de transistores. Respecto a la programación o software, siguen dominando los sistemas de tarjeta o cinta perforada para la entrada de datos. Los laboratorios Bell logran avances muy significativos como la construcción en 1954, de la primera computadora transistorizada, la TRADIC (Transistorized Airborne Digital Computer). - Tercera generación Lo siguiente fue la integración a gran escala de transistores en microcircuitos llamados procesadores o circuitos integrados monolíticos LSI (Large Scale Integration), así como la proliferación de lenguajes de alto nivel y la introducción de sistemas operativos (comunicación entre el usuario y la computadora). - Cuarta generación Empieza con la aparición del primer microprocesador. En 1971, Intel Corporation, presenta el primer microprocesador o Chip de 4 bit, que en un espacio de aproximadamente 4 x 5 mm contenía 2250 transistores. Este primer microprocesador fue bautizado como el 4004. Esta generación se caracterizó por grandes avances tecnológicos realizados en un tiempo uy corto. En 1977 aparecen las primeras microcomputadoras, entre las cuales, las mas famosas fueron las fabricadas por Apple Computer, Radio Shack y Commodore Business Machines. IBM se integra al mercado de las microcomputadoras con su Personal Computer; se incluyo un sistema operativo estandarizado, el MS-DOS (MicroSoft Disk Operating System). - Quinta generación La quinta generación está en desarrollo desde 1990 hasta la fecha. Hay que mencionar dos grandes avances tecnológicos que quizás sirvan como parámetro para el inicio de dicha generación: la creación en 1982 de la primera supercomputadora con capacidad de proceso paralelo, diseñada por Seymouy Cray, quien ya experimentaba desde 1968 con supercomputadoras, y que funda en 1976 la Cray Research Inc; y el anuncio por parte del gobierno japonés del proyecto "quinta generación", que según se estableció en el acuerdo con seis de las más grandes empresas japonesas de computación, debería terminar en 1992. Según este proyecto, la característica principal sería la aplicación de la inteligencia artificial. Las computadoras de esta generación contiene una gran cantidad de microprocesadores trabajando en paralelo y pueden reconocer voz e imágenes. El único proceso que se venido realizando sin interrupciones en el transcurso de esta generación, es la conectividad entre computadoras, que a partir de 1994, con el advenimiento de la red Internet y del World Wide Web, ha adquirido una importancia vital en las grandes, medianas y pequeñas empresas y, entre los usuarios particulares de computadoras. Fuentes http://www.jimenez-ruiz.es/ernesto/II/Historia/treball.html http://www.monografias.com/trabajos10/recped/recped.shtml http://es.wikipedia.org/wiki/Anexo:Historia_de_la_computaci%C3%B3n http://www.ciberhabitat.gob.mx/museo/historia/ http://html.rincondelvago.com/historia-de-la-informatica_12.html Trabajo realizado por Javier López y Alodia Vergara.