Tema 4. Integración. Los métodos más simples, en un ejemplo

Anuncio

Tema 4. Integración.

Los métodos más simples, en un ejemplo: Punto Medio y Trapecio.

Idea general de las Reglas de Cuadratura: en lugar de f , integrar sus polinomios interpoladores.

Cómo depende el error del grado del método y del paso utilizado. Maximizar el grado: reglas gaussianas.

Ejemplo inicial.

Nos encargan una tabla que dé, con 4 dı́gitos correctos, los valores de la distribución Normal

! x

2

1

1

Φ(x) = + √

e−s /2 ds

2

2π 0

2

para cada x = entero/10 ∈ (0, 4] . Llamando f (s) = e−s /2 , todo se reduce a calcular para esos x , con

error1 absoluto < 10−4 , los valores de

"x

F (x) = 0 f (s) ds .

Posibles métodos:

A) Del desarrollo de Taylor de F " (x) = f (x) = 1 − x2 /2 + (x2 /2)2 /2! − . . . , se deduce el de

F (x) = x −

x3

x5

+ 2

− ...

2·3

2 · 2! · 5

Sumando hasta que el tamaño de los sumandos decrezca, los signos alternos aseguran un error de menor

tamaño que el primer sumando omitido; parar cuando sea < 10−4 .

B) Tomar una sucesión xk = kh que incluya los valores deseados x = 0.1, 0.2, . . . , 4 , y aproximar

#k

la integral F (xk ) con una suma de Riemann

1 hfi , donde los fi sean valores de f juiciosamente

escogidos en cada intervalo entre los xi .

Dos opciones naturales son:

B1) la media de los valores extremos:

2fi = f (xi−1 ) + f (xi )

B2) el valor en el centro:

fi = f (mi ) , con 2mi = xi−1 + xi

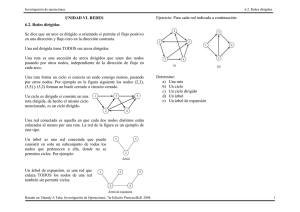

El gráfico que sigue muestra lo que hacen esas dos opciones con la integral de f sobre cada intervalo,

y permite ver:

1) por qué se llaman respectivamente

“del trapecio” y “del punto medio” ;

2) por qué en general el valor exacto

estará entre esas dos aproximaciones.

Llamemos m al punto medio de uno de"esos intervalos, h a su longitud: J = [m − h/2, m + h/2] ,

Itr , Ipm a las dos aproximaciones de I = J f (s)ds que resultan, y veamos el error esperable en cada

una; usando el desarrollo de Taylor

f (m + s) ≈ f (m) + f " (m) s + f "" (m) s2 /2 , resulta

! h/2

h3

I=

f (m + s) ds ≈ f (m) h + f "" (m) (h/2)3 /3 = Ipm + f "" (m)

24

−h/2

pero también f (m − h/2) + f (m + h/2) ≈ 2 f (m) + f "" (m) (h/2)2 , luego

Itr − Ipm ≈

h ""

f (m)(h/2)2 = 3 (I − Ipm )

2

Como Ipm parece mejor opción, veamos qué error tendrá F (xk ) si lo aproximamos con ella:

k

F (xk ) − F̃ (xk ) ≈

h3 $ ""

h2

f (mi ) ≈

24 i=1

24

!

0

xk

f "" (s) ds =

h2 "

f (xk )

24

Teniendo en cuenta que |f " | ≤ |f " (1)| = e−1/2 = 0.61 , resulta un |error| < h2 · 0.61/24 = 0.63/104 para

h = 0.05 . Coste en operaciones2 con ese valor de h : 80 evaluaciones de f (x) · h + 79 sumas.

1 Como

√

F (x) se dividirá por 2π = 2.5 , eso basta para tener “4 dı́gitos correctos”.

con el que tendrı́a la versión Itr si usamos el mismo h , que darı́a un error de tamaño doble.

2 Comparar

1

EJEMPLO PARA TRABAJAR

HASTA LA CLASE SIGUIENTE

E 4.1

Queremos calcular el valor de arctg(x) para cada x = entero/100 ∈ (0, 1)

• Si queremos tener errores < 10−6 , estudiar cómo usar la Regla del Punto Medio para

conseguirlo: qué longitud h de intervalos escoger.

¿Por qué no usar simplemente el desarrollo de Taylor de arctg(x) , que converge en ese

intervalo? Comparar el coste en operaciones.

• Si bastase con tener error < 10−4 , el valor h = 1/100 ya serı́a pequeño de sobra; una posible

alternativa es: calcular aproximadamente la

"x

ds/(1 + s2 )

0

para menos puntos que los pedidos, y luego interpolar linealmente para hallar los restantes

valores de arctg(x) . Estudiar esa posibilidad3 , y comparar el coste en operaciones con el de

usar h = 1/100.

Reglas de cuadratura4 .

"

Se trata ahora de entender y generalizar lo hecho en el ejemplo para aproximar cada J f .

Es obvio en el gráfico que las dos Reglas de cuadratura propuestas integran exactamente cada función

f (x) = c0 + c1 x ; ambas son funciones de un cierto

" número de valores fi = f (xi ) del integrando, y se

comportan (como debe ser) igual que la integral I f en estos dos sentidos:

1) son lineales en f , es decir en los valores fi , y

2) responden igual que la integral al cambio de variable

x = m + hs/2 , que aplica el intervalo I = [−1, 1] sobre el J = [m − h/2, m + h/2] .

En vista de esto, podemos definir cada posible Regla de cuadratura por los puntos si ∈ I que utiliza,

definir su grado por el de los polinomios que es capaz de integrar exactamente, y estudiar qué deberı́a

hacer con los valores fi = f (xi ) para maximizar el grado y minimizar el error.

#

PROPOSICION: Dados n + 1 puntos si ∈ I , la única Regla I(f

" ) = i wi fi que usa los valores

fi = f (xi ) en los puntos xi = m + hsi /2 , y calcula exactamente la J f para cada f ∈ P oln , es

"

"

I(f ) = J P[x0 ,...,xn ] (x) dx , y su error es J (f − Pn ) = O(hn+2 )

"

Observación: Está implı́cito en la afirmación que cada peso wi es J Li (x) dx para el correspondiente

polinomio de Lagrange asociado a esos nodos.

Prueba:

La primera afirmación es consecuencia de que hay un sólo Pn ∈ P oln que coincide con f en los puntos

xi = m + hsi /2 . En vista de la fórmula

f (x) − Pn (x) =

y como W (x) =

%

f n+1) (ξ)

W (x)

(n + 1)!

|

i (x

!

J

|

y de la desigualdad

(f − Pn ) | ≤ max

J

|f n+1) |

(n + 1)!

!

J

!

J

g(x) dx| ≤

!

J

|g(x)| dx

será

|W (x)| dx

− xi ) tiene n + 1 factores, es inmediato que

!

J

|W (x)| dx = (h/2)

n+2

!

1

−1

&

i

|s − si | ds = O(hn+2 )

"

Si se piensa un momento en la "forma que tiene W (x) , se ve que el usar la J |W (x)|dx desprecia la

cancelación que cabe esperar en la J W (x)dx ; en consecuencia, cabe esperar un error mucho menor que

la cota a la que hemos llegado. En el apartado siguiente veremos a dónde nos lleva eso. . .

3 Se puede usar una calculadora programable (o Matlab ), para poner a prueba el plan, y comparar los resultados con

los valores de arctg(x) que dé la calculadora directamente.

4 Ver en Sanz-Serna, Cap.5, un comentario sobre esa terminologı́a.

2

EJEMPLO PARA TRABAJAR

HASTA LA CLASE SIGUIENTE

E 4.2

• Hallar los pesos de las Reglas de cuadratura que resultan de interpolar f con 3 ó 4 puntos

igualmente espaciados, que incluyan los extremos del intervalo de integración; se las llama

respectivamente Regla de Simpson y Regla de los 3/8 (se descubrirá el por qué de este

nombre). Estos son los casos n = 2, 3 de las Reglas de Newton-Cotes; para estas Reglas hay

la tradición notacional siguiente: los nodos se llaman

xi = x0 + ih , y el intervalo en el que se integra es J = [x0 , xn ]

de modo que su longitud, que venimos llamando h , será ahora5 |J| = nh .

• Usar el desarrollo de Taylor de f en el punto medio m del intervalo para deducir sus fórmulas

de error.

• Comprobar (en J = [−1, 1] , pero la afirmación vale en general) que ambas Reglas integran

exactamente la función x3 pero no la función x4 . Observar cómo esto permite verificar la

constante de las fórmulas de error halladas, pero también deducirla del modo más sencillo.

Por qué unos nodos son mejores que otros.

Ya vimos en el Ejemplo Inicial que la Ipm funciona mejor de lo que le corresponde: usa sólo un nodo,

pero integra exactamente las f ∈ P ol1 , y su error es O(h3 ).

• La razón

" es ésta: en vista de que W (x) = x − m , donde m es el punto medio del intervalo J , se

tiene J W (x) dx = 0 , y por lo tanto las siguientes igualdades en las que P0 , P1 son los polinomios

interpoladores de f en x0 = m , y cualquier x1 :

!

!

P1 (x) − P0 (x) = f[m,∗] W (x) = cte · (x − m) ,

P1 (x) dx − Ipm (f ) = cte (x − m)dx = 0

J

J

"

• Esto es general: si el W que se anula en los n + 1 nodos de la Regla I(f ) = J Pn , cumple

"

W (x) dx = 0 ,

J

"

"

el Pn+1 que también interpola f en cualquier otro nodo adicional cumple J Pn = J Pn+1 , luego

"

la Regla I(f ) = J Pn integra exactamente cada f ∈ P oln+1 , y su error es O(hn+3 ) .

Eso ocurre por ejemplo con los nodos s = −1, 0, 1 (Regla de Simpson, ver E 4.2).

Además, el argumento es “reversible”: por ejemplo,

no es posible que la Regla de Simpson integre

"

exactamente la función f (x) = x4 , porque J W (x)x dx &= 0 , y el polinomio interpolador P2 de

f = x4 en esos nodos cumplirá x4 − P2 (x) = (c0 + c1 x)W (x) .

El mismo argumento se aplica a la del Punto Medio con la función x2 , y permite concluir que estas

dos Reglas son

" de orden 3 y 1 respectivamente. En resumen: "

la igualdad J W (x) = 0 hace ganar un grado, la desigualdad J W (x)x &= 0 impide ganar otro más.

• Pero la idea es aún más general: La igualdad

Pn+1 (x) = Pn (x) + c W (x) es un caso particular de

Pn+1+d (x) = Pn (x) + W (x)q(x)

donde q(x) ∈ P old : basta observar la forma de Newton de Pn+1+d (x) para ver que tiene esa forma.

En consecuencia,

"

"

W (x)q(x) dx = 0 para cada q ∈ P old , se tendrá J Pn = J Pn+1+d

"

I(f ) = J Pn es exacta para cada f ∈ P oln+1+d , y su error es O(hn+d+3 ) .

si W cumple

luego la Regla

"

J

¿Cuán grande puede ser d ?

"

Obviamente d < n + 1 , porque J W 2 (x) > 0 y W

" ∈ P oln+1 , pero probaremos de inmediato que

hay un W (x) = (x − x0 ) · · · (x − xn ) que cumple J W (x)q(x) dx = 0 para cada q ∈ P oln .

La Regla In∗ que resulta al usar esos nodos se llama gaussiana, y es por lo tanto de grado 2n + 1 ;

por ejemplo, I0∗ = Ipm . Como los “nodos extra” yj son arbitrarios, podemos tomar de nuevo los

mismos xj , de modo que In∗ (f ) equivale a usar los valores de f y de f " en esos n + 1 nodos, y su

error estará controlado por

!

|f 2n+2) |

2

max

Wn+1

(x) dx

J (2n + 2)! J

5 Pronto se entenderá la conveniencia de hacerlo ası́ en este caso; hay que tenerlo en cuenta, para que las constantes de

las fórmulas de error coincidan con las que se encuentran en los libros; el otro convenio es mejor al hablar de Reglas de

Cuadratura en general.

3

PROPOSICION: Fijado un intervalo J , la expresión

"

< p, q >J = J p(x)q(x) dx

define un producto escalar en el espacio vectorial P ol de los polinomios6 . Si se aplica el proceso de

ortogonalización respecto de ese producto a la sucesión de monomios 1, x, x2 , . . . , los Wk (x) que

resultan tienen raı́ces reales y contenidas en el intervalo J .

Prueba: La de la primera afirmación se reduce a verificar las propiedades que definen un p.e.

Para la segunda, observemos que para hallar Wn+1 restamos a xn+1 su proyección sobre P oln ,

luego resulta el polinomio

"

W (x) = xn+1 − p(x) , con p ∈ P oln , que hace mı́nimo el producto < W, W >J = J W 2 (x) dx .

Pero si W tuviese un cero c ∈ IR \ J , o un par de ceros complejos z = α ± iβ , el acercarlos a J

reducirı́a en cada punto de J el factor (x − c)2 ó |x − z|4 de W 2 , y con ello su integral sobre J .

De este modo hemos conseguido un

Wn+1 (x) = (x − x0 ) · · · (x − xn ) que cumple

"

J

Wn+1 (x)q(x) dx = 0 , ∀q ∈ P oln ,

y sus

son por lo tanto los nodos de la Regla Gaussiana In∗ . Además, la propiedad de minimizar

" ceros

2

la J W entre los polinomios del subespacio afı́n

"

H = {xn+1 − p(x) , con p ∈ P oln }

implica que el factor J W 2 en el error de la Regla In∗ es menor que el de cualquier otra que use

interpolación osculatoria en n + 1 puntos.

Si J = [−1, 1] , estos Wn+1 (x) = (x − x0 ) · · · (x − xn ) se llaman7 polinomios de Legendre.

• Pero resulta que esta idea es aún más general: si fijamos, además del J , alguna función ω(x) > 0

"

sobre él, la expresión

< p, q >ω = J p(x)q(x) ω(x)dx

define también un producto escalar en el espacio vectorial P ol , todo lo anterior se extiende sin

más, e implica lo siguiente: la función W = Wn+1 obtenida como en la PROPOSICION, cumple

"

0 =< W, q >ω = J W (x)q(x) ω(x)dx , ∀q ∈ P oln ,

con la consecuencia de que, si llamamos Pn al polinomio que usa como nodos los ceros de W , se

"

"

tiene para cada f :

P (x) ω(x)dx = J P2n+1 (x) ω(x)dx ,

J n

"

"

y la integral J f (x) ω(x)dx se aproxima con la J Pn (x) ω(x)dx con error = 0 si f ∈ P ol2n+1 .

Por ejemplo, tomando ω(x) = (1 − x2 )−1/2 en J = [−1, 1] , resultan por este procedimiento una vez

más los polinomios de Chebychev Tn (x) , que como vimos en el Tema 3 cumplen

Tn (cos θ) = cos(nθ)

es decir,"los nodos que se obtienen son xk = cos((k + 12 )π/n) . Por otro lado, si reescribimos la

integral J f ω con el cambio de variable x = cos(θ) , y tenemos en cuenta que

"1

"π

ω(x) = (1 − x2 )−1/2 = 1/sen(θ) , resulta: −1 f (x) ω(x)dx = 0 f (cos θ) dθ

y lo que tenemos es una Regla de Cuadratura en [0, π] , con los n nodos θk = (k + 12 )π/n , y exacta

para las funciones g(θ) = f (cos θ) , donde f ∈ P ol2n−1 : se los llama polinomios trigonométricos.

EJEMPLO PARA TRABAJAR

HASTA LA CLASE SIGUIENTE

E 4.3

Hallar los nodos de las Reglas Gaussianas con 2 y con 3 nodos (n = 1, 2), de dos maneras:

"1

• Imponiendo que cumplan

W (x)xk = 0 hasta k = n .

−1

Varias de las ecuaciones implicarán algo que era de esperar: que los nodos son simétricos

respecto del 0; las restantes ecuaciones permitirán determinar dónde están.

• Buscando los sucesivos polinomios de Legendre Wk con el algoritmo

de Gram-Schmidt

"

aplicado a los monomios 1, x, x2 , . . . y el producto escalar < p, q >J = J p(x)q(x) dx .

Observar que no hay que calcular de nuevo, es el mismo cálculo de antes.

• Por último, hallar los pesos wi de esas dos Reglas, sus grados y fórmulas de error.

6 Con

coeficientes reales, pero una teorı́a análoga puede hacerse en el caso complejo con

7 Nuestros

< p, q >J =

R

J

p(x)q̄(x) dx

.

Wn tienen primer coeficiente =1; los que se suelen llamar polinomios de Legendre son múltiplos de éstos, con

valor 1 en x = 1 .

4

Algunas ideas valiosas: entre el punto de vista teórico y el computacional.

• Las Reglas que se obtienen con n nodos equi-espaciados se llaman de Newton-Cotes.

Tras ver en el Tema 3 el mal aspecto de su correspondiente W (x) , no sorprenderá saber que esas

Reglas son muy malas desde el punto de vista de la estabilidad numérica cuando n crece. Eso se

manifiesta en la forma siguiente: ya a partir de n = 8 , los pesos wi de esas Reglas pierden la

propiedad esencial

de ser positivos; es decir, la Regla Newton-Cotes con"n + 1 = 9 nodos calcula

"1

#

por ejemplo 0 dx = 1 como i wi = 1 , pero algunos de esos wi = J Li son < 0 , y crecen

exponencialmente

para n grande. Como consecuencia, algo tan razonable como la convergencia a

"

la integral J f cuando n → ∞ , no se cumple ni siquiera “teóricamente”, es decir en ausencia de

errores de redondeo, salvo que f sea una función muy regular 8 .

Por el contrario,

" los pesos de las Reglas Gaussianas se comportan tan bien que dan convergencia

a la integral J f si f es continua. El siguiente gráfico permite ver esos comportamientos en el

caso de 13 nodos: los pesos Gauss conservan ese aspecto

# cuando n → ∞ , con escala vertical

que va disminuyendo como O(1/n), para mantener la

wi = 2 , mientras que el tamaño de los

Newton-Cotes crece como O(2n ) , y supera por ejemplo 105 en los nodos centrales cuando n = 32 .

13 nodos Newton!Cotes

3

2

1

0

!1

!2

!3

!1.5

!1

!0.5

0

0.5

1

1.5

1

1.5

13 nodos Gauss

0.3

0.25

0.2

0.15

0.1

0.05

0

!0.05

!1.5

!1

!0.5

0

0.5

• La consecuencia práctica de lo anterior es que la frase “cuando n → ∞” es indispensable para los

Teoremas, pero en la práctica las Reglas Newton-Cotes son útiles sólo con n muy pequeño: n ≤ 4 ,

y la más popular es Simpson, n = 2 ; mientras que las Gaussianas convergen tan rápido si f es

derivable9 , que algún n < 10 suele agotar la precisión.

Pero la tarea de usar esas Reglas exige calcular sus nodos y pesos, lo que implica hallar los ceros

de los polinomios Wn , una tarea difı́cil y muy mal condicionada, como ya hemos mencionado.

Ya vimos en el Tema 2 que, sorprendentemente, la mejor forma de hacerlo es hallar los autovalores de

una matriz adecuada con los métodos iterativos que hay para ello, y en los años 60 se descubrió una

prodigiosa manera de calcular los nodos y pesos Gauss resolviendo un problema de autovalores10 .

• Revisemos la situación del Ejemplo Inicial, a la luz de todo lo visto.

Podemos ahora escoger no sólo el paso sino la Regla a usar, y una pregunta natural, en vista del

error O(hn+2 ) , es la de qué interesa más “por el mismo precio”: disminuir h o aumentar n .

8 Por

ejemplo, analı́tica en todo el plano complejo.

chiste es que un inocente salto de la f ! arruina completamente esa velocidad de convergencia...

10 Las lineas de código Matlab que hacen falta para eso, se usaron para producir este gráfico y se verán en el Laboratorio.

9 El

5

Es importante no olvidar lo siguiente: al dividir un intervalo de integración dado en intervalos de

longitud h y sumar los errores, hay cte/h sumandos, lo que hace que el error total sea O(hn+1 ) en

lugar de O(hn+2 ), como vimos en ese Ejemplo. Ver E 4.4.

Los términos de error que sumamos a lo largo de una partición en intervalos J se pueden a menudo

“resumir”, como en aquel ejemplo, en una fórmula aproximada fácil de evaluar:

!

k

h3 $ ""

h2 xk ""

h2 "

f (mi ) ≈

f (s) ds =

( f (xk ) − f " (x0 ) )

24 i=1

24 x0

24

lo que también podrı́a expresarse diciendo que el segundo sumando en

! h/2

f " (m + h) − f " (m − h)

f (m + s) ds ≈ Ipm (f ) + h2

24

−h/2

es una corrección de la Regla de Cuadratura, que es conveniente si, como en este caso, se simplifica

al sumar muchas de ellas. A este modo de operar se le suele llamar una Regla corregida.

• Este cálculo de fórmulas de error por el método de despreciar términos de mayor orden en el

desarrollo de Taylor, es muy conveniente por su simplicidad, e indica lo que cabe esperar cuando

h → 0 ; pero hay versiones “exactas” de esas fórmulas, que utilizan valores de las derivadas en

“puntos no determinados”, como hacen las de los restos de Taylor. La fórmula de error para el

Punto Medio serı́a en ese estilo: para algún ξ ∈ J = [m − h/2, m + h/2] ,

" h/2

f (m + s) ds − Ipm (f ) = h3 f "" (ξ)/24

−h/2

Se llega a fórmulas similares para el error de las Reglas corregidas si se las expresa como el resultado

de utilizar interpolación osculatoria de grado creciente sobre los nodos originales.

• Lo anterior es útil cuando podemos evaluar las derivadas, acotarlas, etc.

Si ocurre todo lo contrario, ni siquiera una estimación a priori del h conveniente es posible; se

recurre entonces a lo que es una idea general del Cálculo Numérico:

ir disminuyendo el paso h , y observar las diferencias de los valores obtenidos.

Ası́ el método se convierte en iterativo, y reaparece una idea del Tema 1: si en cada iteración se

divide h por 2, el error decrecerá geométricamente; por lo tanto podemos extrapolar: saltar al

lı́mite estimado de la sucesión de valores hallados11 .

• Serı́a estúpido subdividir largos intervalos de integración con derivadas evanescentes (como las de

exp(−x2 /2) para x >> 1) usando el h calculado para los máximos valores de esas derivadas.

O arruinar completamente nuestras cotas de error, y con ellas la velocidad de convergencia,

debido

√

a una singularidad de las mismas: si por ejemplo tratamos de integrar f (x) = 1/ 1 − x2 .

Una solución de sentido común es elegir distintos h para distintas zonas del problema, es decir

particiones adaptadas al comportamiento de la función.

En ciertos casos puede haber ideas mejores, como un cambio de variable que equilibre los valores de

esas derivadas, o que cancele la singularidad con la derivada del cambio. Esta idea puede también

servir para traer a un intervalo finito el caso frecuente de una integral impropia en (a, ∞).

EJEMPLO PARA TRABAJAR

HASTA LA CLASE SIGUIENTE

E 4.4

• Suponer que debemos aproximar la

"1

0

f (x) dx ,

y que disponemos ya de los 2 + 1 valores f (i/2k ) , que en principio pensamos utilizar con la

Regla de Simpson, aplicada a intervalos J de longitud 2/2k .

¿Bajo qué condiciones sobre k será mejor usar esos valores con la Regla Newton-Cotes de 5

nodos, aplicada a intervalos J de longitud 4/2k ?

k

Observar cómo entran en la respuesta las cotas disponibles para las derivadas de f , y lo

cómodo que es llamar h = 2−k en todo el cálculo; comparar también el coste computacional.

• Estudiar la idea de las particiones adaptadas en la integral

! x

ds

2 log(s)

Si queremos usar la Regla de Simpson para un x grande, ¿cómo organizar esas particiones?

11 Esta

vez sabemos además con qué factor decrece: r = 1/2m , donde m es el exponente de h en la fórmula de error.

Variantes más generales y sofisticadas de la idea aparecen en los textos como extrapolación de Richardson, o de Romberg.

6

Apéndice III: La idea de las Reglas Interpolatorias desborda su esquema.

• Partimos de la fórmula de error para la Regla del Punto Medio, en dos versiones:

!

(2h)3 ""

h2

f − 2hf (m) =

f (ξ) ≈

∆I f "

24

6

I

donde m, 2h son el punto medio y la longitud del intervalo I , la primera versión es exacta 12 , y la

otra, en la que ∆I f " := f " (x + h) − f " (x − h) ≈ 2hf "" (ξ) , es una aproximación. ¿Cuán buena?

• Para responder a esta pregunta partimos del desarrollo de Taylor en m de f y del de f "" :

s2

s4

+ . . . + f IV (ξ)

2

4!

2

s

f "" (m + s) = f "" (m) + . . . + f IV (ξ)

2

y al integrar, usando el que una media ponderada de valores f IV (ξ) , ξ ∈ I, es otro de ellos,

!

f = 2f (m)h + 2f "" (m)h3 /3! + 2f IV (ξ1 )h5 /5!

f (m + s) = f (m) + f " (m)s + f "" (m)

I

2

h

h2

∆I f " =

6

6

y restando:

!

I

!

I

f "" =

(

h2 ' ""

2f (m)h + 2f IV (ξ2 )h3 /3!

6

'

(

f − 2f (m)h + (h2 /6)∆I f " = C1 f IV (ξ1 ) − C2 f IV (ξ2 ) h5

donde C1 = 2/5! = 1/60 , C2 = 1/18 . Por lo tanto el factor que multiplica a h5 es:

< (C1 + C2 )M4 en valor absoluto, si M4 es una cota de |f IV | en I ;

≈ (C1 − C2 )f IV (ξ) si f IV “varı́a poco en I”, y

si f ∈ P ol4 , exactamente esa constante (que es 0 si f ∈ P ol3 ).

• Conclusiones:

"

1. La fórmula que se ha restado a I f , y que llamaremos Regla del Punto Medio corregida,

funciona igual que Simpson: es exacta hasta grado 3; su error para f = x4 resulta ser 7/2 del

de Simpson: C1 − C2 = (7/2)/90 , pero con un coste computacional que es sólo la mitad de

aquel cuando ambas se usan como Reglas Compuestas: una sola evaluación de f por cada 2h

de longitud de integración, y sólo 2 evaluaciones de f " en total, puesto que los sumandos ∆I f "

de los subintervalos se convierten al sumarlos en uno solo. Esto ya da un balance positivo

frente a Simpson, puesto que un factor 2 en h introduce un factor 24 > 7/2 en el error.

2. Pero ésta no es una Regla Interpolatoria: no equivale a integrar un polinomio interpolador,

porque usa los valores de f " , pero no los de f , en los extremos de I . Es un ejemplo de cómo

pueden extenderse los polinomios interpoladores y estas Reglas de cuadratura al caso de

)

Φ : P oln → IRn+1 que sea inyectiva, o "

cualquier función lineal

Φ : P oln → IRm que se anule sólo si es I f = 0

Por ejemplo, el vector Φ(f ) = [f " (a), f " (b), f (c)] , con a &= b , sólo puede ser = 0 para un

f ∈ P ol2 si f = 0 , luego determina de modo único un polinomio de ese grado.

3. Por la relación que hay entre su error y el de Simpson, la combinación lineal

7 ∗ Simpson − 2 ∗ P M corregida

7 f (m − h) + 16 f (m) + 7 f (m + h) − h∆I f

=h

5

15

integra exactamente f = x4 , y también (x − m)5 , porque ambas Reglas lo hacen; es por

lo tanto una Regla exacta hasta grado 5, con error O(h7 ); es de hecho (ahora sı́) la Regla

Interpolatoria que usa esos 3 nodos dobles.

Pero su coste computacional como Regla Compuesta es idéntico al de Simpson, salvo por los

dos valores de f " en los extremos; y tiene, igual que Simpson, la ventaja de poder ir “reciclando”

los valores ya calculados (y sus sumas) al duplicar el número de subintervalos.

12 A

cambio de no determinar el punto ξ ; en lo que sigue, los puntos ξ ∈ I serán distintos cada vez.

7