herramienta de software para entrenar y simular redes neuronales

Anuncio

UNIVERSIDAD FRANCISCO DE PAULA SANTANDER

BIBLIOTECA EDUARDO COTE LAMUS

RESUMEN - TESIS DE GRADO

AUTORES : A LIRIO MAYORGA DELGADO Y HECTOR JULIO PEDROZA

GARZON

FACULTAD: INGENIERIAS

PLAN DE ESTUDIOS:. DE INGENIERÍA DE SISTEMAS

DIRECTOR : NANCY TORCOROMA VELÁSQUEZ

TÍTULO DE LA TESIS: HERRAMIENTA DE SOFTWARE PARA ENTRENAR Y

SIMULAR REDES NEURONALES ARTIFICIALES.

RESUMEN

El objetivo principal de la presente investigación fue recopilar y analizar la

información existente sobre las redes neuronales artificiales, contemplando

todos los aspectos relacionados con la estructura, entrenamiento y

formulación matemáticas de los diferentes algoritmos. Se siguió una

metodología precisa, acorde con el tipo de investigación, esto con el fin de

garantizar la eficacia de los resultados. La investigación concluye con la

presentación de una herramienta de software que implementa los algoritmos

más representativos, permitiendo poner en practica todos los conocimientos

CARACTERISTICAS

reunidos en 208

este documento.

PLANOS ______ILUSTRACIONES_____CD ROM 1 .

PAGINAS

CARACTERÍSTICAS

PAGINAS

208

PLANOS ______ILUSTRACIONES_____CD ROM 1 .

HERRAMIENTA DE SOFTWARE PARA ENTRENAR Y SIMULAR REDES

NEURONALES ARTIFICIALES

HECTOR JULIO PEDROZA GARZON

ALIRIO MAYORGA DELGADO

UNIVERSIDAD FRANCISCO DE PAULA SANTANDER

FACULTAD DE INGENIERIAS

PLAN DE ESTUDIOS DE INGENIERIA DE SISTEMAS

SAN JOSE DE CUCUTA

2003

HERRAMIENTA DE SOFTWARE PARA ENTRENAR Y SIMULAR REDES

NEURONALES ARTIFICIALES

HECTOR JULIO PEDROZA GARZON

ALIRIO MAYORGA DELGADO

Proyecto de grado presentado como requisito para optar

el título de Ingeniero de Sistemas

Director

NANCY TORCOROMA VELASQUEZ

Ingeniero de Sistemas

UNIVERSIDAD FRANCISCO DE PAULA SANTANDER

FACULTAD DE INGENIERIAS

PLAN DE ESTUDIOS DE INGENIERIA DE SISTEMAS

SAN JOSE DE CUCUTA

2003

Primero le doy gracias a Dios por haberme

dado esta gran oportunidad.

Dedicada especialmente a mis padres por su

gran apoyo tanto en lo económico como en lo moral.

A

mis

hermanos

por

el

apoyo

brindado

A Aleida por brindarme su amistad, su apoyo y por ser

una persona incondicional.

A mi pequeña hija por ser parte importante de mi

esperanza.

A mi amigo y compañero de tesis.

Alirio

A todos los que siempre estuvieron conmigo...

Héctor

AGRADECIMIENTOS

Los autores expresan sus agradecimientos a:

Dios, por darnos el don de ser profesionales.

Nancy Torcoroma Velásquez, Ingeniera de Sistemas y Directora del proyecto, por sus

valiosas orientaciones.

Milton Vera, por su gran orientación en el manejo y uso del lenguaje de

programación(JAVA).

Mery Yaneth Sarmiento, Ingeniera de Sistemas y Directora del grupo de investigación en

inteligencia artificial de la Universidad Francisco de Paula Santander, por su constante

motivación y apoyo en el trabajo realizado.

Los integrantes del grupo de investigación en Inteligencia Artificial (GIIA)

David Gregorio Maurello Rincón, Ingeniero de sistemas.

CONTENIDO

Pág.

INTRODUCCION

1

1

3

PLANTEAMIENTO DEL PROBLEMA

1.1 TITULO

3

1.2 FORMULACION DEL PROBLEMA

3

1.3 OBJETIVOS

4

1.3.1

Objetivo general

4

1.3.2

Objetivos específicos

4

1.4 JUSTIFICACION

5

1.5 ALCANCES Y LIMITACIONES

6

1.5.1

Alcances

6

1.5.2

Limitaciones

7

2. MARCO CONCEPTUAL

8

2.1

INTELIGENCIA ARTIFICIAL

8

2.2

LA NEURONA BIOLÓGICA

9

2.2.1

Partes de la neurona biológica

10

2.2.1.1 El cuerpo

10

2.2.1.2 Las dendritas

11

2.2.1.3 El axón

11

2.2.1.4 Las sinapsis

12

2.2.1.5 La membrana celular

12

2.2.2

Funcionamiento y comunicación interneuronal

13

2.2.3

Aprendizaje en la neurona biológica

14

LA NEURONA ARTIFICIAL

16

Elementos fundamentales

17

2.3.1.1 Sinapsis o pesos de interconexión

17

2.3.1.2 Un sumador

17

2.3.1.3 Función de activación o de transferencia

17

2.4

18

2.3

2.3.1

REDES NEURONALES ARTIFICIALES

2.4.1

Definición

18

2.4.2

Historia

18

2.4.3

Taxonomía

22

2.4.3.1 Fase de diseño

22

2.4.3.2 Fase de aprendizaje

22

2.4.3.3 Fase de prueba

22

2.4.4 Elementos de una red neuronal artificial

23

2.4.4.1 Neuronas

23

2.4.4.2 Estado de activación

23

2.4.4.3 Función de salida o de transferencia

24

2.4.4.4 Conexiones entre neuronas

27

2.4.4.5 Regla de propagación

28

2.4.4.6 Función o regla de activación

29

2.4.4.7 Regla de aprendizaje

30

2.4.4.8 Representación del ambiente

30

2.4.5 Clasificación de las redes neuronales artificiales

30

2.4.5.1 Según el mecanismo de aprendizaje

30

2.4.5.2 Según su topología

34

2.4.5.3 Según el tipo de asociación entre la información de entrada y salida

35

2.4.5.4 Según su modo de operación

36

2.4.6 Estado del arte de las redes neuronales artificiales

37

2.4.7 Aplicaciones de las redes neuronales artificiales

42

2.4.8 Ventajas y desventajas de las redes neuronales artificiales

42

3

ESTRUCTURA Y FORMULACION MATEMÁTICA DE LOS PRINCIPALES

ALGORITMOS

DE

ENTRENAMIENTO

EN

REDES

NEURONALES

ARTIFICIALES

44

3.1 RED TIPO PERCEPTRON

44

3.1.1 Perceptron básico unicapa

45

3.1.1.1 Funcionamiento

46

3.1.1.2 Estructura y aprendizaje

47

3.1.2 Perceptron multicapa

49

3.1.2.1 Funcionamiento perceptron multicapa

49

3.1.2.2 Estructura y aprendizaje perceptron multicapa

50

3.1.2.3 Problemas del perceptron multicapa

53

3.1.3 Problemas generales del perceptron

53

3.2 PROPAGACION INVERSA(BACKPROPAGATION)

54

3.2.1 Regla delta generalizada

55

3.2.1.1 Momentun en la regla delta generalizada

55

3.2.2 Funcionamiento

55

3.2.2.1 Fase hacia delante

56

3.2.2.2 Fase hacia atrás

57

3.2.3 Estructura y aprendizaje

57

3.2.4 Importancia

62

3.2.5 Problemas generales

62

3.3 ALGORITMO DE KOHONEN

65

3.3.1 Funcionamiento

65

3.3.2 Estructura y aprendizaje

67

3.4 MEMORIAS ASOCIATIVAS

70

3.4.1 Red de hopfield

71

3.4.1.1 Funcionamiento

73

3.4.1.2 Aprendizaje de la red de hopfield

75

3.4.1.3 Estabilidad y función de energía

78

3.4.1.4 Algoritmo secuencial (Asíncrono)

79

3.4.1.5 Algoritmo paralelo (Sincrono)

80

3.4.1.6 Problemas de la red de hopfield

82

3.4.2 Memorias asociativas bidireccionales BAM

83

3.4.2.1 Funcionamiento

83

3.4.2.2 Aprendizaje

85

3.4.2.3 Capacidad de memoria en la red BAM

85

3.5 ALGORITMOS GENETICOS

86

3.5.1 Historia

86

3.5.2 Definición

86

3.5.3 Clases de algoritmos genéticos

87

3.5.4 Funcionamiento

88

3.5.5 Componentes y características

90

3.5.5.1 Problema a ser optimizado

90

3.5.5.2 Representación de las soluciones del problema

90

3.5.5.3 Decodificación del cromosoma

91

3.5.5.4 Evaluación

91

3.5.5.5 Selección

91

3.5.5.6 Operadores genéticos

94

3.5.5.7 Inicialización de la población

95

3.5.5.8 Parámetros y criterios de parada

95

3.5.6 Fundamentos matemáticos

96

3.5.6.1 Análisis del efecto de la selección

97

3.5.6.2 Análisis del efecto de cruce

98

3.5.6.3 Análisis del efecto de mutación

98

3.5.7 Aprendizaje

99

3.6 SISTEMAS DIFUSOS

100

3.6.1 Conjuntos difusos

100

3.6.2 Lógica difusa

101

4. ARQUITECTURA DEL SISTEMA EN LA METODOLOGIA OMT

103

4.1 ANALISIS ORIENTADO A OBJETOS

103

4.1.1 Del problema

103

4.1.1.1 Formulación del problema

103

4.1.1.2 Descripción del problema

103

4.1.2 Modelado de objetos

104

4.1.2.1 Objetos y clases

105

4.1.2.2 Diccionario de datos

106

4.1.2.3 Identificación de asociaciones

108

4.1.2.4 Atributos identificativos

109

4.1.3 Modelado dinámico

110

4.1.3.1 Escenarios

111

4.1.3.2 Identificación y seguimiento de sucesos

135

4.1.3.3 Diagramas de estado

145

4.1.4 Modelo funcional

150

4.1.4.1 Listado de valores de entrada y de salida

151

4.1.4.2 Diagramas de flujo de datos (DFD)

151

4.2 DISEÑO ORIENTADO A OBJETOS

155

4.2.1 Diseño del sistema

155

4.2.1.1 Identificación de la concurrencia

155

4.2.1.2 Asignación de subsistemas a procesadores y tareas

155

4.2.1.3 Administración de almacenes de datos

156

4.2.1.4 Manejo de recursos globales

156

4.2.1.5 Selección de una implementación de control de software

157

4.2.1.6 Manejo de condiciones de contorno

158

4.2.1.7 Arquitectura del sistema

159

4.2.2 Diseño de objetos

160

4.2.2.1 Visión general del diseño de objetos

160

4.2.2.2 Diseño de algoritmos para los métodos de las clases

161

4.2.2.3 Diagrama de control en el sistema Intelligent Spider

170

4.3 IMPLEMENTACION Y PRUEBAS

171

4.3.1 IMPLEMENTACION

171

4.3.2 PRUEBAS

177

5. CONCLUSIONES

178

6. RECOMENDACIONES

180

BIBLIOGRAFIA

181

ANEXOS

184

LISTA DE FIGURAS

Pág.

Figura 1. Partes de una neurona biológica

10

Figura 2. Coincidencia pre-post, ley de Hebb

15

Figura 3. Coincidencia pre-moduladora.

16

Figura 4. Esquema típico de la neurona artificial

16

Figura 5. Función de transferencia limitador fuerte

24

Figura 6. Función de transferencia lineal

25

Figura 7. Función de transferencia sigmoidal

26

Figura 8. Función tangente hiperbólica

26

Figura 9. Conexiones entre elementos de la misma capa

27

Figura 10. Conexiones entre elementos de diferente capa

28

Figura 11. Conexiones recurrentes

28

Figura 12. Estructura perceptron unicapa

46

Figura 13. Estructura del perceptron multicapa

49

Figura 14. Estructura algoritmo propagación inversa

54

Figura 15. Problema de los mínimos locales

64

Figura 16. Estructura red de kohonen

67

Figura 17. Modelo de red de hopfield

71

Figura 18. Estructura 1 de las memorias asociativas bidireccionales

83

Figura 19. Estructura 2 de las memorias asociativas bidireccionales

84

Figura 20. Diagrama algoritmos genéticos

89

Figura 21. Modelo de objetos de herramienta de software entrenador de redes

neuronales

104

Figura 22. Seguimiento de sucesos para escenario principal del sistema

136

Figura 23. Sucesos para escenario perceptron

137

Figura 24. Sucesos para escenario propagación inversa

138

Figura 25. Sucesos escenario hopfield

139

Figura 26. Sucesos escenario kohonen

140

Figura 27. Sucesos escenario memorias asociativas

141

Figura 28. Sucesos escenario algoritmos genéticos

142

Figura 29. Sucesos escenario generar código

143

Figura 30. Sucesos escenario propagar patrones

144

Figura 31. Diagrama de estados escenario principal del sistema

146

Figura 32. Diagrama de estados escenario perceptron

147

Figura 33. Diagrama de estados escenario propagación inversa

148

Figura 34. Diagrama de estados escenario hopfield

149

Figura 35. Diagrama de estados escenario propagar patrones

150

Figura 36. Listado de valores de entrada y de salida

151

Figura 37. Diagrama de flujo de datos del nivel más general para el sistema

intelligent spider

152

Figura 38. Diagrama de flujo de datos para el proceso establecer enlace

152

Figura 39. Diagrama de flujo de datos para el proceso seleccionar algoritmo

153

Figura 40. Diagrama de flujo de datos para el proceso propagar

153

Figura 41. Diagrama de flujo para el proceso entrenar

154

Figura 42. Diagrama de flujo de datos para el proceso registrar valores

154

Figura 43. Arquitectura del sistema entrenador de redes neuronales artificiales

160

Figura 44. Modelo de objetos optimizado para la herramienta de entrenamiento de

redes neuronales artificiales

161

Figura 45. Diagrama de control para el sistema intelligent spider

170

LISTA DE CUADROS

Pág.

Cuadro 1. Características de los tipos de redes neuronales mas importantes en la

historia

21

Cuadro 2. Paradigmas de aprendizaje y algoritmos mas conocidos

31

LISTA DE ANEXOS

Pág.

Anexo A. Manual de usuario

185

Anexo B. Detalles técnicos

199

Anexo C. Encuesta

206

INTRODUCCION

El propósito fundamental de los sistemas basados en redes neuronales es mantener un

control centralizado de varias funciones, aplicando mecanismos de aprendizaje que imiten

el comportamiento de los seres humanos para lograr la autonomía y eficiencia que los

caracteriza.

Estos sistemas, actualmente son utilizados en el manejo y control de funciones sensoriales

artificiales, para hacer que las maquinas puedan ver, oír y tomar decisiones sobre diferentes

fenómenos; para lograr esto, se requiere la integración de diferentes tecnologías(hardware

y software) y las más modernas técnicas de representación y gestión del conocimiento.

A lo largo de los últimos 30 años se han venido desarrollando métodos y técnicas en

inteligencia artificial, y aunque los resultados obtenidos son en gran parte satisfactorios; se

espera que el desarrollo de nuevas tecnologías y la masificación del paralelismo a nivel de

circuitos computacionales den un nuevo auge al estudio de esta rama de la ciencias

computacionales.

Para comprender el funcionamiento de las redes neuronales artificiales se necesita estudiar

el funcionamiento biológico del cerebro humano, ya que este es la base de los diferentes

modelos matemáticos que tratan de simular las características propias de la inteligencia

humana. En este documento se explica detalladamente el paralelo entre neurona biológica

2

y neurona artificial a nivel de estructura, funcionamiento y modo de aprendizaje para luego

llevar al lector hacia el concepto de red neuronal artificial, realizando un breve recorrido de

su historia y aportes en la inteligencia artificial, destacando las áreas donde se han aplicado,

los trabajos y autores mas importantes, realizando un análisis de las características y

ventajas que ofrece esta tecnología con respecto a los métodos convencionales y a otras

técnicas de inteligencia artificial.

Esta investigación profundiza sobre los algoritmos de: perceptron, propagación inversa,

hopfield, kohonen, memorias asociativas y algoritmos genéticos haciendo énfasis en las

formulas matemáticas que dan soporte a cada uno de ellos, estos algoritmos son

considerados los mas relevantes en el proceso de aprendizaje de las redes neuronales

artificiales, para cada uno de ellos se explica el origen, funcionamiento, ventajas,

aplicaciones y problemas, manteniendo un lenguaje claro y unificado para representar los

procesos.

Este trabajo concluye con la presentación de una herramienta de apoyo para el estudio de

las redes neuronales artificiales, su diseño la hace apropiada tanto para principiantes como

expertos interesados en desarrollar aplicaciones basadas en esta tecnología.

1. PLANTEAMIENTO DEL PROBLEMA

1.1 TITULO

HERRAMIENTA DE SOFTWARE PARA ENTRENAR Y SIMULAR REDES

NEURONALES ARTIFICIALES.

1.2 FORMULACION DEL PROBLEMA

Las redes neuronales artificiales son un tema complejo. Requieren mucha investigación,

paciencia, dedicación e ingenio de parte de aquellos interesados en usarlas como alternativa

para solucionar problemas donde el computo tradicional ha tenido gran dificultad durante

años.

Para entender, que son las redes neuronales artificiales, como funcionan y en que se

aplican se hace necesario reunir y procesar una gran cantidad de información, que en

nuestro medio se encuentra dispersa, es compleja y muchas veces errada. Además no se

cuenta con talento humano capacitado y experimentado en el área, que este en capacidad de

guiar y resolver dudas en eventuales procesos investigativos que sobre esta área se pueden

desarrollar.

El material bibliográfico que sobre el particular se consigue carece de

profundidad, dificultando la comprensión del verdadero sentido y potencial de la

computación inteligente; igualmente ocurre con las herramientas de apoyo que hasta el

momento se han desarrollado, las cuales presentan serias limitaciones obligando a sus

4

usuarios a moldear sus necesidades de acuerdo a las alternativas ofrecidas, lo cual va en

contra de la particularidad de cada problema.

1.3 OBJETIVOS

1.3.1 Objetivo general. Diseñar una herramienta de software que permita entrenar y

simular Redes Neuronales Artificiales.

1.3.2 Objetivos específicos.

Realizar una búsqueda bibliográfica actualizada acerca del estado del arte en las

redes neuronales y los métodos usados para su modelación y entrenamiento, esto

con el fin de generar documentación formal acerca del área de estudio.

Diseñar un sistema computacional que cumpla con las características necesarias

para modelar redes neuronales artificiales teniendo en cuenta las diferentes

aplicaciones que se pueden tratar.

Desarrollar un software que permita entrenar redes neuronales artificiales para

cualquier aplicación respondiendo a las exigencias de la puesta en marcha del

sistema.

Comprobar la eficacia del sistema a través de la evaluación de los resultados

obtenidos.

5

Utilizar una metodología orientada a objetos para el diseño y el desarrollo del

software.

Servir de base a las investigaciones, que en redes neuronales artificiales, se vienen

realizando en la Universidad Francisco de Paula Santander.

1.4 JUSTIFICACIÓN

La Universidad Francisco de Paula Santander no cuenta con herramientas apropiadas para

el desarrollo de investigaciones en el área de inteligencia artificial, y aunque estas se

pueden conseguir en el mercado su costo es muy elevado y no ofrecen soluciones

completas, sino, por el contrario muy particulares de acuerdo a problemas específicos,

predeterminando el método de solución y limitando al usuario a enfocar su investigación en

el mismo sentido que la herramienta propone.

Esta herramienta de software se crea para brindar apoyo a las investigaciones que se

vienen realizando en el área de inteligencia artificial y que prevén el uso de redes

neuronales como parte de su desarrollo. Es base fundamental para llevar a cabo algunas de

las etapas trazadas en los dos macroproyecto que se están desarrollando al interior del

grupo de investigación en inteligencia artificial(GIIA).

Teniendo en cuenta las observaciones hechas en el proceso de acreditación del plan de

estudios de Ingeniería de Sistemas donde se sugiere la iniciación de procesos investigativos

en diferentes áreas, esta herramienta sirve de apoyo a la investigación en el área de

6

inteligencia artificial, proporcionando un soporte a estudiantes y docentes involucrados en

las materias electivas referentes a “inteligencia artificial”, “redes neuronales artificiales”,

“sistemas expertos” e “imágenes y robótica”.

1.5 ALCANCES Y LIMITACIONES

1.5.1 Alcances.

Presentación de documentación formal de las diferentes arquitecturas y algoritmos

de entrenamiento para redes neuronales artificiales.

Estudio matemático de las formulas que representan los diferentes tipos de redes

neuronales.

Para el diseño y programación de la herramienta de software se utilizara una

metodología orientada a objetos, este sistema se realizará en lenguaje de

programación Java garantizando así la concurrencia lógica de procesos a través de

la programación de hilos y a demás la capacidad para funcionar en un entorno de

red.

Apoyo al plan de capacitación para los integrantes del grupo de investigación en el

área de Inteligencia Artificial, dicho plan estará respaldado por manuales técnicos y

de usuario.

7

1.5.2 Limitaciones.

Se seleccionaran las arquitecturas y algoritmos mas relevantes en el diseño y

entrenamiento de redes neuronales.

No todos los problemas de aplicación se pueden solucionar con redes neuronales

debido a que no funcionan correctamente.

En la formalización del conocimiento se usaran reglas de producción.

Para la simulación de las Redes Neuronales no se utilizará un software de monitoreo

especial.

Se va a utilizar el mismo software creado y este incluye el

comportamiento de la red para el problema planteado.

2. MARCO CONCEPTUAL

2.1 INTELIGENCIA ARTIFICIAL

Es una rama de la ciencia de la computación que permite a las máquinas extraer y

automatizar el comportamiento de los seres inteligentes, mediante la implementación de

algoritmos matemáticos.

La inteligencia artificial a través de módulos computacionales puede ser aplicada en

procesos tales como: la percepción, comprensión del lenguaje natural, aprendizaje, juegos,

demostración de teoremas, sistemas expertos, robótica y en la solución de problemas en

general.

Historia. Los primeros pasos de la inteligencia artificial datan del 3.000 antes de cristo,

con la creación de un sistema lógico para diagnóstico de enfermedades. En 1651 un libro de

Hobbes habla de el futuro uso de las máquinas en el desarrollo de una inteligencia más

poderosa poco antes de que Pascal inventase la primera calculadora.

Después de la segunda guerra mundial aparece la rama científica de la inteligencia

artificial. En 1956, John McCarthy dio nombre a la ciencia en una conferencia en Vermont

orientada a atraer a otros científicos, que juntos sentarían las bases para el futuro desarrollo

en inteligencia artificial.

9

En 1957, ya se había desarrollado el general problem solver(GPS) . Un año después,

McCarthy desarrolló el lenguaje de programación LISP, que aún se utiliza actualmente.

Poco después se separaron lo que se consideran las dos ramas de la inteligencia artificial;

por un lado el desarrollo de algoritmos que se comportasen de forma inteligente y por otro

el conexionismo o redes de neuronas artificiales.

En la actualidad, se tienen programas que analizan oraciones sintacticamente, que pintan,

que escriben cuentos, que hacen música clásica,

coches que conducen solos, y las

tecnologías de redes neuronales que ya están siendo utilizadas por bancos para sustituir a

las tarjetas de crédito en los cajeros reconociendo rasgos como la pupila de los clientes

(sistemas de biometría).

2.2 LA NEURONA BIOLOGICA

Definición. La neurona es el bloque fundamental de construcción del sistema nervioso,

capaz de recibir y transmitir información, es una célula similar a otras células del cuerpo

humano con ciertas especializaciones. Todas las neuronas están constituidas por las mismas

partes básicas, así como las mismas subdivisiones anatómicas independientemente del

tamaño y forma de la misma.

Se estima que en cada milímetro del cerebro hay cerca de 50.000 neuronas, conteniendo en

total más de cien mil millones de neuronas y sinapsis en el sistema nervioso humano.

Según los trabajos en investigación y ciencia realizados por el español Ramón y Cajal, la

neurona no es una masa continua sino una red de unidades discretas.

10

2.2.1 Partes de la neurona biológica

Figura 1. Partes de la neurona biológica

2.2.1.1 El cuerpo. El cuerpo de la célula es el que recibe y suma todas las señales

eléctricas de entrada que provienen de las dendritas.

La actividad de mantenimiento de las células se lleva a cabo en el cuerpo, donde una

fábrica química construye una variedad de moléculas. El cuerpo también controla la

energía de la neurona y regula otras actividades.

11

La capa externa del cuerpo tiene la capacidad única de generar impulsos nerviosos, lo cual

es considerado como una función vital.

El diámetro del cuerpo según los estudios

realizados oscila entre 5 a 100 micras.

2.2.1.2 Las dendritas. Las dendritas, son la vía de entrada de las señales que se combinan

en el cuerpo de la neurona. Son ramas que salen del cuerpo, las cuales poseen conexiones

sinápticas en donde se reciben señales que generalmente vienen de otros axones. Hay un

número significativo de conexiones sinápticas como lo son de axón a axón, axón a cuerpo y

dendrita a dendrita.

A diferencia de los circuitos eléctricos comunes, no hay conexión física en las sinapsis, sino

que un espacio separa los químicos especiales que son liberados por el axón y se transmiten

hacia la dendrita; estos químicos se llaman neurotransmisores. Algunos neurotransmisores

son “activadores” y otros son “inhibidores”.

2.2.1.3 El axón. El axón es una fibra que lleva la señal desde el cuerpo de la célula hacia

otras neuronas. El axón puede ser tan corto como 0.1 mm ó tan largo como 1 metro.

El axón tiene varias ramas cerca de la punta, cada una terminando con una sinapsis desde

donde la señal se trasmite, así la neurona puede generar pulsos que pueden activar o inhibir

otras neuronas(cientos o miles), las cuales a su vez son activadas por cientos o miles de

otras neuronas. De esta manera es como la conectividad de las neuronas, más que su

complejidad funcional, da la capacidad de procesamiento al cerebro humano.

12

2.2.1.4 Las sinapsis. Son las unidades funcionales y estructurales elementales que median

entre las interacciones de las neuronas. En las terminaciones de las sinapsis se encuentran

vesículas que contienen sustancias químicas llamadas neurotransmisores, que ayudan a la

propagación de las señales electroquímicas de una neurona a otra.

La conexión sináptica es un pequeño bulbo que contiene estructuras esféricas llamadas

vesículas sinápticas, algunas neuronas que han sido activadas muy débilmente transmiten

ciertos signos electromagnéticos a través de su interior con cierta respuesta; podemos decir

que son "locales" pues el impulso muere después de cierta distancia.

2.2.1.5 La membrana celular. Permite a la célula la transmisión de señales, siendo la

comunicación cerebral de dos tipos: química a través de las sinapsis y eléctrica dentro de la

neurona.

La maravillosa y compleja acción de la membrana celular crea en la célula la habilidad de

producir y transmitir aún ambos tipos de señales. La membrana celular tiene cerca de 5

nanómetros de espesor y consiste de dos capas de moléculas con lípidos.

En la membrana existen varios tipos de proteínas que se pueden clasificar en 5 grupos:

bombas, canales, receptores, enzimas y proteínas estructurales.

Las bombas mueven iones a través de la membrana para mantener concentraciones.

13

Los canales permiten selectivamente el paso de iones y controlan un flujo a través

de la membrana. Algunos canales se abren o cierran dependiendo del potencial

eléctrico de la membrana, otros se controlan químicamente.

Los receptores reconocen y unen varios tipos de moléculas y son muy específicos.

Las enzimas en las membranas aceleran una gran variedad de reacciones químicas.

2.2.2 Funcionamiento y comunicación intraneuronal. En la transmisión el mensaje (que

es un impulso nervioso de carácter eléctrico) es conducido a través del cuerpo celular a lo

largo del axón hasta el botón sináptico para liberar alguna sustancia transmisora. La

neurona tiene un medio interno y un medio externo, tanto fuera como dentro tiene iones

positivos y negativos, aunque cada medio suele tener una mayor concentración de iones, así

el medio interno tiende a ser negativo y el medio externo a ser positivo; de tal forma que el

medio externo de la neurona lo constituyen fundamentalmente sodio y cloro y en el medio

interno potasio (K+) y aniones (A-).

La concentración de sodio en una neurona es 10 veces más baja que en sus alrededores y la

concentración de potasio es 10 veces más alta. Estas concentraciones tienden a nivelarse

por medio de "fugas" en la célula, debido a poros en las membranas.

Para mantener las concentraciones una proteína llamada "bomba de sodio" continuamente

saca sodio de la célula y mete potasio. Se pueden mover cientos de millones de iones de

potasio por segundo. La combinación de estos dos químicos es responsable de crear y

14

mantener el equilibrio dinámico químico que constituye el estado de reposo de una

neurona.

La concentración iónica causa que en el interior de la célula se genere un potencial de -70

milivoltios con respecto a sus alrededores; para que la célula se "encienda" o sea activada,

las entradas sinápticas deben reducir este nivel a aproximadamente -50 milivoltios, cuando

esto ocurre, los niveles de sodio y potasio se invierten repentinamente, en un milisegundo el

interior de la célula se vuelve 50 milivoltios positivo con respecto al medio ambiente

externo. Este cambio de polaridad se transmite a través del axón y sus conexiones. Cuando

el pulso llega a la terminal del axón, se abren canales de calcio con voltaje controlado, esto

acciona la liberación de moléculas neurotransmisoras y el proceso continúa a otras células;

después de generar un potencial, la célula entra en un período de varios milisegundos en el

cual regresa a su estado de reposo en preparación para otro pulso. Se cree que más de 30

sustancias trabajan como neurotransmisores, un mismo neurotransmisor puede ser activador

en una sinapsis e inhibidor en otra.

2.2.3 Aprendizaje en la neurona biológica. Según el psicólogo canadiense Donald O.

Hebb(1949), el aprendizaje en las neuronas ocurre por la actividad neuronal coincidente,

esto se conoce como la ley de Hebb o aprendizaje Hebbiano. “Cuando el axón de la célula

A excita la célula B y repetidamente toma lugar en su activación, ocurre algún proceso de

crecimiento o cambio metabólico en una o ambas células tal que la eficacia de A, como

una de las células que dispara a B, se incrementa.” Según la regla de aprendizaje de Hebb,

la actividad coincidente en las neuronas presináptica y postsináptica es crítica para

15

fortalecer la conexión entre ellas; según Hebb este proceso se denomina mecanismo

asociativo pre-post.

Figura 2. Coincidencia pre-post, ley de Hebb

Para Hebb la neurona biológica debe su peculiaridad de procesamiento de la información a

la capacidad de autoorganización que ellas tienen.

En el año 1993 Ladislav Tauc y Eric Kandel propusieron una segunda regla de aprendizaje

en la cual la conexión sináptica entre dos neuronas se puede fortalecer sin actividad de la

célula postsináptica, mediante una tercera neurona llamada neurona moduladora la cual

incrementa la liberación del neurotransmisor de la célula presináptica.

16

Figura 3. Coincidencia pre-moduladora.

2.3 LA NEURONA ARTIFICIAL

Definición. Es la que intenta mimetizar las características más importantes de la neurona

biológica, siendo esta el elemento básico de procesamiento de la red neuronal artificial.

El funcionamiento de una neurona artificial, básicamente consiste en aplicar un conjunto de

entradas, cada una representando la salida de otra neurona, o una entrada del medio

externo, realizar una suma ponderada con estos valores, y "filtrar" este valor a través de una

función matemática llamada función de activación[9,11,21].

Figura 4. Esquema típico de la neurona artificial

17

El cuerpo de la neurona es a menudo representado por la suma ponderada de las entradas,

seguida por una función lineal o no lineal, llamada función de activación que usa los

valores de entrada para determinar la actividad de la neurona. La eficiencia sináptica es

representada por los "pesos de interconexión".

2.3.1 Elementos fundamentales

2.3.1.1 Sinapsis o pesos de interconexión. Representan la fuerza de interconexión entre

las neuronas, y pueden ser positivos(excitatorios) o negativos(inhibitorios); además pueden

ser fijos o adaptables. Las redes con pesos adaptables usan leyes de aprendizaje para ajustar

los valores de la fuerza de interconexión. Si la red neuronal usa pesos fijos las tareas a ser

ejecutadas deben estar bien definidas.

2.3.1.2 Un sumador. El cual produce la suma ponderada de las entradas de acuerdo a los

correspondientes pesos de las conexiones.

2.3.1.3 Función de activación o de transferencia. Tiene como misión limitar la amplitud

de la salida generada por la neurona.

Existen distintos tipos de redes neuronales con diferentes funciones de activación, pero la

estructura interna de la neurona, es común en la mayoría de las redes. La elección de la

función de activación junto con la forma de ponderación determinan las características de la

neurona artificial.

18

2.4 REDES NEURONALES ARTIFICIALES

2.4.1 Definición. Las redes neuronales artificiales son redes interconectadas masivamente

en paralelo de elementos simples, con organización jerárquica, los cuales intentan

interactuar con los objetos del mundo real del mismo modo que lo hace el sistema nervioso

biológico del ser humano[3,11,15,16,34].

Las redes neuronales son consideradas modelos analógicos que tienen como su principal

objetivo reproducir en la medida de lo posible las características y la capacidad de

procesamiento de información del conjunto de neuronas presentes en el cerebro de los seres

vivos; con características importantes como lo es la robustez, tolerancia a fallos, capacidad

de adaptación, aprendizaje y la capacidad de procesar información defectuosa[16,17].

2.4.2 Historia. Las redes neuronales no son un concepto nuevo, la idea de una red

neuronal fue originalmente concebida como un intento por modelar la fisiología del

cerebro. El objetivo era crear un modelo capaz de realizar procesos del pensamiento

humano; muchos de los primeros trabajos fueron realizados por filósofos, psicólogos y

fisiólogos.

Las primeras explicaciones teóricas sobre el cerebro humano fueron dadas por algunos

antiguos filósofos griegos, como Platón y Aristóteles. En este orden de ideas también

aportaron Descartes(1596-1650) y los filósofos empiristas del siglo XVIII.

19

El primero en estudiar el cerebro humano a partir de un análisis neuronal fue William

James(1890), cuya afirmación "la actividad de un punto en la corteza cerebral(neurona) es

modelada por la suma ponderada de las entradas", sirvió de base para el trabajo realizado

por Warren McCulloch, un neurofisiólogo, y Walter Pitts, un matemático, quienes en 1943

lanzaron una teoría para modelar la actividad nerviosa del cerebro, el que hasta hoy sirve

como fundamento para la construcción de muchas redes neuronales.

Otra importante obra que habla sobre el inicio de las redes neuronales y titulada “La

organización del comportamiento” fue escrita por Donald Hebb en 1949.

Para el año de 1957 aparece una de las primeras redes neuronales conocidas, la cual se

llamaba “Perceptron” , cuyo creador fue Frank Rosenblatt; cuyo modelo era capaz de

generalizar; es decir, después de haber sido entrenada con ciertos patrones este modelo de

red era capaz de reconocer otros similares a los ya aprendidos.

En el año de 1959 fue desarrollada la primer red neuronal aplicable a problemas reales,

cuyo nombre fue “Adaline” y desarrollada por Bernard Widrow y Marcial Hoff.

seguidamente en 1967 se presento un trabajo realizado por uno de los más considerados

investigadores de las redes neuronales, Stephen Grossberg, cuyo modelo de red se llamo

“Avalancha” y su objetivo era el reconocimiento continuo del habla y el aprendizaje de los

movimientos de los brazos en los robots.

20

En 1977 James Anderson diseño un modelo lineal llamado “Asociador lineal”; también

para ese mismo año el ingeniero electrónico de la universidad de Helsinki Teuvo Kohonen

desarrollo un modelo muy similar al de Anderson. Para el año de 1980 el

japones Kunihiko Fukushima desarrollo un modelo de red neuronal para el reconocimiento

de patrones llamado “El Neocognitrón” .

En 1982 en la academia nacional de las ciencias John Hopfield presentó su trabajo, una red

neuronal que lleva su mismo nombre “Red de Hopfield”.

Para 1985, el Instituto Americano de física comenzó lo que ha sido la reunión anual

“Neural Network for Computing”, en 1987 se formó la “Internatonal Neural Networks

Society(INNS), bajo la dirección de Grossberg, Kohonen y Amari, en 1988 se da la unión

del IEEE y de la INNS. La “International Joint Conference on Neural Network (IJCNN)”,

en 1991 nace en europa la “International Conference on Artificial Neural Networks

(ICANN).

Actualmente existen dos grandes tendencias en el estudio de las redes neuronales. Un

primer grupo compuesto por los biólogos, físicos y psicólogos, los cuales trabajan en el

desarrollo de modelos que imiten el comportamiento del cerebro.

El segundo grupo consiste de ingenieros que poseen el conocimiento del cómo estas

neuronas artificiales pueden ser interconectadas para formar redes con poderosas

capacidades computacionales. Estos últimos utilizan los modelos biológicos desarrollados

por el primer grupo como punto de partida de sus investigaciones[9,16,18].

21

Cuadro 1. Características de los tipos de redes neuronales más importantes en la historia

Nombre de la red

Año

Perceptron

1957

ADALINE/MADALINE

1960

Avalancha

1967

Cerebellatron

1969

Backpropagation

1974

1985

Brain-Estate-in-a-Box

1977

Neocognitron

1978

1984

1980

1984

Self-Organizing-Map

(SOM).

Topology Preserving Map

(TPM)

Hopfield

Memoria asociativa

bidireccional

Maquinas de Boltzman y

Cauchy

Teoría resonancia

adaptativa (ART)

Counter-propagation

Aplicaciones más

importantes

Reconocimiento de

caracteres impresos

Filtrado de señales,

Ecualizador adaptativo

Reconocimiento de

habla Continua

Control del movimiento

de los brazos de un

robot

Síntesis de voz, Control

de robots,

Reconocimiento de

patrones

Extracción de

reconocimiento de bases

de datos

Reconocimiento de

caracteres manuscritos

Reconocimiento de

patrones, Codificación

de datos, Optimización

1982 Reconstrucción de

patrones y optimización

1985 Memoria heteroasociativa

1985 Reconocimiento de

1986 patrones, Optimización

1986 Reconocimiento de

patrones

1986 Comprensión de

imágenes

Inventada/desarrollada

por

Frank Rosenblatt

Bernard Widrow

Stephen Grossberg

David Marr, James Albus,

Andres Pellionez

Paul Werbos, David

Parker, David Rumelhart

James Anderson

K. Fukushima

Teuvo Kohonen

John Hopfield

Bart Kosko

Jeffrey Hinton, Terry

Sejnowski, Harold Szu

Gail Carpenter, Stephen

Grossberg

Robert Hecht-Nielsen

22

2.4.3 Taxonomía. En el desarrollo de aplicaciones basadas en redes neuronales artificiales

se pueden distinguir tres fases: diseño, aprendizaje y pruebas.

2.4.3.1 Fase de diseño. Constituye la fase inicial y la mas importante de todas ya que de

un buen diseño depende el desempeño de la red. En esta etapa se hace un conocimiento del

problema para extraer cuales son los patrones mas representativos que se utilizaran como

entrada a la red neuronal, y que a partir de estos empieza el proceso de entrenamiento.

Además, en esta fase se debe seleccionar el algoritmo, la estructura y configuración mas

adecuadas de la red neuronal.

2.4.3.2 Fase de aprendizaje. Durante esta fase la red es entrenada para que vaya

modificando sus pesos sinápticos, adaptándolos paulatinamente para que la respuesta de la

red sea correcta.

Una de las características más importantes de las redes neuronales artificiales es su

capacidad de aprendizaje, dado mediante la actualización o cambio de los pesos sinápticos

propios de las conexiones.

2.4.3.3 Fase de prueba. En esta fase se evalúan los resultados obtenidos después de una

o más iteraciones, estos resultados

pueden ser calculados inmediatamente, así como

adaptados iterativamente según el tipo de red neuronal y según la función de ecuaciones

dinámicas de prueba utilizadas; después de una iteración se comparan los valores de las

neuronas de la última capa con los valores deseados, y así determinar la validez del diseño.

23

2.4.4 Elementos de una red neuronal artificial. Suele considerarse que todo modelo de

red neuronal queda caracterizado por la especificación de ocho aspectos o elementos

básicos[16,17,48].

2.4.4.1 Neuronas. Son el conjunto de elementos simples e interconectados que procesan

la información, y que suelen disponerse en capas o niveles estructurados jerárquicamente.

Se caracterizan tres tipos de neuronas según su disposición en el modelo: neuronas de

entrada, neuronas de salida y neuronas ocultas.

Las neuronas de entrada reciben las señales del entorno, las cuales pueden ser

señales provenientes de sensores o de otros sectores del sistema.

Las neuronas de salida son las encargadas de enviar las señales fuera del sistema.

Las neuronas ocultas son aquellas cuyas entradas y salidas se encuentran dentro del

sistema, sin contacto con el exterior.

2.4.4.2 Estado de activación. Toda neurona en una red neuronal se encuentra en uno de

dos estados posibles, reposo y excitado, cada uno de los cuales tiene asignado un valor.

Los valores de activación pueden ser discretos o continuos, además pueden ser limitados o

ilimitados.

24

2.4.4.3 Función de salida o de transferencia. Existen cuatro funciones de transferencia

típicas que determinan el valor de salida o la respuesta de cada neurona.

Limitador fuerte. Se asocia a neuronas binarias en las cuales, cuando la suma de

sus entradas es mayor o igual que el umbral de la neurona, la activación es uno (1);

si es menor la activación es menos uno(-1).

Figura 5. Función de transferencia limitador fuerte

25

Función lineal. La salida de una función de transferencia lineal es igual a su

entrada.

a = n

Figura 6. Función de transferencia lineal

Función sigmoidal. Esta función toma los valores de entrada, los cuales pueden

oscilar entre mas y menos infinito, y restringe la salida a valores entre cero y uno,

de acuerdo a la expresión siguiente:

f(n) =

1

1+ e − n

Esta función es comúnmente usada en redes multicapa, como la Backpropagation,

en parte porque la función logística o sigmoidal es diferenciable.

26

Figura 7. Función de transferencia sigmoidal

Función tangente hiperbólica o gaussiana. Esta dada por la siguiente ecuación.

f(n) =

e n − e −n

e n + en

Figura 8. Función tangente hiperbólica

La función tangente hiperbólica es simétrica en el origen, y a diferencia de la función

sigmoidal, la tangente hiperbólica produce valores negativos, lo cual es útil en algunos

27

modelos, especialmente cuando utilizamos valores negativos para los pesos iniciales de la

red [35].

2.4.4.4 Conexiones entre neuronas. El esquema de interconexión es lo que define a la

arquitectura de una red neuronal artificial, es el que indica como se propagará la señal

desde un elemento procesador a otro o hacia sí mismo; dichas interconexiones son

unidireccionales y tienen un peso asociado para cada conexión, estos pesos forman la

memoria de la red.

Las conexiones excitatorias, usualmente señales positivas o cercanas a 1, aumentan el valor

de entrada al elemento procesador, mientras que las conexiones inhibitorias decrementan el

valor.

Tres diferentes esquemas de interconexión entre los elementos procesadores en una red

neuronal son:

Conexiones entre elementos procesadores de la misma capa.

Figura 9. Conexiones entre elementos de la misma capa

Conexiones entre elementos procesadores de diferente capa.

28

Figura 10. Conexiones entre elementos de diferente capa

Conexiones recurrentes que conectan a un elemento procesador consigo mismo

Figura 11. Conexiones recurrentes

Si la información fluye en una dirección, las conexiones son llamadas de propagación hacia

adelante. La realimentación permite que la información fluya entre elementos procesadores

en ambas direcciones y/o recursivamente[16,46].

2.4.4.5

Regla de propagación. Combina las salidas de cada neurona con las

correspondientes ponderaciones establecidas por el patrón de conexión para especificar de

esta forma cómo se evaluaran las entradas que reciba cada neurona. El efecto global sobre

una neurona de todas las demás neuronas suele considerarse aditivo y constituye la llamada

entrada neta o potencial post-sináptico. Todas las entradas ponderadas por los pesos que

29

recibe una unidad constituyen la entrada neta que determinará la activación de la neurona a

través de una función de activación[48].

2.4.4.6 Función o regla de activación. El grado de activación de cada elemento de una

red neuronal artificial determina la presencia o ausencia de señal en sus conexiones de

salida, este grado de activación está dado en función de la suma de sus entradas.

La contribución de un elemento a la entrada de otro puede representarse como el producto

de su grado de activación por el peso de su conexión. Existe la posibilidad de establecer

conexiones de retroalimentación, que básicamente trabajan con el grado de activación

previo del elemento en cuestión.

La regla de activación combina las entradas con el estado actual de la neurona, para

producir un nuevo estado de activación en la neurona, a partir de un estado que ya existía y

la combinación de las entradas con los pesos de las conexiones.

La salida obtenida en una neurona para las diferentes formas de la función de activación

son evaluadas por las siguientes funciones de filtrado[16,17,46]:

función lineal

función Limitador Fuerte

función sigmoidal

función tangente hiperbólica

30

2.4.4.7 Regla de aprendizaje. La regla de aprendizaje consiste en el procedimiento por el

cual se procederá a la modificación del patrón de conexión en función de la experiencia,

conduciendo en última instancia al establecimiento de nuevos modelos de respuesta del

sistema a los estímulos externos. El aprendizaje es considerado como un porcentaje en el

cambio de los pesos o memoria de la red[17,27,46].

2.4.4.8 Representación del ambiente. El comportamiento del ambiente vendrá dado,

dependiendo de la aplicación que vaya a dársele al modelo de red neuronal, por la

información empírica disponible o por una función estocástica que varíe temporalmente

sobre el espacio de patrones de entrada. La interacción de la red con el ambiente vendrá

representada por el conjunto de unidades de entrada y el conjunto de unidades de salida,

cuyas entradas y salidas representarán respectivamente a la información de entrada y a la

respuesta del sistema.

2.4.5 Clasificación de las redes neuronales artificiales.

2.4.5.1 Según el mecanismo de aprendizaje. Los criterios que se siguen para cambiar el

valor asignado a las conexiones cuando se pretende que la red aprenda una nueva

información se conoce como la regla de aprendizaje.

De forma general, se suelen

considerar dos tipos de reglas de aprendizaje para las redes neuronales: La regla de

aprendizaje supervisado, y no supervisado.

31

Cuadro 2. Paradigmas de aprendizaje y algoritmos mas conocidos

Paradigma

Regla de

aprendizaje

Supervisado

Corrección

del error

No

supervisado

Arquitectura

Algoritmo de aprendizaje

Perceptron o perceptron

multicapa

Algoritmos de aprendizaje perceptron,

retropropagación del error, ADALINE,

MADALINE

Elman y Jordan

recurrentes

Retropropagación del error

Boltzmann

Recurrente

Algoritmo de aprendizaje

Boltzmann

Competitivo

Competitivo

LVQ

Red ART

Red de Hopfield

ARTMap

Aprendizaje de memoria asociativa

Corrección

del error

Proyección de Sannon

Multicapa sin

realimentación

VQ

Competitiva

Competitiva

Kohonen SOM

SOM

ART1, ART2

Por refuerzo Hebbian

Híbrido

Corrección

de error y

competitivo

Red ART

Multicapa sin

realimentación

Sin realimentación o

competitiva

Redes RBF

Aprendizaje supervisado.

Análisis lineal de discriminante

Análisis de componentes principales

Algoritmo de aprendizaje RBF

En el proceso de aprendizaje supervisado, el

entrenamiento de la red es controlado por un agente externo(supervisor) que

determina la respuesta que debería generar la red a partir de una entrada

determinada. La salida es comparada con la deseada y en caso de que no coincidan

se procede a modificar los pesos de las conexiones, con el fin de conseguir que la

32

salida obtenida se aproxime a la deseada. Existen diferentes formas de llevar a cabo

el aprendizaje supervisado:

Aprendizaje por corrección de error. Este tipo de aprendizaje consiste en

ajustar los pesos de las conexiones de la red en función de la diferencia entre los

valores deseados y los obtenidos en la salida de la red; es decir en función del

error cometido en la salida.

Aprendizaje por refuerzo. En el aprendizaje por refuerzo el entrenamiento se

realiza sin conocer exactamente la salida deseada para una determinada entrada.

Existe una relación de entrada-salida a través de un proceso de éxito o fracaso,

produciendo una señal(señal de refuerzo) que mide el buen funcionamiento del

sistema.

Los pesos se ajustan en base a la señal de refuerzo basándose en un mecanismo

de probabilidades. "Si una acción tomada por el sistema de aprendizaje es

seguida por un estado satisfactorio, entonces la tendencia del sistema a producir

esa particular acción es reforzada. En otro caso, la tendencia del sistema a

producir dicha acción es disminuida". La función del supervisor es más la de un

crítico que la de un maestro.

Aprendizaje estocástico.

Durante el entrenamiento de la red se realizan

cambios aleatorios e los valores de los pesos de las conexiones de las red y se

evalúa su efecto a partir de la salida deseada y de distribuciones de probabilidad.

33

Aprendizaje no supervisado. El aprendizaje no supervisado se caracteriza

porque la red no recibe influencia externa para ajustar los pesos de las

conexiones entre sus neuronas. La red no conoce ninguna relación entre las

entradas y las salidas que debe generar, por ello, suele decirse que estas redes

son capaces de auto-organizarse.

El éxito de este tipo de aprendizaje se logra buscando en el conjunto de datos de entrada

características, regularidades, correlaciones o categorías que se puedan establecer entre

ellos.

Entre los algoritmos mas relevantes para este tipo de aprendizaje están:

Aprendizaje hebbiano. Este tipo de aprendizaje consiste en ajustar los pesos

de las conexiones de acuerdo con la correlación (multiplicación en el caso de

valores binarios +1 y -1) de los valores de activación(salidas) de las dos

neuronas conectadas sin tener en cuenta si se deseaba o no esos estados de

activación.

Aprendizaje competitivo y cooperativo. Esta idea se basa en la existencia de

competencia y cooperación

entre las neuronas de una cierta capa por la

oportunidad de entrenarse (aprender). Esto, se refiere a que, la neurona que

produce la salida mayor se le considera ganadora, y tiene la capacidad de inhibir

a las otras neuronas(no presentan activación: salida nula). Todo ello conlleva a

que solamente los pesos de la neurona ganadora podrán ser ajustados.

34

2.4.5.2 Según su topología. Cuando hablamos de la topología o arquitectura de las redes

neuronales nos referimos a la organización y disposición de las neuronas en la red

formando capas o grupos de neuronas más o menos alejadas de la entrada y la salida de las

red. Evaluando como parámetros de clasificación el numero de capas, el numero de

neuronas por capa, el grado de conectividad y el tipo de conexiones entre neuronas, existen

redes neuronales monocapa y multicapa.

Redes monocapa. Una red de este tipo está formada por dos capas: una capa de

entrada y una de salida. La capa de entrada es sólo un receptor para los valores

de entrada que se distribuirán hacia la capa siguiente. La capa de salida está

constituida por las neuronas que procesan la información.

Redes multicapa. Una red multicapa se caracteriza por disponer de conjuntos

de neuronas agrupadas en varios niveles o capas. Existen tres tipos de capas: de

entrada, ocultas y de salida.

Para identificar la capa a la cual pertenece una neurona solo basta con identificar el

origen de las señales de entrada y el destino de las señales de salida, puesto que

normalmente todas las neuronas de una capa reciben señales de entrada de otras

capa anteriores, mas cercanas a las entradas de la red y envían sus señales de salida

a una capa posterior , mas cercana a las salidas de la red.

35

2.4.5.3 Según el tipo de asociación entre la información de entrada y salida. Cuando

se aplica un estímulo (dato de entrada) la red responde con una salida asociada a la

información de entrada.

Existen dos formas primarias de realizar esta asociación entre información de entradasalida que se corresponde con la naturaleza de la información almacenada en la red. Estos

dos mecanismos de asociación dan lugar a dos tipos de redes neuronales que son las redes

hetero-asociativas y las auto-asociativas , cuyos modelos no son diferentes en principio.

Redes hetero-asociativas.

Estas redes al asociar información de entrada con

información de salida, precisan al menos de dos capas, una para captar y retener la

información de entrada y otra para mantener la salida con la información asociada.

En cuanto a su conectividad existen redes hetero-asociativas con conexiones hacia

delante o feedforward, redes con conexiones hacia atrás o feedforward/feedback y

redes con conexiones laterales. El aprendizaje de este tipo de redes puede ser con

supervisión o sin supervisión.

Redes auto-asociativas. Este tipo de redes asocia una información de entrada con

el ejemplar mas parecido de los almacenados conocidos por la red; Se pueden

implementar con una sola capa de neuronas.

36

En cuanto a la conectividad en este tipo de redes existen conexiones laterales entre

las neuronas y en algunos casos conexiones autorrecurrentes, en cuanto al tipo de

aprendizaje, habitualmente el utilizado por estas redes es el no supervisado.

2.4.5.4 Según su modo de operación. Cuando se habla del modo de operación de una red

neuronal se está haciendo referencia a la manera en que la red neuronal procesa los

estímulos externos y crea la respuesta de salida. Puede considerarse a una red neuronal

como perteneciente a una de dos grandes categorías, como lo son las redes estáticas y las

dinámicas.

Redes estáticas. Son redes que toman problemas resueltos para construir sistemas

que toman decisiones y que a demás pueden realizar clasificaciones, tomando

aquellos problemas que no tienen solución computacional e implementado

algoritmos para su solución.

Las redes estáticas producen un mapa de datos a datos y es por ello que se utilizan

como aproximadores universales de funciones. Debido a su modo de

funcionamiento, estas redes tienen una capacidad limitada para sintetizar funciones

dependientes del tiempo en comparación con lo que exponen las rede dinámicas.

Entre este tipo de redes encontramos la red Perceptron y las redes multicapa, con

las cuales se resuelven los problemas de clasificación de patrones no separables

linealmente[17].

37

Redes dinámicas. Son las utilizadas para sintetizar un comportamiento dinámico,

es decir algo que evoluciona en el tiempo, para lo cual se alimenta la red con

muestras pasadas por todas las variables involucradas en la solución del problema.

Este tipo de redes responde de manera diferente ante diferentes secuencias de

entradas, haciendo uso de manera implícita o explícita de la variable tiempo. Este

aspecto las hace en principio más idóneas que las redes estáticas para la síntesis de

funciones en las que aparezca de alguna manera el parámetro tiempo. Algunas

Redes dinámicas por naturaleza son las redes recurrentes tipo Hopfield (DNN-H) y

las redes recurrentes tipo multicapa (DNN-M)

Otras redes neuronales. Son redes que se caracterizan por no tener un par entrada

salida asociado, sino que extraen características de las entradas sin que se conozca

la salida. Estas redes asocian una respuesta a una entrada en particular mediante un

procedimiento simple, Entre este tipo de redes encontramos las red de Kohonen, las

memorias asociativas bidireccionales BAM y la red de funciones radiales.

2.4.6 Estado del arte de las redes neuronales artificiales. Diseñar y construir maquinas

capaces de realizar procesos con cierta inteligencia ha sido uno de los principales objetivos

y preocupaciones de los científicos a lo largo de la historia. De los intentos realizados en

este sentido se han llegado a definir líneas fundamentales para la obtención de maquinas

inteligentes en la cual sobresale la obtención de autómatas que realizan funciones típicas de

los seres humanos mediante la formalización de conocimiento a través de la inteligencia

artificial.

38

La mayoría de investigaciones en redes neuronales han culminado con la presentación de

un modelo matemático. Se ha tratado de comprender diferentes características innatas del

ser humano para representarlas por medio de redes neuronales logrando hasta ahora

resultados verdaderamente sorprendentes. Estos hechos han llevado a que organizaciones

importantes como la IEEE se vinculen a patrocinar y colaborar en busca de resultados

óptimos.

También se han formado otras organizaciones entre las cuales están la

International Neural Network Society (INNS), la International Joint Conference on Neural

Networks (IJCNN), la International Conference on Artificial Neural Networks (ICANN) y

la Sociedad Europea de Redes Neuronales (ENNS).

Son numerosos los trabajos que se realizan y que se publican cada año, las aplicaciones

nuevas que surgen y las empresas que lanzan al mercado productos nuevos tanto en

hardware como en software es grande. En relación con la información que se publica en las

revistas especializadas en el área de redes neuronales,

cabe destacar como las

organizaciones y revistas más interesantes las siguientes: la Neural Networks, revista oficial

de la Sociedad Internacional de Redes Neuronales (INNS); Network, Computation in

Neural System; IEEE Transactions on Neural Networks, publicada por IEEE Neural

networks Council; Neural Computation; e International Journal of Neural Systems.

En Estados Unidos podemos destacar la labor patrocinada por la Oficina de Tecnología

Táctica de la Agencia de Proyectos de Investigación Avanzada del Departamento de

Defensa (DARPA/TTO) y llevada a cabo en el Instituto Tecnológico de Massachussets

(MIT) desde octubre de 1987 a febrero de 1988, en el cual se reviso el estado actual de la

tecnología de redes neuronales artificiales, así como sus posibles aplicaciones al área de

39

defensa y otras áreas, tales como: clasificación de patrones, robótica, visión artificial,

procesamiento de señales y reconocimiento de voz.

Dentro del entorno europeo, hay que señalar las dos citas anuales de la sociedad europea de

redes reuronales (ENNS) y, como fuente de planificación política de investigación (por

medio de la financiación selectiva de proyectos de investigación), el programa ESPRIT,

que durante los últimos años ha financiado una veintena de proyectos que podrían

enmarcarse dentro del área de las redes neuronales y sus aplicaciones. La participación

española en estos proyectos ha sido reducida, quedando limitada a las universidades

Politécnica y Autónoma de Madrid, universidad Politécnica del país vasco, centro de

estudios avanzados de Blanes, instituto de cibernética del CSIC, instituto de ingeniería del

conocimiento (IIC) y la empresa Software de Base, S.A.

En España se esta trabajando una aplicación de redes neuronales para la mejora de la

calidad del jamón ibérico. El objetivo del trabajo es desarrollar un sistema electrónico que

ayude a la determinación de la calidad del jamón, el trabajo se está realizando en

colaboración con los siguientes grupos de investigación, además de la empresa JAPASUR

y FUNDECYT:

- Grupo de tecnología de los alimentos (Facultad de Veterinaria - UEX).

- Instituto de física aplicada (CSIC - Madrid).

- Grupo de sensores (Universidad Politécnica de Cataluña).

- Centro nacional de microelectrónica (CNM - CSIC - Barcelona).

40

También en España se esta trabajando en redes neuronales para la detección de cubierta

nubosa y clasificación de nubes. Esta línea de investigación trata la segmentación de las

imágenes meteosat de la península ibérica en las clases mar, tierra, nubes bajas, medias,

altas, nubes de desarrollo vertical y nieblas. El trabajo se realizó bajo la cooperación con el

grupo de meteorología del departamento de física de la universidad de Extremadura.

Se están desarrollando trabajos en redes neuronales para la evaluación morfológica de

ganado Bovino. Esta línea de trabajo se ha estado desarrollando durante los últimos 4 años;

el objetivo es lograr un sistema, que a partir de fotografías de campo (una lateral, otra de

frente y una posterior) permita obtener una evaluación morfológica del animal, el trabajo

esta siendo llevado a cabo en colaboración con expertos del CENSYRA.

Se ha iniciado una nueva línea de investigación para el diagnostico de cáncer de mama,

mediante redes neuronales, que nace con el objetivo de desarrollar un sistema que analice

mamografías de alta resolución, e indique las zonas en las que exista un principio de

cáncer. Este trabajo se esta realizando en conjunto con personal médico de los hospitales

provincial e infanta Cristina de Badajoz en España.

La oficina de transferencia de resultados de la investigación(OTRI) de la UEX en España

ha desarrollado un software sobre redes neuronales para la empresa Conservas Vegetales de

Extremadura, S.A, que permita llevar mejor control del estado de la producción.

Latinoamérica y en especial Colombia no ha sido ajena a este proceso investigativo. La

inteligencia artificial se ha tomado los escenarios científicos del país, prueba de esto es el

41

gran interés que existe en la mayoría de universidades en participar de los seminarios y

congresos que sobre estos temas se organizan.

En cuanto a las redes neuronales artificiales se han desarrollado investigaciones en

instituciones como la Universidad Nacional, Universidad de los Andes, Universidad

Industrial de Santander, Universidad del Valle, entre otras, las cuales han encaminado sus

esfuerzos a dar solución a problemas del mundo real utilizando las mas modernas técnicas

de computación aplicada a las redes neuronales. Los avances mas significativos se han

logrado en campos como el control industrial, la medicina y la enseñanza.

En la Universidad de Pamplona el grupo de investigación en inteligencia artificial

(GINAR), esta trabajando en un proyecto titulado “Sistema de toma de decisiones para el

sector empresarial aplicando técnicas de inteligencia artificial”.

En la Universidad Francisco de Paula Santander hace tiempo se vienen desarrollando

estudios, análisis y proyectos de investigación en el área de inteligencia artificial, pero solo

hasta hace poco se formalizó el grupo de investigación en esta área. Actualmente se están

adelantando investigaciones en áreas como el reconocimiento de patrones e imágenes, para

la detección de enfermedades transmitidas por vectores actualmente se esta desarrollando

un trabajo titulado “ Sistema de toma de decisiones para el apoyo logístico del control

entomológico y epidemiológico de las enfermedades transmitidas por vectores (E.T.V)”,

utilizando redes neuronales; también se esta trabajando en visión artificial, robótica, entre

otros En la mayoría de estos proyectos se están utilizando redes neuronales artificiales.

42

2.4.7 Aplicaciones de las redes neuronales artificiales. Las redes neuronales son una

tecnología computacional emergente que puede utilizarse en un gran numero y variedad de

aplicaciones. Se pueden desarrollar redes neuronales en un periodo de tiempo razonable y

pueden realizar tareas concretas mejor que otras tecnologías convencionales, incluyendo los

sistemas expertos.

Hay muchos tipos diferentes de redes neuronales, cada uno de los cuales tiene una

aplicación particular mas apropiada.

Las redes neuronales han encontrado muchas

aplicaciones con éxito en la visión artificial, reconocimiento de textos manuscritos, en la

simulación de centrales de producción de energía, en la detección de explosivos, en la

identificación de blancos de radares, en el procesado de señales e imágenes, reconocimiento

de voz y caracteres, sistemas expertos, análisis de imágenes médicas, control remoto,

control de robots, inspección industrial, en exploración científica se utilizan redes

neuronales en los vehículos de investigación espacial, en la biometría para distinguir

personas según patrones corporales tales como su huella, rostro, pupila y otros.

2.4.8 Ventajas y desventajas de las redes neuronales artificiales. Las ventajas más

relevantes que presentan las Redes Neuronales Artificiales frente a otros sistemas de

procesamiento de información son las siguientes:

Pueden sintetizar algoritmos a través de un proceso de aprendizaje.

Para utilizar la tecnología neuronal no es necesario conocer los detalles

matemáticos. Solo se requiere estar familiarizado con los datos de trabajo.

43

Las redes neuronales son robustas, pueden fallar algunos elementos de

procesamiento pero la red continua trabajando, esto contrario a lo que sucede en

programación tradicional.

Se utilizan con especial énfasis en la solución de problemas no lineales.

El procesamiento interno en la estructura de la red se da en forma paralela

acelerando el proceso para la obtención de resultados.

Permiten cuantificar la información que se quiere procesar, de este modo se hace

superior a las teorías convencionales basadas solo en dos posibles estados.

Las desventajas de las Redes Neuronales son:

Las Redes Neuronales Artificiales se deben entrenar para cada problema

Necesitan realizar múltiples pruebas para determinar la arquitectura más adecuada,

su entrenamiento es largo y puede consumir varias horas de CPU.

Debido a que las redes se entrenan en lugar de programarlas, estas necesitan muchos

datos.

3. FORMULACION MATEMÁTICA DE LOS PRINCIPALES ALGORITMOS DE

ENTRENAMIENTO EN REDES NEURONALES ARTIFICIALES

En nuestra investigación sobre redes neuronales artificiales hemos tenido en cuenta los

detalles más importantes que sobre esta área se conocen a nivel mundial, de aquí surge la

inclinación a profundizar en los siguientes algoritmos.

3.1 RED TIPO PERCEPTRON

En 1957, Frank Rosenblatt presentó el perceptron, una red neuronal con aprendizaje

supervisado. El primer modelo de perceptron fue desarrollado en un ambiente biológico

imitando el funcionamiento del ojo humano, el fotoperceptron como se le llamo era un

dispositivo que respondía a señales ópticas. El perceptron trabaja bien con patrones de

entrada binarios.

En 1962, Frank Rosenblatt desarrolló una prueba de convergencia y definió el rango de

problemas para los que su algoritmo aseguraba una solución, entonces propuso los

'Perceptrons' como herramienta computacional[16,43,].

El modelo del perceptron es la base de la mayor parte de las arquitectura de las redes

neuronales artificiales que se interconectan entre sí. El perceptron separa las regiones por

45

un hiperplano cuya ecuación queda determinada por los pesos de las conexiones y por el

valor umbral de la función de activación de la neurona.

Los pesos pueden ser positivos o negativos.

Los pesos junto con las funciones de

activación dictan la operación de la red neuronal, normalmente las funciones no se

modifican de tal forma que el estado de la red neuronal depende del valor de los factores de

peso que se aplican a los estímulos de la neurona.

3.1.1 Perceptron básico unicapa. Este tipo de perceptron consta de dos niveles o capas.

El primer nivel está compuesto por un número de unidades de entrada, denominadas

unidades sensoriales. El segundo nivel está compuesto por un número de unidades de

salida denominadas unidades de asociación, cuyas entradas son las salidas de las unidades

de entrada por sus pesos asociados.

Este tipo de red solo pude establecer dos regiones separadas por una frontera lineal en el

espacio de patrones de entrada, donde se tendría un hiperplano. Un perceptron unicapa no

es más que un conjunto de neuronas no unidas entre sí, de manera que cada una de las

entradas del sistema se conectan a cada neurona, produciendo cada una de ellas su salida

individual. (Véase la Figura 12).

46

Figura 12. Estructura perceptron unicapa

3.1.1.1 Funcionamiento. El perceptron se diseñó para trabajar con patrones de entrada y

salidas de tipo binario. Así, la salida será de uno (1) cuando la activación de la neurona

alcance un valor y cero (0) en caso contrario.

La función de activación que suele utilizar este algoritmo es la función escalón.

La regla de aprendizaje que se emplea para la adaptación de los pesos está basada en el

error. Durante la fase de aprendizaje se presentan a la red los patrones de entrada y la

salida deseada para cada entrada. El error viene dado por la diferencia entre la salida

deseada y la salida real de la neurona. El método requiere que cada patrón de entrada salida se presente a la red las veces necesarias hasta que ni los pesos ni el umbral varíen.

47

3.1.1.2 Estructura y aprendizaje.

En el aprendizaje supervisado se presentan al perceptron unas entradas con las

correspondientes salidas que se desea que la red aprenda.

En el aprendizaje no supervisado, solo se presentan al perceptron las entradas y,

para esas entradas la red debe dar una salida parecida.

Los siguientes son los pasos que sigue el algoritmo durante su proceso de aprendizaje

(regla delta)[16,33,43].

1. Inicializar el valor de los pesos wi(t) y del umbral θ (t ) con valores aleatorios pequeños.

wi(t): representa el valor del i-ésimo peso en el instante t.

θ (t ) :es el valor del umbral.

2. Presentar un nuevo vector de entrada X p = (Xo, X1,....Xn-1) y su correspondiente salida

deseada d i , donde:

d i : salida deseada para la neurona i

48

3. Calcular la salida real de la neurona en el instante t.

n −1

y i (t) = f( ∑ wi (t ) x i (t ) - θ (t ) ),

i =0

donde f es la función de activación de tipo escalón, representada por:

1 si net ≥ 0

f(net) =

0 si net ≤ 0

n −1

net = ( ∑ wi (t ) x i (t ) - θ (t ) ), entrada neta para cada una de las neuronas

i =0

4. Hallar el error en las neuronas de salida

δ i = ( d i (t ) - y i (t ) ), donde

y i (t ) : salida real para la neurona i

5. Se modifican los pesos de acuerdo a la siguiente fórmula.

w i (t + 1) = w i (t ) + α [ d i (t ) – y i (t ) ] x i (t ) , donde

0 ≤ i ≤ n - 1.

α : rata o factor de aprendizaje(0.0 ≤ α ≤ 1

w i (t + 1) : vector de pesos para la neurona i en el instante t+1

49

6. Regresar al paso 2 hasta agotar el conjunto de entrenamiento.

3.1.2 Perceptron multicapa. Consiste básicamente en poner varias capas elementales

interconectadas sucesivamente con el objeto de dotar a la red de la complejidad suficiente

para realizar la tarea requerida. Es una red de tipo feedforward que permite establecer

regiones de decisión mucho más complejas que las de dos semiplanos, como en el

perceptron de un solo nivel.

Esta estructura nació con la intención de dar solución a las limitaciones del perceptron

clásico o unicapa, y supuso el resurgimiento del movimiento conexionista. Como su

nombre lo indica, se trata de un unos cuantos (dos o tres) perceptrones unicapa conectados

en cascada.

Figura 13. Estructura del perceptron multicapa

3.1.2.1

Funcionamiento perceptron multicapa.

En el perceptron multicapa, cada

neurona necesita de un "uno (1)" para tener un lindero entrenable. Se puede hacer que la

50

red aprenda dos o tres formas básicas y que dada otra forma que no ha aprendido, la

clasifique como la más cercana a las que conoce.

Este tipo de algoritmo utiliza la función de activación sigmoidal por ser diferenciable en

todos sus puntos, de manera que se pueda propagar el error hacia atrás. Esta red no

requiere mas de cuatro(4) capas o niveles, además el exceso en el numero de neuronas en

cada nivel puede generar ruido .

3.1.2.2 Estructura y aprendizaje perceptron multicapa. El aprendizaje en el perceptron

multicapa lo realiza siguiendo el mismo procedimiento que en el perceptron unicapa y se

lista en los siguientes pasos[33]:

1. Inicializar el valor de los pesos wi (t ) y del umbral θ (t ) con valores aleatorios pequeños.

2. Presentar un nuevo vector de entrada X p = (Xo, X1,....Xn-1) y su correspondiente salida

deseada d i .

3. Calcular la salida real de la neurona.

n −1

y pk (t ) = f( ∑ wi (t ) x i (t ) - θ (t ) ) donde f: es la función de activación tipo sigmoidal

i =0

k: es el índice de neuronas en la ultima capa

51

4. Hallar el error en las neuronas de salida

0

δ pk

= y pk (t ) [1- y pk (t ) ].[ d k (t ) - y pk (t ) )

0

= error en la neurona k de la ultima capa

donde δ pk

5. Se propaga el error de la capa de salida hacia la capa anterior

para cada neurona de la penúltima capa se tiene:

δ pjh =

k

∑

0

w jk

δ pk

j =1

donde j: neuronas de la penúltima capa

w jk : peso entre la neurona j de la penúltima capa y la neurona k de la ultima capa

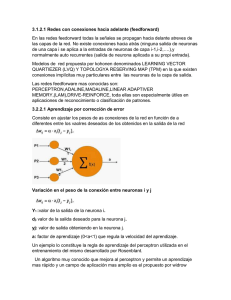

h: identificador de capa oculta