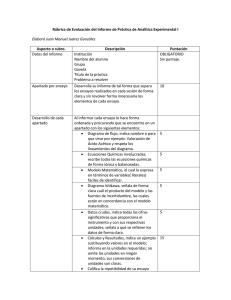

base conceptual del análisis de incertidumbre

Anuncio