ESTIMACIÓN LINEAL DE ERROR CUADRÁTICO MEDIO MÍNIMO

Anuncio

ESTIMACIÓN LINEAL DE ERROR

CUADRÁTICO MEDIO MÍNIMO

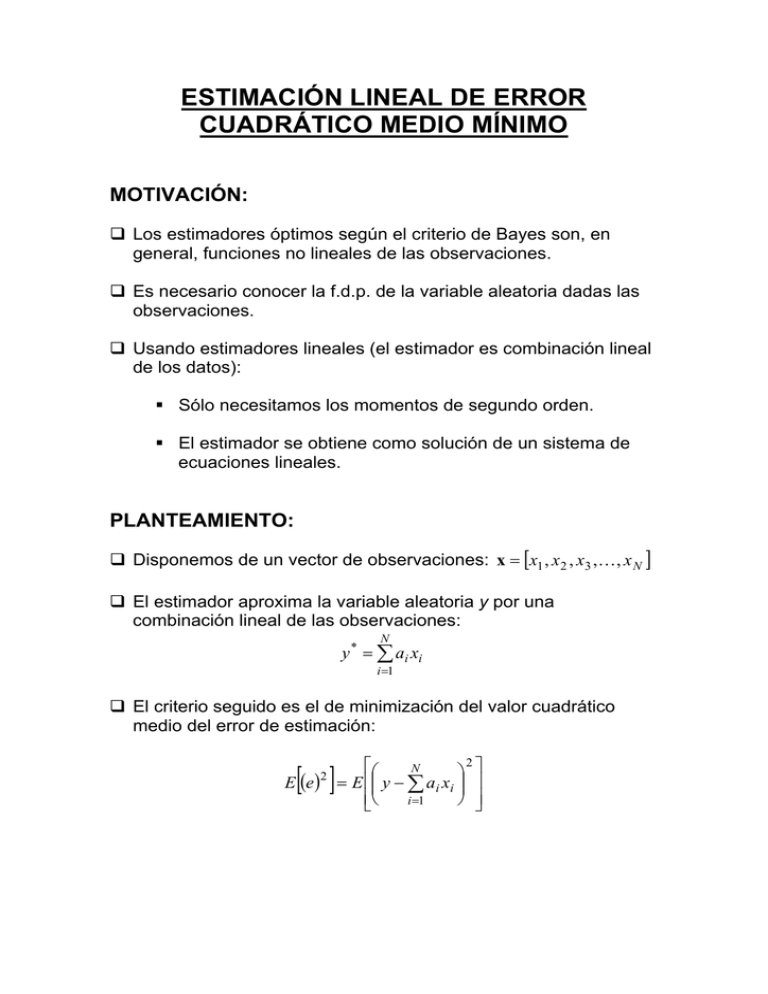

MOTIVACIÓN:

Los estimadores óptimos según el criterio de Bayes son, en

general, funciones no lineales de las observaciones.

Es necesario conocer la f.d.p. de la variable aleatoria dadas las

observaciones.

Usando estimadores lineales (el estimador es combinación lineal

de los datos):

Sólo necesitamos los momentos de segundo orden.

El estimador se obtiene como solución de un sistema de

ecuaciones lineales.

PLANTEAMIENTO:

Disponemos de un vector de observaciones: x = [x1 , x 2 , x3 ,K, x N ]

El estimador aproxima la variable aleatoria y por una

combinación lineal de las observaciones:

N

y * = ∑ a i xi

i =1

El criterio seguido es el de minimización del valor cuadrático

medio del error de estimación:

[ ]

E (e )

2

2

⎡⎛

N

⎞ ⎤

= E ⎢⎜⎜ y − ∑ ai xi ⎟⎟ ⎥

⎢⎣⎝

i =1

⎠ ⎥⎦

PRINCIPIO DE ORTOGONALIDAD

El estimador lineal de error cuadrático medio mínimo es el que

produce un error de estimación que es ortogonal a los datos:

N

⎡⎛

⎞ ⎤

E ⎢⎜⎜ y − ∑ ai xi ⎟⎟ xk ⎥ = E [exk ] = 0; 1 ≤ k ≤ N

i =1

⎠ ⎦

⎣⎝

Demostración:

{ai }iN=1 : vector de coeficientes del estimador lineal óptimo.

{ai '}iN=1 : vector de coeficientes de otro estimador lineal.

{xi }iN=1 : datos utilizados en la estimación.

El error de estimación con el nuevo estimador:

N

N

N

N

i =1

i =1

i =1

i =1

e' = y − ∑ ai ' xi = y − ∑ ai xi − ∑ (ai '−ai ) xi = e − ∑ (ai '− ai ) xi

Su valor cuadrático medio:

[ ]

E (e')

2

2

⎡⎛

N

⎞ ⎤

= E ⎢⎜⎜ e − ∑ (ai '−ai ) xi ⎟⎟ ⎥

⎢⎣⎝ i =1

⎠ ⎥⎦

2

⎡⎛ N

⎞ ⎤

⎡ N

⎤

E (e' ) = E e + E ⎢⎜⎜ ∑ (ai '−ai ) xi ⎟⎟ ⎥ − 2 E ⎢e∑ (ai '−ai ) xi ⎥

⎢⎣⎝ i =1

⎠ ⎥⎦

⎣ i =1

⎦

[ ] [ ]

2

2

⎡ N

⎤

E ⎢e∑ (ai '−ai ) xi ⎥ = 0

⎣ i =1

⎦

[ ] ( )

E (e')2 ≥ E e 2

CONCLUSIÓN: El valor cuadrático medio mínimo se obtiene

cuando el error es ortogonal a los datos.

ECUACIONES NORMALES

El principio de ortogonalidad permite obtener fácilmente los

coeficientes del estimador lineal de error cuadrático medio

mínimo.

N

⎡⎛

⎞ ⎤

E ⎢⎜⎜ y − ∑ ai xi ⎟⎟ xk ⎥ = E [exk ] = 0; 1 ≤ k ≤ N

i =1

⎠ ⎦

⎣⎝

N

∑ ai E[xi xk ] = E[ yxk ];

1≤ k ≤ N

i =1

N

∑ Rxi x k ai = R yx k ;

1≤ k ≤ N

i =1

♦ Observación:

El cálculo de los coeficientes del estimador sólo requiere

información de los estadísticos de segundo orden ⇒ en

general, peor solución que en el caso Bayesiano.

CONSIDERACIONES DE INTERÉS

El error cuadrático medio es la diferencia de los valores

cuadráticos medios de la variable a estimar y de su estimador

lineal.

Demostración:

Por ser el error ortogonal a los datos:

[ ] [

es decir: E [yy ] = E [( y ) ]

] [ ] [

]

E ey * = E ( y − y * ) y * = E yy * − E ( y * ) 2 = 0

*

* 2

Finalmente, el error cuadrático medio se expresa como:

[( ) ]

[ ] [ ( )]

= E [( y ) ] − E [y y ] = E [( y ) ] − E [( y ) ]

E (e )2 = E e y − y * = E [ey ] = E y − y * y =

2

2

*

∗ 2

El error cuadrático medio puede reducirse utilizando más datos

en la estima, si estos datos no son ortogonales a la variable a

estimar:

N

Ree = R yy − ∑ ai R yxi

i =1

La reducción del error cuadrático medio es tanto mayor, cuanto

mayor sea la correlación del dato extra introducido con la

variable a estimar.

Interpretación geométrica:

y

e

x2

y*

x1

FILTRO DE WIENER-HOPF DE TIEMPO

DISCRETO

La estimación lineal de error cuadrático medio mínimo puede

extenderse fácilmente a la estimación de señales de tiempo

discreto, con las siguientes consideraciones:

Las observaciones son muestras de un proceso estocástico.

Los coeficientes del estimador son las muestras de la

respuesta impulsiva de un filtro lineal.

dˆ [n] =

N −1

∑ ai [n]x[n − i ]

i =0

ε [n] = d [n] − dˆ [n]

d[n]: señal a estimar (deseada).

x[n]: señal observada.

ε[n]: error de estimación.

Los coeficientes del filtro se obtienen aplicando el principio de

ortogonalidad:

N −1

⎡

⎛

⎞⎤

E [x[n − l ]ε [n]] = E ⎢ x[n − l ] ⎜⎜ d [n] − ∑ ai [n]x[n − i ]⎟⎟⎥ = 0; l = 0,1,...., N − 1

i =0

⎝

⎠⎦

⎣

N −1

∑ ai [n]R x [n − l , n − i ] = Rdx [n, n − l ];

l = 0 ,1,...,N − 1

i =0

Para el caso estacionario:

N −1

∑ ai R x [i − l ] = Rdx [l ];

i =0

l = 0,1,..., N − 1.

[ ] = R [0] − ∑ a R

Eε

N −1

2

d

i =0

i

dx

[i ]

APLICACIONES TÍPICAS

Problema

Forma de la

observación

x[n] = s[n] + η[n]

Filtrado de la señal con

ruido

Predicción de la señal con x[n] = s[n] + η[n]

ruido

Suavizado de la señal con x[n] = s[n] + η[n]

ruido

x[n] = s[n − 1]

Predicción lineal

Secuencia deseada

d [n] = s[n]

d [n] = s[n + p ]; p > 0

d [n] = s[n − p ]; p > 0

d [n] = s[n]

PROBLEMA PRÁCTICO:

Desconocimiento de la caracterización estadística del

problema (funciones de autocorrelación de la señal observada

y de correlación cruzada de las señales observada y

deseada).

SOLUCIÓN:

♦ Estimación de las funciones de autocorrelación y correlación

cruzada (necesitamos ergodicidad).

♦ Utilización de algoritmos iterativos ⇒ Filtro de Widrow-Hopf.

PREDICCIÓN LINEAL

Se utilizan las muestras disponibles de un proceso para generar

muestras futuras del mismo.

xˆ[n] =

N

∑ a k x[n − k ]

k =1

Puede resolverse el problema sin utilizar algoritmos iterativos

estimando la secuencia de autocorrelación (ergodicidad).

El predictor lineal se obtiene aplicando el principio de

ortogonalidad:

N

⎤

⎡⎛

⎞

E ⎢⎜⎜ x[n] − ∑ a k x[n − k ]⎟⎟ x[n − m]⎥ = 0; m = 1,..., N

k =1

⎠

⎦

⎣⎝

R x [m] =

N

∑ a k R x [m − k ];

k =1

m = 1,..., N

APLICACIÓN: Codificación diferencial:

Codificador Diferencial.

Decodificador Diferencial.