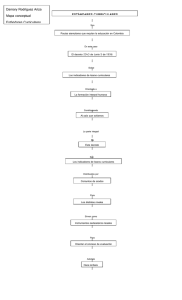

Uso de los resultados de evaluaciones educativas a gran escala en

Anuncio