memoria - Pàgina inicial de UPCommons

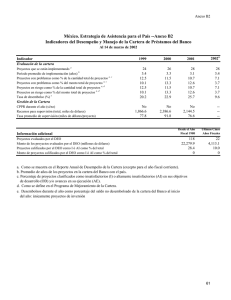

Anuncio