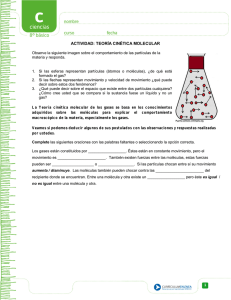

Y SIN EMBARGO SE MUEVEN

Anuncio