Tema 2: Errores de Especificación y Problemas con la Muestra

Anuncio

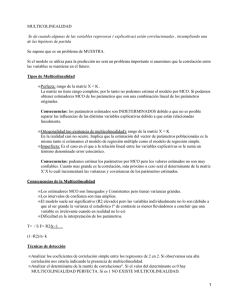

Tema 2: Errores de Especificación y Problemas con la Muestra 1 TEMA 2: ERRORES DE ESPECIFICACIÓN Y PROBLEMAS CON LA MUESTRA 2.1) Introducción. 2.2) Omisión de Variables Relevantes. 2.3) Inclusión de Variables Superfluas. 2.4) Mala Especificación de la Forma Funcional. 2.5) Multicolinealidad. 2.6) Errores de Medida. 2.7) Observaciones Atípicas. 2 TEMA 2: ERRORES DE ESPECIFICACIÓN Y PROBLEMAS CON LA MUESTRA 2.1) INTRODUCCIÓN LINEALES INSESGADOS ESTIMADORES MCO βˆ MCO = W ⋅ Y E ( βˆ MCO ) = β βˆ MCO = β CONSISTENTES lim n →∞ PROPIEDADES ÓPTIMOS βˆ MCO = ( X '⋅ X ) −1 ⋅ ( X '⋅Y ) HIPÓTESIS MODELO BIEN ESPECIFICADO U ES RUIDO BLANCO - Variables Relevantes E (U t ) = 0; ∀t - Forma Funcional Correcta E (U t2 ) = σ u2 ; ∀t - No Existen Errores de Medida ni Outliers E (U t , U s ) = 0; ∀t ≠ s 3 TEMA 2: ERRORES DE ESPECIFICACIÓN Y PROBLEMAS CON LA MUESTRA 2.1) INTRODUCCIÓN OBJETIVO: Análisis de las consecuencias de que se violen los supuestos relacionados con las variables explicativas: · INCORRECTA ESPECIFICACIÓN: 2.2) Omisión de Variables Relevante 2.3) Inclusión de Variables Superfluas 2.4) Mala Especificación de la Forma Funcional · PROBLEMAS RELACIONADOS CN LA INFORMACIÓN MUESTRAL: 2.5) Multicolinealidad 2.6) Errores de Medida 2.7) Observaciones Atípicas 4 TEMA 2: ERRORES DE ESPECIFICACIÓN Y PROBLEMAS CON LA MUESTRA 2.2) OMISIÓN DE VARIABLES RELEVANTES - Planteamiento del Problema - Estimación del Modelo · Estimación · Propiedades ¿Insesgadez? ¿Consistencia? ¿Eficiencia? (Varianza de la Estimación) - Consecuencias 5 TEMA 1. INTRODUCCIÓN: GENERALIZACIÓN Y EXTENSIÓN DEL MODELO DE REGRESIÓN 2.2) OMISIÓN DE VARIABLES RELEVANTES - Planteamiento del Problema MODELO VERDADERO ÁLGEBRA ORDINARIA Yi = β 0 + β1 ⋅ X 1i + β 2 ⋅ X 2i + ... + β k ⋅ X ki + U i ÁLGEBRA MATRICIAL Y( nx1) = X ( nx ( k +1)) ⋅ β (( k +1) x1) + U ( nx1) ∀i = 1,2,..., n E (U t ) = 0; ∀i E (U i2 ) = σ u2 ; ∀i E (U i ,U s ) = 0; ∀i ≠ s d Ui → N (0, σ u2 ) E (U ) =ϑ ( nX 1) E (U ⋅ U ' ) = σ u2 ⋅ I d U → N (ϑ , σ u2 ⋅ I ) 6 TEMA 2. INTRODUCCIÓN: GENERALIZACIÓN Y EXTENSIÓN DEL MODELO DE REGRESIÓN 2.2) OMISIÓN DE VARIABLES RELEVANTES - Planteamiento del Problema SUPUESTO. Cometemos un ERROR DE ESPECIFICACIÓN: Se especifica un MODELO ERRÓNEO en donde omitimos variables que son relevantes para explicar Y. AGRUPACIÓN DE LAS VARIABLES EXPLICATIVAS GRUPO A: Variables que sabemos que son relevantes y por eso LAS INCLUIMOS EN NUESTRO MODELO. Suponemos que serán un total de (K-r) variables. GRUPO B: Variables que influyen sobre la variable endógena (Y) pero por desconocimiento NO LAS INCLUIMOS EN EL MODELO. Serán las r restantes 7 variables. TEMA 2. INTRODUCCIÓN: GENERALIZACIÓN Y EXTENSIÓN DEL MODELO DE REGRESIÓN 2.2) OMISIÓN DE VARIABLES RELEVANTES - Planteamiento del Problema: Un ejemplo MODELO VERDADERO Yi = β 0 + β1 ⋅ X 1i + β 2 ⋅ X 2i + β 3 ⋅ X 3i + U i ∀i = 1,2,..., n Las Variables X 1 , X 2 y X 3 son relevantes para explicar ¿QUÉ SUCEDE? NUESTRO MODELO DE TRABAJO Y Por desconocimiento sólo incluimos X 1 y X 2 Yi = β 0 + β 1 ⋅ X 1i + β 2 ⋅ X 2i + Vi VARIABLES EXPLICATIVAS GRUPO A X1 X 2 ∀i = 1,2,..., n VARIABLES EXPLICATIVAS GRUPO B 8 X3 TEMA 2. INTRODUCCIÓN: GENERALIZACIÓN Y EXTENSIÓN DEL MODELO DE REGRESIÓN 2.2) OMISIÓN DE VARIABLES RELEVANTES - Planteamiento del Problema: MODELO DE TRABAJO XA Y = X A ⋅ βA +V EJEMPLO: 1 X 11 1 X 12 . XA = . . 1 X 1n X 21 X 22 βA X 2 n ( nx ( k − r +1))=( nX 3) β0 = β1 β 2 V1 V2 . V = . . V n βA V Matriz que recoge los valores de las variables incluidas en el modelo. [nx( K − r + 1)] Vector que recoge los parámetros de las variables incluidas en el modelo. [( K − r + 1) x1] Vector que recoge las perturbaciones de nuestro modelo. [nx1] 9 TEMA 2. INTRODUCCIÓN: GENERALIZACIÓN Y EXTENSIÓN DEL MODELO DE REGRESIÓN 2.2) OMISIÓN DE VARIABLES RELEVANTES - Planteamiento del Problema: MODELO VERDADERO EJEMPLO: U1 X 31 U 2 X 32 . . U = XB = . . . . X U 3n ( nxr ) =( nx1) n ( nx1) β B = (β 3 ) Y = X ⋅ β +U = X A ⋅ β A + X B ⋅ βB +U XB βB U Matriz que recoge los valores de las variables omitidas en el modelo. [nxr ] Vector que recoge los parámetros de las variables omitidas en el modelo. [rx1] Vector que recoge las perturbaciones del modelo verdadero.[nx1] 10 TEMA 2. INTRODUCCIÓN: GENERALIZACIÓN Y EXTENSIÓN DEL MODELO DE REGRESIÓN 2.2) OMISIÓN DE VARIABLES RELEVANTES - Planteamiento del Problema: MODELO DE TRABAJO Y = X A ⋅ βA +V MODELO VERDADERO Y = X ⋅ β +U = X A ⋅ β A + X B ⋅ βB +U V = X B ⋅ βB +U Existe un efecto sistemático sobre la perturbación de nuestro modelo de trabajo. Podrá originar problemas de AUTOCORRELACIÓN o HETEROCEDASTICIDAD. 11 TEMA 2. INTRODUCCIÓN: GENERALIZACIÓN Y EXTENSIÓN DEL MODELO DE REGRESIÓN 2.2) OMISIÓN DE VARIABLES RELEVANTES - Estimación: (Ver demostraciones) MODELO DE TRABAJO ESTIMACIÓN MCO Y = X A ⋅ βA +V ( βˆ A = X A' ⋅ X A ESTIMADOR SESGADO ) −1 ⋅ X A' ⋅ Y = β A + P ⋅ β B + ( X A' ⋅ X A ) −1 ⋅ X A' ⋅ U E ( βˆ A ) ≠ β A ; E ( βˆ A ) = β A ⇔ β B = ϑ ; P = ϑ or P ⋅ β B = ϑ ESTIMADOR NO CONSISTENTE VARIANZA DE LOS ESTIMADORES 12 TEMA 2. INTRODUCCIÓN: GENERALIZACIÓN Y EXTENSIÓN DEL MODELO DE REGRESIÓN 2.2) OMISIÓN DE VARIABLES RELEVANTES - Consecuencias: 1-. Las Estimaciones de β̂ A son SESGADAS. 2-. Las Estimaciones de β̂ A son INCONSISTENTES. 3-. Se sobreestima σ U2 (σˆ 2 U ≥ σ U2 ) No se puede hacer inferencia estadística porque se obtendrán conclusiones erróneas sobre los parámetros de modelo 13 TEMA 2: ERRORES DE ESPECIFICACIÓN Y PROBLEMAS CON LA MUESTRA 2.3) INCLUSIÓN DE VARIABLES SUPERFLUAS - Planteamiento del Problema - Estimación del Modelo · Estimación · Propiedades ¿Insesgadez? ¿Consistencia? ¿Eficiencia? (Varianza de la Estimación) - Consecuencias 14 TEMA 1. INTRODUCCIÓN: GENERALIZACIÓN Y EXTENSIÓN DEL MODELO DE REGRESIÓN 2.3) INCLUSIÓN DE VARIABLES SUPERFLUAS - Planteamiento del Problema MODELO VERDADERO ÁLGEBRA ORDINARIA Yi = β 0 + β1 ⋅ X 1i + β 2 ⋅ X 2i + ... + β k ⋅ X ki + U i ÁLGEBRA MATRICIAL Y( nx1) = X ( nx ( k +1)) ⋅ β (( k +1) x1) + U ( nx1) ∀i = 1,2,..., n E (U t ) = 0; ∀i E (U i2 ) = σ u2 ; ∀i E (U i ,U s ) = 0; ∀i ≠ s d Ui → N (0, σ u2 ) E (U ) =ϑ ( nX 1) E (U ⋅ U ' ) = σ u2 ⋅ I d U → N (ϑ , σ u2 ⋅ I ) 15 TEMA 2. INTRODUCCIÓN: GENERALIZACIÓN Y EXTENSIÓN DEL MODELO DE REGRESIÓN 2.3) INCLUSIÓN DE VARIABLES SUPERFLUAS - Planteamiento del Problema SUPUESTO. Cometemos un ERROR DE ESPECIFICACIÓN: Se especifica un MODELO ERRÓNEO en donde incorporamos variables que no son relevantes para explicar Y. AGRUPACIÓN DE LAS VARIABLES EXPLICATIVAS GRUPO A: Variables que sabemos que son relevantes y por eso LAS INCLUIMOS EN NUESTRO MODELO. Suponemos que serán un total de K variables. GRUPO B: Variables que creemos que son relevantes para explicar la variable endógena (Y) y por eso las INCLUIMOS EN NUESTRO MODELO pero, en realidad, son irrelevantes. Suponemos que son s variables. 16 TEMA 2. INTRODUCCIÓN: GENERALIZACIÓN Y EXTENSIÓN DEL MODELO DE REGRESIÓN 2.3) INCLUSIÓN DE VARIABLES SUPERFLUAS - Planteamiento del Problema: Un ejemplo MODELO VERDADERO ∀i = 1,2,..., n Yi = β 0 + β1 ⋅ X 1i + β 2 ⋅ X 2i + U i Las Variables X 1 y X 2 son relevantes para explicar ¿QUÉ SUCEDE? NUESTRO MODELO DE TRABAJO Incluimos X 1, X 2 y X 3 ( X 3 no es relevante) Yi = β 0 + β1 ⋅ X 1i + β 2 ⋅ X 2i + β 3 · X 3i + Vi VARIABLES EXPLICATIVAS GRUPO A X1 X 2 Y ∀i = 1,2,..., n VARIABLES EXPLICATIVAS GRUPO B 17 X3 TEMA 2. INTRODUCCIÓN: GENERALIZACIÓN Y EXTENSIÓN DEL MODELO DE REGRESIÓN 2.3) INCLUSIÓN DE VARIABLES SUPERFLUAS - Planteamiento del Problema: MODELO VERDADERO X Y = X ⋅ β + U = X A ·β A + U Matriz que recoge los valores de las variables realmente relevantes para explicar Y. X = XA β Vector que recoge los parámetros de las variables realmente relevantes. β = βA [nx( K + 1)] U Vector que recoge las perturbaciones deL modelo verdadero. [nx1] [( K + 1) x1] 18 TEMA 2. INTRODUCCIÓN: GENERALIZACIÓN Y EXTENSIÓN DEL MODELO DE REGRESIÓN 2.3) INCLUSIÓN DE VARIABLES SUPERFLUAS - Planteamiento del Problema: MODELO DE TRABAJO X* Matriz que recoge los valores de todas las variables incluidas en el modelo. X = (X A * XA XB X B ) [nx( K + s + 1)] [nx( K + 1)] [nxs ] Y = X * ⋅ β * +V β* Vector que recoge los parámetros de las variables incluidas en el modelo. β A * β = ::::: β B βA βB Vector que recoge las perturbaciones de nuestro modelo. [nx1] V [( K + s + 1) x1] [( K + 1) x1] [sx1] 19 TEMA 2. INTRODUCCIÓN: GENERALIZACIÓN Y EXTENSIÓN DEL MODELO DE REGRESIÓN 2.3) INCLUSIÓN DE VARIABLES SUPERFLUAS - Planteamiento del Problema: Resumen MODELO VERDADERO Y = X ⋅ β + U = X A ·β A + U MODELO DE TRABAJO Y = X * ⋅ β * + V = X A ·β A + X B ·β B + V 20 TEMA 2. INTRODUCCIÓN: GENERALIZACIÓN Y EXTENSIÓN DEL MODELO DE REGRESIÓN 2.3) INCLUSIÓN DE VARIABLES SUPERFLUAS - Planteamiento del Problema: EJEMPLO: MODELO VERDADERO MODELO DE TRABAJO 1 X 11 1 X 12 . Y = X ·β + U = X A ·β A + U = . . 1 X 1n Y = X * ·β * + V = [ X A X 12 U1 X 22 U 2 β 0 · β1 + β 2 X 2n U N 1 X 11 1 X 12 β A . X B ]· :::: + V = . β B . 1 X 1n X 21 X 31 V 1 X 22 X 32 V2 β0 · β1 + β 2 β 3 V 21 X 2 n X 3n n TEMA 2. INTRODUCCIÓN: GENERALIZACIÓN Y EXTENSIÓN DEL MODELO DE REGRESIÓN 2.3) INCLUSIÓN DE VARIABLES SUPERFLUAS - Estimación: (Ver demostraciones) MODELO DE TRABAJO ESTIMACIÓN MCO ESTIMADOR INSESGADO Y = X * ·β * + V = X A ⋅ β A + X B ·β B + V ( βˆ * = X *' ⋅ X * ) −1 ⋅ X *' ⋅ Y = P ⋅ β A + ( X *' ⋅ X * ) −1 ⋅ X *' ⋅ U βA * E ( βˆ ) = :::: ϑ ESTIMADOR CONSISTENTE VARIANZA DE LOS ESTIMADORES 22 TEMA 2. INTRODUCCIÓN: GENERALIZACIÓN Y EXTENSIÓN DEL MODELO DE REGRESIÓN 2.3) INCLUSIÓN DE VARIABLES SUPERFLUAS - Consecuencias: 1-. Las Estimaciones de β̂ * son INSESGADAS. 2-. Las Estimaciones de β̂ * son CONSISTENTES. ( ) 3-. E σˆU2 = σ 2 Se puede hacer inferencia estadística 23 TEMA 2. INTRODUCCIÓN: GENERALIZACIÓN Y EXTENSIÓN DEL MODELO DE REGRESIÓN 24 TEMA 2: ERRORES DE ESPECIFICACIÓN Y PROBLEMAS CON LA MUESTRA 2.4) ERROR EN LA ESPECIFICACIÓN DE LA FORMA FUNCIONAL - Planteamiento del Problema - Tipos de Modelos según la Relación Funcional · Modelos Lineales · Modelos No-lineales pero Fácilmente Linealizables. · Modelos Intrínsecamente No-lineales - ¿Cómo se puede detectar la No-linealidad? 25 TEMA 2. INTRODUCCIÓN: GENERALIZACIÓN Y EXTENSIÓN DEL MODELO DE REGRESIÓN 2.4) ERROR EN LA ESPECIFICACIÓN DE LA FORMA FUNCIONAL - Planteamiento del Problema: SUPUESTO DE LINEALIDAD Y = X ·β + U La Forma Funcional de nuestro modelo es LINEAL tanto en Parámetros como en Variables Y = F(X ) +U La Especificación INCORRECTA de la Forma Funcional Genera Estimadores Sesgados e Inconsistentes. 26 TEMA 2. INTRODUCCIÓN: GENERALIZACIÓN Y EXTENSIÓN DEL MODELO DE REGRESIÓN 2.4) ERROR EN LA ESPECIFICACIÓN DE LA FORMA FUNCIONAL - Tipos de Modelos Según la Forma Funcional: 1) MODELOS LINEALES F(X ) Presenta una Estructura Lineal tanto en Variables como en Parámetros Y = X ·β + U Yi = β 0 + β1 ⋅ X 1i + β 2 ⋅ X 2i + ... + β k ⋅ X ki + U i 27 TEMA 2. INTRODUCCIÓN: GENERALIZACIÓN Y EXTENSIÓN DEL MODELO DE REGRESIÓN 2.4) ERROR EN LA ESPECIFICACIÓN DE LA FORMA FUNCIONAL - Tipos de Modelos Según la Forma Funcional: 2) MODELOS NO-LINEALES PERO LINEALIZABLES NO-LINEAL EN LAS VARIABLES EXPLICATIVAS Yi = β 0 + β 1 ·e X 1i + β 2 · X 22i + u i Z1 = e X 1i Z2 = X 2 2i Yi = β 0 + β1 ·Z1 + β 2 ·Z 2 + ui NO-LINEAL EN PARÁMETROS Qi = A· X iβ1 ·Lβi 2 ·e ui ln(Qi ) = ln( A) + β 1 ·ln( X i ) + β 2 ·ln( Li ) + u i 28 TEMA 2. INTRODUCCIÓN: GENERALIZACIÓN Y EXTENSIÓN DEL MODELO DE REGRESIÓN 2.4) ERROR EN LA ESPECIFICACIÓN DE LA FORMA FUNCIONAL - Tipos de Modelos Según la Forma Funcional: 3) MODELOS INTRÍNSECAMENTE NO-LINEALES [ Qi = α · δ ·L−i p + (1 − δ )·K n −p p i ] 29 TEMA 2. INTRODUCCIÓN: GENERALIZACIÓN Y EXTENSIÓN DEL MODELO DE REGRESIÓN 2.4) ERROR EN LA ESPECIFICACIÓN DE LA FORMA FUNCIONAL Modelos No-Lineales pero Fácilmente Linealizables · Modelo Doble-Log (Modelo Exponencial) Yi = β 0 · X 1βi 1 · X 2βi2 ·...· X Kiβ K ·e ui Los Parámetros β j miden la ELASTICIDAD de X j respecto a Y ε Y ,X j ∂Y X j = · = βj ∂X j Y ln(Yi ) = ln(β 0 ) + β1 ·ln( X 1i ) + β 2 ·ln( X 2i ) + ... + β K ·ln( X Ki ) + u i MCO 30 TEMA 2. INTRODUCCIÓN: GENERALIZACIÓN Y EXTENSIÓN DEL MODELO DE REGRESIÓN 2.4) ERROR EN LA ESPECIFICACIÓN DE LA FORMA FUNCIONAL Modelos No-Lineales pero Fácilmente Linealizables · Modelo Semi-Log Yi = e β 0 + β1 · X 1i + β 2 · X 2 i +...+ β K · X Ki ·eui Los Parámetros β j miden el cambio relativo de la variable Y motivado por una unidad de cambio en X j . ∂Y 1 · = βj ∂X j Y ln(Yi ) = β 0 + β1 · X 1i + β 2 · X 2i + ... + β K · X Ki + ui MCO 31 TEMA 2. INTRODUCCIÓN: GENERALIZACIÓN Y EXTENSIÓN DEL MODELO DE REGRESIÓN 2.4) ERROR EN LA ESPECIFICACIÓN DE LA FORMA FUNCIONAL Modelos No-Lineales pero Fácilmente Linealizables · Modelo Semi-Log Yi = β 0 + β1 ·ln( X 1i ) + β 2 ·ln( X 2i ) + ... + β K ·ln( X Ki ) + ui Los Parámetros β j miden el cambio absoluto de la variable Y motivado por cambios relativos en X j . ∂Y ·X j = β j ∂X j 32 TEMA 2. INTRODUCCIÓN: GENERALIZACIÓN Y EXTENSIÓN DEL MODELO DE REGRESIÓN 2.4) ERROR EN LA ESPECIFICACIÓN DE LA FORMA FUNCIONAL Modelos No-Lineales pero Fácilmente Linealizables · Modelo Recíproco 1 Yi = β 0 + β1 · + ui X 1i Z1 = 1 X1 Yi = β 0 + β1 ·Z1 + ui 33 TEMA 2. INTRODUCCIÓN: GENERALIZACIÓN Y EXTENSIÓN DEL MODELO DE REGRESIÓN 2.4) ERROR EN LA ESPECIFICACIÓN DE LA FORMA FUNCIONAL - ¿Cómo se puede Detectar la No-linealidad?: Representación Gráfica de la Posible Forma Funcional: X vs. Y Y Y 1 50 100 45 90 40 80 35 70 30 60 Y 25 50 20 40 15 30 10 20 5 10 0 1 2 3 4 5 X X 6 7 8 9 10 0 -5 -4 -3 -2 -1 0 1 2 3 4 5 X 34 TEMA 2. INTRODUCCIÓN: GENERALIZACIÓN Y EXTENSIÓN DEL MODELO DE REGRESIÓN 2.4) ERROR EN LA ESPECIFICACIÓN DE LA FORMA FUNCIONAL - ¿Cómo se puede Detectar la No-linealidad?: Representación Gráfica de los Residuos MCO respecto a la VariableY 2 4 60 3 50 2 1 Y 40 0 Y -1 30 -2 20 -3 -4 10 -5 -6 20 30 40 50 60 e 70 80 90 0 20 30 40 50 60 70 80 90 e 35 TEMA 2. INTRODUCCIÓN: GENERALIZACIÓN Y EXTENSIÓN DEL MODELO DE REGRESIÓN 2.4) ERROR EN LA ESPECIFICACIÓN DE LA FORMA FUNCIONAL - ¿Cómo se puede Detectar la No-linealidad?: Representación Gráfica de la VariableY respecto a Yˆ 3 100 100 Yˆ Yˆ 90 90 80 80 70 70 60 60 50 50 40 40 30 30 20 20 10 10 20 30 40 50 60 Y 70 80 90 100 10 10 20 30 40 50 60 70 80 90 Y 36 100 TEMA 2. INTRODUCCIÓN: GENERALIZACIÓN Y EXTENSIÓN DEL MODELO DE REGRESIÓN 2.4) ERROR EN LA ESPECIFICACIÓN DE LA FORMA FUNCIONAL - ¿Cómo se puede Detectar la No-linealidad?: 4 Signos de los Coeficientes Estimados Incorrectos 5 Valor muy bajo del R-CUADRADO 6 Regresión por Tramos 7 Contraste RESET de Ramsey 37 TEMA 2: ERRORES DE ESPECIFICACIÓN Y PROBLEMAS CON LA MUESTRA 2.5) MULTICOLINEALIDAD 2.5.1) Introducción 2.5.2) Causas de la Presencia de Multicolinealidad 2.5.3) Relación entre Variables Explicativas. · Multicolinealidad Perfecta · Ortogonalidad · Multicolinealidad Imperfecta 2.5.4) Consecuencias 2.5.5) Detección 2.5.6) Solución 38 TEMA 2: ERRORES DE ESPECIFICACIÓN Y PROBLEMAS CON LA MUESTRA 2.5) MULTICOLINEALIDAD 2.5.1) Introducción ¿QUÉ ES LA MULTICOLINEALIDAD? Un modelo presenta problemas de MULTICOLINEALIDAD si alguna variable explicativa se puede representar como una combinación exacta o aproximada de las otras variables explicativas. 1-. PERFECTA TIPOS DE MULTICOLINEALIDAD 2-. APROXIMADA 39 TEMA 2: ERRORES DE ESPECIFICACIÓN Y PROBLEMAS CON LA MUESTRA 2.5) MULTICOLINEALIDAD 2.5.1) Introducción 1-. MULTICOLINEALIDAD PERFECTA Rango( X ) < K + 1 Una Columna de la matriz X se puede expresar como una combinación lineal de alguna o algunas de las demás. x ji = α 0 + α1 · x1i + ... + α ( j −1) · x( j −1)i + α ( j +1) · x( j +1) i + ... + α k · xki Ejemplo: 1 x11 1 x12 . . X = . . . . 1 x 1n x21 1 20 17 x21 1 20 15 . . . . = . . . . . . . . x2 n 1 20 31 INCUMPLIMIENTO HIPÓTESIS MRLC x 2i = 20·x0i 40 TEMA 2: ERRORES DE ESPECIFICACIÓN Y PROBLEMAS CON LA MUESTRA 2.5) MULTICOLINEALIDAD 2.5.1) Introducción 2-. MULTICOLINEALIDAD APROXIMADA Rango( X ) = K + 1 Una Columna de la matriz X se puede expresar aproximadamente como una combinación lineal de alguna o algunas de las demás. x ji ≈ α 0 + α1 · x1i + ... + α ( j −1) · x( j −1)i + α ( j +1) · x( j +1) i + ... + α k · xki Ejemplo: 1 x11 1 x12 . . X = . . . . 1 x 1n x21 1 19.5 17 x21 1 20.5 15 . . . . = . . . . . . . . x2 n 1 20 31 · CUMPLE HIPÓTESIS MRLC x2i ≈ 20·x0i · EMCO SON MELI 41 TEMA 2: ERRORES DE ESPECIFICACIÓN Y PROBLEMAS CON LA MUESTRA 2.5) MULTICOLINEALIDAD 2.5.1) Introducción ESQUEMA DE ACTUACIÓN 1 Detectar la existencia de Multicolinealidad No Multicol. MRLC Perfecta MCO NO MCO Sí Multicol. Aproximada 2 Analizar las CAUSAS que provocan el problema 3 CONSECUENCIAS de la Multicolinealidad 4 Buscar SOLUCIONES al problema MCO 42 TEMA 2: ERRORES DE ESPECIFICACIÓN Y PROBLEMAS CON LA MUESTRA 2.5) MULTICOLINEALIDAD 2.5.2) Causas de la Existencia de Multicolinealidad 1 Existe una RELACIÓN CAUSAL entre 2 o más variables explicativas 2 Existe una TENDENCIA CRECIENTE entre las variables explicativas 3 Se crean nuevas variables por medio de una TRANSFORMACIÓN INCORRECTA de variables 4 Incorrecta utilización de variables ficticias 5 Existe una variable explicativa con ESCASA VARIABILIDAD 6 Existe una RELACIÓN CASUAL entre las variables explicativas 43 TEMA 2: ERRORES DE ESPECIFICACIÓN Y PROBLEMAS CON LA MUESTRA 2.5) MULTICOLINEALIDAD 2.5.3) Tipos de Relaciones entre Variables Explicativas TIPOS DE RELACIONES ENTRE VARIABLES EXPLICATIVAS 1-. MULTICOLINEALIDAD PERFECTA 2-. ORTOGONALIDAD 3-. MULTICOLINEALIDAD APROXIMADA Explicación: (Ver notas de clase) 44 TEMA 2: ERRORES DE ESPECIFICACIÓN Y PROBLEMAS CON LA MUESTRA 2.5) MULTICOLINEALIDAD 2.5.3) Tipos de Relaciones entre Variables Explicativas TIPOS DE RELACIONES ENTRE VARIABLES EXPLICATIVAS 1-. MULTICOLINEALIDAD PERFECTA MODELO Matriz de Regresores PROBLEMA Yi = β 0 + β1 ⋅ X 1i + β 2 ⋅ X 2i + ... + β k ⋅ X ki + U i 1 X 11 1 X 12 . . X = . . . . 1 X 1n ... X k 1 ... X k 2 ... . ... . ... . ... X kn ∀i = 1,2,..., n ui → N (0, σ u2 ) MULTICOLINEALIDAD PERFECTA: Una de las variables de la matriz X se puede expresar como una Combinación Lineal del resto de variables. Rang ( X ) < K + 1 ⇒ Rang ( X ) = Rang ( X '·X ) < K + 1 ⇒det( X '·X ) = 0 ⇒ −1 ⇒ No Existe ( X '· X ) −1 ⇒ βˆMCO = ( X '·X ) · X '·Y INDETERMIN ADOS 45 TEMA 2: ERRORES DE ESPECIFICACIÓN Y PROBLEMAS CON LA MUESTRA 2.5) MULTICOLINEALIDAD 2.5.3) Tipos de Relaciones entre Variables Explicativas TIPOS DE RELACIONES ENTRE VARIABLES EXPLICATIVAS 1-. MULTICOLINEALIDAD PERFECTA: Un Ejemplo Yi = β 0 + β1 ⋅ X 1i + β 2 ⋅ X 2i + U i ∀i = 1,2,..., n ui → N (0, σ u2 ) Suponemos que existe MULTICOLINEALIDAD PERFECTA: 1 X 11 1 X 12 . . X= . . . . 1 X 1n X 12 X 22 . . . X 2 n 1 X ' = X 11 X 21 X 2i = α · X 1i 1 . . . 1 X 12 . . . X 1n X 22 . . . X 2 n 46 TEMA 2: ERRORES DE ESPECIFICACIÓN Y PROBLEMAS CON LA MUESTRA 2.5) MULTICOLINEALIDAD 2.5.3) Tipos de Relaciones entre Variables Explicativas TIPOS DE RELACIONES ENTRE VARIABLES EXPLICATIVAS 1-. MULTICOLINEALIDAD PERFECTA: Un Ejemplo 1 X '·X = X 11 X 21 1 . . . 1 X 12 . . . X 1n X 22 . . . X 2 n 1 X 11 1 X 12 . . . . . . 1 X 1n n n n X 1i α ·∑ X 1i ∑ i =1 i =1 n n n = X 2i = α · X 1i = ∑ X 1i α ·∑ X 12i X 12i ∑ i =1 i =1 i =1n n n 2 2 2 α · X α · X α · X ∑ ∑ 1i 1i ∑ 1i i =1 i =1 i =1 X 21 X 22 . = . . X 2 n n n ∑ X 1i in=1 X ∑ 2i i =1 n ∑X 1i i =1 n ∑X 2 1i i =1 n ∑X 2i i =1 n X · X ∑ 2i 1i = i =1 n 2 X 2i ∑ i =1 n · X 1i i =1 ∑X 2i EL DETERMINANTE DE ESTA MATRIZ ES IGUAL A CERO det( X '·X ) = 0 47 TEMA 2: ERRORES DE ESPECIFICACIÓN Y PROBLEMAS CON LA MUESTRA 2.5) MULTICOLINEALIDAD 2.5.3) Tipos de Relaciones entre Variables Explicativas TIPOS DE RELACIONES ENTRE VARIABLES EXPLICATIVAS 1-. MULTICOLINEALIDAD PERFECTA: Un Ejemplo Del Sistema de Ecuaciones visto en el Tema 1 (transp. 35) para lograr los EMCO obtenemos ( X '⋅ X ) · βˆ n X 1i α ·∑ X 1i ∑ i =1 i =1 n n n 2 2 X X · X α ∑ ∑ 1i 1i ∑ 1i i =1 i =1 i =1 n n n α · X α · X 2 α 2 · X 2 ∑ ∑ 1i 1i ∑ 1i i =1 i =1 i =1 n = X '·Y ∑ Yi i =1 n X · Y ∑ 1i i in=1 X ·Y ∑ 2i i i =1 n n βˆ0 βˆ1 = βˆ 2 = X 2i = α · X 1i n ∑ Yi i =1 n = ∑ X 1i ·Yi i =1n α · X ·Y ∑ 1i i i =1 48 TEMA 2: ERRORES DE ESPECIFICACIÓN Y PROBLEMAS CON LA MUESTRA 2.5) MULTICOLINEALIDAD 2.5.3) Tipos de Relaciones entre Variables Explicativas TIPOS DE RELACIONES ENTRE VARIABLES EXPLICATIVAS 1-. MULTICOLINEALIDAD PERFECTA: Un Ejemplo Multiplicando obtenemos el siguiente sistema de ecuaciones: n 1 2 n n·βˆ0 + βˆ1 ·∑ X 1i + α ·βˆ2 ·∑ X 1i = ∑ Yi i =1 n i =1 n n i =1 n βˆ0 ·∑ X 1i + βˆ1 ·∑ X + α ·βˆ2 ·∑ X = ∑ X 1i ·Yi 2 1i i =1 2 1i i =1 n 3 n i =1 n i =1 n n α ·βˆ0 ·∑ X 1i + α ·βˆ1 ·∑ X + α ·βˆ2 ·∑ X = α ·∑ X 1i ·Yi 2 1i i =1 i =1 2 2 1i i =1 ESTAS 2 ECUACIONES SON IGUALES i =1 Tenemos un Sistema de 2 Ecuaciones con 3 Incógnitas. No podemos obtener los βˆ MCO 49 TEMA 2: ERRORES DE ESPECIFICACIÓN Y PROBLEMAS CON LA MUESTRA 2.5) MULTICOLINEALIDAD 2.5.3) Tipos de Relaciones entre Variables Explicativas TIPOS DE RELACIONES ENTRE VARIABLES EXPLICATIVAS 1-. MULTICOLINEALIDAD PERFECTA: Un Ejemplo No es posibles estimar los de X 1 y X 2 sobre Y β̂ MCO pero sí en cambio el EFECTO CONJUNTO E (Yi X 1 , X 2 ) = E ( β 0 + β1 ⋅ X 1i + β 2 ⋅ X 2i + U i ) = X 2i = α · X 1i = = E ( β 0 + β1 ⋅ X 1i + β 2 ⋅ (α · X 1i ) + U i ) = = E ( β 0 + ( β1 + α ·β 2 )· X 1i + U i ) = β 0 + ( β1 + α ·β 2 )· X 1i + E (U i ) = = β 0 + ( β1 + α ·β 2 )· X 1i 50 TEMA 2: ERRORES DE ESPECIFICACIÓN Y PROBLEMAS CON LA MUESTRA 2.5) MULTICOLINEALIDAD 2.5.3) Tipos de Relaciones entre Variables Explicativas TIPOS DE RELACIONES ENTRE VARIABLES EXPLICATIVAS 2-. ORTOGONALIDAD DEFINICIÓN Dos variables son ORTOGONALES si están INCORRELADAS (coeficiente de correlación lineal igual a cero). n X · X 2 = ∑ X 1i · X 2i = 0 ' 1 X 1 y X 2 Incorreladas i =1 Dos grupos de regresores A y B son ORTOGONALES si Cada regresor del grupo A está X A' · X B = 0 incorrelado con cada regresor del gruo B 51 TEMA 2: ERRORES DE ESPECIFICACIÓN Y PROBLEMAS CON LA MUESTRA 2.5) MULTICOLINEALIDAD 2.5.3) Tipos de Relaciones entre Variables Explicativas TIPOS DE RELACIONES ENTRE VARIABLES EXPLICATIVAS 2-. ORTOGONALIDAD: Un Ejemplo ∀i = 1,2,..., n Yi* = β1* ⋅ X 1*i + β 2* ⋅ X 2*i + U i En donde Yi * = Yi − Y X 1*i = X 1i − X 1 * 2i X = X 2i − X 2 ui → N (0, σ u2 ) Modelo en Desviaciones Vamos a suponer que X 1* y X 2* son ORTOGONALES n X · X = ∑ X 1*i · X 2*i = 0 *' 1 * 2 i =1 52 TEMA 2: ERRORES DE ESPECIFICACIÓN Y PROBLEMAS CON LA MUESTRA 2.5) MULTICOLINEALIDAD 2.5.3) Tipos de Relaciones entre Variables Explicativas TIPOS DE RELACIONES ENTRE VARIABLES EXPLICATIVAS 2-. ORTOGONALIDAD: Un Ejemplo * βˆMCO = ( X *' · X * ) −1 · X *' ·Y * X 11* * X 12 . X* = . . X* 1n * X 21 * X 22 . . . X 2*n * X X *' = 11 * X 21 X 12* * X 22 X 1*n * . . . X 2n . . . 53 TEMA 2: ERRORES DE ESPECIFICACIÓN Y PROBLEMAS CON LA MUESTRA 2.5) MULTICOLINEALIDAD 2.5.3) Tipos de Relaciones entre Variables Explicativas TIPOS DE RELACIONES ENTRE VARIABLES EXPLICATIVAS 2-. ORTOGONALIDAD: Un Ejemplo X X ·X = X *' (X *' ·X * * * 11 * 21 X X 1 n ∑ X *2 1i −1 i =1 = 0 ) * 12 * 22 X . . . X . . . 1 n X 2*i2 ∑ i =i 0 * 1n * 2n X 11* * X 12 . · . . X* 1n * X 21 * X 22 n *2 X 1i . i =1 = . 0 . X 2*n ∑ n *2 X ∑ 2i i =i 0 54 TEMA 2: ERRORES DE ESPECIFICACIÓN Y PROBLEMAS CON LA MUESTRA 2.5) MULTICOLINEALIDAD 2.5.3) Tipos de Relaciones entre Variables Explicativas TIPOS DE RELACIONES ENTRE VARIABLES EXPLICATIVAS 2-. ORTOGONALIDAD: Un Ejemplo * X X *' ·Y *= 11* X 21 X 12* . . . * X 22 . . . Y1* * n Y * * 2 X 1*n . X 1i ·Yi i =1 = X 2*n · . n * * X 2i ·Yi i =1 . Y * n ∑ ∑ 55 TEMA 2: ERRORES DE ESPECIFICACIÓN Y PROBLEMAS CON LA MUESTRA 2.5) MULTICOLINEALIDAD 2.5.3) Tipos de Relaciones entre Variables Explicativas TIPOS DE RELACIONES ENTRE VARIABLES EXPLICATIVAS 2-. ORTOGONALIDAD: Un Ejemplo βˆ * MCO βˆ1* = * = ( X *' · X * ) −1 · X *' ·Y * = βˆ2 n * * ∑ X 1i ·Yi i =1 Cov( X 1 , Y ) n *2 ∑ X 1i Var ( X 1 ) = = ni =1 X * ·Y * Cov( X , Y ) 2 2i i ∑ Var ( X ) i =1 2 n ∑ X 2*i2 i =1 1 n ∑ X *2 i =1 1i 0 1 n *2 X 2i ∑ i =i 0 n * * ∑ X 1i ·Yi = · in=1 * * ∑ X 2i ·Yi i =1 56 TEMA 2: ERRORES DE ESPECIFICACIÓN Y PROBLEMAS CON LA MUESTRA 2.5) MULTICOLINEALIDAD 2.5.3) Tipos de Relaciones entre Variables Explicativas 2-. ORTOGONALIDAD: Un Ejemplo Los estimadores MCO son los mismos al Estimar un Modelo de Regresión Lineal Múltiple Yi* = β1* ⋅ X 1*i + β 2* ⋅ X 2*i + U i que dos Modelos de Regresión Simples Yi * = δ1 ⋅ X 1*i + Vi βˆ1* = δˆ1 βˆ2* = δˆ2 Yi * = δ 2 ⋅ X 2*i + Wi Si los regresores X 1* y X 2* son ortogonales n X · X = ∑ X 1*i · X 2*i = 0 *' 1 * 2 i =1 57 TEMA 2: ERRORES DE ESPECIFICACIÓN Y PROBLEMAS CON LA MUESTRA 2.5) MULTICOLINEALIDAD 2.5.3) Tipos de Relaciones entre Variables Explicativas 2-. ORTOGONALIDAD: Un Ejemplo ( * Los estimadores MCO son los mismos βˆ1* = δ1 y βˆ2 = δ 2 ) si X 1* y X 2* son ORTOGONALES. Pero habrá diferencias en la ESTIMACIÓN DE LAS VARIANZAS. · VARIANZA DEL MODELO DE REGRESIÓN LINEAL MÚLTIPLE * 2 u ( *' Vˆ ( βˆ ) = σˆ · X · X ) * −1 Vˆ ( βˆ *j ) = σˆ u2 n * X ∑ ji ; σˆ u2 = e'·e n−2 i =1 58 TEMA 2: ERRORES DE ESPECIFICACIÓN Y PROBLEMAS CON LA MUESTRA 2.5) MULTICOLINEALIDAD 2.5.3) Tipos de Relaciones entre Variables Explicativas 2-. ORTOGONALIDAD: Un Ejemplo · VARIANZA DE LOS MODELOS DE REGRESIÓN LINEAL SIMPLE 2 v ( *' 1 Vˆ (δˆ1 ) = σˆ · X · X ) * −1 1 2 v = σˆ · vˆ'·vˆ ; σˆ = n −1 *2 1 2 v n ∑X 1i i =1 2 w ( *' 2 Vˆ (δˆ2 ) = σˆ · X · X ) * −1 2 2 w = σˆ · 1 2 σ ˆ ; v = n ∑X *2 2i wˆ '·wˆ n −1 i =1 En este ejemplo, además, se verifica que (Demostración) e'·e < vˆ'·vˆ + wˆ '·wˆ El ajuste es mayor en el Modelo de Regresión 59 Múltiple TEMA 2: ERRORES DE ESPECIFICACIÓN Y PROBLEMAS CON LA MUESTRA 2.5) MULTICOLINEALIDAD 2.5.3) Tipos de Relaciones entre Variables Explicativas TIPOS DE RELACIONES ENTRE VARIABLES EXPLICATIVAS 3-. MULTICOLINEALIDAD APROXIMADA Una o más de las variables explicativas pueden expresarse aproximadamente como una combinación lineal de las restante x ji ≈ α 0 + α1 · x1i + ... + α ( j −1) · x( j −1)i + α ( j +1) · x( j +1) i + ... + α k · xki No existe una relación lineal exacta entre uno o más regresores pero sí están fuertemente correlacionados. Rang ( X ) = K + 1 ⇒ Rang ( X ) = Rang ( X '·X ) = K + 1 ⇒ det( X '·X ) ≠ 0 −1 ⇒ Existe ( X '·X ) −1 ⇒ βˆMCO = ( X '·X ) · X '·Y PREGUNTA: ¿Cuál es el Multicolinealidad Aproximada? Problema de la Existencia de la 60 TEMA 2: ERRORES DE ESPECIFICACIÓN Y PROBLEMAS CON LA MUESTRA 2.5) MULTICOLINEALIDAD 2.5.3) Tipos de Relaciones entre Variables Explicativas TIPOS DE RELACIONES ENTRE VARIABLES EXPLICATIVAS 3-. MULTICOLINEALIDAD APROXIMADA PREGUNTA: ¿Cuál es el Multicolinealidad Aproximada? Problema de la Existencia de la −1 muy elevado ⇒ det( X '·X ) ≠ 0 pero… det( X '·X ) ≈ 0 ⇒ ( X '·X ) ( ⇒ Vˆ ( βˆ ) = σˆ u2 · X ' · X ) −1 elevada ⇒ LA MATRIZ DE VARIANZAS-COVARIANZAS DE LOS EMCO SERÁN MUY ELEVADAS LOS EMCO SON IMPRECISOS 61 TEMA 2: ERRORES DE ESPECIFICACIÓN Y PROBLEMAS CON LA MUESTRA 2.5) MULTICOLINEALIDAD 2.5.3) Tipos de Relaciones entre Variables Explicativas 3-. MULTICOLINEALIDAD APROXIMADA PREGUNTA: ¿Qué CONSECUENCIAS se derivan de la existencia de una matriz de Varianzas-Covarianzas elevada? - Los Intervalos de Confianza serán excesivamente amplios IC(1−α ) = βˆ j ± S βˆ j ⋅ t n − k −1,α 2 S β̂ j Elevado ⇒ IC amplio - Los Estimadores MCO serán Imprecisos tj = βˆ j S βˆ j ; S β̂ j Elevado ⇒ t j Bajos ⇒ Tendencia aceptar H0 62 TEMA 2: ERRORES DE ESPECIFICACIÓN Y PROBLEMAS CON LA MUESTRA 2.5) MULTICOLINEALIDAD 2.5.3) Tipos de Relaciones entre Variables Explicativas 3-. MULTICOLINEALIDAD APROXIMADA PREGUNTA: ¿Qué CONSECUENCIAS se derivan de la existencia de una matriz de Varianzas-Covarianzas elevada? - En consecuencia, será difícil analizar la relevancia de la variable explicativa - Es muy probable que los β̂ MCO tengan SIGNOS INCORRECTOS. A PESAR DE ESTOS INCONVENIENTES, LOS EMCO SIGUEN SIENDO MELI. AHORA BIEN, NO ES LA MEJOR ESTIMACIÓN QUE PODEMOS REALIZAR. 63 TEMA 2: ERRORES DE ESPECIFICACIÓN Y PROBLEMAS CON LA MUESTRA 2.5) MULTICOLINEALIDAD 2.5.3) Tipos de Relaciones entre Variables Explicativas 3-. MULTICOLINEALIDAD APROXIMADA: Un ejemplo Yi* = β1* ⋅ X 1*i + β 2* ⋅ X 2*i + U i En donde Modelo en Desviaciones Yi* = Yi − Y * * 1i X = X 1i − X 1 X 2*i = X 2i − X 2 * Vamos a suponer que X 1 y X 2 están fuertemente correlacionadas. Suponemos que el Coeficiente de Correlación está próximo a 1 n n ∑ ( X 1i − X 1 )(· X 2i − X 2 ) r12 = * * X X · ∑ 1i 2i i =1 n ∑ (X i =1 n ) ∑ (X 2 = 1i − X 1 · i =1 2i − X 2 ) 2 i =1 n ∑X i =1 ≈1 n *2 1i · ∑X i =1 *2 2i 64 TEMA 2: ERRORES DE ESPECIFICACIÓN Y PROBLEMAS CON LA MUESTRA 2.5) MULTICOLINEALIDAD 2.5.3) Tipos de Relaciones entre Variables Explicativas 3-. MULTICOLINEALIDAD APROXIMADA: Un ejemplo X X ·X = X *' * * 11 * 21 X X * 12 * 22 X . . . X . . . * 1n * 2n X 11* * X 12 . · . . X* 1n * X 21 * X 22 n *2 X 1i . i =1 = . n X 1*i · X 2*i . i =1 X 2*n ∑ ∑ * * X · X ∑ 1i 2i i =1 n *2 X 2i ∑ i =i n 65 TEMA 2: ERRORES DE ESPECIFICACIÓN Y PROBLEMAS CON LA MUESTRA 2.5) MULTICOLINEALIDAD 2.5.3) Tipos de Relaciones entre Variables Explicativas 3-. MULTICOLINEALIDAD APROXIMADA: Un ejemplo ( *' det X · X * )= X = ∑ X 1*i2 ·∑ X 2*i2 − ∑ X 1*i · X 2*i i =1 i =1 i =1 n *' ·X * n n 2 Este determinante se puede expresar en función del COEFICIENTE DE CORRELACIÓN r12 ( *' det X · X * )= X n *' n · X = (1 − r )·∑ X ·∑ X 2*i2 * 2 12 *2 1i i =1 * * X Cuanta mayor Correlación entre 1 y X 2 ( ) det X *' · X * se aproxima más a 0 (Demostración) i =1 r12 se aproxima más a 1 ( Vˆ ( βˆ ) = σˆ u2 · X ' · X ) −1 elevada 66 TEMA 2: ERRORES DE ESPECIFICACIÓN Y PROBLEMAS CON LA MUESTRA 2.5) MULTICOLINEALIDAD 2.5.3) Tipos de Relaciones entre Variables Explicativas 3-. MULTICOLINEALIDAD APROXIMADA: Un ejemplo ANÁLISIS DE LA MATRIZ DE VARIANZAS-COVARIANZAS (X *' ·X * ) −1 = 1 *' * · adj X · X det( X *' · X * ) ( ( )) t n ∑ X 2*i2 1 · ni =1 = *' * det( X · X ) − X * · X * ∑ 1i 2i i =1 − ∑ X 1*i · X 2*i i =1 n *2 X ∑ 1i i =1 n 67 TEMA 2: ERRORES DE ESPECIFICACIÓN Y PROBLEMAS CON LA MUESTRA 2.5) MULTICOLINEALIDAD 2.5.3) Tipos de Relaciones entre Variables Explicativas 3-. MULTICOLINEALIDAD APROXIMADA: Un ejemplo ANÁLISIS DE LA MATRIZ DE VARIANZAS-COVARIANZAS ( V (βˆMCO ) = σ u2 · X *' · X * ) −1 n V (βˆ1 ) = σ u2 · σ ·∑ X 2*i2 2 u n 1 *2 · X 2i = *' * ∑ det( X · X ) i =1 i =1 n (1 − r )·∑ X ·∑ X 2 12 *2 1i i =1 n = ∑X i =1 n *2 1i = ∑ ( X 1i − X 1 ) = n·Var ( X 1 ) i =1 2 = = n *2 2i i =1 σ u2 (1 − r )·n·Var ( X ) 2 12 1 68 TEMA 2: ERRORES DE ESPECIFICACIÓN Y PROBLEMAS CON LA MUESTRA 2.5) MULTICOLINEALIDAD 2.5.3) Tipos de Relaciones entre Variables Explicativas 3-. MULTICOLINEALIDAD APROXIMADA: Un ejemplo ANÁLISIS DE LA MATRIZ DE VARIANZAS-COVARIANZAS ( V (βˆMCO ) = σ u2 · X *' · X * V (β̂1 ) = V (β̂ 2 ) = ) −1 σ u2 (1 − r )·n·Var ( X ) 2 12 1 2 12 2 · σu · Poca Variabilidad de σ u2 (1 − r )·n·Var ( X El Valor de la Varianza de los Estimadores MCO depende de: 2 ) Xj Var ( X j ) · Tamaño Muestral (n) · Fuerte Correlación r12 69 TEMA 2: ERRORES DE ESPECIFICACIÓN Y PROBLEMAS CON LA MUESTRA 2.5) MULTICOLINEALIDAD 2.5.3) Tipos de Relaciones entre Variables Explicativas 3-. MULTICOLINEALIDAD APROXIMADA: Un ejemplo ¿Cómo Cuantificar el Efecto de la Multicolinealidad? V (β̂ j ) = σ u2 (1 − r )·n·Var ( X 2 12 j ) 1 FIV = 1 − r122 ( Ejemplo: Si r12 = 0.7 FIV = 1.96 ) FACTOR DE INFLACIÓN DE LA VARIANZA La Varianza de β̂1 o β̂ 2 será 1.96 más elevada que en el caso de que X 1 y X 2 sean ORTOGONALES 70 TEMA 2: ERRORES DE ESPECIFICACIÓN Y PROBLEMAS CON LA MUESTRA 2.5) MULTICOLINEALIDAD 2.5.3) Tipos de Relaciones entre Variables Explicativas 3-. MULTICOLINEALIDAD APROXIMADA: Un ejemplo En general, se define FIV como 1 FIV = 1 − RX2 j ( donde R X2 j ) es el COEFICIENTE DE CORRELACIÓN MÚLTIPLE. Es el R2 en la regresión X ji = α 0 + α1 · X 1i + ... + α ( j −1) · X ( j −1) i + α ( j +1) · X ( j +1) i + ... + α k · X ki + Vi ∀i = 1,2,..., n 71 TEMA 2: ERRORES DE ESPECIFICACIÓN Y PROBLEMAS CON LA MUESTRA 2.5) MULTICOLINEALIDAD 2.5.4) Consecuencias de la Existencia de Multicolinealidad 1 β̂ MCO Los serán elevados. Habrá problemas para interpretar los efectos directos de las variables explicativas 2 Afectará a la precisión de los β̂ MCO ya que su varianza será mayor. 3 Existe una tendencia a aceptar la no significatividad estadística de los parámetros del modelo. H 0 : β j = 0 H1 : β j ≠ 0 4 5 t= βˆi S βˆi = βˆi Vˆ ( βˆi ) La Multicolinealidad no afecta al valor del la capacidad predictiva del modelo. Sesgo a Aceptar R2 H0 ni del estadístico F, ni a β̂ MCO Los tendrán muchas veces los signos incorrectos y serán 72 muy sensibles al tamaño muestral. TEMA 2: ERRORES DE ESPECIFICACIÓN Y PROBLEMAS CON LA MUESTRA 2.5) MULTICOLINEALIDAD 2.5.4) Consecuencias de la Existencia de Multicolinealidad ATENCIÓN!!! Puede suceder que: SE RECHACE LA SIGNIFICACIÓN INDIVIDUAL DE TODOS LOS PARÁMETROS ACEPTAR H0 : β j = 0 ∀j PERO QUE SE RECHACE LA NO SIGNIFICACIÓN CONJUNTA RECHAZAR H 0 : β1 = β 2 = ... = β K = 0 73 TEMA 2: ERRORES DE ESPECIFICACIÓN Y PROBLEMAS CON LA MUESTRA 2.5) MULTICOLINEALIDAD 2.5.5) Detección y Cuantificación de la Multicolinealidad 1 Tras una Estimación MCO obtenemos: - Elevada Bondad de Ajuste (R2 elevado) - Estimadores Imprecisos (no significatividad estadística) ACEPTAR H0 : β j = 0 para muchos j - Incoherencia en los Contrastes de Hipótesis ACEPTAR RECHAZAR H0 : β j = 0 INDICAN LA POSIBLE PRESENCIA DE MULTICOL. ∀j H 0 : β1 = β 2 = ... = β K = 0 74 TEMA 2: ERRORES DE ESPECIFICACIÓN Y PROBLEMAS CON LA MUESTRA 2.5) MULTICOLINEALIDAD 2.5.5) Detección y Cuantificación de la Multicolinealidad 2 3 La lógica puede ayudarnos a conocer si existe o no una elevada relación lineal entre alguna de las variables explicativas del modelo. El Coeficiente de Correlación Lineal Simple puede ser un buen indicador de la existencia de multicolinealidad. n − 1 < rk , j < 1 ∑ (X rk , j = ki − X k )·(X ji − X j ) i =1 n ∑ (X − Xk ) · 2 ki i= Si 4 n ∑ (X i= rk , j > 0.9 − X j) rk , j = 0 No Correlación 2 ji rk , j = 1 Correlación Perfecta MULTICOLINEALIDAD El FIV de al menos un regresor es mayor que 10. 75 TEMA 2: ERRORES DE ESPECIFICACIÓN Y PROBLEMAS CON LA MUESTRA 2.5) MULTICOLINEALIDAD 2.5.5) Detección y Cuantificación de la Multicolinealidad 5 Si el determinante de la matriz de correlaciones está próximo a cero MULTICOLINEALIDAD r11 r21 . R= . . r k1 r12 r11 . . . rk 2 . r1k . r2 k . . . . . . . . . rkk . . . . . . . . . . RX ∈ [0,1] MATRIZ DE CORRELACIONES ENTRE LAS K VARIABLES DEL MODELO RX = 1 ORTOGONALIDAD RX = 0 MULTICOLINEALIDAD PERFECTA 76 TEMA 2: ERRORES DE ESPECIFICACIÓN Y PROBLEMAS CON LA MUESTRA 2.5) MULTICOLINEALIDAD 2.5.6) Soluciones a la Multicolinealidad 1 Aumentar el Tamaño Muestral 2 Utilizar Información a priori (ver ejemplo) 3 Eliminar aquella o aquellas variables que presentan una elevada correlación. Se optará por esta alternativa cuando: - Nuestro conocimiento sobre la relevancia de esta variable no sea favorable β j = 0 ⇒ X j fuera ( ) - Los coeficientes estimados tengan signos incorrectos cuando incluimos la variable y correctos cuando la excluimos. - Bajo valor de la varianza estimada del error de predicción cuando excluimos la variable. ¿QUÉ PROBLEMA NOS PODEMOS ENCONTRAR? Omisión de Variables Relevantes 77 TEMA 2: ERRORES DE ESPECIFICACIÓN Y PROBLEMAS CON LA MUESTRA 2.5) MULTICOLINEALIDAD 2.5.6) Soluciones a la Multicolinealidad 4 Transformar Variables (ejemplo: Tomar Primeras Diferencias) 5 Aplicar Métodos Alternativos de Estimación Ejemplo: El Estimador de Ridge βˆRIDGE = ( X '·X + C ·I )−1 · X '·Y donde C es una constante arbitrariamente seleccionada 78 TEMA 2: ERRORES DE ESPECIFICACIÓN Y PROBLEMAS CON LA MUESTRA 2.6) ERRORES DE MEDIDA 2.6.1) Planteamiento del Problema 2.6.2) Errores de Medida en la Variable Endógena 2.6.3) Errores de Medida en la Variable Exógena 79 TEMA 2: ERRORES DE ESPECIFICACIÓN Y PROBLEMAS CON LA MUESTRA 2.6) ERRORES DE MEDIDA 2.6.1) Planteamiento del Problema Valores de la V. Endógena POBLACIÓN Y Suponemos que son medidas sin error MUESTRA Valores de las V. Explicativas PROBLEMAS: - Errores en la recogida de datos - Variable objeto de Estudio no Disponible X Y REAL ≠ Y OBSERVADO X REAL ≠ X OBSERVADO - Errores de Medida 80 TEMA 2: ERRORES DE ESPECIFICACIÓN Y PROBLEMAS CON LA MUESTRA 2.6) ERRORES DE MEDIDA 2.6.1) Planteamiento del Problema VARIABLE LATENTE Y X VARIABLE PROXY Y* = Y + ε Verdadero Valor de la Variable: La variable es medida correctamente. No existen errores de medida pero los datos no están disponibles. Valor Observado de la Variable: Es una variable muy correlacionada con la variable latente, pero no coincide exactamente. Conocemos el valor de la variable pero existen errores de medida. X* = X + ω 81 TEMA 2: ERRORES DE ESPECIFICACIÓN Y PROBLEMAS CON LA MUESTRA 2.6) ERRORES DE MEDIDA 2.6.2) Errores de Medida en la Variable Endógena MODELO ECONOMÉTRICO PROBLEMA: Desconocemos el verdadero valor de Y · SUPUESTOS SOBRE 1 E(ε ) = 0 2 Cov(X, ε ) = 0 3 Cov(ε , U ) = 0 Y = X·β + U ε d U → N (ϑ , σ U2 ) Se aproxima por Y * (Variable Proxy) Y* =Y +ε 82 TEMA 2: ERRORES DE ESPECIFICACIÓN Y PROBLEMAS CON LA MUESTRA 2.6) ERRORES DE MEDIDA 2.6.2) Errores de Medida en la Variable Endógena MODELO A ESTIMAR * * Y = X·β + V d U → N (ϑ , σ U2 ) * * * * Y* = X·β * + U ⇒ Y = Y + ε ⇒ Y = Y + ε = X ·β + U + ε = X ·β + V en donde V = U + ε error de medida. recoge el efecto de la perturbación aleatoria y el −1 * βˆMCO = ( X '·X ) · X '·Y * (demostrar insesgadez) 83 TEMA 2: ERRORES DE ESPECIFICACIÓN Y PROBLEMAS CON LA MUESTRA 2.6) ERRORES DE MEDIDA 2.6.2) Errores de Medida en la Variable Endógena COMPARACIÓN DE VARIANZAS - VARIANZA CON ERRORES DE MEDIDA Y* = Y + ε ( ) −1 −1 2 V βˆ * = σ V2 ·( X '·X ) = σ (U +ε ) ·( X '·X ) ( ) = σ U2 + σ ε2 ·( X '·X ) −1 (Cov(ε ,U ) = 0) - VARIANZA SIN ERRORES DE MEDIDA ( ) V βˆ * > V(βˆ ) Y* = Y −1 V(βˆ ) = σ U2 ·( X '·X ) 84 TEMA 2: ERRORES DE ESPECIFICACIÓN Y PROBLEMAS CON LA MUESTRA 2.6) ERRORES DE MEDIDA 2.6.2) Errores de Medida en las Variables Exógenas Para simplificar el análisis suponemos un Modelo de Regresión Lineal Simple * 1i Yi = β 0 + β1 ·X + U i d U → N (ϑ , σ U2 ) ∀i = 1,...n * PROBLEMA: X 1i = X 1i + wi ; ∀i = 1,...n · SUPUESTOS SOBRE 1 E( w) = 0 2 Cov(U, w) = 0 3 Cov( X , w) ≠ 0 w 85 TEMA 2: ERRORES DE ESPECIFICACIÓN Y PROBLEMAS CON LA MUESTRA 2.6) ERRORES DE MEDIDA 2.6.2) Errores de Medida en las Variables Exógenas Para simplificar el análisis suponemos un Modelo de Regresión Lineal Simple MODELO VERDADERO Yi = β 0 + β1 ·X1i + U i ∀i = 1,...n d U → N (ϑ , σ U2 ) Yi = β 0 + β1 ·X1i + U i = X1i* = X 1i + wi ⇒ X 1i = X 1*i − wi = ( ) * = β + β ·X = β 0 + β1 · X − wi + U i 0 1 1i − β1 ·wi + U i * 1i Yi = β 0 + β1 ·X1i* + Z i en donde Z i = U i − β1 ·wi 86 TEMA 2: ERRORES DE ESPECIFICACIÓN Y PROBLEMAS CON LA MUESTRA 2.6) ERRORES DE MEDIDA 2.6.2) Errores de Medida en las Variables Exógenas Yi = β 0 + β1 ·X1i* + Z i PROPIEDADES DE Z i = U i − β1 ·wi Zi 1 E ( Z i ) = 0 ∀i 2 Cov ( Z i , Z j ) = 0 ∀i ≠ j 3 Cov( X * , Z ) = E X * − E X * ·(Z − E (Z )) = E X * − X ·Z [( ( ) )] [( ) ] [ ] = E [( X + W − X )·Z ] = E [W ·Z ]= E [W ·(U − β1 ·W )] = E W ·U − β1 ·W 2 = = Cov(W , U ) − β1 ·σ W2 = − β1 ·σ W2 = γ ≠ 0 87 TEMA 2: ERRORES DE ESPECIFICACIÓN Y PROBLEMAS CON LA MUESTRA 2.6) ERRORES DE MEDIDA 2.6.2) Errores de Medida en las Variables Exógenas Z i = U i − β1 ·wi Yi = β 0 + β1 ·X1i* + Z i Demostración: Cov( X * , Z ) = γ * Cov ( X ,Y ) MCO: βˆ1 = SESGADO * Var ( X ) Cov ( X * , Y − β 0 − β1 · X 1* ) = γ Cov( X * , Y ) − β1 ·Cov( X * , X * ) = γ Cov ( X * , Y ) γ β − = 1 Var ( X * ) Var ( X * ) E (βˆ1 ) = β1 + βˆ1 = β1 + γ * Var ( X ) ≠ β1 γ Var ( X * ) 88 TEMA 2: ERRORES DE ESPECIFICACIÓN Y PROBLEMAS CON LA MUESTRA 2.7) OBSERVACIONES ATÍPICAS 2.7.1) Planteamiento del Problema 2.7.2) Influencia Potencial o Leverage 2.7.3) Influencia Real 89 TEMA 2: ERRORES DE ESPECIFICACIÓN Y PROBLEMAS CON LA MUESTRA 2.7) OBSERVACIONES ATÍPICAS DEFINICIÓN: Las Observaciones Atípicas o Outliers muestran un comportamiento muy diferenciado respecto al resto de los valores de la muestra. PROBLEMA: Pueden tener una gran influencia en los resultados de la regresión. * OUTLIER 90 TEMA 2: ERRORES DE ESPECIFICACIÓN Y PROBLEMAS CON LA MUESTRA 2.7) OBSERVACIONES ATÍPICAS * OUTLIER * OUTLIER 91 TEMA 2: ERRORES DE ESPECIFICACIÓN Y PROBLEMAS CON LA MUESTRA 2.7) OBSERVACIONES ATÍPICAS 2.7.1) Planteamiento del Problema ¿CÓMO DETECTAR OUTLIERS?: · Graficar Y vs. X * 92 TEMA 2: ERRORES DE ESPECIFICACIÓN Y PROBLEMAS CON LA MUESTRA 2.7) OBSERVACIONES ATÍPICAS 2.7.1) Planteamiento del Problema ¿CÓMO DETECTAR OUTLIERS?: · Graficar X vs. Errores 93 TEMA 2: ERRORES DE ESPECIFICACIÓN Y PROBLEMAS CON LA MUESTRA 2.7) OBSERVACIONES ATÍPICAS 2.7.1) Planteamiento del Problema · ¿CÓMO DETECTAR OUTLIERS?: · Graficar Evolución de la Variable 94 TEMA 2: ERRORES DE ESPECIFICACIÓN Y PROBLEMAS CON LA MUESTRA 2.7) OBSERVACIONES ATÍPICAS 2.7.2) Influencia Potencial o Leverage DEFINICIÓN: La INFLUENCIA POTENCIAL de una observación sobre los resultados de la estimación viene determinada por los valores de las variables explicativas. Aquellas observaciones con VALORES EXTREMOS (aquéllos más alejados de los valores medios de las variables explicativas ) tienen MÁS INFLUENCIA que aquellas observaciones próximas a la media. 95 TEMA 2: ERRORES DE ESPECIFICACIÓN Y PROBLEMAS CON LA MUESTRA 2.7) OBSERVACIONES ATÍPICAS 2.7.2) Influencia Potencial o Leverage ¿Cómo medir la influencia Potencial de una Observación? LEVERAGE I n − X ·( X '·X ) · X ' = M −1 Yˆ = X ·β̂ = X ·( X '·X ) −1 · X '·Y = X ·( X '·X ) · X ' = I n − [I n − −1 = (I n − M )·Y − X ·( X '·X ) · X '] = (I n − M ) −1 = H = I n − M = H ·Y h11 h21 . H = . . h n1 h12 h22 . . . hn 2 . . . h1n . . . h2 n . . . . . . . . . . . . . . . hnn H contiene las ponderaciones que deben aplicarse a los valores observados de la endógena Y para obtener Yˆ . hij Es la influencia de la observación j sobre el valor estimado del valor i. 96 TEMA 2: ERRORES DE ESPECIFICACIÓN Y PROBLEMAS CON LA MUESTRA 2.7) OBSERVACIONES ATÍPICAS 2.7.2) Influencia Potencial o Leverage ¿Cómo medir la influencia Potencial de una Observación? LEVERAGE Yˆ = X ·βˆ = H ·Y Yˆi = hi1 ·Y1 + hi 2 ·Y2 + ... + hii ·Yi + ... + hin ·Yn hii tenderá a ser mayor cuando una El valor del LEVERAGE observación sea más diferente a las demás. 97 TEMA 2: ERRORES DE ESPECIFICACIÓN Y PROBLEMAS CON LA MUESTRA 2.7) OBSERVACIONES ATÍPICAS 2.7.2) Influencia Potencial o Leverage Ejemplo: Modelo de Regresión Lineal Simple Yi = β 0 + β1 ·X1i + U i La Expresión para hii es 1 ( X i − X ) hii = ·1 + n Var ( X ) 1 Estará acotado hii ∈ ,1 n Valores elevados de se hii corresponden con observaciones muy diferentes a la mayoría. 98 TEMA 2: ERRORES DE ESPECIFICACIÓN Y PROBLEMAS CON LA MUESTRA 2.7) OBSERVACIONES ATÍPICAS 2.7.2) Influencia Potencial o Leverage Ejemplo: Modelo de Regresión Lineal Simple Componentes de la Influencia Potencial 1 Tamaño Muestral: Cuantas más observaciones haya, menos influencia potencial tiene cada una de las observaciones. 2 Desviaciones respecto a la Media: Aquellas observaciones con valores de X i alejadas de su media presentarán un mayor leverage. 3 Dispersión de la Variable X : Si la variable exógena tiene una dispersión elevada, entonces tenderá a reducir el valor del leverage. 99 TEMA 2: ERRORES DE ESPECIFICACIÓN Y PROBLEMAS CON LA MUESTRA 2.7) OBSERVACIONES ATÍPICAS 2.7.2) Influencia Potencial o Leverage Ejemplo: Modelo de Regresión Lineal Múltiple 1 hii = · 1 + ( X i − X )·S −1 ·( X i − X ) n [ ] ' en donde X i = ( X 1i , X 2i ,..., X Ki ) , X = ( X , X ,..., X ) y S es la matriz ' de Varianzas-Covarianzas. n ∑h ii = traz ( H ) = traz[I n − M ] = n − (n − K − 1) = K + 1 i =1 REGLA DE DECISIÓN: 1 n K +1 h = ·∑ hii = n i =1 n Una observación que tenga una hii ( K + 1) > 3·h = 3· se puede considerar potencialmente influyente. n 100 TEMA 2: ERRORES DE ESPECIFICACIÓN Y PROBLEMAS CON LA MUESTRA 2.7) OBSERVACIONES ATÍPICAS 2.7.2) Influencia Real OBJETIVO Identificar aquellas observaciones cuya supresión conlleva a una modificación importante de los resultados de la estimación. Qué observaciones son las responsables del ajuste hasta el punto de determinar: - Qué variables son estadísticamente significativas - El signo de los coeficientes estimados - La no-linealidad de la relación entre variables - El incumplimiento de la hipótesis de normalidad - La capacidad predictiva del modelo 101 TEMA 2: ERRORES DE ESPECIFICACIÓN Y PROBLEMAS CON LA MUESTRA 2.7) OBSERVACIONES ATÍPICAS 2.7.2) Influencia Real * * * Observación i Gráfico A Se emplean todas las observaciones para llevar a cabo la regresión. Gráfico B Se excluye la observación i para llevar a cabo la regresión. CAMBIO SUSTANCIAL EN LA PENDIENTE 102 TEMA 2: ERRORES DE ESPECIFICACIÓN Y PROBLEMAS CON LA MUESTRA 2.7) OBSERVACIONES ATÍPICAS 2.7.2) Influencia Real ¿Cómo se mide la influencia real de una observación? 1 DISTANCIA DE COOK: Modelo estimado con todas las observaciones. Yˆ = X ·β̂ Yˆ (i ) = X ·βˆ ( (i ) Modelo estimado suprimiendo la observación (i) )( ' Yˆ − Yˆ (i ) · Yˆ − Yˆ ( i ) Di = (K + 1)·σ U2 ) o ( βˆ − βˆ ) ·( X '·X )·(βˆ − βˆ ) D = (i ) ' (K + 1)·σ U2 i d Di → FK +1,n − K −1 REGLA DE DECISIÓN: Si Di > FK +1,n − K −1,α La observación i presenta una fuerte influencia real sobre 103 la estimación. (i ) TEMA 2: ERRORES DE ESPECIFICACIÓN Y PROBLEMAS CON LA MUESTRA 2.7) OBSERVACIONES ATÍPICAS 2.7.2) Influencia Real ¿Cómo se mide la influencia real de una observación? 2 DFFITS: ( Yˆ − Yˆ ) = →t (i ) DFFITSi REGLA DE DECISIÓN: d σ U2 · hii n − K −1 DFFITSi ≥ 2 DFFITSi ≥ 2· k +1 n La observación i presenta una fuerte influencia real sobre la estimación. 104 TEMA 2: ERRORES DE ESPECIFICACIÓN Y PROBLEMAS CON LA MUESTRA 2.7) OBSERVACIONES ATÍPICAS 2.7.2) Influencia Real ¿Cómo se mide la influencia real de una observación? 3 DFBETAS: DFBETASij REGLA DE DECISIÓN: ( βˆ = σ − βˆ j j 2(i ) U DFBETASij ≥ (i ) ) · a jj 2 n para algún j La observación i presenta una fuerte influencia real sobre la estimación. 105