Alternativas estadísticas al cálculo del Valor en Riesgo

Anuncio

ESTADÍSTICA ESPAÑOLA

Vol. 46, Núm. 155, 2004, págs. 119 a 148

Alternativas estadísticas al cálculo del

Valor en Riesgo

por

PEDRO GENTO MARHUENDA

Facultad de Derecho y CC. Sociales de Ciudad Real

Universidad de Castilla-La Mancha

JUAN FCO. ORTEGA DATO

GONZALO GARCÍA-DONATO LAYRÓN

Facultad de C.C. Económicas y Empresariales de Albacete

Universidad de Castilla-La Mancha

RESUMEN

El Valor en Riesgo (VaR) es una medida estadística de las pérdidas potenciales de una cartera de instrumentos financieros.

En este trabajo presentamos dos procedimientos estadísticos alternativos para el cálculo del Valor en Riesgo. El primero consiste en

aplicar la metodología Bayesiana, confiando en su particular potencial

para el tratamiento de los problemas predictivos. Por otro lado, con el

objeto de prevenir la influencia por la presencia de observaciones atípicas, el segundo procedimiento consiste en la utilización de técnicas

Robustas en la estimación del VaR. Los modelos resultantes de la utilización de estas técnicas son analizados mediante su aplicación a la

cartera del IBEX, con datos diarios y un periodo observacional comprendido entre los años 1993 al 1998, comparando sus resultados con

las técnicas estándar.

120

ESTADÍSTICA ESPAÑOLA

Palabras clave: Valor en Riesgo, Inferencia Bayesiana, Técnicas Robustas, IBEX, Empírico-Bayes.

Clasificación AMS: 90A09, 62F15, 62C12, 62F35, 62G35.

1. INTRODUCCIÓN

Durante la última década se han desarrollado nuevos métodos de medida y de

gestión del riesgo de mercado. Una de estas medidas, conocida como Valor en

Riesgo (VaR), ha cobrado especial importancia y tiende a convertirse en el patrón a

seguir por las instituciones financieras para el control de sus riesgos de mercado. El

enfoque VaR es atractivo porque es fácil de interpretar (el VaR está medido en

unidades monetarias) y puede ser utilizado para producir una estimación de la

cantidad necesaria de fondos propios para cubrir el riesgo de mercado de las

actividades de negociación desarrolladas por las entidades financieras. Además,

tiene la ventaja adicional de poder incorporar los efectos de la diversificación de las

carteras. En la actualidad, muchas entidades financieras basan sus prácticas sobre

estimación y gestión de riesgos en el VaR.

A la consolidación de este enfoque como herramienta de gestión del riesgo de

mercado entre las entidades financieras, ha contribuido de forma notable el grupo

J.P. Morgan al hacer pública en octubre de 1994 la descripción de su sistema de

medida del riesgo de mercado, denominado RiskMetrics, basado en la metodología

VaR, así como el conjunto de datos necesarios para su aplicación. También ha

contribuido a la consolidación de estos sistemas el hecho de que las autoridades

internacionales en supervisión bancaria (Comité de Basilea y Unión Europea),

hayan permitido a las entidades financieras la posibilidad de determinar la cantidad

de fondos propios necesarios para cubrir el riesgo de mercado de sus carteras de

negociación mediante modelos propios basados en la metodología VaR.

Las entidades supervisoras aconsejan especificaciones estadísticas concretas

para el cálculo del VaR; sin embargo, las instituciones financieras no están obligadas a utilizar ningún procedimiento concreto para estimar el VaR. Son las propias

entidades las que deciden el procedimiento estadístico en que se basarán. Esta

libertad de elección tiene sentido, ya que como indica Beder (1995) no existe hasta

el momento un determinado enfoque VaR que sea superior al resto.

En la práctica, las instituciones financieras utilizan sus modelos VaR sobre una

base diaria (horizonte temporal unitario), haciendo públicos sus resultados. Según

Hendricks y Hirtle (1997), esta información constituye una herramienta reguladora

útil para comparar el nivel de riesgo asumido entre distintas entidades financieras a

ALTERNATIVAS ESTADÍSTICAS AL CÁLCULO DEL VALOR EN RIESGO

121

lo largo del tiempo; sin embargo, la fuerte dependencia del VaR con los procedimientos estadísticos utilizados disminuye la capacidad comparativa de éste.

En este trabajo, pretendemos introducir nuevos procedimientos para el cálculo

del VaR, de manera que constituyan una alternativa a las técnicas estadísticas

clásicas utilizadas en la práctica. En la Sección 2 se introduce el concepto de Valor

en Riesgo, se analizan las propiedades estadísticas de esta medida y se describen

someramente los principales enfoques utilizados habitualmente para su cálculo. En

la Sección 3 se expone una introducción a los aspectos básicos de la inferencia

bayesiana, aplicándolos al cálculo del VaR mediante la utilización de dos modelos

alternativos. La Sección 4 está dedicada a introducir las técnicas robustas y al

desarrollo de estimaciones robustas del VaR. La Sección 5 está constituida por una

aplicación empírica de los procedimientos propuestos, cuyos resultados son comparados utilizando una batería de medidas habituales en este contexto. Finalmente,

en la Sección 6 se resumen las conclusiones más relevantes del trabajo.

2. EL VALOR EN RIESGO

En este apartado introducimos el concepto de Valor en Riesgo (VaR) y analizamos las propiedades estadísticas de esta medida del riesgo. También hacemos una

breve referencia a la selección de los parámetros en los que se basa su cálculo,

como el periodo de mantenimiento de la cartera y el nivel de confianza a utilizar.

2.1.

Definición del VaR

En un determinado instante del tiempo t, se define el VaRt como la máxima pérdida monetaria que puede alcanzar un activo financiero o una cartera de activos, en

un horizonte temporal [t,t+1] con una probabilidad establecida c, lo que también se

conoce como nivel de confianza.

La definición del VaRt se puede formalizar probabilísticamente de la siguiente

forma. Sea Pt el valor inicial de la cartera (usualmente Pt representa su valor presente) y sea Pt+1 el valor de la cartera transcurrido el horizonte temporal en consideración. La definición implícita del VaRt en términos probabilísticos es

Pr(Pt+1 − Pt < − VaRt ) = 1 − c

[1]

donde el signo negativo se usa porque generalmente el VaRt se expresa con signo

positivo. Alternativamente se puede definir el VaRt en función del rendimiento de la

cartera producido en el horizonte temporal, lo que denotaremos por Rt+1. De esta

122

ESTADÍSTICA ESPAÑOLA

forma es trivial observar que Rt+1 = (Pt+1 - Pt) / Pt, con lo que sustituyendo en [1]

encontramos que VaRt debe cumplir:

Pr(R t+1 < − VaRt / Pt ) = 1 − c

[2]

Si llamamos Q1-c (Rt+1) al percentil (1-c) de la variable rendimiento de la cartera

después del horizonte temporal, entonces [2] nos conduce a la siguiente expresión

para VaRt

VaRt = −Pt Q1−c (R t +1)

[3]

por lo que en términos estadísticos el VaRt se corresponde con el percentil (1-c)

de la distribución de los beneficios y pérdidas de la cartera.

La vocación del VaRt es predictiva, ya que es una estimación sobre el valor futuro de la cartera transcurrido el horizonte temporal.

Las ecuaciones anteriores asignan propiedades probabilísticas al VaR, sin embargo, también resultan interesantes sus posibles propiedades frecuentistas, ya

que éstas pueden servir como herramienta de gestión a medio y largo plazo. Analizando [1] podemos intuir que si calculamos el VaRt sobre un alto número de periodos de negociación (moviendo t), la proporción de periodos donde el cambio del

valor de la cartera no será superior al VaRt será aproximadamente de (1-c). Pero

debemos considerar que esta propiedad frecuentista del VaRt sólo es cierta bajo la

hipótesis de independencia entre los periodos, lo que no se cumple con generalidad.

Debido a que el VaRt es un cálculo estadístico de las pérdidas potenciales de

una cartera, independientemente de cuál sea el método utilizado para su estimación, su valor depende de la elección del periodo de mantenimiento de la cartera

(holding period) y el nivel de confianza c seleccionado.

El periodo de mantenimiento es el horizonte temporal para el que queremos estimar la máxima pérdida de nuestra cartera, con lo que implícitamente se supone

que las posiciones de la cartera se mantienen constantes durante dicho periodo.

Los periodos habitualmente utilizados oscilan entre un día y un mes, aunque se

puede utilizar otros periodos más largos como trimestres e incluso años. El Comité

de Basilea establece un periodo de dos semanas, aunque en la práctica se utilizan

periodos de un día, siendo posible trabajar con periodos inferiores a éste. En la

elección del periodo de mantenimiento deben considerarse diversos aspectos,

como la liquidez de los mercados en los que opera la institución o la posibilidad de

que la entidad reajuste las posiciones de la cartera. En el primer caso, el periodo de

ALTERNATIVAS ESTADÍSTICAS AL CÁLCULO DEL VALOR EN RIESGO

123

mantenimiento ideal sería el tiempo necesario para asegurar la liquidación de las

posiciones en ese mercado. En cuanto al segundo aspecto, si el periodo de mantenimiento es demasiado largo, es más que probable que los gestores realicen

cambios en la composición de la cartera, de manera que éstos hacen que la medida del VaR sea menos significativa. Por tanto, cuanto más corto sea el periodo de

mantenimiento, más real será el supuesto de que la cartera se mantiene inalterada

durante dicho periodo.

La elección de c dependerá en parte del uso que queramos dar al cálculo del

VaR. Bajo este punto de vista es importante distinguir entre los siguientes usos del

VaR:

1. Mecanismo para la determinación de los fondos propios requeridos por las

autoridades supervisoras, para cubrir el riesgo de mercado de las posiciones de

negociación de la entidad.

2. Como sistema interno, para la gestión de riesgos en la entidad.

Si la medida del VaR se utiliza para determinar los fondos propios requeridos

por los reguladores, los parámetros del VaR, incluido el nivel de confianza, vienen

determinados por el regulador. Por ejemplo, el Comité de Basilea establece que el

cálculo del VaR debe realizarse diariamente sobre un horizonte de planificación de

dos semanas (diez días de negociación), utilizando un nivel de confianza del 99%

(c=0.99) y un periodo de observación mínimo de un año.

En la práctica, las entidades calculan diariamente el VaR y lo remiten periódicamente a los organismos supervisores, por lo que el VaR puede ser utilizado por

los supervisores para comparar el nivel de riesgo asumido por las distintas entidades. Dicha comparación no ofrecerá problema alguno si asumimos que los rendimientos de las distintas carteras se pueden describir a través de una función de

distribución de probabilidades normal, u otra asimilable, ya que el nivel de probabilidad se puede modificar para originar un valor del VaR comparable al de otra

institución. En este caso, la elección del nivel de probabilidad no ofrece problema

alguno. Sin embargo, sin el supuesto de normalidad, el VaR calculado para un

determinado nivel de probabilidad nos dirá muy poco del VaR correspondiente a

otro nivel de probabilidad distinto.

En el caso de que el VaR se utilice como sistema interno para la gestión de

riesgos, el nivel de confianza dependerá básicamente de la aversión al riesgo del

gestor con respecto a los riesgos asociados a los casos extremos.

A modo de conclusión, podemos afirmar que pueden existir diferentes niveles de

probabilidad apropiados en función de cual sea el propósito para el que se calcule

el VaR. Igualmente, tampoco existen razones para que una institución trabaje con

124

ESTADÍSTICA ESPAÑOLA

un único nivel de probabilidad. En definitiva, la institución debe utilizar un nivel de

probabilidad apropiado en función del objetivo marcado en cuanto a la estimación

del VaR.

Hasta el momento se han propuesto en la literatura numerosos métodos para

resolver aproximadamente [1], aunque la inmensa mayoría de éstos son variantes

de tratamientos estadísticos clásicos y tratamientos estadísticos no paramétricos.

Merece destacar entre los primeros citados el Enfoque de Varianzas-Covarianzas y

el de Simulación de Monte-Carlo, y entre los segundos el enfoque de Simulación

Histórica. Haremos una breve introducción a estos métodos actuales y los utilizaremos como referencia comparativa para las técnicas alternativas propuestas en

este trabajo.

2.2.

Enfoques básicos del cálculo del VaR

En [3] se pone de manifiesto la necesidad de calcular un percentil de la variable

rendimiento para encontrar el VaR. A continuación describiremos someramente

algunos de los exponentes de las técnicas estadísticas utilizadas en la actualidad

para calcular el percentil mencionado.

2.2.1.

El enfoque Varianzas-Covarianzas

En este enfoque se asume para los rendimientos de la cartera considerada que

Rt ~ N(0, σ2 ) , con Rt independiente de Rs para s≠t. En definitiva se asume que los

rendimientos de la cartera son normales de media 0 (se asume que la media es

cero debido al supuesto de que la magnitud de la media es muy pequeña en relación a la desviación típica) y varianza σ2 constante en el tiempo. Además se supone

que los rendimientos son independientes entre sí en el tiempo.

Denotando por zc el percentil c de la normal tipificada, encontramos que

Q1−c (Rt ) = z1−c σ = − z c σ

por lo que sustituyendo en [3], tenemos el valor del VaRt propuesto por esta metodología

VaR VC

t = Pt z c σ

[4]

Si la cartera está formada por N activos, el valor de σ se corresponde con una

combinación de las varianzas y covarianzas de los rendimientos de los activos que

completan dicha cartera. Así, llamando ℜ t = (R1t, R2t ,..., RNt) al vector formado por los

rendimientos individuales, con pesos la matriz columna w T=(w1, w2, ... ,wN) dentro

ALTERNATIVAS ESTADÍSTICAS AL CÁLCULO DEL VALOR EN RIESGO

125

de la cartera, entonces Rt es la media ponderada con pesos wi de los rendimientos,

esto es,

Rt =

N

∑w R

i

i t

i=1

y por tanto σ2 es:

σ2 =

N

∑w σ

i=1

2 2

i i

∑w w σ

+2

i

j ij

i< j

siendo σi2 la varianza de Rit y σij la covarianza entre Rit y Rtj . Matricialmente

σ2 = w T Σ w

con Σ la matriz de varianzas-covarianzas de los rendimientos.

Cuando la cartera incluye una gran cantidad de activos o instrumentos mas

complejos, es necesario recurrir a técnicas que permitan reducir el número de

factores de riesgo. La solución habitual es reducir la dimensionalidad de Σ mediante

la cartografía o descomposición de los activos que componen la cartera mediante

activos de referencia para los que disponemos de datos necesarios. De esta forma

los distintos instrumentos pueden ser descritos mediante combinaciones de tales

activos de referencia.

Las fórmulas vistas hasta ahora en este enfoque sólo expresan la relación entre

el VaRt y los parámetros del modelo (básicamente Σ) que evidentemente deben ser

estimados pues son desconocidos.

Para obtener el VaRt se propone una estimación de Σ a partir de las últimas v

observaciones r={rt, rt-1,..., rt-v+1}. Una estimación de Σ es la ofrecida por el estimador Máximo Verosímil que llamaremos Σ . Es sencillo comprobar que Σ es la matriz

de varianzas-covarianzas muestral de las observaciones. De esta forma, el VaR

resultante de este enfoque es:

t

VaR VC

t = Pt z c σ

[5]

Merece la pena hacer dos observaciones a la anterior fórmula. La primera es

que implícitamente σ t es una estimación de σ que cambia con el tiempo, pues

para calcular σ t se utilizan distintas secuencias de observaciones históricas cada

vez. Por otro lado, y más importante, al sustituir en [4] σ por σ t pasamos literal-

126

ESTADÍSTICA ESPAÑOLA

mente a desconocer las propiedades probabilísticas del VaRt resultante, puesto que

evidentemente estas características concretas no se conservan.

El tratamiento de Varianzas-Covarianzas permite obtener Intervalos de Confianza (IC) para la volatilidad σ2 (supuestamente constante) de la cartera a partir de

σ 2 . En efecto, es sencillo demostrar que a nivel de confianza (1-γ) el intervalo de

colas iguales que se obtiene es:

(v − 1)σ 2 (v − 1)σ 2

T

t

, 2

IC1− γ (σ 2 ) = 2

χ v −1,1− γ / 2 χ v −1,γ / 2

siendo χ 2v ,γ el percentil γ de la distribución Chi-cuadrado con v grados de libertad.

2.2.2.

Enfoques por simulación

Simulación Histórica

Este enfoque utiliza la función de distribución empírica provista por las observaciones históricas de los rendimientos r={rt, rt-1, rt-2,...,rt-v+1} para estimar Q1-c(Rt+1) y

sustituirlo en [3], de manera que encaja en un tratamiento no paramétrico del

problema, ya que no supone ninguna distribución para la variable rendimiento.

Así, si llamamos Q

1−c al percentil (1-c) de la muestra r, el VaRt es:

VaRSH

t = −Pt Q1−c

el cual posee un alto grado intuitivo y no tiene problemas de error en la especificación del modelo observacional, pues éste no se explícita. Aunque a la metodología

se le intuye robustez ante la aparición de observaciones de rendimientos atípicos,

en términos estadísticos las técnicas no paramétricas suelen ser menos potentes

que las paramétricas.

Simulación por Monte-Carlo.

Es un enfoque potente y flexible para la estimación del VaR. En este caso, la

distribución de las variaciones hipotéticas en el valor de la cartera se simula mediante números aleatorios a partir de un proceso estocástico. Sin embargo, la

complejidad de este procedimiento crea inevitablemente problemas. Por un lado, es

computacionalmente muy intenso, por otro, requiere de una dotación de personal

muy cualificado.

ALTERNATIVAS ESTADÍSTICAS AL CÁLCULO DEL VALOR EN RIESGO

127

3. EL ENFOQUE BAYESIANO

En este apartado proponemos una metodología bayesiana para el cálculo del

VaR. La versatilidad y la potencia del análisis bayesiano convierten a esta técnica

en una seria alternativa a la metodología clásica. El objetivo del trabajo es fundamentalmente introductorio, por lo que describiremos las ventajas del uso de la

metodología bayesiana (entre otras para su aplicación en las finanzas) e introduciremos los conceptos mas importantes, materializando el uso de la estadística

bayesiana para el cálculo del VaR a través de dos modelos univariantes.

3.1.

El VaR Bayesiano

La estadística bayesiana constituye un entorno de trabajo propio e independiente de la estadística clásica, cuyos fundamentos difieren de forma importante de

los fundamentos propios de la estadística clásica.

De gran importancia (y en el contexto del cálculo del VaR lo es) es la distribución predictiva que caracteriza el comportamiento de una observación futura de la

variable de interés, condicionada a las observaciones pasadas. Sea Xt+1 la observación futura de la variable de interés X (piénsese en el rendimiento de la cartera

mañana), ¿cómo se comporta Xt+1 si en el proceso hemos observado

x={x1,x2,...,xt}? La respuesta a esta pregunta está en la distribución de probabilidad

p(xt+1 | x) que se conoce como distribución predictiva.

Aplicando sencillas leyes de probabilidad, se obtiene

∫

p(x t+1 | x) = p(x t+1 | θ)p(θ | x)dθ

en donde p(x t+1 | θ) es el modelo supuesto para x y p(θ | x) es la distribución a

posteriori, esto es, p(θ | x) = p(x | θ)p(θ)/p(x) y p(θ) es la distribución a priori.

Para la definición del VaR es importante el límite inferior de predicción a un nivel

de probabilidad c, esto es, fijado c calcular aquel punto de la distribución predictiva

p(xt+1 | x) que deja por debajo suya una probabilidad de (1-c). Este punto lo denotaremos Q1-c(Xt+1 | x), que cumple:

Pr(X t+1 ≤ Q1−c (X t+1 | x) | x) = 1 − c

128

3.2.

ESTADÍSTICA ESPAÑOLA

El VaR desde un enfoque bayesiano

Dada una cartera de negociación, hemos llamado Rt a la rentabilidad de la cartera en el instante t. Para calcular el VaRt a partir de [3], utilizaremos la distribución

predictiva p(rt+1 | r) donde r={rt, rt-1,..., rt-v+1} son los v anteriores rendimientos de la

cartera.

Definición 1. Dada una cartera y la muestra r={rt, rt-1,..., rt-v+1} de la variable

Rendimientos (R), donde Rt+1 es su Rentabilidad en el instante t+1, definimos el

Valor en Riesgo Bayesiano en el instante t ( VaRBt ) a un nivel de probabilidad c

como:

VaRBt = −Pt Q1−c (R t +1 | r)

siendo Pt el valor de la cartera en el instante t.

La interpretación del VaRBt es muy sencilla. Con la información incorporada en

el procedimiento (incluye el modelo, la distribución a priori y las observaciones), la

probabilidad de que la rentabilidad en el instante t+1 sea mayor que el − VaRBt es

c.

La bondad en el cálculo del VaRBt depende en gran parte de la buena elección

del modelo para describir el comportamiento de la rentabilidad en el tiempo. Cuanto

mejor refleje la realidad mejor será el valor del VaRBt . En los modelos escogidos

tendrá que haber compromiso entre fidelidad a la realidad y sencillez.

En los últimos años ha aumentado la producción de material científico sobre

selección de modelos bayesiano (Berger y Perichi, 2000). Por el momento, la

selección de modelos (en términos formales) queda fuera de nuestros propósitos.

Seguiremos el principio de evaluar los modelos según su capacidad predictiva, lo

que creemos es un posicionamiento sensato del problema.

La distribución a priori p(θ) es importante, aunque en problemas con tamaño de

muestra grandes (a diario se utilizan usualmente tamaños de muestra grandes) su

influencia en el resultado final será pequeña. Utilizaremos alternativas que permitan

un tratamiento automático del problema, de tal forma que no sea necesario asignar

objetivamente la distribución a priori. Concretamente, utilizaremos distribuciones a

priori mínimo informativas y técnicas Empírico-Bayes.

ALTERNATIVAS ESTADÍSTICAS AL CÁLCULO DEL VALOR EN RIESGO

3.3.

129

Algunos modelos para carteras univariantes

El objetivo de este apartado es introducir la aplicación del VaR bayesiano en

carteras sencillas.

3.3.1.

Rendimientos normales. Varianzas iguales

Consideremos el modelo siguiente

Modelo 2 (Norm)

Rt | σ2 ~ N(0, σ2 )

σ2 ~ p(σ2 ) = 1 / σ 2

Este modelo es adecuado para describir carteras con rendimientos centrados en

0 (hipótesis usual en este contexto) y con volatilidades desconocidas pero constantes en el tiempo (hipótesis incumplida con frecuencia), además el comporta2

miento de la variable rentabilidad condicionada a σ debe ser Normal. Como

2

distribución a priori para σ hemos utilizado la mínimo informativa usual (Yang y

Berger, 1996), conocida como distribución a priori de referencia (Berger y Bernardo,

1992).

El tratamiento analítico de este modelo es sencillo, por lo que se pueden encontrar fórmulas explícitas de la distribución predictiva que permitan definir el VaR

asociado.

Para una muestra de rendimientos r={rt, rt-1,..., rt-v+1}, la distribución predictiva del

rendimiento en el instante t+1 asociada al Modelo 2 es(1):

R t+1 | r ~ St(0,1/ S2 , v)

donde S2 =

∑r

2

i

/ v . La distribución predictiva es una t-Student centrada en 0 y

con varianza aproximada S2.

El VaRt usando el Modelo 2 es por tanto

(1)

St(µ,λ,ν) denota la distribución t-Student no central. La densidad es:

p(y | µ, λ, v) =

Γ((v + 1) / 2)

Γ(v / 2)Γ(1 / 2)

λ

v

[1 + λv 1(y − µ)2 ] (v 1) / 2

−

−

+

130

ESTADÍSTICA ESPAÑOLA

VaRBt,Norm = Pt t v,c S

[6]

denotando tv,c el percentil c de la distribución St(0,1,v) y S = + S2 . Como la distribución t-Student es similar a una Normal cuando el parámetro ν es lo suficientemente grande entonces si éste es grande (ν≥30),

VaRBt,Norm = Pt z cS

Este valor coincide numéricamente con el VaRt propuesto desde un enfoque

clásico bajo hipótesis de normalidad. Esta coincidencia numérica, que no conceptual, explica la validez predictiva del procedimiento clásico.

3.3.2.

Un modelo de estructura jerárquica

Considérese el siguiente modelo:

Modelo 3. (IG)

Rt | σ2t ~ N(0, σ2t )

σ 2t | α, β ~ IG(α, β)

α, β ~ p(α, β)

con Rt independiente de {Rs, σ2s ,α,β} condicionalmente sobre σ2t , y σ2t independiente de σ2s condicionado a α, β para s≠t.

La estructura jerárquica propuesta modeliza el comportamiento de las varianzas

σ2t como observaciones de una distribución común. La novedad es que aunque las

elasticidades tengan un comportamiento común, sus valores varían con el tiempo,

lo que parece mas realista.

Aunque un tratamiento Bayesiano requiere modelizar el comportamiento de

(α

α,β

β), nosotros usaremos la técnica del Empírico-Bayes (EB) (Carlin y Louis, 2000)

para tratar el Modelo 3 y así evitar asignar la distribución a priori p(α,β).

Para usar el EB, encontraremos (α , β ) , estimaciones MV de (α,β) provistas por

las observaciones de r, e incluiremos esta estimación en el Modelo 3 como constante conocida. La función de verosimilitud L(α,β) que se debe maximizar para

obtener (α , β ) a partir de una muestra r={rt, rt-1,..., rt-v+1} es:

L(α, β) =

t

Γ((α + 1) / 2)β α

2

α +1 / 2

i / 2 + β)

∏ Γ(α)(r

i= t − v +1

[7]

ALTERNATIVAS ESTADÍSTICAS AL CÁLCULO DEL VALOR EN RIESGO

131

La optimización de [7] se puede abordar por procedimientos numéricos habituales, disponibles en cualquier paquete estadístico.

Condicionado a (α , β ) , la distribución predictiva del rendimiento en el instante

t+1 es:

Rt +1 | r, (α , β ) ~ St(0, α / β ,2α )

por lo que el VaR utilizando el Modelo 3 es:

VaRBt,IG = Pt t 2α ,c

β

α

[8]

Esta segunda aproximación del VaRt tiene una forma similar a la obtenida en [6]

aunque con características propias importantes. Comprobamos que β α es

aproximadamente la media a posteriori de σ 2t +1 , por lo que se puede considerar

este factor como un representante de la variabilidad prevista para el instante t+1.

Los grados de libertad del percentil de la t-Student cambian (no son constantes

como ocurría con el Modelo 2) y se autoajustan a las circunstancias propias de

cada periodo de observación por lo que (8) se regula para ajustar el parámetro

grados de libertad a las circunstancias. Soluciones clásicas al cálculo del VaR

proponen que la distribución condicional de los rendimientos sea t-Student con

grados de libertad constantes y ajustados por el investigador. Al utilizar grados de

libertad constantes, las características de la distribución no se ajustan a los datos y

los resultados no son buenos.

4. EL ENFOQUE ROBUSTO

Una posible alternativa a los procedimientos clásicos en el estudio del Valor en

Riesgo, es la utilización de técnicas robustas para su cálculo.

La estadística robusta es una rama de la estadística la cual pretende estudiar el

comportamiento de diferentes procedimientos cuando existe una pequeña variación

en los supuestos iniciales, o cuando existe la posibilidad de que el modelo esté

contaminado por ciertas observaciones conocidas por el nombre de “Outliers” (que

llamaremos Observaciones Atípicas) que producen influencias en los resultados

que conllevan a resultados erróneos.

La experiencia y los estudios de simulación sobre los procedimientos propuestos en estadística robusta, aconsejan el uso de estas técnicas en toda modelización

132

ESTADÍSTICA ESPAÑOLA

estadística. Así, dado el diseño de estos procedimientos, en el caso en el que no

existan Observaciones Atípicas en los datos del estudio (cosa que en la práctica es

totalmente imposible de confirmar), el resultado que proporcionan estos métodos

son idénticos a los dados por el estimador clásico al que sustituye o complementa.

En cambio, en presencia de Observaciones Atípicas, las buenas propiedades de

las que gozan estos procedimientos ante ellas (propiedades específicas descritas

en Ortega, 2000), nos aseguran una estimaciones más fiables de los parámetros en

estudio.

En definitiva, podemos decir que, aunque existen ciertos contras en la utilización

de los métodos robustos, como la pérdida de eficiencia (por la controversia conocida entre eficiencia y robustez) y la mayor complejidad y tiempo de cálculo de ellos,

éstos son generalmente asumidos o sacrificados en pro de unos mejores resultados

en el sentido de estimaciones que responden a la mayoría de las observaciones de

la muestra utilizada para la determinación del modelo en estudio.

Presentaremos a continuación un enfoque del problema que nos ocupa, desde

un punto de vista robusto, proponiendo posteriormente una estimación robusta del

Valor en Riesgo partiendo del Enfoque de Varianzas-Covarianzas presentado en la

Sección 2.

4.1.

Enfoque robusto del VaR

El enfoque de Varianzas-Covarianzas supone que la variable que representa el

rendimiento de la cartera en estudio cumple el supuesto de Normalidad. De esta

forma el Valor en Riesgo se definía, ver [4], como un múltiplo de la volatilidad de la

rentabilidad de la cartera en estudio. Para obtener una estimación del VaR se

proponía una estimación de la desviación típica ( σ ) a partir de las observaciones

históricas de los rendimientos en el horizonte temporal, ver [5].

El estimador de escala σ t no es nada adecuado en presencia de Observaciones Atípicas, ya que es conocido que una única observación de la muestra es

capaz de influir de tal manera en su cálculo que puede arrastrarla hacia cualquier

valor deseado. Así, ya que la presencia de Observaciones Atípicas es posible en la

variable en estudio, y que los procedimientos clásicos no están protegidos ante

ellas, proponemos un estudio mediante otros estimadores de escala con buenas

propiedades en robustez, de manera que nos proporcionen resultados más reales

del Valor de Riesgo.

4.1.1.

Estimadores de Escala Robustos

Muchos estimadores de escala se definen utilizando un estimador de posición

como base para su construcción, e incluso siguiendo su estructura (por ejemplo, la

ALTERNATIVAS ESTADÍSTICAS AL CÁLCULO DEL VALOR EN RIESGO

133

varianza mediante la media). En general, el comportamiento ante la presencia de

Observaciones Atípicas de los estimadores de escala definidos mediante un estimador de posición, heredan las propiedades de estos últimos, por lo que el uso de

estimadores de posición más resistentes a la presencia de Observaciones Atípicas

promete unos estimadores más adecuados al estudio de muestras contaminadas.

Por otra parte, como es conocido y se comenta en diversos trabajos (por ejemplo;

Martin y Zamar, 1993), la eficiencia es un concepto que en general se contrapone al

de robustez, de manera que estimadores poco robustos son muy eficientes, y

viceversa. Por lo tanto, es necesario tomar una decisión de compromiso de manera

que no sea dejada de lado totalmente ninguna de las dos características.

Un estimador de posición con buenas propiedades en robustez es la conocida

mediana, aunque su eficiencia en poblaciones simétricas con respecto a la media

es del 64%. La media y la mediana pueden ser considerados como elementos

extremos de una familia conocida por el nombre de “Trimmed Means”, que traduciremos por Medias Truncadas. Los elementos de esta familia utilizan para su definición un parámetro o Nivel de Truncamiento (número real que denotaremos por α),

donde la Media Truncada a Nivel de Truncamiento α (α_Truncada) se construye

como la media de las observaciones de la muestra eliminando el α% de las observaciones mayores y el α% de las menores. Es decir, dada la muestra x={x1,x2,...,xn}

de la variable X, donde denotamos por x[i] a la observación en la posición i-ésima de

una ordenación de menor a mayor de los elementos de x, y eligiendo α∈[0,50)

donde a=Int(αn/100) (donde Int denota parte entera), se define α_Truncada de x,

que denotaremos por α_Trun(x), de la forma:

α _ Trun(x) =

n−2a

1

x [i]

2n − a i=a+1

∑

[9]

Notar que un truncamiento a nivel 0 coincide con la media muestral, y si α tiende a 50 entonces el concepto tiende a la mediana muestral, de manera que, tomando por convenio que 50_Truncada es la mediana, podemos definir las

α_Truncada para todo α en el intervalo cerrado [0,50].

Las propiedades de este estimador son estudiadas en Hoaglin y otros (1983).

De ellas, y utilizando propiedades de los Estadísticos Ordenados(2), es fácil demostrar que α_Truncada es un estimador Insesgado. Por otra parte, respecto de

las propiedades en robustez de estos estimadores (ver Rousseeuw y Leroy, 1987)

(2) La propiedad necesaria se puede enunciar de la forma: Si x={x1,x2,...,xn} es una muestra aleatoria simple de tamaño n de la variable X, que sigue una Distribución Simétrica de

media µ, y recordando la notación de x[i], entonces se cumple que: E[x[n-i+1]]+E[x[i]] = 2µ, , para

todo i=1,2,...,n.

134

ESTADÍSTICA ESPAÑOLA

son Equivariantes Afín, tienen Punto de Ruptura de valor (a+1)/n, con Punto de

Ruptura Asintótico de α/100 y son B-Robustos siempre que a≥1. Además, de la

controversia entre Robustez y Eficiencia (considerando Eficiencia Relativa con

respecto a la media), debemos hacer notar que la Eficiencia de estos estimadores

bajo el supuesto de Normalidad en la variable observada (siguiendo a Hampel y

otros, 1986) puede ser aproximada mediante la forma lineal (100-0.723α)%, por lo

que los elementos de esta familia recorren los diferentes rangos de esta propiedades entre el 64% (de la mediana) y el máximo, el 100% (de la media).

Es fácil observar que la media (0_Truncada) tiene la mayor Eficiencia posible en

Distribuciones Normales, junto con el peor comportamiento ante Observaciones

Atípicas (Punto de Ruptura de valor 0, con Función de Influencia no acotada, es

decir no es B-Robusto,...), mientras que, en el otro extremo, la mediana

(50_Truncada) tiene una Eficiencia menor (del 64%) bajo Normalidad, siendo su

Punto de Ruptura Asintótico el máximo posible, con Función de Influencia acotada,

y en definitiva comportamientos más idóneos para el tratamiento de Observaciones

Atípicas.

Retomando el comentario inicial de esta sección, en el que se exponía el hecho

de que es habitual la construcción de estimadores de escala a partir de estimadores

de posición, creemos que una buena elección para la construcción de estimadores

de escala sería la utilización de los elementos de la familia de Medias Truncadas.

Esta decisión generaría una familia de estimadores de escala con elementos

recorriendo combinaciones de ambas propiedades genéricas antes citadas.

4.1.2.

La Familia de Estimadores αβ-Truncada

Partiendo de la estructura de la conocida varianza (definida como la media de

los cuadrados de las distancias de las observaciones a la media), en Ortega (2000)

se propone la construcción de una familia de nuevos estimadores de escala, siguiendo la estructura de la varianza pero sustituyendo medias por elementos de la

familia de las Medias Truncadas.

Así, dada la estructura de la varianza y las Medias Truncadas, se define una

familia de estimadores de escala mediante dos parámetros de truncamientos; uno

utilizado para calcular un estimador de posición que haga las veces de media

(denotado por α), y otro que nos proporcione, en vez de la media de las distancias

de las observaciones a esta medida de posición, la media truncada de éstas distancias (denotado por β). La propuesta de los elementos de dicha familia de estimadores de escala, dada la muestra x={x1,x2,...,xn} de la variable X, eligiendo los

parámetros α∈[0,50] y β∈[0,50] y conocida la familia Medias Truncadas [9], queda

definido el concepto αβ_Truncada sobre x como:

ALTERNATIVAS ESTADÍSTICAS AL CÁLCULO DEL VALOR EN RIESGO

αβ _ Trun(x) = C X (α, β) β _ Trun (x i − α _ Trun(x))2

i

135

[10]

donde CX(α,β) es un coeficiente, dependiente de la distribución de la variable X, y

de α y β, que nos asegura la consistencia de este estimador.

Notar que, moviendo α y β en el intervalo [0,50] se construye una familia, de

manera que cada elemento de ésta proporciona una Media Truncada (a nivel β) de

las distancias de la colección de x a un representante de estos, calculado mediante

otra Media Truncada (ahora a nivel α). En Ortega (2000) se encuentran tabulados

los valores de los coeficientes CX(α,β) para variables X Normales y cualquier combinación de α y β.

La familia αβ_Truncada tienen buenas propiedades en robustez como, que son

estimadores Equivariantes, con Eficiencia Relativa bajo Normalidad (con respecto a

la varianza corregida) entre el 38.35% y el 100%, dependiendo de los Niveles de

Truncamiento considerados, con Punto de Ruptura de valor Min{a+1,b+1}, con

a=Int(αn/100) y b=Int(βn/100), siendo el Punto de Ruptura Asintótico de la forma

Min{α/100,β/100}, y con Curva de Sensibilidad acotada siempre que Min{a,b}>1.

Por esto, dicha familia forma un abanico de estimadores de escala con buenas

propiedades ante la presencia de Observaciones Atípicas, siendo de interés su uso

en el caso de muestras contaminadas.

Los Niveles de Truncamiento (valores de α y β) influyen de manera directa en

las propiedades del estimador αβ_Truncada que definen, como ocurre para la

familia de Medias Truncadas. Siguiendo algunos estudios sobre este tema para el

caso de la familia de Medias Truncadas (ver: Hoaglin y otros, 1983; Hampel y otros,

1986 y Peña, 1992) se consideran unos niveles aceptables para α∈[0,10], es decir,

eliminar de la muestra en estudio menos del 10% de las observaciones menores y

mayores de ésta. Así, para el caso de los elementos de la familia αβ_Truncada,

también consideraremos Niveles de Truncamiento en el intervalo [0,10], dependiendo del valor a priori que pensemos puede haber de Observaciones Atípicas en

el estudio.

4.2.

Estimación robusta de VaR

Dada la definición de VaR en [4], donde bajo los supuestos del Enfoque de Varianzas-Covarianzas se construye mediante VaR VC

t = Pt z c σ , con Pt el valor inicial

de la cartera, en el intervalo temporal considerado, zc el percentil c de la Normal

estándar considerado y σ la estimación mediante el estimador Máximo Verosímil,

ahora, utilizando las técnicas robustas descritas en el apartado anterior, propone-

136

ESTADÍSTICA ESPAÑOLA

mos una estimación robusta del parámetro σ mediante la familia de estimadores

αβ_Truncada.

Así, elegidos unos determinados Niveles de Truncamiento (α y β) y considerada

la muestra r={rt, rt-1,..., rt-v+1} de la variable R, definimos un estimador robusto de σ

utilizando [10] de la forma:

~ = [αβ _ Trun(r)]1 / 2

σ

[11]

Notar que para la definición de este estimador, es necesaria la elección de unos

concretos Niveles de Truncamiento, los cuales deben ser determinados de manera

que la pérdida de eficiencia del estimador considerado sea la mínima posible, y al

mismo tiempo, sea suficientemente robusto como para proteger la estimación de

las posibles Observaciones Atípicas.

~ para unos determinados Niveles de Truncamiento, el VaUna vez calculado σ

lor en Riesgo Robusto, denotado por VaRRt , queda definido de la forma:

Definición 2. Dada una cartera y la muestra r={rt, rt-1,..., rt-v+1} de la variable

Rendimientos (R), definimos el Valor en Riesgo Robusto en el instante t, VaRRt , a

un nivel de probabilidad c como:

VaRRt = Pt z c ~

σ

donde Pt es el valor inicial de la cartera, zc es el percentil c de la Normal estándar, y

~ es dada por (11) para la muestra r y determinados Niveles de Truncamiento α y

σ

β.

En definitiva, mediante la Definición 2 proponemos una nueva aproximación de

VaR basándonos en el Enfoque de Varianzas-Covarianzas y mediante técnicas

robustas, que nos aseguran un comportamiento de dicho valor no influido por

posibles Observaciones Atípicas en la muestra utilizada para la estimación.

5. APLICACIÓN A LA CARTERA DEL IBEX

Los modelos descritos en este trabajo serán aplicados sobre una cartera de

renta variable. Adicionalmente utilizaremos una serie de medidas sencillas, propuestas por Hendricks (1996), con el objetivo de evaluar, a un nivel básico, el

comportamiento de los modelos propuestos.

137

ALTERNATIVAS ESTADÍSTICAS AL CÁLCULO DEL VALOR EN RIESGO

5.1.

Planteamiento general

El análisis de los modelos propuestos se realizará sobre la cartera del IBEX,

asumiendo que la inversión inicial en cada periodo es siempre la misma. Arbitrariamente hemos elegido una cifra de 100 millones de euros para poder presentar

gráficos y tablas en euros, aunque la valía de los resultados es independiente de

esta cifra.

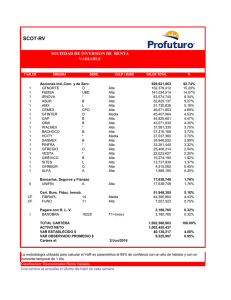

Figura 1

EVOLUCIÓN DE LA RENTABILIDAD DEL IBEX

8,00%

6,00%

Rentabilidad

4,00%

2,00%

0,00%

-2,00%

-4,00%

5/10/98

5/07/98

5/04/98

5/01/98

5/10/97

5/07/97

5/04/97

5/01/97

5/10/96

5/07/96

5/04/96

5/01/96

5/10/95

5/07/95

5/04/95

5/01/95

5/10/94

5/07/94

5/04/94

5/01/94

5/10/93

5/07/93

5/04/93

-8,00%

5/01/93

-6,00%

El periodo de análisis se inicia el 5/01/93 y finaliza el 30/12/98. La toma de observaciones es diaria, por lo que el periodo considerado contiene 1490 observaciones.

La Figura 1 muestra la evolución de los rendimientos diarios de dicha cartera

durante el periodo de análisis. En dicho gráfico se puede observar que el periodo

de análisis incluye periodos de baja volatilidad y alta volatilidad. Intuimos dos

subperiodos bien diferenciados respecto al comportamiento de la cartera. Un primer

subperiodo caracterizado por poca volatilidad y un comportamiento regular de los

rendimientos, que abarca (aproximadamente) del día 5/01/93 al 29/12/95 y un

segundo subperiodo del 2/01/96 al 30/12/98 de alta volatilidad y mayor inestabilidad

en el comportamiento (especialmente las fechas de la moratoria Rusa cercanas al

30/12/98 aparece una gran variabilidad en la cartera).

Las características estadísticas de esta cartera se muestran en la Figura 2. En

esta tabla se distinguió los dos subperiodos mencionados anteriormente. Encontramos que la desviación típica en el segundo subperiodo es aproximadamente un

40% mayor que en el primer subperiodo, lo que confirma lo que se puede apreciar

138

ESTADÍSTICA ESPAÑOLA

en la Figura 1. Todavía es mas sorprendente la diferencia entre subperiodos en la

forma de la distribución. El test de Kolmogorov-Smirnof realizado en los dos subperiodos demuestra que la hipótesis de normalidad no es desechable para el primer

tramo de observaciones (p-Valor de 0.33), mientras que la hipótesis de normalidad

no es aceptable para la segunda parte observacional (p-Valor de 0.001).

Figura 2

CARACTERÍSTICAS DE LA RENTABILIDAD DEL IBEX POR SUBPERÍODOS

Periodo

Total(05/01/93 a 30/12/98)

Primero (5/1/93 al 29/12/95)

Segundo (2/1/96 al 30/12/98)

Días

Media

D. Típica

p-Valor(KS)

1490

0.0950%

1.2614%

0.0001

743

0.0600%

1.0271%

0.3292

747

0.1314%

1.4575%

0.0010

En consecuencia el comportamiento de la cartera no es homogéneo en el tiempo. Considerando el total del periodo podemos apreciar en la Figura 2 que la hipótesis de normalidad es insostenible (p-valor de Kolmogorov-Smirnof de 0.001).

Figura 3

HISTOGRAMA DE LA RENTABILIDAD DEL IBEX (PERÍODO: 5/01/93 HASTA

30/12/98, DONDE SE HA SUPERPUESTO UNA CURVA NORMAL CON MEDIA Y

VARIANZA IGUALES A LAS ENCONTRADAS EN LA CARTERA EN EL PERÍODO

EN ESTUDIO

0,040

0,035

0,025

0,020

0,015

0,010

0,005

Intervalos de rendimiento

Ibex

Normal

0,045

0,041

0,037

0,034

0,030

0,026

0,022

0,018

0,015

0,011

0,007

0,003

0,000

-0,004

-0,008

-0,012

-0,016

-0,019

-0,023

-0,027

-0,031

-0,035

-0,038

-0,042

0,000

-0,046

Frecuencia

relativa

0,030

ALTERNATIVAS ESTADÍSTICAS AL CÁLCULO DEL VALOR EN RIESGO

139

Estas características condicionaran los resultados obtenidos por los modelos

basados en el supuesto de normalidad, especialmente cuando se utilicen altos

niveles de confianza. La Figura 3 muestra el histograma de los rendimientos de la

cartera analizada, junto con el perfil de la Normal de igual media y varianza. Como

se puede apreciar, la distribución real de la cartera presenta picos más altos que la

correspondiente a una distribución normal y, además, presenta una mayor frecuencia de resultados extremos de los que se esperaría en una distribución normal.

Estas características son propias de una distribución con un coeficiente de apuntamiento significativamente mayor que el de una distribución normal.

5.2.

Cálculos de los modelos y resultados

Para comparar los resultados obtenidos a partir de las propuestas realizadas a

lo largo del trabajo, decidimos utilizar un periodo de estimación de 75 observaciones. En consecuencia calculamos, para cada uno de los enfoques propuestos,

1415 estimaciones del VaR, a partir de niveles de probabilidad c=0.95 (un 5% de

excepciones esperadas) y de c=0.99 (un 1% de excepciones esperadas). Considerando una inversión inicial, en cada periodo, constante de 100 millones de euros

(Pt=100 ⋅ 106), el cálculo del VaR mediante cada uno de los métodos considerados

es:

Bayesiano (Bnorm): Tratamiento bayesiano al modelo Normal sobre las

observaciones. Lo que da lugar a:

VaRBt,Norm = Pt t 75,cS

recordamos que la expresión de arriba coincide con la propuesta por la metodología clásica (ver [5]), por lo que los resultados obtenidos en ambos

coinciden.

Bayesiano (B.GI): Tratamiento Empírico-Bayes al modelo jerárquico

Normal con varianzas distribuidas Gamma-Invertida. Da lugar a:

VaR Bt,IG = Pt t 2α ,c

β

α

siendo α y β los estimadores máximos verosímiles (máximos de [7]) a partir

de las anteriores 75 observaciones.

Robusto (Rob): Tratamiento robusto. Obteniéndose como resultado

VaRRt = Pt z c ~

σ

140

ESTADÍSTICA ESPAÑOLA

~ se calcula mediante [11] para Niveles de Truncamiento α =0 y

donde σ

0

β0=5, ya que suponemos que la variable rentabilidad es Normal de media cero, y el porcentaje de Observaciones Atípicas es pequeña, y con un Coeficiente de Consistencia, utilizando (10), de CX(α,β)=1.2486.

donde debemos recordar que zc y t(75,c) denotan el percentil c de las distribuciones

Normal y t75, respectivamente. Por otra parte, VaRRt obtenido cuenta con buenas

propiedades, tales como: ser Equivariante; con Punto de Ruptura Asintótico de

valor 5%; y con Curva de Sensibilidad acotada; con una pequeña pérdida de Eficiencia, siendo la Eficiencia Relativa, con respecto a la Varianza Corregida del

87%.

Figura 4

COMPORTAMIENTO DEL VAR BAYESIANO CON MODELO NORMAL

(BNORM) (COINCIDENTE CON EL CLÁSICO). SE REPRESENTAN LAS

PÉRDIDAS Y EL VAR (CAMBIADO DE SIGNO) PARA NIVELES c=0.95 (LÍNEA SUPERIOR) Y c=0.99 (LÍNEA INFERIOR)

0

-1.000.000

-2.000.000

-4.000.000

-5.000.000

-6.000.000

P érdida

-V aR 95%

-V aR 99%

23/10/1998

23/07/1998

23/04/1998

23/01/1998

23/10/1997

23/07/1997

23/04/1997

23/01/1997

23/10/1996

23/07/1996

23/04/1996

23/01/1996

23/10/1995

23/07/1995

23/04/1995

23/01/1995

23/10/1994

23/07/1994

23/04/1994

23/01/1994

23/10/1993

-8.000.000

23/07/1993

-7.000.000

23/04/1993

Pérdidas(euros )

-3.000.000

141

ALTERNATIVAS ESTADÍSTICAS AL CÁLCULO DEL VALOR EN RIESGO

Figura 5

COMPORTAMIENTO DEL VAR BAYESIANO CON MODELO NORMALGAMMAINVERTIDA (B.GI). SE REPRESENTAN LAS PÉRDIDAS Y EL VAR

(CAMBIADO DE SIGNO) PARA NIVELES c=0.95 (LÍNEA SUPERIOR) Y

c=0.99 (LÍNEA INFERIOR)

0

-1.000.000

-3.000.000

-4.000.000

-5.000.000

-6.000.000

-7.000.000

Pérdida

-VaR 95%

-VaR 99%

23/10/1998

23/07/1998

23/04/1998

23/01/1998

23/10/1997

23/07/1997

23/04/1997

23/01/1997

23/10/1996

23/07/1996

23/04/1996

23/01/1996

23/10/1995

23/07/1995

23/04/1995

23/01/1995

23/10/1994

23/07/1994

23/04/1994

23/01/1994

23/10/1993

23/07/1993

-8.000.000

23/04/1993

Pérdidas(euros)

-2.000.000

142

ESTADÍSTICA ESPAÑOLA

Figura 6

COMPORTAMIENTO DEL VAR ROBUSTO (ROB). SE REPRESENTAN

LAS PÉRDIDAS Y EL VAR (CAMBIADO DE SIGNO) PARA NIVELES c=0.95

(LÍNEA SUPERIOR) Y c=0.99 (LÍNEA INFERIOR)

0

-1.000.000

Pérdidas(euros)

-2.000.000

-3.000.000

-4.000.000

-5.000.000

-6.000.000

-7.000.000

Perdidas

-VaR 95%

23/10/1998

23/07/1998

23/04/1998

23/01/1998

23/10/1997

23/07/1997

23/04/1997

23/01/1997

23/10/1996

23/07/1996

23/04/1996

23/01/1996

23/10/1995

23/07/1995

23/04/1995

23/01/1995

23/10/1994

23/07/1994

23/04/1994

23/01/1994

23/10/1993

23/07/1993

23/04/1993

-8.000.000

-VaR 99%

Las Figuras 4 a 6 comparan las pérdidas de la cartera con las correspondientes

medidas del VaR, obtenidas mediante los diferentes métodos considerados, a

niveles de probabilidad c=0.05 (línea superior) y c=0.01 (línea inferior). En aquellos

casos donde la pérdida observada es inferior al VaR se produce una excepción.

Encontramos que los contornos de las distintas propuestas es similar. Observamos que a corto plazo las oscilaciones de los valores del VaR para los modelos

B.GI y Rob es mucho mayor que los demás, denotando mayor sensibilidad a los

cambios en la cartera.

En particular en el cálculo B.GI los contornos son muy fluctuantes debido a que

el modelo permite heterocedasticidad.

ALTERNATIVAS ESTADÍSTICAS AL CÁLCULO DEL VALOR EN RIESGO

5.3.

143

Evaluación de resultados

En este apartado aplicamos una serie de criterios de evaluación, propuestos en

Hendricks (1996), que miden la bondad predictiva de los procedimientos.

El Múltiplo Medio analiza el tamaño medio de las excepciones. Dicho valor ha

sido calculado como la media del cociente entre el valor absoluto de la pérdida real

y el correspondiente VaR en aquellos casos en los que se ha producido efectivamente una excepción, de manera que la medida obtenida nos indica, en términos

porcentuales, el tamaño medio de la excepción con respecto a su VaR correspondiente. Por ejemplo, si el valor medio del tamaño de las excepciones es igual a 1.5,

las pérdidas que suponen una excepción son por término medio superiores a su

correspondiente VaR en un 50%.

El Múltiplo Máximo tiene relación con la máxima pérdida del título o cartera. El

tamaño máximo de la excepción está medido en los mismos términos que el criterio

anterior, solo que ahora no promediamos los tamaños de las excepciones si no que

tomamos para cada modelo el valor máximo observado. Esta forma de medir el

tamaño máximo de la pérdida realizada con respecto al correspondiente VaR

estimado es por lo tanto muy dependiente de la longitud del periodo analizado (en

nuestro caso casi cinco años). Para periodos mas cortos, el tamaño medio de la

excepción obtenido sería menor.

El Múltiplo Necesario se centra en el tamaño del ajuste que se debería aplicar

sobre los valores obtenidos para alcanzar una cobertura perfecta en función del

nivel de confianza utilizado. Para obtener dicho valor, simplemente calculamos a

posteriori la cantidad (múltiplo) por la que habría que haber multiplicado cada uno

de los valores producidos por un modelo para que en el periodo de análisis, dicho

modelo hubiera cumplido perfectamente con el nivel de cobertura deseado (95% o

99%). Este criterio de evaluación de los modelos VaR es por lo tanto un complemento al criterio del porcentaje de excepciones, dado que tiene en cuenta el tamaño del error potencial en la medida del riesgo en vez del porcentaje de excepciones

producido por un modelo. Un valor muy cercano a uno significa que el modelo

produce medidas del riesgo muy aceptables e indicaría que el modelo no necesita

ser corregido para producir una cobertura perfecta.

Estos criterios son en realidad un conjunto de medidas básicas, cuyo objetivo es

describir el comportamiento de los modelos con respecto a determinadas características concretas. La Figura 7 muestra los resultados de aplicar dichos criterios a

los tres métodos propuestos, junto a los resultados obtenidos sobre el modelo

clásico. La evaluación se ha realizado sobre el periodo total (1415 valores VaR) y

144

ESTADÍSTICA ESPAÑOLA

sobre los dos subperiodos en los que se hemos dividido el periodo total (668 y 747

valores, respectivamente).

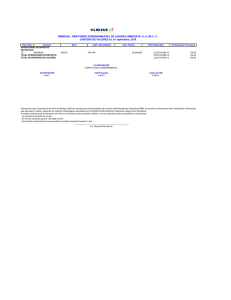

Figura 7

RESULTADOS DE LOS PROCEDIMIENTOS ALTERNATIVOS. DIVIDIDOS

EN DOS SUBPERIODOS

Excepciones y múltiplos

Muestra

(dias)

Excepciones

(número)

Excepciones

(porcentaje)

Múltiplo

medio

Múltiplo

máximo

Múltiplo

necesario

Panel A. VaR 95%

Periodo total (23/04/93 al 30/12/98)

Bnorm

1415

69

B.IG

1415

68

Rob

1415

68

4,88% 1,427

4,81% 1,449

4,81% 1,450

3,855

3,941

3,946

0,984

0,987

0,996

Primer Per. (23/04/93 al 9/12/95)

Bnorm

668

B.IG

668

Rob

668

35

34

33

5,24% 1,298

5,09% 1,318

4,94% 1,335

2,113

2,121

2,119

1,002

1,001

0,997

Segundo Per. (02/01/96 al 30/12/98)

Bnorm

747

34

B.IG

747

34

Rob

747

35

4,55% 1,560

4,55% 1,580

4,69% 1,559

3,855

3,941

3,946

0,950

0,950

0,979

Periodo total (23/04/93 al 30/12/98)

Bnorm

1415

25

B.IG

1415

26

Rob

1415

25

1,77% 1,326

1,84% 1,325

1,77% 1,347

2,726

2,843

2,790

1,199

1,204

1,224

Primer Per. (23/04/93 al 9/12/95)

Bnorm

668

B.IG

668

Rob

668

8

8

8

1,20% 1,261

1,20% 1,262

1,20% 1,275

1,494

1,511

1,498

1,088

1,078

1,068

Segundo Per. (02/01/96 al 30/12/98)

Bnorm

747

17

B.IG

747

18

Rob

747

17

2,28% 1,356

2,41% 1,353

2,28% 1,381

2,726

2,843

2,790

1,226

1,244

1,243

Panel B. VaR 99%

Los resultados muestran un buen comportamiento de todos los modelos a un

nivel de confianza del 95%. En ninguno de los casos, el porcentaje de excepciones

observado es muy distinto del teórico. La propuesta Robusta destaca por su comportamiento en el segundo subperiodo, tanto por el porcentaje de excepciones

(más cercano al 5% objetivo), como por el múltiplo necesario (más cercano a uno).

Esto puede ser debido a que las técnicas robustas caracterizan de mejor modo los

ALTERNATIVAS ESTADÍSTICAS AL CÁLCULO DEL VALOR EN RIESGO

145

comportamientos extremos, que son mucho más acusados sobre todo al final de

dicho subperiodo.

Sin embargo, los modelos muestran dificultades para capturar el riesgo de la

cartera a un nivel de confianza del 99%. El comportamiento de los modelos es muy

diferente en cada uno de los subperiodos considerados. Durante el primer subperiodo (periodo de menor volatilidad), todos los modelos producen porcentajes de

excepciones compatibles con el 1% teórico. Sin embargo, durante el segundo

subperiodo (con alta volatilidad), el número de excepciones es excesivamente alto

como para aceptar la hipótesis de que el porcentaje de excepciones observado es

igual al teórico.

Notamos que en el segundo subperiodo, el porcentaje de excepciones observado es superior al predicho por todos los modelos, concluyendo que el percentil 1%

de la distribución real de los rendimientos, en periodos de alta volatilidad, está más

alejado de la media de lo que suponen los modelos utilizados. Esto indica que para

predecir correctamente en estas circunstancias, se hace necesario seguir investigando la forma de incorporar el tratamiento de las colas gruesas mediante estos

métodos.

En la actualidad estamos considerando modelos de colas más densas, en el

contexto bayesiano, y técnicas que proporciones otros niveles de truncamientos

más adecuados, para el ámbito robusto.

6. CONCLUSIONES

En este trabajo se han presentado los conceptos básicos para calcular el VaR

utilizando metodologías bayesianas y metodologías robustas. El trabajo tiene un

alto componente divulgativo en las técnicas presentadas, siendo su objetivo prioritario abrir posibles líneas de investigación para futuros trabajos.

En la metodología bayesiana, introducida en la Sección 3, la predicción se gestiona de manera muy natural, pudiendo introducir modelos muy realistas y precisos

para conseguir predicciones tan acertadas como se quiera. En este trabajo se

aplicó la metodología bayesiana a dos modelos sencillos. Un análisis en detalle del

funcionamiento de los modelos permitirá aprender sus debilidades para conseguir

asignar modelos alternativos que se ajusten más a las características concretas de

la cartera en estudio. En particular, observamos en la Sección 5, que en el estudio

del IBEX se requieren modelos con colas más gruesas que la distribución Student,

pues ésta se manifiesta poco capaz de predecir correctamente los percentiles 0.05

y 0.01. En tratamientos no-bayesianos, modelos distintos al Normal dificultan muy

seriamente su tratamiento, lo que en la mayoría de las ocasiones induce a la so-

146

ESTADÍSTICA ESPAÑOLA

breutilización del modelo Normal o a la utilización de soluciones ad-hoc “poco

naturales” que resuelvan la falta de ajuste a la realidad. Por otro lado, un tratamiento bayesiano del problema permite incorporar información adicional a la provista por los datos a través de la distribución a priori. Esto permite gestionar la

información a priori que los expertos tienen de la cartera en estudio o reutilizar

observaciones históricas que de otra forma son sistemáticamente desechadas. En

futuros trabajos se prevé desarrollar técnicas para incorporar información extramuestral en los procedimientos de cálculo del Valor en Riesgo.

Respecto a la metodología robusta, en la Sección 4 se introduce la interesante

posibilidad de usar estas técnicas para el cálculo del VaR. Es sabido que cuando

una muestra contiene observaciones atípicas, las aptitudes de los estadísticos

usuales (media, varianza, etc) se ven seriamente disminuidos, provocando resultados poco acertados, a la vez que lejanos de la realidad. La experiencia nos dice

que este tipo de observaciones atípicas aparecen con cierta frecuencia en el estudio de carteras, usualmente estas observaciones están enmascaradas por cambios

bruscos en las tendencias de los mercados o factores ocultos que actúan provocando gran volatilidad. Así, el uso de las técnicas robustas presentadas conduce a

resultados mas fiables. En próximos trabajos, se realizarán estudios sobre diferentes carteras que nos proporcione experiencia en la utilización de estas técnicas.

El último comentario se refiere a la Sección 5, donde se comprueba, en una

primera aplicación de estos procedimientos, que los resultados son altamente

prometedores.

REFERENCIAS

BEDER, T.S. (1995): «VAR: Seductive but dangerous». Journal Financial Analysts.

BERGER, J.O. y BERNARDO, J.M. (1992): «On the development of the reference prior

method». Bayesian Statistics, Vol.4.

BERGER, J.O. y PERICCHI, L.R. (2000): «Objective Bayesian Methods for Model

Selection: Introduction and Comparison». Technical report, Duke University,

ISDS.

BERNARDO, J.M. (1979): «Reference posteriors distributions for Bayes inference».

Journal of the Royal Statistics Society (Serie B),Vol.41.

CARLIN, B.P. y LOUIS, T.A. (2000): «Bayes and Empirical Bayes Methods for Data

Analysis». Ed. Chapman and Hall. Segunda Edición.

ALTERNATIVAS ESTADÍSTICAS AL CÁLCULO DEL VALOR EN RIESGO

147

HAMPEL, F.R., RONCHETTI, E.M., ROUSSEEUW, P.J. y STAHEL, W. (1986): «Robust

Statistics: The approach based on influence function». Ed. John Wiley and

Sons. N.Y.

HENDRICKS, D. (1996): «Evaluation of Value-at-Risk Models Using Historical Data».

Federal Reserve Bank of New York Economic Policy Review, Vol.2.

HENDRICKS, D. y HIRTLE, B. (1997). «Bank Capital Requirements for Market Risk:

The Internal Models Approach». Federal Reserve Bank of New York. Economic

Policy Review 3.

HOAGLIN, D.C., MOSTELLER, F. y TUCKEY, J.W. (1983): «Understanding Robust and

Exploratory Data Analysis». Ed. John Wiley and Sons.

MARTIN, R.D. y ZAMAR, R. (1993): «Efficiency-constrained bias-robust estimation of

location». Annals of Statistics, Vol.21,1.

MORGAN, J.P. y REUTERS (1996): «RiskMetrics». Technical Document. 4ª edición.

Nueva York.

ORTEGA, J. FCO. (2000): «Nuevas Familias de Estimadores Robustos y Detección

de Observaciones Atípicas en Modelos Lineales». Tesis Doctoral. Univ. de

Castilla-La Mancha.

PEÑA, D. (1992): «Estadística: Modelos y Métodos». Ed. Alianza Universidad Textos.

ROUSSEEUW, P.J. y LEROY, A.M. (1987): «Robust Regression and Outlier Detection». Ed. John Wiley and Sons.

YANG, R. y BERGER, J.O. (1996): «A Catalog of Noninformative Priors». Technical

report, Purdue University, Dept. of Statistics.

148

ESTADÍSTICA ESPAÑOLA

STATISTICAL ALTERNATIVES TO CALCULATE VALUE AT RISK

SUMMARY

Value at Risk (VaR) is a statistical measure of potential losses in a

portfolio of financial assets. The proceedings usually used for calculating VaR are based on classical statistical techniques, also called

frequentist.

In this paper, we present two alternative statistical procedures for

calculating VaR. The first one consists of applying the bayesian methodology, taking advantage of its high ability for dealing with predictive

problems. On the other hand, in order to avoid the problems caused

by the presence of outliers, the second proceeding consists of the use

of robust techniques for calculating VaR. The models resulting from

the use of these techniques are analyzed by means of its application

to the IBEX portfolio, with daily data and an observational period that

ranges from 1993 to 1998, comparing its results with those resulting

from the standard techniques.

Key words: Value at risk, Bayesian Inference, Robustness, IBEX, Empirical-Bayesian.

Classification AMS: 90A09, 62F15, 62C12, 62F35, 62G35.