Tema 4.- El espacio vectorial Rn.

Anuncio

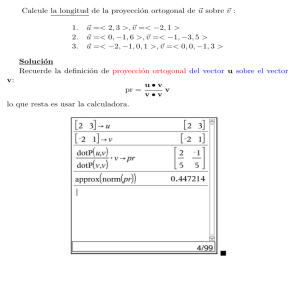

Tema 4.- El espacio vectorial Rn.

1.

2.

3.

4.

5.

Subespacios vectoriales de Rn .

Bases de un subespacio.

Rango de una matriz.

Bases de Rn . Cambios de base.

Ejercicios.

En este tema estudiamos la estructura vectorial del espacio Rn , de las n−uplas ordenadas de números reales, es

decir, la estructura relacionada con las operaciones suma (de vectores) y multiplicación de un número (real) por un

vector. El espacio Rn es uno de los modelos para el estudio de los denominados espacios vectoriales (generales). Sin

entrar en más detalles y definiciones, un espacio vectorial es un conjunto de elementos sobre el que hay definida una

operación suma (de dichos elementos) y una operación producto de un número por uno de dichos elementos. Por

ejemplo, son espacios vectoriales:

el conjunto de las matrices de unas dimensiones dadas, con la operación suma de matrices y producto de un

escalar (real, complejo) por una matriz,

el conjunto de todos los polinomios en una variable, con las operaciones suma de polinomios y producto de un

escalar por un polinomio,

el conjunto de todos los polinomios en una variable y con grado menor o igual que un cierto valor prefijado. Por

ejemplo, el conjunto de todos los polinomios de grado menor o igual que 3.

Para finalizar, daremos la definición formal de base y consideraremos los resultados fundamentales asociados a

dicho concepto.

1.

Subespacios vectoriales de Rn .

Los subespacios vectoriales de Rn serán los subconjuntos de Rn que se pueden caracterizar mediante ecuaciones

lineales homogéneas (ecuaciones implı́citas en las n variables dadas por las coordenadas de un vector genérico). Como

ya hemos visto, cualquier conjunto de vectores descrito como el conjunto de todas las combinaciones lineales de ciertos

vectores también puede caracterizarse mediante ecuaciones lineales homogéneas. A la hora de manipular subespacios

vectoriales recurriremos, de forma habitual, a su expresión mediante ecuaciones implı́citas o a su expresión mediante

ecuaciones paramétricas. Una de las cuestiones que trataremos es el número mı́nimo de ecuaciones implı́citas mediante

las que se puede caracterizar un subespacio y el número mı́nimo de vectores que permiten generar dicho subespacio. En

el espacio tridimensional R3 , los subespacios vectoriales son, además del subespacio nulo {0} y del total R3 , las rectas

y los planos que pasan por el origen de coordenadas. Recordemos que cualquier recta o plano se puede caracterizar

mediante ecuaciones implı́citas y mediante ecuaciones paramétricas. En R3 , para caracterizar una recta que pasa por

el origen de coordenadas necesitamos dos ecuaciones (no redundantes) o un vector, y para caracterizar un plano que

pasa por el origen de coordenadas necesitamos una ecuación o dos vectores linealmente independientes (una base de

dicho plano).

1.1.

Subespacios vectoriales.

Definición. Se llama subespacio vectorial de Rn a todo subconjunto no vacı́o S ⊂ Rn que verifica:

(1) Si un vector está en S, también lo está cualquiera de sus múltiplos, es decir,

v ∈ S =⇒ αv ∈ S,

∀ α ∈ R,

(2) Si dos vectores están en S, también lo está la suma de ambos, es decir,

v1 , v2 ∈ S =⇒ v1 + v2 ∈ S.

79

La propiedad (1) nos dice que si tenemos un vector no nulo de un subespacio vectorial, la recta determinada por

dicho vector está contenida en el subespacio. La propiedad (2) nos dice que si tenemos dos vectores (no colineales) de

un subespacio vectorial, el plano determinado por dichos vectores está contenido en el subespacio.

Las dos propiedades anteriores se pueden expresar de forma conjunta: Si dos vectores están en S, también lo

está cualquiera de sus combinaciones lineales:

v1 , v2 ∈ S

∀

=⇒ αv1 + βv2 ∈ S.

α, β ∈ R

En particular el vector nulo pertenece a cualquier subespacio vectorial.

n o

Obviamente S = ~0 y S = Rn son subespacios vectoriales (a veces llamados subespacios triviales).

En el espacio bidimensional, R2 , además de esos dos subespacios triviales, cualquier recta que pase por el origen

es un subespacio vectorial. Sin embargo, los vectores de posición determinados por los puntos de una parábola NO

forman un subespacio vectorial.

n o

En el espacio tridimensional, R3 , además de los dos subespacios triviales ( ~0 y R3 ), cualquier recta o plano que

pase por el origen es un subespacio vectorial.

Ejercicio resuelto

Encontrar unas ecuaciones implı́citas del subespacio de R4

E = Gen{(1, 1, 1, 0)T , (2, 0, 1, 2)T , (0, 2, 1, −2)T , (0, −2, −1, 2)T , (−1, 1, 0, −2)T }.

Dado un conjunto generador {v1 , v2 , v3 , v4 , v5 } de un subespacio E ⊂ R4 , encontrar las ecuaciones implı́citas de E

es hallar las condiciones que deben verificar las componentes de un vector de R4 , x = (x1 , x2 , x3 , x4 )T , para que

pertenezca a E, es decir, para que se pueda escribir como combinación lineal del conjunto generador x = c1 v1 + c2 v2 +

c3 v3 + c4 v4 + c5 v5 , es decir, para que existan esos escalares ci , o lo que es equivalente, para que el sistema

(v1 |v2 |v3 |v4 |v5 )c = x, con c = (c1 , c2 , c3 , c4 , c5 )T

sea compatible. Para exigir esto

1 2 0

1 0 2

1 1 1

0 2 −2

construimos la matriz ampliada (v1 |v2 |v3 |v4 |v5 |x):

0 −1 x1

1 2

0

0 −1 x1

0 −2 2 −2 2 x2 − x1

F

−

F

−2 1 x2

2

1

−1 0 x3 F3 − F1 0 −1 1 −1 1 x3 − x1

- 0 2 −2 2 −2 x4

2 −2 x4

1 2 0 0 −1 x1

F3 − F2 /2

,

0 −2 2 −2 2 x2 − x1

F4 + F2

0 0 0 0

0 x3 − x1 /2 − x2 /2

- 0 0 0 0

0 x4 + x2 − x1

es decir, el sistema es compatible cuando

x3 − x1 /2 − x2 /2 = 0,

x4 + x2 − x1 = 0,

que son unas ecuaciones implı́citas de E.

Observemos que podı́amos haber buscado

(v1 |v2 |v3 |v4 |v5 ):

1 2 0

0 −1

1 0 2 −2 1 F2 − F1

1 1 1 −1 0 F3 − F1

0 2 −2 2 −2

→

x1 + x2 − 2x3 = 0,

x1 − x2 − x4 = 0,

primero una base de E, aplicando eliminación gaussiana a la matriz

1 2

0

0 −1

0 −2 2 −2 2

F3 − F2 /2

0 −1 1 −1 1 F4 + F2

0 2 −2 2 −2

1

0

0

0

2

−2

0

0

0 0

2 −2

0 0

0 0

−1

2

,

0

0

de donde deducimos que E = Gen{v1 , v2 }, es decir, una base de E es BE = {v1 , v2 }. Dada una base {v1 , v2 } de

un subespacio E ⊂ R4 , encontrar las ecuaciones implı́citas de E es hallar las condiciones que deben verificar las

componentes de un vector de R4 , x = (x1 , x2 , x3 , x4 )T , para que pertenezca a E, es decir, para que se pueda escribir

como combinación lineal de los vectores de la base x = c1 v1 + c2 v2 , es decir, para que existan esos escalares ci , o lo

que es equivalente, para que el sistema

(v1 |v2 )c = x, con c = (c1 , c2 )T

80

sea compatible.

1

1

1

0

Para exigir esto construimos la matriz ampliada (v1 |v2 |x):

1 2 x1

2 x1

0 x2

F2 − F1 0 −2 x2 − x1 F3 − F2 /2

F4 + F2

F3 − F1

1 x3

0 −1 x3 − x1

2 x4

0 2 x4

es decir, el sistema es compatible cuando

x3 − x1 /2 − x2 /2 = 0,

x4 + x2 − x1 = 0,

→

1

0

0

0

2

−2

0

0

x1

x2 − x1

,

x3 − x1 /2 − x2 /2

x4 + x2 − x1

x1 + x2 − 2x3 = 0,

x1 − x2 − x4 = 0,

que son unas ecuaciones implı́citas de E.

La garantı́a de que el resultado al que hemos llegado es correcto se obtiene comprobando que todos los vectores vi

verifican todas las ecuaciones implı́citas obtenidas.

1.2.

Espacio nulo y espacio columna de una matriz.

Asociados a una matriz A, m × n,

A = [v1 |v2 |...|vn ] =

a11

a21

..

.

a12

a22

..

.

···

···

..

.

a1n

a2n

..

.

am1

am2

· · · amn

hemos considerado los denominados

Espacio nulo de la matriz A, esto es, el conjunto de vectores reales x ∈ Rn caracterizados por las ecuaciones

implı́citas

a11 x1 + a12 x2 + · · · + a1n xn

= 0

= 0

a21 x1 + a22 x2 + · · · + a2n xn

.

.

.

..

.. ..

Ax = 0 −→

.

a x + am2 x2 + · · · + amn xn = 0

m1 1

Espacio columna de la matriz A, subespacio generado por las columnas de A, esto es, el conjunto de vectores

y que se pueden escribir como combinación lineal de dichas columnas

y = α1 v1 + α2 v2 + · · · + αn vn ,

caracterizado por las ecuaciones

y1 =

y2 =

..

..

.

.

y

=

m

paramétricas

α1 a11 + α2 a12 + · · · + αn a1n

α1 a21 + α2 a22 + · · · + αn a2n

..

.

α1 am1 + α2 am2 + · · · + αn amn

, con α1 , α2 , . . . , αn ∈ R.

Resolviendo el sistema homogéneo Ax = 0 podemos obtener los vectores del espacio nulo de A como el conjunto

de vectores que se pueden expresar como combinación lineal (arbitraria) de determinados vectores, es decir, como el

subespacio generado por ciertos vectores o como el espacio columna de la matriz que tiene a dichos vectores como

vectores columna. Por otra parte, puesto que el espacio columna de una matriz A está formado por los vectores y tales

que el sistema de ecuaciones Ax = y es compatible, obteniendo las condiciones de compatibilidad de este sistema (en

función del término independiente y), tendremos unas ecuaciones lineales homogéneas que permiten expresar el citado

espacio columna como espacio nulo de otra matriz.

Por tanto, hablar de espacio nulo o espacio columna de una matriz (o subespacio generado por ciertos vectores)

no es hablar de conjuntos de vectores con caracterı́sticas distintas, sino que es hablar de un mismo tipo de conjunto

de vectores, que son los denominados subespacios vectoriales, pero expresados en forma distinta:

cuando uno de dichos conjuntos de vectores viene dado como espacio nulo de una matriz tenemos una descripción

implı́cita (ecuaciones implı́citas) de dicho conjunto (un vector está en el conjunto considerado si, y sólo si,

sus coordenadas verifican el sistema homogéneo asociado a la matriz),

81

cuando uno de dichos conjuntos de vectores viene dado como espacio columna de una matriz tenemos una descripción paramétrica (ecuaciones paramétricas) de dicho conjunto (un vector está en el conjunto considerado

si, y sólo si, puede expresarse como combinación lineal de determinados vectores).

Entre las descripciones paramétricas de un subespacio vectorial unas serán mejores que otras en el sentido de que

unas involucren menos vectores que otras. Es decir, si tenemos el espacio columna de una cierta matriz A, m × n,

y los vectores columna de A son linealmente dependientes, suprimiendo vectores que sean combinación lineal de los

que quedan, tendremos que el espacio columna de la matriz original también es el espacio columna de la matriz que

resulta de la matriz anterior suprimiendo algunas columnas. Si nos quedamos con un conjunto de vectores linealmente

independiente, tendremos que dichos vectores generan el espacio columna de la matriz original y cada vector de

dicho espacio se puede expresar de forma única como combinación lineal de los vectores linealmente independientes

obtenidos. Dichos vectores constituyen lo que se denomina una base (es decir, un conjunto de vectores linealmente

independiente que genera el subespacio) del subespacio vectorial considerado, el espacio columna de la matriz original.

Si en la representa-ción paramétrica eliminamos los parámetros, llegaremos a unas ecuaciones homogéneas que darán

una descripción implı́cita del subespacio considerado.

De forma paralela, entre las descripciones implı́citas de un subespacio vectorial también habrá unas mejores que

otras, en el sentido de que una puede tener ecuaciones redundantes y otra no. Si mediante operaciones fila reducimos

una matriz A a forma escalonada y obtenemos la matriz U , las soluciones del sistema U x = 0 coinciden con las del

sistema Ax = 0, es decir los espacios nulos de la matriz A y de la matriz U coinciden. Si de la matriz U eliminamos las

filas nulas, que proceden de ecuaciones originales redundantes en el sistema Ax = 0, tendremos un sistema de ecuaciones

sin ecuaciones redundantes y cuyas soluciones forman el espacio nulo de la matriz A original. Si resolvemos el

sistema homogéneo tendremos una descripción paramétrica del conjunto solución, es decir, del subespacio dado.

Podemos caracterizar las matrices invertibles en términos de sus espacios nulo y columna.

Teorema.- Consideremos una matriz cuadrada de orden n.

(1) La matriz A tiene inversa si, y sólo si, Col (A) = Rn .

(2) La matriz A tiene inversa si, y sólo si, Nul (A) = {0}.

Cuando se consideran las transformaciones lineales sin hacer referencia a la matriz asociada, se suele utilizar la

siguiente terminologı́a:

Definición. Consideremos una aplicación lineal T : Rn −→ Rm .

(1) Se denomina núcleo de T y se denota por ker(T ) al conjunto (subespacio)

ker(T ) = {x ∈ Rn : T (x) = 0} .

(2) Se denomina conjunto o espacio imagen de T al conjunto de vectores de Rm que tienen anti-imagen, es decir,

Imagen(T ) = T (Rn ) = {T (x) : x ∈ Rm } = {y ∈ Rm : ∃x ∈ Rn , y = T (x)} .

Si consideramos la matriz A asociada a T , tenemos

ker(T ) = {x ∈ Rn : Ax = 0} = Nul (A)

Imagen(T ) = T (Rn ) = {Ax : x ∈ Rm } = {y ∈ Rm : ∃x ∈ Rn , y = Ax} =

= {y ∈ Rm : Ax = y es un S.C.} = Col (A).

Ejemplo.- Consideremos el espacio nulo de la matriz

−1 2 0

A= 3 0 1

1 4 1

3

−1 ,

5

es decir, estamos considerando el conjunto S de los vectores x ∈ R4

ecuaciones (implı́citas)

−x1 + 2x2 +

3x4 =

3x1 +

x3 − x4

=

x1 + 4x2 + x3 + 5x4 =

cuyas coordenadas (x1 , x2 , x3 , x4 ) verifican las

0

0

.

0

Haciendo operaciones fila sobre la matriz A (que se corresponden con operaciones sobre las ecuaciones del sistema)

tenemos

−1 2 0 3

F3 − F2

−1 2 0 3

−1 2 0 3

F2 + 3F1

- 0 6 1 8

- U = 0 6 1 8 .

A = 3 0 1 −1

0 6 1 8

F3 + F1

0 0 0 0

1 4 1 5

82

De hecho, refiriéndonos a la matriz original tenemos que F3 (A) = F2 (A) + 2F1 (A). Equivalentemente, la tercera

ecuación del sistema original es combinación lineal de las dos primeras con lo cual si un vector es solución de las dos

primeras también lo es de la tercera. Resumiendo, tenemos que

−1 2 0 3

−1 2 0 3

S = Nul (A) = Nul

= Nul (U ) = Nul

3 0 1 −1

0 6 1 8

con lo cual nuestro conjunto S de vectores está caracterizado por las ecuaciones (no redundantes)

−x1 + 2x2 +

3x4 = 0

−x1 + 2x2 +

3x4 = 0

o por

3x1 +

x3 + x4

= 0 .

6x2 + x3 + 8x4 = 0

Resolviendo el sistema U x = 0 tenemos

-1

0

0

2

6

0

0

1

0

Variables libres

3 0

x3 y x4 .

8 0 =⇒

Variables fijas =⇒

0 0

x1 y x2 .

x2 = 16 (−x3 − 8x4 )

⇒

x1 = 2x2 + 3x4 = 26 (−x3 − 8x4 ) + 3x4 = − 31 x3 + 31 x4

x1

x2

⇒

x3 = x3

x4

Por tanto,

Nul (A) =

=

1

−3

−1

6

Gen v1 =

1

0

− 31

−1

6

Col

1

0

1

− 31

3

4

− 61

+ x4 − 3

0

1

0

1

, v2 =

= Gen

0

1

1

3

− 34

−2 1

= Col −1 −4 .

6

0

0

0

3

1

1

3

− 68

.

−2

−1

6v1 =

6

0

1

−4

, 3v2 =

0

3

Los vectores {v1 , v2 } forman una base de S = Nul (A). Los vectores de Nul (A) son los que pueden expresarse como

combinación lineal de v1 y v2 y, como consecuencia de la independencia lineal, cada vector de S sólo puede expresarse

de una única forma como combinación lineal de v1 y v2 . Los coeficientes que aparezcan en dicha combinación lineal

son las coordenadas del vector de S respecto a la base {v1 , v2 } (de S). El vector v = [−8 5 18 − 6] está en S y sus

coordenadas respecto a {v1 , v2 } son la solución de

1

1

−3

−8

3

−1 −4 5

λ

6

3

,

≡

v = λv1 + µv2 ≡ v = v1 v2

1

µ

18

0

0

1 −6

es decir, λ = 18, µ = −6 (v = 18v1 − 6v2 ).

Ejemplo.- Vamos a utilizar la misma matriz A del ejemplo anterior. El espacio columna de dicha matriz es, por

definición de espacio columna, el conjunto de vectores y que se pueden expresar como combinación lineal de las

columnas de A, es decir los vectores y (¡con 3 coordenadas!) que se pueden expresar mediante

−1

y1

2

0

3

y = y2 = α 3 + β 0 + γ 1 + δ −1

y3

1

4

1

5

para ciertos α, β, γ, δ ∈ R. Esto es lo mismo que decir que el espacio columna está formado por los vectores y ∈ R3

para los que el sistema de ecuaciones Ax = y tiene solución. En dicho caso, cada solución del sistema Ax = y nos

darı́a una forma de expresar y como combinación lineal de las columnas de A. Obtengamos, para un vector genérico

83

y ∈ R3 las condiciones de compatibilidad del sistema Ax = y, reduciendo la matriz ampliada del sistema [A|y] a forma

escalonada. Haciendo las mismas operaciones fila que hemos hecho cuando hemos obtenido el espacio nulo tenemos

F2 + 3F1

−1 2 0 3

y1

−1 2 0 3 y1

- 0 6 1 8 y2 + 3y1

[A|y] = 3 0 1 −1 y2

F3 + F1

1 4 1 5 y3

0 6 1 8 y3 + y1

F3 − F2

-1

- U = 0

0

2

6

0

0

1

0

3

y1

.

8

y2 + 3y1

0 y3 − y2 − 2y1

Por tanto, el sistema Ax = y es compatible (determinado o indeterminado) ⇐⇒ y3 − y2 − 2y1 = 0. Es decir, el espacio

columna de A está formado por los vectores y ∈ R3 cuyas coordenadas verifican la ecuación (lineal homogénea)

y3 − y2 − 2y1 = 0. Se trata, por tanto, de un plano (en R3 ) que pasa por el origen de coordenadas. Además, teniendo

la forma escalonada U que hemos obtenido, puesto que:

Las columnas 1 y 2 de U son linealmente independientes y

Las columnas 3 y 4 son combinación lineal de las columnas 1 y 2,

lo mismo sucede con las columnas correspondientes de la matriz A con lo cual, el espacio columna de A (generado por

las 4 columnas) coincide con el espacio generado por las columnas 1 y 2 de A (¡no de U !). Los vectores dados por las

columnas 1 y 2 de A forman una base de Col (A) puesto que son linealmente independientes y generan dicho espacio.

Si denotamos por v1 , v2 , v3 y v4 a los vectores columna de A, cada vector y ∈ Col (A) se puede expresar de infinitas

formas distintas como combinación lineal de v1 , v2 , v3 y v4 puesto que el sistema de ecuaciones Ax = y es compatible

(puesto que y ∈ Col (A)) indeterminado (puesto que hay 2 variables libres). Sin embargo, dicho vector y ∈ Col (A)

sólo puede expresarse de una única forma como combinación lineal de v1 y v2 puesto que el sistema de ecuaciones

y1

v1 v2 λ = y2

µ

y3

tendrá solución única. Para discutir,

que hemos hecho del sistema Ax = y

−1 2

3 0

1 4

y resolver, este sistema basta con suprimir las columnas 3 y 4 de la reducción

con lo cual tenemos

y1

-1

2

y1

.

y2

-··· 0

6

y2 + 3y1

y3

0

0 y3 − y2 − 2y1

La solución única (λ, µ) de este sistema (compatible cuando y ∈ R3 ) nos dará los coeficientes para los cuales se verifica

y = λv1 + µv2 .

Estos coeficientes (λ, µ) (únicos para cada vector y ∈ Col (A)) se denominan coordenadas de y respecto de la base

{v1 , v2 }. Por ejemplo, las coordenadas del vector

1

y= 1

(∈ Col (A) puesto que y3 − y2 − 2y1 = 3 − 1 − 2 = 0)

3

respecto a la base {v1 , v2 } de Col (A) vienen dadas por la

1

v1 v2 λ = 1 −→

µ

3

Ejercicio resuelto

Dada la matriz

solución del sistema

-1

2 1

λ

=⇒

=

0

6 4

µ

0

0 0

0

1

1

1 −1 −3

,

A=

−2 0

4

−1 2

a

1

3

4

6

.

a ∈ R,

encontrar, según los valores del parámetro a, unas ecuaciones implı́citas del espacio columna de A, Col(A). Para

a = 1, escribir razonadamente, si es que existe, una matriz C, 4 × 5, tal que Col(C) = Col(A).

84

Si llamamos vi a las columnas de A, A = [v1 |v2 |v3 ], entonces su espacio columna, Col(A) = Gen {v1 , v2 , v3 }, que

está contenido en R4 .

Dado un conjunto generador {v1 , v2 , v3 } de un subespacio E ⊂ R4 , encontrar las ecuaciones implı́citas de E es hallar

las condiciones que deben verificar las componentes de un vector de R4 , x = (x1 , x2 , x3 , x4 )T , para que pertenezca a

E, es decir, para que se pueda escribir como combinación lineal del conjunto generador, x = c1 v1 + c2 v2 + c3 v3 , es

decir, para que existan esos escalares ci , o lo que es equivalente, para que el sistema

(v1 |v2 |v3 )c = x, con c = (c1 , c2 , c3 )T

sea compatible. Para exigir esto construimos la matriz ampliada (v1 |v2 |v3 |x):

0

1

1 x1

1 −1 −3 x2

1 −1 −3 x2

1

1 x1

F2 ↔ F1 0

F3 + 2F1

−2 0

−2 0

F

+

F

x

4 x3

4

4

1

3

−1 2

a x4

−1 2

a x4

x2

1 −1 −3

1 −1

x

0

1

1

F3 − 2F2

1

F4 ↔ F3 0 1

x3 + 2x2 + 2x1

0

F4 − F2 0 0

- 0 0

- 0 0 a − 4 x4 + x2 − x1

0 0

es decir, si a 6= 4 aparecen tres pivotes y el sistema es compatible cuando

x2

1 −1 −3

0 1

1

x1

0 −2 −2 x3 + 2x2

0 1 a − 3 x4 + x2

x2

−3

x1

1

,

a − 4 x4 + x2 − x1

0

x3 + 2x2 + 2x1

2x1 + 2x2 + x3 = 0

(si a 6= 4, Col(A) ⊂ R4 tiene una sola ecuación implı́cita pues al ser las tres columnas linealmente independientes,

dim(Col(A)) = 3). Sin embargo, si a = 4, sólo aparecen dos pivotes (sólo hay dos columnas linealmente independientes,

con lo que dim(Col(A)) = 2 y ese subespacio tendrá dos ecuaciones implı́citas) y, por tanto, el sistema es compatible

cuando

2x1 + 2x2 + x3 = 0,

x1 − x2 − x4 = 0,

que son unas ecuaciones implı́citas de Col(A) cuando a = 4.

La garantı́a de que el resultado al que hemos llegado es correcto se tiene comprobando que todos los vectores vi

verifican todas las ecuaciones implı́citas obtenidas (una en el caso a 6= 4 y dos cuando a = 4).

Nos piden después que, para a = 1, encontremos si es posible alguna matriz C, 4 × 5, tal que Col(C) = Col(A).

Es decir, C = [u1 |u2 |u3 |u4 |u5 ] y como los ui ∈ R4 , entonces Col(C) ⊂ R4 con lo que sı́ puede darse Col(C) = Col(A).

(Si C no tuviera 4 filas, entonces los ui ∈

/ R4 y no existirı́a C tal que Col(C) = Col(A)).

Para escribir una matriz C, 4 × 5, cuyo espacio columna coincida con Col(A) basta con que sus cinco columnas

sean combinación lineal de v1 , v2 y v3 (columnas de A) y que tres de ellas sean linealmente independientes (pues las

tres columnas de A lo son para a = 1). Por ejemplo, nos sirven las matrices siguientes (por comodidad repetimos las

tres primeras columnas de A, aunque basta con que las cinco columnas verifiquen la ecuación implı́cita de Col(A),

2x1 + 2x2 + x3 = 0, y que haya tres linealmente independientes):

0

1

1

1

1

0

1

1

0

0

0

1

1 0 0

1 −1 −3 0 0 1 −1 −3 1

1

, 1 −1 −3 −1 −3 ,

,

−2 0

−2 0

4

0

4

−2 0

4 −2 −2

4 0 0

−1 2

1

2

1

−1 2

1 −1 −1

−1 2

1 0 0

0

1

1

0

0

0

1

1

0

3

1 −1 −3 2 −3 1 −1 −3 1

1

, ...

,

−2 0

4 −2 −2

4 −4 0 −2 0

−1 2

1

27

0

−1 2

1 −2 6

Observemos que para las matrices B1 = [v1 |v1 |v1 |v1 |v1 ], B2 = [v1 |v2 |v1 −v2 |0|2v1 −3v2 ], B3 = [v2 |v2 |v3 −v2 |v3 |4v2 −

5v3 ], se verifica Col(Bi ) ⊂ Col(A) pero no se da la igualdad Col(Bi ) = Col(A) (que es lo que nos pide el enunciado; por tanto, tres columnas deben ser linealmente independientes) ya que dim(Col(B1 )) = 1, dim(Col(B2 )) =

dim(Col(B3 )) = 2, mientras que dim(Col(A)) = 3.

Ejercicio resuelto

Dada la matriz

1

B= 1

0

−1 1

1

2

0 −1 ,

b −1 −2

b ∈ R,

encontrar, según los valores del parámetro b, un conjunto generador linealmente independiente del espacio nulo de

B, N ul(B).

85

El espacio nulo de B está formado por los vectores x ∈ R4 tales que Bx = 0. Nos piden que encontremos un conjunto

generador linealmente independiente (una base) de dicho espacio nulo, en función del parámetro b. Para ello basta con

resolver el sistema Bx = 0 (homogéneo, de tres ecuaciones y cuatro incógnitas):

1

1

0

−1 1

1

2

0 −1

b −1 −2

1

F2 − F1 0

- 0

1 −1

−1 1

1

3 −1 −2 F3 − 3b F2 0 3

- 0 0

b −1 −2

Entonces, cuando b = 3, la matriz que representa al sistema es

1 −1 1

1

0 3 −1 −2

0 0

0

0

1

1

.

−1

−2

b

b

3 − 1 2( 3 − 1)

con lo que tomando x3 , x4 como variables libres (al ser las columnas tercera y cuarta columnas no pivote) obtenemos

x1

−2/3

−1/3

x3 , x4 ∈ R

x2

= x3 1/3 + x4 2/3 ,

x2 = 31 (x3 + 2x4 )

→x=

x

1

0

3

x1 = x2 − x3 − x4 = − 23 x3 − 31 x4

0

x4

1

con lo que

−2/3

−1/3

2/3

1/3

N ul(B) = Gen

,

= Gen

1 0

0

1

−2

−1

2

1

3 , 0

0

3

y una base de N ul(B), para b = 3, es {(−2, 1, 3, 0)T , (−1, 2, 0, 3)T }. Conviene comprobar que estos vectores verifican

el sistema Bx = 0.

Si b 6= 3, la matriz que representa el sistema (hemos dividido la tercera fila por 3b − 1 6= 0) es

1 −1 1

1

0 3 −1 −2

0 0

1

2

con lo que, tomando x4 como variable libre (al ser la cuarta columna

1

x1

x4 ∈ R

0

x2

x3 = −2x4

→x=

x3 = x4 −2

x2 = 31 (x3 + 2x4 ) = 0

1

x1 = x2 − x3 − x4 = x4

x4

no pivote), obtenemos

1

0

→ N ul(B) = Gen

−2

1

y una base de N ul(B), para b 6= 3, es {(1, 0, −2, 1)T }. Conviene comprobar que este vector verifica el sistema Bx = 0.

Ejercicio resuelto 1

2

1

Dada la matriz A =

, escribir, si es posible, dos matrices cuadradas de orden 3 y dos matrices

−2 −4 −2

3 × 4 cuyo espacio columna coincida con el espacio nulo de A, N ul(A).

Vamos a calcular, en primer lugar el espacio nulo de A, N ul(A), es decir vamos a encontrar los vectores x tales que

Ax = 0. Puesto que A es una matriz 2 × 3, para que se pueda hacer el producto Ax, debe verificarse que x ∈ R3 . Ası́,

Ax = 0 nos proporciona las ecuaciones implı́citas de N ul(A):

−2

−1

x1 + 2x2 + x3 = 0

→ N ul(A) = Gen v1 = 1 , v2 = 0 .

N ul(A) ≡

−2x1 − 4x2 − 2x3 = 0

0

1

Por tanto, una base de N ul(A) es {v1 , v2 }. Para escribir matrices 3 × 3 cuyo espacio columna coincida con N ul(A)

basta con que sus tres columnas sean combinación lineal de v1 y v2 (o, equivalentemente, que verifiquen su ecuación

implı́cita x1 + 2x2 + x3 = 0) y que dos sean linealmente independientes:

−2 −1 0

−2 −1 −2

−2 −1 −1

−1 −2 −3

1

2

4

1

0 0 , 1

0

1 , 1

0

0 , 0

1

1 , 0 −1 0 , ...

0

1 0

0

1

0

0

1

1

1

0

1

−1 0 −4

86

Observemos que para la matriz B = [v1 |v1 |v1 ] se verifica Col(B) ⊂ N ul(A) pero no se da la igualdad Col(B) = N ul(A)

(que es lo que nos pide el enunciado). Por tanto, dos columnas deben ser linealmente independientes.

Si las matrices son 3 × 4, se aplica el mismo razonamiento sobre las cuatro columnas: todas deben ser combinación

lineal de v1 y v2 y, simultáneamente, dos deben ser linealmente independientes:

−2 −1 0 0

−2 −1 −2 −4

−2 −1 2 −7

−1 −2 −2 −2

1

0 0 0 , 1

0

1

0 , 1

0 −1 0 , 0

1

1

1 , ...

0

1 0 0

0

1

0

4

0

1

0

7

1

0

0

0

2.

Bases de un subespacio.

Definición. Dado un subespacio S de Rn distinto del subespacio nulo S 6= {0}, se dice que un conjunto de vectores

{v1 , v2 , . . . , vr }

de S es una base de S si:

(a) {v1 , v2 , . . . , vr } es linealmente independiente,

(b) {v1 , v2 , . . . , vr } genera S,

S = Gen {v1 , v2 , . . . , vr } .

Las anteriores condiciones se pueden expresar de forma matricial:

son los vectores dados

..

.

..

. · · · ..

.

A = v1 v2 . . . vr

..

.

..

. · · · ..

.

las columnas de A forman una base de un subespacio vectorial S si:

Si denotamos por A a la matriz cuyas columnas

(a) El sistema homogéneo Ax = 0 tiene solución única (condición equivalente a que los vectores sean linealmente

independientes) y

(b) S = Col (A), es decir S está formado por los vectores y ∈ Rm para los que el sistema de ecuaciones Ax = y es

compatible.

Ejemplo. Los vectores canónicos de Rn ,

e1 =

forman una base de Rn . Los vectores

1

0

..

.

0

, e2 =

0

..

.

, . . . , en =

0

0

1

0

1

..

.

{e1 , e1 + e2 , · · · , e1 + e2 + · · · + en }

también forman una base de Rn .

Definición/Teorema. (Coordenadas respecto de una base) Dada una base {v1 , v2 , . . . , vr } de un subespacio vectorial

S, cada vector v de S se puede expresar de forma única como combinación lineal de los vectores de la base dada,

v = c1 v1 + c2 v2 + · · · + cr vr .

Los coeficientes que aparecen en dicha expresión (c1 , . . . , cr ) se denominan coordenadas de v respecto a la base dada

B = {v1 , v2 , . . . , vr } y se suelen denotar por

c1

[v]B = ... .

cr

Definición/Teorema. Consideremos un subespacio vectorial S de Rm distinto del subespacio nulo S 6= {0}. Se

verifican:

87

(a) S tiene base.

(b) Todas las bases de S tienen el mismo número de elementos.

Al número de elementos de una base de S se le denomina dimensión de S. Por definición, la dimensión del

subespacio formado por el vector nulo es cero.

Si, al igual que antes, denotamos por A a la matriz cuyas columnas son los vectores dados

..

..

..

.

.

.

·

·

·

A = v1 v2 . . . vr ,

..

.

..

. · · · ..

.

para cada vector v (vector columna) de S se verifica que

v = Ac

para algún vector de coeficientes c.

Teorema (El Teorema de la Base). Consideremos un subespacio vectorial S de Rm de dimensión p (p ≤ m) y un

conjunto de vectores {u1 , . . . , uq } ⊂ S.

(a) Si {u1 , . . . , uq } generan S, entonces q ≥ p. Además, q = p ⇐⇒ {u1 , . . . , uq } es una base de S.

(b) Si {u1 , . . . , uq } es linealmente independiente, entonces q ≤ p. Además, q = p ⇐⇒ {u1 , . . . , uq } es una base de S.

En particular, si tenemos un conjunto de n vectores de Rm :

Si n > m, los n vectores no pueden ser linealmente independientes,

Si m > n, los n vectores no pueden generar Rm .

3.

Rango de una matriz.

Definición. Dada una matriz A, m × n, se llama rango de A a la dimensión de su espacio columna, es decir, a la

dimensión del subespacio vectorial (de Rm )

Col (A) = {combinaciones lineales de las columnas de A}

= {Ax : x ∈ Rn } = {y ∈ Rm : Ax = y es compatible} .

Teniendo en cuenta la relación entre la dimensión del espacio columna de A y la reducción de A a forma escalonada

tenemos que

rango(A) = número de pivotes de A.

Para una matriz cuadrada A de orden n, teniendo en cuenta los resultados sobre la existencia de la inversa

obtenemos que:

A tiene inversa ⇐⇒ rango(A) = n.

Teorema. Consideremos una matriz A, m × n. Se verifican:

(a) rango(A) = rango(AT ). Es decir, la dimensión del subespacio vectorial (de Rn ) generado por las m filas de A

coincide con la dimensión del espacio columna de A (subespacio vectorial de Rm generado por las n columnas

de A):

dim (Col (A)) = dim Col (AT ) .

Es decir, si por un lado reducimos la matriz A a forma escalonada por filas (mediante operaciones fila) y por

otro reducimos a forma escalonada por columnas (mediante operaciones columna), el número de pivotes que se

tienen en ambas reducciones es el mismo.

88

(b) Teorema del rango.

dim (Col (A)) + dim (Nul (A)) = n.

(c) En términos de la reducción por filas de A a forma escalonada, el Teorema del rango se puede expresar mediante:

(número de pivotes) + (número de variables libres) = n.

Si consideramos la transformación lineal T : Rn −→ Rm , asociada a una matriz real A, m × n, el espacio imagen

de la transformación es el espacio columna de la matriz A,

Imagen(T ) = T (Rn ) = {T (x) ∈ Rm : x ∈ Rn } =

= {y ∈ Rm : y = T (x) para algún x ∈ Rn } = Col (A).

Se trata, por tanto, de un subespacio vectorial de Rm cuya dimensión es rango(A).

La imagen, mediante T , de cualquier subespacio vectorial S de Rn será un subespacio vectorial T (S) de Rm

contenido en el espacio imagen (columna) y por tanto la dimensión de dicho subespacio T (S) será menor o igual que

el rango de A (y menor o igual que la dimensión del subespacio S original).

Por otra parte, si consideramos un subespacio vectorial H de Rm , el conjunto de los vectores x ∈ Rn cuyos

transformados T (x) = Ax pertenecen a H forman un subespacio vectorial de Rn . En particular, si H es el subespacio

nulo de Rm , es decir, H = {0} ⊆ Rm entonces, obtenemos el núcleo de la transformación T o lo que es lo mismo, el

espacio nulo de A,

ker(T ) = {x ∈ Rn : T (x) = 0} = {x ∈ Rn : Ax = 0} = Nul (A).

Ejercicio resuelto

Considera la transformación lineal

1

T 2 =

0

T que verifica

1

1

−1

, T 1 =

−1

0

2

0

−3

,

0

3

1

1

−4

T 0 =

−1 .

1

5

(a) Calcula la matriz A tal que T (x) = Ax para todo x ∈ R3 .

(b) Calcula unas ecuaciones implı́citas del espacio columna de A.

(c) Calcula un conjunto linealmente independiente de vectores S que genere el subespacio nulo de A.

(a) La aplicación lineal T : R3 → R4 tiene asociada, respecto de las bases canónicas, la matriz A en cuyas columnas

aparecen los transformados de la base canónica del espacio de partida, es decir, A = [T (e1 )|T (e2 )|T (e3 )].

Una posibilidad es plantear el sistema de ecuaciones vectoriales, donde, por comodidad llamamos a = (1, −1, −1, 2)T ,

b = (0, −3, 0, −3)T , c = (1, −4, −1, 5)T ,

T ([1, 2, 0]T ) = T (e1 + 2e2 ) = T (e1 ) + 2T (e2 ) = a

T (e2 ) = a − b = (1, 2, −1, −1)T

T ([1, 1, 0]T ) = T (e1 + e2 ) = T (e1 ) + T (e2 ) = b

−→ T (e1 ) = b − T (e2 ) = (−1, −5, 1, 4)T

T ([1, 0, 1]T ) = T (e1 + e3 ) = T (e1 ) + T (e3 ) = c

T (e3 ) = c − T (e1 ) = (2, 1, −2, 1)T

que en este caso se resuelve trivialmente (en general, lo resolveremos

Por tanto,

−1

−5

A = [T (e1 )|T (e2 )|T (e3 )] =

1

4

mediante eliminación de Gauss).

1

2

2

1

.

−1 −2

−1 1

Antes de seguir, podemos asegurarnos de que la matriz encontrada es la correcta comprobando que

A[1, 2, 0]T = (1, −1, −1, 2)T , A[1, 1, 0]T = (0, −3, 0, −3)T A[1, 0, 1]T = (1, −4, −1, 5)T .

Otra forma de encontrar A es escribir

1

1

1

−1

A 2 =

−1 , A 1 =

0

0

2

matricialmente las igualdades que nos

0

1

1

1

−3

0 = −4 → A 2

,

A

−1

0

1

0

3

5

89

dan:

1

1

0

1

0

1

1

−1 −3 −4

0 =

−1 0 −1

1

2

3

5

,

de donde deducimos

1

0

1

−1 −3 −4 1

A=

−1 0 −1 2

0

2

3

5

La matriz inversa

1

2

0

(b) Puesto que

−1

1 1

1 0

0 1

1

0

1

−1 −3 −4 −1

2

=

−1 0 −1

0

2

3

5

−1 1

2

1

1

−5 2

1

−1 −2 =

1 −1 −2 .

0

1

4 −1 1

que aparece la hemos calculado aplicando el método de Gauss–Jordan:

1 1

1

1 1 0 1 0 −1

1 0 0

1 1 1 0 0

1 0 0 1 0 ∼ 0 −1 −2 −2 1 0 ∼ 0 −1 0 −2 1 2

0 1 0 0 1

0 0

1

0 0 1

0 0 1 0 0 1

1 0 0 −1 1

1

1 0 0 −1 1 1

∼ 0 −1 0 −2 1 2 ∼ 0 1 0 2 −1 −2 .

0 0 1 0 0 1

0 0 1 0

0

1

−1

1

2

−5

Col(A) = Gen

1 , −1

4

−1

2

1

,

,

−2

1

dado un conjunto generador {v1 , v2 , v3 } del subespacio Col(A) ⊂ R4 , encontrar las ecuaciones implı́citas de Col(A) es

hallar las condiciones que deben verificar las componentes de un vector de R4 , x = (x1 , x2 , x3 , x4 )T , para que pertenezca

a Col(A), es decir, para que se pueda escribir como combinación lineal del conjunto generador x = c1 v1 + c2 v2 + c3 v3 ,

es decir, para que existan esos escalares ci , o lo que es equivalente, para que el sistema

(v1 |v2 |v3 )c = x, con c = (c1 , c2 , c3 )T

sea compatible. Para exigir esto construimos la matriz ampliada (v1 |v2 |v3 |x):

−1 1

2 x1

−1 1

2

−1 1

2

x1

x1

−5 2

0 −3 −9 x2 − 5x1 0 −3 −9

x

x

−

5x1

1

2

2

∼

1 −1 −2 x3 ∼ 0

x3 + x1 0

x3 + x1

0

0

0

0

4 −1 1 x4

0

3

9 x4 + 4x1

0

0

0 x4 − x1 + x2

es decir, las coordenadas de los vectores que pertenezcan a Col(A) deben verificar

x1 + x3 = 0,

,

x1 − x2 − x4 = 0.

Merece la pena emplear unos segundos, para estar seguros de que el resultado obtenido es correcto, en comprobar que

los tres vectores que generan el espacio columna verifican todas (dos en nuestro caso) las ecuaciones obtenidas.

Observemos que dim(Col(A)) = 2 (pues la tercera columna de A es combinación lineal de las dos primeras) y al

estar ese subespacio en R4 lo definen dos ecuaciones implı́citas.

(c) El espacio nulo de A está formado por los vectores x ∈ R3 tales que Ax = 0. Al aplicar el método de eliminación

para resolverlo vamos a obtener el mismo resultado (en las tres primeras columnas) que el conseguido al buscar las

ecuaciones implı́citas en el apartado anterior:

−1 1

2

−1 1

2

−1 1

2

−5 2

x1 = x2 + 2x3 = −3x3 + 2x3 = −x3 ,

1

∼ 0 −3 −9 ∼ 0 −3 −9 →

1 −1 −2 0

0

0

0

0 0

x2 = −3x3 ,

0

0

0

0

3

9

4 −1 1

−1

con lo que N ul(A) = Gen {v = (−1, −3, 1)T }, es decir, S = −3 . Es fácil comprobar que v verifica Av = 0,

1

es decir, que pertenece a N ul(A). Además, sabiendo que, en nuestro caso, T está definida en R3 , la igualdad

dim(Col(A)) + dim(N ul(A)) = 3

nos permitı́a saber, antes de comenzar este apartado, que

dim(N ul(A)) = 3 − dim(Col(A)) = 3 − 2 = 1.

90

4.

4.1.

Bases de Rn . Cambios de base.

Bases de Rn .

Todas las bases de Rn están formadas por n vectores. Puesto que en ese caso tendremos n vectores linealmente

independientes con n coordenadas cada uno, la matriz cuadrada formada por dichos vectores como vectores columna

tiene inversa (y los vectores columna de dicha matriz inversa formarán otra base de Rn ). Por otra parte, también los

vectores fila de las dos matrices citadas serán una base de Rn . Para comprobar si n vectores forman una base de Rn

bastará con reducir a forma escalonada la matriz formada por dichos vectores como vectores columna y comprobar si

se obtienen n pivotes. Notemos que, el orden de los vectores no influye en si éstos forman base o no.

Ejemplo. Siendo e1 , e2 , . . . , en los vectores de la base canónica de Rn , los vectores

e1 , e1 + e2 , e1 + e2 + e3 , . . . , e1 + e2 + · · · + en

forman una base de Rn y para calcular las coordenadas

resolver el sistema (con término independiente x)

1 1 ··· 1

0 1 ··· 1

.. .. . .

.

. .

. ..

0 0

··· 1

Resolvemos el sistema

1

0

..

.

0

1 · · · 1 x1

1 · · · 1 x2

..

.. . .

.

. ..

.

.

0 · · · 1 xn

−→

de un vector genérico x ∈ Rn respecto de esta base basta con

α1

α2

..

.

=

αn

1 0

0 1

.. ..

. .

0 0

0 0

xn

.

0

0

..

.

··· 0

x1 − x2

x2 − x3

··· 0

..

..

..

. .

.

· · · 1 0 xn−1 − xn

xn

··· 0 1

Por tanto, las coordenadas de x respecto a la base dada son

α1

x1 − x2

α2 x2 − x3

..

..

. =

.

αn−1 xn−1 − xn

αn

xn

4.2.

x1

x2

..

.

.

.

Cambios de base.

Dada una base B = {v1 , v2 , . . . , vn } de Rn , las coordenadas

coeficientes (únicos) α1 , α2 , . . . , αn para los cuales se verifica

..

..

.

.

α1 v1 + α2 v2 + · · · + αn vn = x ≡ v1 v2

..

..

.

.

Dadas dos bases

con x =

x1

x2

..

.

xn

de un vector x ∈ Rn respecto a dicha base son los

.

· · · ..

..

. vn

.

· · · ..

α1

α2

..

.

αn

=x=

x1

x2

..

.

xn

las coordenadas de x respecto de la base canónica.

U = {u1 , u2 , . . . , un }

y

B = {v1 , v2 , . . . , vn }

de Rn se trata de hallar la relación entre las coordenadas de un vector x ∈ Rn respecto de ambas bases. Hallemos

primero, la relación entre las coordenadas del vector x en la base U y la base canónica C. Las coordenadas de un vector

91

x ∈ Rn respecto a U vienen dadas por un vector [x]U que verifica que

α1

x1

α2

x2

x = . , [x]U = . ⇔ x = α1 u1 + α2 u2 + · · · + αn un

..

..

xn

αn

La matriz

⇔

..

.

u1

..

.

..

.

= u1

..

.

x1

x2

..

.

xn

..

.

.

· · · ..

..

. un

.

· · · ..

u2

..

.

..

.

u2

..

.

.

· · · ..

..

. un

.

· · · ..

α1

α2

..

.

αn

.

(∗)

que relaciona las coordenadas de un mismo vector x respecto a la base canónica con las coordenadas del mismo vector

x respecto a la base U se denomina matriz del cambio de base U −→ C de U a la base canónica C = {e1 , e2 , . . . , en }

y se denota por

..

..

..

. ··· .

.

P

P

= u1 u2 . . . un ,

[x]U

x = [x]C =

C←U

C←U

..

..

..

.

. ··· .

Puesto que la igualdad (∗) es equivalente a

−1

..

..

..

x1

α1

.

.

.

·

·

·

−1

α2

x2

P

[x]C

.. = u1 u2 . . . un .. ≡ [x]U =

C←U

.

.

..

..

.

xn

αn

.

. · · · ..

−1

P

la matriz

es la matriz del cambio de base C → U con lo cual

C←U

−1

P

P

=

.

U ←C

C←U

De forma análoga, si consideramos ahora las bases de Rn ,

B = {v1 , v2 , . . . , vn }

y

U = {u1 , u2 , . . . , un }

podrı́amos obtener las matrices de cambio de base B −→ U y U −→ B de la misma forma que lo que acabamos de

hacer si conociéramos las coordenadas de los vectores de una base respecto a la otra. Si, en cambio, conocemos las

coordenadas de los vectores de ambas bases respecto, por ejemplo, a la base canónica, tenemos un planteamiento

similar.

Denotemos las coordenadas de un vector genérico x ∈ Rn respecto de ambas bases B y U mediante

β1

α1

[x]B = ... , [x]U = ... .

βn

αn

Tenemos entonces que x = α1 v1 + · · · + αn vn = β1 u1 + · · · + βn un y expresando estas igualdades en forma matricial

tenemos que

α

β

x1

1

1

..

..

..

x = . = v1 v2 · · · vn . = u1 u2 · · · un .

x3

αn

βn

es decir, siendo B la matriz cuyas columnas son los vectores de la base B en la base canónica y siendo U la matriz

cuyas columnas son los vectores de la base U en la base canónica, se verifica que

x = B[x]B = U [x]U .

92

Por tanto,

[x]B = B −1 U [x]U =⇒

P

= B −1 U,

B←U

[x]U = U −1 B[x]B =⇒

P

= U −1 B.

U ←B

Ejemplos.

(1) Vamos a calcular las matrices de cambio de base entre la base canónica de R3 y la base

o

n

T

T

T

B = v1 = [−2 1 0] , v2 = [1 − 2 3] , v3 = [−1 0 − 1] .

Siendo las coordenadas de un vector genérico x ∈ R3 respecto a B y respecto a la base canónica

α1

x1

[x]B = α2 ,

x = x2 ,

α3

x3

respectivamente, se verifica que

x = α1 v1 + α2 v2 + α3 v3

Por tanto, la matriz

P = v1

v2

x1

≡ x2 = v1

x3

v2

α1

v3 α2 .

α3

−2 1 −1

v3 = 1 −2 0

0

3 −1

(cuyas columnas son las coordenadas de los vectores de la base B respecto a la base C es la matriz

cambio de base B −→ C puesto que

Puesto que la inversa P −1 verifica

x = [x]C = P [x]B ,

[x]B = P −1 [x]C ,

P

del

C←B

∀x ∈ R3 .

∀x ∈ R3

dicha matriz es la del cambio de base C −→ B. Resumiendo,

−2 1 −1

2 −2

1

P

P

= P = 1 −2 0 ,

= P −1 = − 1 2

6

C←B

0

3 −1

B←C

3 6

−2

−1 .

3

(2) Calculemos las matrices de cambio de base entre las bases

−2

1

−1

B = v1 = 1 , v2 = −2 , v3 = 0

y

0

3

−1

1

−1

−1

U = u1 = 2 , u2 = −2 , u3 = 3 .

1

2

2

Denotemos las coordenadas de un vector genérico x ∈ R3 respecto de ambas bases B y U mediante

β1

α1

[x]B = α2 , [x]U = β2 .

β3

α3

Tenemos entonces que x = α1 v1 + α2 v2 + α3 v3 = β1 u1 + β2 u2 + β3 u3 . Escribiendo estas igualdades en forma

matricial

−2 1 −1

x1

1 −1 −1

α1

β1

x2 = 1 −2 0 α2 = 2 −2 3 β2

x3

0

3 −1

α3

1 2

2

β3

93

obtenemos

−1

α1

1 −1

−2 1 −1

α2 = 1 −2 0 2 −2

1 2

0

3 −1

α3

y, por tanto,

−1

−2 1 −1

1 −1

1 −2 0 2 −2

0

3 −1

1 2

P

=

B←U

12

−3 .

−21

4

2

1

−4

7

6

−18 9

=

Análogamente podrı́amos obtener

−1

P

P

=

U ←B

B←U

Ejercicio resuelto

−1

β1

3 β2

2

β3

2 −2 −2

1

−1

3 = − 16 1 2 −1 2

3 6

3

1

2

−1 −1

−2 3

2

2

−20 25 −15

1

−5

22

−6 .

=

15

15 −12

6

−5

2

−3

−4

Dadas las bases de R , B1 =

,

y B2 =

,

, encontrar, con la ayuda

2

−1

1

1

de la matriz correspondiente, las coordenadas en la base B2 del vector v cuyas coordenadas en la base B1 son

[v]B1 = (2, 1)B1 .

2

Sabemos que dada una base de R2 , B1 = {v1 , v2 }, la matriz PB1 = [v1 |v2 ] relaciona las coordenadas que un vector v

tiene en la base canónica, [v]BC , y las que tiene en la base B1 , [v]B1 , de forma que

[v]BC = PB1 [v]B1 .

Análogamente, dada una base B2 = {u1 , u2 }, la matriz PB2 = [u1 |u2 ] relaciona las coordenadas que un vector v tiene

en la base canónica, [v]BC , y las que tiene en la base B2 , [v]B2 , de forma que

[v]BC = PB2 [v]B2 .

Combinando ambas expresiones obtenemos

PB1 [v]B1 = PB2 [v]B2 →

PB1 [v]B1 = PB2 ←B1 [v]B1 ,

[v]B2 = PB−1

2

−1

[v]B1 = PB1 PB2 [v]B2 = PB1 ←B2 [v]B2 .

PB1 [v]B1 . Puesto que

Como el enunciado nos da [v]B1 , usaremos [v]B2 = PB−1

2

PB1 =

−5

2

2

−1

, PB2 =

−3 −4

1

1

→

PB1

PB−1

2

=

1

4

−1 −3

−5

2

2

−1

=

3 −2

−1 1

3 −2

2

4

=

.

−1 1

1

−1

Es fácil comprobar que el resultado es correcto. Teniendo en cuenta las coordenadas obtenidas en ambas bases

v = 2v1 + v2 = 4u1 − u2 con lo que debe ser cierto

−5

2

−3

−4

2

+

=4

−

.

2

−1

1

1

obtenemos [v]B2 = PB−1

PB1 [v]B1 =

2

De aquı́ deducimos además (sin más que sumar los vectores) que, en la base canónica, v = (−8, 3)T .

Ejercicio resuelto

Consideremos una transformación lineal f : R3 −→ R3 .

Hallar la matriz A que representa a f cuando se trabaja con la base canónica B = {e1 , e2 , e3 }, sabiendo que A es

simétrica, que f (e1 ) = e2 + e3 , f (e1 + e2 + e3 ) = 2(e1 + e2 + e3 ) y que f (e2 ) pertenece al subespacio E de ecuación

x − z = 0.

94

La aplicación lineal dada f : R3 → R3 tiene asociada, respecto de las bases canónicas, la matriz A

aparecen los transformados de la base canónica del espacio de partida, es decir,

a1 b 1 c1

A = [f (e1 )|f (e2 )|f (e3 )] = a2 b2 c2 .

a3 b 3 c3

a1 a2

Al ser A simétrica, AT = A, debe ser b1 = a2 , c1 = a3 y c2 = b3 , con lo que A = a2 b2

a3 b 3

f (e1 ) = Ae1 = e2 + e3 = (0, 1, 1)T la matriz A será

0 1 1

A = 1 b2 b3 .

1 b 3 c3

Puesto que f (e2 ) pertenece al subespacio E de ecuación x − z

verificar dicha ecuación, es decir, 1 − b3 = 0, con lo que b3 = 1

0 1

A = 1 b2

1 1

en cuyas columnas

a3

b3 . Puesto que

c3

= 0, los elementos de la segunda columna de A deben

y tenemos

1

1 .

c3

Finalmente, usando f (e1 + e2 + e3 ) = f (e1 ) + f (e2 ) + f (e3 ) = (2, 2, 2)T , obtenemos que la tercera columna de A debe

verificar

f (e3 ) = (2, 2, 2)T − f (e1 ) − f (e2 ) = (2, 2, 2)T − (0, 1, 1)T − (1, b2 , 1)T = (1, 1 − b2 , 0)T .

Por tanto, debe ser (1, 1, c3 )T = (1, 1 − b2 , 0)T , con lo que

0

A= 1

1

b2 = 0, c3 = 0, y la matriz pedida es

1 1

0 1 .

1 0

Es recomendable emplear un minuto en comprobar que la matriz calculada satisface todas las condiciones del enunciado,

es decir, que no nos hemos equivocado al calcularla.

5.

Ejercicios.

Ejercicio 1. Determinar si los siguientes conjuntos son subespacios vectoriales de R2 y R3 , respectivamente:

x

2

(a) H =

∈ R : x ≥ 0, y ≥ 0 .

y

x

(b) H = y ∈ R3 : x + y = 0 .

z

Ejercicio 2. Sea E el conjunto de vectores de R4 cuyas dos primeras coordenadas suman cero.

(a) Probar que E es un subespacio vectorial de R4 .

(b) Calcular un sistema generador linealmente independiente para dicho subespacio.

(c) Hallar unas ecuaciones implı́citas del subespacio E.

Ejercicio 3. Probar que el espacio nulo y columna de una matriz A de orden m × n son subespacios vectoriales de

Rn y Rm respectivamente.

Ejercicio 4. Dados la matriz A y el vector b por

1

A= 1

0

2

3

1 , b = 2 .

2

2

95

(a) Determinar si el vector b pertenece al espacio columna de la matriz A.

(b) Obtener los vectores pertenecientes al espacio nulo de la matriz A.

Ejercicio 5. Sean las matrices A, B y

1

1

A=

1

1

el vector b dados por

0 1 1

1

1 2 0

, B = 0

0 1 1

1

1 2 0

3

1 0

0

1 2 , b =

1 .

1 3

0

(a) Determinar unas ecuaciones implı́citas y paramétricas del espacio columna de las matrices A y B.

(b) Determinar unas ecuaciones implı́citas linealmente independientes y unas ecuaciones paramétricas del espacio

nulo de A y B.

(c) Hallar un sistema generador linealmente independiente para el espacio nulo y columna de dichas matrices.

(d) Razonar si el vector b pertenece al espacio nulo de la matriz A. ¿Y al espacio nulo de la matriz B?

Ejercicio 6. (a) Determinar el rango de

0

0

A=

0

0

las siguientes matrices:

−1

1 −1 2

0

3

2 1

2 −2

, B =

2

1 −1 2

0

0

0 −1 −2 3

1

2

1

1

−1 2

3

2

.

2

2

0 −2

(b) Sea A una matriz 20 × 15 cuyo rango es 12. Determinar la dimensión de los siguientes subespacios vectoriales,

Col (A), Nul (A), Col (AT ) y Nul (AT ).

Ejercicio 7. Siendo e1 , e2 , e3 los vectores de la base canónica de R3 y sabiendo que los vectores de la base B verifican

e1 = 2u1 + 2u2 + u3 , e2 = u1 − 2u2 + 2u3 , e3 = −2u1 + u2 + 2u3 , señalar la relación correcta entre las siguientes

(considerando a los vectores como vectores-columna)

2

2 1

(a) [e1 e2 e3 ] = 1 −2 2 [u1 u2 u3 ] .

−2 1 2

−1

2

2 1

2 1 −2

(b) [u1 u2 u3 ] = 1 −2 2 = 19 2 −2 1 .

−2 1 2

1 2

2

−1

2 1 −2

2

2 1

(c) [u1 u2 u3 ] = 2 −2 1 = 19 1 −2 2 .

1 2

2

−2 1 2

Ejercicio 8. Consideremos la base B = {(2, 1)T , (−3, −1)T } de R2 . R4 :

(a) Obtener, en dicha base, las ecuaciones implı́citas y las paramétricas de los subespacios que, en la base canónica,

vienen definidos mediante

E ≡ x1 + x2 = 0, F ≡ x1 − 2x2 = 0, G = Gen {(1, 1)T }, H = Gen {(3, 1)T }.

(b) Obtener, en la base canónica, las ecuaciones implı́citas y las paramétricas de los subespacios que, en la base B,

vienen definidos mediante

E ≡ y1 + 5y2 = 0, F ≡ y2 = 0, G = Gen {(1, 0)TB }, H = Gen {(2, 4)TB }.

96

Tema 5.- Ortogonalidad. Mı́nimos cuadrados

1.

2.

3.

4.

5.

6.

7.

8.

Producto escalar. Norma, distancia, ángulos y ortogonalidad.

El complemento ortogonal de un subespacio.

Bases ortonormales de un subespacio. Matrices ortogonales.

Proyección ortogonal sobre un subespacio. El teorema de la mejor aproximación.

El método de Gram-Schmidt.

Problemas de mı́nimos cuadrados. Ecuaciones normales de Gauss.

Ajuste de curvas, regresión lineal.

Ejercicios.

En este tema estudiamos la estructura métrica de los espacios Rn , es decir, las cuestiones relacionadas con distancias

y ángulos. Al contrario de lo que sucede con el estudio de la resolución de sistemas de ecuaciones lineales, el álgebra de

matrices, etc., el hecho de considerar aquı́ vectores reales es esencial. Para poder considerar conceptos métricos en Cn ,

es decir, con vectores de coordenadas complejas, habrı́a que considerar la definición apropiada (coherente) de producto

escalar de vectores complejos, que se suele denominar producto hermı́tico. Al aplicar dicha definición a vectores reales

nos darı́a la definición usual que vemos a continuación y que los alumnos conocen en dimensión 2 y en dimensión 3.

Finalmente, estudiaremos el problema del ajuste por mı́nimos cuadrados, de gran interés en las aplicaciones.

1.

Producto escalar. Norma, distancia, ángulos y ortogonalidad.

Definición. (Producto escalar, norma, ortogonalidad) Consideremos dos vectores x, y ∈ Rn

Se denomina Producto escalar de dos vectores x, y ∈ Rn al número real

x · y = xT y = y T x = x1 y1 + x2 y2 + · · · + xn yn ∈ R.

Se denomina Norma de un vector x ∈ Rn al número real no-negativo

q

√

2

2

||x|| = |x1 | + · · · + |xn | = x · x ≥ 0.

Se denomina Distancia entre dos vectores x, y ∈ Rn al número real no-negativo

d(x, y) = ||x − y|| .

Ortogonalidad

(a) Se dice que dos vectores x, y ∈ Rn son ortogonales (x ⊥ y) si

x · y = 0.

(b) Se dice que un conjunto de vectores {v1 , . . . , vm } de Rn es un conjunto ortogonal si cada uno de los

vectores vk es ortogonal a todos los demás,

vk · vj = 0, j 6= k.

(c) Se dice que un conjunto de vectores {v1 , . . . , vm } de Rn es un conjunto ortonormal si es un conjunto

ortogonal y cada uno de los vectores vk tiene norma igual a 1,

vk · vj = 0, j 6= k;

||v1 || = · · · = ||vm || = 1.

Las propiedades del producto escalar, la norma, la distancia y la ortogonalidad son conocidas por el alumno

para vectores en R2 y en R3 . En los espacios Rn , las propiedades son esencialmente las mismas. Notemos que si

considerásemos dichos conceptos de forma independiente de un sistema de referencia, en cada uno de ellos aparecen

involucrados uno o dos vectores. Algunas de las propiedades del producto escalar pueden obtenerse directamente

del hecho de que el producto escalar de dos vectores puede expresarse como un producto matricial, vector-fila por

vector-columna

y1

x1

x · y = [x1 , x2 , . . . , xn ] ... = xT y = y T x = [y1 , y2 , . . . , yn ] ... = y · x.

yn

xn

97

Propiedades. Sean x, y ∈ Rn , α ∈ R.

(1) ||x|| = 0 ⇐⇒ x = 0.

(2) ||αx|| = |α| ||x||.

(3) Desigualdad triangular: ||x + y|| ≤ ||x|| + ||y|| , (||x − y|| ≤ ||x|| + ||y||).

(1) Desigualdad de Cauchy-Schwartz: |x · y| ≤ ||x|| ||y||.

(4) Teorema de Pitágoras:

2

2

2

x ⊥ y ⇐⇒ ||x + y|| = ||x|| + ||y|| .

El ángulo (los ángulos) determinado por dos vectores no-nulos x, y ∈ Rn puede caracterizarse (definirse) mediante

la igualdad

x · y = ||x|| ||y|| cos(θ).

2.

El complemento ortogonal de un subespacio.

Definición. (El complemento ortogonal de un subespacio) Dado un subespacio vectorial S de Rn se denomina complemento ortogonal de S al conjunto

S ⊥ = {v ∈ Rn : v ⊥ u , ∀u ∈ S} .

Es decir, S ⊥ está formado por todos losnvectores

que son ortogonales a todos los vectores de S. Por tanto, el como

n

~

plemento ortogonal del subespacio nulo 0 es R puesto que cualquier vector es ortogonal al vector nulo. Por otra

parte, el complemento ortogonal del espacio total Rn es el subespacio nulo, puesto que el vector nulo (de Rn ) es el

único que es ortogonal a todos los vectores de Rn .

Ejemplos. A la hora de trabajar con el complemento ortogonal de un subespacio es conveniente tener presente cómo se

puede caracterizar, el complemento ortogonal de un subespacio, cuando el subespacio viene dado en forma paramétrica

o cuando viene dado en forma implı́cita. En R2 , un subespacio vectorial de dimensión 1 es una recta que pasa por el

origen y su complemento ortogonal será (como es natural) la recta que pasa por el origen (es un subespacio vectorial)

y es perpendicular a la recta dada. En R3 , un subespacio vectorial de dimensión 1 es una recta que pasa por el origen.

Su complemento ortogonal será el plano que pasa por el origen (es un subespacio vectorial) y es perpendicular a la

recta dada. Un subespacio vectorial de dimensión 2 es un plano que pasa por el origen. Su complemento ortogonal

será la recta que pasa por el origen (es un subespacio vectorial) y es perpendicular al plano dado.

(1) Consideremos un subespacio de dimensión 1 en R2 , dado en forma paramétrica, es decir, una recta que pasa por

el origen de coordenadas, dada por un vector dirección v1 . Por ejemplo, para v1 = [2, −1]T

x1 = 2α

S = Gen {v1 } = {αv1 : α ∈ R} ≡

,

x2 = −α

T

su complemento ortogonal estará formado por los vectores v = [x1 , x2 ] ∈ R2 que son ortogonales a todos los

vectores de la forma αv1 , α ∈ R

v ∈ S ⊥ ⇔ (αv1 ) · v = 0, ∀α ∈ R ⇐⇒ v1 · v = 0 ⇔ 2x1 − x2 = 0.

T

Es decir, el complemento ortogonal S ⊥ está formado por todos los vectores v = [x1 , x2 ] ∈ R2 cuyas coordenadas

verifican la ecuación

2x1 − x2 = 0,

con lo cual S ⊥ es un subespacio vectorial (de dimensión 1) que viene dado en forma implı́cita y los coeficientes

de la ecuación implı́cita son las coordenadas del vector dirección de S. Si hubiéramos considerado otro vector

dirección de S (que será un múltiplo no-nulo de v1 ), habrı́amos obtenido una ecuación equivalente.

(2) Si consideramos un subespacio vectorial S de dimensión 1 en Rn , es decir una recta que pasa por el origen,

generada por un vector no-nulo v1 ∈ Rn

a1

S = Gen v1 = ... ,

an

98

T

su complemento ortogonal estará formado por los vectores v = [x1 , . . . , xn ] ∈ Rn cuyas coordenadas verifican

la ecuación

v1 · v = 0 ≡ a1 x1 + · · · + an xn = 0,

con lo cual S ⊥ es un subespacio vectorial (de dimensión n − 1) que viene dado mediante una ecuación implı́cita

y los coeficientes de dicha ecuación son las coordenadas del vector dirección de S.

Teorema. Dado un subespacio vectorial S de Rn se verifica:

(1) S ⊥ es un subespacio vectorial de Rn .

⊥

(2) S ⊥ = S.

(3) Se verifica la siguiente relación entre S y S ⊥ .

Por tanto, todo vector v de Rn se puede expresar de forma única como suma

(a) S ∩ S ⊥ = {0}.

de un vector de S y un vector de S ⊥ . (Esto será consecuencia del teorema de

⊥

n

(b) S + S = R .

la proyección ortogonal que veremos más adelante).

(5) Si S = Gen {v1 , . . . , vp }, entonces

v ∈ S ⊥ ⇐⇒ v ⊥ v1 , . . . , v ⊥ vp .

Ejemplo. Antes hemos obtenido el complemento ortogonal de un subespacio de Rn de dimensión 1, que era un

subespacio vectorial de dimensión n−1 (estos subespacios se suelen denominar hiperplanos). Las propiedades anteriores

permiten obtener fácilmente el complemento ortogonal de un subespacio, de dimensión n − 1, cuya ecuación implı́cita

es

W ≡ a1 x1 + · · · + an xn = 0.

Como hemos visto antes,

W = S ⊥,

tenemos que W ⊥ = S ⊥

⊥

siendo S = Gen

a1

.. ,

.

an

= S. Es decir, de manera inmediata obtenemos, W ⊥ , en forma paramétrica.

El hecho de expresar el complemento ortogonal de una u otra forma paramétrica/implı́cita dependiendo de como

venga expresado el subespacio vectorial:

S en forma paramétrica

S en forma implı́cita

−→

−→

S ⊥ en forma implı́cita

S ⊥ en forma paramétrica

queda reflejado con el siguiente Teorema.

Teorema. (Los cuatro subespacios asociados a una matriz) Sea A una matriz real m × n. Se verifica:

[Col (A)]⊥ = Nul (AT ),

[Nul (A)]⊥ = Col (AT )

El espacio Col (AT ) se suele denominar espacio fila de la matriz A.

Notemos que en lo que se refiere a las dimensiones de los complementos ortogonales tenemos

⊥

dim [Col (A)]

= dim Nul (AT ) = m − pivotes de AT = m − rango (A) = m − dim (Col (A)) .

Puesto que cualquier subespacio vectorial se puede expresar como el espacio columna de una matriz tenemos que para

cualquier subespacio vectorial S de Rm , se verifica

dim S ⊥ = m − dim (S).

99

3.

Bases ortonormales de un subespacio. Matrices ortogonales.

Proposición. Si {u1 , u2 , . . . , ur } es un conjunto de vectores no-nulos ortogonales dos a dos, entonces son linealmente

independientes.

Demostración.- Si tenemos una combinación lineal de los vectores dados igual al vector nulo

α1 u1 + α2 u2 + · · · + αp up = ~0

(∗)

al multiplicar escalarmente por el vector u1 tenemos

(α1 u1 + α2 u2 + · · · + αp up ) · u1 = ~0 · u1 = 0.

Desarrollando el primer miembro de la igualdad

usando la

α1 u1 · u1 + α2 u2 · u1 + · · · + αp up · u1 = condición de =

ortogonalidad

= α1 ||u1 ||2 + α2 0 + · · · + αp 0 = 0

puesto

que u1 6= 0

=⇒ α1 = 0.

De manera análoga, al multiplicar escalarmente la igualdad (∗) por un vector

uk , k = 1, 2, . . . , p,

se obtiene

α1 0 + α2 0 + · · · + αk ||uk ||2 + · · · + αn 0 = 0 ⇒

puesto

que uk 6= 0

⇒ αk = 0.

Por tanto, la única combinación lineal que es igual al vector nulo es la combinación lineal idénticamente nula (todos los

coeficientes son nulos). Es decir, los vectores dados son linealmente independientes.

2

Proposición. Sea {u1 , u2 , . . . , ur } una base ortogonal de un subespacio S de Rn . Entonces:

u · uk

Las coordenadas de un vector u ∈ S respecto de dicha base vienen dadas por

2 , es decir, se verifica que

||uk ||

u=

u · u1

||u1 ||

2 u1

+ ···+

u · ur

||ur ||

2 ur .

La expresión anterior se suele denominar desarrollo de Fourier de v respecto a la base {u1 , u2 , . . . , ur }.

Antes de pasar a estudiar la proyección ortogonal de un vector sobre un subespacio, vamos a considerar las

propiedades de las matrices cuyas columnas son ortonormales. En particular, vamos a considerar las matrices cuadradas

cuyas columnas son ortonormales. Cuando se tiene un conjunto ortogonal de vectores no-nulos y se normalizan (se

divide cada uno por su norma), obtenemos un conjunto ortonormal de vectores que formarán una base ortonormal del

subespacio vectorial que generan. En términos de computación numérica, las matrices cuyas columnas son ortonormales

juegan un papel importante por ser matrices que transmiten los errores de redondeo de manera controlada.

Proposición. Sea U = [u1 , . . . , un ] una matriz real m × n.

(1) U tiene columnas ortonormales ⇐⇒ U T U = I.

(2) Si U tiene columnas ortonormales, la transformación lineal asociada

U : x ∈ Rn −→ y = U x ∈ Rm

conserva ángulos y distancias, es decir

(a) ||U x|| = ||x|| ,

∀x ∈ Rn .

(b) (U x) · (U y) = x · y,

(c) U x ⊥ U y ⇐⇒ x ⊥ y.

∀x, y ∈ Rn y en particular,

Un caso particularmente importante lo constituyen las matrices cuadradas con columnas ortonormales.

Definición. (Matriz ortogonal) Se denomina matriz ortogonal a toda matriz Q real cuadrada no-singular cuya

inversa coincide con su traspuesta, Q−1 = QT .

100

Proposición. Se verifica:

(1) Si Q es ortogonal =⇒ det(Q) = ±1.

(2) Q es ortogonal ⇐⇒ QT es ortogonal.

(3) Si Q1 y Q2 son ortogonales, entonces Q1 Q2 es ortogonal.

Proposición. Sea Q una matriz real cuadrada n × n. Son equivalentes:

(1) Q es una matriz ortogonal.

(2) Las n columnas de Q son ortonormales (y por tanto forman una base ortonormal de Rn ).

(3) Las n filas de Q son ortonormales (y por tanto forman una base ortonormal de Rn ).

4.

Proyección ortogonal sobre un subespacio. El teorema de la mejor

aproximación.

Si consideramos el subespacio vectorial S, de dimensión uno (una recta), generado por un vector, u1 , no-nulo,

S = Gen {u1 }, la proyección ortogonal de un vector v ∈ Rn sobre S será el vector u = αu1 ∈ S que verifica que

v − u = v − αu1

es ortogonal a S, es decir, tenemos que determinar α con la condición que v − αu1 sea ortogonal a u1 ,

2

(v − αu1 ) · u1 = v · u1 − α ||u1 || = 0 ⇐⇒ α =

v·u1

||u1 ||2

⇒

=⇒ u = proy S (v) =

v·u1

u .

||u1 ||2 1

Para un subespacio de dimensión arbitraria puede darse una expresión de la proyección ortogonal de un vector sobre

dicho subespacio cuando disponemos de una base ortogonal de dicho subespacio. Considerando una base ortonormal

puede darse una expresión cómoda de la matriz de la proyección ortogonal.

Teorema (de la descomposición ortogonal). Sea S un subespacio vectorial de Rn . Dado cualquier vector v ∈

Rn existe un único vector u ∈ S (llamado proyección ortogonal de v sobre S) tal que v − u ∈ S ⊥ . De hecho, si

{u1 , u2 , . . . , ur } es una base ortogonal de S, entonces la proyección ortogonal de v sobre S es

v · u1

u := proy S (v) =

||u1 ||

2 u1

v · ur

+ ···+

||ur ||

2 ur ,

y la proyección ortogonal de v sobre S ⊥ es

w = v − u.

Notemos que:

Cada sumando de la expresión

v · u1

||u1 ||

2 u1

+ ···+

v · ur

||ur ||

2 ur

nos da la proyección ortogonal del vector v sobre el subespacio generado por el correspondiente vector uk .

2

2

El vector u = proy S (v) verifica que ||u|| ≤ ||v|| .

Corolario. (Matriz de una proyección ortogonal) Sea S un subespacio vectorial de Rn .

(a) Si {u1 , u2 , . . . , ur } es una base ortonormal de S, la proyeción ortogonal de un vector v ∈ Rn sobre S es

u := proy S (v) = (v · u1 ) u1 + · · · + (v · ur ) ur .

101

(b) Siendo U una matriz cuyas columnas forman una base ortonormal de S, la matriz de la proyección ortogonal

sobre S es PS = U U T , es decir

proy S (v) = U U T v, ∀v ∈ Rn .

Aunque puedan considerarse distintas matrices U como en el enunciado, la matriz PS = U U T que representa

a la proyección ortogonal, respecto a la base canónica, es única. Las propiedades caracterı́sticas de las matrices de

proyección ortogonal son

2

PS2 = PS ,

U U T = U (U T U )U T = U IU T = U U T ,

T

PS es simétrica, U U T

= (U T )T U T = U U T .

y

Teorema (de la mejor aproximación). Sea S un subespacio vectorial de Rn y consideremos un vector x ∈ Rn y

un vector y ∈ S. Son equivalentes:

(a) y es la proyección ortogonal de x sobre S,

S⊥

es decir,

y ∈ S,

x

x − y ∈ S⊥.

(b) y es la mejor aproximación de x desde S,

es decir,

y ∈ S,

y

O

S

w

||x − y|| ≤ ||x − w||

para todo w ∈ S.

Sea y = proy S (x) y sea w ∈ S. Puesto que

x−w = (x−y)+(y−w),

x−y ∈ S ⊥ , y−w ∈ S,

aplicando el Teorema de Pitágoras tenemos

||x − w||2 = ||x − y||2 + ||y − w||2 ≥ ||x − y||2 .

5.

El método de Gram-Schmidt.

En el Tema 4 hemos visto cómo obtener una base de un subespacio vectorial a partir de un conjunto de vectores

que genera el subespacio vectorial. En los epı́grafes anteriores hemos visto que el cálculo de las coordenadas de un

vector respecto de una base ortogonal es muy simple (desarrollo de Fourier) y que éstas permiten dar la expresión

de la proyección ortogonal sobre el subespacio que generan dichos vectores. El método de ortogonalización de GramSchmidt, que vamos a describir, permite construir de manera progresiva una base ortogonal de un subespacio vectorial

a partir de una base de dicho subespacio e incluso de un conjunto de vectores que genere el subespacio.

Partiendo de una base {v1 , v2 , . . . , vp } de un subespacio S, el método consiste en generar uno a uno vectores que

son ortogonales a los construidos. Denotamos por S1 , S2 , . . . , los subespacios vectoriales definidos por

S1 = Gen {v1 } , S2 = Gen {v1 , v2 } , . . . , Sp = Gen {v1 , v2 , . . . , vp } = S.

El método de Gram-Schmidt consiste en generar los vectores:

u1 = v1 ∈ S1 ,

u2 = v2 − proy S1 (v2 ) ∈ S2 , es decir, u2 es el único vector de la forma u2 = v2 + αu1 que es ortogonal a u1 ,

u3 = v3 − proy S2 (v3 ) ∈ S3 , es decir, u3 es el único vector de la forma u3 = v3 + αu1 + βu2 que es ortogonal a

u1 y a u2 ,

...

Notemos que, puesto que los vectores {v1 , v2 , . . . , vp } son linealmente independientes, necesariamente los subespacios

S1 ⊂ S2 ⊂ · · · ⊂ Sp = S

102

son todos distintos (dim (Sk ) = k, k = 1, 2, . . . , p), los vectores u1 , u2 , . . . , up son todos no-nulos y linealmente independientes y se verifica que

S1 = Gen {v1 }

= Gen {u1 },

S2 = Gen {v1 , v2 }

= Gen {u1 , u2 } ,

S3 = Gen {v1 , v2 , v3 } = Gen {u1 , u2 , v3 } = Gen {u1 , u2 , u3 } ,

..

..

.

.

Sp = Gen {v1 , . . . , vp } = . . .

= Gen {u1 , · · · , up } .

Teorema (Método de ortogonalización de Gram-Schmidt). Consideremos una base {v1 , v2 , . . . , vp } de un

subespacio vectorial S de Rn . Entonces, los siguientes vectores están bien definidos

u1 = v1

u2

= v2 −

u3

= v3 −

v2 · u1

||u1 ||

2

v3 · u1

||u1 ||

2

u1

u1 −

v3 · u2

||u2 ||2

u2

..

.

vp · u1

vp · up−1

up = vp −

2 u1 − · · ·

2 up−1

||u1 ||

||up−1 ||

y son no-nulos y ortogonales dos a dos.

(a) {u1 , u2 , . . . , up } es una base ortogonal de S = Gen {v1 , v2 , . . . , vp }.

(b) Para cada k = 1, . . . , p, {u1 , u2 , . . . , uk } es una base ortogonal de Sk = Gen {v1 , v2 , . . . , vk }.

Observaciones.

(a) Si el objetivo es obtener una base ortonormal de S, una vez que se ha obtenido una base ortogonal basta normalizar

los vectores obtenidos.

(b) En cada paso del método de Gram-Schmidt que acabamos de describir podrı́amos multiplicar (o dividir) el vector

obtenido por un coeficiente no-nulo y seguir los cálculos con dicho vector.

(c) Si el vector vk es combinación lineal de los anteriores, v1 , v2 , ..., vk−1 , al aplicar el método de Gram-Schmidt

obtenemos uk = 0. Es decir, el método de Gram-Schmidt devuelve el vector nulo cuando se aplica a un conjunto

de vectores linealmente dependientes.

Ejercicio resuelto

Consideremos la matriz

1

0

A=

1

0

0

1

0

1

b a

a b

,

b a

a b

a, b ∈ R.

Si a = 0 y b = 1, la matriz B = 21 A es la matriz de la proyección ortogonal sobre un cierto subespacio S ⊂ R4 .

(a) Encontrar una base ortonormal del subespacio S.

(b) Calcular la proyección ortogonal del vector (1, 1, 1, 1)T sobre S ⊥ .

Si a = 0 y b = 1 la matriz B es

1

1

1

0

B= A=

2

2 1

0

0

1

0

1

1

0

1

0

0

1

.

0

1

(a) Nos dicen que B es la matriz PS de la proyección ortogonal sobre un cierto subespacio S ⊂ R4 , es decir, que la

proyección ortogonal de cualquier vector x ∈ R4 sobre S es Bx. Los vectores v que pertenecen a S son aquéllos que

coinciden con su proyección ortogonal sobre S, es decir, los que verifican Bv = v. Resolviendo este sistema

v1

v1

v1

0

1 0 1 0

−1 0

1

0

1

v1 − v3 = 0,

1

v2 = 0 →

0 1 0 1 v2 = v2 → 1 0 −1 0

v2 − v4 = 0,

0 −1 0 v3 0

2 1 0 1 0 v3 v3

2 1

v4

v4

v4

0

0 1 0 1

0

1

0 −1

103

obtenemos

1

0

v = α

1 +β

0

0

1

0

1

, α, β ∈ R → S = Gen u1 =

1

0

1

0

Como la base encontrada ya es ortogonal (u1 · u2 = 0),

una base ortonormal de S:

1