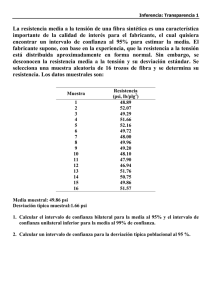

INTRODUCCIÓN A LA ESTADÍSTICA

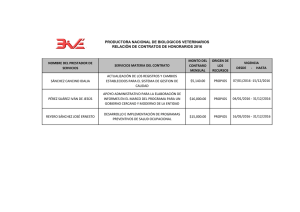

Anuncio