Formación de imágenes - ELAI-UPM

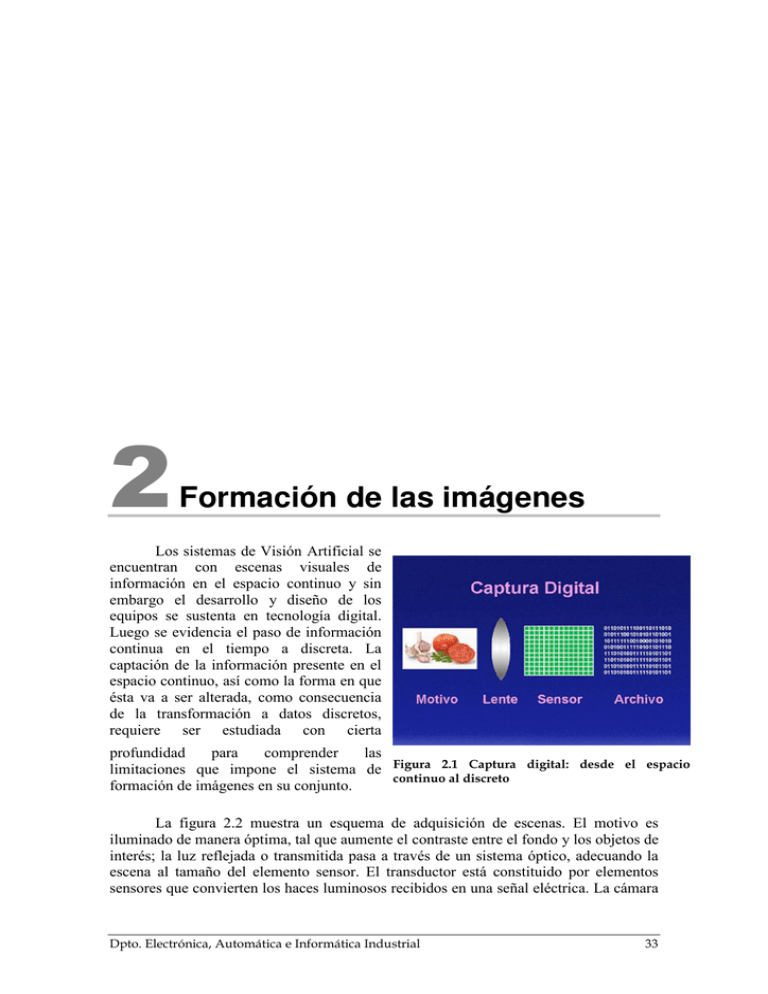

Anuncio