La física al extremo en experimentos de gran ciencia: Buscando

Anuncio

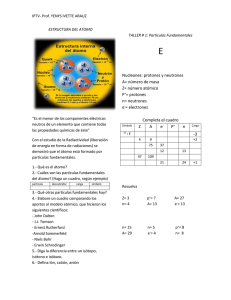

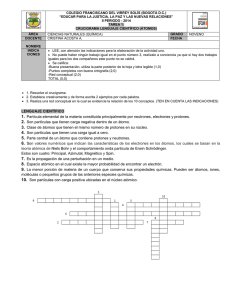

La física al extremo en experimentos de gran ciencia: Buscando antimateria en el universo. Arturo Menchaca Hoy en día la estructura de los átomos se comprende a partir de suponer que estos están compuestos de electrones y núcleos. Los segundos resultan ser conjuntos de protones y neutrones, mismos que en la escala más elemental están constituidos por quarks. Así, el modelo que explica la fenomenología de lo más elemental, llamado estándar (Fig. 1), considera que la materia está compuesta de quarks y de leptones, partículas no-nucleares que incluyen al electrón y a los elusivos neutrinos. Por cierto, a las partículas compuestas por quarks se les denomina hadrones. Fig. 1: Modelo Estándar Existen 6 tipos (o sabores) de quarks (up, down, charmed, strange, top y bottom), denotados en la Fig. 1 por sus iniciales (cubos color de rosa). Los leptones (cubos verdes) también son 6, tres de ellos con carga eléctrica (electrón, muón y tauón) y tres neutrinos, cada uno asociando a un leptón cargado. Quarks y leptones interaccionan entre ellos intercambiando bosones de norma, que son emisarios cuantizados de 3 fuerzas fundamentales: la electromagnética (transmitida por el fotón γ), la fuerte (transmitida por el gluón g) y la débil (transmitida por los bosones intermedios W+- y Zo). En esta escala, la influencia de la gravitación (cuarta fuerza fundamental en la naturaleza) es despreciable. El modelo estándar asocia a las partículas elementales otras propiedades, como la ya mencionada carga eléctrica y, en el caso de los quarks, el color. Otro ingrediente importante del modelo estándar fue descubierto hace 84 años por el físico inglés Paul Dirac, quien logró una formulación para el comportamiento del electrón en que se mezcló la entonces recién descubierta mecánica cuántica con la relatividad de Einstein. Una predicción de la teoría de Dirac que de inmediato llamó la atención de los especialistas fue la existencia de la antimateria. Este resultado sorprendente implicó que las 12 partículas elementales de la figura 1 se presentan por pares (ver Fig. 2), cuyas propiedades son idénticas, salvo una, que es el signo de la carga eléctrica, para las no-neutras. Fig. 2: Partículas y anti-partículas La teoría de Dirac también predice que la unión (aniquilación) de una partícula con su “antipartícula” produce energía. Inversamente, también resulta que partículas o fotones de muy alta energía, al interaccionar con la materia producen pares partícula-antipartícula (Fig. 3). Fig. 3: Aniquilación y creación Estos conceptos han permitido comprender como, a través del intercambio de los emisarios de las diversas fuerzas, los quarks se unen para formar los protones y neutrones que integran a los núcleos, y estos últimos se unen con los electrones para formar átomos, que a su vez se juntan para formar moléculas, y así sucesivamente hasta constituir toda la materia que nos rodea. Sin embargo, las fuerzas dominantes a nivel nuclear (la fuerte y la débil) sólo extienden su influencia a distancias tan cortas que ya a nivel atómico resultan imperceptibles, mientras que en el nivel macroscópico la materia tiende a ser eléctricamente neutra, por lo que en la escala macroscópica la fuerza electromagnética juega un rol insignificante, comparado con la gravitación. Es por esto que basta con esta última para poder explicar el movimiento de las rocas, los aviones, la Luna, de nuestro planeta y de los otros que forman del sistema solar, el de este último en la vía láctea, y así hasta considerar al universo en general. Una tema relacionado es la cosmología, que trata de explicar el origen y la evolución del universo con base en observables astronómicas, así como en los conocimientos de física que hemos podido deducir en experimentos en la Tierra. Así, de comparar la luz que nos llega de las estrellas con la que emiten los cuerpos incandescentes en laboratorios terrestres se ha establecido que la materia de que están hechos los astros más lejanos es la misma que encontramos en nuestro planeta. También, se ha logrando entender una buena parte de la mecánica celeste con base en las mismas fuerzas que conocemos en la Tierra. En este proceso de inferencia científica, los cosmólogos han concluido que el Universo se encuentra en una expansión acelerada que es consecuencia de una gran explosión ocurrida hace 14 mil millones de años. En los primeros instantes de este enigmático evento primordial (zona amarilla en la Fig. 4) la materia formaría un estado de alta densidad y temperatura en que los constituyentes más elementales del modelo estándar (los quarks, los leptones y los bosones de norma) debieron encontrarse completamente desvinculados, formando una verdadera sopa. Sin embargo, cuando el Universo tenía menos de un segundo de edad se formarían los hadrones, luego los núcleos (3 min), luego los átomos (300,000 años), las primeras galaxias (mil millones de años después) y así hasta llegar al universo de hoy. Fig. 4: Evolución del Universo De esta manera, resulta que para poder comprender lo que ocurría en esos instantes, cosmólogos y astrofísicos (quienes estudian lo más grande) se unen con quien se encarga de lo más pequeño, los físicos de partículas, para poder entender el origen del universo. Sin embargo, este matrimonio entre los físicos de lo más grande y los de lo más pequeño tiene sus desavenencias, y resolver una de ellas es el tema de esta presentación. El problema se relaciona con una simetría implícita en la teoría de Dirac en el sentido de que las partículas y sus antipartículas se crean y se aniquilan siempre por pares. Esta predicción, que se cumple en todos los experimentos realizados hasta ahora en laboratorios terrestres, implica que en el Big-Bang la enorme energía inicial debió dar como resultado cantidades iguales de materia y de antimateria. Sin embargo, todo parece indicar que, para suerte nuestra, en la época actual el universo está compuesto principalmente por materia. La pregunta natural es, entonces, ¿qué pasó con la antimateria? Los modelos propuestos para responder a esta incógnita coinciden en sugerir que la simetría materia-antimateria se viola, pero de una manera tan imperceptible, que hasta ahora no se ha podido identificar en el laboratorio. Así, se propone que en el Big-Bang la casi totalidad de las partículas de materia y de antimateria se aniquilaron, sobreviviendo sólo una cantidad pequeña de materia, que hoy constituye el universo que observamos. Lo que no sabemos aún es cómo es que esa materia sobrevivió a esta catástrofe. Otra posibilidad es que la simetría materia-antimateria sea estrictamente válida, pero que durante el Big-Bang se dieron pequeñas inhomogeneidades espaciales en que ya sea la materia, o la antimateria, resultaron dominantes localmente. Así, en la expansión, estas zonas se separaron, aniquilándose toda la materia y la antimateria intermedia. En ese caso, al igual que la materia, la antimateria debió formar el mismo tipo de estructuras que hoy observamos en el universo, con (Anti-) estrellas y (anti-) galaxias. De ser así, hoy en día sería difícil deducir a partir de observaciones astronómicas si algún objeto celeste visto desde la Tierra está hecho de materia o de antimateria, pues la luz emitida en ambos casos sería idéntica. Sin embargo, además de luz, a lo largo de su vida las estrellas también emiten un poco de las partículas de las que están compuestas. Esas partículas, que incluyen núcleos atómicos, viajan por el universo y constituyen los que se conoce como la radiación cósmica. Así, bastaría con estudiar estas partículas y (en caso de haber anti-estrellas) antipartículas que llegan a la Tierra con gran energía, luego de su viaje sideral. Naturalmente, la búsqueda de esta antimateria debería realizarse más allá de la atmósfera terrestre, ya que al interaccionar con ella las antipartículas se aniquilarían. Más adelante describiremos ese experimento, pero antes se deben agregar un par de ingredientes conceptuales relevantes. El primero de ellos es entender cómo se forman los núcleos (y los anti-núcleos). El descubrimiento del neutrón, por Chardwick en 1932, logró explicar porqué el comportamiento químico de los átomos sólo depende del número de protones, conocido como número atómico, Z, sin que importe el número de neutrones, N, que tiene su núcleo. Así, apareció el concepto de isótopo, que son elementos químicos que ocupan el mismo lugar en la Tabla Periódica (que los clasifica según su Z) pero que pueden tener diferente N. Cabe agregar aquí que a los físicos nucleares les gusta caracterizar a los isótopos por su Z y su número másico A, que es la suma de N más Z. Implícito en este concepto está el hecho de que los neutrones y los protones resultan ser partículas muy similares, salvo por su carga eléctrica y una pequeña diferencia de masa, siendo el neutrón ligeramente más pesado que el protón. Esto permite hablar de nucleones, cuando uno se quiere referir indistintamente a neutrones o a protones. El otro ingrediente importante para la argumentación aquí, es que los núcleos estables muestran una tendencia a tener N = Z, regla que se viola ligeramente para núcleos con A grande. La fuerza que mantiene unidos a los núcleos es la misma que une a los quarks, sólo que a la escala de protones y neutrones se manifiesta por el intercambio de mesones (pares quark-antiquark). La imagen de un núcleo compuesto por protones y neutrones unidos por la fuerza fuerte deja sin explicar un fenómeno conocido como la desintegración beta, en que el núcleo de un elemento químico se transforma en el núcleo de un elemento vecino en la tabla periódica (es decir con diferente Z), emitiendo electrones y anti-neutrinos (o sus anti-partículas), que es una manifestación de la interacción débil. Por cierto, debido a su mayor masa, los neutrones libres resultan ser inestables ante el decaimiento beta, con una vida media aproximada de 10 minutos, al cabo de los cuales, decaen en protones, electrones y antineutrinos (electrónicos). Curiosamente, una vez unidos a los protones para formar núcleos estables, la energía que une al sistema nuclear evita que los neutrones internos decaigan. En el Universo existe un centenar de elementos químicos conocidos, siendo el hidrógeno (~90%) y el helio (~9%), por mucho, los más abundantes. La física nuclear nos enseña que la estabilidad de los núcleos depende del equilibrio entre la fuerza fuerte (atractiva) que actúa entre los protones y los neutrones por igual, y la fuerza eléctrica (repulsiva) que actúa sólo entre los protones. En los núcleos ligeros (con pocos protones) la repulsión eléctrica es pequeña, de manera que la atracción nuclear aumenta al aumentar el número A. Así, un núcleo con A < 60, tiene menor masa que la suma de sus A constituyentes (libres). Dicho de otra manera, para desintegrar a uno de esos núcleos, es necesario invertir una energía que, dividida por la velocidad de la luz al cuadrado (m=E/c2), llega a ser del orden de 1% de la masa del sistema. Inversamente, si uno pudiera unir (fundir) esos A constituyentes, se recupera esa misma energía, que se conoce como de fusión nuclear (Fig. 5, lado derecho). Este es el mecanismo que genera la energía del Sol y de las estrellas, y al cual debemos que haya vida en la Tierra, por cierto. Comparada con la fusión nuclear, la energía química (que surge de unir moléculas) es un millón de veces más pequeña. Sin embargo, la ganancia de energía por fusión nuclear cesa de existir para núcleos con A > 60, punto en que la repulsión acumulada entre los protones hace que la energía específica (dividida por A) que une a los núcleos más pesados decrezca al aumentar A, en lugar de crecer. Es por esta razón que los núcleos con A grande tienden a tener más neutrones que protones, y que el número A esté limitado a valores inferiores a ~240. Así, resulta que la energía necesaria para arrancar a un nucleón (protón o neutrón) de un núcleo pesado (A > 200) es menor que la correspondiente para núcleos con A ~ 100. Esto implica que al romper en dos (fisionar) un núcleo pesado, se gana una energía que se conoce como de fisión (Fig. 5 lado izquierdo). Fig. 5: Reacciones nucleares Un grupo de investigadores del IFUNAM, que incluyen a Rubén Alfaro, Ernesto Belmont, Varlen Grabski, Arnulfo Martínez, el autor de esta nota, Andrés Sandoval y los alumnos Miguel Villoro, Roberto Núñez y Jorge Baylón, se unieron a una colaboración internacional dedicada a resolver este problema. El proyecto, denominado AMS (Alpha Magnetic Spectrometer, Fig. 6), consistió en construir un instrumento que distingue las partículas de las antipartículas, y que (luego de casi 10 años de trabajo) fue instalado en la Estación Espacial Internacional (EEI) en mayo de 2011. La construcción del AMS, fue propuesta por Samuel Ting, Investigador del MIT y Premio Nóbel (1976), y con él trabajan investigadores de varios países del mundo. El aparato se llama así por estar asociado a la EEI, que es conocida por los norteamericanos como Estación Alfa, y porque el principal instrumento que lo constituye es un imán que permite medir la masa, la carga (y su signo) de las partículas que lo cruzan, constituyendo lo que los físicos conocen como un Espectrómetro de Masas. Una componente importante de este instrumento es un tipo de detector de partículas, denominado de Cherenkov por reconstrucción de anillos (RICH, en inglés). Éste sirve para medir la velocidad de las partículas, a partir de la una radiación luminosa que se produce cuando las partículas que lo cruzan viajan a velocidades cercanas a la de la luz. En particular, los investigadores del IFUNAM trabajaron en la caracterización óptica del material mismo en que se produce la luz de Cherenkov, denominado "radiador”. Fig. 6: El detector AMS El mismo grupo de investigadores del IFUNAM, también está analizando los datos que se generan en el detector ALICE del Gran Colisionador de Hadrones (LHC) del CERN, que tiene la capacidad de reproducir condiciones que debieron darse durante los primeros instantes del Big-Bang. Concretamente, estudian el mecanismo de producción de núcleos y antinúcleos, con el propósito de buscar relaciones entre el inicio del universo y lo que ocurre en interacciones entre pares de protones, así como entre pares de núcleos de plomo, que colisionan a las más altas energías logradas hasta ahora en el mundo. Por cierto, la producción de núcleos y anti-núcleos se ha sido observada a energías inferiores al LHC, siendo interpretada como resultado de un mecanismo denominado de “coalescencia”. Para explicarlo, recurriré a una escena que fue noticia hace un año: Barack Obama cazando moscas en la Casa Blanca (Fig. 7). Fig. 7 Obama y la coalescencia Sobre este hecho inusitado podemos hacer algunas deducciones interesantes. La más simple es que la probabilidad de que Obama cace una mosca es proporcional a la densidad de moscas que hay en su residencia. También es fácil de ver que la probabilidad de cazar dos moscas de un solo manotazo debe ser proporcional al cuadrado de la probabilidad de que cace una. Cabe recordar que las probabilidades son números inferiores a uno, de manera que al elevarlos al cuadrado se obtiene un número más pequeño. Algo parecido ocurre con la formación de los núcleos más simples, los deuterones (isótopo del hidrógeno que tiene un protón y un neutrón en su núcleo), cuando se tiene un gas en expansión hecho de protones y neutrones. En ese caso, la probabilidad de que esos nucleones se encuentren dentro de un volumen lo suficientemente pequeño como para garantizar que se fusionen, formando un deuterio, depende del producto de las probabilidades de encontrar a cada uno de ellos, individualmente dentro de ese volumen (que, en el caso de las moscas de la Casa Blanca sería el tamaño de la mano de Obama). A ese mecanismo de fusión nuclear estadística se le conoce como coalescencia. El factor de proporcionalidad que relaciona las densidades antes mencionadas se le llama parámetro de coalescencia, y es lo que están tratando de medir los investigadores de la UNAM en el detector ALICE del Large Hadron Collider (LHC) del CERN para el deuterón, y para el anti-deuterón. Cabe preguntarse, ¿de dónde sale el gas en expansión que tiene protones y neutrones? La respuesta es que es el residuo que queda cuando la sopa de quarks se enfría y ocurre un fenómeno llamado hadronización, mismo que debió ocurrir en las primeras fracciones de segundo del BigBang (ver Fig. 4), y que se espera ocurra en las colisiones del LHC. La siguiente figura (8) nos permite ilustrar mejor este punto. Fig. 8 Hadronización Aquí, el título del eje horizontal densidad bariónica se refiere, en lo que a nosotros respecta, a la densidad de nucleones, y está normalizada a la que tienen los núcleos estables. En el eje vertical tenemos la temperatura de ese gas de nucleones, medida en millones de electrón-Voltios, unidad de energía que es apropiada en esta física y que equivale a diez mil millones de grados Kelvin. Las colisiones nucleares que ocurren en el LHC permiten aumentar la temperatura y la densidad de los núcleos que chocan, como lo indica la trayectoria etiquetada RHIC LHC. El Relativistic Heavy-Ion Collider (RHIC) es el acelerador que antecede en energía al LHC. Este diagrama termodinámico muestra como la materia caliente y/o densa, sufre esa transición que llamamos de hadronización a una temperatura T=~150 MeV, por encima de la cual la materia nuclear se transforma en la famosa sopa de cuarks (zona anaranjada de la figura 8). Lo que es relevante aquí es la trayectoria etiquetada “Early Universe”, en que la materia inicial del Universo experimenta esa transición en el sentido inverso. Naturalmente, la trayectoria RHIC-LHC está incompleta, pues la materia que ahí se forma también se tiene que enfriar. La pregunta entonces es ¿se puede aprender algo sobre el Big-Bang en el LHC? La Figura 9 ayuda a entender la situación. Estos cálculos fueron hechos (en colaboración con Eulogio Serradilla, actualmente alumno de doctorado) utilizando un modelo llamado núcleo-síntesis del Big-Bang (BBNS). La figura representa la evolución de las abundancias relativas de los isótopos de los elementos más ligeros a medida que se enfría el Big-Bang. Tratándose de una explosión, la temperatura disminuye mientras aumenta el tiempo, es decir, de izquierda a derecha. Nótese que se trata de una grafica logarítmica y que las curvas de colores representan abundancias relativas de diversas partículas. El extremo izquierdo de la gráfica inicia a una temperatura de 150 MeV, justo después de la hadronización, es decir, cuando ya no quedan quarks, como en la zona blanca de la Fig. 8, o la zona amarilla de la figura 4. En ese momento, lo que más abunda son los protones (curva azul) y los neutrones (curva verde), mientras los deuterones (curva amarilla) son mil millones de veces menos abundantes. Ahí mismo los isótopos con A=3 del hidrógeno y del helio (curvas naranja y roja), que traslapan, son es diez mil veces menos abundantes aún que los deuterones. A esta temperatura el resto de los núcleos ni siquiera aparecen en la escala. Cabe preguntarse, ¿por qué hay deuterones?, peor aún, por que inicialmente se reduce su abundancia, en lugar de aumentar, al disminuir la temperatura. Para entender esto hay que recordar que de izquierda a derecha también disminuye la densidad. En este gas super caliente, de vez en cuando se encuentran un neutrón un protón, y se fusionan para formar un deuterón, pero este sólo sobrevive un instante, pues las otras partículas del gas lo golpean, rompiéndolo fácilmente. Así, como ocurre con las moscas en la Casa Blanca, si la densidad baja, la probabilidad de que se forme un deuterón (aunque sea por un instante), también disminuye. Cualitativamente, lo mismo ocurre con los núcleos que tienen A= 3, aunque con mucho menor probabilidad, pues se requiere que se fusionen 3 nucleones. Sin embargo, a medida que baja la temperatura llega un momento en que la temperatura del gas es tan baja, que el golpeteo de las partículas deja de ser eficaz para romper a los núcleos que se forman. En esas condiciones, la abundancia de todos los isótopos crece rápidamente, pasa por un máximo y luego se estabiliza. A partir de ese momento, sólo se volverán a sintetizar núcleos hasta que se formen las estrellas, mil millones de años después. Fig. 9 Núcleo-Síntesis del Big-Bang Esta hermosa teoría predice a grandes rasgos las abundancias relativas de hidrógeno (protones), deuterones, helios 4 y litios 7, que se observa en las regiones más alejadas del Universo. Sin embargo, el grupo Mexicano que trabaja en ALICE ha observado recientemente que la producción de deuterones que se observa en la hadronización que ocurre en el LHC es casi un millón de veces mayor a lo que predice BBNS (cruce de la curva amarilla con el eje vertical en la Fig. 9). Esta enorme diferencia puede indicar que BBNS no es extrapolable a tan alta temperatura. También puede pasar que la hadronización que ocurre en el LHC en una escala de tiempo mucho más corta que el Big-Bang, no sea comparable directamente con BBNS. Al momento de hacer esta presentación, tal controversia no ha sido resuelta. La producción de núcleos y anti-núcleos en el LHC también tendrán un impacto en el proyecto AMS, pues la coalescencia es un mecanismo que debe ocurrir en colisiones de rayos cósmicos de alta energía y, por lo tanto, representan un fondo para la búsqueda de anti-núcleos cósmicos. En concusión, en esta presentación se han querido dar ejemplos del tipo de estudios fundamentales que científicos mexicanos están realizando como miembros de grandes colaboraciones internacionales, como es ALICE y AMS. Cabe reconocer que esa labor sería imposible sin el apoyo de instituciones como la UNAM y el CONACYT. Para saber más: www.ams02.org aliceweb.cern.ch