REGLA DE KOHONEN (Matlab, Neural

Anuncio

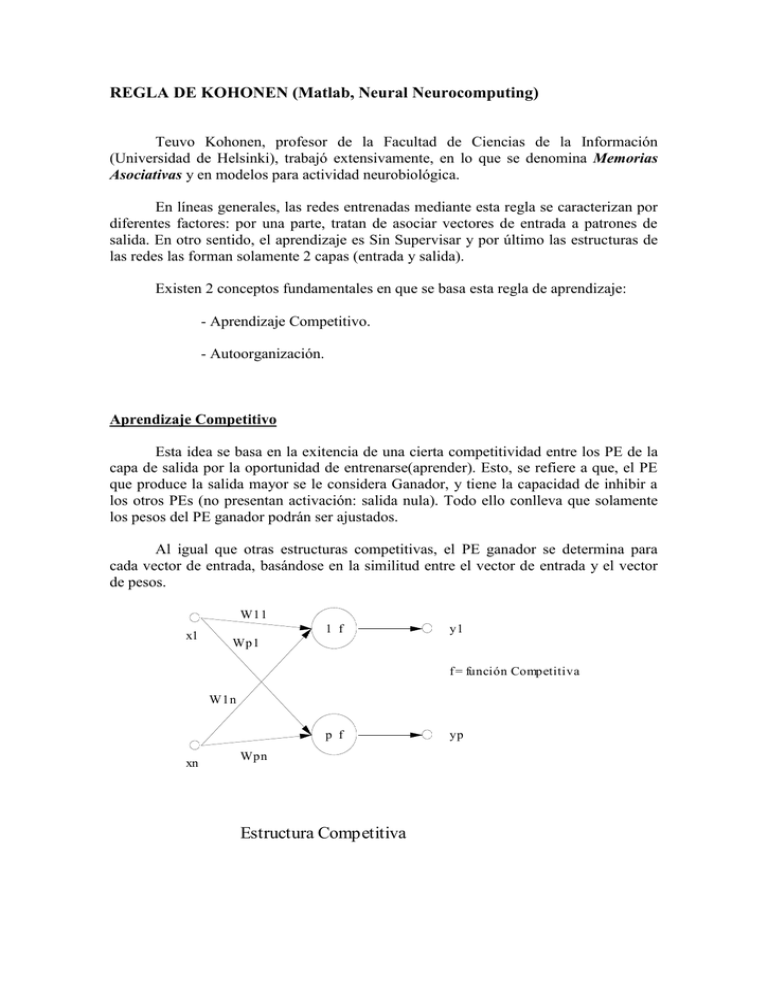

REGLA DE KOHONEN (Matlab, Neural Neurocomputing) Teuvo Kohonen, profesor de la Facultad de Ciencias de la Información (Universidad de Helsinki), trabajó extensivamente, en lo que se denomina Memorias Asociativas y en modelos para actividad neurobiológica. En líneas generales, las redes entrenadas mediante esta regla se caracterizan por diferentes factores: por una parte, tratan de asociar vectores de entrada a patrones de salida. En otro sentido, el aprendizaje es Sin Supervisar y por último las estructuras de las redes las forman solamente 2 capas (entrada y salida). Existen 2 conceptos fundamentales en que se basa esta regla de aprendizaje: - Aprendizaje Competitivo. - Autoorganización. Aprendizaje Competitivo Esta idea se basa en la exitencia de una cierta competitividad entre los PE de la capa de salida por la oportunidad de entrenarse(aprender). Esto, se refiere a que, el PE que produce la salida mayor se le considera Ganador, y tiene la capacidad de inhibir a los otros PEs (no presentan activación: salida nula). Todo ello conlleva que solamente los pesos del PE ganador podrán ser ajustados. Al igual que otras estructuras competitivas, el PE ganador se determina para cada vector de entrada, basándose en la similitud entre el vector de entrada y el vector de pesos. W11 x1 1 f y1 Wp1 f = función Competitiva W1n p f xn Wpn Estructura Competitiva yp Se determina la similitud entre los PE y el vector de entrada mediante la formula: n d j ( xi(t ) w ji(t )) 2 i 1 Una vez que se determina cual es el PE ganador (supongamos "k") se aplica la función de transferencia de tipo competitiva: yj 0 j k yj 1 jk Una vez seleccionado el PE ganador se modifican sus pesos mediante la siguiente regla: wki (t 1) wki (t ) (t )( xi (t ) wki (t )) En estos casos, la velocidad de aprendizaje, suele ser dependiente del tiempo y nomalmente decrece en cada paso. Características - La velocidad de aprendizaje suele disminuir con el tiempo, hasta que toma un valor próximo a 0 en cuyo caso el aprendizaje finaliza. - La utilidad de sistemas que utilizan para su entrenamiento este tipo de regla, está en tratar de asociar cada PE de la capa de salida a un grupo de vectores de entrada, con una cierta similitud, generando de tal manera clases o clusters. Si existen más PE en la capa de salida que clases de patrones de entrada, pueden suceder dos cosas: la primera es que queden PE inactivos, es decir sin asociar a ninguna clase y por otro lado, que una clase tenga asociados más de un PE. - Normalmente los patrones de entrada se Normalizan antes de entrar al sistema, la razón es la siguiente: El PE ganador se determina calculando una medida de similaridad entre el patrón de entrada y los vectores de pesos. Dicha similaridad se calcula empleando, normalmente, la Distancia Euclídea y ésta no sólo compara magnitudes entre vectores sino, también la orientación espacial. En otras palabras, dos vectores son similares si apuntan en la misma dirección y la única manera que tenemos para asegurar este hecho es haciendo que los patrones estén normalizados, implicando que los pesos también lo estén. Por otra parte supone incrementar la velocidad de aprendizaje ya que, existe menos variabilidad en el espacio de pesos. Por ejemplo:(1,1,1,1);(4,4,4,4) son idéntidos. Al normalizarlos nos quedan: (1/2,1/2,1/2,1/2). La normalización se debe realizar en función de lo que nos interese comparar. -Una Limitación de las redes competitivas es que algunas neuronas pueden no ser entrenadas. En otras palabras, pueden existir vectores de pesos muy distanciados de las entradas, con lo cual, nunca ganarán. Importantísimo en estos sistemas es la inicialización de pesos.