fundamentos teóricos del procesamiento de imágenes y clasificacion

Anuncio

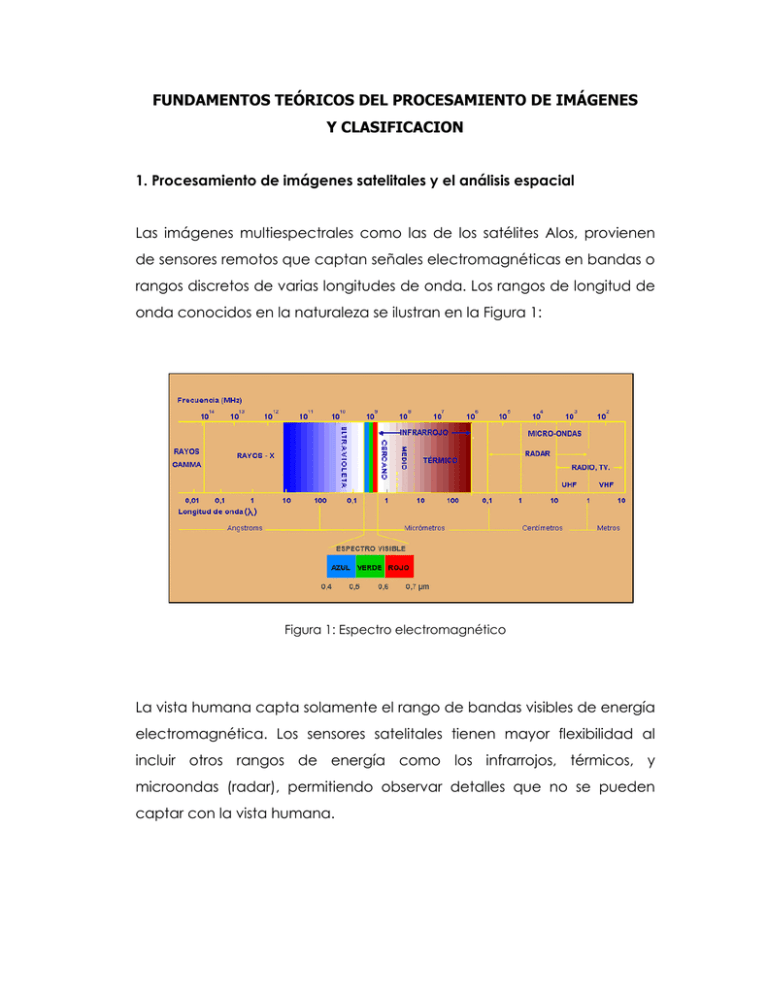

FUNDAMENTOS TEÓRICOS DEL PROCESAMIENTO DE IMÁGENES Y CLASIFICACION 1. Procesamiento de imágenes satelitales y el análisis espacial Las imágenes multiespectrales como las de los satélites Alos, provienen de sensores remotos que captan señales electromagnéticas en bandas o rangos discretos de varias longitudes de onda. Los rangos de longitud de onda conocidos en la naturaleza se ilustran en la Figura 1: Figura 1: Espectro electromagnético La vista humana capta solamente el rango de bandas visibles de energía electromagnética. Los sensores satelitales tienen mayor flexibilidad al incluir otros rangos de energía como los infrarrojos, térmicos, y microondas (radar), permitiendo observar detalles que no se pueden captar con la vista humana. La Figura 2 muestra reflectancias características de ciertos materiales típicos en función de la longitud de onda. Figura 2. Reflectancia típica de distintos materiales 1.1. Correcciones de imágenes Las operaciones básicas de teledetección pueden incluir procesos de visualización y realce de las imágenes. Operaciones más avanzadas involucran procesos de correcciones geométricas, radiométricas y clasificación digital. Las correcciones radiométricas y geométricas de la imagen se hacen con el propósito de preparar los datos para realizar estudios precisos. Los estudios de análisis multi-temporal por ejemplo, requieren alta precisión en la corrección geométrica de la imagen. Las fuentes de error más comunes en la calidad espectral de la imagen son las originadas por el movimiento de la plataforma del satélite que genera cambios en la escala y la descalibración del sensor. Estos son corregidos generalmente en la estación receptora de las señales del satélite. 1.2. Correcciones radiométricas Las correcciones radiométricas modifican los ND originales con el objetivo de acercarlos a una recepción ideal. Generalmente comprenden la restauración de líneas o píxeles perdidos, corrección del bandeado de la imagen (“banding”) y las correcciones de distorsiones causadas por la interacción entre las ondas electromagnéticas y los gases y partículas atmosféricas en suspensión. Estas correcciones atmosféricas no se aplican a imágenes de radar debido a que la atmósfera es transparente a las microondas. 1.3. Correcciones geométricas Las correcciones geométricas en la imagen se hacen con el propósito de orientar la posición de los píxeles a un sistema de referencia. El proceso comprende tres pasos: 1. La localización de puntos de control (GCP) que relacionan los valores de coordenadas a un sistema de referencia. 2. La transformación de las coordenadas de la imagen a algún tipo de coordenada cartográfica (UTM, Latitud-Longitud, etc.), para lo cual se utiliza un modelo matemático de mapeo de las coordenadas de la imagen al sistema de referencia. 3. El remuestreo o reubicación de los píxeles a una nueva posición y asignación del nuevo valor de ND de acuerdo al método de asignación seleccionado (vecino más cercano, bilineal, cúbico). En el caso de que hagamos una corrección del desplazamiento debido al relieve, además de las anteriores correcciones geométricas, tendríamos que tomar en cuenta la elevación del punto, denominada una ortorectificación de la imagen, cuyo producto es una ortoimagen de nuestra zona de interés. 1.4. Mosaicos de imágenes de satélite "Mosaic images", es el proceso de unir imágenes previamente georeferenciadas con los mismos parámetros para formar una imagen más grande (las imágenes tienen una zona en común que permite asociarlas). Para ello deben cumplirse ciertos requisitos: 1. Cada imagen debe estar georeferenciada usando la misma proyección del mapa. 2. Deben tener la misma resolución 2. Clasificación de imágenes 5.5.1. Análisis visual de las imágenes de satélite Si definimos el tono como la percepción diferencial por parte del ojo de los distintos rangos de energía del espectro visible, entonces cada uno de los tonos ó colores básicos puede considerarse como una dimensión de la imagen. El tono es un elemento básico en la interpretación visual de las imágenes ya que, aporta una gran cantidad de información. Los programas actuales de visualización y procesamiento permiten generar imágenes en color compuesto, es decir, la aplicación de un color primario (rojo, verde, azul) a cada banda de la imagen. Si la correspondencia es la natural, la impresión final será parecida a la que percibiría el ojo humano actuando como un sensor. Esto supone aplicar cada color a la banda del sensor que capta aproximadamente el mismo rango de energía que el ojo. El análisis visual se utiliza para la identificación y disposición de los elementos presentes en la imagen y el reconocimiento de formas sobre la base de la experiencia de campo previo. 2.2. Clasificación de imágenes de satélite con eCognition La clasificación se realiza en base a objetos y no a píxeles. Al estar la imagen formada por píxeles, el primer paso en el análisis orientado a objetos es agrupar los píxeles adyacentes mediante técnicas de regiones crecientes, para posteriormente clasificar los objetos extraídos. Con ello el número de parámetros que se pueden valorar aumenta notablemente, permitiendo considerar criterios como el tamaño, la forma, medias de color, máximos y mínimos, proximidad a otros objetos, textura, etc. Al mismo tiempo, la segmentación reduce el número de objetos a clasificar, con lo que el tiempo de procesado también disminuye. En eCognition los píxeles son agrupados en polígonos cuando sus valores en los diferentes productos empleados son semejantes. El grado de similitud varia con la máxima heterogenidad permitida para un objeto en la imagen, definida por el parámetro scale factor. Además se incluye el criterio de homogeneidad que considera el parámetro Compactness que es usado para optimizar el objeto en la imágen en relación la compactación en conjunto, y el Shape que ayuda a evitar la alta fragmantación del objeto imágen. 3. Índice de Vegetación Diferencial Normalizado - NDVI El análisis de la vegetación y la detección de los cambios en los patrones de vegetación son claves para la evaluación y el monitoreo de recursos naturales. De aquí que la detección y la evaluación cuantitativa de la vegetación es una de las aplicaciones principales de la percepción remota para el manejo de recursos ambientales y la toma de decisiones, usando imágenes multiespectrales. Las diversas capas de la vegetación interactúan con la energía solar en las regiones de la banda visible y del infrarrojo cercano del espectro electromagnético. En las regiones visibles, los pigmentos de las plantas (más notablemente la clorofila) causan una fuerte absorción de energía, principalmente para la realización de la fotosíntesis. Los picos de absorción en la mayoría de las hojas están en las áreas del rojo y del azul del espectro visible. En el infrarrojo cercano, en cambio, ocurre una interacción muy diferente. En esta región, la energía no es utilizada para la fotosíntesis, sino que es en gran medida dispersada por la estructura interna de la mayoría de las hojas, conduciendo a una reflectancia alta en la zona del infrarrojo cercano. Es este fuerte contraste entonces, más particularmente entre la cantidad de energía reflejada en las regiones roja e infrarroja cercana del espectro electromagnético, el tema que ha ocupado el foco de atención de una gran variedad de intentos para desarrollar índices cuantitativos de la condición de la vegetación usando imágenes de sensores remotos. El índice de vegetación diferencia normalizada, (NDVI), es una variable que permite estimar el desarrollo de una vegetación sobre la base de la medición, con sensores remotos, de la intensidad de la radiación de ciertas bandas del espectro electromagnético que la misma emite o refleja. El NDVI oscila en un rango de valores de –1 a +1 (para nuestro caso de estudio lo hemos multiplicado por 10,000 para facilitar el análisis). Las mayores concentraciones de biomasa fotosintéticamente activa presentan valores próximos a 1. Los valores negativos de –1 a 0 son elementos de suelos, cuerpos de agua, y nubes. Este es el índice más comúnmente usado porque retiene la habilidad para minimizar los efectos topográficos y a su vez producir una escala de medida lineal. Además, los errores de división por cero son reducidos en gran medida. Dentro del rango de 0 a 1 tendremos diferentes grados de vigorosidad vegetal así como diferentes grados de cobertura de la superficie. El NDVI se calcula: . NDVI = (Banda Infrarroja cercana – Banda roja visible) (Banda Infrarroja cercana + Banda roja visible)