Didáctica de la Estadística

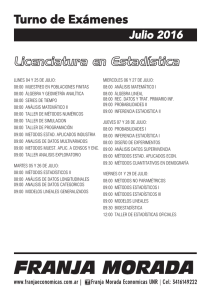

Anuncio