Evaluación de un Programa de Capacitación Profesional

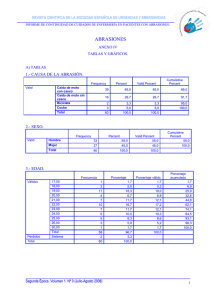

Anuncio