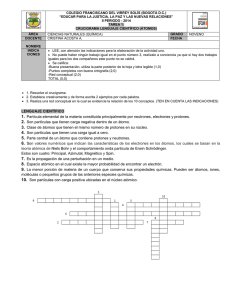

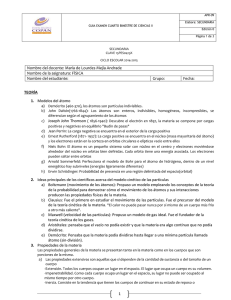

Siglos I a

Anuncio