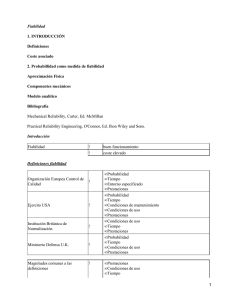

teoría de fiabilidad

Anuncio

Introducción

9

TEORÍA DE FIABILIDAD

Introducción

La teoría de la fiabilidad industrial estudia métodos que deben seguirse tanto en el diseño

como en la recepción, el transporte y el uso de los productos para garantizar al máximo su

rendimiento. Uno de los objetivos de la teoría de la fiabilidad industrial es el abandono de la

subjetividad en las previsiones sobre la duración de los productos a través de la

cuantificación de dichas previsiones. Así expresiones como: "Esta construcción es más

segura que aquélla", "Nuestro producto es más resistente que el de la competencia", tienen

que sustituirse por formulaciones más precisas, que necesitan del lenguaje estadístico.

Hay que pensar en la fiabilidad desde la primera fase del desarrollo de un producto. Antes

de tomar la decisión de fabricarlo en serie hay que someterlo a ensayos que sean

suficientemente representativos de sus condiciones de fabricación como para permitir no

sólo juzgar lo ensayado, sino también la fabricación en serie. En la etapa de desarrollo de un

producto deben elaborarse una serie de reglas que se tendrán que observar a la hora de

fabricar los productos, en su recepción y en su explotación, con la finalidad de preservar la

fiabilidad.

La fiabilidad en la ingeniería está orientada a los fallos. El problema reside en predecir si

puede ocurrir un fallo al utilizar un dispositivo y cuándo ocurrirá. Esta información es útil para

determinar las políticas de mantenimiento e inspección de una empresa, así como para

determinar los plazos de garantía de los productos. También puede utilizarse para predecir

costes debidos al mantenimiento y a los eventuales fallos que puedan ocurrir mientras el

dispositivo está operativo.

La definición utilizada en la ingeniería para la fiabilidad es la de "probabilidad de que un

dispositivo haga su función bajo condiciones establecidas, durante un período de tiempo

establecido".

Para la Física, la probabilidad se define: "Por probabilidad de un acontecimiento de una

observación nosotros entendemos nuestra estimación más creíble de la fracción del número

de observaciones que resultarán del acontecimiento particular" [Feynman]. Esta idea

corresponde a la definición frecuentista de la probabilidad: consiste en imaginar la repetición

de una experiencia y establecer la relación entre la frecuencia de un suceso A NA y el

número N de repeticiones:

P(A)=

NA

.

N

Hay por lo menos dos reflexiones ligadas a esta idea:

Un suceso no es siempre exactamente repetible. Como mínimo, los tiempos de

ocurrencia son distintos.

La probabilidad está ligada a la información disponible en cada momento.

© Los autores, 2003; © Edicions UPC, 2003.

10

Fiabilidad industrial

Otra definición de probabilidad más subjetiva es que "probabilidad es el grado de creencia

que tiene un analista u observador." La idea es que la probabilidad es una herramienta

analítica basada en la valoración, útil para poder tomar decisiones. Esta definición es en la

que se apoya la Escuela Bayesiana.

Para revisar las propiedades de la probabilidad se puede consultar el capítulo 2 de

Montgomery y Runger (1996).

Perspectiva histórica de la teoría de la fiabilidad

El origen de la fiabilidad puede atribuirse a los estudios para poder evaluar la mortalidad

derivada de las epidemias y a los métodos actuariales desarrollados por las compañías de

seguros, para determinar los riesgos de sus pólizas. Como herramienta para el cálculo del

riesgo se utilizaba las tablas de vida.

La primera tabla de vida data de 1693 y es debida a Edmund Halley1, astrónomo inglés

conocido por haber predicho la órbita del cometa que lleva su nombre.

A principios de 1900 se utilizaban los métodos actuariales tanto para estimar la

supervivencia de pacientes sometidos a distintos tratamientos como para estudiar la

fiabilidad de equipamientos, en particular de los ferrocarriles.

La teoría matemática de la fiabilidad se desarrolla por las demandas de la tecnología

moderna y en particular por las necesidades de los sistemas complejos militares. El área de

mantenimiento de máquinas es una de las áreas donde la fiabilidad se aplica con

sofisticadas matemáticas. La renovación y los avances de la tecnología se utilizan muy

pronto para resolver problemas de reparación e inspección de dispositivos.

En 1939 Walodie Weibull, cuando era profesor del Royal Institute of Technology en Suiza,

propuso una distribución para describir la duración de materiales, que más tarde llevaría su

nombre. La distribución de Weibull es muy utilizada en las aplicaciones, ya que es muy

versátil, pues admite distintas formas de funciones de riesgo.

En 1951 Epstein y Sobel empezaron a trabajar con la distribución exponencial como modelo

probabilístico para estudiar el tiempo de vida de dispositivos [ver Epstein y Sobel (1953)].

Este modelo de probabilidad, tan bueno como muchos otros, se basa en el concepto de

población de tamaño infinito o no acotado. La distribución exponencial tiene la propiedad de

no tener memoria; es decir, en el cálculo de la probabilidad de que falle un dispositivo no

influye el tiempo que hace que funciona.

Una razón fundamental de la popularidad de la distribución exponencial es la amplia

explotación que se ha hecho de ella en trabajos de fiabilidad, debido a su simplicidad en la

suma de las tasas de fallo ya que hace posible el cálculo de diseños de datos de forma

simple.

La investigación de sistemas de fiabilidad en general (y en particular las funciones de

sistemas coherentes) se inició en 1961 a partir del artículo de Birnbaum, Esary y Sauders.

1

Puede encontrarse una traducción al español del artículo citado en James R. Newman (1968).

© Los autores, 2003; © Edicions UPC, 2003.

Introducción

11

Se puede citar también un trabajo previo de Moore-Shanon donde plantean de forma más

abstracta unos enlaces de superfiabilidad. Birmbaum, Esary y Marshall (1966) introdujeron

la conexión entre las estructuras de los sistemas coherentes y la clase de distribuciones de

tiempos de vida, incluyendo las distribuciones exponenciales.

El cálculo de la fiabilidad de los sistemas había llegado a un nivel de complejidad tal que era

necesaria la formalización abstracta de dichos sistemas.

Los sistemas coherentes forman una clase de modelos de fiabilidad; el concepto

fundamental de los sistemas coherentes (coherent system) es que los componentes se

encuentran individualmente en uno de los dos estados: funcionan o fallan, y el estado de los

sistemas se representa en términos de los estados individuales de cada componente a

través de las funciones de estructura (structure function). Dos propiedades clave son: (a) la

relevancia de cada componente, es decir, no hay ningún componente cuya fiabilidad no

afecte a la fiabilidad del sistema; y (b) la monotonicidad, que encierra el concepto de que la

fiabilidad de un sistema nunca puede ser mejorada cuando uno de sus componentes se

vuelve menos fiable.

Merece mención especial indicar las publicaciones W. Nelson (1982,1990) sobre

aplicaciones de fiabilidad industrial y pruebas de vida acelerada que se han convertido en

referencias obligadas en el campo de la fiabilidad industrial.

El análisis mediante árboles de fallo, FTA (failure tree analysis), es un método de análisis de

la seguridad de un sistema. Lo desarrolló por primera vez H.A. Watson en los laboratorios

Bell. Pero es en los años 70 cuando el análisis de la fiabilidad de un sistema mediante

árboles de fallo toma más fuerza por problemas relacionados con la seguridad en las

centrales nucleares.

En los años 80 el objetivo principal de los trabajos de fiabilidad está en las redes de

comunicaciones. Esto fue motivado por el proyecto Advanced Research Project Agency

Network (ARPAnet) del Departamento de Defensa americano, que se planteó el objetivo de

la alta fiabilidad de las comunicaciones entre centros estratégicos, aunque los nodos

intermedios no fueran altamente fiables. El resultado de estos trabajos ha encontrado

aplicación en los sistemas de web e Internet actuales.

En los años 90, la investigación de la fiabilidad toma nuevas direcciones con M.B. Mendel.

Los orígenes de su investigación se basan en la hipótesis de que muchas de las

representaciones en el espacio muestral que se han considerado en la estadística no

correspondan en ingeniería a los espacios euclídeos. Por ello, utiliza la geometría diferencial

como base para la aproximación de los problemas de ingeniería estadística. Esto puntos de

vista se pueden encontrar en recientes publicaciones sobre problemas de fiabilidad de la

ingeniería, entre ellos los de Shortle y Mendel (1994) y (1996).

Objetivos de la materia

La materia de fiabilidad que se imparte en este texto es una introducción a las técnicas

estadísticas para resolver cuestiones de fiabilidad industrial.

La fiabilidad industrial se diferencia de otras técnicas estadísticas por utilizar los modelos

probabilísticos propios de las variables aleatorias que son tiempos de vida hasta el fallo,

© Los autores, 2003; © Edicions UPC, 2003.

12

Fiabilidad industrial

como la distribución exponencial y la Weibull. Otro rasgo diferencial es que en la práctica las

muestras aleatorias de que se dispone no son completas. Esto es debido a que en muchos

casos las pruebas de vida o ensayos de fiabilidad son destructivas, con lo cual son costosas

económicamente y en tiempo. Por ello, en muchos casos, se finaliza el ensayo antes de

observar el fallo.

Se desarrollan los modelos exponencial y Weibull en el contexto de la fiabilidad. También se

hace una introducción a los datos censurados y la estimación de parámetros con datos

censurados.

Se hace una introducción a las pruebas de vida acelerada, que son una práctica común en

la industria. Son aquellos ensayos que se realizan a un nivel de estrés superior al de las

condiciones ordinarias de funcionamiento, con el fin de provocar la aparición de fallos en un

tiempo más corto. Estas pruebas se realizan exponiendo los productos a condiciones más

severas que las usuales. Generalmente implica aumentar la temperatura, el voltaje, la

presión, la vibración, el tiempo operativo, etc.

Las pruebas de vida acelerada pueden usarse tanto para evaluar la capacidad de un

componente, a fin de satisfacer los requisitos de fiabilidad, como para tener un medio más

rápido de detectar debilidades potenciales o modos de fallo.

En el último capítulo se desarrolla el análisis de un sistema, formulando los sistemas

coherentes, la fiabilidad de un sistema en serie y en paralelo con tasa de fallo constante. Por

fin, se hace una introducción al análisis de la fiabilidad mediante árboles de fallo.

El objetivo principal de esta materia es dar una introducción a la fiabilidad industrial de forma

que el estudiante sea capaz de:

Identificar cuándo un problema es propio de la fiabilidad y determinar cuál es la prueba

de vida más adecuada para estudiarlo.

Reconocer la variable aleatoria que define la problemática planteada, acotando bien la

definición de fallo y definiendo las unidades con que se medirá: ciclos, horas, resistencia

hasta el fallo, etc.

Establecer cuál es el modelo probabilístico adecuado que ajusta mejor los datos de una

prueba de vida.

Estimar gráficamente con una hoja de cálculo los parámetros de los modelos

exponencial y Weibull para muestras con datos completos y datos censurados.

Estimar por el método de máxima verosimilitud los parámetros de los modelos

exponencial y Weibull para muestras con datos completos y datos censurados.

Calcular las características de fiabilidad: la fiabilidad, la vida media hasta el fallo, la tasa

de fallo, la función de riesgo, los percentiles y la mediana.

Calcular los intervalos de confianza de la vida media y la tasa de fallo del modelo

exponencial.

Calcular las constantes de los modelos de pruebas de vida con estrés constante: el de

Arrhenius y el de la potencia inversa de Weibull.

© Los autores, 2003; © Edicions UPC, 2003.

Introducción

13

Determinar la fiabilidad de un sistema compuesto por componentes en serie con tasa de

fallo constante, en paralelo, sistemas combinados y sistemas con componentes

redundantes.

Calcular la fiabilidad de un sistema a partir del análisis de un modelo lógico gráfico

como los árboles de fallo (FTA).

La materia de fiabilidad está estructurada en 5 capítulos y dos apartados de ejercicios y

prácticas:

Capítulo 1: Conceptos fundamentales

En este capítulo se presentan los conceptos generales de la teoría de la fiabilidad. El

objetivo de este capítulo es familiarizarse con las nociones de fallo, tasa de fallo, vida

media y fiabilidad. Estos conceptos se introducen haciendo referencia al lenguaje y la

terminología de una prueba de vida industrial. Se dan los preliminares de las

distribuciones de probabilidad en fiabilidad, haciendo hincapié en la función de riesgo

(hazard function), que es específica de los estudios de fiabilidad. También se hace una

introducción de los distintos enfoques que puede tener la fiabilidad en la industria.

Capítulo 2: Fiabilidad con tasa de fallo constante

Este capítulo aborda el modelo exponencial, que es el más utilizado en el análisis de

pruebas de vida. Se plantea la estimación de la vida media y la tasa de fallo para

distintas situaciones de pruebas de vida. Se introducen las muestras aleatorias que no

son completas y el concepto de datos censurados.

Capítulo 3: Tasa de fallo no constante: El modelo de Weibull y otros

Este capítulo trata el modelo de Weibull, que permite modelar tasas de fallo constante,

crecientes y decrecientes. También se tratan otras distribuciones como la Gumbel, la

Normal y la lognormal. Se describen los gráficos de probabilidad como herramienta para

validar el modelo de Weibull y estimar sus parámetros, tanto para muestras completas

como datos censurados. Se expone brevemente el método de estimación de la máxima

verosimilitud y se proponen estimadores para los parámetros basados en este método.

Capítulo 4: Pruebas de vida aceleradas

Es una introducción a las pruebas de vida acelerada, que son una práctica común en

situaciones donde es difícil la aparición de fallos. Se explican dos tipos de pruebas de

donde, a partir de los datos de dispositivos sometidos a una aceleración, se puede

inferir la fiabilidad del dispositivo en condiciones normales de uso. Se exponen el

modelo de Arrhenius y el de la potencia inversa de Weibull, dos modelos típicos de

pruebas de vida con estrés constante,

Capítulo 5: Análisis de la fiabilidad de un sistema

En este capítulo se desarrolla el análisis de un sistema, formulando los sistemas

coherentes, la fiabilidad de un sistema en serie y en paralelo con tasa de fallo

constante. Se hace una introducción al análisis de la fiabilidad mediante árboles de fallo.

© Los autores, 2003; © Edicions UPC, 2003.

14

Fiabilidad industrial

Ejercicios y prácticas de fiabilidad

Se proponen ejercicios y prácticas resueltos de los cinco capítulos. La herramienta

utilizada es la hoja de cálculo Excel y el programario estadístico Minitab.

Autoevaluaciones de fiabilidad

Se proponen ejercicios tipo test resueltos.

La fuente de algunos de los ejemplos desarrollados en estos apuntes es de W. Nelson

(1982) y G. Gómez y M. Canela (1992).

© Los autores, 2003; © Edicions UPC, 2003.

Conceptos fundamentales

15

1 CONCEPTOS FUNDAMENTALES

En este capítulo se presentan los conceptos generales de la teoría de la fiabilidad. El

objetivo de este capítulo es familiarizarse con las nociones de fallo, tasa de fallo, vida media

y fiabilidad. Estos conceptos se introducen haciendo referencia al lenguaje y la terminología

de una prueba de vida industrial. Se dan los preliminares de las distribuciones de

probabilidad en fiabilidad, haciendo hincapié en la función de riesgo (hazard function) que es

específica de los estudios de fiabilidad. También se hace una introducción de los distintos

enfoques que puede tener la fiabilidad en la industria.

Fiabilidad es un concepto con muchas connotaciones distintas. Cuando se aplica al ser

humano, normalmente se refiere a la habilidad de las personas para hacer ciertas tareas de

acuerdo con un estándar especificado. Por extensión, la palabra se aplica a una pieza de un

equipo, o a un componente de un sistema, y significa la habilidad de un equipo o

componente para cumplir con la funcionalidad que se requiere de él. El origen del uso del

término era cualitativo.

En su aplicación actual, la fiabilidad es casi siempre un concepto cuantitativo, y esto implica

la necesidad de métodos para medirla.

Hay muchas razones por las que la fiabilidad necesita ser cuantificada. Quizá el más

importante es el económico ya que la mejora de la fiabilidad cuesta dinero, y esto puede ser

justificado sólo si se puede evaluar la no fiabilidad de un equipo. Para un componente

crítico, del cual su operación funcional es esencial en un sistema, la fiabilidad puede ser

medida como la probabilidad de que el componente opere con éxito, y la esperanza del

costo de un componente no fiable se mide como el producto de la probabilidad de fallo y el

costo del fallo. En una aplicación rutinaria, donde los componentes que fallan pueden ser

reparados, la media del tiempo entre fallos (Mean Time Between Failures) es un parámetro

crítico. En ambos casos, la necesidad de una definición probabilística de fiabilidad es

evidente.

1.1 Fiabilidad y fallo

Según la norma internacional ISO 8402, la calidad de un producto es el conjunto de

características que le confieren la aptitud para satisfacer las necesidades establecidas y las

implícitas. Estas necesidades pueden comportar aspectos relativos a su aptitud de uso, la

seguridad, el respeto al medio ambiente, y en muchos casos, la fiabilidad.

La fiabilidad (reliability) de un producto se define como la facultad de conservar la calidad,

durante un tiempo preestablecido, en unas condiciones determinadas de explotación

(definición cualitativa). Para poder cuantificarla se utiliza el lenguaje estadístico y se define

como la probabilidad de que un dispositivo desarrolle su función con ciertas condiciones

establecidas, durante un período de tiempo establecido. El valor de esta probabilidad se

denota por R.

Para no tener ambigüedades en la cuantificación de la fiabilidad es importante tener bien

definido el concepto de tiempo de vida de un producto y tener identificado cuándo éste falla

y de que clase de fallo se trata.

© Los autores, 2003; © Edicions UPC, 2003.

16

Fiabilidad industrial

La vida de un producto es el período de tiempo durante el que puede ser utilizado, en las

condiciones establecidas.

Fallo (failure) es la pérdida de alguna de las propiedades del dispositivo que reduce, total o

parcialmente, su funcionamiento.

Cuando el fallo se define como un cierto nivel de degradación en el funcionamiento del

dispositivo, puede interesar estudiar la variación de la propiedad en la que se concreta la

degradación con el tiempo y a la curva que la describe se le llama curva de degradación. No

es objeto de estos apuntes entrar en el estudio de ésta, que requiere de un aparato

matemático más sofisticado. En la figura 1.1, a modo de ilustración, se puede observar

gráficamente la deriva de la media y la varianza de una medida de interés.

Ejemplo 1.1

Un tipo de resistencia eléctrica de 3.000 nominales presenta una deriva del parámetro

fundamental según el siguiente esquema: el valor medio decrece a razón del 1% de su valor

inicial cada 1.000 horas; la desviación estándar, inicialmente del 2%, es decir 60Ω, aumenta

a razón del 0,5% de su valor inicial cada 1.000 horas. Un esquema de la pauta de la deriva

puede ser el de la figura 1.1.

¿Cuál es la probabilidad de que una resistencia se encuentre después de 2.000 horas de

funcionamiento dentro del intervalo de tolerancia 3.000 ± 240Ω, suponiendo que la

distribución del valor de la resistencia sigue una ley Normal?

En t = 0 horas la variable aleatoria, T = "resistencia eléctrica", se distribuye según una

distribución Normal de media 3.000Ω y una desviación estándar 60Ω . Es decir,

T~N(3.000, 60)

En t = 2.000 horas, T ~ N(3.000 - 60Ω; 60 + 0,6Ω) = N(2.940; 60,6)

Se calcula la probabilidad de que la resistencia cumpla la tolerancia al cabo de 2.000 horas

de funcionamiento a partir de la tablas estadísticas de la distribución Normal Z(0;1) en la

tabla 2 del anexo.

2.760-2.940 T -2.940 3.240-2.940

Pr(2.760 ≤ T ≤ 3.240) = Pr

≤

≤

=

60,6

60,6

60,6

Pr[-2,97 ≤ Z ≤ 4,95] = Pr(Z ≤ 4,95)- Pr[Z ≤ -2,97] = 1-(1-0,9985) = 0,9985, donde Z~N(0;1)

No cumplirán la tolerancia un 0,15% de las resistencias. Al cabo de 2.000 horas de

funcionamiento.

© Los autores, 2003; © Edicions UPC, 2003.

Conceptos fundamentales

17

Figura 1.1 Ejemplo de la deriva de los parámetros de la distribución Normal con el tiempo

La manera en que se observa el fallo se denomina modo de fallo (failure mode) y el

mecanismo del fallo (failure mechanism) se refiere al proceso químico, físico que da lugar al

fallo.

En ciertos casos la noción de fallo no es transparente: por ejemplo, nos puede interesar

saber cuándo una pieza de un motor deja de funcionar de manera adecuada; en este caso

debe precisarse muy bien cuál es el fallo. Por ejemplo, si el fallo se detecta por el ruido del

motor, se tendrá que definir cómo medirlo (en decibelios por ejemplo) y definir un límite

superior de tolerancia (por ejemplo 60 dB). Cuando se supera el límite de 60 dB, tenemos el

fallo.

Los fallos se pueden clasificar según la causa que lo provoca: fallo por uso indebido (misuse

failure) cuando la causa es extrínseca al dispositivo, y fallo por debilidad inherente (inherent

weakness failure) cuando la causa es intrínseca.

Un sistema es un dispositivo formado por partes, la fiabilidad de las cuales es conocida.

Estas partes se denominan componentes. En general, el fallo de un sistema se produce al

fallar uno o varios componentes. Según sea el fallo, se denomina fallo primario (primary

failure) cuando no es causado ni directamente ni indirectamente por el fallo de otro

dispositivo, fallo secundario cuando es causado por el fallo de otro dispositivo, y fallo por

desgaste (wear-out failure) cuando es un fallo con una probabilidad de aparición que

aumenta a medida que el tiempo pasa, resultado de una serie de procesos característicos

del dispositivo.

© Los autores, 2003; © Edicions UPC, 2003.

18

Fiabilidad industrial

1.2 Características de fiabilidad

Para poder describir el comportamiento del tiempo de vida T de un dispositivo utilizamos la

fiabilidad, que es la probabilidad de que un objeto realice su función con ciertas condiciones

establecidas, durante un período de tiempo prefijado. T es una variable aleatoria y para cada

valor del tiempo t se obtiene un valor de fiabilidad R(t), el que en estadística se denomina

distribución de probabilidad. Una distribución de probabilidad se caracteriza mediante unos

parámetros estadísticos, que en el contexto de la fiabilidad se denominan características de

fiabilidad. La distribución de probabilidad será distinta si los dispositivos se reparan o no,

puesto que en un caso la variable aleatoria de interés es el tiempo entre fallos y, en el otro,

el tiempo hasta el fallo.

En los dispositivos que no se reparan, únicamente tiene sentido considerar tiempos de vida

hasta el primer fallo, y la variabilidad de una unidad a otra da una distribución, que es el

objeto de estudio de la fiabilidad.

Una característica de fiabilidad de la variable aleatoria T: tiempo hasta el fallo es la vida

media hasta el fallo, MTTF (mean time to failure).

Si los dispositivos son reparados tiene sentido considerar el tiempo entre fallos

consecutivos. La fiabilidad en este caso es más complicada, a menos que la distribución de

probabilidad de tiempo entre fallos sea independiente de la edad del dispositivo.

Una característica de fiabilidad de la variable aleatoria T: tiempo entre fallos consecutivos es

el tiempo medio entre fallos, MTBF (mean time between failure).

En las aplicaciones, sólo se dispone de un valor aproximado de estos parámetros, obtenido

por un procedimiento estadístico de estimación más o menos complejo. Estos valores están

muchas veces incluidos en la especificación de un producto, y pueden figurar en una

relación contractual entre un cliente y un proveedor, o servir de criterio para una

homologación. Es importante concretar de qué forma se obtiene una característica de

fiabilidad. Un lenguaje preciso y preferiblemente normalizado ayuda a evitar malentendidos

cuando se utilizan valores de las características de fiabilidad. Aquí utilizaremos la

terminología de la Internacional Electrotechnical Comision (IEC), recogida en la norma IEC

271.

Observación: La variable aleatoria duración de un dispositivo a veces no se mide en tiempo

sino en otra magnitud que tiene un significado análogo, por ejemplo la fiabilidad de un cable

puede referirse a la resistencia en Newton hasta la rotura, la de un neumático a los

kilómetros rodados, la de una tostadora al número de ciclos, la de un motor al número de

revoluciones, la de un equipo eléctrico a los kilovatios consumidos. De todas formas

mantendremos la notación temporal para simplificar.

Otras características de fiabilidad son la fiabilidad y la tasa de fallo.

La fiabilidad es la probabilidad de que una variable aleatoria T: tiempo hasta el fallo supere

un cierto período de tiempo en funcionamiento y se denota por R(t):

R(t) = Pr(T > t), donde T: tiempo hasta el fallo es la variable aleatoria.

© Los autores, 2003; © Edicions UPC, 2003.

Conceptos fundamentales

19

Hay distintas formas de aproximar una característica de fiabilidad. En general se distinguen

cuatro formas distintas: observada, evaluada, extrapolada y predicha. Esta distinción es

válida para cualquier característica de fiabilidad. En el caso de la fiabilidad se definen de la

siguiente forma:

Fiabilidad observada (observed reliability): de un dispositivo que no se repara a un tiempo

dado t, es la proporción de dispositivos de una muestra que hacen su función de manera

satisfactoria una vez transcurrido este tiempo t. Puede expresarse en porcentaje. El ejemplo

1.2 es una ilustración de este concepto.

Ejemplo 1.2

Se realiza un ensayo del mecanismo de arrastre del papel de un nuevo modelo de

impresora de chorro de tinta. El ensayo se realiza con 12 unidades y la duración prefijada es

de 60.000 ciclos. Los resultados son:

24.609; 25.237; 30.391; 41.434; 42.212; 51.615; 60.000+; 60.000+; 60.000+; 60.000+;

60.000+; 60.000+.

El símbolo + indica censura por la derecha, es decir al cabo de 60.000 ciclos aún

funcionaba.

En este caso la variable aleatoria es:

T = "nº ciclos de un mecanismo de arrastre hasta el fallo"

La muestra aleatoria simple T1, ... ,T12 es de tamaño n=12.

La fiabilidad observada a 50.000 ciclos es:

R(50.000) = 7/12 = 0,58

donde se interpreta que este nuevo mecanismo tiene una fiabilidad observada del 0,58, es

decir un 58% de las impresoras superan los 50.000 ciclos.

Nota: las fórmulas y la terminología para los cálculos se encuentran desarrolladas en el

capítulo 2.

La fiabilidad evaluada (assessed reliability) hace referencia a valores obtenidos a partir de

datos experimentales por un tratamiento estadístico. El resultado de este tratamiento puede

dar distinto a la fiabilidad observada como puede apreciarse en el ejemplo 1.3. La ventaja

del tratamiento estadístico es que el resultado es más preciso ya que en el cálculo

intervienen los tiempos de vida, y además nos permite la obtención de un intervalo de

confianza. Se puede dar a la fiabilidad evaluada un límite de confianza inferior o dos límites.

Obsérvese en el ejemplo 1.3 un intervalo de confianza unilateral de la fiabilidad evaluada.

© Los autores, 2003; © Edicions UPC, 2003.

20

Fiabilidad industrial

1.2.1 Interpretación de un intervalo de confianza (1-α) para un parámetro θ

El intervalo de confianza asocia una verosimilitud o nivel de certeza que puede atribuirse a

la estimación del parámetro θ.

Un intervalo de confianza (1-α) en el sentido clásico (no bayesiano) es tal que, si repetimos

el experimento una infinidad de veces (y cada vez recalculamos el intervalo) entonces un

porcentaje (1-α)100 % de las veces, el intervalo cubriría el verdadero valor del parámetro

desconocido θ.

Ejemplo 1.3

Se realiza un ensayo con 20 dispositivos y se finaliza cuando 12 de ellos han fallado. Se

obtienen los siguientes resultados:

55, 58, 86, 131, 335, 376, 517, 544, 920, 953, 1.072 y 1.260 horas hasta el fallo.

En este caso la variable aleatoria es:

T = "tiempo en horas hasta el fallo de un dispositivo"

La muestra aleatoria simple T1, ... ,T20 es de tamaño n = 20.

Sólo se dispone del tiempo hasta el fallo de 12 de los 20 dispositivos; de los 8 restantes

sabemos que han superado las 1.260 horas de funcionamiento.

Si suponemos que la distribución exponencial se ajusta bien a los datos podemos estimar la

vida media hasta el fallo como:

θ̂ = MTTFOBSERVADO =

T

= 1.365,58

12

horas, donde T es el tiempo total en test

T = 55+58+86+131+335+376+517+544+920+953+1.072+1.260+8×60 = 16.387

La vida media evaluada hasta el fallo es de 1.365,58 horas.

La fiabilidad observada a 600 horas es 12/20 = 0,60, donde 12 son los dispositivos que han

superado las 600 horas.

La fiabilidad evaluada a 600 horas es:

R(600) = exp(-600/1.365,58) = 0,64

© Los autores, 2003; © Edicions UPC, 2003.

Conceptos fundamentales

21

Cálculo de la fiabilidad mínima de 600 horas con una confianza del 0,95

Primero se calcula el intervalo de confianza unilateral del 0,95 para θ, que es:

900,01=

2T

2

χ0,95:24

≤ θˆ

2

= 36,415 . Así, se deduce que la vida media

donde el percentil 0,95 de la distribución χ0,95;24

de los dispositivos es de 900,01 horas como mínimo, con una confianza del 0,95.

Utilizando el límite inferior de la estimación de la vida media se encuentra el intervalo de

confianza unilateral del 0,95 para R(600), que es

R(600) = exp(-600/900,01) = 0,51

De donde se interpreta que, como mínimo, la fiabilidad a 600 horas es de 0,51 con una

confianza del 0,95, lo que indica que 51% de los dispositivos superarán las 600 horas y esta

afirmación se hace con una confianza del 0,95.

Nota: las fórmulas para los cálculos se encuentran descritas en el capítulo 2.

La fiabilidad extrapolada (extrapolated reliability) se refiere a un valor obtenido al extrapolar

o interpolar una fiabilidad observada o evaluada para poder obtener un valor aplicable a

condiciones de estrés distintas, en que se van obteniendo resultados experimentales.

Habitualmente, los valores extrapolados se basan en pruebas de vida aceleradas, que

comentaremos en el capítulo 4.

La fiabilidad predicha (predicted reliability) designa un valor aplicable a un sistema, que se

obtiene a partir de los valores observados, evaluados o extrapolados, de sus componentes.

Los métodos para el cálculo de las características de fiabilidad de un sistema se harán en el

capítulo 5.

La tasa de fallo (failure rate) es una característica de la fiabilidad que se puede interpretar

como la velocidad a la que se producen los fallos, la fracción de unidades de un producto

que fallan por unidad de tiempo.

Si la tasa de fallo es constante se designa por λ y si es función del tiempo t se designa por

h(t) y se llama función de riesgo (Hazard function).

La tasa de fallo es la magnitud recíproca de la vida media, ya que generalmente representa

un número medio de fallos por unidad de tiempo.

Igual que las otras características de fiabilidad, la tasa de fallo para un tiempo dado puede

ser observada, extrapolada, etc.

La tasa de fallo, para un intervalo (t1, t2) se define como:

h(t1, t2)=

R (t1)-R (t 2 )

(t 2 -t1)R (t1)

© Los autores, 2003; © Edicions UPC, 2003.

22

Fiabilidad industrial

y es llamada también tasa de fallo auténtico (true failure rate). La fiabilidad R(t) representa la

proporción de unidades que no han fallado en el instante t.

El cociente (R(t1) - R(t2)) / R(t1) representa la fracción de unidades que, no habiendo fallado

en el instante t1, fallan en el intervalo (t1, t2).

Si hacemos el límite de h(t1, t2) cuando t2 tiende a t1 se obtiene la función de riesgo o tasa

de fallo instantáneo en un instante t, que es una derivada:

h(t)=

-R ′(t)

R (t)

Si se asume que la tasa de fallo no depende de t, es decir es constante, el tratamiento

estadístico es mucho más sencillo tal como veremos en el siguiente capítulo.

Ejemplo 1.4

La siguiente tabla de mortalidad debida a Halley (1693) es un ejemplo clásico, que fue

discutido por Todhunter en 1949, que puede servir de ilustración para discutir las fórmulas

de la fiabilidad y de la tasa de fallo definidas. La tabla muestra las edades de defunción de

las personas de la época, que vienen agrupadas en intervalos de 5 años.

Edad t

Proporción

F(t)

Fiabilidad R(t)

Tasa h(t)

0−5

5−10

10−15

15−20

20−25

25−30

30−35

35−40

40−45

45−50

50−55

55−60

60−65

65−70

70−75

75−80

80−85

0,290

0,057

0,031

0,030

0,032

0,037

0,042

0,045

0,049

0,052

0,053

0,050

0,050

0,051

0,053

0,044

0,034

0,290

0,347

0,378

0,408

0,440

0,477

0,519

0,564

0,613

0,665

0,718

0,768

0,818

0,869

0,922

0,966

1

0,710

0,653

0,622

0,592

0,560

0,523

0,481

0,436

0,387

0,335

0,282

0,232

0,182

0,131

0,078

0,034

0

0,058

0,016

0,009

0,010

0,011

0,013

0,016

0,019

0,022

0,027

0,032

0,035

0,043

0,056

0,081

0,113

0,200

© Los autores, 2003; © Edicions UPC, 2003.

Conceptos fundamentales

23

1.3 Pruebas de vida

Las pruebas de vida son experimentos cuya finalidad es determinar el valor de una

característica de fiabilidad (determination tests) o bien asegurar que una característica de

fiabilidad es superior o inferior a un límite especificado (compliance test).

Una cuestión importante es la elección de las condiciones exteriores y el régimen de trabajo

que hace falta seguir durante las pruebas. En la elección de las condiciones se deben tener

en cuenta las particularidades del producto durante su explotación, como temperatura,

humedad, tensión, vibraciones, etc. Las condiciones exteriores pueden tener una influencia

decisiva en la variación de los parámetros medidos.

La aproximación de las pruebas de vida es estadística, puesto que a priori no puede saberse

cuándo se va a producir el fallo. Es decir, la aparición del fallo tiene un carácter aleatorio.

El conjunto de reglas que rigen el desarrollo de las pruebas se designa por plan de las

pruebas y éste ha de estar bien definido antes de empezar a experimentar. Debe fijarse el

número de unidades que se prueban, y la duración, que vendrá restringida por la

disponibilidad económica y de tiempo. La duración puede fijarse en tiempo o en número de

unidades que sé esta dispuesto a observar que fallen. En ambos casos puede pasar que la

prueba termine y haya unidades donde no se ha observado el fallo.

Los ejemplos 1.2 y 1.3 ilustran situaciones típicas de pruebas de vida: en el ejemplo 1.2 se

fija la duración de la prueba en 60.000 ciclos y en el ejemplo 1.3 se fija la cantidad de

unidades que se está dispuesto a esperar que fallen, en particular 12.

El tratamiento estadístico en este caso requiere de las técnicas de muestras estadísticas no

completas, puesto que la información de que se dispone sobre algunas unidades es que el

fallo no ha ocurrido durante el tiempo de la prueba, denominado tiempo total de test. Estos

datos se llaman censurados. El concepto de censuramiento se define en el capítulo 2.

También es importante fijar si el seguimiento de la prueba será continuo o periódico. En

muchos casos no se dispone de equipos conectados a las unidades para poder determinar

exactamente cuándo ha habido el fallo y en estos casos debe fijarse con qué periodicidad se

efectuará y cuáles serán las unidades de medida. En otros casos puede que el seguimiento

no sea en tiempo real sino operacional, es decir el seguimiento se hace a largo plazo y sólo

cuando el dispositivo opera, por ejemplo en el tiempo de vuelo, y no el tiempo desde su

fabricación.

Es importante establecer si las unidades que fallan serán reemplazadas o no, a medida que

vayan fallando (sistemas reparables o no reparables) y cuándo se dá por terminada la

prueba.

Debido a la duración y al coste de las pruebas de vida se plantea el reducir el número de

unidades sometidas al test y el tiempo de la prueba. En algunos casos la magnitud de la

vida media del producto hace inviable una prueba de vida en las condiciones normales de

funcionamiento del producto. Es en estos casos que se hace necesaria la realización de

pruebas de vida aceleradas (accelerated life test), en las cuales las condiciones de la prueba

se hacen más severas a fin de acelerar el proceso de envejecimiento y bajar la vida media.

Para poder sacar partido de este tipo de pruebas debe disponerse de un modelo teórico o

empírico que permita la extrapolación de los resultados en condiciones ordinarias de

© Los autores, 2003; © Edicions UPC, 2003.

24

Fiabilidad industrial

funcionamiento. Las principales dificultades de la elaboración de planes de prueba de vida

acelerada están ligadas al estudio de los aspectos físico-químicos del proceso de

envejecimiento, en función de las condiciones externas y el régimen de trabajo. Este tema

se desarrolla en el capítulo 4.

1.4 Distribuciones de probabilidad en fiabilidad

En muchas áreas de la estadística aplicada, la distribución Normal es el punto de partida

natural para modelar la variable aleatoria de interés. Puede resultar de consideraciones

puramente pragmáticas o del argumento teórico basado en el Teorema del Límite Central, el

cual nos dice que si una variable aleatoria es la suma de un gran número de efectos

pequeños, entonces la distribución es aproximadamente Normal. En el contexto de

fiabilidad, el caso de la Normalidad tiene una importancia menor. Por un lado los tiempos de

vida y las resistencias a la rotura son cantidades inherentemente positivas y además para

una variable aleatoria de estas características surge de forma natural la idea de que la

aparición de fallos puede seguir el proceso de Poisson, con lo que en este caso la

distribución exponencial es más adecuada.

En la práctica, los modelos utilizados en fiabilidad son generalizaciones de la distribución

exponencial, tales como las distribuciones Gamma y Weibull.

Otro aspecto distintivo del análisis estadístico de los datos de fiabilidad es el papel central

que juegan la función de fiabilidad y la función de riesgo (Hazard Function) y la natural

aparición de datos censurados.

1.4.1 El proceso de Poisson

El proceso de Poisson modeliza los tiempos entre sucesos aleatorios. Supongamos que se

observan una serie de sucesos aleatorios; concretando, supongamos que los sucesos son

fallos de unidades, de forma que las observaciones son tiempos entre fallos, por ejemplo en

sistemas reparables. Las hipótesis naturales, las cuales pueden o no satisfacerse en algún

ejemplo particular, son:

Los fallos que ocurren en intervalos de tiempo disjuntos son estadísticamente

independientes.

La tasa de fallo (media de fallos por unidad de tiempo) es constante, así que no

depende del intervalo examinado en particular.

Cuando ambas hipótesis se cumplen, entonces el proceso de aparición de fallos se llama

proceso de Poisson con tasa de fallo λ.

El proceso de Poisson tiene dos propiedades importantes:

El número de fallos X en un intervalo de longitud t sigue una distribución de Poisson con

media λt, de tal forma que

Pr(X = k) = (λt)k e-λt/k! , k≥0

© Los autores, 2003; © Edicions UPC, 2003.

Conceptos fundamentales

25

Los tiempos entre fallos sucesivos son variables aleatorias independientes, cada una de

las cuales sigue una distribución exponencial con parámetro λ, así que:

Pr(tiempo de fallo > t) = e-λt, 0 < t < ∞

El tiempo medio entre fallos (MTBF) es λ-1.

La primera propiedad está totalmente relacionada con la distribución de Poisson de

parámetro λ:

X ∼Poisson(λ) ⇔ Pr(X = k) = λke-λ/k!, k = 0,1,2, ...

Además, el proceso de Poisson es un buen modelo para aquellos sistemas con muchos

componentes que pueden fallar, pero que la probabilidad de fallo de cada uno de los

componentes es pequeña. Este fenómeno es conocido con el nombre de sucesos raros.

La segunda propiedad sugiere la distribución exponencial como modelo para tiempos de

vida. La distribución exponencial se estudiará en el capítulo 2.

En las aplicaciones la hipótesis 2 puede ser crítica, ya que muchos sistemas pueden mejorar

o deteriorarse con el tiempo. En este caso se necesitan modelos más generales como los

procesos de Poisson no homogéneos (Nonhomogeneous Poisson Process) donde la tasa

de fallo no es constante. Este tipo de modelos es particularmente importante en el análisis

de sistemas reparables. Para ampliar el tema consultar el capítulo 8 del libro de Crowder y

otros (1995).

1.4.2 Preliminares de las distribuciones del tiempo de vida

Para fijar ideas, supondremos la variable aleatoria

T = "duración de una unidad hasta el fallo"

Aquí utilizaremos tiempo en el sentido más general. Puede ser tiempo real o tiempo

operacional o incluso cualquier variable no negativa, tal como resistencia a la rotura o

número de revoluciones hasta el fallo o número de ciclos hasta el fallo. Entonces

F(t) = Pr(T ≤ t)

es la función de distribución de T y

R(t) = Pr(T > t) = 1-F(t)

es la función de fiabilidad o función de supervivencia de T. Fiabilidad (R) se utiliza en el

contexto de fiabilidad industrial y supervivencia (S) en el contexto de supervivencia en

epidemiología.

Diremos que T tiene la función de densidad

f(t) =

dF (t ) dR(t )

=dt

d(t )

© Los autores, 2003; © Edicions UPC, 2003.

26

Fiabilidad industrial

así que la probabilidad de que una unidad falle en un intervalo de tiempo pequeño (t, t+δt] es

Pr(t < T ≤ t+δt) ≅ f(t)δt

Consideremos el mismo suceso, t < T ≤ t+δt, condicionado al hecho de que la unidad no ha

fallado antes del tiempo t. Es decir

Pr(t < T ≤ t+δt| T>t) ≅

f(t )δt

R (t )

La función h(t) dada por

h(t) =

-R ′(t )

f (t )

=

R (t )

R (t )

es la función de riesgo (hazard function) o función tasa de fallo, y es un indicador de la

disposición al fallo de una unidad después de un intervalo de funcionamiento t. La función de

riesgo acumulada es

t

H(t)= ∫ h(u )du

0

de donde se puede deducir

R(t) = exp{-H(t)}

Obsérvese que f, F, R, h y H son descripciones equivalentes de T en el sentido que, dada

cualquiera de ellas, se pueden deducir las otras cuatro.

A continuación discutimos tipologías de la función de riesgo:

Si h(t) = λ es constante, entonces H(t) = λt y R(t) = exp(-λt), que es la función de

fiabilidad de una distribución exponencial de parámetro de tasa de fallo λ. La

correspondiente función de densidad es

f(t) = λe-λt

Así, la distribución del tiempo de vida exponencial corresponde a dispositivos que no

envejecen, y es un punto de partida para modelar datos de fiabilidad. Esta es la etapa

de la vida de un dispositivo llamada período de fallo con tasa constante (constant failure

rate periode).

Si h(t) es una función creciente de t, entonces se dice que T tiene una tasa de fallo

creciente. Esto es apropiado cuando las unidades están sujetas al envejecimiento

debido al desgaste, la fatiga o la acumulación de daños. Esta es la etapa de la vida de

un dispositivo llamada período de fallo por desgaste (wear-out failure periode).

© Los autores, 2003; © Edicions UPC, 2003.

Conceptos fundamentales

27

Conceptos fundamentales

p27

n

Si h(t) es una función decreciente de t, ent nces se dice que T tiene una tasa de fall

decreciente.

Estfunción

puede

currir, p de

r ejempl

, cuand

el prque

ces

de fabricación

duce

Si h(t) es una

decreciente

t, entonces

se dice

T tiene

una tasa deprfallo

decreciente.

Esto

puede ocurrir,

por ejemplo,

cuando

el proceso

de fabricación

produce

una

pr p rción

apreciable

de unidades

c n baja

calidad

que pueden

pr v car

un fall

una proporción

de unidades

conlas

baja

calidad de

quecalidad

puedensuperi

provocar

falloda

prec

z. Pasad apreciable

un ciert tiemp

, quedan

unidades

r, l uncual

precoz.

unidadescdemún

calidad

cualsitiv

da s

una

tasaPasado

de fallun cierto

inferi tiempo,

r. Esta quedan

es unalassituación

en superior,

algun s lo

disp

una

tasa

de

fallo

inferior.

Esta

es

una

situación

común

en

algunos

dispositivos

electrónic s. En tales cas s se s mete a veces al disp sitiv a una prueba de

electrónicos.c En

tales casos

somete

dispositivo

a una

prueba

resistencia

n estrés

más se

grande

dela cveces

rrespalndiente

a las

c ndici

nesdede

resistencia

con

estrés

más

grande

del

correspondiente

a

las

condiciones

deen

funci namient para eliminar las unidades subestándares. Estas pruebas s n típicas

para eliminar

las unidades

subestándares.

Estases

pruebas

sondetípicas

ende

lafuncionamiento

industria electrónica,

y se llaman

pruebas

de burn-in. Esta

la etapa

la vida

la

industria

electrónica,

y

se

llaman

pruebas

de

burn-in.

Esta

es

la

etapa

de

la

vida

de

un disp sitiv llamada período de fallo precoz (early failure periode).

un dispositivo llamada período de fallo precoz (early failure periode).

n

Otra c sa que se debe resaltar es la función de riesg en f rma curva de bañera (bathOtra cosa que se debe resaltar es la función de riesgo en forma curva de bañera (bathtub

hazard), que tiene un riesg inicial decreciente per eventualmente pasa a un riesg

tub hazard), que tiene un riesgo inicial decreciente pero eventualmente pasa a un riesgo

creciente. Un escenari en el cual se puede bservar este c mp rtamient es c m

creciente. Un escenario en el cual se puede observar este comportamiento es como

sigue. L s disp sitiv s c n baja calidad tienden a tener una fallada prec z, dejand

sigue. Los dispositivos con baja calidad tienden a tener una fallada precoz, dejando

pas

s de

tienden aa hacer

hacer bajar

bajary yaacontinuación

c ntinuaciónaplanar

aplanar

paso aa l los

de alta

alta calidad.

calidad. Est

Estoss tienden

la la

función

de

riesg

en

la

etapa

de

su

vida

para

la

cual

ha

sid

diseñada.

Después

de

este

función de riesgo en la etapa de su vida para la cual ha sido diseñada. Después de este

perí

d , debid

crecer,yycausa

causauna

unafunción

funcióndederiesgo

riesgcreciente.

creciente.

período,

debido aa la

la fatiga,

fatiga, empieza

empieza aa crecer,

Tasa

Tasa de

de fallo

fallo

FFALLO

ALLO

PRECOZ

PRECOZ

ESGASTE

DD

ESGASTE

T

ASACONSTANTE

CONSTANTE

TASA

Tiempo

Tiempo

Figura 1.2

1.2 Etapas

Figura

Etapas de

de lalavida

vidade

deun

undispositivo

disp sitiv

Observaciones: en

en muchas

muchas situaci

situaciones

Observaciones:

nes de

de interés

interés aplicado

aplicad lalamayoría

may ríadedelaslasunidades

unidades

defectuosas

son

separadas

(quizá

como

resultado

del

control

de

calidad)

empezar

defectu sas s n separadas (quizá c m resultad del c ntr l de calidad)antes

antesdede

empezar

el período de observación con lo cual es difícil encontrar funciones de riesgo decreciente. La

el perí d de bservación c n l cual es difícil enc ntrar funci nes de riesg decreciente. La

fiabilidad de algunos componentes electrónicos, puede ser tan alta que el equipo del que

fiabilidad de algun s c mp nentes electrónic s, puede ser tan alta que el equip del que

formaran parte quedará obsoleto antes de llegar a la fase de desgaste, por lo cual en este

f tipo

rmaran

parte quedará bs let antes de llegar a la fase de desgaste, p r l cual en este

de productos no interesa la etapa del período de envejecimiento.

tip de pr duct s n interesa la etapa del perí d de envejecimient .

En algunos productos el período de fallo precoz no forma parte de su vida comercial, ya que

En

s prla duct

s el perí

d deque

fall elprec

n f rma

dede

sulavida

c mercial,

yase

que

sealgun

organiza

producción

de forma

fallo z

precoz

se départe

dentro

fábrica.

Por esto

sesomete

rganiza

la pr ducción

de f rma

que prueba

el fall prec

z se dé dentr

de la fábrica.

P r estdelse

a veces

al dispositivo

a una

de resistencia

con estrés

más grande

s correspondiente

mete a veces a

al las

dispcondiciones

sitiv a una

prueba

de

resistencia

c

n

estrés

más

grande

de funcionamiento. Estas pruebas son típicas

en ladel

c industria

rresp ndiente

a

las

c

ndici

nes

de

funci

namient

.

Estas

pruebas

s

n

típicas

en la

electrónica, y se llaman pruebas de burn-in. Y es por esto, que en muchos

industria

electrónica,

y

se

llaman

pruebas

de

burn-in.

Y

es

p

r

est

,

que

en

much

s

productos solamente interesa la etapa período de fallo con tasa constante.

pr duct s s lamente interesa la etapa perí d de fall c n tasa c nstante.

Es difícil encontrar modelos probabilísticos para modelar funciones de riesgo con curva de

Es

difícil Pueden

enc ntrar

m del s pr

babilístic

s para

m este

delarproblema

funci nes

riesg

c n(1979).

curva de

bañera.

encontrarse

estudios

donde

se trata

ende

Gaver

y Acar

bañera. Pueden enc ntrarse estudi s d nde se trata este pr blema en Gaver y Acar (1979).

© Los autores, 2003; © Edicions UPC, 2003.

28

Fiabilidad industrial

Ejemplo 1. 5

El siguiente gráfico es la tasa de fallo de la tabla de mortalidad de Halley (ejemplo 1.4).

Obsérvese que tiene forma de curva de bañera.

05

510

10

-1

15 5

-2

20 0

-2

25 5

-3

30 0

-3

35 5

-4

40 0

-4

45 5

-5

50 0

-5

55 5

-6

60 0

-6

65 5

-7

70 0

-7

75 5

-8

80 0

-8

5

0,25

0,2

0,15

0,1

0,05

0

AÑOS

1.5 Enfoques de la fiabilidad

Para finalizar este capítulo, y a manera de síntesis podemos decir que la fiabilidad en la

industria se puede enfocar desde un punto de vista cuantitativo o cualitativo.

Desde el punto de vista cuantitativo, tenemos herramientas como la curva de fiabilidad, la

curva de degradación o las características de fiabilidad para cuantificar el comportamiento

de la vida de los dispositivos. Estos conceptos ya han sido desarrollados a lo largo de este

capítulo.

Desde el punto de vista cualitativo las herramientas que se utilizan en la industria son el

Análisis de modo de fallo y sus efectos (AMFE) y los análisis por árboles de fallos FTA

(failure tree analysis). Este último se desarrollara en el capítulo 5.

El análisis modal de fallos y sus efectos es un sistema metódico de valoración de

prioridades de riesgos de un proceso o producto con el propósito de reconocer y evaluar

fallos potenciales de un producto o proceso y sus efectos, identificar acciones que puedan

eliminar o reducir el riesgo de los potenciales fallos y documentar el proceso.

Fue desarrollado por la NASA en el proyecto Apolo a mediados de los años 70. Después de

las aplicaciones en los viajes aéreos y espaciales así como en las centrales nucleares se

utilizó de inmediato en la industria de la automoción; actualmente es una herramienta de uso

habitual en la industria.

Es una técnica de carácter preventivo que debe llevarse a cabo en las fases de diseño y

desarrollo de productos y servicios a lo largo del proceso de fabricación para que se puedan

detectar y prevenir los posible modos de fallo potenciales.

En el manual Potential Failure Mode and Effects Analysis de la QS 9000, normativa del

sector de la automoción Ford, Opel y General Motors, pueden encontrase las ideas

fundamentales de esta técnica y la manera de aplicarlas.

© Los autores, 2003; © Edicions UPC, 2003.

Fiabilidad con tasa de fallo constante

29

2 FIABILIDAD CON TASA DE FALLO CONSTANTE

En este capítulo se aborda el modelo exponencial que, como hemos mencionado en el

apartado 1.4, es un punto de partida natural como distribución en fiabilidad. Se introducen

las muestras aleatorias no completas y el concepto de datos censurados. Se plantea la

estimación de la vida media y la tasa de fallo para distintos tipos de pruebas de vida.

2.1 El modelo Exponencial

La función de fiabilidad de una variable aleatoria T = "Tiempo de vida hasta el fallo de un

dispositivo", cuya distribución es expo-nencial, se expresa como

-t

R(t) = Pr(T > t) = exp(-λt) = exp , t > 0

θ

donde λ es un parámetro positivo, denominado tasa se fallo, y θ=1/λ es otra parametrización

habitual de la distribución exponencial que representa la media del tiempo de vida . La figura

2.1 muestra dos funciones de fiabilidad.

Utilizando las fórmulas del apartado 1.4 se deduce que h(t), la función de riesgo (hazard

function) de la distribución exponencial es constante:

h(t) =

-R ′(t )

=λ

R (t )

En este caso se llama tasa de fallo.

La función de densidad exponencial tiene la expresión:

f(t) = λ exp(-λt) =

1

t

exp - , t >0

θ

θ

Para cualquier valor de λ la forma de la función de densidad es siempre la misma. Así, por

ejemplo, si el tiempo en minutos, T, de cierto dispositivo es exponencial con tasa de fallo λ,

el tiempo en horas es T*=T/60, y T* se distribuye exponencial con tasa de fallo 60λ. La

figura 2.2 muestra dos funciones de densidad exponencial.

La función de distribución exponencial viene dada por:

F(t) = Pr(T ≤ t) = 1- exp(-λt),

t>0

La media o esperanza matemática de la exponencial se deduce de

∞

E(T) = ∫ tf (t )dt = θ = 1/λ

0

© Los autores, 2003; © Edicions UPC, 2003.

30

Fiabilidad industrial

y la varianza

∞

Var(T) = ∫ (t - θ)2 f (t )dt = θ2 = (1/λ)2

0

En el capítulo 3 veremos que la función exponencial es un caso especial de la distribución

de Weibull.

El ejemplo 2.1 ilustra la interpretación de las características de fiabilidad de la distribución

exponencial.

R(t)

F ia b ilid a d

1

0 ,8

0 ,6

0 ,4

0 ,2

0

λ=5

λ=10

0

0 ,2

0 ,4

0 ,6

0 ,8

1

1 ,2

T

Figura 2.1 Función de fiabilidad exponencial

con tasa de fallo λ = 5 (sólido) y λ = 10 (punteado)

f(t)

D e n s id a d

10

8

6

4

2

0

λ=10

λ=5

0

0 ,1

0 ,2

0 ,3

0 ,4

0 ,5

0 ,6

T

Figura 2.2 Función de densidad exponencial

con tasa de fallo λ = 5 (sólido) y λ = 10 (punteado)

© Los autores, 2003; © Edicions UPC, 2003.

0 ,7

0 ,8

Fiabilidad con tasa de fallo constante

p31

Ejemplo 2.1 Cambio de un motor Diesel

La duración en km del cambio de un motor Diesel de un automóvil sigue una ley exponencial

de vida media θ = 300.000 km. La tasa de fallo es λ = 1/300.000 = 3×10-6 fallos/km o 3 fallos

por 1 millón de km de funcionamiento.

La dirección de una fabrica quiere decidir si es necesario rediseñar los equipos actuales

para poder mantener la garantía, que es actualmente de 20.000 km de funcionamiento.

Se calcula la probabilidad de que fallen antes de 60.000:

20.000

Pr(T ≤ 20.000) = F(20.000) = 1-R(20.000) = 1-exp = 0,0645

300.000

Esto indica que un 6,45% de los cambios fallan durante la garantía.

La dirección de la empresa quiere saber en qué valor tiene que fijar la garantía para que

fallen únicamente un 5% de los cambios de los motores.

Para esto se plantea cuál ha de ser el valor k de la variable aleatoria T para que

F(t) = 1-R(k) = 0,05, es decir R(k) = Pr(T > k) = 0,95, de donde se deduce:

k

R(k) = exp = 0,95 ⇒ k = -ln(0,95)x300.000 = 15.388 km

300.000

La magnitud k = 15.388 km representa el percentil del 5% de la distribución de la variable

aleatoria T, km hasta el fallo de un cambio del motor.

Conclusión: Si la dirección desea que sólo fallen un 5% de los cambios del motor durante el

período de garantía debería fijarla en 15.388 Km. de funcionamiento. En caso de querer

mantener los 20.000 Km. debería rediseñar los cambios. Es importante remarcar que esto

se ha hecho suponiendo que el modelo exponencial es adecuado para modelar los km de

funcionamiento hasta el fallo de los cambios de los motores.

2.2 Datos censurados

Frecuentemente los datos de tiempo de vida tienen observaciones incompletas. El

tratamiento estadístico y en particular la estimación de las características de fiabilidad

cambia respecto a la estimación clásica de muestras completas.

Este tipo de datos se denominan datos censurados. El mecanismo de censuramiento puede

ser por la derecha, por la izquierda y por intervalo. En principio el tiempo de vida de las

unidades no depende del mecanismo de censuramiento.

Ocurre comúnmente que el valor exacto del tiempo de vida de una unidad no es observado

pero se sabe que excede de un cierto tiempo c. Tales tipos de observaciones reciben el

nombre de censuradas por la derecha. Una observación de este tipo aparece cuando la

unidad aún no ha fallado cuando termina el tiempo previsto de la prueba de vida.

© Los autores, 2003; © Edicions UPC, 2003.

32

Fiabilidad industrial

El censuramiento por la izquierda aparece cuando de la unidad se conoce que ha fallado

algún tiempo antes c. Por ejemplo cuando el test sobre la unidad se hace cada hora. Si una

unidad ha fallado antes de la primera hora entonces de la unidad sólo se sabe que el tiempo

de vida es inferior a una hora. En este escenario puede darse que una unidad falle entre la

segunda y la tercera hora (es decir, que la unidad trabaje en el segundo test y en el tercero

ya no funcione). Entonces sabemos que la unidad ha durado más de dos horas pero menos

de tres horas. Este es un ejemplo de censuramiento por intervalo.

Un posible mecanismo de censuramiento, conocido como tipo I, es cuando se ponen n

unidades en un ensayo y a priori se fija un periodo t0 de la prueba. Entonces, los i-ésimos

tiempos de vida Ti (i = 1, ... ,n) que se observan son los que Ti ≤ t0, mientras que hay otros

de los que sólo se sabe que Ti > t0. Este tipo de censuramiento es fácil de tratar

estadísticamente.

Otro tipo de mecanismo de censuramiento puede darse cuando se hace un test a n

unidades y cada unidad es observada hasta que el observador está convencido de que la

unidad ha empezado a fallar. El punto de vista del observador se basa en su experiencia y

no en puras suposiciones. En este caso, el mecanismo de censuramiento contiene

información de interés sobre los tiempos de vida. Esta situación se puede formalizar de la

siguiente forma: sea Ti censurada por la derecha por ci; entonces se sabe que Ti > ci y

además Ti = ci + εi, donde εi es una variable aleatoria positiva de media cero y varianza

pequeña (su pequeñez depende de la experiencia del observador). Así, según este

esquema, una unidad censurada en ci puede no ser representativa de todas las unidades

que tienen un tiempo de vida ci o superior. Este tipo de mecanismo de censuramiento debe

tratarse con métodos estadísticos más complejos que no se desarrollarán en este texto.

(Puede consultarse Crowder y otros (1995).)

Una forma de censuramiento habitual en estudios de fiabilidad es el censuramiento por la

derecha llamado tipo II. En este caso se fija la duración del ensayo hasta después de haber

observado un número especificado de unidades que fallen. Obsérvese que el tiempo de

censuramiento por la derecha (o tiempos, si todas las unidades no se han puesto en

funcionamiento a la vez) no es (son) conocido (s) por avanzado. Pueden encontrarse otras

formas más complicadas de censuramiento por la derecha, pero deben tratarse de manera

particular cada una de ellas, sabiendo que cualquier unidad censurada por la derecha en ci

es representativa de todas las unidades similares que tienen un tiempo de vida superior a ci.

Para el censuramiento por la izquierda y por intervalo pueden aplicarse criterios similares.

Dada una muestra aleatoria simple de la variable de interés T si la realización de la muestra

es completa, es decir, si disponemos de todos los tiempos de vida, se trata de pruebas de

vida con datos completos. Si la realización de la muestra es incompleta, por lo tanto no

hemos observado todos los fallos, se trata de pruebas de vida con datos censurados.

2.3 Estimación de la vida media y la tasa de fallo de la distribución exponencial

Sea T = "tiempo de vida de una unidad", una variable aleatoria que se distribuye exp(θ).

Sea T1, T2, ... , Tn una muestra aleatoria de T. Se define el tiempo total de test T, como la

suma de los tiempos de funcionamiento de las unidades de la muestra (hayan fallado o no).

© Los autores, 2003; © Edicions UPC, 2003.

Fiabilidad con tasa de fallo constante

33

El valor estimado de la vida media viene dada por

MTTF = θ̂ =

T

r

^ indica la estimación del parámetro θ, la vida media hasta el fallo. T es el tiempo total en

test y r es el número de fallos observados. Cuando la muestra es completa r coincide con n,

tamaño de la muestra.

El valor estimado de la tasa de fallo λ= 1/θ viene dado por

λ̂ =

r

T

donde T es el tiempo total de test y r es el número de fallos observados. Obviamente aquí

también, para una muestra completa r, coincide con n.

2.4 Pruebas con datos completos. Intervalos de confianza 1-α para la vida media

y la tasa de fallo

El intervalo de confianza bilateral 1-α para la vida media es

χ

2T

2

(1-α/2);2n

≤ θˆ ≤

χ

2T

(2.1)

2

(α/2);2n

donde T es el tiempo total de test de una muestra de tamaño n y

χ1-2 α;ν

es el (1-α)-percentil

2

de la distribución χ con ν grados de libertad, en este caso ν = 2n, donde n es el tamaño de

la muestra.

El intervalo de confianza unilateral 1-α para la vida media es

2T

χ(1-2 α);2n

≤ θˆ

(2.2)

donde T es el tiempo total en test de una muestra de tamaño n y

χ2α;ν es el (1-α)-percentil de

la distribución χ2 con ν grados de libertad, en este caso ν = 2n.

El intervalo de confianza bilateral 1-α para la tasa de fallo λ es

χ(2α/2);2n

2T

≤ λˆ ≤

χ(1-2 α/2);2n

(2.3)

2T

donde T es el tiempo total de test de una muestra de tamaño n y

2

distribución χ con ν grados de libertad, en este caso ν = 2n.

© Los autores, 2003; © Edicions UPC, 2003.

χ2α;ν

es el α-percentil de la

34

Fiabilidad industrial

De forma similar, se puede definir el intervalo de confianza unilateral 1-α para la tasa de

fallo λ

χ2α;2n

2T

≤ λˆ

(2.4)

Ejemplo 2.2

La siguiente tabla presenta los datos obtenidos en una prueba de vida en que se midieron

los tiempos de perforación (time to breakdown) en minutos, de un fluido aislante entre

electrodos sometido a un voltaje de 34 kV. El experimento duró hasta que todos los

componentes (n = 19) fallaron.

(fuente W. Nelson 1982)

Sea la variable aleatoria T= "Tiempo, en minutos, de un fluido aislante sometido a 34 kV" y

supongamos que T es exponencial.

El tiempo total de test es T =

n

∑t

i

= 272,82 minutos, donde t1,...,tn es la realización de la

i=1

muestra de la variable aleatoria T.

La media del tiempo de vida en minutos es θ̂ =

T

= 272,8191/19 = 14,3589 minutos.

n

El intervalo de confianza 0,95, aplicando la fórmula (2.1), de la media del tiempo de vida es

9,59 ≤ θ̂ ≤ 23,85

En los anexos se encuentran las tablas de

son para este caso:

2

χ0,025;38

= 22,8785

χ2 donde los percentiles de la distribución χ2,

2

χ0,975;38

= 56,8955

lo que indica que la vida media de un fluido sometido a un voltaje de 34kV se encuentra

entre 9,59 y 23,85 minutos con una confianza del 0,95.

La tasa de fallo se estima como λ̂ = 1/ θ̂ = 0,0696, de donde se deduce que la tasa de fallo

es de 0,0696 fallos por minuto.

Aplicando la fórmula (2.3) se calcula el intervalo de confianza 0,95 para la tasa de fallo:

0,0419 ≤ λ̂ ≤ 0,1043

lo que indica que la tasa de fallo de un fluido sometido a un voltaje de 34kV se encuentra

entre 0,042 y 0,10 fallos por minuto.

© Los autores, 2003; © Edicions UPC, 2003.

Fiabilidad con tasa de fallo constante

35

La función de fiabilidad estimada o evaluada es

R(t) = exp

-t

, t≥0

14,36

de donde podemos decir que la fiabilidad evaluada a 15 minutos sería 0,35, es decir, que el

35% de los componentes sometidos a un voltaje constante de 34kV superaran los 15

minutos.

El intervalo de confianza 0,975 unilateral para R(15) es

exp(-15/9,59) = 0,21 ≤ R(15)

Es decir, que con una confianza del 0,975 podemos asegurar que el 21% de los

componentes superaran los 15 minutos.

Nota: Obsérvese que para el cálculo del intervalo de confianza unilateral 0,975 para R(15)

utilizamos el límite inferior del intervalo de confianza 0,95 de la estimación de la media del

tiempo de vida.

2.5 Pruebas de vida con duración prefijada (Censuramiento tipo I)

2.5.1 Tiempos de fallo conocidos

Supongamos un experimento en el que tenemos n dispositivos y prefijamos un tiempo t0 de

duración y se registran los tiempos de fallo. Este tipo de prueba admite dos variantes, según

si se reemplazan o no los dispositivos. En el primer caso se dice que la prueba se realiza

con sustitución. Los dos tipos de prueba tienen un tratamiento matemático parecido, las

pruebas con sustitución no tienen otra finalidad que aumentar el tamaño de la muestra.

Al cabo de t0 horas observamos r < n fallos.

En este caso el tiempo total en test T viene dado por:

T=

r

∑t +(n-r )t

i

0

, donde ti ≤ t0

i=1

Si las pruebas son con sustitución, T = n x t0.

La estimación de la vida media es

θ̂ = MTTF = T/r

(2.5)

El intervalo de confianza bilateral 1-α es

χ

2T

2

1-(α/2);2r +2

≤ θˆ ≤

χ

2T

2

(α/2);2r

© Los autores, 2003; © Edicions UPC, 2003.

(2.6)

36

Fiabilidad industrial

donde T es el tiempo total de test de una muestra de tamaño n y

χ2α;ν

es el α-percentil de la

distribución χ con ν grados de libertad y donde r(<n) es el número de fallos observados de

la muestra.

2

El intervalo de confianza unilateral se obtiene sustituyendo en la fórmula (2.6) α/2 por α en

un solo límite. Hay una ilustración en el ejemplo 2.3.

Si durante el período previsto para la prueba no se observa ningún fallo, es decir r = 0, no

podemos dar un valor para θ ni para R(t0), pero sí límites de confianza inferiores para la vida

media y la fiabilidad.

Ejemplo 2.3

Se realiza una prueba de vida con n = 12 componentes durante una semana, es decir

fijando el tiempo de duración en t0 = 168 horas, con substitución, observándose r = 3 fallos.

Se quiere evaluar la fiabilidad al cabo de 168 horas y la vida media en horas de

funcionamiento. El tiempo total en test T es de 168 x 12 = 2.016 horas.

La vida media en horas de funcionamiento aplicando la fórmula (2.5) es

θ̂ = MTTF = T/r = 2.016/3 = 672 horas.

Sustituyendo α por α/2 en el límite inferior de la fórmula (2,6) se obtiene un límite inferior de

confianza 0,95 para la vida media de

2x2016

=259,96 horas

θˆ ≥ 2

χ0,95;8

2

donde χ0,95;

8 = 15,51 se encuentra en las tablas estadísticas del Anexo. Lo que indica que

estos dispositivos tienen una duración media mínima de 259,96 horas, y esta afirmación se

hace con una confianza del 0,95.

La fiabilidad estimada al cabo de 168 horas es

R̂ (168) = exp(-168/672) = 0,78

lo que indica que 78% de los dispositivos superan una semana.

Obsérvese que ésta es una estimación puntual sin ningún grado de confianza. Se podría

precisar más dando una aproximación por intervalo de confianza. Utilizando el límite de

confianza inferior de la estimación de la vida media se obtiene con un 95% de confianza:

R̂ (168) ≥ exp(-168/259,96) = 0,524

Es decir, la probabilidad de que una pieza funcione al cabo de 168 horas es superior al

52,4% con una confianza del 95%.

© Los autores, 2003; © Edicions UPC, 2003.

Fiabilidad con tasa de fallo constante

37

Si durante este período de 168 horas los n=12 componentes no hubiesen fallado, es decir,

no se hubiese observado ningún fallo, podríamos asegurar, con una confianza del 95%, que

la vida media de estos dispositivos es superior a:

2x2.016 4.092

θˆ ≥

=

=673,12

2

χ0,95;2

5,99

Sustituyendo por θ̂ = 673,12 obtenemos R̂ (168) = exp(-168/673,12) = 0,78, que nos da un

límite inferior de confianza para la fiabilidad al cabo de una semana, que se puede

interpretar como que la probabilidad de que un componente no haya fallado al cabo de una

semana es superior al 78%, con una confianza del 95%.

2.5.2 Pruebas de vida donde no se registran los tiempos de fallo

En los estudios de fiabilidad en la industria pueden plantearse pruebas de vida donde, fijado

un tiempo de duración t0, sólo se pueda obtener el número de fallos y no se registre el

tiempo de fallo de cada unidad. En este caso puede calcularse la fiabilidad en el momento t0

como:

R(t0)=

n- r

n

(fiabilidad observada)

donde n es el tamaño de la muestra y r son los fallos observados.

El intervalo de confianza 1-α para la fiabilidad al cabo de t0 horas viene dado por

1

1+ (r +1)/(n -r ) F2

≤ Rˆ (t0 ) ≤

F1

F1+(r /n - r +1))

(2.7)

donde F1 = F (1- α2 ;2n -2r +2;2r ) y F2 = F (1- α2 ;2r +2;2n -2r ) son los (1-α/2) percentiles de la distribución F

con 2n-2r+2 y 2r grados de libertad y 2r+2 y 2n-2r respectivamente. Los percentiles del 0,90

y 0,95 de la distribución F se encuentran en las tablas estadísticas del Anexo.

De la misma manera que en la fórmula 2.6, puede obtenerse el intervalo unilateral inferior

sustituyendo α/2 por α en el límite inferior de la fórmula (2.7). El comentario se ilustra en el

ejemplo 2.4.

Las fórmulas para obtener la fiabilidad observada y el intervalo de confianza anteriores,

obviamente no dependen de la distribución de los datos. Si por estudios anteriores o por la

naturaleza de los datos puede suponerse que el modelo exponencial es válido, se puede

estimar la vida media como:

θˆ =

-t 0

=

lnR (t 0 )

-t 0

n-r

ln

n

© Los autores, 2003; © Edicions UPC, 2003.

(2.8)

38

Fiabilidad industrial

Ejemplo 2.4

Se dispone de n = 20 unidades de un dispositivo durante una semana, 168 horas. Al finalizar

la semana sólo se observa que han fallado 5 unidades.

La fiabilidad observada de este producto al cabo de una semana R(168) = 15/20 = 0,75

horas, lo que indica que un 0,75% de los dispositivos superan la semana. Esta aproximación

es sin grado de confianza.

Sustituyendo α/2 por α en el límite inferior de la fórmula (2.7) el intervalo de confianza 0,95

unilateral al cabo de 1 semana es:

1

1

0,54 =

=

≤ Rˆ (168)

1+(

r

+1)/(

n

r

)

F

2

1+ (5+1)/(20-5) F2

donde F2 = F(0,95;12;30) = 2,09, n es el tamaño de la muestra y r el numero de fallos

observados. Con lo que se puede afirmar que la fiabilidad del dispositivo al cabo de una

semana es superior al 54%, con una confianza del 95%.

Si podemos suponer que los tiempos de vida (no registrados) se distribuyen exponencial, a

partir de la fórmula (2.8) una estimación puntual de la vida media es:

-168

θˆ =

= 583,9 horas

15

ln

20

El intervalo unilateral inferior con una confianza del 95%, utilizando el límite de confianza

inferior obtenido para la fiabilidad en la fórmula 2.8, es:

-168

= 272,6 ≤ θ̂

ln(0,54)

Concluimos que la validez del modelo exponencial permite asegurar que la vida media es

superior a 272,6 horas, con una confianza del 95%.

2.6 Pruebas de vida con número de fallos prefijados (Censuramiento tipo II)