MAXIMUM LIKELIHOOD

Anuncio

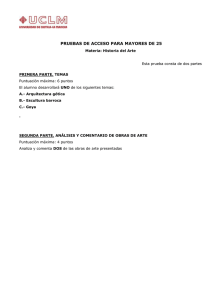

MAXIMUM LIKELIHOOD Jesús A. González y Eduardo Morales Maximum Likelihood Estimation (MLE) 2 ¨ ¨ Método preferido para estimación de parámetros en estadística Indispensable para muchas técnicas de modelado estadístico ¤ ¨ Modelado no-lineal con datos que no siguen una distribución normal La meta del modelado es deducir la forma de un proceso al probar la viabilidad de el modelo 25/02/13 2:53 pm Maximum Likelihood Estimation (MLE) 3 ¨ Al especificar un modelo y sus parámetros para un conjunto de datos ¤ Evaluar qué tan bien se ajusta el modelo a los datos observados ¨ El “buen ajuste” se evalúa al encontrar los parámetros del modelo que mejor se ajustan a los datos ¤ Este proceso se conoce como n Estimación de parámetros 25/02/13 2:53 pm Estimación de Parámetros 4 ¨ Dos métodos generales para estimación de parámetros: 1. Least-squares estimation (LSE) n Estimación por mínimos cuadrados n Utilizado en varios conceptos Regresión lineal n Suma de errores cuadrados n Desviación de la raíz del cuadrado de la media n n No requiere (o mínima) asunción de la distribución n Útil para obtener medida descriptiva para sumarizar los datos observados n No tiene base para pruebas de hipótesis o construir intervalos de confianza 25/02/13 2:53 pm Estimación de Parámetros 5 ¨ Dos métodos generales para estimación de parámetros: 1. Maximum likelihood estimation (MLE) n Estimación por máxima verosimilitud n Estándar para estimación de parámetros e inferencia en estadística n MLE tiene muchas propiedades óptimas en la estimación Información completa del parámetro de interés contenido en su estimador MLE n Consistencia: sobre el valor del parámetro verdadero que generó los datos, que se recupera asintóticamente (con suficientes datos) n Eficiencia: se obtiene la menor-posible varianza de los estimados del parámetro, recuperado asintóticamente n Invarianza a la parametrización (obtiene la misma solución MLE independientemente de la parametrización utilizada) n 25/02/13 2:53 pm Estimación de Parámetros 6 ¨ Muchos métodos estadísticos de inferencia están basados en MLE ¤ Prerequisito para Prueba chi-square n Prueba G-square n Métodos bayesianos n Inferencia con valores faltantes n Modelado de efectos aleatorios n Modelos de criterios de selección: criterio de información de Akaike y criterio de información Bayesiana n 25/02/13 2:53 pm Especificación del Modelo 7 ¨ Función de densidad de probabilidad ¤ Muestra n y ¤ La aleatoria de una población desconocida = (y1, …, ym) meta del análisis de datos n Identificar cuál es la población más probable de haber generado la muestra ¤ En estadística, cada población se identifica por su correspondiente distribución de probabilidad ¤ A cada distribución se asocia un valor único del parámetro del modelo 25/02/13 2:53 pm Especificación del Modelo 8 ¨ Función de densidad de probabilidad (continuación…) ¤ Cambiar el valor del parámetro, genera diferentes distribuciones de probabilidad ¤ Un modelo se define como una familia de distribuciones de probabilidad indexada por los parámetros del modelo ¨ f(y|w) à función de densidad de probabilidad ¤ Nos dice la probabilidad de observar el vector de datos y dado el parámetro w 25/02/13 2:53 pm Especificación del Modelo 9 ¨ Función de densidad de probabilidad (continuación…) ¤ w = (w1, …, wk) Vector definido en el espacio de parámetros multi-dimensional n Si yi’s son estadísticamente independientes una de otra n n n De acuerdo a teoría de probabilidad La PDF de los datos y=(y1, …, ym) dado el vector de parámetros w se puede expresar como una multiplicación de PDFs de observaciones individuales f (y = (y1, y2 ,..., yn ) | w) = f1 (y1 | w) f2 (y2 | w)... fn (ym | w). 25/02/13 2:53 pm Ejemplo 10 ¨ Caso más simple: una observación y un parámetro ¤ m =k=1 ¤ Los datos, y representan una secuencia de sucesos de 10 tiradas Bernoulli (tirar una moneda 10 veces) n Probabilidad de éxito en cada tirada, w = 0.2 25/02/13 2:53 pm Ejemplo 11 ¨ Distribución binomial para el experimento con n = 10, y variando w: 0.2, 0.7 f (y | n = 10, w = 0.2) = 10! (0.2) y (0.8)10−y y!(10 − y)! (y = 0,1,...,10) 10! f (y | n = 10, w = 0.7) = (0.7) y (0.3)10−y y!(10 − y)! (y = 0,1,...,10) n! (w) y (1− w)n−y y!(n − y)! (0 ≤ w ≤ 1; y = 0,1,..., n) f (y | n, w) = 25/02/13 2:53 pm From a statistical standpoint, the data vector y ¼ ðy1 ; y; ym Þ is a random sample from an unknown population. The goal of data analysis is to identify the population that is most likely to have generated the sample. In statistics, each population is identified by a corresponding probability distribution. Associated with each probability distribution is a unique value of the Ejemplo 12 number of successes in a sequence of 10 Bernoulli trials (e.g. tossing a coin 10 times) and that the probability of a success on any one trial, represented by the parameter w; is 0.2. The PDF in this case is given by f ðy j n ¼ 10; w ¼ 0:2Þ ¼ 10! ð0:2Þy ð0:8Þ10$y y!ð10 $ yÞ! ðy ¼ 0; 1; y; 10Þ Fig. 1. Binomial probability distributions of sample size n ¼ 10 and probability parameter w ¼ 0:2 (top) and w ¼ 0:7 (bottom). 25/02/13 2:53 pm ð2Þ Ejemplo 13 ¨ En la distribución binomial del ejemplo: ¤ El número de intentos (tiradas), n, se considera un parámetro ¤ La función de y especifica la probabilidad de los datos y para valores dados de n y w ¤ A la colección de todas las PDFs generadas al variar los parámetros en el rango (0-1en este caso para w, n>=1) define un modelo. 25/02/13 2:53 pm Función de Verosimilitud (likelihood) 14 Dado un conjunto de valores de parámetros ¨ La PDF correspondiente muestra que algunos datos son más probables que otros ¨ En el ejemplo, con w = 2, y = 2 es más probable de ocurrir que y = 5 (0.302 vs. 0.026) ¨ 25/02/13 2:53 pm Función de Verosimilitud (likelihood) 15 ¨ Sin embargo, tenemos el problema inverso ¤ Ya observamos los datos ¤ Dados los datos observados y un modelo de interés n Encontrar la PDF, entre todas las densidades de probabilidad que provee el modelo, que tiene la mayor probabilidad de haber producido los datos ¨ Para resolver el problema se define la función de verosimilitud invirtiendo los roles del vector de datos y y el vector de parámetros w en f(y|w) ¤ LL(w|y) = f(y|w). 25/02/13 2:53 pm Función de Verosimilitud (likelihood) 16 ¨ L(w|y) representa la verosimilitud del parámetro w dados los datos observados y. ¤ Por ejemplo, con y = 7 y n = 10: L(w | n = 10, y = 7) = f (y = 7 | n = 10, w) 10! 7 = w (1− w)3 (0 ≤ w ≤ 1). 7!3! 25/02/13 2:53 pm Given a set of parameter values, the corresponding PDF will show that some data are more probable than other data. In the previous example, the PDF with w ¼ 0:2; y ¼ 2 is more likely to occur than y ¼ 5 (0.302 vs. 0.026). In reality, however, we have already observed the data. Accordingly, we are faced with an inverse problem: Given the observed data and a model of likelihood function is a function of the parameter given a particular set of observed data, defined on the parameter scale. In short, Fig. 1 tells us the probability of a particular data value for a fixed parameter, whereas Fig. 2 tells us the likelihood (‘‘unnormalized probability’’) of a particular parameter value for a fixed data set. Note that the likelihood function in this figure is a curve Función de Verosimilitud (likelihood) 17 Fig. 2. The likelihood function given observed data y ¼ 7 and sample size n ¼ 10 for the one-parameter model described in the text. 25/02/13 2:53 pm Función de Verosimilitud (likelihood) 18 ¨ Diferencia importante entre las funciones PDF f(y|w) y de verosimilitud L(w|y) (ver figuras). ¤ Se definen sobre ejes diferentes ¤ No son directamente comparables ¤ f(y|w) se define en la escala de datos n Función de los datos dado un conjunto de valores de parámetros ¤ L(w|y) se define en la escala de parámetros n Función del parámetro, dado un conjunto particular de datos observados 25/02/13 2:53 pm other sources (e.g., Bickel & Doksum, 1977, Chap. 3; Casella & Berger, 2002, Chap. 7; DeGroot & Schervish, 2002, Chap. 6; Spanos, 1999, Chap. 13). vector w can be expressed as a multiplication of for individual observations, f ðy ¼ ðy1 ; y2 ; y; yn Þ j wÞ ¼ f1 ðy1 j wÞ f2 ðy2 j wÞ ?fn ðym j wÞ: Función de Verosimilitud (likelihood) 2. Model specification 2.1. Probability density function To illustrate the idea of a PDF, consider the si case with one observation and one parameter, t m ¼ k ¼ 1: Suppose that the data y represen number of successes in a sequence of 10 Bernoull (e.g. tossing a coin 10 times) and that the probab a success on any one trial, represented by the par w; is 0.2. The PDF in this case is given by From a statistical standpoint, the data vector y ¼ ðy1 ; y; ym Þ is a random sample from an unknown population. The goal of data analysis is to identify the population that is most likely to have generated the 10! f ðy j n ¼ 10; w ¼ 0:2Þ ¼ ð0:2Þy ð0:8Þ10$y sample. In statistics, each population is identified by a 92 I.J. Myung / Journal of Mathematical Psychology 47 (2003) 90–100 y!ð10 $ yÞ! corresponding probability distribution. Associated with ðy all ¼ 0; 1; y; 10Þ each probability is a unique value of theinterest, find the one PDF, among the probability which is knowndistribution as the binomial distribution with 19 ¨ ¨ Fig. 1 nos dice la probabilidad de un valor de datos en particular para un parámetro fijo. Fig. 2 nos dice la verosimilitud (“probabilidad no normalizada”) de un parámetro particular para un conjunto de datos fijo. parameters n ¼ 10; w ¼ 0:2: Note that the number of trials ðnÞ is considered as a parameter. The shape of this PDF is shown in the top panel of Fig. 1. If the parameter value is changed to say w ¼ 0:7; a new PDF is obtained as 10! f ðy j n ¼ 10; w ¼ 0:7Þ ¼ ð0:7Þy ð0:3Þ10$y y!ð10 $ yÞ! ðy ¼ 0; 1; y; 10Þ ð3Þ whose shape is shown in the bottom panel of Fig. 1. The following is the general expression of the PDF of the binomial distribution for arbitrary values of w and n: n! wy ð1 $ wÞn$y f ðyjn; wÞ ¼ y!ðn $ yÞ! ð0pwp1; y ¼ 0; 1; y; nÞ ð4Þ densities that the model prescribes, that is most likely to have produced the data. To solve this inverse problem, we define the likelihood function by reversing the roles of the data vector y and the parameter vector w in f ðyjwÞ; i.e. LðwjyÞ ¼ f ðyjwÞ: ð5Þ Thus LðwjyÞ represents the likelihood of the parameter w given the observed data y; and as such is a function of w: For the one-parameter binomial example in Eq. (4), the likelihood function for y ¼ 7 and n ¼ 10 is given by Lðw j n ¼ 10; y ¼ 7Þ ¼ f ðy ¼ 7 j n ¼ 10; wÞ 10! 7 ¼ w ð1 $ wÞ3 ð0pwp1Þ: 7!3! ð6Þ The shape of this likelihood function is shown in Fig. 2. which as a function of y specifies the probability of data There exist an important difference between the PDF y for a given value of n and w: The collection of all such f ðyjwÞ and the likelihood function LðwjyÞ: As illustrated PDFs generated by varying the parameter across its in Figs. 1 and 2, the two functions are defined on range (0–1 in this case for w; nX1) defines a model. different axes, and therefore are not directly comparable to each other. Specifically, the PDF in Fig. 1 is a 2.2. Likelihood function function of the data given a particular set of parameter values, defined on the data scale. On the other hand, the Given a set of parameter values, the corresponding likelihood function is a function of the parameter given PDF will show that some data are more probable than a particular set of observed data, defined on the other data. In the previous example, the PDF with w ¼ parameter scale. In short, Fig. 1 tells us the probability 0:2; y ¼ 2 is more likely to occur than y ¼ 5 (0.302 vs. of a particular data value for a fixed parameter, whereas 0.026). In reality, however, we have already observed the Fig. 2 tells us the likelihood (‘‘unnormalized probabil1. Binomial we probability distributions of sample 10 and ¼ 0:2 for (top) and wdata ¼ 0:7 (bottom). data. Fig. Accordingly, are faced with an inversesize n ¼ity’’) of aprobability particularparameter parameterwvalue a fixed set. problem: Given the observed data and a model of Note that the likelihood function in this figure is a curve Fig. 2. The likelihood function given observed data y ¼ 7 and sample size n ¼ 10 for the one-parameter model described in the text. 25/02/13 2:53 pm Ecuación de Verosimilitud 20 Las estimaciones “MLE” pueden no existir o pueden no ser únicas. ¨ Veremos sólo cuando existen y son únicas. ¨ Por conveniencia, MLE se obtiene maximizando la función log-likelihood: lnL(w|y) ¨ ¤ lnL(w|y) y L(w|y) están monotónicamente relacionadas una a la otra n Se obtiene el mismo estimado MLE maximizando cualquiera de ellas 25/02/13 2:53 pm Ecuación de Verosimilitud 21 ¨ Asumiendo que lnL(w|y) es diferenciable, si wMLE existe, debe satisfacer la siguiente ecuación diferencial parcial conocida como “likelihood equation” ∂ln L(w | y) =0 ∂wi ¤ con wi = wi,MLE para todo i = 1, …, k. 25/02/13 2:53 pm Ecuación de Verosimilitud 22 ¨ ¨ La ecuación representa una condición necesaria para la existencia de un estimado MLE Condición adicional a satisfacer para asegurar que lnL(w|y) sea un máximo y no un mínimo ¤ La primera derivada no revela esta condición n ¤ Para ser un máximo, la forma de la función “log-likelihood” debe ser convexa (representar un pico y no un valle) en la vecindad de wMLE Se puede verificar con la segunda derivada de “log-likelihoods” y mostrando si son todos negativos en wi = wi,MLE para i = 1, …, k ∂2 ln L(w | y) <0 2 ∂w i 25/02/13 2:53 pm Ejemplo 23 ¨ Con L(w|n = 10, y = 7), obtenemos el log-likelihood como: 10! ln L(w | n = 10, y = 7) = ln + 7ln w + 3ln(1− w)(9) 7!3! ¨ La primera derivada del log-likelihood: d ln L(w | n = 10, y = 7) 7 3 7 −10w = − = . dw w 1− w w(1− w) ¨ Se requiere que esta ecuación sea cero y el estimado MLE deseado se obtiene como: wMLE = 0.7 25/02/13 2:53 pm Ejemplo 24 ¨ Para asegurar que la solución representa un máximo y no un mínimo, se obtiene la segunda derivada del log-likelihood en w = wMLE d 2 ln L(w | n = 10, y = 7) 7 3 = 2− = −47.62 < 0. 2 2 dw w (1− w) ¨ es negativo, como se desea. 25/02/13 2:53 pm Ecuación de Verosimilitud 25 ¨ En la práctica, (usualmente) no es posile obtener una solución en forma analítica para el estimado MLE ¤ Aún más cuando el modelo tiene muchos parámetros y su PDF es altamente no-lineal. ¤ En esas situaciones, el estimado MLE se debe ser buscado numéricamente usando algoritmos de optimización nolineales n Buscar subconjuntos mucho más pequeños del espacio de parámetros multi-dimensional, en lugar de búsqueda exhaustiva de todo el espacio de parámetros n Intratable conforme aumenta el número de parámetros 25/02/13 2:53 pm Ecuación de Verosimilitud 26 94 I.J. Myung / Journal of Mathematical Psychology 47 (2003) 90–100 Fig. 3. A schematic plot of the log-likelihood function for a fictitious one-parameter model. Point B is the global maximum whereas points A and C are two local maxima. The series of arrows depicts an iterative optimization process. searching much smaller sub-sets of the multi-dimensional parameter space rather than exhaustively searching the whole parameter space, which becomes tries to improve upon an initial set of parameters that is 25/02/13 2:53 pm are chosen supplied by the user. Initial parameter values either at random or by guessing. Depending upon the Referencia 27 ¨ In Jae Myung, Tutorial on maximum likelihood estimation. Journal of Mathematical Psychology 47, pp. 90 – 100, 2003. 25/02/13 2:53 pm