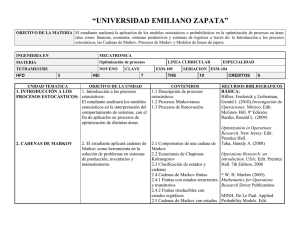

TOMA DE DECISIONES DE AGENTES RACIONALES CON

Anuncio