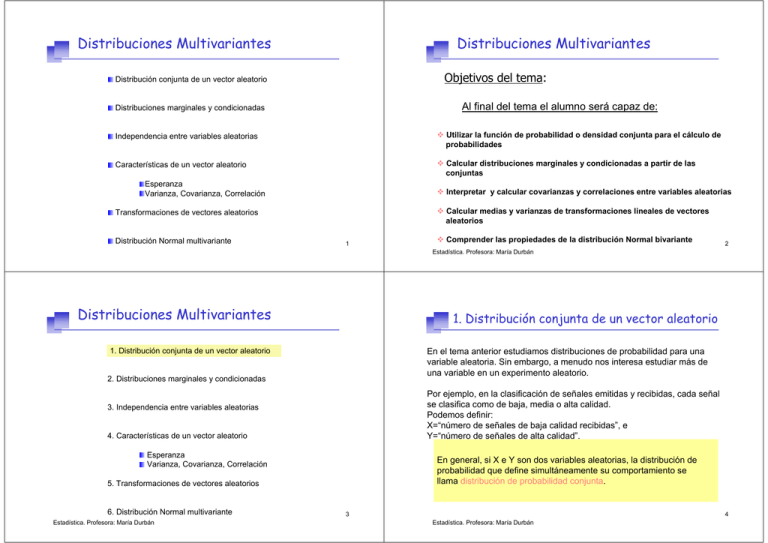

Distribuciones Multivariantes Distribuciones Multivariantes

Anuncio

Distribuciones Multivariantes

Distribuciones Multivariantes

Objetivos del tema:

Distribución conjunta de un vector aleatorio

Al final del tema el alumno será capaz de:

Distribuciones marginales y condicionadas

Independencia entre variables aleatorias

Utilizar la función de probabilidad o densidad conjunta para el cálculo de

probabilidades

Características de un vector aleatorio

Calcular distribuciones marginales y condicionadas a partir de las

conjuntas

Esperanza

Varianza, Covarianza, Correlación

Interpretar y calcular covarianzas y correlaciones entre variables aleatorias

Calcular medias y varianzas de transformaciones lineales de vectores

aleatorios

Transformaciones de vectores aleatorios

Distribución Normal multivariante

1

Comprender las propiedades de la distribución Normal bivariante

2

Estadística. Profesora: María Durbán

Distribuciones Multivariantes

1. Distribución conjunta de un vector aleatorio

1.

1.Distribución

Distribuciónconjunta

conjuntade

deun

unvector

vectoraleatorio

aleatorio

En el tema anterior estudiamos distribuciones de probabilidad para una

variable aleatoria. Sin embargo, a menudo nos interesa estudiar más de

una variable en un experimento aleatorio.

2. Distribuciones marginales y condicionadas

Por ejemplo, en la clasificación de señales emitidas y recibidas, cada señal

se clasifica como de baja, media o alta calidad.

Podemos definir:

X=“número de señales de baja calidad recibidas”, e

Y=“número de señales de alta calidad”.

3. Independencia entre variables aleatorias

4. Características de un vector aleatorio

Esperanza

Varianza, Covarianza, Correlación

En general, si X e Y son dos variables aleatorias, la distribución de

probabilidad que define simultáneamente su comportamiento se

llama distribución de probabilidad conjunta.

5. Transformaciones de vectores aleatorios

6. Distribución Normal multivariante

Estadística. Profesora: María Durbán

3

4

Estadística. Profesora: María Durbán

1. Distribución conjunta de un vector aleatorio

1. Distribución conjunta de un vector aleatorio

Variables discretas

Ejemplo

Dadas dos v.a. discretas, X , Y, definimos su función distribución de

probabilidad mediante la función de probabilidad conjunta:

En el desarrollo de un nuevo receptor para la transmisión de información

digital, cada bit recibido se clasifica como aceptable, sospechoso o no

aceptable, dependiendo de la calidad de la señal recibida.

Se transmiten 4 bits y se definen las siguientes v.a.:

p( x, y ) = Pr( X = x, Y = y )

Como en el caso unidimensional está función debe verificar:

p ( x, y ) ≥ 0

X = Número de bits aceptables

Y = Número de bits sospechosos

∑∑ p( x, y) = 1

x

y

La función de distribución conjunta:

F ( x0 , y0 ) = Pr( X ≤ x0 , Y ≤ y0 ) =

∑ ∑ Pr( X = x, Y = y)

x ≤ x0 y ≤ y0

5

Estadística. Profesora: María Durbán

6

Estadística. Profesora: María Durbán

1. Distribución conjunta de un vector aleatorio

1. Distribución conjunta de un vector aleatorio

Ejemplo

Ejemplo

En el desarrollo de un nuevo receptor para la transmisión de información

digital, cada bit recibido se clasifica como aceptable, sospechoso o no

aceptable, dependiendo de la calidad de la señal recibida.

Se transmiten 4 bits y se definen las siguientes v.a.:

Y

p ( x, y ) ≥ 0

∑∑ p( x, y) = 1

x

y

Estadística. Profesora: María Durbán

4

4.1x10-5

3

4.1x10-5

2

1.54x10-5 1.38x10-3 3.11x10-2

1.84x10-3

Pr( X ≤ 1, Y ≤ 2)

1

2.56x10-6 3.46x10-4 1.56x10-2

0.2333

0

1.6x10-7 2.88x10-5

7.83x10-2

0

En el desarrollo de un nuevo receptor para la transmisión de información

digital, cada bit recibido se clasifica como aceptable, sospechoso o no

aceptable, dependiendo de la calidad de la señal recibida.

Se transmiten 4 bits y se definen las siguientes v.a.:

Y

1

1.94x10-3

2

3

0.6561

4

X

7

Estadística. Profesora: María Durbán

4

4.1x10-5

3

4.1x10-5

2

1.54x10-5 1.38x10-3 3.11x10-2

1.84x10-3

1

2.56x10-6 3.46x10-4 1.56x10-2

0.2333

0

1.6x10-7 2.88x10-5

7.83x10-2

0

1

1.94x10-3

2

3

0.6561

4

X

8

1. Distribución conjunta de un vector aleatorio

1. Distribución conjunta de un vector aleatorio

Distribución Multinomial

Ejemplo

Un experimento se repite n veces de forma independiente:

Las probabilidades de que cierta lámpara de un modelo de proyector dure

menos de 40 horas, entre 40 y 80 horas, y más de 80 horas de uso son

0.3 ; 0.5 y 0.2 respectivamente.

1. El experimento tiene k posibles resultados

2. La probabilidad de cada resultado, p1 , p2 ,K pk se mantiene constante

Calcular la probabilidad de que entre 8 de tales lámparas, 2 duren menos de

40 horas; cinco duren entre 40 y 80 horas, y una dure más de 80 horas.

La variable X i = el número de veces que ocurre el resultado i-ésimo

Hay 3 resultados posibles:

X 1 = dura < 40 → p1 = 0.3

X 1 , X 2 , K X k siguen una distribución multinomial con función de probabilidad

X 2 = dura 40 − 80 → p2 = 0.5

conjunta:

X 3 = dura > 80 → p3 = 0.2

n!

p1x1 p2x2 K pkxk

Pr( X 1 = x1 , X 2 = x2 , K, X k = xk ) =

x1 ! x2 !K xk !

x1 + x2 + K + xk = n

Pr( X 1 = 2, X 2 = 5, X 3 = 1) =

p1 + p2 + K + pk = 1

8!

0.32 0.550.2 = 0.095

2!5!1!

9

Estadística. Profesora: María Durbán

10

Estadística. Profesora: María Durbán

1. Distribución conjunta de un vector aleatorio

1. Distribución conjunta de un vector aleatorio

Variables continuas

Variables continuas

Dadas dos v.a. continuas, X , Y definimos su función distribución de

probabilidad mediante la función de densidad conjunta:

La probabilidad ahora se calcula como un volumen:

Pr(a ≤ X ≤ b, c ≤ Y ≤ d ) = ∫

b

a

f ( x, y )

∫

d

c

f ( x, y )dxdy

Como en el caso unidimensional está función debe verificar:

f ( x, y ) ≥ 0

+∞

+∞

−∞

−∞

∫ ∫

f ( x, y )dxdy = 1

Pr(−1 ≤ X ≤ 1, −1.5 ≤ Y ≤ 1.5)

La función de distribución conjunta:

2

d F ( x, y )

f

(

x

,

y

)

=

F ( x , y ) = Pr( X ≤ x , Y ≤ y ) = ∫ ∫

dxdy

y0

0

0

Estadística. Profesora: María Durbán

0

0

x0

−∞ −∞

f ( x, y )dxdy

11

12

Estadística. Profesora: María Durbán

1. Distribución conjunta de un vector aleatorio

1. Distribución conjunta de un vector aleatorio

Variables continuas

Ejemplo

La probabilidad ahora se calcula como un volumen:

Pr(a ≤ X ≤ b, c ≤ Y ≤ d ) = ∫

b

a

∫

d

c

Sea X la variable aleatoria que representa el tiempo hasta que un servidor

se conecta con tu ordenador (en milisegundos) e Y el tiempo hasta que el

servidor te autoriza como usuario.

f ( x, y )dxdy

La función de densidad conjunta viene dada por:

f ( x, y ) = 6 ×10−6 exp(−0.001x − 0.002 y )

Pr(−1 ≤ X ≤ 1, −1.5 ≤ Y ≤ 1.5)

0< x< y

¿ Pr( X < 1000, Y < 2000) ?

13

Estadística. Profesora: María Durbán

14

Estadística. Profesora: María Durbán

1. Distribución conjunta de un vector aleatorio

1. Distribución conjunta de un vector aleatorio

Ejemplo

Ejemplo

f ( x, y ) = 6 ×10−6 exp(−0.001x − 0.002 y )

f ( x, y ) = 6 ×10−6 exp(−0.001x − 0.002 y )

0< x< y

¿ Pr( X < 1000, Y < 2000) ?

0< x< y

¿ Pr( X < 1000, Y < 2000) ?

Y

Y

3000

3000

Recinto donde la función de

densidad no es 0

2000

2000

Recinto de integración para el cálculo

de esa probabilidad

1000

1000

1000 2000 3000

Estadística. Profesora: María Durbán

X

15

1000 2000 3000

Estadística. Profesora: María Durbán

X

16

1. Distribución conjunta de un vector aleatorio

1. Distribución conjunta de un vector aleatorio

Ejemplo

f ( x, y ) = 6 ×10−6 exp(−0.001x − 0.002 y )

Y

Pr( X < 1000, Y < 2000) = ∫

1000

0

∫

y

0

Ejemplo

f ( x, y ) = 6 ×10−6 exp(−0.001x − 0.002 y )

0< x< y

Y

f ( x, y )dxdy +

Pr( X < 1000, Y < 2000) = ∫

1000

0

3000

y

0

f ( x, y )dxdy + ∫

2000

1000

∫

1000

0

f ( x, y )dxdy

= 0.915

3000

2000

∫

0< x< y

2000

x=y

x=y

1000

1000

1000 2000 3000

X

17

Estadística. Profesora: María Durbán

1000 2000 3000

X

18

Estadística. Profesora: María Durbán

Distribuciones Multivariantes

2. Distribuciones marginales

Si se definen más de una v.a. en un experimento, es importante

distinguir entre la distribución de probabilidad conjunta y la distribución

de probabilidad de cada variable individualmente. A la distribución de

cada variable se le denomina distribución marginal.

1. Distribución conjunta de un vector aleatorio

2. Distribuciones marginales y condicionadas

Variables Discretas

3. Independencia entre variables aleatorias

Dadas dos v.a. discretas, X , Y con función de probabilidad conjunta

p( x, y ) las funciones de probabilidad marginales de ambas variables son:

4. Características de un vector aleatorio

p X ( x) = Pr( X = x) = ∑ Pr( X = x, Y = y )

Esperanza

Varianza, Covarianza, Correlación

∀y

pY ( y ) = Pr(Y = y ) = ∑ Pr( X = x, Y = y )

∀x

5. Transformaciones de vectores aleatorios

6. Distribución Normal multivariante

Estadística. Profesora: María Durbán

Son funciones de probabilidad

19

Se puede calcular su esperanza,

varianza, etc.

20

Estadística. Profesora: María Durbán

2. Distribuciones marginales

2. Distribuciones marginales

Ejemplo

Ejemplo

En el desarrollo de un nuevo receptor para la transmisión de información

digital, cada bit recibido se clasifica como aceptable, sospechoso o no

aceptable, dependiendo de la calidad de la señal recibida.

Se transmiten 4 bits y se definen las siguientes v.a.:

Y

X = Número de bits aceptables

Las funciones de probabilidad 4 4.1x10

Y = Número de bits sospechosos

En el desarrollo de un nuevo receptor para la transmisión de información

digital, cada bit recibido se clasifica como aceptable, sospechoso o no

aceptable, dependiendo de la calidad de la señal recibida.

Se transmiten 4 bits y se definen las siguientes v.a.:

Y

X = Número de bits aceptables

Las funciones de probabilidad

Y = Número de bits sospechosos

-5

marginal se obtendrían

sumando en ambas

direcciones.

3

4.1x10-5

2

1.54x10-5 1.38x10-3 3.11x10-2

1.84x10-3

1

2.56x10-6 3.46x10-4 1.56x10-2

0.2333

0

1.6x10-7 2.88x10-5

7.83x10-2

0

Estadística. Profesora: María Durbán

1

1.94x10-3

2

3

marginal se obtendrían

sumando en ambas

direcciones.

0.0001 0.0036

0.6561

4

X

21

0

Estadística. Profesora: María Durbán

0.0486

1

2

0.2916

3

0.6561

4

X

22

2. Distribuciones marginales

2. Distribuciones marginales

Ejemplo

Ejemplo

En el desarrollo de un nuevo receptor para la transmisión de información

digital, cada bit recibido se clasifica como aceptable, sospechoso o no

aceptable, dependiendo de la calidad de la señal recibida.

Se transmiten 4 bits y se definen las siguientes v.a.:

Y

X = Número de bits aceptables

Las funciones de probabilidad 4 4.1x10

Y = Número de bits sospechosos

En el desarrollo de un nuevo receptor para la transmisión de información

digital, cada bit recibido se clasifica como aceptable, sospechoso o no

aceptable, dependiendo de la calidad de la señal recibida.

Se transmiten 4 bits y se definen las siguientes v.a.:

Y

X = Número de bits aceptables

Las funciones de probabilidad 4 0.00004

Y = Número de bits sospechosos

-5

marginal se obtendrían

sumando en ambas

direcciones

Estadística. Profesora: María Durbán

3

4.1x10-5

2

1.54x10-5 1.38x10-3 3.11x10-2

1

2.56x10-6 3.46x10-4 1.56x10-2

0.2333

0

1.6x10-7 2.88x10-5

7.83x10-2

0

1.84x10-3

1

1.94x10-3

2

3

marginal se obtendrían

sumando en ambas

direcciones

0.6561

4

X

23

Estadística. Profesora: María Durbán

3

0.00188

2

0.03250

1

0.24925

0

0.71637

X

24

2. Distribuciones marginales

2. Distribuciones marginales

Variables Continuas

Ejemplo

Dadas dos v.a. continuas, X , Y con función de densidad conjunta f ( x, y )

las funciones de densidad marginal de ambas variables son:

f X ( x) = ∫

+∞

−∞

fY ( y ) = ∫

+∞

−∞

f ( x, y )dy

f ( x, y )dx

Sea X la variable aleatoria que representa el tiempo hasta que un servidor

se conecta con tu ordenador (en milisegundos) e Y el tiempo hasta que el

servidor te autoriza como usuario.

La función de densidad conjunta viene dada por

Son funciones de densidad

Se puede calcular su esperanza,

varianza, etc.

f ( x, y ) = 6 ×10−6 exp(−0.001x − 0.002 y )

0< x< y

0.4

¿ Pr(Y > 2000) ?

f(x)

0.3

0.2

0.1

0.0

-4

-2

0

2

x

4

25

Estadística. Profesora: María Durbán

26

Estadística. Profesora: María Durbán

2. Distribuciones marginales

2. Distribuciones marginales

Ejemplo

Ejemplo

f ( x, y ) = 6 ×10−6 exp(−0.001x − 0.002 y )

f ( x, y ) = 6 ×10−6 exp(−0.001x − 0.002 y )

0< x< y

¿ Pr(Y > 2000) ?

0< x< y

¿ Pr(Y > 2000) ?

Y

Y

Podemos resolverlo de dos formas:

Podemos resolverlo de dos formas:

Integrar la función de densidad conjunta

en el recinto adecuado

3000

Calcular la función de densidad marginal

de Y y calcular esa probabilidad

2000

1000

27

Estadística. Profesora: María Durbán

Integrar la función de densidad conjunta

en el recinto adecuado

Pr(Y > 2000) = ∫

+∞

∫

y

2000 0

1000 2000 3000

Estadística. Profesora: María Durbán

X

f ( x, y )dxdy = 0.05

28

2. Distribuciones marginales

2. Distribuciones marginales

Ejemplo

Ejemplo

f ( x, y ) = 6 ×10−6 exp(−0.001x − 0.002 y )

f ( x, y ) = 6 ×10−6 exp(−0.001x − 0.002 y )

0< x< y

¿ Pr(Y > 2000) ?

Y

¿ Pr(Y > 2000) ?

Y

Y

Y

Podemos resolverlo de dos formas:

Podemos resolverlo de dos formas:

Calcular la función de densidad marginal

de Y y calcular esa probabilidad

3000

2000

0< x< y

y

fY ( y ) = ∫ f ( x, y )dx = 6 × 10−3 e −0.002 y (1 − e −0.001 y )

0

Calcular la función de densidad marginal

de Y y calcular esa probabilidad

3000

2000

y>0

Pr(Y > 2000) = ∫

+∞

2000

1000

fY ( y )dy = 0.05

1000

0

0

1000 2000 3000

X

29

Estadística. Profesora: María Durbán

30

Estadística. Profesora: María Durbán

2. Distribuciones condicionadas

2. Distribuciones condicionadas

Cuando se definen más de una v.a. en un experimento, el conocimiento

de una de las variables puede afectar a las probabilidades que se asocian

con los valores de la otra variable

Cuando se definen más de una v.a. en un experimento, el conocimiento

de una de las variables puede afectar a las probabilidades que se asocian

con los valores de la otra variable

Recordemos del Tema de Probabilidad el Teorema de Bayes:

Pr (B A ) =

Pr (A I B )

Pr (A )

Variables Discretas

Mide el tamaño

de uno con

respecto al otro

Dadas dos v.a. discretas, X , Y con función de probabilidad conjunta

p( x, y ) la funcion de probabilidad de Y condicionada a X=x0:

p ( y | x0 ) =

Para un valor genérico de x

p( y | x ) =

31

Estadística. Profesora: María Durbán

p(x0 , y ) Pr ( X = x0 , Y = y )

=

p X (x0 )

Pr ( X = x0 )

p (x, y ) Pr ( X = x, Y = y )

=

p X (x )

Pr ( X = x )

Podemos calcular su esperanza, varianza, etc.

Estadística. Profesora: María Durbán

A∩ B

A

p X ( x0 ) > 0

p ( x, y ) = p ( y | x ) p X ( x )

32

2. Distribuciones condicionadas

2. Distribuciones condicionadas

Ejemplo

Ejemplo

En el desarrollo de un nuevo receptor para la transmisión de información

digital, cada bit recibido se clasifica como aceptable, sospechoso o no

aceptable, dependiendo de la calidad de la señal recibida.

Se transmiten 4 bits y se definen las siguientes v.a.:

En el desarrollo de un nuevo receptor para la transmisión de información

digital, cada bit recibido se clasifica como aceptable, sospechoso o no

aceptable, dependiendo de la calidad de la señal recibida.

Se transmiten 4 bits y se definen las siguientes v.a.:

X = Número de bits aceptables

Y = Número de bits sospechosos

X = Número de bits aceptables

Y = Número de bits sospechosos

Como sólo se transmiten 4 bits, si X=3, Y=0 ó 1

Como sólo se transmiten 4 bits, si X=4, necesariamente Y=0

si X=3, Y=0 ó 1

Pr(Y = 0, X = 3) 0.05832

=

= 0.2

Pr(Y = 0 | X = 3) + Pr(Y = 1| X = 3) = 1

Pr( X = 3)

0.2916

Pr(Y = 1, X = 3) 0.2333

=

= 0.8

Pr(Y = 1| X = 3) =

E[Y | X = 3] = 0 × 0.2 + 1× 0.8 = 0.8

Pr( X = 3)

0.2916

Pr(Y = 0 | X = 3) =

M

Saber lo que vale X cambia la probabilidad asociada con los valores de Y

33

Estadística. Profesora: María Durbán

Número esperado de bits sospechosos cuando el número de aceptables es 3

2. Distribuciones condicionadas

2. Distribuciones condicionadas

Variables Continuas

Ejemplo

Dadas dos v.a. continuas, X , Y con función de densidad conjunta f ( x, y )

la función de densidad de Y condicionada a X

f ( y | x) =

f ( x, y )

f X ( x)

34

Estadística. Profesora: María Durbán

Sea X la variable aleatoria que representa el tiempo hasta que un servidor

se conecta con tu ordenador (en milisegundos) e Y el tiempo hasta que el

servidor te autoriza como usuario.

La función de densidad conjunta viene dada por

Es función de densidad

Se puede calcular su esperanza,

varianza, etc.

f ( x, y ) = 6 ×10−6 exp(−0.001x − 0.002 y )

0< x< y

¿Cuál será la probabilidad de que el tiempo hasta que el servidor te autoriza

como usuario sea más de 2000 milisegundos si el tiempo que ha tardado el

servidor en conectarse ha sido 1500 milisegundos?

f ( x, y ) = f ( y | x ) f X ( x )

¿ Pr(Y > 2000 | X = 1500) ?

35

Estadística. Profesora: María Durbán

36

Estadística. Profesora: María Durbán

2. Distribuciones condicionadas

2. Distribuciones condicionadas

Ejemplo

Ejemplo

f ( x, y ) = 6 ×10−6 exp(−0.001x − 0.002 y )

f ( x, y ) = 6 ×10−6 exp(−0.001x − 0.002 y )

0< x< y

¿ Pr(Y > 2000 | X = 1500) ?

Y

Y

f ( y | x) =

3000

f X ( x) = ∫

2000

+∞

x

1000

¿ Pr(Y > 2000 | X = 1500) ?

Y

Y

f ( x, y )

f X ( x)

f ( x, y )dy = 0.003e −0.003 x

f ( y | x) = 0.002e

0.002 x − 0.002 y

0< x< y

f ( y | x) = 0.002e0.002 x −0.002 y 0 < x < y

3000

x>0

0< x< y

+∞

2000

Pr(Y > 2000 | X = 1500) = ∫

1000

=∫

2000

+∞

2000

f ( y | X = 1500)dy

0.002e3−0.002 y dy

= 0.368

0

0

1000 2000 3000

X

37

Estadística. Profesora: María Durbán

1000 2000 3000

X

38

Estadística. Profesora: María Durbán

Distribuciones Multivariantes

3. Independencia entre variables aleatorias

En algunos experimentos, el conocimiento de una de las variables puede

no afectar ninguna de las probabilidades que se asocian con los valores

de la otra variable

1. Distribución conjunta de un vector aleatorio

2. Distribuciones marginales y condicionadas

3.Independencia

Independenciaentre

entrevariables

variablesaleatorias

aleatorias

3.

Recordemos del Tema de Probabilidad:

4. Características de un vector aleatorio

Pr ( A ∩ B ) = Pr ( A) Pr (B )

Pr ( A | B ) = Pr ( A)

Pr (B | A) = Pr (B )

Esperanza

Varianza, Covarianza, Correlación

5. Transformaciones de vectores aleatorios

6. Distribución Normal multivariante

Estadística. Profesora: María Durbán

39

40

Estadística. Profesora: María Durbán

3. Independencia entre variables aleatorias

3. Independencia entre variables aleatorias

Variables Discretas

Variables Continua

Diremos que dos variables X , Y son independientes si:

p ( y | x) = pY ( y )

Diremos que dos variables X , Y son independientes si:

p ( x | y ) = p X ( x)

f ( y | x ) = fY ( y )

f ( x | y ) = f X ( x)

f ( x, y ) = f ( x | y ) fY ( y ) = f X ( x ) fY ( y )

p ( x, y ) = p ( x | y ) pY ( y ) = p X ( x) pY ( y ) ∀x, y

41

Estadística. Profesora: María Durbán

∀x, y

42

Estadística. Profesora: María Durbán

Distribuciones Multivariantes

3. Independencia entre variables aleatorias

Ejemplo

1. Distribución conjunta de un vector aleatorio

Sea X la variable aleatoria que representa el tiempo hasta que un servidor

se conecta con tu ordenador (en milisegundos) e Y el tiempo hasta que el

servidor te autoriza como usuario.

La función de densidad conjunta viene dada por

f ( x, y ) = 6 ×10−6 exp(−0.001x − 0.002 y )

2. Distribuciones marginales y condicionadas

3. Independencia entre variables aleatorias

0< x< y

4. Características de un vector aleatorio

Esperanza

Varianza, Covarianza, Correlación

f ( y | x) = 0.002e0.002 x −0.002 y 0 < x < y

≠

5. Transformaciones de vectores aleatorios

Para todos los valores de x

fY ( y ) = 6 ×10−3 e −0.002 y (1 − e −0.001 y )

y>0

43

Estadística. Profesora: María Durbán

6. Distribución Normal multivariante

Estadística. Profesora: María Durbán

44

4. Características de un vector aleatorio

4. Características de un vector aleatorio

Covarianza

X1

X

Dadas n v.a. X 1 , X 2 ,K, X n definimos el vector n-dimensional X = 2

M

Xn

Primero comenzamos por definir la covarianza entre dos variables:

Es una medida de la relación lineal entre dos variables

La función de probabilidad/densidad del vector es la función de

probabilidad/densidad conjunta de los componentes del vector.

Cov( X , Y ) = E ( X − E [ X ]) (Y − E [Y ]) = E [ XY ] − E [ X ] E [Y ]

Esperanza

Propiedades

Se define el vector de medias como el vector cuyas componentes son

las medias o esperanzas de cada componente.

E [ X1 ]

E [ X 2 ]

µ = E [ X] =

M

E [ X n ]

Si X , Y son independientes ⇒ Cov( X , Y ) = 0 ya que E [ XY ] = E [ X ] E [Y ]

Si Cov( X , Y ) = 0 ⇒ X , Y sean independientes

Si hacemos un cambio de origen y escala:

45

Estadística. Profesora: María Durbán

Z = aX + b

W = cY + d

⇒ Cov(Z ,W ) = acCov( X , Y )

46

Estadística. Profesora: María Durbán

4. Características de un vector aleatorio

4. Características de un vector aleatorio

Covarianza

Cov( X , Y ) = E ( X − E [ X ]) (Y − E [Y ]) = E [ XY ] − E [ X ] E [Y ]

¿Cómo lo calculamos?

Necesitamos calcular la esperanza de una función de dos variables

aleatorias:

E [ h( X , Y ) ] =

´Covarianza positiva

Covarianza cero

Hay relación

pero no

lineal

∑∑ h( x, y) p( x, y)

x

y

+∞

+∞

−∞

−∞

∫ ∫

h( x, y ) f ( x, y )dxdy

47

Estadística. Profesora: María Durbán

Covarianza

negativa

Estadística. Profesora:

María Durbán

Covarianza cero

48

4. Características de un vector aleatorio

4. Características de un vector aleatorio

Ejemplo

Correlación

En el desarrollo de un nuevo receptor para la transmisión de información

digital, cada bit recibido se clasifica como aceptable, sospechoso o no

aceptable, dependiendo de la calidad de la señal recibida.

Se transmiten 4 bits y se definen las siguientes v.a.:

La correlación entre dos variables también es una medida de la relación

lineal entre dos variables

ρ ( X ,Y ) =

X = Número de bits aceptables

Y = Número de bits sospechosos

Cov( X , Y )

Var [ X ]Var [Y ]

¿Es la covarianza entre X e Y positiva o negativa?

Si X , Y son independientes ⇒ ρ ( X , Y ) = 0

ya que Cov ( X , Y ) = 0

| ρ ( X , Y ) |≤ 1

Sabemos que X + Y ≤ 4 ⇒ cuando Y se acerca a 4, X se acerca a 0

Por lo tanto la covarianza es negativa.

Si

Y = aX + b ⇒| ρ ( X , Y ) |= 1

49

Estadística. Profesora: María Durbán

Distribuciones Multivariantes

4. Características de un vector aleatorio

Matriz de Varianzas y Covarianzas

1. Distribución conjunta de un vector aleatorio

Dadas n v.a. X 1 , X 2 ,K, X n llamamos matriz de varianzas y covarianzas

del vector X a la matriz cuadrada de orden n:

2. Distribuciones marginales y condicionadas

Var [ X 1 ]

Cov [ X 1 , X 2 ] L Cov [ X 1 , X n ]

M

M

Cov [ X 1 , X 2 ]

Var [ X 2 ]

M X = E ( X - µ )( X - µ )′ =

M

M

O

M

L

L

Var [ X n ]

Cov [ X 1 , X n ]

3. Independencia entre variables aleatorias

4. Características de un vector aleatorio

Esperanza

Varianza, Covarianza, Correlación

Propiedades

5. Transformaciones

Transformaciones de

de vectores

vectores aleatorios

aleatorios

5.

Simétrica (ella y su matriz traspuesta coinciden)

Semidefinida positiva (todos sus autovalores son ≥ 0)

51

Estadística. Profesora: María Durbán

50

Estadística. Profesora: María Durbán

6. Distribución Normal multivariante

Estadística. Profesora: María Durbán

52

5. Transformaciones de vectores aleatorios

5. Transformaciones de vectores aleatorios

Al igual que en el caso univariante, hay ocasiones en que es necesario

calcular la distribución de probabilidad de una función de dos o más v.a.

Si Y tiene menor dimensión que X, completamos Y con elementos

de X hasta completar la misma dimensión.

Dado un vector aleatorio X con función de densidad conjunta f ( X),

lo transformamos en otro vector aleatorio Y de la misma dimensión

mediante una función g

y1 = g1 ( x1 , K , xn )

M

yn = g n ( x1 , K, xn )

dX

dY

f X1 X 2 ( x1 , x2 ) =

Existen las

transformaciones

inversas

y2 = g 2 ( x1 , K, xn )

f (Y) = f ( g −1 (Y))

Ejemplo

dx1

dy1

dX

= M

dY

dxn

dy1

1. Definimos Y2 = X 2

M

dxn

dyn

0 < x1 , x2 < 1

en el resto

Calcular la función de densidad de Y1 = X 1 + X 2

dx1

L

dyn

L

4 x1 x2

0

2. Buscamos la distribución conjunta de Y = (Y1 , Y2 )

3. Calculamos la marginal de Y1

53

Estadística. Profesora: María Durbán

54

Estadística. Profesora: María Durbán

5. Transformaciones de vectores aleatorios

5. Transformaciones de vectores aleatorios

Ejemplo

f X1 X 2 ( x1 , x2 ) =

4 x1 x2

0

Ejemplo

0 < x1 , x2 < 1

en el resto

(x1 =0,x 2 =0) → (y1 = 0 + 0, y2 = 0)

Y1 = X 1 + X 2

(x1 =0,x 2 =1) → (y1 = 1 + 0, y2 = 1)

Y2 = X 2

Buscamos la distribución conjunta de Y = (Y1 , Y2 )

f (Y) = f ( g −1 (Y))

0 < x1 , x2 < 1

dX

dY

(0,1)

(x1 =1,x 2 =0) → (y1 = 1 + 0, y2 = 0)

(x1 =1,x 2 =1) → (y1 = 1 + 1, y2 = 1)

(1,1)

g ( X) = ( X 1 + X 2 , X 2 ) → g −1 (Y) = (Y1 − Y2 , Y2 )

1

424

3 {

Y1

dX 1 −1

=

=1

dY 0 1

Y2

f (Y ) = 4( y1 − y2 ) y2

(0,0)

¿En−1 qué recinto está definida?

f ( g (Y)) = 4( y1 − y2 ) y2

55

Estadística. Profesora: María Durbán

(1,0)

56

Estadística. Profesora: María Durbán

5. Transformaciones de vectores aleatorios

5. Transformaciones de vectores aleatorios

Ejemplo

Ejemplo

Calculamos las 4 rectas que delimitan el recinto:

0 < x1 , x2 < 1

(x1 =0,x 2 =0) → (y1 = 0 + 0, y2 = 0)

0 < x1 , x2 < 1

Y1 = X 1 + X 2

(x1 =0,x 2 =1) → (y1 = 1 + 0, y2 = 1)

Y1 = X 1 + X 2

y2 = 1

Y2 = X 2

y1 − y2 = 0

(x1 =1,x 2 =0) → (y1 = 1 + 0, y2 = 0)

Y2 = X 2

(x1 =1,x 2 =1) → (y1 = 1 + 1, y2 = 1)

(1,1)

(1,1)

(0,1)

y2 = 0

y1 − y2 = 1

(2,1)

1

y1 − y2 = 0

y1 − y2 = 1

(0,0)

(0,0)

(1,0)

2

(1,0)

Estadística. Profesora: María Durbán

58

5. Transformaciones de vectores aleatorios

Ejemplo

Convolución de X1 y X2

Si X1 y X2 son variables aleatorias independientes con funciones de

densidad f X ( x1 ) y f X ( x2 ), la función de densidad de Y = X 1 + X 2 es

Calculamos la marginal de Y1

1

1

fY1 ( y1 ) =

− y2 ) y2 ∂y2 =

0

0 < y1 < 1 0 < y2 < y1

Estadística. Profesora: María Durbán

5. Transformaciones de vectores aleatorios

∫ 4( y

f (Y) = 4( y1 − y2 ) y2

1 < y2 < 2 y1 -1 < y2 < 1

57

y1

0 < y1 < 1 0 < y2 < y1

1 < y2 < 2 y1 -1 < y2 < 1

3 3

y1

2

0 < y1 < 1

2

fY ( y ) = ∫

+∞

−∞

1

8

3 3

∫y −1 4( y1 − y2 ) y2∂y2 = − 3 + 4 y1 − 2 y1 1 < y1 < 2

1

f X1 ( y − x) f X 2 ( x)∂x

Se utiliza en casos como la transformada de Fourier

59

Estadística. Profesora: María Durbán

60

Estadística. Profesora: María Durbán

5. Transformaciones de vectores aleatorios

5. Transformaciones de vectores aleatorios

Un caso que merece mención especial es el cálculo de esperanzas y

varianzas de transformaciones lineales:

Un caso que merece mención especial es el cálculo de esperanzas y

varianzas de transformaciones lineales:

Ym×1 = A m×n X n×1 m ≤ n

Ym×1 = A m×n X n×1 m ≤ n

E [ Y ] = AE [ X ]

E [ Y ] = AE [ X ]

Var [ Y ] = AM X A′

Var [ Y ] = AM X A′

Ejemplo

Ejemplo

Y = X1 + X 2

E [ Y ] = E [ X1 ] + E [ X 2 ]

X

⇒ Y = (1 1) 1

X2

X

⇒ Y = (1 −1) 1

X2

Y = X1 − X 2

Var [ X1 ]

Cov( X1 , X 2 ) 1

Var [ Y ] = (1 1)

= Var [ X1 ] + Var [ X 2 ] + 2Cov( X1 , X 2 )

(

X

,

X

)

Cov

Var [ X 2 ] 1

1

2

61

Estadística. Profesora: María Durbán

E [ Y ] = E [ X1 ] − E [ X 2 ]

Var [ X1 ]

Cov( X1 , X 2 ) 1

= Var [ X1 ] + Var [ X 2 ] − 2Cov( X1 , X 2 )

Var [ Y ] = (1 −1)

(

X

,

X

)

Cov

Var [ X 2 ] −1

1

2

62

Estadística. Profesora: María Durbán

5. Transformaciones de vectores aleatorios

5. Transformaciones de vectores aleatorios

Ejemplo

Un caso que merece mención especial es el cálculo de esperanzas y

varianzas de transformaciones lineales:

Una pieza en forma de U está formada por tres partes, A, B y C. La longitud

de A sigue una distribución Normal con media 10mm y desviación típica

0.1mm. El grosor de las partes B y C se distribuye normalmente con media

2mm y desviación típica 0.05mm.

Suponiendo que las dimensiones de las partes son independientes:

Ym×1 = A m×n X n×1 m ≤ n

E [ Y ] = AE [ X ]

Var [ Y ] = AM X A′

1. Determinar la media y desviación típica de la distribución del hueco D.

2. En esa pieza ha de encajar otra de 5.9 mm, ¿cuál es la probabilidad de

que una pieza de esta forma sea inservible?

Caso particular: Distribución Normal

X i ~ N ( µi , σ i ) i = 1, K, n independientes

Y = a1 X 1 + a2 X 2 + K + an X n

n

E [Y ] = ∑ ai µi

i =1

D

Normal

B

Var [Y ] = ∑ ai2σ i2

A

i =1

63

Estadística. Profesora: María Durbán

C

n

64

Estadística. Profesora: María Durbán

5. Transformaciones de vectores aleatorios

5. Transformaciones de vectores aleatorios

Ejemplo

Ejemplo

2. En esa pieza ha de encajar otra de 7.9 mm, ¿cuál es la probabilidad de

que una pieza de esa forma sea inservible?

1. Determinar la media y desviación típica de la distribución del hueco D.

A ~ N (10, 0.1)

D = A− B −C

D ~ N (6, 0.015)

B ~ N (2, 0.05) C ~ N (2, 0.05)

E [ D ] = 10 − 2 − 2 = 6

5.9 − 6

Pr( D < 5.9) = Pr Z <

0.122

Pr( Z < −0.82) = 1 − Pr( Z ≤ 0.82)

Var [ D ] = 0.1 + 0.05 + 0.05 = 0.015

2

2

2

D.T [ D ] = 0.122

1 − 0.7939 = 0.2061

D

B

D

C

El 20% de las

piezas fabricadas

es inservible

A

B

C

A

65

Estadística. Profesora: María Durbán

66

Estadística. Profesora: María Durbán

Distribuciones Multivariantes

6. Distribución Normal multivariante

1. Distribución conjunta de un vector aleatorio

X

Si vector aleatorio X = 1 sigue una distribución Normal bivariante

X2

2. Distribuciones marginales y condicionadas

con vector de medias

3. Independencia entre variables aleatorias

σ2

Σ= 1

ρσ 1σ 2

4. Características de un vector aleatorio

tiene función de densidad:

Esperanza

Varianza, Covarianza, Correlación

f (X ) =

5. Transformaciones de vectores aleatorios

6. Distribución Normal multivariante

Estadística. Profesora: María Durbán

µ

µ = 1 y matriz de varianzas-covarianzas

µ2

ρσ 1σ 2

σ 22

1

(2π ) Σ

67

1/ 2

1

exp − ( X − µ)' Σ −1 ( X − µ)

2

68

Estadística. Profesora: María Durbán

The Bivariate Normal Distribution

f(x,y)

6. Distribución Normal multivariante

σ1 = σ

σ1 = σ

2

2

f (X ) =

1

(2π ) Σ

1/ 2

1

exp − ( X − µ )' Σ −1 ( X − µ)

2

ρ = 0.90

ρ=0

σ

Σ=

ρσ 1σ 2

ρσ 1σ 2

σ 22

2

1

y

σ1 = σ

ρ=0

1

( 2π ) σ 1σ 2

x

y

y

2

σ1 = σ 2

ρ = 0.9

σ1 = σ 2

ρ = − 0.9

Función de densidad

µ2

µ2

µ2

Diagrama de dispersión

µ1

f ( x1 , x2 ) =

ρ = −0.90

x

Contour Plots of the Bivariate Normal Distribution

−ρ

σ 1σ 2

1

σ 22

2

y

x

1

2

1 σ1

−1

2 2

2

∑

=

∑ = σ 1 σ 2 (1 − ρ )

(1 − ρ 2 ) − ρ

σ σ

1 2

σ1 = σ

y

y

x − µ 2 x − µ 2

x1 − µ1 x2 − µ 2

1

1

2

2

1

exp −

+

− 2ρ

2

2

(1 − ρ )

σ 1 σ 2

2(1 − ρ ) σ 1 σ 2

y

σ1 = σ

ρ=0

69

6. Distribución Normal multivariante

µ1

x

x

y

y

σ1 = σ 2

ρ = 0.9

2

σ1 = σ 2

ρ = − 0.9

µ2

µ2

Estadística. Profesora: María Durbán

µ1

x

Scatter Plots of data from the Bivariate Normal Distribution

µ1

x

µ2

µ1

x

µ1

x

6. Distribución Normal multivariante

Ejemplo

X

X= 1

X2

µ

µ= 1

µ2

σ 12

Σ=

ρσ 1σ 2

En el proceso de fabricación de lámparas electroluminiscentes (luz negra), se

depositan capas de tinta en una base de plástico. El grosor de esas capas es

determinante a la hora de satisfacer las especificaciones relativas al color e intensidad

de la luz.

Sean X e Y el grosor de dos capas de tinta, se sabe que ambas siguen una

distribución Normal, con medias 0.1mm y 0.23mm y desviaciones típicas 0.00031mm

y 0.00017mm respectivamente. La correlación entre ambas es 0.

Las especificaciones de grosor son las siguientes:

ρσ 1σ 2

σ 22

Propiedades

ρ = 0 ⇒ X 1 , X 2 independientes

0.099535 ≤ X ≤ 0.100465

0.22966 ≤ Y ≤ 0.23039

X1 ~ N ( µ1 , σ 1 ) X 2 ~ N ( µ1 , σ 1 )

X1 | X 2 y X 2 | X1 son normales

¿Cuál es la probabilidad de que una lámpara elegida

al azar satisfaga las especificaciones?

71

Estadística. Profesora: María Durbán

72

Estadística. Profesora: María Durbán

6. Distribución Normal multivariante

Ejemplo

¿Cuál es la probabilidad de que una lámpara elegida al azar satisfaga las

especificaciones?

X ~ N (0.1, 0.00031)

0.099535 ≤ X ≤ 0.100465

Y ~ N (0.23, 0.00017)

0.22966 ≤ Y ≤ 0.23039

Pr(0.099535 ≤ X ≤ 0.100465, 0.22966 ≤ Y ≤ 0.23039)

ρ = 0 → independientes

Pr(0.099535 ≤ X ≤ 0.100465) Pr(0.22966 ≤ Y ≤ 0.23039)

Pr(−1.5 ≤ Z ≤ 1.5) Pr(−2 ≤ Z ≤ 2) =

( 2 Pr(Z ≤ 1.5) − 1)( 2 Pr( Z ≤ 2) − 1)

= 0.827

73

Estadística. Profesora: María Durbán