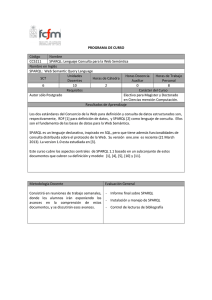

0701044_00000_0000.pdf

Anuncio