Aunque cueste reconocerlo por parte de los consumidores de

Anuncio

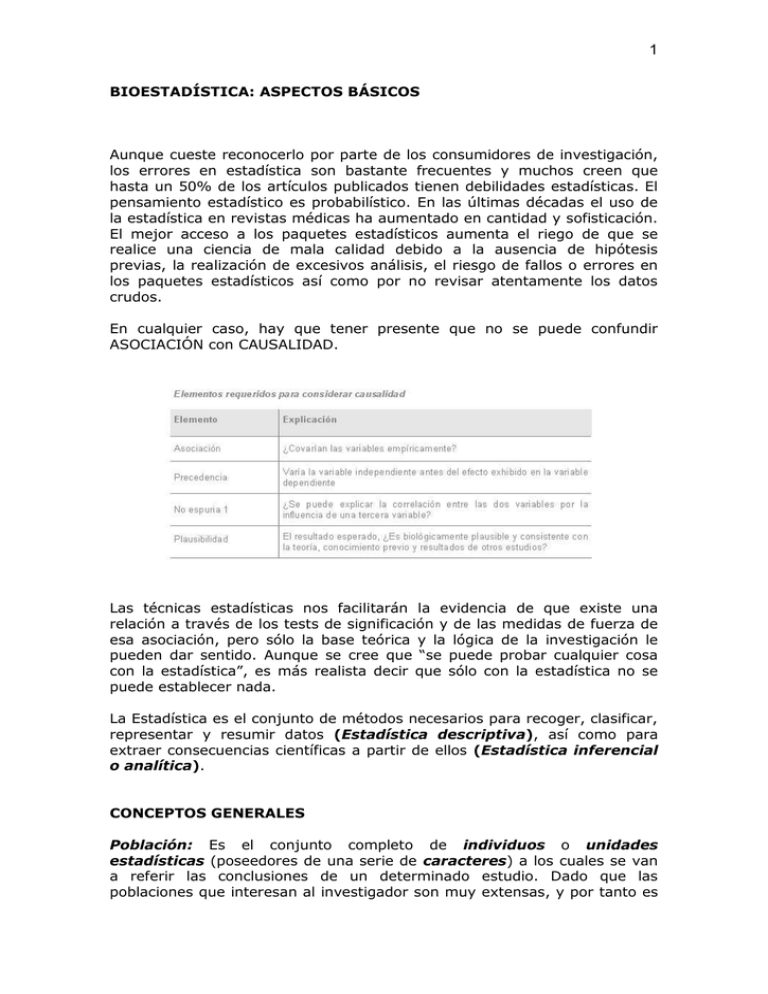

1 BIOESTADÍSTICA: ASPECTOS BÁSICOS Aunque cueste reconocerlo por parte de los consumidores de investigación, los errores en estadística son bastante frecuentes y muchos creen que hasta un 50% de los artículos publicados tienen debilidades estadísticas. El pensamiento estadístico es probabilístico. En las últimas décadas el uso de la estadística en revistas médicas ha aumentado en cantidad y sofisticación. El mejor acceso a los paquetes estadísticos aumenta el riego de que se realice una ciencia de mala calidad debido a la ausencia de hipótesis previas, la realización de excesivos análisis, el riesgo de fallos o errores en los paquetes estadísticos así como por no revisar atentamente los datos crudos. En cualquier caso, hay que tener presente que no se puede confundir ASOCIACIÓN con CAUSALIDAD. Las técnicas estadísticas nos facilitarán la evidencia de que existe una relación a través de los tests de significación y de las medidas de fuerza de esa asociación, pero sólo la base teórica y la lógica de la investigación le pueden dar sentido. Aunque se cree que “se puede probar cualquier cosa con la estadística”, es más realista decir que sólo con la estadística no se puede establecer nada. La Estadística es el conjunto de métodos necesarios para recoger, clasificar, representar y resumir datos (Estadística descriptiva), así como para extraer consecuencias científicas a partir de ellos (Estadística inferencial o analítica). CONCEPTOS GENERALES Población: Es el conjunto completo de individuos o unidades estadísticas (poseedores de una serie de caracteres) a los cuales se van a referir las conclusiones de un determinado estudio. Dado que las poblaciones que interesan al investigador son muy extensas, y por tanto es 2 imposible estudiarlas de forma completa, se va a trabajar con subconjuntos de esa población o muestras. Las técnicas estadísticas nos permiten inferir las características y relaciones existentes en la población analizando dichos aspectos en una muestra representativa (si se ha obtenido aleatoriamente). Por lo tanto, existe una única población e infinidad de muestras representativas. Parámetro: Es el valor real de cualquier característica de una población (por ejemplo el peso medio de la población de la Comunidad de Madrid, o el porcentaje de diabéticos en la población española). Cada parámetro (poblacional) puede ser estimado a partir de los datos extraídos de una muestra representativa mediante la utilización de una fórmula (una función) en la que entran esos datos obtenidos. A esa función se le denomina estadístico. Usando ese estadístico obtendremos un valor, o estimación del parámetro poblacional. P. ej: Imaginemos que conociéramos con exactitud el peso medio de la población de la CAM, que sería m = 77,4 Kg. y que extrayendo una muestra representativa de 500 personas hubiéramos sumado todos los pesos y el resultado de la suma lo hubiésemos dividido entre 500, habiendo obtenido un peso medio de m = 76,6 Kg. El valor 77,4 es el parámetro, la operación realizada con los datos observados en la muestra sería el estadístico media y el valor 76,6 es la estimación de aquel parámetro. La media de la población (parámetro) es la verdadera y tiene un único valor (m = 77,4 Kg.), mientras que al aplicar el estadístico m a cada muestra obtendremos un valor diferente). La fluctuación de las estimaciones obtenidas en torno al verdadero valor del parámetro serán tanto menores cuanto mayor sea el tamaño de las muestras. Es costumbre utilizar letras griegas para designar los parámetros poblacionales y letras latinas en el caso de las estimaciones muestrales. Variable: Se refiere a cada uno de los caracteres o aspectos que se registran en una muestra de individuos (por ejemplo la raza, la edad, el sexo, el nivel de glucemia, etc...). Cada individuo presenta una y sólo una de las posibles modalidades de ese carácter. Las variables pueden ser: 1. CUALITATIVAS O CATEGÓRICAS: Si sus modalidades no son medibles: a. Escala Nominal: No hay un orden entre las categorías: Binarias o Dicotómicas: Sólo constan de dos categorías (sexo: masculino/ femenino; afectación hepática: si/ no). Más de dos categorías: Grupo sanguíneo: A, B, O, AB. b. Escala ordinal: Las categorías son susceptibles de ordenación ascendente o descendente (afectación hepática: nula/leve /moderada/ grave). 3 CUANTITATIVAS: Si sus modalidades son medibles (datos métricos): 1. Discreta: No puede tomar cualquier valor entre dos valores dados (nº de hijos, nº de partos). 2. Continua: Puede tomar cualquier valor dentro de un intervalo (estatura, colesterolemia). Una serie de observaciones sólo queda perfectamente definida si se dan sus valores originales (datos continuos) ó su distribución de frecuencias con clases sin agrupar (datos cualitativos o discretos), pero puede ser resumida correctamente mediante una serie de medidas llamadas genéricamente medidas de una distribución de frecuencias, que son las medidas de posición y las medidas de dispersión; las cuales estudiaremos a continuación... MEDIDAS DE TENDENCIA CENTRAL O DE CENTRALIZACIÓN Son las medidas de posición más usuales y aluden a un número “central” que intenta representar a toda la muestra (“¿alrededor de que valor se encuentran los datos de mi distribución?”). Dentro de ellas tenemos: MEDIA: Existen varios tipos de media, pero cuando se habla de media sin más, nos estamos refiriendo a la media aritmética, que es igual a la suma de las observaciones dividida entre el número de observaciones. La media es sensible a las desviaciones y a los valores extremos ya que usa todos los valores en su cálculo. Sólo es una buena medida de tendencia central para las distribuciones simétricas. Es útil para datos como frecuencia cardíaca o tensión arterial, pero no para escalas como Apgar, Glasgow etc. Donde: x= media xi = elemento iésimo f i = frecuencia de aparición del elemento iésimo n = número de elementos MEDIA GEOMÉTRICA: La media geométrica G de un conjunto de números x 1, x 2,..., xn que se presentan con frecuencias f1, f2,..., fn, respectivamente será: 4 MEDIA CUADRÁTICA: La media cuadrática Q de un conjunto de números x1, x2,..., xn que se presentan con frecuencias f1, f2,..., fn, respectivamente será: MEDIDAS DE TENDENCIA CENTRAL O DE CENTRALIZACIÓN MEDIANA: La mediana de un conjunto de datos ordenados es un número (perteneciente o no a la muestra) que ocupa el valor medio de la distribución estadística. Por tanto, deja el 50% de las observaciones de la muestra por debajo y el 50% por encima. MODA: Llamamos moda de una distribución, al valor dentro del conjunto de datos que se presenta con mayor frecuencia. Es útil para describir datos nominales. RESTO DE MEDIDAS DE POSICIÓN: Análogamente a la mediana (que divide la distribución en dos partes iguales), existen otras medidas de posición genéricamente llamadas cuartiles. Las más utilizadas son los cuartiles y los percentiles. Consideraciones acerca de las medidas de posición La media aritmética es la medida de posición más utilizada ya que se basa en el total de las observaciones y matemáticamente es de fácil manejo. Su desventaja es que resulta muy influida por los valores extremos, y por ello se emplea preferentemente en distribuciones simétricas. La media geométrica es muy utilizada en microbiología y serología (a la hora de expresar titulaciones). La mediana es preferida cuando la distribución de los datos es asimétrica (y por tanto los valores extremos distorsionan el valor de la media). Como desventaja respecto de la media, pierde información, ya que no tiene en cuenta la magnitud exacta de la mayoría de las observaciones. Además no es tan manejable desde el punto de vista matemático, con vistas a la estadística analítica. La moda interesa cuando queremos estimar de forma rápida y no muy precisa una medida de tendencia central. Al igual que la mediana no se ve afectada por los valores extremos y es poco susceptible de manejo matemático 5 Aplicabilidad de las medidas de tendencia central MEDIDAS DE DISPERSIÓN Las medidas de posición nos informan acerca de cuáles son los valores de la muestra, pero no nos dicen nada de cómo son de diferentes esos datos. Si las medidas de centralización sirven para hallar un dato “central” alrededor del cual se distribuye la muestra, las medidas de dispersión nos contestan a la pregunta: “¿cómo se distribuyen esos datos alrededor del “central”?; ¿se encuentran muy agrupados, o muy dispersos?”. Estudiaremos: a. Rango, amplitud o recorrido: Diferencia entre los valores más grande y más pequeño de la muestra. Tiene la ventaja de expresarse en las mismas unidades de los datos y ser fácil de calcular. Sus desventajas son que sólo utiliza para su cálculo dos elementos de la muestra (y además los extremos), y que aumenta con el tamaño muestral. El uso de la amplitud es restringido, utilizándose cuando se desea una medida rápida de la dispersión de la muestra. Es la medida de dispersión que debe acompañar a la moda, en las escasas ocasiones en que ésta sea la medida de posición utilizada. b. Rango intercuartílico: Diferencia entre los cuartiles tercero y primero. Al igual que la anterior se emplea con fines meramente descriptivos. Se sugiere su uso para describir la variabilidad de los datos que no cumplen los estándares de análisis paramétrico como las escalas de datos ordinales y es la medida de dispersión adecuada cuando se utiliza la mediana como medida de posición. c. Desviación típica (o estándar): Raíz cuadrada de la media de los cuadrados de las desviaciones con respecto a la media de la distribución. 6 Se trata de la medida de dispersión más utilizada en la literatura científica, y es de elección cuando usamos la media como medida de posición. El 68'26% de los datos de una población con distribución normal caen dentro de más o menos una desviación estándar de la media y 95.44% de los puntos caen dentro del valor de la media más o menos 2 desviaciones estándar. En una distribución normal la desviación estándar no debería ser mayor que la mitad de la media (ya que esto es un dato de normalidad de la distribución). Es la medida de dispersión que posee más estabilidad frente a las fluctuaciones de la muestra tomada. Deberá hallarse cuando posteriormente haya que calcular otras medidas, sobre todo relacionadas con la inferencia estadística. Se basa en todos los valores de la variable, atendiendo a su magnitud y a su signo y se mide en las mismas unidades de la variable. La varianza (s2) es el cuadrado de la desviación estándar y constituye otra medida de dispersión, cuya desventaja respecto a la anterior es que se mide en unidades al cuadrado. d. Error estándar de la media: Es un estadístico derivado de la desviación estándar y se calcula como De manera que el EEM siempre va a ser más pequeño que la desviación estándar, y cuanto mayor sea n, menor será el EEM. El EEM se usa para estimar la precisión o fiabilidad de una muestra. No informa sobre la dispersión de una muestra. Es útil porque se utiliza para calcular los intervalos de confianza. Evalúa la precisión con que una muestra representa a la población original. e. Coeficiente de variación: La desviación estándar de un conjunto de mediciones se expresa con las mismas unidades que estas medidas. A veces puede ser útil describir la variabilidad expresando la desviación estándar como un porcentaje de su media. Por ejemplo, ¿qué implica mayor dispersión, 2 metros respecto de una media de 366m, ó 0,3mm respecto de una media de 1,5mm? Estamos ante 7 el coeficiente de variación, es decir, la desviación estándar medida en unidades de su media: DISTRIBUCIONES DE PROBABILIDAD Siempre que hablemos de probabilidad entenderemos por tal el límite teórico de las frecuencias relativas de un suceso cuando el número de pruebas o ensayos es infinito. La gran mayoría de los fenómenos de la naturaleza siguen exacta o aproximadamente unas pocas leyes bien conocidas que son las leyes o distribuciones de probabilidad teóricas. Las tres más importantes son la binomial, la de Poisson (ambas para variables discretas), y la Normal (para continuas). Distribución Binomial La Distribución Binomial es aquella en la que un cierto suceso sólo admite dos resultados posibles (éxito-fracaso, masculino-femenino..). Además, la probabilidad de éxito (p) y la de fracaso (q=1-p), se mantienen constantes a lo largo de todas las pruebas. Por último ha de cumplirse que todos los sucesos sean independientes entre sí, y por tanto que el resultado de cada uno de ellos no dependa de los resultados anteriores. Sea un experimento para el que únicamente se pueden presentar los sucesos A (éxito) y B = no A (fracaso), siendo p(A)= p y p(B)= q , con p+q =1. Por ej: lanzar 20 veces una moneda al aire y averiguar la probabilidad de obtener 3 caras. Se realizan n pruebas de ese experimento y queremos saber la probabilidad de obtener r éxitos en esas n pruebas. Este problema se resuelve con: siendo: p(r)= probabilidad de obtener r éxitos (que aparezca r veces el suceso A) =número combinatorio “n sobre r”, que se calcula mediante la fórmula donde n!=n.(n-1).(n-2)...3.2.1 La distribución Binomial se caracteriza por los valores n y p , que son los parámetros de la distribución. Se demuestra que la media o esperanza matemática) y la desviación estándar de la distribución son: 8 Media: Desviación estándar: Distribución De Poisson Se puede considerar como un caso límite de la binomial en la cual n es muy grande y p muy pequeño. Pero además de su utilidad como caso particular de la Binomial también tiene interés cuando sucesos iguales ocurren aleatoriamente a lo largo del tiempo o cuando pequeñas partículas se distribuyen de forma aleatoria en el espacio. La ley de poisson depende del parámetro l=n.p, da la probabilidad p(0), p(1), p(2)...etc de hallar en muestras de tamaño n un numero r de sujetos con igual característica. Se demuestra que la probabilidad de encontrar aproximadamente r sujetos con la misma característica es: siendo e=2,7182...(la base del logaritmo natural) La esperanza matemática y la varianza son: Sea por ejemplo, una población con una prevalencia de diabetes del 2%. La probabilidad de encontrar 0, 1, 2, 3,... etc diabéticos en una muestra aleatoria de 100 sujetos viene dada de forma exacta por la ley Binomial B(100;0,02), pero también se puede calcular con mucha aproximación, mediante la ley de Poisson p(2), ya que p es pequeño y n grande (n*p=100*0,02=2). Distribución Normal O de Gauss La distribución Normal es la distribución continua más importante en la teoría y en la práctica estadísticas. Una gran mayoría de las variables aleatorias de la naturaleza la siguen. Las propiedades más importantes de la curva (que tiene forma de campana, campana de Gauss), son: La curva Normal es simétrica con respecto a la ordenada de la media. En ese punto la media presenta la ordenada máxima. Las tres medidas importantes de tendencia central (media, mediana y moda) coinciden en el mismo punto de esa curva. 9 La curva normal es asintótica con el eje de abscisas, es decir las ramas son casi tangentes (lo son en el infinito) con el eje de abscisas. La curva es simétrica y mesocúrtica. El área encerrada por la curva vale 1. Entre –s y +s se halla comprendido el 68,27% del área. Entre –2s y +2s, se encuentra el 95,45% y entre –3s y +3s el 99,73% del área total (siendo s la desviación estándar de la distribución). Por último, decir que si en una distribución Binomial la n es grande, aproximadamente se distribuirá como una Normal. Dado que la de Poisson es un caso particular de la Binomial, también se podrá aproximar a una Normal. ESTIMACIÓN Y CONTRASTE DE HIPÓTESIS Hay dos amplias categorías en la inferencia estadística: la estimación y los contrastes de hipótesis. La teoría de la estimación sirve para determinar el valor de los parámetros poblacionales en base al de los parámetros muestrales. Por su parte, el contraste de hipótesis es un conjunto de reglas tendentes a decidir cuál de dos hipótesis (hipótesis nula o hipótesis alternativa) debe aceptarse en torno al resultado obtenido en una muestra. A un estadístico empleado para aproximar o estimar un parámetro de la población e se le llama estimador puntual de e y se denota por ê. Una vez que la muestra ha sido tomada y se han hecho algunas observaciones se puede obtener el valor numérico del estadístico ê (sea la media, desviación estándar,..), que se conoce como estimación puntual. Pero además de la estimación puntual obtenemos un intervalo de confianza, es decir un intervalo numérico hallado a partir de la muestra que con un alto nivel de seguridad contiene el verdadero valor del parámetro poblacional. 10 En general, en estadística se dice que unos valores o resultados tienen significación o son significativos cuando son poco probables y, por tanto, seguramente no son debidos al azar, sino a factores específicos. De modo más estricto, significación estadística hace referencia a la cuestión de determinar estadísticamente, si unos determinados valores o resultados, obtenidos mediante muestras, son poco probables, de modo que no pueden explicarse por las fluctuaciones de las muestras, sino que, al diferir marcadamente de los que se esperaría producidos por el efecto del simple azar, indican que los resultados obtenidos de las muestras, son válidos y extensibles, estadísticamente, a las poblaciones de las que proceden las muestras y, por tanto, dan pie para rechazar la hipótesis nula. Esta cuestión es la razón de ser de la Estadística Inferencial y de las pruebas estadísticas de hipótesis. Test de significación: Es un procedimiento estadístico mediante el cual se determina el grado en el que los datos obtenidos son compatibles con una hipótesis específica bajo estudio. El resultado del proceso de evaluación se llama nivel de significación estadística (valor de P) de los datos con relación a la hipótesis. Mediante los tests estadísticos, aplicando teorías de probabilidad, decidimos cuál es la probabilidad de que diferencias tan grandes como las observadas sean debidas al azar si la eficacia de ambos (o más) “tratamientos” es la misma. El objetivo de las pruebas de significación es valorar cómo de “potente” es la evidencia de que un “tratamiento” es mejor que otro. Esta evidencia se establece en términos de probabilidades (valores de P), de forma que cuanto menor es el valor de la P, menor es la probabilidad de que la diferencia de los tratamientos haya aparecido por azar. P sólo cuantifica la probabilidad de cometer un error tipo I (concluir que el tratamiento produce un efecto cuando realmente no lo produce). La utilización de los valores de “p<0,05” o “p<0,01” son una convención arbitraria y no está justificada desde el punto de vista matemático ni clínico. En la práctica existe muy poca diferencia entre un valor de p = 0,06 y p = 0,04, como para establecer una separación rígida entre ambos. 11 Las técnicas que permiten evaluar el grado de compatibilidad de los datos muestrales con una hipótesis predeterminada se conoce genéricamente con el nombre de test (pruebas o contrastes) de hipótesis. En ocasiones el interés de la investigación se centra no tanto en estimar el valor de un parámetro sino en determinar si es superior o inferior a un valor determinado. Una hipótesis estadística es una asunción relativa a una o varias poblaciones, que puede ser cierta o no. Las hipótesis estadísticas se pueden contrastar con la información extraída de las muestras y tanto si se aceptan como si se rechazan se puede cometer un error. La hipótesis formulada con intención de rechazarla se llama hipótesis nula y se representa por H0. Rechazar H0 implica aceptar una hipótesis alternativa (H1). La situación se puede esquematizar: 12 α=p (rechazar H0|H0 cierta) El error tipo 1 se considera el error más grave en experimentos biomédicos y consiste en concluir que un tratamiento es eficaz cuando en realidad no lo es. Se suele aceptar un riesgo de error de 5% (α =0.05). La pregunta inmediata es por qué no exigir una seguridad máxima, es decir por qué no exigir un (α =0.01). Si lo hiciéramos, entonces correríamos el riesgo de no encontrar una diferencia significativa cuando realmente la hay. La contrapartida de un error a muy bajo es incrementar el error tipo II. β=p (aceptar H0|H0 falsa) El error tipo β es el riesgo de no detectar un efecto clínicamente significativo. Potencia=1-β=p (rechazar H0|H0 falsa) La potencia es el poder de reconocer diferencias verdaderas. Si en un contraste de hipótesis se rechaza H0, se debe calcular α, pero si no se rechaza, se debe calcular β. Tener en cuenta que: 1- α y β están inversamente relacionadas. 2- Sólo pueden disminuirse las dos aumentando el tamaño muestral (n). Los pasos necesarios para realizar un contraste relativo a un parámetro “ ” son: 1. Establecer la hipótesis nula en términos de igualdad H0: = 0 2. Establecer la hipótesis alternativa, que puede hacerse de tres maneras, dependiendo del interés del investigador H1: 0 H1: < 0 H1: > 3. en el primer caso se habla de contraste bilateral o de dos colas, y en los otros dos de lateral (derecho en el 2º caso, o izquierdo en el 3º) o una cola. 4. Elegir un nivel de significación: nivel crítico para α: “valor p” de los contrastes. 5. Elegir un estadístico de contraste: estadístico cuya distribución muestral se conozca en H0 y que esté relacionado con y establecer, sobre la base de dicha distribución, la región crítica: región en la que el estadístico tiene una probabilidad menor que α si H0 fuera cierta y, en consecuencia, si el estadístico cayera en la misma, se rechazaría H0. 6. Calcular el estadístico para una muestra aleatoria y compararlo con la región crítica, o equivalentemente, calcular el "valor p" del estadístico (probabilidad de obtener ese valor, u otro más alejado de la H0, si H0 fuera cierta) y compararlo con la región crítica. 13 Contraste de una media en una población con un valor teórico Se contrasta una media obtenida en una muestra de una población con una media teórica. Para contrastar la hipótesis nula Ho: = o con una hipótesis alternativa bilateral H1: o se utiliza el estadístico. Que sigue una distribución t de Student con n-1 grados de libertad si la hipótesis nula es cierta. Por tanto, para obtener el valor de p bilateral se contrasta el valor del estadístico con la distribución tn-1. Comparación de una proporción en una población con un valor teórico Se compara el porcentaje obtenido en una muestra de una población con un porcentaje teórico. Para contrastar la hipótesis nula Ho: hipótesis alternativa bilateral H1: = o con una o se utiliza el estadístico: Con corrección de continuidad: Que bajo la hipótesis nula, seguirá aproximadamente una distribución N (0,1). El grado de significación de z se obtiene a partir de la tabla de la ley Normal. La elección de la prueba estadística más adecuada a fin de comparar la homogeneidad de dos muestras viene determinada por: 1. El tipo de variable estudiada (cuantitativa-cualitativa). 2. Según se analicen datos independientes o apareados. 3. Las condiciones de aplicabilidad (normalidad, tamaño de la muestra...). 14 COMPARACIÓN DE MEDIAS a. Muestras Independientes Supongamos que disponemos de dos muestras de dos poblaciones base, de tamaño nA y nB, con medias mA y mB. Para el estudio de la homogeneidad de dos medias será preciso comparar si su diferencia, d = mA - mB, supera o no la atribuible al azar. Según la hipótesis nula, las medias son iguales. La distribución de diferencias de medias sigue una ley Normal con las siguientes características: Si se cumple la hipótesis nula, ¿Cuál es la probabilidad de que exista una discrepancia entre las medias, mA - mB, tan importante o mayor a la que hemos observado? Es decir, queremos saber, si la diferencia es superior a 1,96XEE, en cuyo caso la diferencia sería estadísticamente significativa (p<0,05). El error estándar de la diferencia de medias es igual a la suma de los errores estándar de cada una de las muestras. Se calcula con la ecuación 1. Si se desconocen las desviaciones estándar en la población, que es lo más frecuente, es necesario emplear una aproximación de estos valores utilizando las desviaciones estándar de las muestras. Esto se puede hacer con la asunción adicional de que las desviaciones estándar en las poblaciones base son equivalentes, A= B. Si las desviaciones estándar son equivalentes A= B= , la ecuación 1 se puede simplificar de la forma indicada en la ecuación 2 (siendo Sp la varianza combinada de las dos muestras): Queda por calcular la desviación típica común, basada en los resultados de la muestra. Ésta se obtendría de un promedio de ambas desviaciones pero de forma ponderada, para que se dé más peso a la muestra más numerosa (ecuación 3). Asimismo, en el caso de dos muestras pequeñas, no se puede demostrar que la distribución de la diferencia de medias siga una curva de Gauss, y no pueden utilizarse los valores 1,96 y 2,6 como coeficientes del intervalo de confianza. Es preciso recurrir a la distribución t de Student. 15 El error estándar deberá multiplicarse, para hallar el intervalo de confianza, por los valores t obtenidos en la tabla de Student, entrando en ella con nA + nB–2. Si d>tXEE, la diferencia será estadísticamente significativa. Cuando nA + nB –2 sea igual a 30, los valores de Student prácticamente coinciden con los de la curva de Gauss (ecuación 4). b. Dos muestras apareadas Es frecuente el caso de comparar dos valores medios obtenidos en dos muestras de pacientes pero con la particularidad de que se trata de los mismos individuos, considerados, por ejemplo, antes y después de un tratamiento. Existe una prueba estadística específica que permite analizar la homogeneidad de dos medias en datos apareados (prueba de la t pareada). El mal uso del test de distribución t es uno de los errores más comunes en la literatura médica. Es apropiado para comparar dos grupos o un grupo antes y después de un tratamiento. Si se aplica mal el test t para comparar más de dos grupos, se obtienen valores de P pequeños que pueden llevar a los investigadores a afirmar que el tratamiento produce más efecto del que los datos justifican. Disponemos de dos muestras: (n1, m1, s1) y (n2, m2, s2). Las dos muestras pueden considerarse como una sola tomando, en vez de la serie doble de valores, una única serie de incrementos. Esta nueva serie tendrá su propia media y desviación típica. Según la hipótesis nula, el tratamiento es ineficaz y los incrementos nulos. Si se repitiera indefinidamente el experimento, las medias se agruparían en una curva de Gauss de media 0. El intervalo de confianza de la media nula sería 1,96xEE a cada lado de la media. Habría que comprobar si la verdadera media de incrementos supera este margen, en cuyo caso sería estadísticamente distinta de la media nula (ecuación 5). Si la serie fuera pequeña, los valores 1,96 y 2,6 serían sustituidos por los valores t de Student (ecuación 6). 16 d media de las diferencias EE estándar de la diferencia de medias Como se desconoce el error estándar de la diferencia poblacional, se emplea la desviación estándar de las diferencias de la muestra. El error estándar sería el calculado en la ecuación 7. El test t se debe usar para evaluar la hipótesis de que dos medias no son diferentes. Si el diseño implica múltiples grupos, se deben hacer otras pruebas como el análisis de la varianza o la generalización multigrupos del test t. Cuando se usan los tests t para diferencias entre múltiples grupos se puede calcular la p verdadera multiplicando la p que informan por el número de tests posibles. c. Pruebas no paramétricas de dos muestras Hasta ahora hemos asumido que la variable analizada sigue una distribución de Gauss. Si esta condición no se cumple, hay que recurrir a las pruebas no paramétricas. Estas pruebas no dependen de la distribución de la variable y no precisan de la condición previa de normalidad de las poblaciones. Son pruebas de menor precisión, por lo que se necesitarán diferencias mayores para demostrar significación estadística. Se utilizarán, por lo tanto, sólo cuando el tamaño de la muestra sea menor de 30 y la distribución de la variable en la población no pueda considerarse normal. En caso de medias en muestras mayores de 30 y con variables de distribución no normal, no será necesario emplear tests no paramétricos. Para la comparación de medias independientes podemos emplear el test de Mann-Whitney, y también el test de Wilcoxon de la suma de clasificaciones. Estas pruebas son análogas, por lo que sus resultados son similares. Entre las diversas pruebas para medias de muestras apareadas podemos apuntar el test de Wilcoxon o test de los rangos con signo y el test de los signos. Nos referimos a los datos nominales y ordinales como datos categóricos o de clasificación. Son datos atractivos porque son fáciles de recoger. En contra tenemos la relativa insensibilidad de las medidas y las limitaciones de los datos que no siguen una distribución normal. Éstos se evalúan mediante tests no paramétricos. Aunque el test t de Student y ANOVA están 17 entre los más poderosos de los métodos de la estadística inferencial no son apropiados para datos nominales y ordinales. Afortunadamente los estadísticos han proporcionado otras técnicas. Chi cuadrado, el test de Fisher y el test de filas X columnas se podrán usar para analizar datos nominales. Mann- Whitney U, Kolmogorov y Wilcoxon con los datos ordinales (como los tests t para comparación única entre grupos, mientras que Kruskal Wallis y Friedman para datos ordinales (y como ANOVA, para comparaciones entre grupos). 18 COMPARACIÓN DE PROPORCIONES a. Muestras independientes Constituye la comparación clásica de porcentajes de una variable cualitativa en dos muestras independientes. El estadístico de comparación Z viene definido por: donde: p1 = r1/n1 p2 = r2/n2 p = r1 + r2/n1 + n2 r1, r2 son el número de casos favorables en los respectivos grupos n1 + n2 el tamaño muestral de ambos grupos. Aplicando el estadístico obtendremos su valor. El grado de significación de z se obtiene a partir de la tabla de la ley Normal. Tabla 2x2 y prueba de χ2 Chi cuadrado se usa para responder preguntas sobre tasas, proporciones o frecuencias. Se usan para decir si hay diferencias entre poblaciones o grupos para la tasa a la que ocurren diferentes resultados. Hay dos tipos de chi cuadrado: test de independencia y “goodness of fit”. Si la técnica estadística de comparación de porcentajes es muy utilizada en investigación biomédica, las tablas 2x2 (y, generalizando, fila x columna) son aún más conocidas y utilizadas. Por ejemplo: En una muestra de 100 pacientes que sufrieron infarto de miocardio se observa que 75 sobrevivieron más de 5 años (éxito). Se quiere estudiar su posible asociación con la realización de ejercicio moderado (factor pronóstico), o si, por el contrario, ambas variables son independientes. Para resolver esta cuestión, aplicaremos la prueba χ 2 de Pearson. 19 Observados Para el cálculo del estadístico de contraste es necesario calcular las frecuencias esperadas (aquéllas que debieran haberse observado bajo la hipótesis nula). Se calculan mediante el producto de los marginales dividido por la frecuencia total. Valores esperados a = m1 x n1 / T = 45 b = m2 x n1 / T = 30 c = m1 x n2 / T = 15 d = m2 x n2 / T = 10 Esperados A continuación se calcula el estadístico de contraste χ2 χ2 = = (Observado-Esperado)2 30)2/30+……..=5,56 / Esperado (50-45)2 /45+(25- La distribución de probabilidad de este estadístico es una χ 2, regida por un parámetro, grados de libertad, que es igual al número de filas menos 1, por el número de columnas menos 1, de la tabla. En este caso su valor es (2-1) x (2-1)= 1. Para =0.05 el valor de χ 2 con un grado de libertad es 3.84. Como el valor obtenido en el estudio es 5.56 podemos concluir que hay asociación entre el ejercicio y la supervivencia. Obviamente esta asociación no es necesariamente causal. El procedimiento es semejante para las tablas filas x columnas, teniendo en cuenta que si en el caso de tablas 2x2 los grados de libertad es 1, para una tabla filas x columnas, los grados de libertad se calculan con (filas-1) x (columnas-1). 20 Corrección de Yates Yates propuso en 1945 una corrección conservadora para aquellos casos de tablas 2x2 en los que N es pequeña, en concreto menor de 200. Consiste en restar 0.5 a la diferencia entre los valores observados y esperados, en el cálculo del estadístico de contraste. χ 2 Yates= ( | Observado-Esperado | -0.5)2 / Esperado b. Dos muestras apareadas Test de McNemar Se debe emplear cuando los dos grupos que comparamos no son independientes. La muestra consiste en n parejas de observaciones, cada pareja compuesta por observaciones de dos poblaciones (por ejemplo, dos observaciones en el mismo sujeto antes y después de un tratamiento; observaciones en un caso y un control emparejados). La unidad de análisis es la pareja y no cada individuo. Se realiza con el siguiente estadístico (1) que sigue una distribución χ 2 con un grado de libertad y que puede aplicarse si el número de parejas discordantes es mayor de 20. c. Pruebas no paramétricas de dos muestras Test exacto de Fisher Se emplea cuando ningún valor esperado de la tabla 2x2 sea menor de 5. El test exacto de Fisher se basa en la probabilidad exacta de observar los valores de las 4 celdas de la tabla bajo la hipótesis nula de no asociación entre las dos variables, y asumiendo que los marginales son fijos. Partiendo de esta tabla 2X2 21 La probabilidad de observar exactamente los valores a, b, c y d si no existe asociación entre las variables y si los marginales están fijos es de: Pr(a,b,c,d) = (a+b)! (c+d)! (a+c)! (b+d)! / a! b! c! d! n! Para calcular el valor p bilateral, se suman las probabilidades de la tabla observada, así como de todas las tablas más extremas de la observada, y el valor se multiplica por 2. INTERVALOS DE CONFIANZA En la estimación por intervalo, el estimador puntual se completa con un intervalo de valores del parámetro poblacional que serían compatibles con los resultados de la muestra. Los intervalos de confianza llevan asociados una probabilidad que indica la cobertura del parámetro poblacional. En la práctica, se utilizan casi exclusivamente intervalos de confianza al 95%. La estimación puntual de un parámetro representa la estimación más probable de ese parámetro con la información disponible, sin embargo los estimadores puntuales no indican la incertidumbre de nuestra investigación. En la teoría de las muestras, el intervalo de confianza es el espacio comprendido dentro de los límites formados por el parámetro de la muestra más/menos el error correspondiente dentro del que se debe encontrar el parámetro del universo, con el grado de probabilidad señalado por el nivel de confianza con el que se trabaje. La amplitud de un intervalo depende del error estándar de la media y del grado de confianza que de forma arbitraria hayamos elegido. Cuanto más cercano esté un punto al medio del IC, más probable es que represente a la población. Si se amplía un IC del 95 al 99%, la exactitud también aumenta porque aumentan las probabilidades de incluir un parámetro de la población verdadero. Sin embargo, cuando el IC se mantiene constante y aumenta el tamaño de la muestra, disminuye el EEM y se estrecha el IC, lo que a su vez incrementa la precisión. Interpretación del error estándar y de los límites de confianza El error estándar (EE) de un porcentaje indica la precisión del estimador del porcentaje poblacional. Su principal utilidad es el cálculo de los intervalos de confianza para un porcentaje o una media que intentan darnos una idea de cuál es el verdadero valor del porcentaje o media en toda la población de futuros pacientes. Límites de confianza para la diferencia de proporciones Los límites de confianza al 95 % para la diferencia de dos proporciones puede estimarse mediante: 22 Límites de confianza para la diferencia de medias Los límites de confianza al 95 % para la diferencia de dos medias puede estimarse mediante: ACERCA DEL TAMAÑO MUESTRAL Y OTROS ASPECTOS DE INTERÉS Tamaño de la muestra Sea cuál sea el tipo de estudio que vamos a usar, debemos enfrentarnos al problema del tamaño de la muestra. Este aspecto es una de las razones más frecuentes por las que se consulta a un estadístico. Tanto los investigadores como los responsables de evaluar los estudios deben ser conscientes de las implicaciones estadísticas y éticas que tiene la elección del tamaño de la muestra. Un estudio con una muestra demasiado grande pone en riesgo pacientes de forma innecesaria e incrementa los costes. Pero un estudio con una muestra demasiado pequeña es también no ético, por ser inútil científicamente e incapaz de detectar diferencias importantes. El tamaño de la muestra permite al investigador asumir si se debe esperar una distribución normal. Cuando las muestras son pequeñas (menores de 30), en general, no se puede asumir una distribución normal. Cuando las muestras son menores de 200, el investigador debería explorar si la distribución es normal. 23 En general, 30 sujetos en cada grupo dan confianza sobre la normalidad de la curva. Pero si los resultados son negativos con menos de 30 sujetos, habría que poner en duda la generalización de los resultados. En general se dice que se deben incluir 15 sujetos por cada variable estudiada. El número aumenta si se comparan subgrupos. En encuestas, se considera que se necesita al menos un 50% de respuestas para obtener resultados (sea cual sea el tamaño de la muestra). Las muestras deben ser mayores, cuanta mayor variabilidad haya (y la variabilidad se mide con la desviación estándar) Cuando la muestra es pequeña, hay que tener mucho cuidado, ya que el error tipo II puede ser la explicación de resultados negativos. Aproximación estadística a la incertidumbre P e IC nos facilitan en general resultados consistentes. Si el efecto es estadísticamente significativo, el IC del 95% no incluirá el valor de “no diferencia” y viceversa. Cuanto más grande es una muestra, menor es la incertidumbre y menor el efecto observado que pueda ser significativo (es decir, que incluso pequeñas diferencias sin significación clínica, podrían alcanzar significación estadística. 24 La amplitud del IC se ve afectada por la muestra, el tamaño y la desviación estándar. Cuanto mayor es la muestra, más estrecho es el IC Estadísticos más comunes: Su uso e interpretación MUESTREO Casi siempre basamos las conclusiones y decisiones de los estudios de investigación en función de lo que haya sucedido previamente en un grupo o muestra de individuos, más que en la experiencia de toda la población. En muchos estudios, los pacientes se reclutan a medida que acuden a consultas. En otras ocasiones, esta selección se lleva a cabo mediante técnicas específicas de muestreo. Los estudios transversales requieren, casi invariablemente, su utilización para conocer la prevalencia de un fenómeno en la población. 25 Ventajas del muestreo La principal razón es el ahorro de tiempo y dinero. Es una cuestión de eficiencia. Por ello, al considerar aspectos relacionados con los participantes en el estudio, es necesario calcular el tamaño muestral mínimo para concentrar los esfuerzos en obtener una muestra que refleje fielmente a la población de estudio. Validez del estudio. La medición de las variables será más exacta pues se dedicarán más esfuerzos a asegurar su calidad si se efectúa en un número reducido de individuos. Además, es también un problema de cantidad de información pues al tener más recursos, éstos se invierten en medir variables pronósticas que pudieran influir en los resultados (control de posibles factores de confusión). Muestreo Probabilístico Se define como el proceso en el que todos los individuos tienen una probabilidad conocida de ser elegidos distinta de cero. Utiliza siempre alguna forma de selección aleatoria. Es un tipo de muestreo muy utilizado porque con él la muestra será más representativa de la población de estudio al elegir al azar las unidades de muestreo evitando la parcialidad, consciente o inconsciente, del investigador. Cuando se elige una muestra ésta no es más que una de las infinitas muestras que se pueden obtener de una población. La aplicación de técnicas de muestreo probabilístico permiten la aplicación de técnicas estadísticas capaces de cuantificar el error aleatorio (error debido al muestreo). La unidad de muestreo es el elemento sobre el cual se aplicará la técnica de selección, puede ser distinta de la unidad de análisis. La fracción de muestreo es el cociente entre el tamaño de la muestra deseado y el total de la población candidata (n/N). Tipos de muestreo probabilístico: 1. Muestreo aleatorio simple (MAS): En este tipo de muestreo, cada unidad de muestreo tiene la misma probabilidad de ser elegida. El primer paso es preparar un listado de las unidades de muestreo, numerándolas, por ejemplo, secuencialmente. Este proceso puede ser fácil y rápido si la población de referencia se encuentra en una base de datos informatizada y muy laborioso si se realiza manualmente y la población es grande. Luego, se calcula el tamaño muestral necesario y se eligen las unidades con una tabla de números aleatorios o mediante un programa estadístico. 26 El MAS tiene la ventaja de ser sencillo y de permitir un cálculo rápido de medias y varianzas. Sin embargo, requiere el conocimiento previo de la lista completa de todas las unidades de muestreo. 2. Muestreo sistemático (MS): Este procedimiento se basa en alguna regla sistemática simple para elegir uno de cada n individuos. Es un método más cómodo y práctico que el MAS y los resultados son los mismos. Primero, se calcula la constante de muestreo (k) dividiendo el total de la población entre el tamaño de la muestra (N/n). La primera unidad se extrae al azar entre los k primeros individuos y se le suma a la primera unidad la constante sucesivamente hasta completar el tamaño de la muestra. Tampoco es necesario tener a mano la lista completa de toda la población (también el listado puede construirse a medida que el estudio avanza siempre y cuando las unidades sigan un orden establecido, por ejemplo, los pacientes que acuden a una consulta). Además, cuando la población de referencia está ordenada siguiendo una tendencia conocida (por ejemplo, de mayor a menor o de más joven a más viejo) el MS asegura una cobertura de unidades de todos los tipos. La desventaja más importante aparece cuando la constante de muestreo que se aplica está relacionada con el fenómeno que se quiere estudiar. En este caso, se pueden hallar estimaciones muy distorsionadas de los parámetros poblacionales. 3. Muestreo estratificado (ME): Se caracteriza porque la población se divide en uno o más estratos, es decir, subgrupos de población que comparten alguna característica y son mutuamente excluyentes. Luego, se escoge una muestra al azar en cada estrato, manteniendo la proporción observada en la población de referencia. Este tipo de muestreo intenta evitar muestras sesgadas al conseguir la igualdad en la distribución con que una o varias variables se encuentran en la población o en la muestra. Su correcta aplicación requiere que se conozca la distribución de las variables empleadas para la estratificación en la población y que la variabilidad dentro de los estratos sea lo más pequeña posible y entre los estratos lo más grande posible. Es preciso que los estratos se delimiten en función de las variables que puedan distorsionar los resultados. Así, se obtendrán subgrupos de la población muy homogéneos respecto a la posible variable de confusión y muy heterogéneos entre sí. Además, se controlará el posible efecto de estas variables en el resultado. Si el interés principal es conocer si existen diferencias entre los estratos, la aplicación del muestreo proporcional puede significar que en un estrato exista un número muy pequeño de individuos que dificulte o invalide las comparaciones. Una solución es aplicar diferentes fracciones de muestreo en cada uno de los estratos. Hay que tener en cuenta las distintas fracciones si se quieren estimar las medias y varianzas de toda la muestra, lo que añade cierta dificultad al análisis. 27 Si se tiene intención de realizar un análisis sólo de los subgrupos por separado, no es necesario tener en cuenta las diferentes fracciones de muestreo porque cada estrato puede considerarse como una población diferente. En general, con el ME se obtienen estimaciones más precisas de los parámetros poblacionales que con el MAS pues la varianza total se basa en la de cada uno de los estratos, y éstos, al ser más homogéneos que la población total, tienen menor variabilidad. El ME reduce la variación debida al muestreo. Esta reducción depende de las diferencias entre estratos. Cuanto mayor sea esta diferencia, y cuanto menor sea la variabilidad dentro de un estrato, mayor será la reducción de la varianza. 4. Muestreo en etapas múltiples: Consiste en seleccionar unidades de muestreo de una población (unidades primarias), procediéndose a obtener, en una segunda etapa, una muestra de cada una de las unidades primarias (unidades secundarias). Se puede usar el número de etapas que sea necesario y, en cada una de ellas, un método distinto de muestreo (simple, estratificado, sistemático). Cuando en el estudio se incluyen todas las unidades secundarias se denomina muestreo por conglomerados (elegir a todos los alumnos de las aulas que se escojan). La unidad de muestreo primaria es la más grande y comprende un mayor número de elementos y se desciende en las sucesivas etapas hasta llegar a la unidad básica o elemento de la población (ej: si queremos saber la prevalencia de caries en la población escolar, se podrán seleccionar escuelas como unidades primarias y los alumnos como unidades secundarias). El muestreo en etapas múltiples se utiliza cuando la población es muy grande y dispersa. Su principal desventaja es que si las unidades primarias contienen personas similares con relación al fenómeno de interés, es difícil estimar la precisión con que pueden calcularse los parámetros poblacionales. En este tipo de muestreo, la variabilidad es mayor que en el MAS o que en el ME y su cálculo es complejo. Una solución parcial es extraer una muestra de mayor tamaño y considerarla como aleatoria simple, procurando que las unidades de muestreo sean lo más pequeñas posible. El muestreo en etapas múltiples es útil cuando la población se encuentra agrupada y el coste que supone estudiar cada uno de estos grupos es grande y cuando no existe un listado de toda la población de referencia. Muestreo no Probabilístico En este tipo de muestreo, las unidades se escogen utilizando métodos en los que no interviene el azar. Se desconoce la probabilidad que posee cada unidad de ser incluida en la muestra. 28 Tipos de muestreo no probabilístico: 1. Muestreo consecutivo: Consiste en seleccionar a los pacientes que cumplen los criterios de selección especificados en el protocolo del estudio a medida que acuden a consulta durante un periodo de tiempo determinado. Es la técnica más utilizada en los ensayos clínicos, especialmente, cuando la enfermedad es aguda. 2. Inclusión de voluntarios: Es preferible rechazar su colaboración ya que los motivos que llevan a una persona a prestarse a un estudio sin haber sido seleccionada suelen estar relacionados con otras características que afecten a la representatividad de la muestra. 3. Muestreo por cuotas: Es cuando la composición general de la población de referencia en términos de características tales como la edad, el sexo o el nivel de educación, se decide o se conoce de antemano. Seguidamente, se determina el número de personas requeridas (o cuotas) para los varones o mujeres según diferentes edades y niveles de instrucción, siendo el único requerimiento el conseguir el número de personas adecuado para llenar cada una de las mismas. La desventaja de este método es que no todos los elementos tienen la misma probabilidad de ser incluidos en el estudio, por lo que es posible que la muestra difiera de la población de referencia. Por tanto, siempre que se pueda, se aplicará una técnica de muestreo probabilística. Si no es posible, y si se emplea un muestreo consecutivo, se han de concentrar todos los esfuerzos en conseguir que las personas seleccionadas cumplan estrictamente los criterios de inclusión en el estudio con el fin de evitar una muestra sesgada. CORRELACIÓN LINEAL Trata de comprobar si dos variables cuantitativas (x e y) están relacionadas y facilitar la intensidad de esa relación. a. Covarianza Es la media aritmética de los productos de las desviaciones de la variable x con respecto a su media aritmética por las desviaciones de la variable y con respecto a su media aritmética. b. Coeficiente de correlación lineal de Pearson Se obtiene dividiendo la covarianza por las desviaciones típicas de cada variable. Su signo está determinado por el signo de la covarianza. Sus valores van de 1 a –1. Si es cero, no existe relación lineal, aunque puede haberla de otro tipo. Sólo es aplicable para la relación lineal entre variables. No tiene unidades. 29 No es una medida de tipo cuantitativo sino ordinal (un coeficiente de 0,6 no indica que la relación entre las variables sea el doble de intensa que si fuera 0,3 sino simplemente que es mayor). c. Coeficiente de correlación muestral Cuando se estudian en todos los individuos de una población dos variables independientes entre sí que siguen una distribución normal, el coeficiente de correlación poblacional es cero. d. Coeficiente de correlación de Spearman Se utiliza cuando se quiere valorar la dependencia de dos variables medidas en escala ordinal o que, aunque sean cuantitativas, no siguen una distribución normal. Se basa en la correlación de rangos. Se miden dos variables a una serie de sujetos y se les asignan números de orden para cada uno de los valores de cada una de las variables: - Si existe relación directa entre estas dos variables, un rango alto en una variable irá acompañado de un valor de orden alto en la otra: así, cada pareja de valores tendrá el mismo rango aproximadamente para cada variable. - Si existe una relación inversa, lo que ocurrirá es que un rango alto en una variable irá acompañado de un valor de orden bajo en la otra y, por tanto, los rangos serán totalmente opuestos. Para el cálculo se procede a asignar a cada valor de cada variable el número de orden que le corresponde de menor a mayor. Se halla la diferencia d para cada individuo entre los rangos asignados a cada variable y se eleva al cuadrado. El coeficiente calculado es una estimación del coeficiente poblacional. Si toma un valor distinto de cero, se debe averiguar si procede de una población con un coeficiente distinto de cero o si ha sido el azar el que ha hecho aparecer este valor. Para muestras inferiores a 30 sujetos existen tablas que permiten comprobar si el valor r hallado es mayor que el que ofrece la tabla (si es así, se puede decir que las variables están relacionadas. Para muestras superiores a 30 sujetos, se aplica el mismo estadístico que el usado para el coeficiente de correlación de Pearson. 30 Prueba de independencia entre dos variables cuantitativas basada en el coeficiente de correlación REGRESIÓN LINEAL La regresión lineal es la explicación de la relación existente entre dos variables (x e y) por una función y= f(x). Donde x es la variable independiente e y la variable dependiente. La regresión lineal simple intenta ajustar una recta a la relación entre dos variables. La función de una recta es y= a + bx donde “b” es la pendiente de la recta o coeficiente de regresión y “a” es el término independiente o altura en el origen. Por cada valor de x se obtiene un valor de y. 31 Estimación puntual de los parámetros de una recta Dado que en muy pocas ocasiones se estudia a la población, lo que se hace es obtener una muestra y estimar los valores de “b” y “a” y buscar la recta que mejor se ajuste a los valores observados. El método que se utiliza es el de mínimos cuadrados, método que se basa en considerar como la mejor adaptación la de una recta tal que sea mínima la suma de los cuadrados de las diferencias entre los valores observados y los ajustados o calculados, correspondientes a los distintos valores de la recta para los mismos valores de la variable explicativa. Las suposiciones en las que se fundamenta el análisis de la regresión son: Los valores de la variable x son escogidos por el investigador. Cada valor de x delimita una subpoblación de individuos con distintos valores de y que deben seguir una distribución normal. Las varianzas de y en cada subpoblación son iguales. Todas las medias de y en cada subpoblación están sobre una línea recta: linealidad. Los valores de y son estadísticamente independientes. Coeficiente de determinación El coeficiente de determinación R 2 da la bondad de ajuste decidido para representar la relación entre las variables estudiadas. Se define como el cociente entre la parte explicada de la variación de la variable “y” y el total de variación. En la regresión lineal, el coeficiente de determinación coincide con el cuadrado del coeficiente de correlación de Pearson. Características Sus características son las siguientes: Es siempre positivo. Sus valores se sitúan entre 0 y 1. Viene expresado por unidades abstractas lo que permite comparaciones con otros coeficientes de determinación. Si su valor es 1, la relación entre las dos variables es perfecta e indica que la varianza de los valores de “y” es totalmente explicada por la regresión. Si su valor es 0, significa que la función ajustada no explica en absoluto la relación entre las dos variables estudiadas. La línea ajustada es una recta paralela al eje x que pasa por y. Estimación por intervalo de los parámetros de la recta Para estudiar la relación existente entre dos variables x e y se ha tomado al azar una muestra de tamaño n y se ha calculado la recta de regresión que no es más que una estimación puntual de la verdadera recta que liga todos los valores de x e y. Es necesario calcular el intervalo de confianza para cada uno de los parámetros de la recta de regresión. 32 Estimación de parámetros del modelo de regresión y pruebas de significación